Технология NIC Teaming (или Load Balancing/Failover – LBFO, или NIC bonding) позволяет объединить несколько физических сетевых адаптеров (NIC) в одну логическую сетевую карту. В этой статье мы рассмотрим, как настроить NIC Teaming в Windows Server 2019/2016/2012R2 и в десктопых версиях Windows 10 и 11.

Содержание:

- Настройка NIC Teaming в Windows Server 2019

- Используем PowerShell для настройки NIC Teaming в Windows Server

- Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Для чего может понадобится объединять сетевые адаптеры в группу NIC Teaming?

- Увеличение пропускной способности. Например, объединив две сетевые 1 Гб сетевые карты в одну группу NIC Teaming, вы получите общую полосу пропускания на логическом адаптере 2 Гбит/с;

- Управление балансировкой нагрузки на сетевые карты – можно управлять распределением трафика между NIC сервера;

- Отказоустойчивость – при выходе из строя любой из сетевых карт, добавленных в группу NIC teaming, остальные подхватывают ее функции, и связь с сервером не прерывается. Для критически важных серверов этот механизм может защитить от простоя сервиса во время выхода из строя сетевого коммутатора или Ethernet порта на нем, сетевого кабеля (которым ваш хост подключен к коммутатору). Для реализации такой возможности, достаточно подключить сетевые карты в разные физические коммутаторы.

В Windows Server 2012R2/2016/2019/2022 технология NIC Teaming не совместима с Single-root I/O virtualization (SR-IOV), TCP Chimney и Remote Direct Memory Access (RDMA).

Настройка NIC Teaming в Windows Server 2019

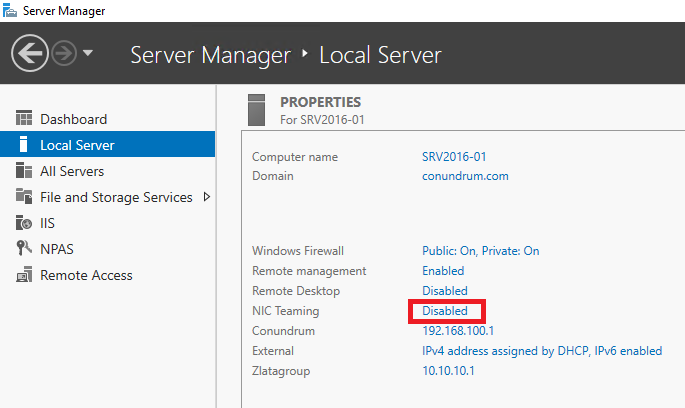

Вы можете настроить NIC Teaming в Windows Server начиная с версии 2012. Рассмотрим, как объединить несколько сетевых адаптеров в Windows Server 2019 в одну группу NIC Teaming. Режим NIC Teaming по умолчанию отключен в Windows Server.

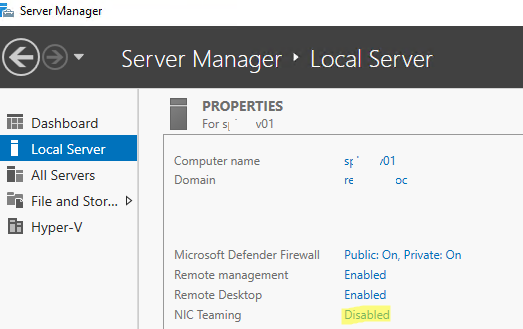

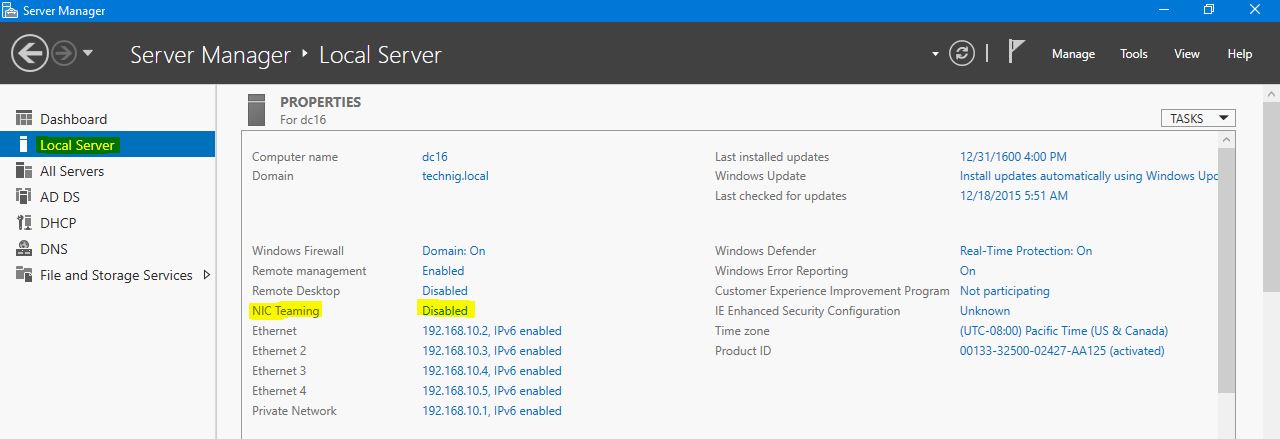

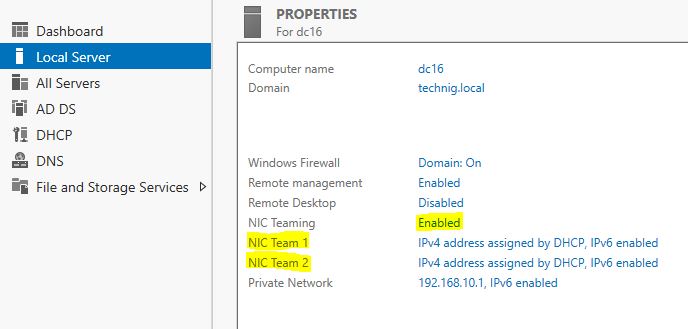

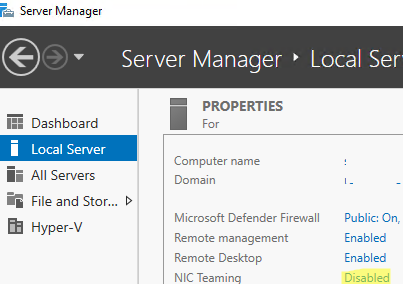

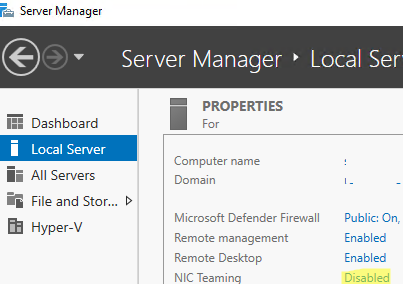

Чтобы включить его, откройте консоль Server Manager, выберите локальный сервер (Local Server) и в его свойствах выберите пункт “NIC Teaming: Disabled“.

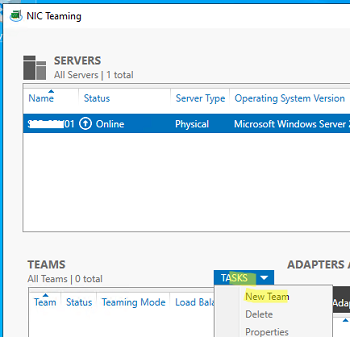

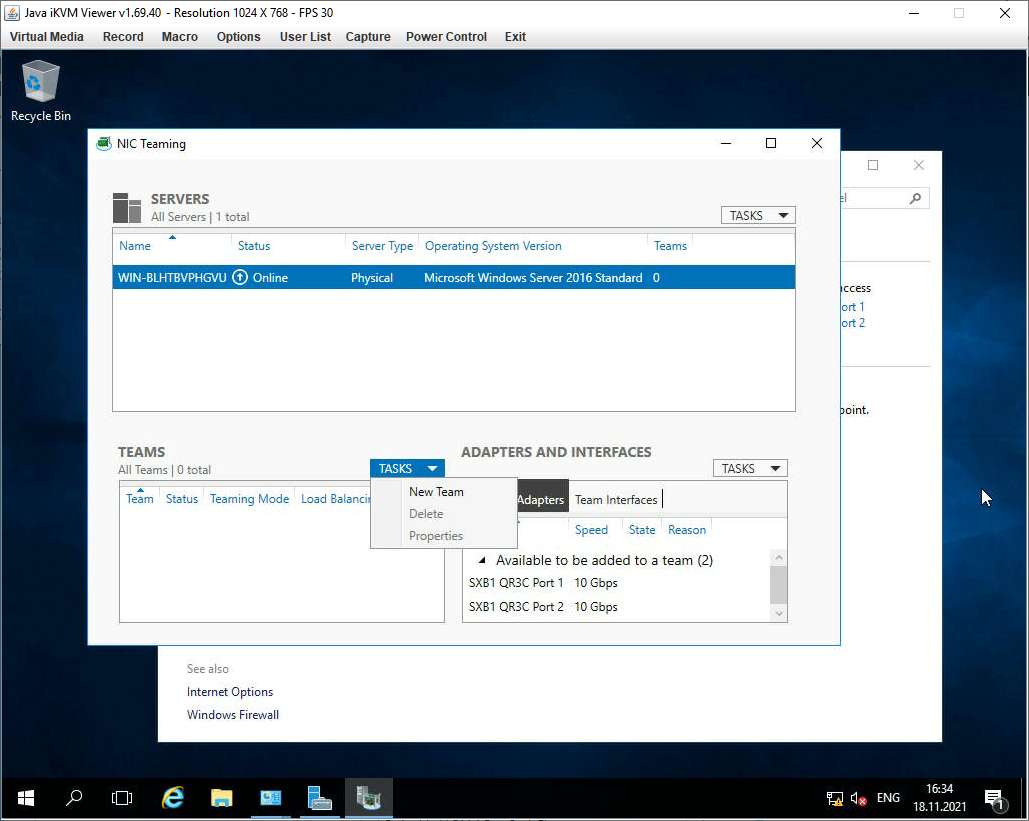

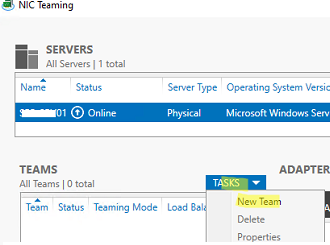

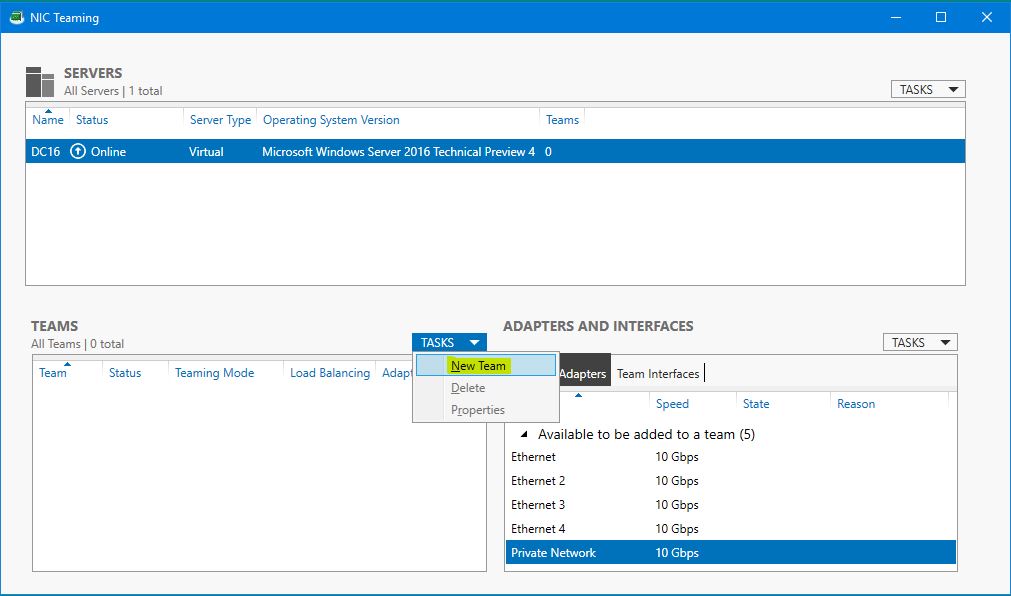

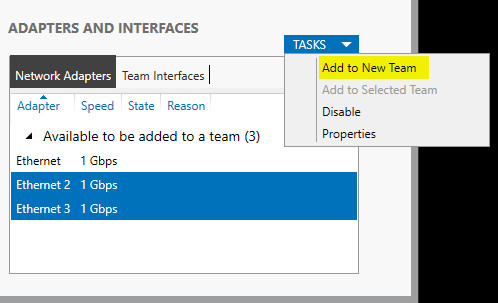

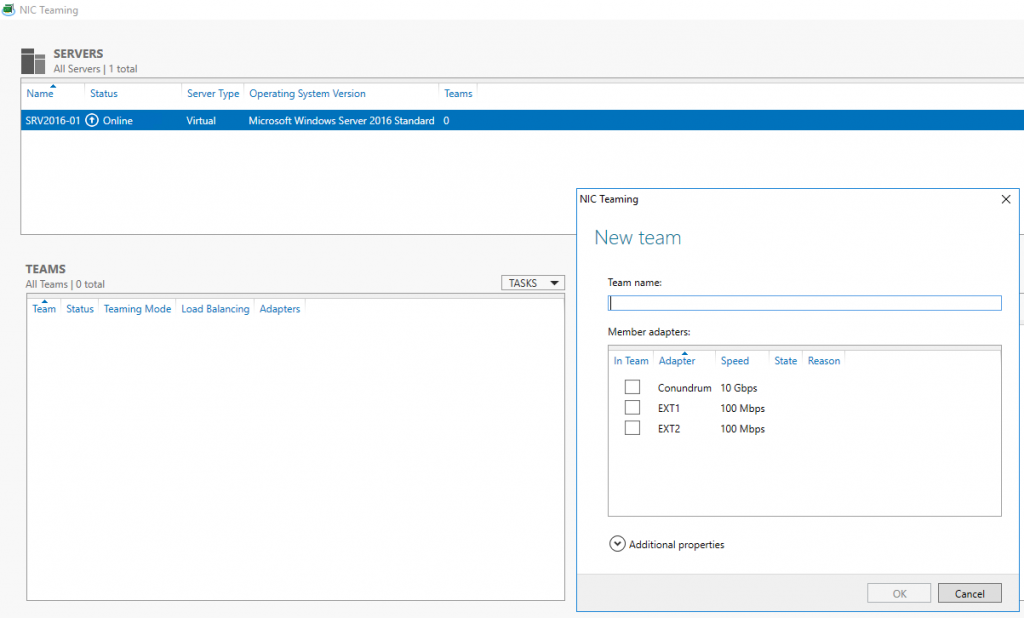

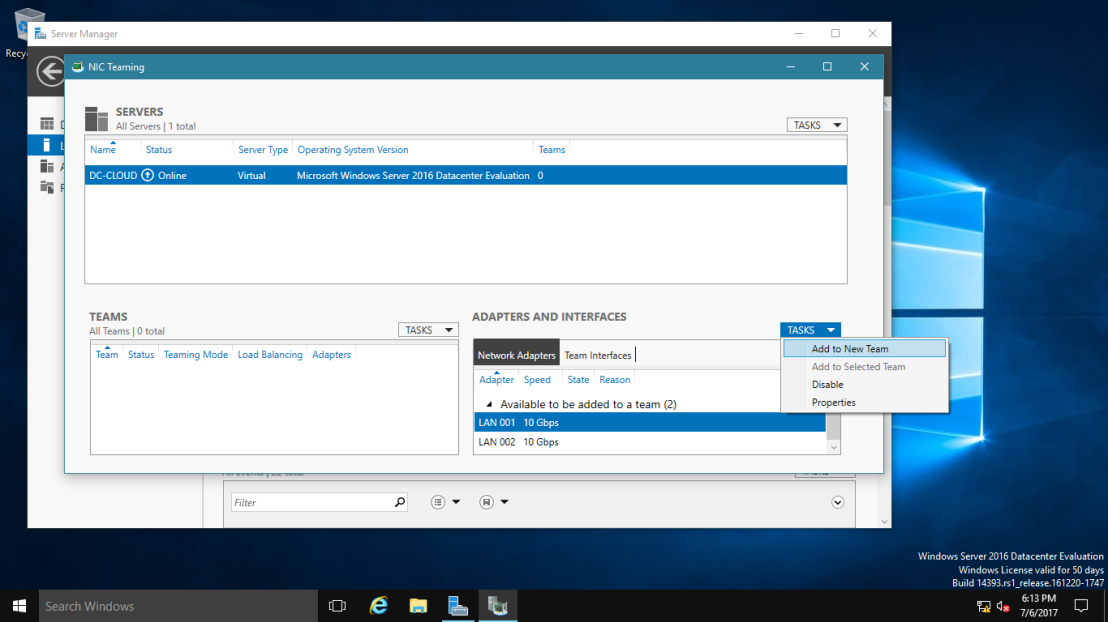

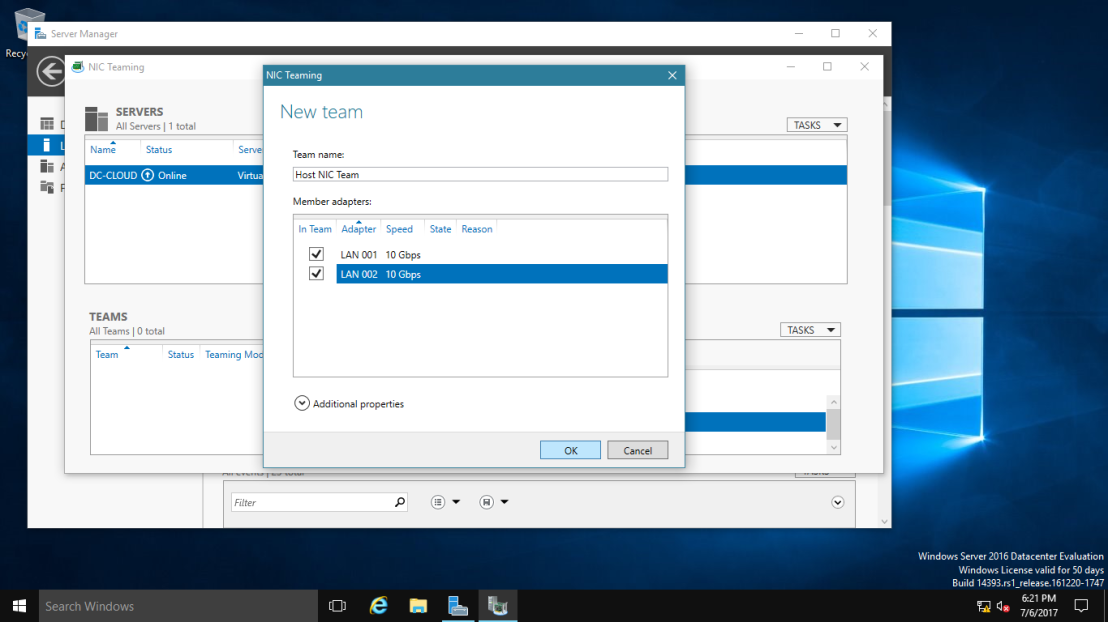

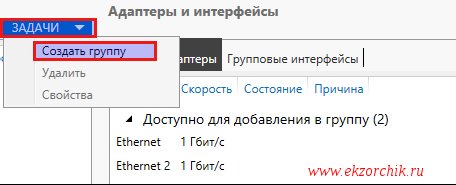

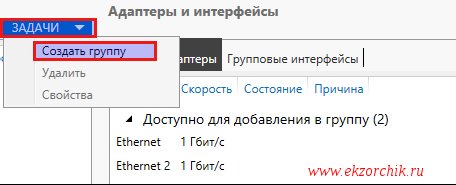

В появившемся окне в левой нижней панели выберите пункт Tasks -> New Team (Создать группу).

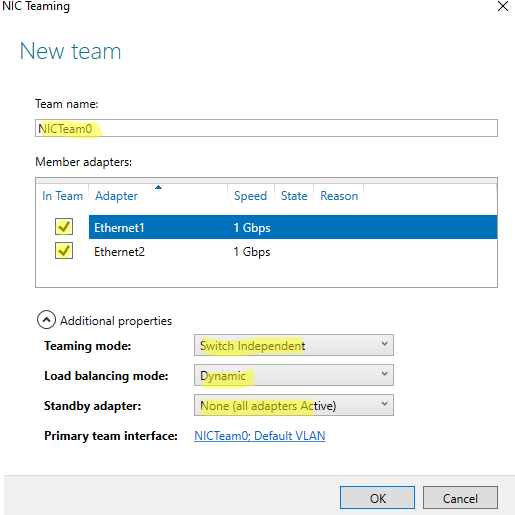

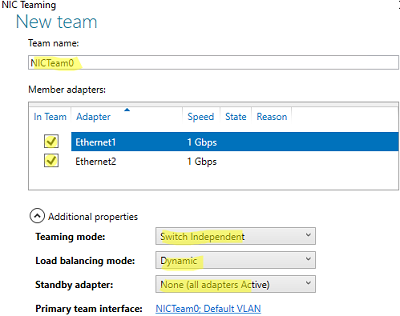

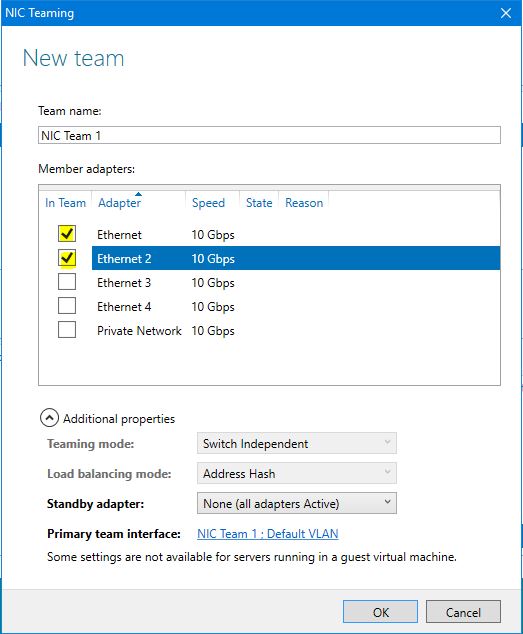

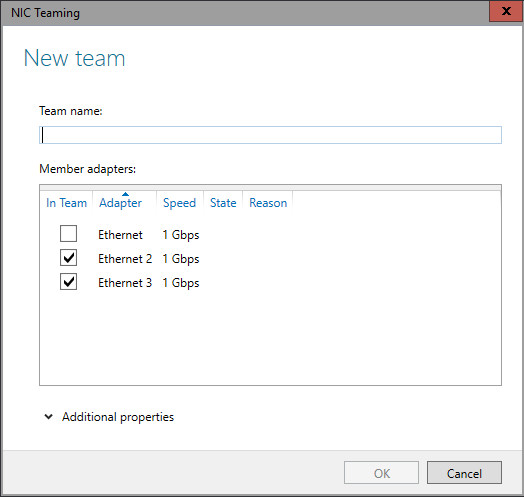

Далее нужно указать имя группы (Team Name) и выбрать сетевые адаптеры, которые будут входить в эту группу.

В Windows Server 2019 в одну NIC Teaming групп можно объединить до 32 физических сетевых адаптеров, главное, чтобы они работали на одной скорости.

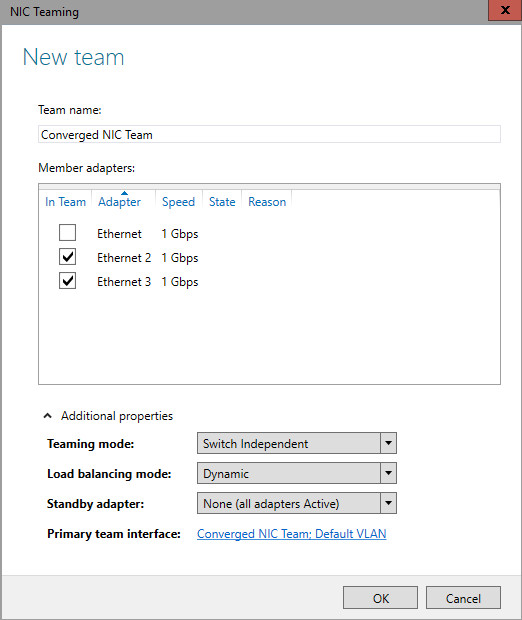

Ниже можно настроить специальные параметры группы. От данных параметров зависит правила и эффективность NIC Teaming. Рассмотрим эти настройки подробнее.

Режим поддержки групп (Teaming Mode). Данный параметр определяет способ взаимодействия группы с сетевым оборудованием (коммутатором)

- Static Teaming (IEEE 802.3ad)— статический режим работы с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору, Ethernet порты которого настроены на использование статической агрегации каналов (требуется настройка на коммутаторе);

- Switch Independent (режим по-умолчанию) – группа работает независимо от коммутатора, для реализации не нужно дополнительно настраивать сетевое оборудование. В этом режиме разные сетевые адаптеры группы можно подключить к разным коммутаторам для повышения отказоустойчивости (защита от сбоев в коммутаторах);

- LACP (Link Aggregation Control Protocol, LACP, IEEE 802.1ax) – режим также зависит от сетевого оборудования. Нужно включить и настроить на коммутаторе динамическую агрегацию каналов по протоколу LACP.

Режим балансировки нагрузки (Load Balancing mode) – задает как распределяется сетевой трафик по NIC в группе.

- Address Hash — для каждого из адаптеров вычисляется специальный хэш (на основании MAC или IP-адресов отправителя и получателя) и привязывается определенному физическому адаптеру. Весь трафик от данного отправителя будет идти через этот NIC;

- Hyper-V Port — режим можно использовать для сервера с ролью Hyper-V. Позволяет привязать конкретный адаптер группу NIC teaming к конкретному порту на виртуальном коммутаторе Hyper-V;

- Dynamic – опция по умолчанию, совмещает оба типа балансировки нагрузки.

Один из адаптеров в группе можно назначить резервным (Standby adapter). В обычном режиме работы данная NIC не используется для передачи трафика. При неполадке на любом другом адаптере в группе NIC Teaming, он тут-же занимает его место. В общем случае и без данной функции при выходе из строя любой сетевой карты, не будет простоя сервиса, т.к. ее нагрузка автоматически распределится между оставшимися картами в группе.

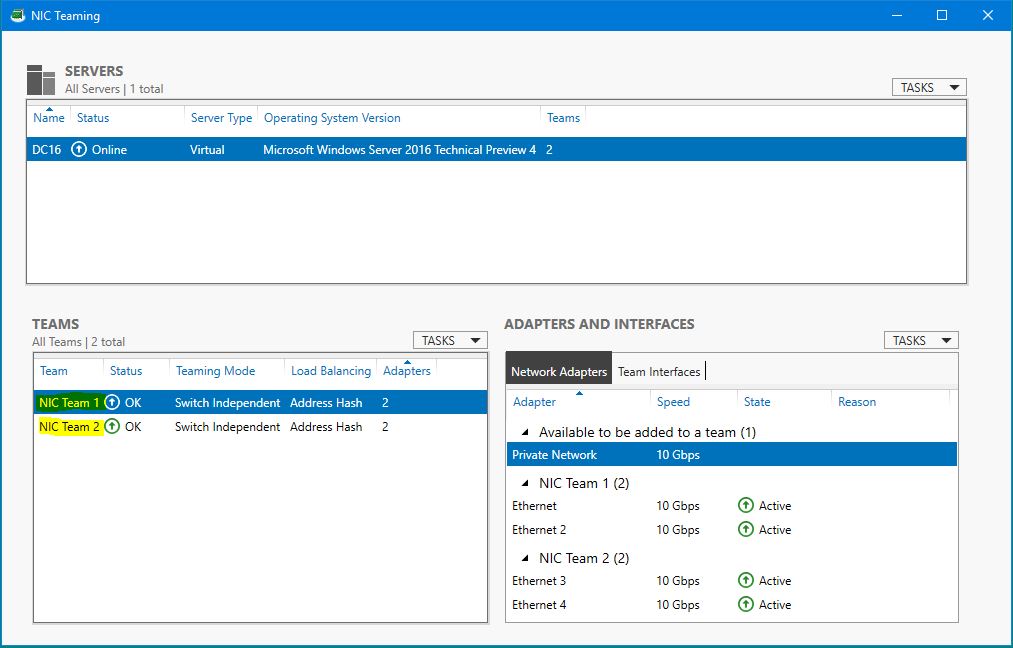

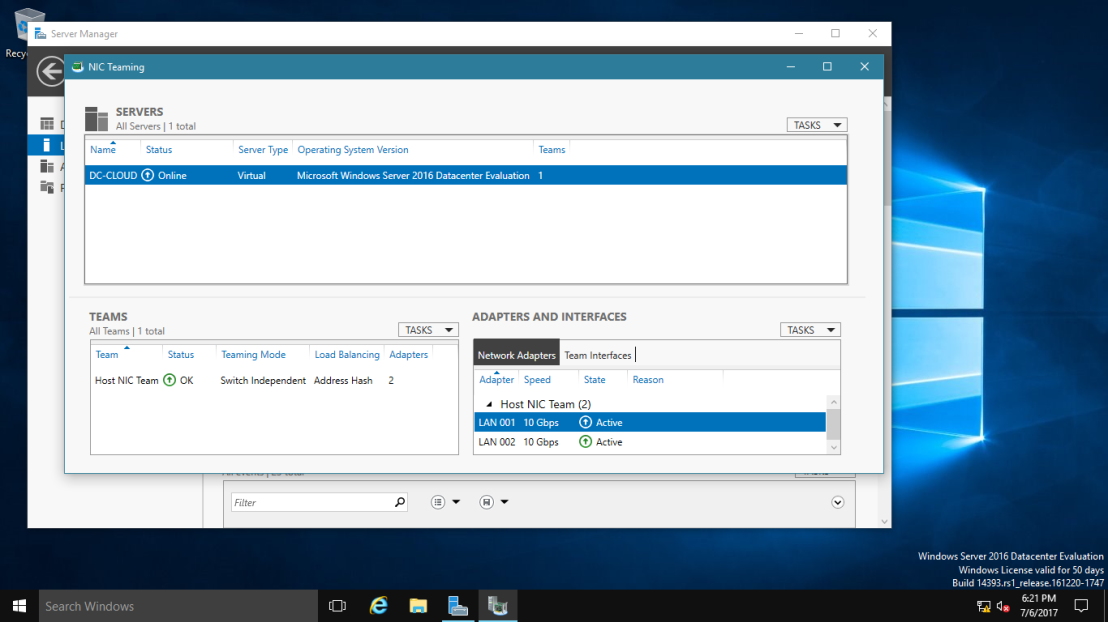

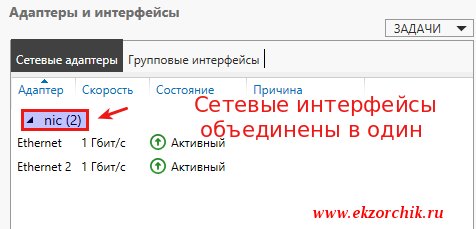

Выберите нужные параметры, нажмите ОК и новая группа Nic Teaming будет создана.

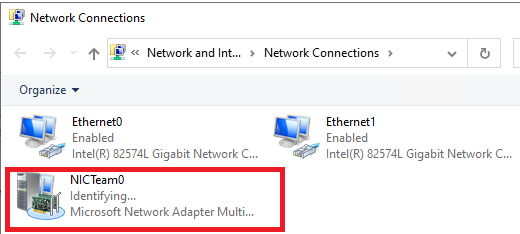

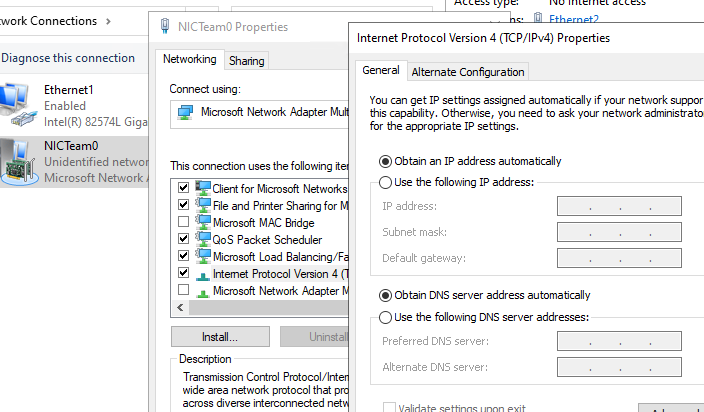

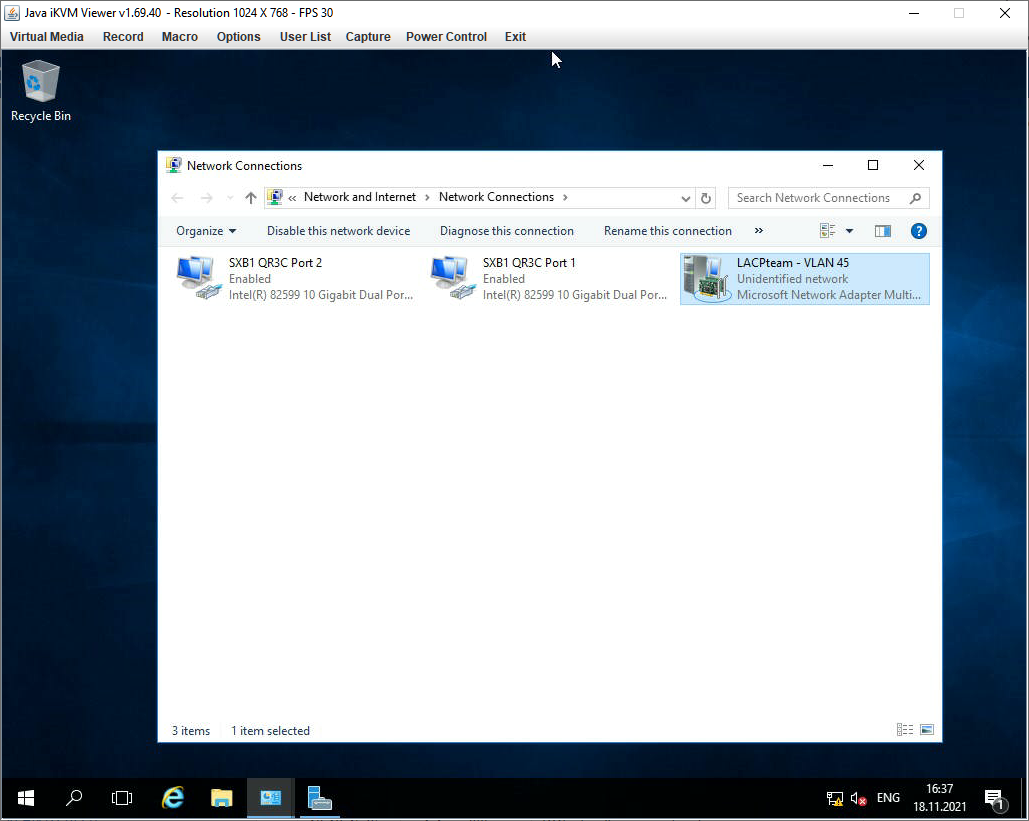

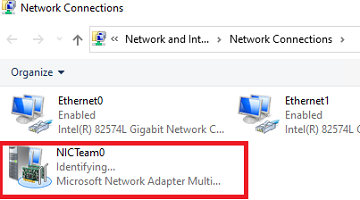

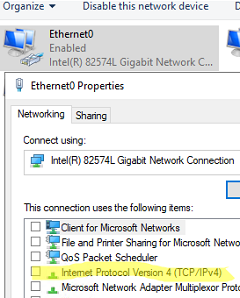

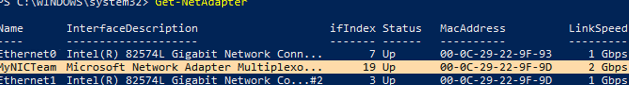

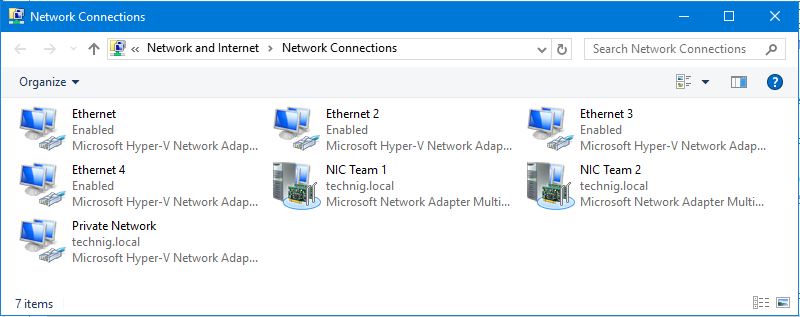

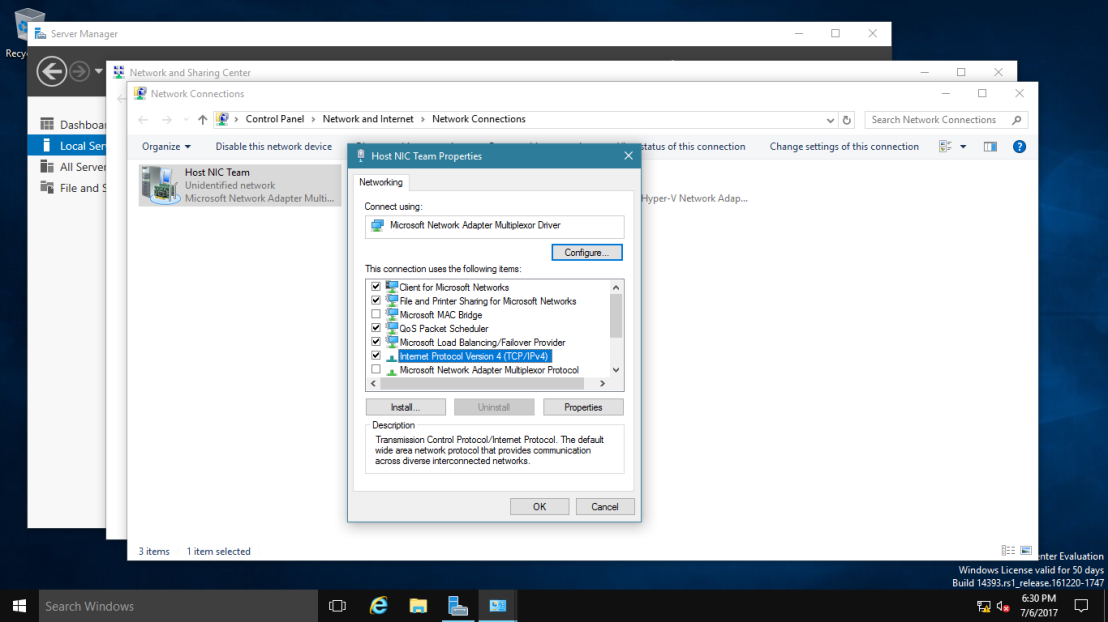

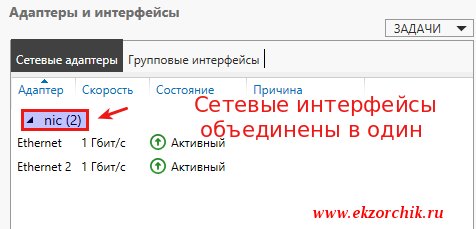

Откройте список сетевых подключения в панели управления Windows. Убедитесь, что в Windows Server появился новый сетевой адаптер Microsoft Network Adapter Multiplexor Driver (его иконка немного отличается). Это и есть виртуальный адаптер группы NIC Teaming.

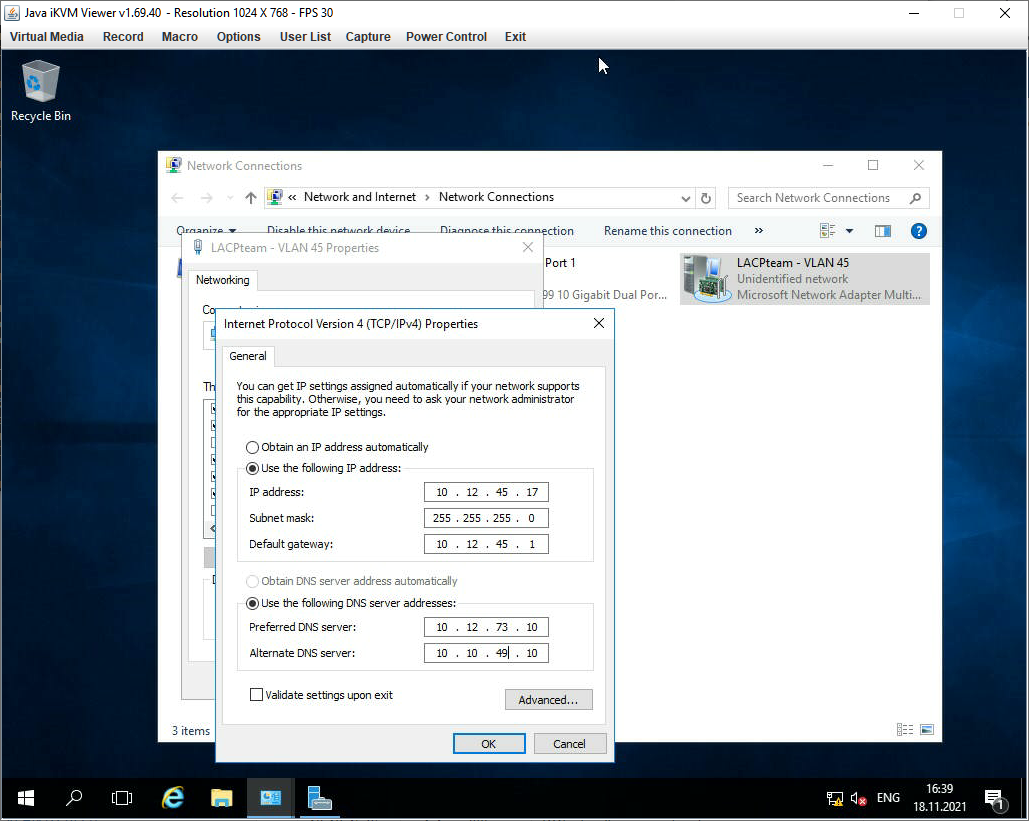

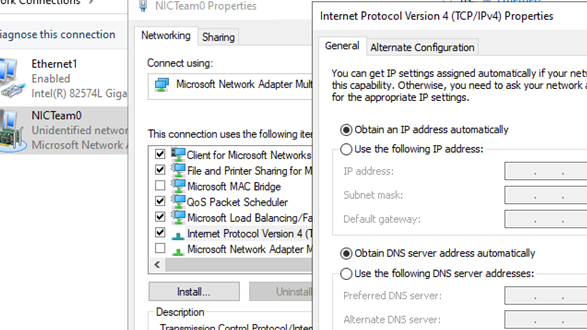

Дальнейшая настройка параметров сетевой карты (протоколы, IPv4/v6 адрес) осуществляется теперь в свойствах этого адаптера.

У всех остальных сетевых адаптеров, которые вы добавили в группу NIC Teaming уже не будет собственных IP адресов.

При удалении группы NIC Teaming предыдущие настройки сетевых адаптеров восстанавливаются.

В дальнейшем вы можете добавить или удалить сетевые адаптеры в группу NIC Teaming.

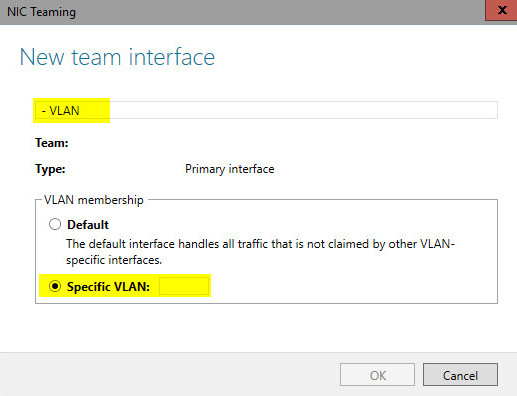

Вы можете использовать группу NIC Teaming для настройки нескольких VLAN интерфейсов в Windows Server. Для этого можно даже создать группу NIC Teaming из одного сетевого адаптера.

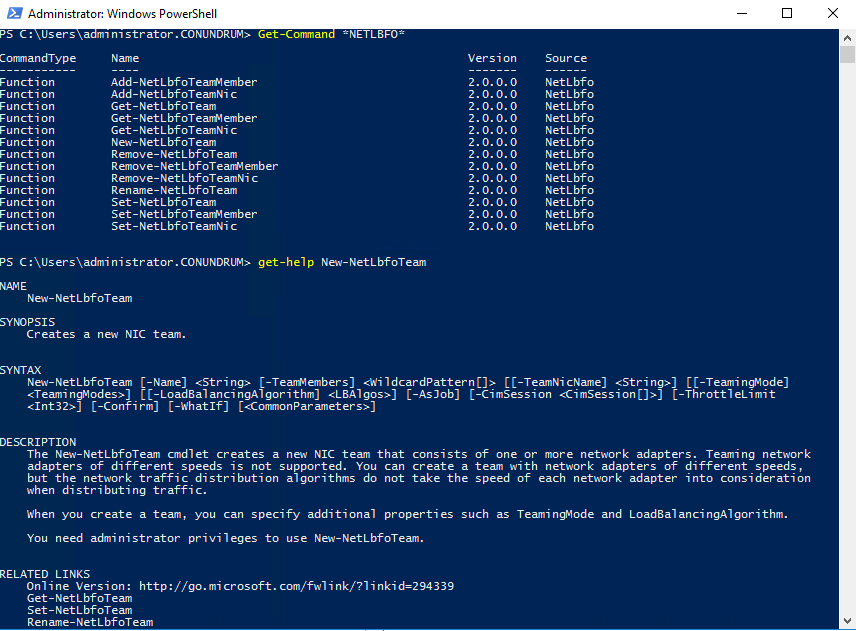

Используем PowerShell для настройки NIC Teaming в Windows Server

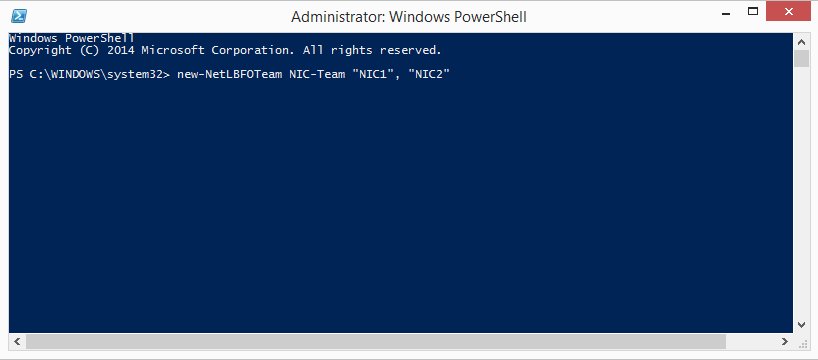

Вы можете создавать и управлять группами NIC Teaming не только из графического интерфейса Windows, но и с помощью PowerShell. Вы можете использовать PowerShell для настройки NIC Teaming в Windows Server Core

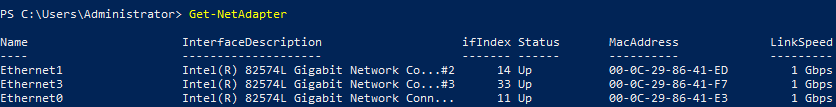

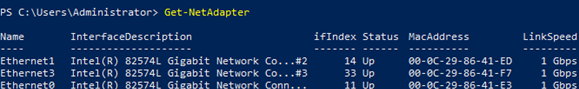

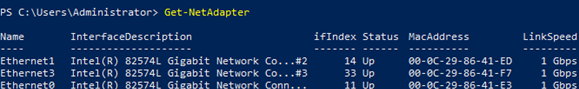

В Windows Server для управления MIC Teaming есть встроенный модуль NetLbfo. Выведите список сетевых адаптеров на сервере:

Get-NetAdapter

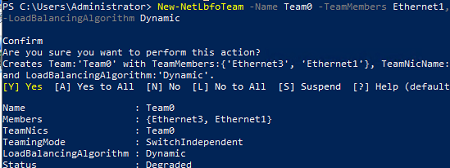

Создайте новую группу с Team0 из адаптеров с именами Ethernet1 и Ethernet3. Выберите режим работы NIC Teaming: Switch Independent с динамической балансировкой.

New-NetLbfoTeam -Name Team0 -TeamMembers Ethernet1,Ethernet3 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm Dynamic

Доступные параметры:

- TeamingMode:

Static

,

SwitchIndependent

,

Lacp - LoadBalansingAlgorithm:

TransportPorts

,

IPAddresses

,

MacAddresses

,

HyperVPort

,

Dynamic

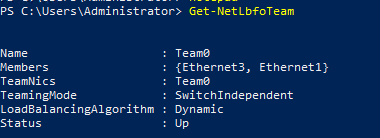

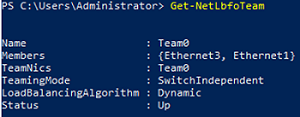

Информацию о группах NIC Teaming на сервере можно вывести с помощью команды:

Get-NetLbfoTeam

Name : Team0

Members : {Ethernet3, Ethernet1}

TeamNics : Team0

TeamingMode : SwitchIndependent

LoadBalancingAlgorithm : Dynamic

Status : Up

Можно настроить IP адрес интерфейса NIC Teaming с помощью PowerShell:

New-NetIPAddress -InterfaceAlias team0 -IPAddress 192.168.13.100 -PrefixLength 24 -DefaultGateway 192.168.13.1

Set-DnsClientServerAddress -InterfaceAlias team0 -ServerAddresses 192.168.13.10

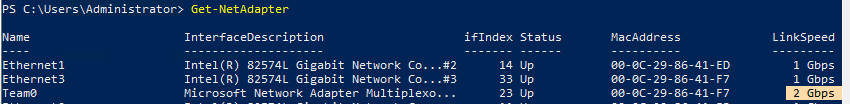

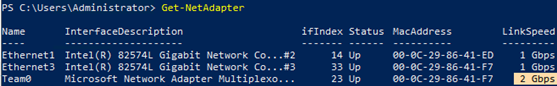

Выполните команду

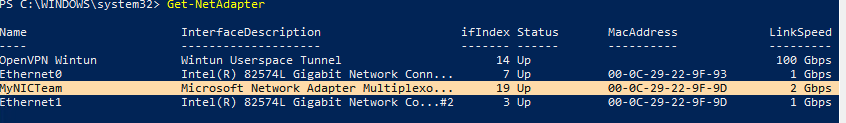

Get-NetAdapter

. Обратите внимание, что LinkSpeed сетевого адаптера группу NIC Teaming — 2 Гбит/с.

Чтобы изменить настройки группы NIC Teaming используется командлет Set-NetLbfoTeam:

Set-NetLbfoTeam -Name team0 -TeamingMode LACP

Если выполнить эту команду в ВМ, появится ошибка

Set-NetLbfoTeam : 'SwitchIndependent' is the only TeamingMode value supported in a Virtual Machine

Чтобы через NIC Teaming добавить отдельный VLAN интерфейс, используйте команду:

Add-NetLbfoTeamNIC -Team Team0 -VlanID 10

Удалить группу NIC Team можно командой:

Remove-NetLbfoTeam -Name Team0

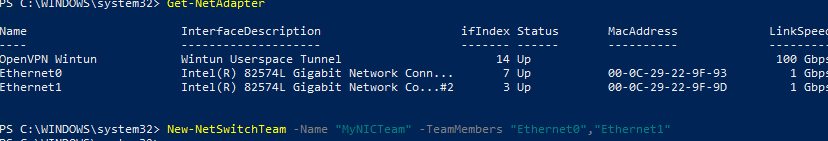

Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Вы можете использовать NIC Teaming для объединения сетевых карт не только в Windows Server, но и в клиентских версиях Windows 10 и 11. Главное, чтобы производитель вашей сетевой карты поддерживал для нее режим Link aggregation / NIC teaming/ LBFO.

Например, NIC Teaming работает из коробки с драйверами картами Realtek PCIe GbE Family Controller ( 10.35.510.2019) или Intel(R) 82574L Gigabit Network Connection.

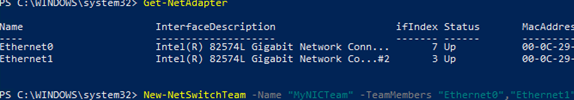

Чтобы собрать группу NIC Teaming в Windows 10 (в этом примере это Windows 10 20H2), откройте консоль PowerShell и выведите список сетевых адаптеров:

Get-NetAdapter

Соберем группу NIC Team из адаптеров Ethernet0 и Ethernet1.

New-NetSwitchTeam -Name "MyNICTeam" -TeamMembers "Ethernet0","Ethernet1"

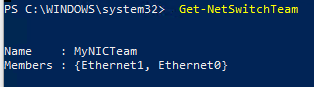

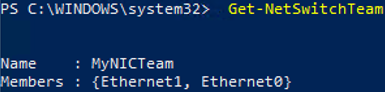

Проверьте, что в системе появился новый интерфейс NIC Teaming.

Get-NetSwitchTeam

Не забудьте задать для него сетевые настройки. Теперь у вас появился новый интерфейс с пропускной способностью 2 Гбит/с.

Для удаления созданной группы NIC Team, также нужно использовать PowerShell:

Remove-NetSwitchTeam -Name "MyNICTeam"

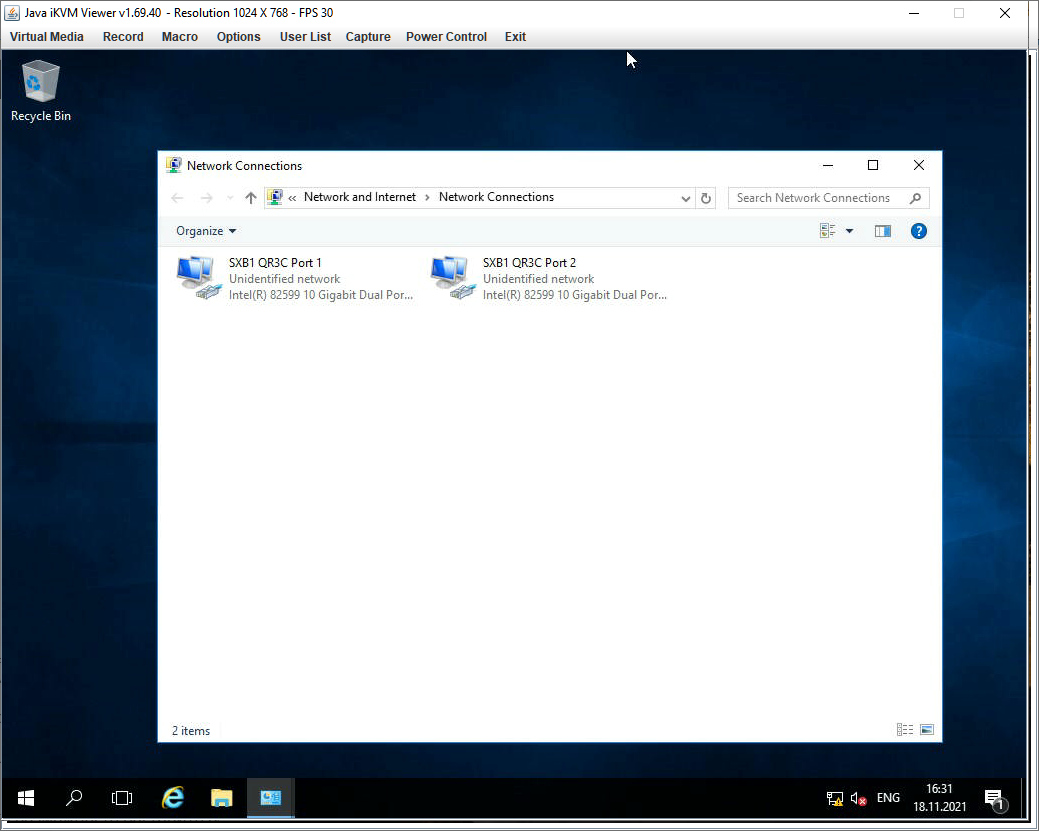

Агрегируем порты на двухпортовой 10G сетевухе сервера Supermicro SYS-1029P-WTRT штатными средствами операционной системы Windows Server 2016.

Имеется:

- Железный сервер Supermicro SYS-1029P-WTRT.

- На борту двухпортовая сетевуха AOC-STGN-i2S.

- ОС — Windows Server 2016.

- Есть возможность настроить порты коммутаторов. И агрегация портов на них уже настроена.

Ссылки

Supermicro AOC-STGN-i2S — обзор

Windows Server 2012 R2 — NIC Teaming

NIC Teaming в Windows

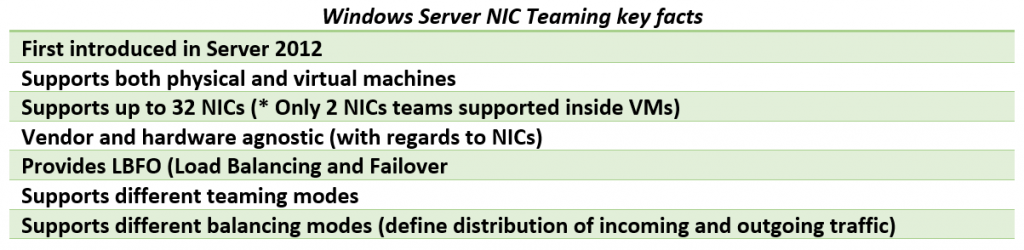

NIC Teaming или Load Balancing/Failover (LBFO) входит в Windows начиная с Windows Server 2012. Технология позволяет объединить в группу (team) до 32 сетевых адаптеров Ethernet. В группу можно объединять адаптеры разных производителей, условие — наличие цифровой подписи драйвера сетевухи. В группу можно объединять адаптеры одинаковой скорости.

Что даёт NIC Teaming:

- Отказоустойчивость на уровне сетевухи. Перестала работать одна — включается вторая. С точки зрения системного администрирования это позволяет админу перетыкать по очереди провода в стойке не опасаясь, что всё перестанет работать.

- Агрегирование полосы пропускания адаптеров. Один гигабит хорошо, а два ещё лучше.

- Вы можете использовать NIC Teaming не по назначению. Никто не запрещает в группу добавить только один адаптер и использовать NIC Teaming для разделения трафика по VLAN. Я не особо представляю для чего это может понадобиться. Возможно, для работы с виртуальными машинами или ещё для чего-то.

Teaming mode

Тут на ровном месте развели путаницы. Есть три режима:

- Зависимый от коммутатора (switch dependent) — статическая настройка коммутатора (IEEE 802.3ad draft v1).

- Зависимый от коммутатора (switch dependent) — Link Aggregation Control Protocol (LACP, IEEE 802.1ax).

- Независимый от коммутатора (switch independent) — есть возможность подключения к разным коммутаторам для обеспечения ещё большей отказоустойчивости.

Мы с вами сегодня полностью настроим LACP. А потом разберём его и переделаем на switch independent. Потому как iLO нам всю агрегацию портит.

Load balancing mode

Есть три режима балансировки:

- Hyper-V Port. Сделано для Hyper-V. Сетевуха привязывается к виртуалке.

- Address Hash. Хеш на основе отправителя и получателя:

- MAC адреса (для не IP трафика)

- IP адреса (для не TCP и UDP трафика)

- Порт — обычно.

- Dynamic.

Standby adapter

Есть возможность один из адаптеров назначить как резервный. Тогда трафик будет гоняться только через активный.

LACP

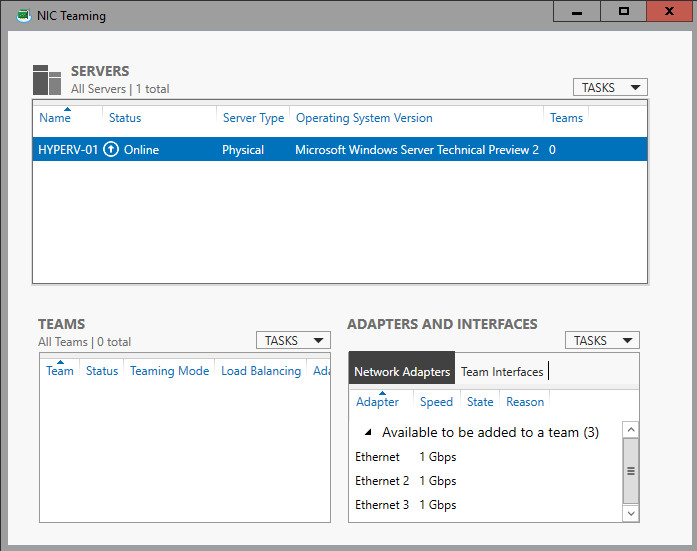

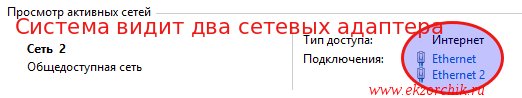

Давайте для примера настроим LACP. У нас есть два гигабитных физических адаптера. Винда их видит.

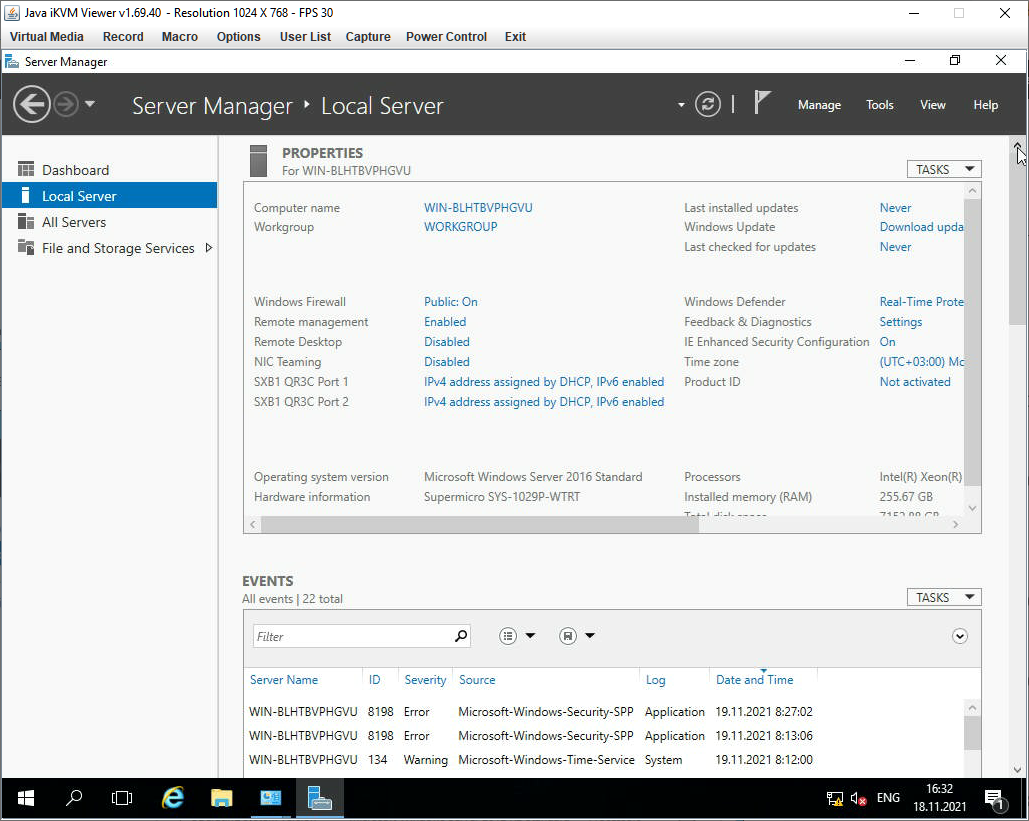

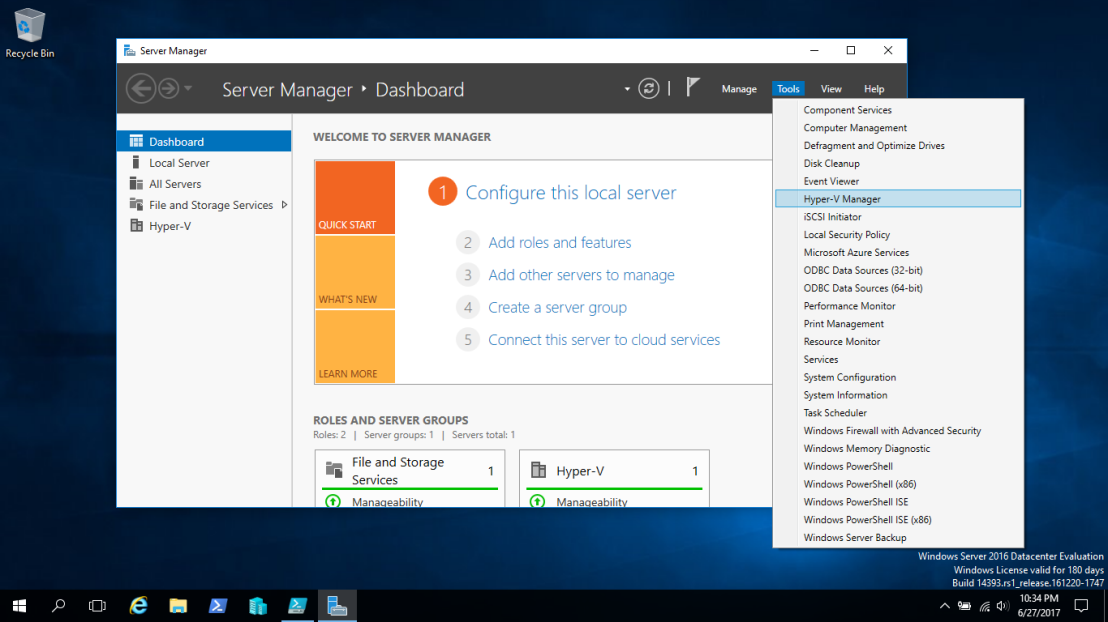

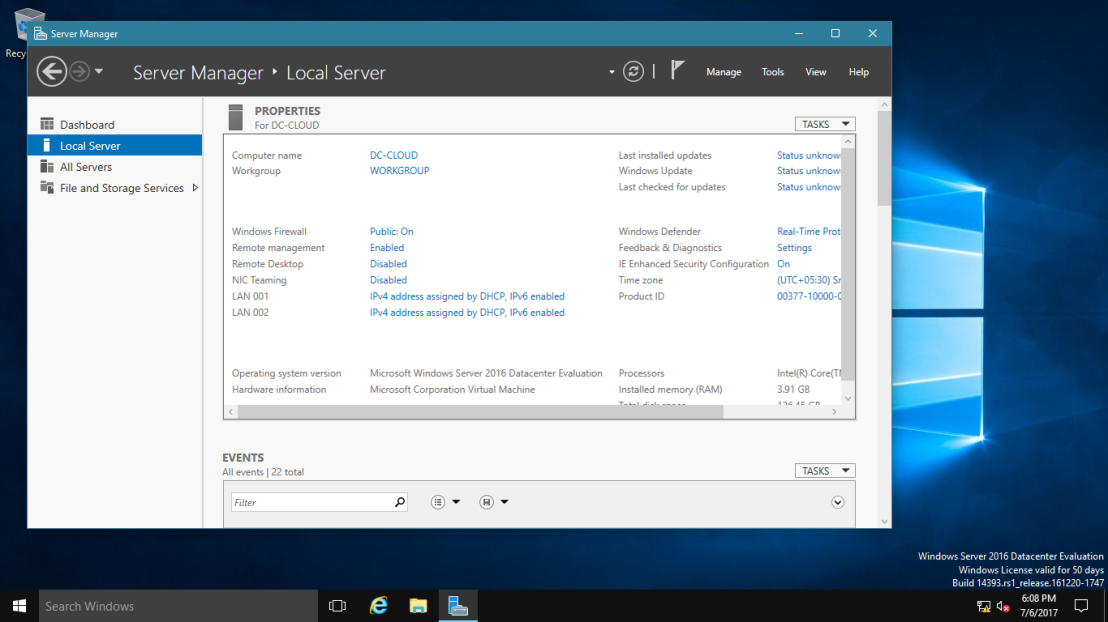

Открываем Server Manager > Local Server.

Видно, что сервер железный Supermicro SYS-1029P-WTRT. Видно ось, кстати, Standerd. Видно что обе сетевуха настроена по умолчанию на получение IP адреса по DHCP. Нас интересует раздел NIC Teaming — Disabled. Тыкаем в него.

Открывается окно NIC Teaming. Вверху выбираем сервер, он у нас один. Справа ниже видим две сетевухи, которые можно объединить в группу.

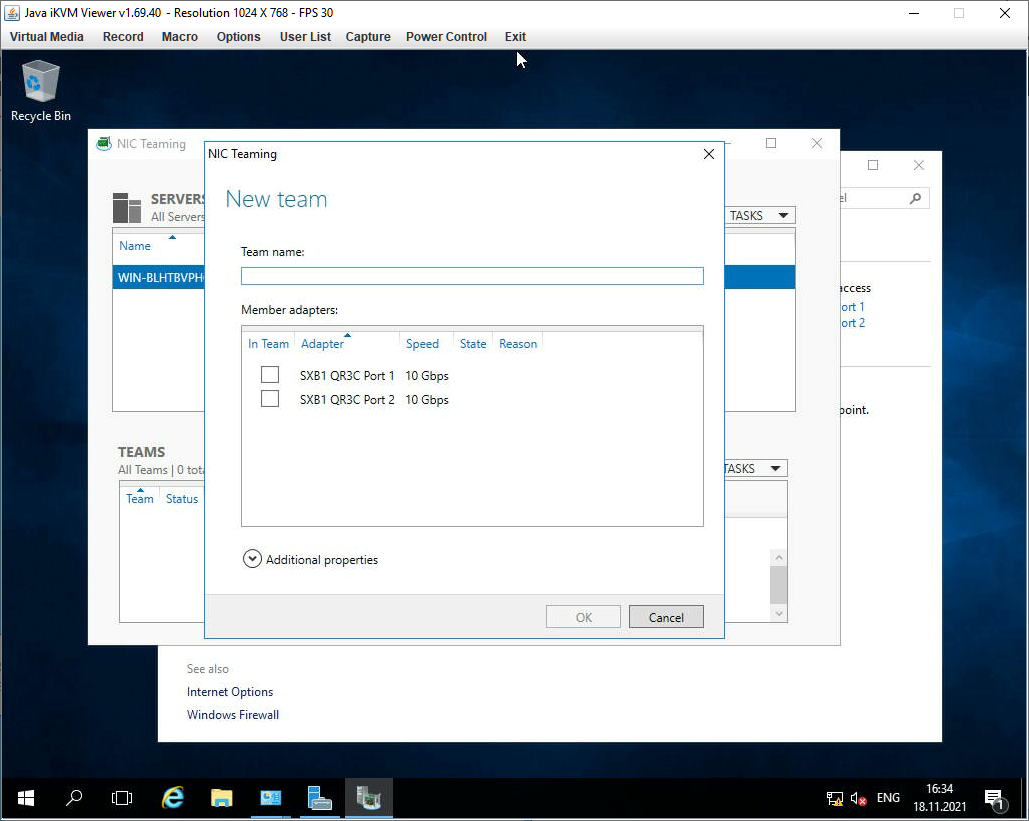

Слева ниже нажимаем в TASKS > New Team. Открывается окошко:

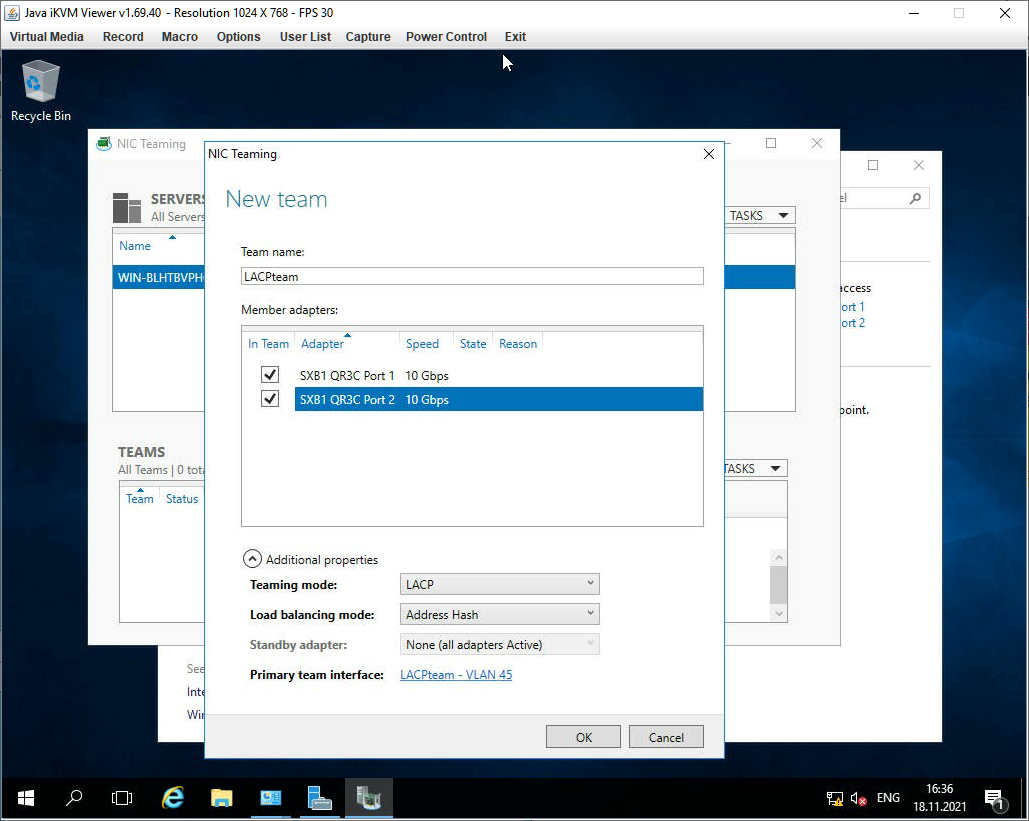

Указываем название группы, я пишу «LACPteam». Отмечаем галками адаптеры, которые объединяем в группу. У меня их всего два, оба и выделяю. Разворачиваем скрытый ниже раздел Additional properties.

- Teaming mode — LACP, его сейчас пробуем собрать.

- Load balancing mode — ставлю Address Hash.

- Standby adapter в режиме LACP не выбирается.

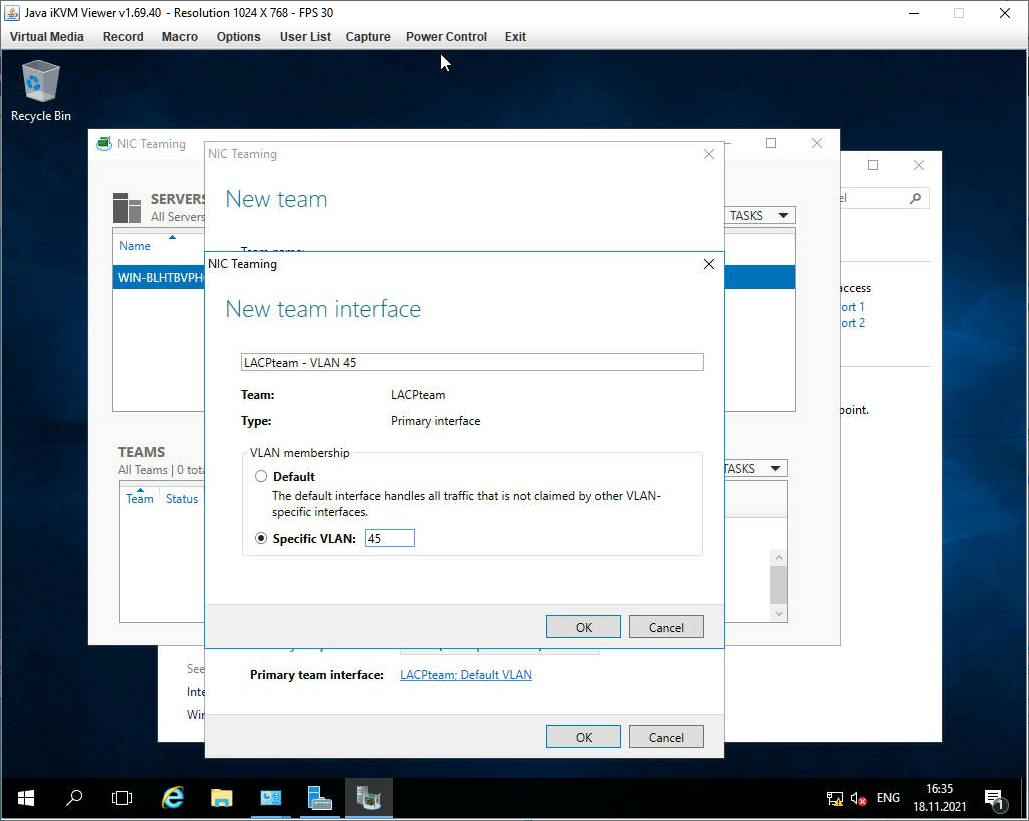

- Кликаем по ссылке Primary team interface:

У нас одна группа. Здесь мы можем только задать VLAN — пишем его при необходимости. OK.

Что-то вроде настроили. Тыкаем ОК. Побежал прогресс.

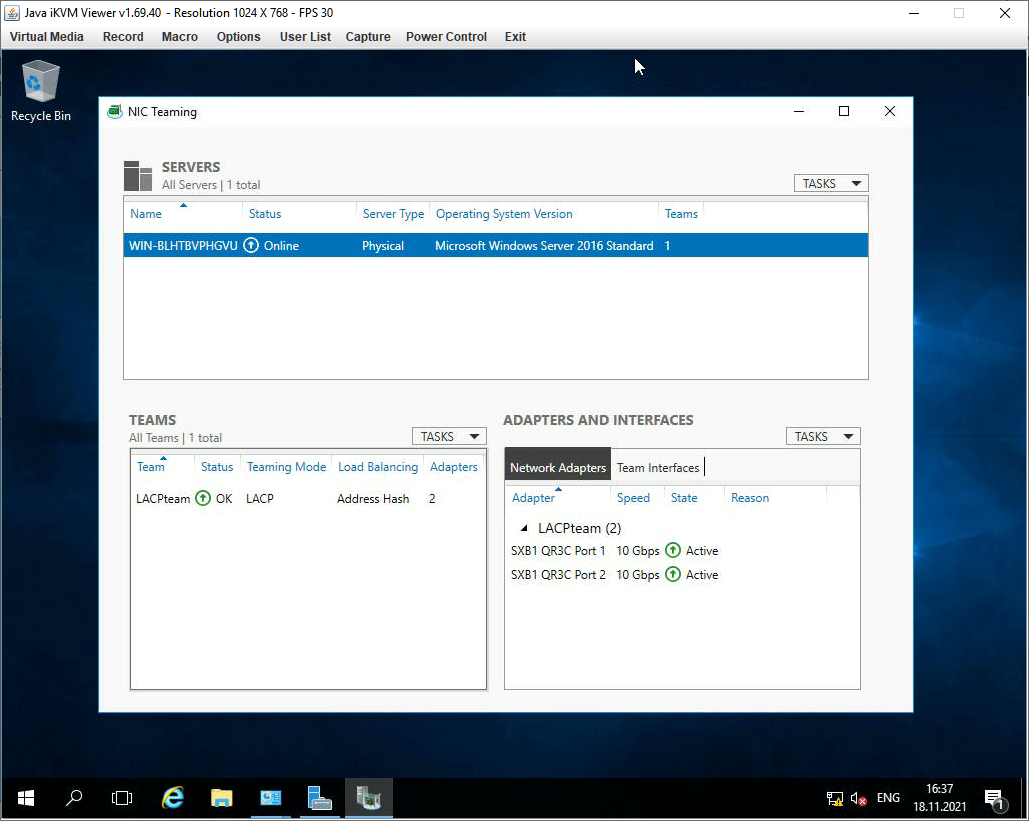

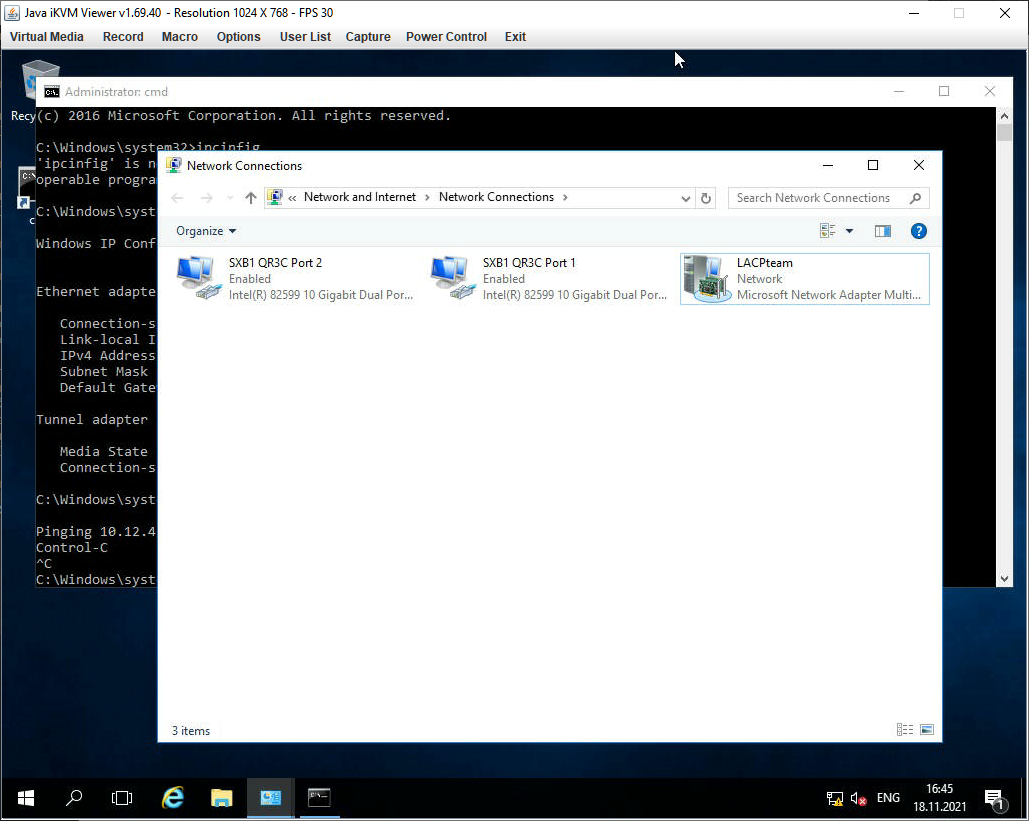

В окне NIC Teaming теперь видно группу. Обе сетевухи подцепились, т.к. на коммутаторе уже всё настроено. В списке сетевых адаптеров появляется новый — LACPteam — VLAN 45.

Сетевые наcтройки теперь нужно производить через него. Задаём их.

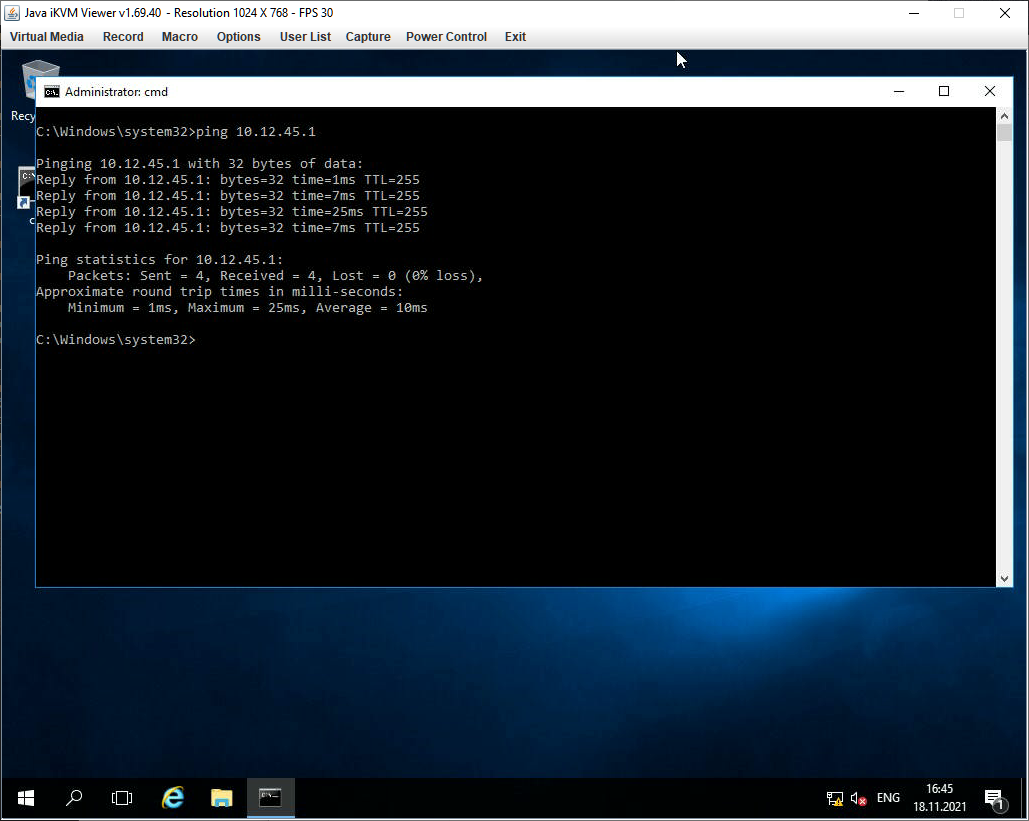

Ура, мы настроили агрегацию портов в Windows Server 2016!

Если VLAN не указывать, то новый адаптер будет называться LACPteam.

Прочитано:

5 350

Задача: Самостоятельно проработать, как поднять/организовать Nic Teaming средствами Windows Server 2016 в GUI составляющей. Ранее я уже делал, но использовал Windows Server 2008 R2, а тут хочу посмотреть также это все легко или есть определенные нюансы.

Итак, под Virtualbox развернута виртуальная система с осью на борту Windows Server 2016 Standard (Microsoft Windows [Version 10.0.14393]) с двумя сетевыми адаптерами.

Авторизуюсь в системе с правами, либо локального администратора, либо Администратора домена.

Win + R — cmd.exe с правами Администратора (Обязательно)

C:UsersАдминистратор>netsh interface teredo set state disabled

C:UsersАдминистратор>netsh interface isatap set state disabled

C:UsersАдминистратор>netsh interface 6to4 set state disabled

Чтобы сделать объединение сетевых интерфейсов в один для увеличения пропускной способности:

Win + R — control — Просмотр: Категория — Мелкие значки — Администрирование — Диспетчер серверов (ServerManager.exe) — Локальный сервер — по умолчанию настройка «Объединение сетевых карт» в состоянии «Отключено», щелкаю левой кнопкой мыши по настройке и перехожу в диалоговое окно «Объединение сетевых карт» (Приложение: LbfoAdmin.exe), в элементе «Группы» — «Задачи» — выбираю «Создать группу»

Имя группы: nic

и отмечаю галочками сетевые интерфейсы которые буду объединять, также нужно через «Дополнительные свойства» указать режим работы объединенных интерфейсов:

- Режим поддержки групп: LACP или «Динамически» (но на коммутаторе куда подключен также нужно будет сделать объединение интерфейсов и назначить роль lacp)

- Режим балансировки нагрузки: → может принимать: Хэш адреса, Порт Hyper-V, Динамический, т. к. я не использую Hyper-V то и не указываю, а выбираю «Хэш адреса» это Вычисление хэша на основе портов позволяет распределять трафик более равномерно. Однако для трафика отличного от TCP или UDP применяется хэш на основе IP-адреса, для не IP-трафика – хэш на основе MAC-адресов.

- Резервный адаптер: выставлено и затемнено мастером «Нет (Все адаптеры активны)». Если не указывать LACP, то можно сделать если линк на одном адаптере пропадает на его место встает другой.

Основной групповой интерфейс: nic (виртуальная локальная сеть по умолчанию)

и нажимаю кнопку «ОК»

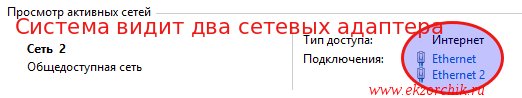

Итого объединение интерфейсов в системе сформировано:

В случае если линк обрывается на одном сетевом интерфейсе, доступ к системе Вы не теряете.

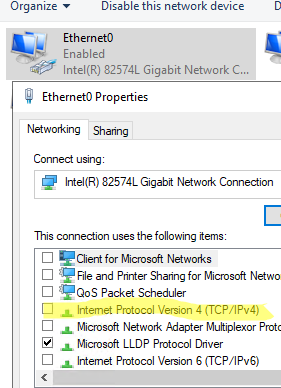

Если обратить внимание на свойства первого и второго сетевого адаптера, то у них выставлена всего лишь одна настройка «Протокол мультиплексора сетевого адаптера», а у нового с именем группы nic:

- Клиент для сетей Microsoft

- Общий доступ к файлам и принтерам

- Планировщик пакетов QoS

- Microsoft Load Balancing/Failower Provider

- IP версии 4 (TCP/IPv4)

- IP версии 6 (TCP/IPv6) — снимаю галочку, так как не использую во всей сети.

- Отвечающее устройство обнаружение топологии (делает компьютер видимым в сети)

Ответчик обнаружения топологии канального уровня (используется для обнаружения других компьютеров, устройств и компонентов в сети).

Смотрю текущие настройки сети от DHCP—сервиса в локальной сети:

Win + R — cmd.exe с правами Администратора (Обязательно)

C:UsersАдминистратор>ipconfig

Настройка протокола IP для Windows

Адаптер Ethernet nic:

DNS-суффикс подключения . . . . . :

IPv4-адрес. . . . . . . . . . . . : 172.40.40.6

Маска подсети . . . . . . . . . . : 255.255.255.0

Основной шлюз. . . . . . . . . : 172.40.40.1

Как видно, сетевой адрес получает лишь общий интерфейс, а не вспомогательные.

На заметку: Если Ваши наблюдения показываю, что объединение интерфейсов требуют изменения, то все также через оснастку «Объединения сетевых карт» можно поменять настройки. Вот только желательно это делать имея к системе еще один вид подключения, к примеру консоль Hyper-V, vSphere Client, iDRAC, IPMI и т. д. Чтобы если что не остаться у разбитого корыта и подстраховаться.

На заметку: Если физическое железо может на уровне железа объединять интерфейсы или использует специализированное программное обеспечение, то лучше делать через него, чем средствами Windows, а если не хочется от него зависить, то средствами операционной системы и не важно Windows это или Linux.

Вот на этом я прощаюсь, как я мог убедиться нет ничего сложно в настройке объединения сетевых карт в системе Windows Server 2016. Если у меня буду какие-либо дополнения и наблюдения, то я постараюсь отразить их в этой заметке. А пока у меня всё, с уважением автор блога Олло Александр aka ekzorchik.

Table of Contents

- Summary

- Steps

- LACP Mode

- Address Hash Mode

- Cisco Switch Port-Channel Configuration

- Conclusion

- References

Summary

Network Teaming is one of important part in infrastructure when we need High Availability in networking. NIC Teaming allows you to group between 1 to 32 physical Ethernet network adapters into one or more software-based virtual

network adapters. These virtual network adapters provide fast performance and fault tolerance in the event of a network adapter failure. NIC Team member network adapters must all be installed in the same physical host computer to be placed in a team. In Cisco

language its called Port-Channel, in Linux language its called Network Bonding and in Microsoft language we call it NIC Teaming.

Most of the administrator face the issue in configuring NIC Teaming at the other side which is Cisco switch. In this article, we will address both side configuration involved in setting up NIC Teaming.

Steps

First, we need to have a look at the NIC of the VM or a physical server if it is a physical Server.

We have two NICs on Windows Server 2016. You can rename them as you like.

Go to Server Manager and click Local Server, and click Disabled. By default NIC Teaming is disabled when you install your operating system.

Click TASKS and click New Team

Here we need to provide any Name of the Team as per your environment and select both NIC cards.

The Teaming mode will be LACP because we will configure LACP at Cisco Switch side as well, so both sides should have the same Teaming mode.

LACP Mode

LACP stands for Link Aggregation Control Protocol and essentially it is the more dynamic version of switch dependent teaming means that with if you configure the switch rather than individual ports. Once the switch is configured

it becomes aware about your network team and handles dynamic negotiation of the ports. Also called dynamic teaming and based on IEEE 802.1ax, this mode is supported by most enterprise-class switches and allows automatic creation of a team using the Link Aggregation

Control Protocol (LACP), which dynamically identifies links between the server and a specific switch. To use this mode, you generally need to enable LACP manually on the port of the switch.

Address Hash Mode

It uses attributes of network traffic (IP address, port and MAC address) to determine to which specific NIC traffic should be sent.

You can see the status of NIC Team up and running, for this configuration we have both NIC in active/active mode. You can add more NIC to the Team as per your need and requirement of the scenario.

We can analyze NIC Team statistics sent/received packets.

In network properties, we can see the NIC Team icon and its speed showing as 2.0 Gbps, as we have combined both NIC having 1 GB each through NIC Teaming.

Cisco Switch Port-Channel Configuration

At this point we have complete the configuration involved in NIC Teaming, this is time to configure the Cisco Switch side so that both sides can be synchronized. If you have Switch access, you should know about the connected ports

of your Server so that you can configure the same LACP port-channel in switch side.

This Server NIC 0 is connected with Switch port 1/0/18 and NIC 1 is connected with Switch port 2/0/18, In this environment, we have two switches configured as a stack so we have to use one port from each switch to make a port channel.

This design will also provide us Switch level redundancy.

After login into the Switch simply paste these commands in a switch and save the configuration. You can check the status after a while at Server side it will be synchronized.

Core-SW#conf t

Core-SW(config)#interface port-channel18

Core-SW(config)#interface gigabitEthernet1/0/18

Core-SW(config-if)#channel-group18mode passive

Core-SW(config)#interface gigabitEthernet2/0/18

Core-SW(config-if)#channel-group18mode passive

Save the configuration and exit.

Conclusion

As we have configured NIC Teaming in Windows Server 2016 and other side switch configuration required for the port-channel. We have aggregated the ports as both ports active, you can configure active/standby as well you want

failover between the ports.

References

- NIC Teaming Overview

- https://gallery.technet.microsoft.com/Windows-Server-2016-839cb607

- https://docs.microsoft.com/en-us/powershell/module/netlbfo/?view=win10-ps

- https://technet.microsoft.com/fr-fr/library/jj130849(v=wps.630).aspx

Предыстория…

В текущем исполнении у нас два контроллера домена:

— Primary AD железный (достаточно старый еле ползущий сервак HP, от которого мы планировали избавиться)

— Secondary AD виртуальный (уже все как положено, быстрый на Windows 2012).

Некоторое время назад, столкнулись с интересной проблемой:

Судя по логам, в пятницу вечером, «воткнул» основной контроллер. Не просто «воткнул» полностью, а «воткнул» как-то странно (продолжал пинговаться, но войти удаленно на него уже было нельзя и свою роль он уже также не выполнял). Вроде воткнул и воткнул, есть же второй контроллер. Но в воскресенье днем пропала доменная авторизация на всех устройствах, хотя второй контроллер был вроде как доступен. А далее интересный момент. Как только пропала авторизация, второй контроллер перестал удаленно пускать в систему по RDP, решили посмотреть, что происходит с ним через Vcenter, но тут тоже нас ждал «отлуп», авторизация также не проходила, а самое интересное никак невозможно было попасть на виртуальный второй контроллер. Получился некий замкнутый круг: PDC в «дауне», а что случилось с SDC, тоже невозможно посмотреть и понять, что с ним происходит.

Соответственно все виртуальные сервера продолжали работать, но уже не так хорошо, как были должны. Впервые за свою практику, столкнулся с похожей ситуацией.

Далее пошли по следующему пути:

— Ребутнули железный PDC, он благополучно перезагрузился и поднялся, стал работать по-прежнему, как надо, но репликации со вторым контроллером так и не появилось. Это нам говорило о том, что второй контроллер хоть и пингуется, но тоже в анабиозе.

— Далее авторизуемся локально на Vcenter понимаем на каком хосте крутится SDC, далее уже принудительно ребутаем SDC, он благополучно поднимается, поднимается репликация с PDC, но авторизация на всех остальных (файл-серверах, терминальных серверах и прочих серверах…), так и не работает.

— Пришлось принудительно перезагрузить все виртуальные сервера, чтоб полноценно восстановить работу и вернуть их в строй.

Неприятный момент.

До этого случая планировали приобрести более быстрый железный сервак и смигрировать, текущий PDC на него, а вот после него, пересмотрели свое первоначальное решение: PDC на новый смигрируем (перенесем роли и прочие дела), а избавляться от второго железного сервера пока не будем, оставим его третьим контроллером.

Наконец наш новый сервер DELL уже в стойке, Windows Server 2016 уже «залит», пришло время поэтапно приступить к поднятию третьего контроллера и дальнейшему PDC переносу на него.

Но сначала для отказоустойчивости имеет смысл объединить сетевые порты:

Соответственно из разных сетевых портов сервера включаем шнурки в разные коммутаторы, на этих портах коммутаторов, включаем LACP.

На втором аналогично.

Далее, переходим непосредственно к серверу.

По умолчанию режим NIC Teaming в Windows server 2016 (в 2012 аналогично) отключен. Для его активации открываем Server Manager и видим, что это действительно так.

В Задачах (Tasks) выбираем пункт Создать группу (New Team).

Далее именуем группу, выбираем отмечаем адаптеры и настраиваем дополнительные свойства группы.

Имеет смысл сказать несколько слов о дополнительных параметрах настройки NIC Teaming в Windows server 2016:

Режим поддержки групп (Teaming mode) определяет режим взаимодействия группы с сетевым оборудованием:

1. Не зависит от коммутатора (Switch Independent) — группа работает независимо от коммутатора, никакой дополнительной настройки сетевого оборудования не требуется. Этот режим позволяет подключать адаптеры одной тиминговой группы к разным свичам для защиты от сбоя одного из них. настройка по умолчанию;

2. Статическая поддержка групп (Static Teaming) — режим с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору. Порты коммутатора, к которым подключены адаптеры группы, настраиваются на использование статической агрегации каналов;

3. LACP — режим с зависимостью от сетевого оборудования. Коммутатор настраивается на использование динамической агрегации каналов с использованием протокола Link Aggregation Control Protocol (LACP).

Режим балансировки нагрузки (Load Balancing mode) определяет, каким образом распределять сетевой трафик между адаптерами группы:

1. Хэш адреса (Address Hash) — при передаче сетевого трафика на основании MAC или IP-адресов отправителя и получателя вычисляется хеш (некое число). Это число привязывается к определенному физическому адаптеру и в дальнейшем весь трафик от этого отправителя будет идти через этот адаптер;

2. Порт Hyper-V (Hyper-V Port) — в этом режиме осуществляется привязка адаптера teaming группы к определенному порту виртуального свича в Hyper-V. Этот режим используется в том случае, если на сервере активирована роль Hyper-V.

Резервный адаптер (Standby adapter) позволяет назначить один из адаптеров группы в качестве резервного. В нормальном состоянии резервный адаптер не используется для передачи трафика, но при выходе любого адаптера группы из строя сразу занимает его место и трафик продолжает передаваться без перерывов. Но даже без резервирования выход из строя одного адаптера в NIC Teaming не приведет к прерыванию сетевого соединения, потому что, нагрузка будет автоматически распределена по оставшимся адаптерам.

Тоже самое можно сделать и через PowerShell:

New-NetLbfoTeam -Name LACP -TeamMembers ″Ethernet″,″Ethernet 2″ ` -TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

Далее в окне «Сетевые подключения» появиться еще один сетевой адаптер, который как раз и является виртуальным адаптером созданной группы.

При необходимости все это можно удалить:

Или через PowerShell: Remove-NetLbfoTeam -Name LACP

Порты объединены, можно будет приступить к следующим этапам, но это уже тема последующих постов…

Всем хорошей работы!!!

28.03.2018 —

Posted by |

ms windows server 2016

Sorry, the comment form is closed at this time.

NIC Teaming (or Load Balancing/Failover – LBFO, or NIC bonding) allows joining multiple physical network adapters (NICs) into a single logical network card. In this article, we’ll show how to configure NIC Teaming on Windows Server 2019/2016/2012R2 and on Windows 10/11 desktop computers.

Contents:

- Configuring a NIC Teaming on Windows Server 2019

- How to Create NIC Teaming on Windows Server with PowerShell?

- How to Enable NIC Teaming on Windows 10 and 11?

Why may you need to combine multiple network adapters into a NIC Team?

- Increase throughput. For example, by joining two 1GB network cards into a NIC Team, you will get a 2Gbit/s bandwidth on a logical adapter;

- Manage network card load balancing. You can balance the network traffic across active NICs.

- Fault tolerance. If any of your network cards in a NIC Team fails, the rest cards take their functions and the connection with the server is not interrupted. For critical servers, the mechanism protects a service against downtime if a network switch or an Ethernet port on it fails, or if a network cable (connecting your host and switch) is damaged. To implement this feature, it is enough to connect network cards to different physical switches.

In Windows Server 2022/2019/2016/2012R2, NIC Teaming is not compatible with Single-Root I/O Virtualization (SR-IOV), TCP Chimney, and Remote Direct Memory Access (RDMA).

Configuring a NIC Teaming on Windows Server 2019

You can configure NIC Teaming on Windows Server 2012 or newer. Let’s see how to combine multiple network adapters into a NIC Team interface on Windows Server 2019. NIC Teaming is disabled by default on Windows Server.

To enable it, open the Server Manager, select Local Server, and click NIC Teaming: Disabled in its properties.

In the next window, select Tasks -> New Team in the left bottom pane.

Then enter a Team name and select the network adapters you want to add to the group.

In Windows Server 2019, you can add up to 32 physical network adapters to a NIC Team. The only requirement is the same connection speed on the team adapters.

You can select special team options. The options set NIC Teaming rules and performance. Let’s take a closer look at these settings.

Teaming Mode. The option sets how the group interacts with the network switches:

- Static Teaming (IEEE 802.3ad) is a static operation mode depending on your network hardware. All team adapters must be connected to the same switch, which Ethernet ports are configured to use static channel aggregation (additional switch configuration is required);

- Switch Independent (a default mode) — the NIC Team works independently of the switch; no additional configuration of network hardware is needed. If this mode is on, you can connect different network adapters to different switches to improve fault tolerance (protection against switch failure);

- LACP (Link Aggregation Control Protocol, LACP, IEEE 802.1ax) is the mode that depends on your network hardware as well. You need to enable and configure the dynamic link aggregation using the LACP on your switch.

Load Balancing mode sets how network traffic is distributed between NICs in the team.

- Address Hash — a special hash is assigned to each physical adapter (based on sender and recipient MAC or IP addresses). All traffic from a specific sender will go through this NIC;

- Hyper-V Port — you can use this mode on a server with the Hyper-V role. It allows you to bind an adapter from your NIC Team to a specific port on a Hyper-V virtual switch;

- Dynamic is a default option combining both load balancing types.

You can make one of the adapters in the group a Standby adapter. In a normal operation mode, this NIC is not used to process traffic. If any other adapter in your NIC Team fails, it will be replaced by a standby one. Actually, if this function is not enabled, there will be no service downtime when any network adapter fails, since its load will be automatically distributed among other cards in the group.

Select the settings you need, click OK and a new NIC Team will be created.

Open the list of network connections in the Control Panel. Make sure that a new device labeled Microsoft Network Adapter Multiplexor Driver (it has a different icon) has appeared. This is the NIC Teaming virtual adapter.

Further configuration of the network card (protocols, IPv4/v6 address) is performed in the properties of the NICTeam adapter.

Network adapters that you add to a NIC group will no longer have their own IP addresses.

If you remove a NIC Team, the previous network adapter settings will be restored.

Later you can add or remove network adapters to your NIC Team.

You can use the NIC Teaming to configure multiple VLAN interfaces on Windows Server. To do it, you can even create a NIC Teaming group from a single network adapter.

How to Create NIC Teaming on Windows Server with PowerShell?

You can create and manage NIC Teams both through the Windows graphical interface and PowerShell. PowerShell can be used to set up NIC Teaming on Windows Server Core.

You can use the built-in NetLbfo module on Windows Server to manage NIC Teaming. Display a list of network adapters on your server:

Get-NetAdapter

Create a new Team0 from the adapters named Ethernet1 and Ethernet3. Select NIC Teaming mode: Switch Independent with dynamic load balancing.

New-NetLbfoTeam -Name Team0 -TeamMembers Ethernet1,Ethernet3 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm Dynamic

Available options:

- TeamingMode: Static SwitchIndependent, Lacp

- LoadBalansingAlgorithm: TransportPorts, IPAddresses, MacAddresses, HyperVPort, Dynamic

To get information about NIC Teams on a server, use the command below:

Get-NetLbfoTeam

Name : Team0

Members : {Ethernet3, Ethernet1}

TeamNics : Team0

TeamingMode : SwitchIndependent

LoadBalancingAlgorithm : Dynamic

Status : Up

You can use PowerShell to configure an IP address of your NIC Teaming interface and other network settings:

New-NetIPAddress -InterfaceAlias team0 -IPAddress 192.168.13.100 -PrefixLength 24 -DefaultGateway 192.168.13.1

Set-DnsClientServerAddress -InterfaceAlias team0 -ServerAddresses 192.168.13.10

Run the Get-NetAdapter command. Note that the LinkSpeed of the NIC Teaming network adapter is 2 Gbit/s.

To change the NIC Teaming group settings, use the NetLbfoTeam cmdlet:

Set-NetLbfoTeam -Name Team0 -TeamingMode LACP

If you run this command in a VM, the following error appears:

Set-NetLbfoTeam : 'SwitchIndependent' is the only TeamingMode value supported in a Virtual Machine

To add an additional VLAN interface via NIC Teaming, run the command below:

Add-NetLbfoTeamNIC -Team Team0 -VlanID 44

You can remove a NIC Team using this command:

Remove-NetLbfoTeam -Name Team0

How to Enable NIC Teaming on Windows 10 and 11?

You can use NIC Teaming to combine network adapters both in Windows Server and in desktop versions of Windows 10 and 11. The main thing is that your network card must support Link aggregation, NIC teaming, or LBFO.

For example, NIC Teaming works out of the box with Realtek PCIe GbE Family Controller (10.35.510.2019) or Intel(R) 82574L Gigabit Network Adapter.

To create a NIC Team on Windows 10 (in this example, it is Windows 10 20H2), open your PowerShell console and list network adapters:

Get-NetAdapter

Let’s create a NIC Team of Ethernet0 and Ethernet1 adapters.

New-NetSwitchTeam -Name "MyNICTeam" -TeamMembers "Ethernet0","Ethernet1"

Make sure that a new NIC Teaming interface has appeared on the computer:

Get-NetSwitchTeam

Don’t forget to set its network settings. Now you have got a new 2 Gbit/s interface.

To remove a NIC Team, use PowerShell:

Remove-NetSwitchTeam -Name "MyNICTeam"

Технология NIC Teaming (или Load Balancing/Failover – LBFO, или NIC bonding) позволяет объединить несколько физических сетевых адаптеров (NIC) в одну логическую сетевую карту. В этой статье мы рассмотрим, как настроить NIC Teaming в Windows Server 2019/2016/2012R2 и в десктопых версиях Windows 10 и 11.

Содержание:

- Настройка NIC Teaming в Windows Server 2019

- Используем PowerShell для настройки NIC Teaming в Windows Server

- Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Для чего может понадобится объединять сетевые адаптеры в группу NIC Teaming?

- Увеличение пропускной способности. Например, объединив две сетевые 1 Гб сетевые карты в одну группу NIC Teaming, вы получите общую полосу пропускания на логическом адаптере 2 Гбит/с;

- Управление балансировкой нагрузки на сетевые карты – можно управлять распределением трафика между NIC сервера;

- Отказоустойчивость – при выходе из строя любой из сетевых карт, добавленных в группу NIC teaming, остальные подхватывают ее функции, и связь с сервером не прерывается. Для критически важных серверов этот механизм может защитить от простоя сервиса во время выхода из строя сетевого коммутатора или Ethernet порта на нем, сетевого кабеля (которым ваш хост подключен к коммутатору). Для реализации такой возможности, достаточно подключить сетевые карты в разные физические коммутаторы.

В Windows Server 2012R2/2016/2019/2022 технология NIC Teaming не совместима с Single-root I/O virtualization (SR-IOV), TCP Chimney и Remote Direct Memory Access (RDMA).

Вы можете настроить NIC Teaming в Windows Server начиная с версии 2012. Рассмотрим, как объединить несколько сетевых адаптеров в Windows Server 2019 в одну группу NIC Teaming. Режим NIC Teaming по умолчанию отключен в Windows Server.

Чтобы включить его, откройте консоль Server Manager, выберите локальный сервер (Local Server) и в его свойствах выберите пункт “NIC Teaming: Disabled“.

В появившемся окне в левой нижней панели выберите пункт Tasks -> New Team (Создать группу).

Далее нужно указать имя группы (Team Name) и выбрать сетевые адаптеры, которые будут входить в эту группу.

В Windows Server 2019 в одну NIC Teaming групп можно объединить до 32 физических сетевых адаптеров, главное, чтобы они работали на одной скорости.

Ниже можно настроить специальные параметры группы. От данных параметров зависит правила и эффективность NIC Teaming. Рассмотрим эти настройки подробнее.

Режим поддержки групп (Teaming Mode). Данный параметр определяет способ взаимодействия группы с сетевым оборудованием (коммутатором)

- Static Teaming (IEEE 802.3ad)— статический режим работы с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору, Ethernet порты которого настроены на использование статической агрегации каналов (требуется настройка на коммутаторе);

- Switch Independent (режим по-умолчанию) – группа работает независимо от коммутатора, для реализации не нужно дополнительно настраивать сетевое оборудование. В этом режиме разные сетевые адаптеры группы можно подключить к разным коммутаторам для повышения отказоустойчивости (защита от сбоев в коммутаторах);

- LACP (Link Aggregation Control Protocol, LACP, IEEE 802.1ax) – режим также зависит от сетевого оборудования. Нужно включить и настроить на коммутаторе динамическую агрегацию каналов по протоколу LACP.

Режим балансировки нагрузки (Load Balancing mode) – задает как распределяется сетевой трафик по NIC в группе.

- Address Hash — для каждого из адаптеров вычисляется специальный хэш (на основании MAC или IP-адресов отправителя и получателя) и привязывается определенному физическому адаптеру. Весь трафик от данного отправителя будет идти через этот NIC;

- Hyper-V Port — режим можно использовать для сервера с ролью Hyper-V. Позволяет привязать конкретный адаптер группу NIC teaming к конкретному порту на виртуальном коммутаторе Hyper-V;

- Dynamic – опция по умолчанию, совмещает оба типа балансировки нагрузки.

Один из адаптеров в группе можно назначить резервным (Standby adapter). В обычном режиме работы данная NIC не используется для передачи трафика. При неполадке на любом другом адаптере в группе NIC Teaming, он тут-же занимает его место. В общем случае и без данной функции при выходе из строя любой сетевой карты, не будет простоя сервиса, т.к. ее нагрузка автоматически распределится между оставшимися картами в группе.

Выберите нужные параметры, нажмите ОК и новая группа Nic Teaming будет создана.

Откройте список сетевых подключения в панели управления Windows. Убедитесь, что в Windows Server появился новый сетевой адаптер Microsoft Network Adapter Multiplexor Driver (его иконка немного отличается). Это и есть виртуальный адаптер группы NIC Teaming.

Дальнейшая настройка параметров сетевой карты (протоколы, IPv4/v6 адрес) осуществляется теперь в свойствах этого адаптера.

У всех остальных сетевых адаптеров, которые вы добавили в группу NIC Teaming уже не будет собственных IP адресов.

При удалении группы NIC Teaming предыдущие настройки сетевых адаптеров восстанавливаются.

В дальнейшем вы можете добавить или удалить сетевые адаптеры в группу NIC Teaming.

Вы можете использовать группу NIC Teaming для настройки нескольких VLAN интерфейсов в Windows Server. Для этого можно даже создать группу NIC Teaming из одного сетевого адаптера.

Используем PowerShell для настройки NIC Teaming в Windows Server

Вы можете создавать и управлять группами NIC Teaming не только из графического интерфейса Windows, но и с помощью PowerShell. Вы можете использовать PowerShell для настройки NIC Teaming в Windows Server Core

В Windows Server для управления MIC Teaming есть встроенный модуль NetLbfo. Выведите список сетевых адаптеров на сервере:

Get-NetAdapter

Создайте новую группу с Team0 из адаптеров с именами Ethernet1 и Ethernet3. Выберите режим работы NIC Teaming: Switch Independent с динамической балансировкой.

New-NetLbfoTeam -Name Team0 -TeamMembers Ethernet1,Ethernet3 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm Dynamic

Доступные параметры:

- TeamingMode:

Static

,

SwitchIndependent

,

Lacp - LoadBalansingAlgorithm:

TransportPorts

,

IPAddresses

,

MacAddresses

,

HyperVPort

,

Dynamic

Информацию о группах NIC Teaming на сервере можно вывести с помощью команды:

Get-NetLbfoTeam

Name : Team0

Members : {Ethernet3, Ethernet1}

TeamNics : Team0

TeamingMode : SwitchIndependent

LoadBalancingAlgorithm : Dynamic

Status : Up

Можно настроить IP адрес интерфейса NIC Teaming с помощью PowerShell:

New-NetIPAddress -InterfaceAlias team0 -IPAddress 192.168.13.100 -PrefixLength 24 -DefaultGateway 192.168.13.1

Set-DnsClientServerAddress -InterfaceAlias team0 -ServerAddresses 192.168.13.10

Выполните команду

Get-NetAdapter

. Обратите внимание, что LinkSpeed сетевого адаптера группу NIC Teaming — 2 Гбит/с.

Чтобы изменить настройки группы NIC Teaming используется командлет Set-NetLbfoTeam:

Set-NetLbfoTeam -Name team0 -TeamingMode LACP

Если выполнить эту команду в ВМ, появится ошибка

Set-NetLbfoTeam : 'SwitchIndependent' is the only TeamingMode value supported in a Virtual Machine

Чтобы через NIC Teaming добавить отдельный VLAN интерфейс, используйте команду:

Add-NetLbfoTeamNIC -Team Team0 -VlanID 10

Удалить группу NIC Team можно командой:

Remove-NetLbfoTeam -Name Team0

Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Вы можете использовать NIC Teaming для объединения сетевых карт не только в Windows Server, но и в клиентских версиях Windows 10 и 11. Главное, чтобы производитель вашей сетевой карты поддерживал для нее режим Link aggregation / NIC teaming/ LBFO.

Например, NIC Teaming работает из коробки с драйверами картами Realtek PCIe GbE Family Controller ( 10.35.510.2019) или Intel(R) 82574L Gigabit Network Connection.

Чтобы собрать группу NIC Teaming в Windows 10 (в этом примере это Windows 10 20H2), откройте консоль PowerShell и выведите список сетевых адаптеров:

Get-NetAdapter

Соберем группу NIC Team из адаптеров Ethernet0 и Ethernet1.

New-NetSwitchTeam -Name "MyNICTeam" -TeamMembers "Ethernet0","Ethernet1"

Проверьте, что в системе появился новый интерфейс NIC Teaming.

Get-NetSwitchTeam

Не забудьте задать для него сетевые настройки. Теперь у вас появился новый интерфейс с пропускной способностью 2 Гбит/с.

Для удаления созданной группы NIC Team, также нужно использовать PowerShell:

Remove-NetSwitchTeam -Name "MyNICTeam"

Агрегируем порты на двухпортовой 10G сетевухе сервера Supermicro SYS-1029P-WTRT штатными средствами операционной системы Windows Server 2016.

Имеется:

- Железный сервер Supermicro SYS-1029P-WTRT.

- На борту двухпортовая сетевуха AOC-STGN-i2S.

- ОС — Windows Server 2016.

- Есть возможность настроить порты коммутаторов. И агрегация портов на них уже настроена.

Ссылки

Supermicro AOC-STGN-i2S — обзор

Windows Server 2012 R2 — NIC Teaming

NIC Teaming в Windows

NIC Teaming или Load Balancing/Failover (LBFO) входит в Windows начиная с Windows Server 2012. Технология позволяет объединить в группу (team) до 32 сетевых адаптеров Ethernet. В группу можно объединять адаптеры разных производителей, условие — наличие цифровой подписи драйвера сетевухи. В группу можно объединять адаптеры одинаковой скорости.

Что даёт NIC Teaming:

- Отказоустойчивость на уровне сетевухи. Перестала работать одна — включается вторая. С точки зрения системного администрирования это позволяет админу перетыкать по очереди провода в стойке не опасаясь, что всё перестанет работать.

- Агрегирование полосы пропускания адаптеров. Один гигабит хорошо, а два ещё лучше.

- Вы можете использовать NIC Teaming не по назначению. Никто не запрещает в группу добавить только один адаптер и использовать NIC Teaming для разделения трафика по VLAN. Я не особо представляю для чего это может понадобиться. Возможно, для работы с виртуальными машинами или ещё для чего-то.

Teaming mode

Тут на ровном месте развели путаницы. Есть три режима:

- Зависимый от коммутатора (switch dependent) — статическая настройка коммутатора (IEEE 802.3ad draft v1).

- Зависимый от коммутатора (switch dependent) — Link Aggregation Control Protocol (LACP, IEEE 802.1ax).

- Независимый от коммутатора (switch independent) — есть возможность подключения к разным коммутаторам для обеспечения ещё большей отказоустойчивости.

Мы с вами сегодня полностью настроим LACP. А потом разберём его и переделаем на switch independent. Потому как iLO нам всю агрегацию портит.

Load balancing mode

Есть три режима балансировки:

- Hyper-V Port. Сделано для Hyper-V. Сетевуха привязывается к виртуалке.

- Address Hash. Хеш на основе отправителя и получателя:

- MAC адреса (для не IP трафика)

- IP адреса (для не TCP и UDP трафика)

- Порт — обычно.

- Dynamic.

Standby adapter

Есть возможность один из адаптеров назначить как резервный. Тогда трафик будет гоняться только через активный.

LACP

Давайте для примера настроим LACP. У нас есть два гигабитных физических адаптера. Винда их видит.

Открываем Server Manager > Local Server.

Видно, что сервер железный Supermicro SYS-1029P-WTRT. Видно ось, кстати, Standerd. Видно что обе сетевуха настроена по умолчанию на получение IP адреса по DHCP. Нас интересует раздел NIC Teaming — Disabled. Тыкаем в него.

Открывается окно NIC Teaming. Вверху выбираем сервер, он у нас один. Справа ниже видим две сетевухи, которые можно объединить в группу.

Слева ниже нажимаем в TASKS > New Team. Открывается окошко:

Указываем название группы, я пишу «LACPteam». Отмечаем галками адаптеры, которые объединяем в группу. У меня их всего два, оба и выделяю. Разворачиваем скрытый ниже раздел Additional properties.

- Teaming mode — LACP, его сейчас пробуем собрать.

- Load balancing mode — ставлю Address Hash.

- Standby adapter в режиме LACP не выбирается.

- Кликаем по ссылке Primary team interface:

У нас одна группа. Здесь мы можем только задать VLAN — пишем его при необходимости. OK.

Что-то вроде настроили. Тыкаем ОК. Побежал прогресс.

В окне NIC Teaming теперь видно группу. Обе сетевухи подцепились, т.к. на коммутаторе уже всё настроено. В списке сетевых адаптеров появляется новый — LACPteam — VLAN 45.

Сетевые наcтройки теперь нужно производить через него. Задаём их.

Ура, мы настроили агрегацию портов в Windows Server 2016!

Если VLAN не указывать, то новый адаптер будет называться LACPteam.

Прочитано:

5 347

Задача: Самостоятельно проработать, как поднять/организовать Nic Teaming средствами Windows Server 2016 в GUI составляющей. Ранее я уже делал, но использовал Windows Server 2008 R2, а тут хочу посмотреть также это все легко или есть определенные нюансы.

Итак, под Virtualbox развернута виртуальная система с осью на борту Windows Server 2016 Standard (Microsoft Windows [Version 10.0.14393]) с двумя сетевыми адаптерами.

Авторизуюсь в системе с правами, либо локального администратора, либо Администратора домена.

Win + R — cmd.exe с правами Администратора (Обязательно)

C:UsersАдминистратор>netsh interface teredo set state disabled

C:UsersАдминистратор>netsh interface isatap set state disabled

C:UsersАдминистратор>netsh interface 6to4 set state disabled

Чтобы сделать объединение сетевых интерфейсов в один для увеличения пропускной способности:

Win + R — control — Просмотр: Категория — Мелкие значки — Администрирование — Диспетчер серверов (ServerManager.exe) — Локальный сервер — по умолчанию настройка «Объединение сетевых карт» в состоянии «Отключено», щелкаю левой кнопкой мыши по настройке и перехожу в диалоговое окно «Объединение сетевых карт» (Приложение: LbfoAdmin.exe), в элементе «Группы» — «Задачи» — выбираю «Создать группу»

Имя группы: nic

и отмечаю галочками сетевые интерфейсы которые буду объединять, также нужно через «Дополнительные свойства» указать режим работы объединенных интерфейсов:

- Режим поддержки групп: LACP или «Динамически» (но на коммутаторе куда подключен также нужно будет сделать объединение интерфейсов и назначить роль lacp)

- Режим балансировки нагрузки: → может принимать: Хэш адреса, Порт Hyper-V, Динамический, т. к. я не использую Hyper-V то и не указываю, а выбираю «Хэш адреса» это Вычисление хэша на основе портов позволяет распределять трафик более равномерно. Однако для трафика отличного от TCP или UDP применяется хэш на основе IP-адреса, для не IP-трафика – хэш на основе MAC-адресов.

- Резервный адаптер: выставлено и затемнено мастером «Нет (Все адаптеры активны)». Если не указывать LACP, то можно сделать если линк на одном адаптере пропадает на его место встает другой.

Основной групповой интерфейс: nic (виртуальная локальная сеть по умолчанию)

и нажимаю кнопку «ОК»

Итого объединение интерфейсов в системе сформировано:

В случае если линк обрывается на одном сетевом интерфейсе, доступ к системе Вы не теряете.

Если обратить внимание на свойства первого и второго сетевого адаптера, то у них выставлена всего лишь одна настройка «Протокол мультиплексора сетевого адаптера», а у нового с именем группы nic:

- Клиент для сетей Microsoft

- Общий доступ к файлам и принтерам

- Планировщик пакетов QoS

- Microsoft Load Balancing/Failower Provider

- IP версии 4 (TCP/IPv4)

- IP версии 6 (TCP/IPv6) — снимаю галочку, так как не использую во всей сети.

- Отвечающее устройство обнаружение топологии (делает компьютер видимым в сети)

Ответчик обнаружения топологии канального уровня (используется для обнаружения других компьютеров, устройств и компонентов в сети).

Смотрю текущие настройки сети от DHCP—сервиса в локальной сети:

Win + R — cmd.exe с правами Администратора (Обязательно)

C:UsersАдминистратор>ipconfig

Настройка протокола IP для Windows

Адаптер Ethernet nic:

DNS-суффикс подключения . . . . . :

IPv4-адрес. . . . . . . . . . . . : 172.40.40.6

Маска подсети . . . . . . . . . . : 255.255.255.0

Основной шлюз. . . . . . . . . : 172.40.40.1

Как видно, сетевой адрес получает лишь общий интерфейс, а не вспомогательные.

На заметку: Если Ваши наблюдения показываю, что объединение интерфейсов требуют изменения, то все также через оснастку «Объединения сетевых карт» можно поменять настройки. Вот только желательно это делать имея к системе еще один вид подключения, к примеру консоль Hyper-V, vSphere Client, iDRAC, IPMI и т. д. Чтобы если что не остаться у разбитого корыта и подстраховаться.

На заметку: Если физическое железо может на уровне железа объединять интерфейсы или использует специализированное программное обеспечение, то лучше делать через него, чем средствами Windows, а если не хочется от него зависить, то средствами операционной системы и не важно Windows это или Linux.

Вот на этом я прощаюсь, как я мог убедиться нет ничего сложно в настройке объединения сетевых карт в системе Windows Server 2016. Если у меня буду какие-либо дополнения и наблюдения, то я постараюсь отразить их в этой заметке. А пока у меня всё, с уважением автор блога Олло Александр aka ekzorchik.

Table of Contents

- Summary

- Steps

- LACP Mode

- Address Hash Mode

- Cisco Switch Port-Channel Configuration

- Conclusion

- References

Summary

Network Teaming is one of important part in infrastructure when we need High Availability in networking. NIC Teaming allows you to group between 1 to 32 physical Ethernet network adapters into one or more software-based virtual

network adapters. These virtual network adapters provide fast performance and fault tolerance in the event of a network adapter failure. NIC Team member network adapters must all be installed in the same physical host computer to be placed in a team. In Cisco

language its called Port-Channel, in Linux language its called Network Bonding and in Microsoft language we call it NIC Teaming.

Most of the administrator face the issue in configuring NIC Teaming at the other side which is Cisco switch. In this article, we will address both side configuration involved in setting up NIC Teaming.

Steps

First, we need to have a look at the NIC of the VM or a physical server if it is a physical Server.

We have two NICs on Windows Server 2016. You can rename them as you like.

Go to Server Manager and click Local Server, and click Disabled. By default NIC Teaming is disabled when you install your operating system.

Click TASKS and click New Team

Here we need to provide any Name of the Team as per your environment and select both NIC cards.

The Teaming mode will be LACP because we will configure LACP at Cisco Switch side as well, so both sides should have the same Teaming mode.

LACP Mode

LACP stands for Link Aggregation Control Protocol and essentially it is the more dynamic version of switch dependent teaming means that with if you configure the switch rather than individual ports. Once the switch is configured

it becomes aware about your network team and handles dynamic negotiation of the ports. Also called dynamic teaming and based on IEEE 802.1ax, this mode is supported by most enterprise-class switches and allows automatic creation of a team using the Link Aggregation

Control Protocol (LACP), which dynamically identifies links between the server and a specific switch. To use this mode, you generally need to enable LACP manually on the port of the switch.

Address Hash Mode

It uses attributes of network traffic (IP address, port and MAC address) to determine to which specific NIC traffic should be sent.

You can see the status of NIC Team up and running, for this configuration we have both NIC in active/active mode. You can add more NIC to the Team as per your need and requirement of the scenario.

We can analyze NIC Team statistics sent/received packets.

In network properties, we can see the NIC Team icon and its speed showing as 2.0 Gbps, as we have combined both NIC having 1 GB each through NIC Teaming.

Cisco Switch Port-Channel Configuration

At this point we have complete the configuration involved in NIC Teaming, this is time to configure the Cisco Switch side so that both sides can be synchronized. If you have Switch access, you should know about the connected ports

of your Server so that you can configure the same LACP port-channel in switch side.

This Server NIC 0 is connected with Switch port 1/0/18 and NIC 1 is connected with Switch port 2/0/18, In this environment, we have two switches configured as a stack so we have to use one port from each switch to make a port channel.

This design will also provide us Switch level redundancy.

After login into the Switch simply paste these commands in a switch and save the configuration. You can check the status after a while at Server side it will be synchronized.

Core-SW#conf t

Core-SW(config)#interface port-channel18

Core-SW(config)#interface gigabitEthernet1/0/18

Core-SW(config-if)#channel-group18mode passive

Core-SW(config)#interface gigabitEthernet2/0/18

Core-SW(config-if)#channel-group18mode passive

Save the configuration and exit.

Conclusion

As we have configured NIC Teaming in Windows Server 2016 and other side switch configuration required for the port-channel. We have aggregated the ports as both ports active, you can configure active/standby as well you want

failover between the ports.

References

- NIC Teaming Overview

- https://gallery.technet.microsoft.com/Windows-Server-2016-839cb607

- https://docs.microsoft.com/en-us/powershell/module/netlbfo/?view=win10-ps

- https://technet.microsoft.com/fr-fr/library/jj130849(v=wps.630).aspx

NIC Teaming (or Load Balancing/Failover – LBFO, or NIC bonding) allows joining multiple physical network adapters (NICs) into a single logical network card. In this article, we’ll show how to configure NIC Teaming on Windows Server 2019/2016/2012R2 and on Windows 10/11 desktop computers.

Contents:

- Configuring a NIC Teaming on Windows Server 2019

- How to Create NIC Teaming on Windows Server with PowerShell?

- How to Enable NIC Teaming on Windows 10 and 11?

Why may you need to combine multiple network adapters into a NIC Team?

- Increase throughput. For example, by joining two 1GB network cards into a NIC Team, you will get a 2Gbit/s bandwidth on a logical adapter;

- Manage network card load balancing. You can balance the network traffic across active NICs.

- Fault tolerance. If any of your network cards in a NIC Team fails, the rest cards take their functions and the connection with the server is not interrupted. For critical servers, the mechanism protects a service against downtime if a network switch or an Ethernet port on it fails, or if a network cable (connecting your host and switch) is damaged. To implement this feature, it is enough to connect network cards to different physical switches.

In Windows Server 2022/2019/2016/2012R2, NIC Teaming is not compatible with Single-Root I/O Virtualization (SR-IOV), TCP Chimney, and Remote Direct Memory Access (RDMA).

Configuring a NIC Teaming on Windows Server 2019

You can configure NIC Teaming on Windows Server 2012 or newer. Let’s see how to combine multiple network adapters into a NIC Team interface on Windows Server 2019. NIC Teaming is disabled by default on Windows Server.

To enable it, open the Server Manager, select Local Server, and click NIC Teaming: Disabled in its properties.

In the next window, select Tasks -> New Team in the left bottom pane.

Then enter a Team name and select the network adapters you want to add to the group.

In Windows Server 2019, you can add up to 32 physical network adapters to a NIC Team. The only requirement is the same connection speed on the team adapters.

You can select special team options. The options set NIC Teaming rules and performance. Let’s take a closer look at these settings.

Teaming Mode. The option sets how the group interacts with the network switches:

- Static Teaming (IEEE 802.3ad) is a static operation mode depending on your network hardware. All team adapters must be connected to the same switch, which Ethernet ports are configured to use static channel aggregation (additional switch configuration is required);

- Switch Independent (a default mode) — the NIC Team works independently of the switch; no additional configuration of network hardware is needed. If this mode is on, you can connect different network adapters to different switches to improve fault tolerance (protection against switch failure);

- LACP (Link Aggregation Control Protocol, LACP, IEEE 802.1ax) is the mode that depends on your network hardware as well. You need to enable and configure the dynamic link aggregation using the LACP on your switch.

Load Balancing mode sets how network traffic is distributed between NICs in the team.

- Address Hash — a special hash is assigned to each physical adapter (based on sender and recipient MAC or IP addresses). All traffic from a specific sender will go through this NIC;

- Hyper-V Port — you can use this mode on a server with the Hyper-V role. It allows you to bind an adapter from your NIC Team to a specific port on a Hyper-V virtual switch;

- Dynamic is a default option combining both load balancing types.

You can make one of the adapters in the group a Standby adapter. In a normal operation mode, this NIC is not used to process traffic. If any other adapter in your NIC Team fails, it will be replaced by a standby one. Actually, if this function is not enabled, there will be no service downtime when any network adapter fails, since its load will be automatically distributed among other cards in the group.

Select the settings you need, click OK and a new NIC Team will be created.

Open the list of network connections in the Control Panel. Make sure that a new device labeled Microsoft Network Adapter Multiplexor Driver (it has a different icon) has appeared. This is the NIC Teaming virtual adapter.

Further configuration of the network card (protocols, IPv4/v6 address) is performed in the properties of the NICTeam adapter.

Network adapters that you add to a NIC group will no longer have their own IP addresses.

If you remove a NIC Team, the previous network adapter settings will be restored.

Later you can add or remove network adapters to your NIC Team.

You can use the NIC Teaming to configure multiple VLAN interfaces on Windows Server. To do it, you can even create a NIC Teaming group from a single network adapter.

How to Create NIC Teaming on Windows Server with PowerShell?

You can create and manage NIC Teams both through the Windows graphical interface and PowerShell. PowerShell can be used to set up NIC Teaming on Windows Server Core.

You can use the built-in NetLbfo module on Windows Server to manage NIC Teaming. Display a list of network adapters on your server:

Get-NetAdapter

Create a new Team0 from the adapters named Ethernet1 and Ethernet3. Select NIC Teaming mode: Switch Independent with dynamic load balancing.

New-NetLbfoTeam -Name Team0 -TeamMembers Ethernet1,Ethernet3 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm Dynamic

Available options:

- TeamingMode: Static SwitchIndependent, Lacp

- LoadBalansingAlgorithm: TransportPorts, IPAddresses, MacAddresses, HyperVPort, Dynamic

To get information about NIC Teams on a server, use the command below:

Get-NetLbfoTeam

Name : Team0

Members : {Ethernet3, Ethernet1}

TeamNics : Team0

TeamingMode : SwitchIndependent

LoadBalancingAlgorithm : Dynamic

Status : Up

You can use PowerShell to configure an IP address of your NIC Teaming interface and other network settings:

New-NetIPAddress -InterfaceAlias team0 -IPAddress 192.168.13.100 -PrefixLength 24 -DefaultGateway 192.168.13.1

Set-DnsClientServerAddress -InterfaceAlias team0 -ServerAddresses 192.168.13.10

Run the Get-NetAdapter command. Note that the LinkSpeed of the NIC Teaming network adapter is 2 Gbit/s.

To change the NIC Teaming group settings, use the NetLbfoTeam cmdlet:

Set-NetLbfoTeam -Name Team0 -TeamingMode LACP

If you run this command in a VM, the following error appears:

Set-NetLbfoTeam : 'SwitchIndependent' is the only TeamingMode value supported in a Virtual Machine

To add an additional VLAN interface via NIC Teaming, run the command below:

Add-NetLbfoTeamNIC -Team Team0 -VlanID 44

You can remove a NIC Team using this command:

Remove-NetLbfoTeam -Name Team0

How to Enable NIC Teaming on Windows 10 and 11?

You can use NIC Teaming to combine network adapters both in Windows Server and in desktop versions of Windows 10 and 11. The main thing is that your network card must support Link aggregation, NIC teaming, or LBFO.

For example, NIC Teaming works out of the box with Realtek PCIe GbE Family Controller (10.35.510.2019) or Intel(R) 82574L Gigabit Network Adapter.

To create a NIC Team on Windows 10 (in this example, it is Windows 10 20H2), open your PowerShell console and list network adapters:

Get-NetAdapter

Let’s create a NIC Team of Ethernet0 and Ethernet1 adapters.

New-NetSwitchTeam -Name "MyNICTeam" -TeamMembers "Ethernet0","Ethernet1"

Make sure that a new NIC Teaming interface has appeared on the computer:

Get-NetSwitchTeam

Don’t forget to set its network settings. Now you have got a new 2 Gbit/s interface.

To remove a NIC Team, use PowerShell:

Remove-NetSwitchTeam -Name "MyNICTeam"

The NIC Teaming feature is now the builtin feature to Configure NIC Teaming in Windows Servers. NIC Teaming is provide network availability and network performance. It act as a bonding network adapters to form one logical network adapter. It provides useful features such as load balancing across individual links and failover for network connections.

NIC Teaming Features and Modes

Currently Windows Server support two modes of NIC Teaming configurations. The firs once is Switch dependent mode and the second one is Switch independent mode.

Switch dependent mode is connecting all network adapters to the same switch. It requires to configure on the physical switch with Generic teaming mode and LACP for Dynamic mode. These two Generic 802.3ad and Dynamic 802.1ax are the features of Switch dependent mode.

Switch Independent mode is connecting network adapters to different switches and configuration is not required on physical switches.

In this article I’m going to configure NIC Teaming in Windows Server 2016 using a Hyper-v lab. All network adapters are logical and just created for testing the functionality of NIC teaming in Windows Server 2016.

To configure NIC Teaming, at least you need to have two Network adapters. Before configuring NIC teaming, create some virtual network card for your virtual hyper-v servers.

1. On Windows server open Server Manager and select Local Server. It shows all network adapters with their IP configurations. The screenshot shows the network adapters configured with static IP address.

2. Just click Disabled in front of NIC Teaming to open NIC Teaming configuration window.

3. From TEAMS section click TASKS and select New Team to create and new NIC Team from existing network adapters.

4. Select the adapters you want to team with each others and type a name. Then select the appropriate settings from Additional properties. and click OK to create the first NIC team.

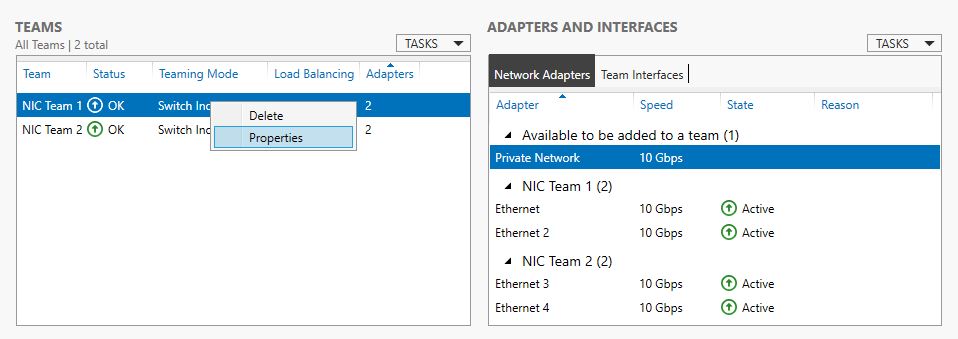

5. Finally you see the created NIC Teams on TEAMS section of NIC Teaming window. If you want to change the settings of NIC Teams, select and right click a NIC team then select Properties.

Yes, you have successfully created and configured NIC Teaming in Windows Server. To see the NIC Teaming is enabled, once refresh the Server Manager then see the result.

6. Now, once check the Network Connections to see the NIC Teams connections created after NIC Teaming configuration.

That’s all. Hope you clearly understand to configure NIC teaming in Windows Server. In case of any issue related to NIC Teaming, comment us please.

Configure NIC Teaming – Video Tutorial

Предыстория…

В текущем исполнении у нас два контроллера домена:

— Primary AD железный (достаточно старый еле ползущий сервак HP, от которого мы планировали избавиться)

— Secondary AD виртуальный (уже все как положено, быстрый на Windows 2012).

Некоторое время назад, столкнулись с интересной проблемой:

Судя по логам, в пятницу вечером, «воткнул» основной контроллер. Не просто «воткнул» полностью, а «воткнул» как-то странно (продолжал пинговаться, но войти удаленно на него уже было нельзя и свою роль он уже также не выполнял). Вроде воткнул и воткнул, есть же второй контроллер. Но в воскресенье днем пропала доменная авторизация на всех устройствах, хотя второй контроллер был вроде как доступен. А далее интересный момент. Как только пропала авторизация, второй контроллер перестал удаленно пускать в систему по RDP, решили посмотреть, что происходит с ним через Vcenter, но тут тоже нас ждал «отлуп», авторизация также не проходила, а самое интересное никак невозможно было попасть на виртуальный второй контроллер. Получился некий замкнутый круг: PDC в «дауне», а что случилось с SDC, тоже невозможно посмотреть и понять, что с ним происходит.

Соответственно все виртуальные сервера продолжали работать, но уже не так хорошо, как были должны. Впервые за свою практику, столкнулся с похожей ситуацией.

Далее пошли по следующему пути:

— Ребутнули железный PDC, он благополучно перезагрузился и поднялся, стал работать по-прежнему, как надо, но репликации со вторым контроллером так и не появилось. Это нам говорило о том, что второй контроллер хоть и пингуется, но тоже в анабиозе.

— Далее авторизуемся локально на Vcenter понимаем на каком хосте крутится SDC, далее уже принудительно ребутаем SDC, он благополучно поднимается, поднимается репликация с PDC, но авторизация на всех остальных (файл-серверах, терминальных серверах и прочих серверах…), так и не работает.

— Пришлось принудительно перезагрузить все виртуальные сервера, чтоб полноценно восстановить работу и вернуть их в строй.

Неприятный момент.

До этого случая планировали приобрести более быстрый железный сервак и смигрировать, текущий PDC на него, а вот после него, пересмотрели свое первоначальное решение: PDC на новый смигрируем (перенесем роли и прочие дела), а избавляться от второго железного сервера пока не будем, оставим его третьим контроллером.

Наконец наш новый сервер DELL уже в стойке, Windows Server 2016 уже «залит», пришло время поэтапно приступить к поднятию третьего контроллера и дальнейшему PDC переносу на него.

Но сначала для отказоустойчивости имеет смысл объединить сетевые порты:

Соответственно из разных сетевых портов сервера включаем шнурки в разные коммутаторы, на этих портах коммутаторов, включаем LACP.

На втором аналогично.

Далее, переходим непосредственно к серверу.

По умолчанию режим NIC Teaming в Windows server 2016 (в 2012 аналогично) отключен. Для его активации открываем Server Manager и видим, что это действительно так.

В Задачах (Tasks) выбираем пункт Создать группу (New Team).

Далее именуем группу, выбираем отмечаем адаптеры и настраиваем дополнительные свойства группы.

Имеет смысл сказать несколько слов о дополнительных параметрах настройки NIC Teaming в Windows server 2016:

Режим поддержки групп (Teaming mode) определяет режим взаимодействия группы с сетевым оборудованием:

1. Не зависит от коммутатора (Switch Independent) — группа работает независимо от коммутатора, никакой дополнительной настройки сетевого оборудования не требуется. Этот режим позволяет подключать адаптеры одной тиминговой группы к разным свичам для защиты от сбоя одного из них. настройка по умолчанию;

2. Статическая поддержка групп (Static Teaming) — режим с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору. Порты коммутатора, к которым подключены адаптеры группы, настраиваются на использование статической агрегации каналов;

3. LACP — режим с зависимостью от сетевого оборудования. Коммутатор настраивается на использование динамической агрегации каналов с использованием протокола Link Aggregation Control Protocol (LACP).

Режим балансировки нагрузки (Load Balancing mode) определяет, каким образом распределять сетевой трафик между адаптерами группы:

1. Хэш адреса (Address Hash) — при передаче сетевого трафика на основании MAC или IP-адресов отправителя и получателя вычисляется хеш (некое число). Это число привязывается к определенному физическому адаптеру и в дальнейшем весь трафик от этого отправителя будет идти через этот адаптер;

2. Порт Hyper-V (Hyper-V Port) — в этом режиме осуществляется привязка адаптера teaming группы к определенному порту виртуального свича в Hyper-V. Этот режим используется в том случае, если на сервере активирована роль Hyper-V.

Резервный адаптер (Standby adapter) позволяет назначить один из адаптеров группы в качестве резервного. В нормальном состоянии резервный адаптер не используется для передачи трафика, но при выходе любого адаптера группы из строя сразу занимает его место и трафик продолжает передаваться без перерывов. Но даже без резервирования выход из строя одного адаптера в NIC Teaming не приведет к прерыванию сетевого соединения, потому что, нагрузка будет автоматически распределена по оставшимся адаптерам.

Тоже самое можно сделать и через PowerShell:

New-NetLbfoTeam -Name LACP -TeamMembers ″Ethernet″,″Ethernet 2″ ` -TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

Далее в окне «Сетевые подключения» появиться еще один сетевой адаптер, который как раз и является виртуальным адаптером созданной группы.

При необходимости все это можно удалить:

Или через PowerShell: Remove-NetLbfoTeam -Name LACP

Порты объединены, можно будет приступить к следующим этапам, но это уже тема последующих постов…

Всем хорошей работы!!!

28.03.2018 —

Posted by |

ms windows server 2016

Sorry, the comment form is closed at this time.

The browser version you are using is not recommended for this site.

Please consider upgrading to the latest version of your browser by clicking one of the following links.

- Safari

- Chrome

- Edge

- Firefox

Setting up NIC Teaming for Windows Server 2012*/2012 R2*/2016*/2019*

Documentation

Content Type

Install & Setup

Article ID

000022706

Last Reviewed

01/29/2020

To create a NIC Team:

- In Server Manager, click Local Server.

- In the Properties pane locate NIC Teaming, and then click the link Disabled to the right. The NIC Teaming dialog box opens.

- In Adapters and Interfaces, select the network adapters that you want to add to a NIC Team.

- Click TASKS, and then click Add to New Team.

- The New team dialog box opens and displays network adapters and team members. In Team name, type a name for the new NIC Team.

- If needed, in Additional properties, select values for Teaming mode, Load balancing mode, and Standby adapter. In most cases, the highest-performing load balancing mode is Dynamic.

- If you want to configure or assign a VLAN number to the NIC Team, click the link to the right of Primary team interface. The New team interface dialog box opens.

- To configure VLAN membership, click Specific VLAN. Type the VLAN information in the first section of the dialog box

-

Click OK.

PowerShell* Instruction

| Note | We recommend using Microsoft Teaming on operating systems 2012 and higher. |

Creating the Network Team using PowerShell

See the Microsoft TechNet article that details NIC Teaming (NetLBFO) cmdlets in Windows PowerShell*.

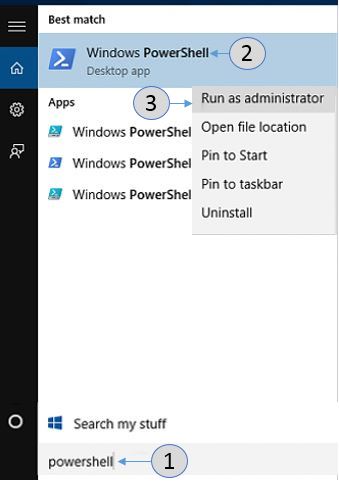

- Open an elevated PowerShell prompt. In the Windows® 10 taskbar search, type PowerShell. Press the W and S keys to open Search.

- You should now see the result Windows PowerShell at the top. Right-click Windows PowerShell and select Run as Administrator.

- If you are presented with the User Account Control prompt, click Yes.

- Enter the command new-NetLBFOTeam [TEAMNAME] “[NIC1]”, “[NIC2]” and press the Enter Key.

[TEAMNAME] – the name you want to give to the team of network adapters

[NIC1] – the name of the first network adapter found from above

[NIC2] – the name of the second network adapter found from above - Open the Network Connections by going to Control Panel > Network and Internet > Network Connections.

Related Products

This article applies to 214 products.

Intel® Ethernet Controller X540-AT2

Intel® Ethernet Controller X710-BM2

Intel® Ethernet Controller XL710-BM1

Intel® Ethernet Controller XL710-BM2

800 Series Controllers (up to 100GbE)

Intel® 82567 Gigabit Ethernet Controller

Discontinued Products

Need more help?

Give Feedback

NIC teaming is not something we got with Windows Server 2016, but I just find it interesting to review this functionality as we have it in the current iteration of Windows Server, as usual, touching a bit on the basics and history of this feature.

The NIC teaming feature reached its maturity in Server 2012 R2, and there have been (almost) no major changes in this department in Server 2016, yet if you are just starting out with a practical use of NIC teaming on prepping for any related Microsoft exam you may find it useful to review this feature thoroughly.