Технология NIC Teaming (или Load Balancing/Failover – LBFO, или NIC bonding) позволяет объединить несколько физических сетевых адаптеров (NIC) в одну логическую сетевую карту. В этой статье мы рассмотрим, как настроить NIC Teaming в Windows Server 2019/2016/2012R2 и в десктопых версиях Windows 10 и 11.

Содержание:

- Настройка NIC Teaming в Windows Server 2019

- Используем PowerShell для настройки NIC Teaming в Windows Server

- Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Для чего может понадобится объединять сетевые адаптеры в группу NIC Teaming?

- Увеличение пропускной способности. Например, объединив две сетевые 1 Гб сетевые карты в одну группу NIC Teaming, вы получите общую полосу пропускания на логическом адаптере 2 Гбит/с;

- Управление балансировкой нагрузки на сетевые карты – можно управлять распределением трафика между NIC сервера;

- Отказоустойчивость – при выходе из строя любой из сетевых карт, добавленных в группу NIC teaming, остальные подхватывают ее функции, и связь с сервером не прерывается. Для критически важных серверов этот механизм может защитить от простоя сервиса во время выхода из строя сетевого коммутатора или Ethernet порта на нем, сетевого кабеля (которым ваш хост подключен к коммутатору). Для реализации такой возможности, достаточно подключить сетевые карты в разные физические коммутаторы.

В Windows Server 2012R2/2016/2019/2022 технология NIC Teaming не совместима с Single-root I/O virtualization (SR-IOV), TCP Chimney и Remote Direct Memory Access (RDMA).

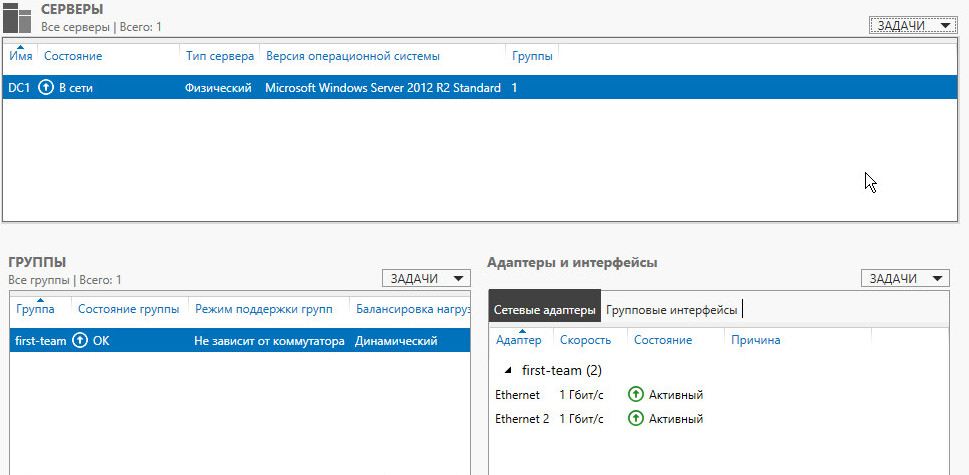

Настройка NIC Teaming в Windows Server 2019

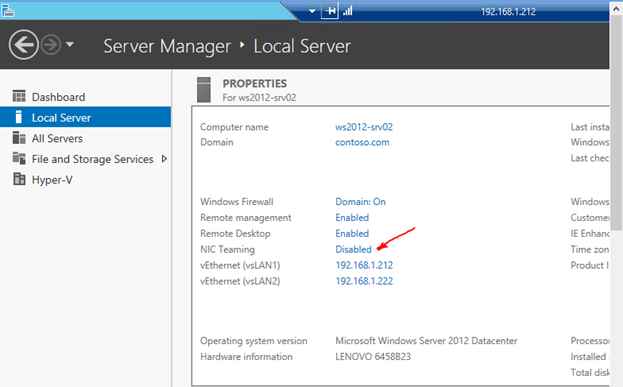

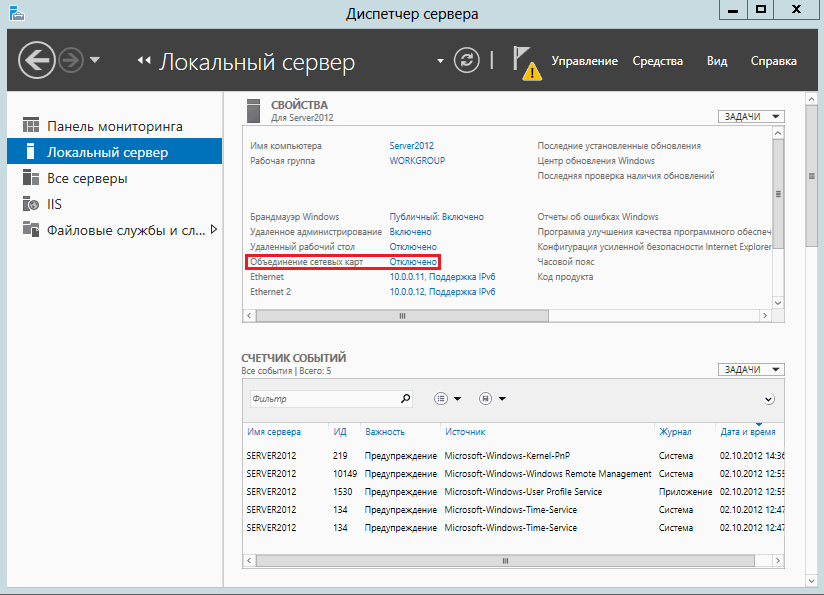

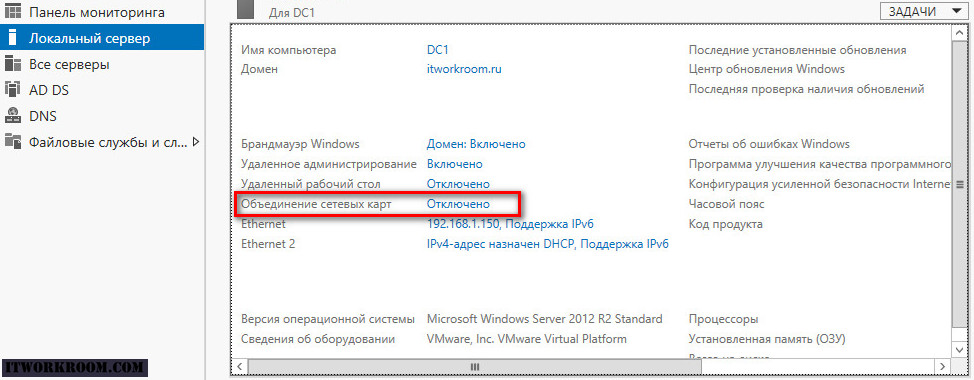

Вы можете настроить NIC Teaming в Windows Server начиная с версии 2012. Рассмотрим, как объединить несколько сетевых адаптеров в Windows Server 2019 в одну группу NIC Teaming. Режим NIC Teaming по умолчанию отключен в Windows Server.

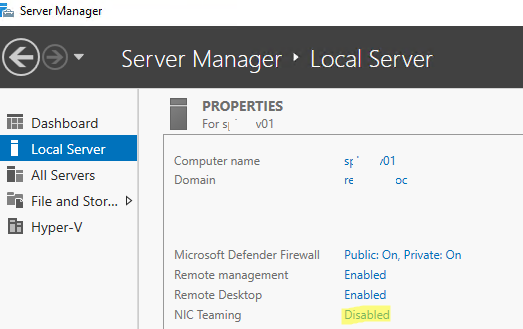

Чтобы включить его, откройте консоль Server Manager, выберите локальный сервер (Local Server) и в его свойствах выберите пункт “NIC Teaming: Disabled“.

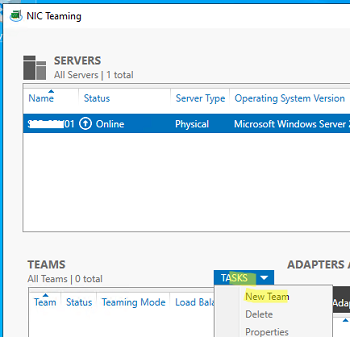

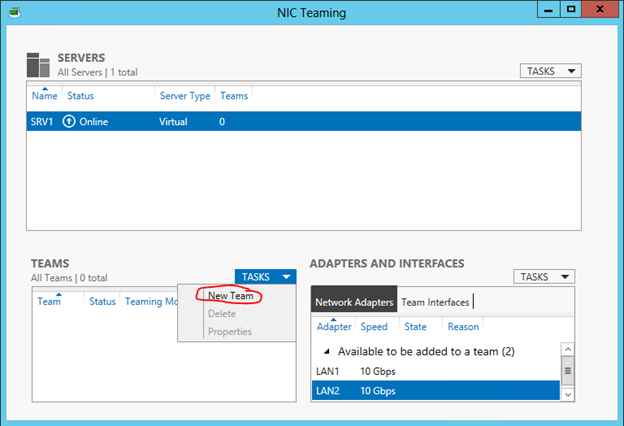

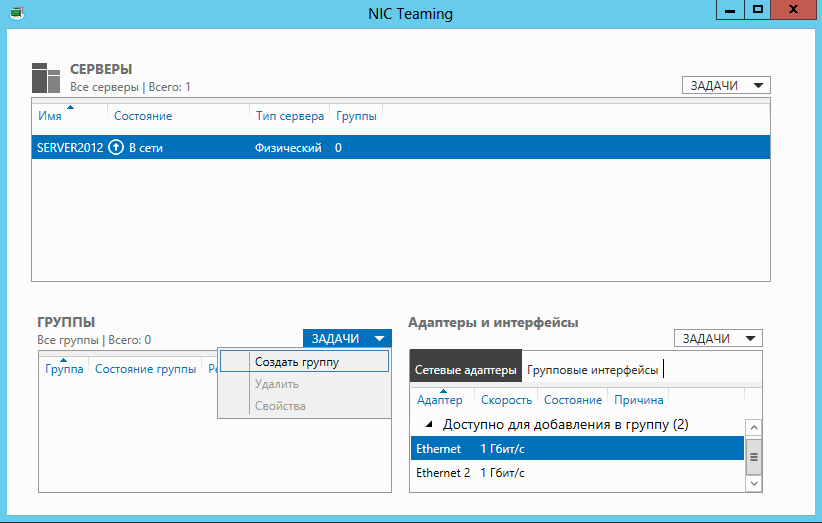

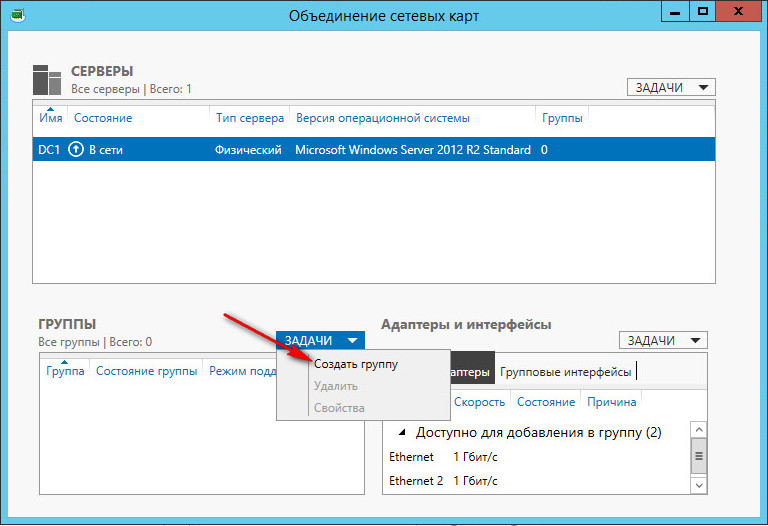

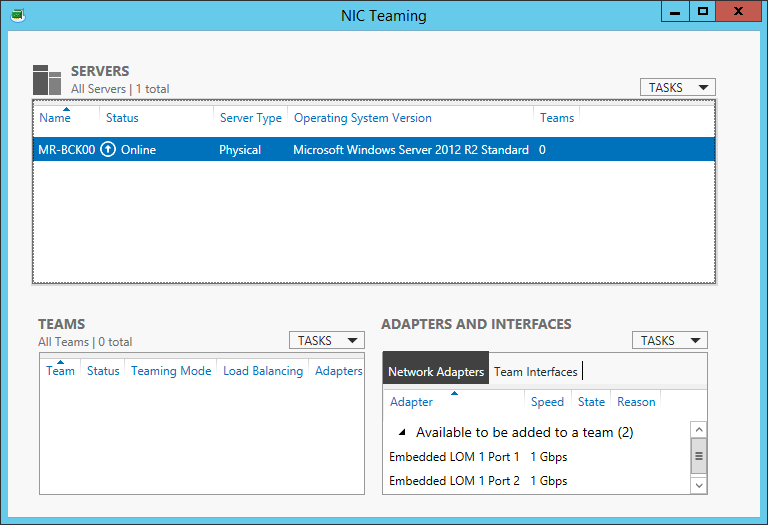

В появившемся окне в левой нижней панели выберите пункт Tasks -> New Team (Создать группу).

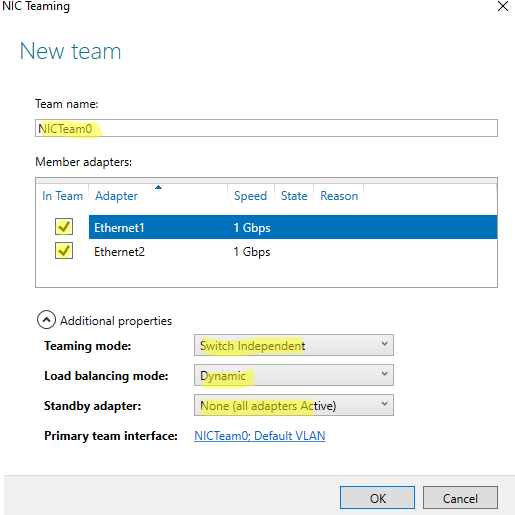

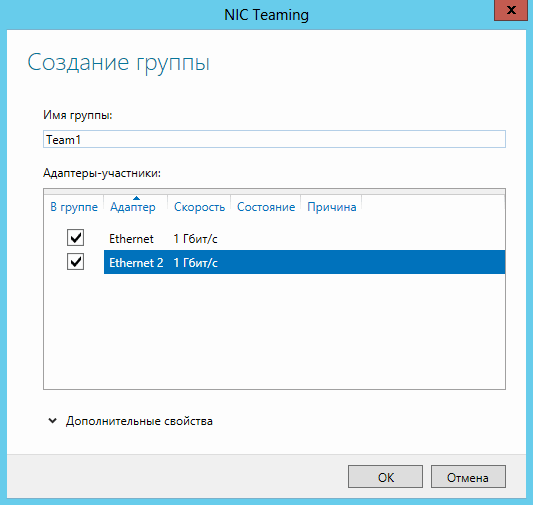

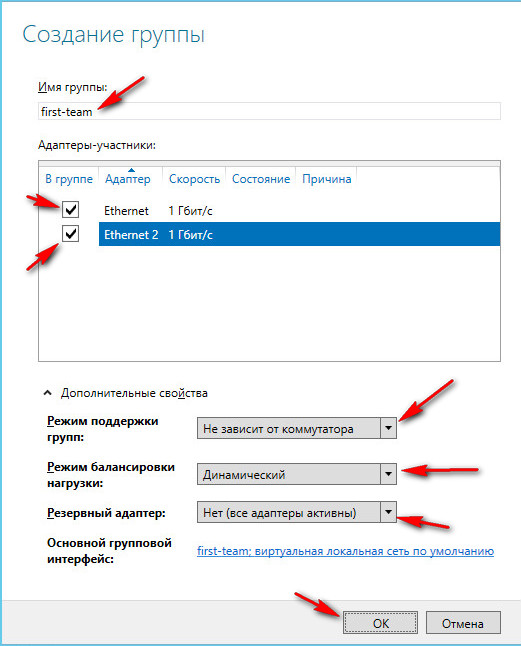

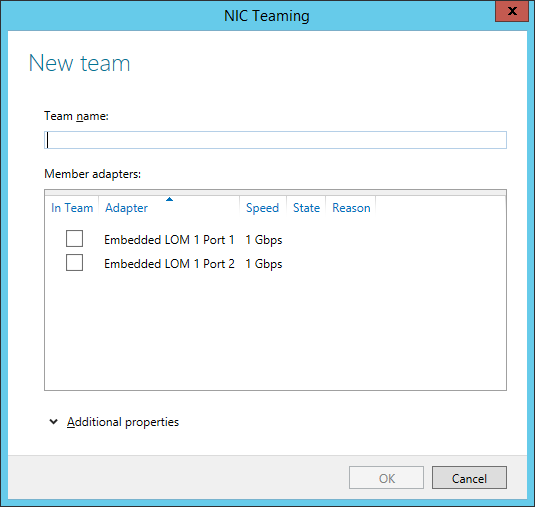

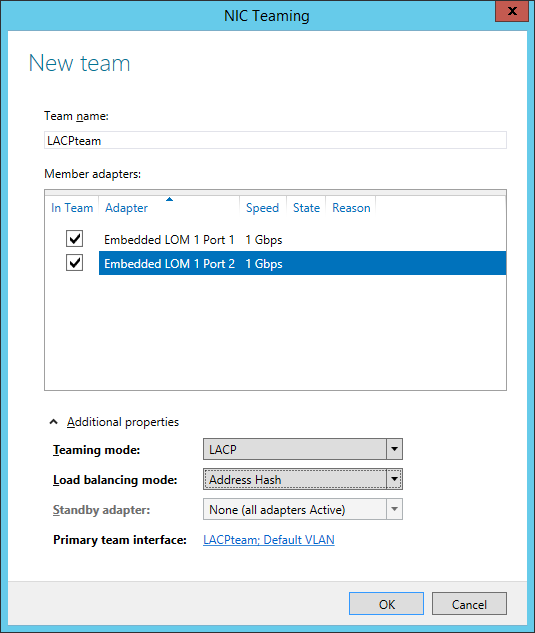

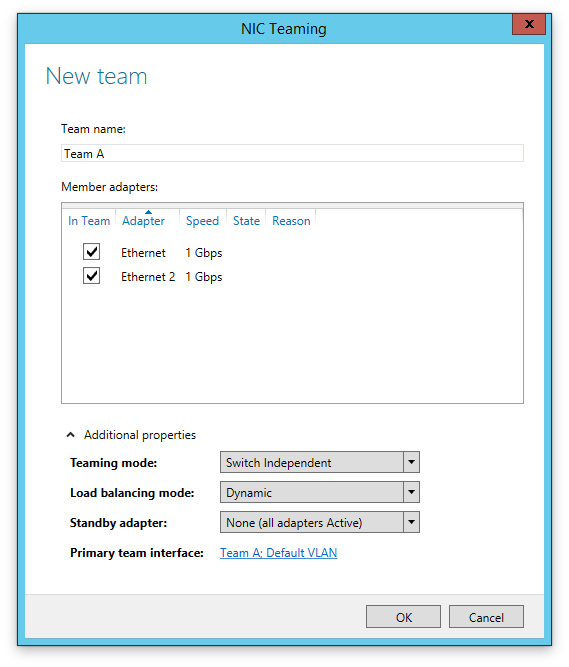

Далее нужно указать имя группы (Team Name) и выбрать сетевые адаптеры, которые будут входить в эту группу.

В Windows Server 2019 в одну NIC Teaming групп можно объединить до 32 физических сетевых адаптеров, главное, чтобы они работали на одной скорости.

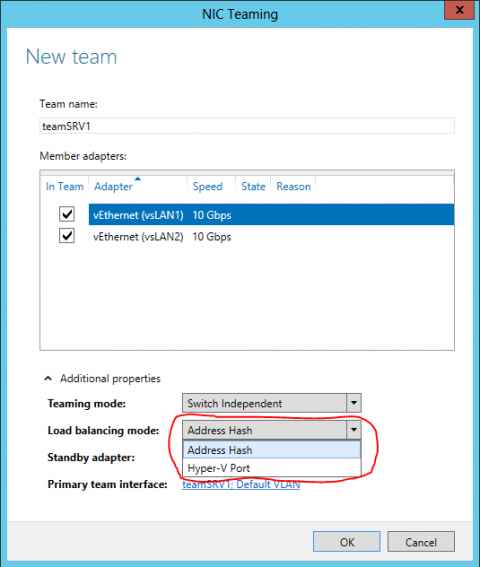

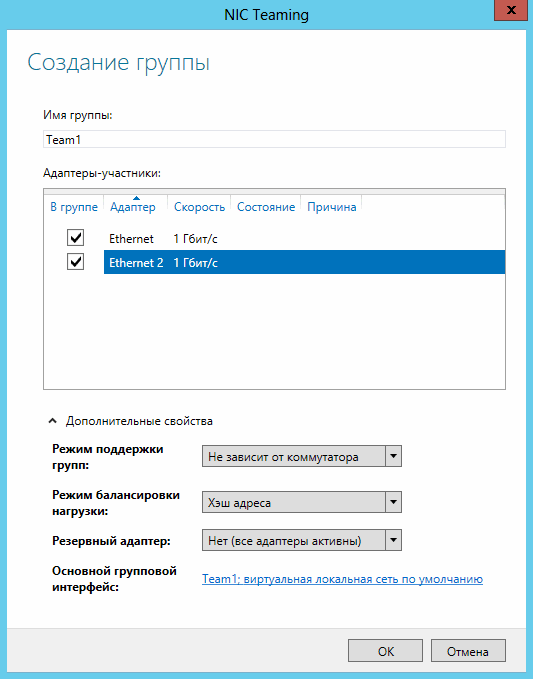

Ниже можно настроить специальные параметры группы. От данных параметров зависит правила и эффективность NIC Teaming. Рассмотрим эти настройки подробнее.

Режим поддержки групп (Teaming Mode). Данный параметр определяет способ взаимодействия группы с сетевым оборудованием (коммутатором)

- Static Teaming (IEEE 802.3ad)— статический режим работы с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору, Ethernet порты которого настроены на использование статической агрегации каналов (требуется настройка на коммутаторе);

- Switch Independent (режим по-умолчанию) – группа работает независимо от коммутатора, для реализации не нужно дополнительно настраивать сетевое оборудование. В этом режиме разные сетевые адаптеры группы можно подключить к разным коммутаторам для повышения отказоустойчивости (защита от сбоев в коммутаторах);

- LACP (Link Aggregation Control Protocol, LACP, IEEE 802.1ax) – режим также зависит от сетевого оборудования. Нужно включить и настроить на коммутаторе динамическую агрегацию каналов по протоколу LACP.

Режим балансировки нагрузки (Load Balancing mode) – задает как распределяется сетевой трафик по NIC в группе.

- Address Hash — для каждого из адаптеров вычисляется специальный хэш (на основании MAC или IP-адресов отправителя и получателя) и привязывается определенному физическому адаптеру. Весь трафик от данного отправителя будет идти через этот NIC;

- Hyper-V Port — режим можно использовать для сервера с ролью Hyper-V. Позволяет привязать конкретный адаптер группу NIC teaming к конкретному порту на виртуальном коммутаторе Hyper-V;

- Dynamic – опция по умолчанию, совмещает оба типа балансировки нагрузки.

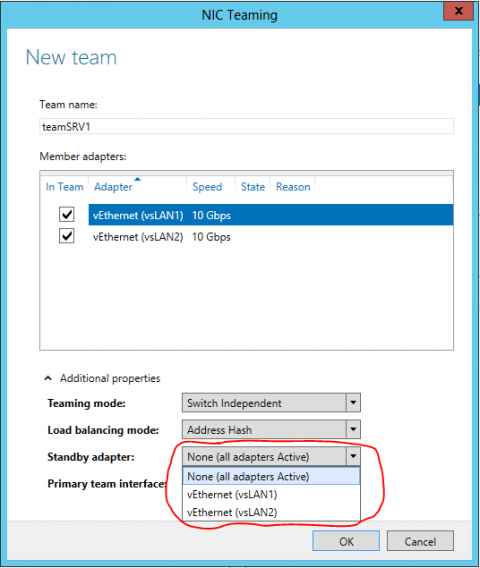

Один из адаптеров в группе можно назначить резервным (Standby adapter). В обычном режиме работы данная NIC не используется для передачи трафика. При неполадке на любом другом адаптере в группе NIC Teaming, он тут-же занимает его место. В общем случае и без данной функции при выходе из строя любой сетевой карты, не будет простоя сервиса, т.к. ее нагрузка автоматически распределится между оставшимися картами в группе.

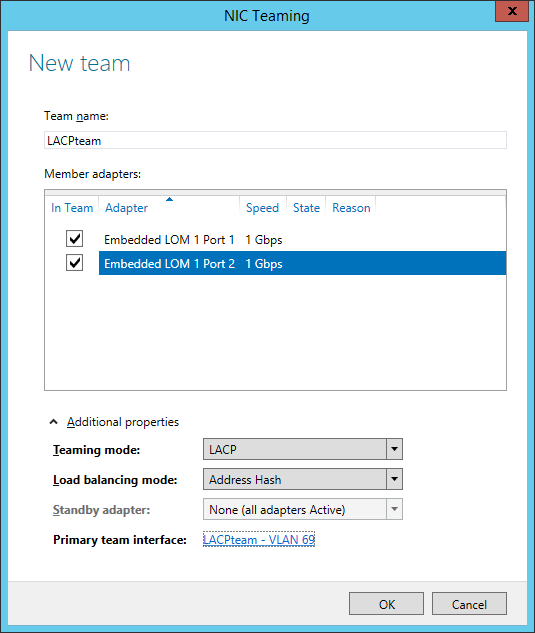

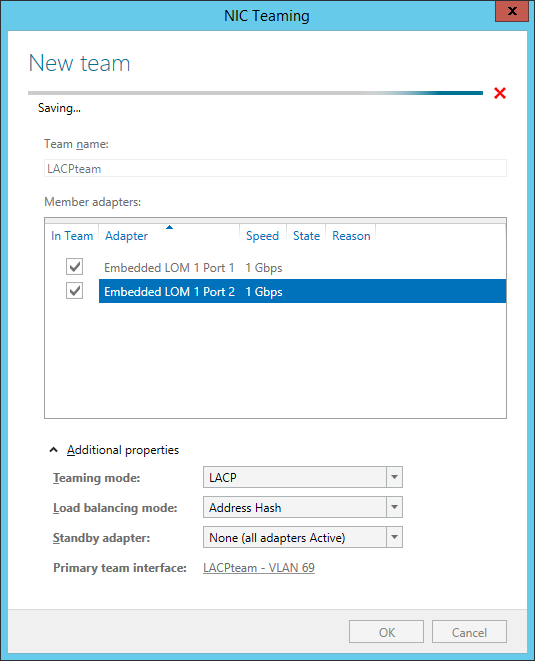

Выберите нужные параметры, нажмите ОК и новая группа Nic Teaming будет создана.

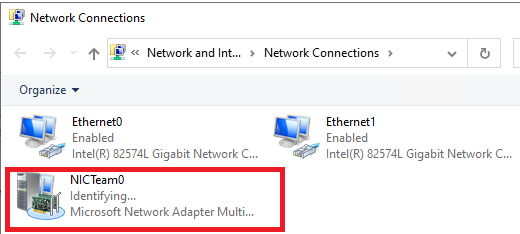

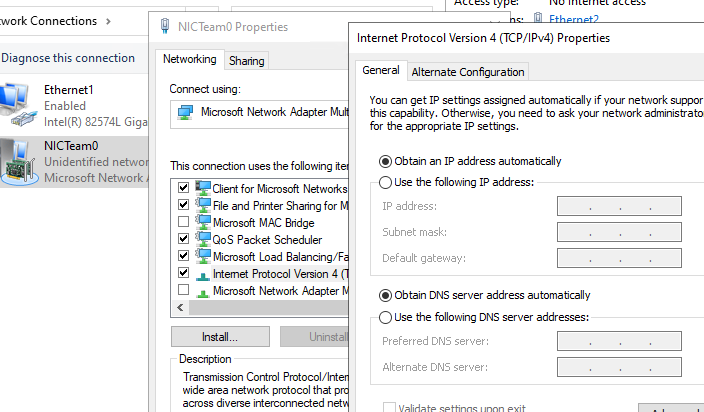

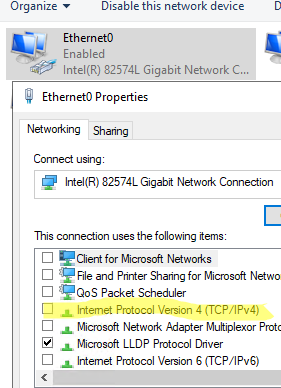

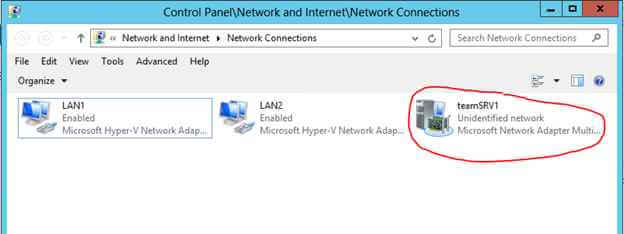

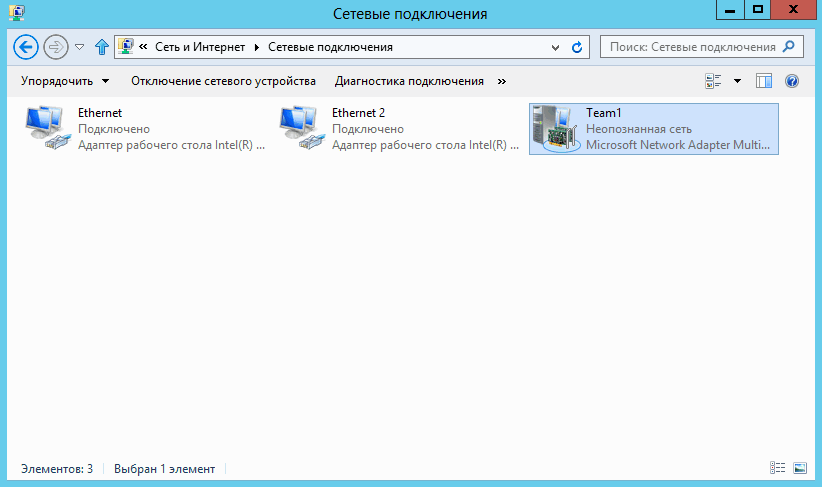

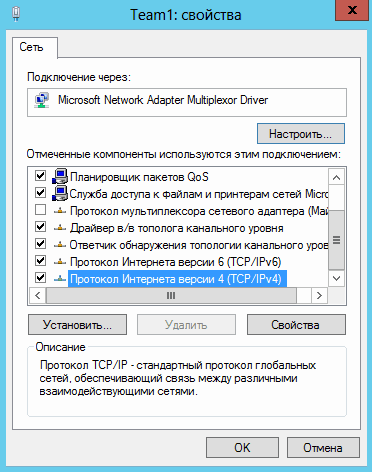

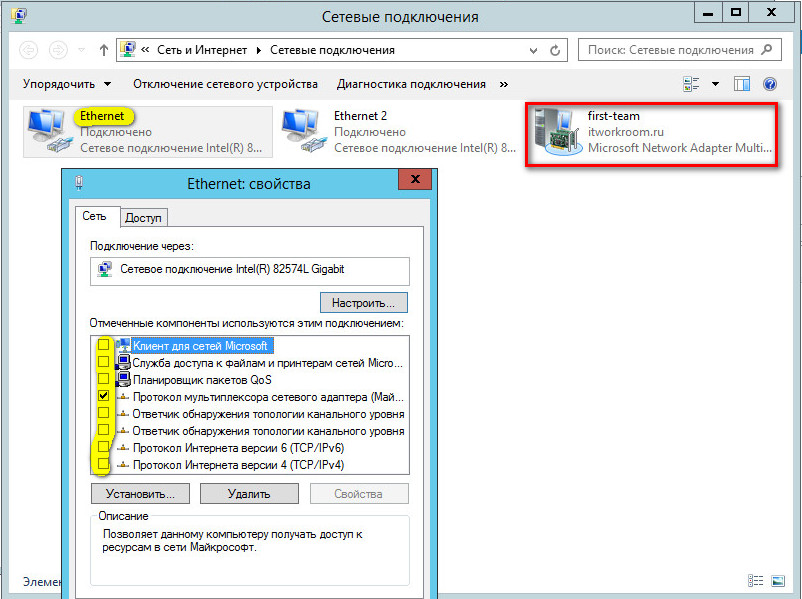

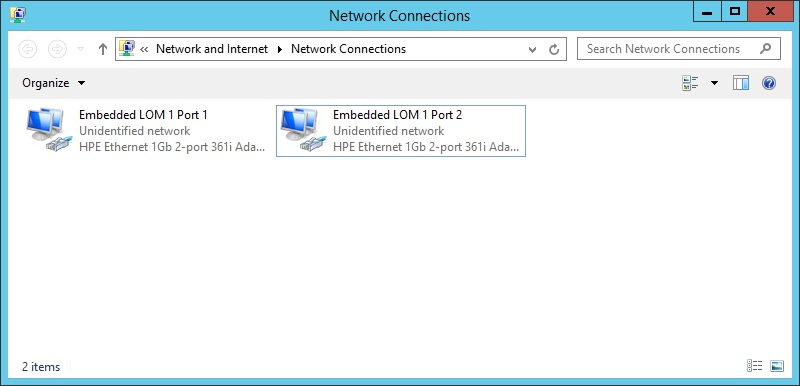

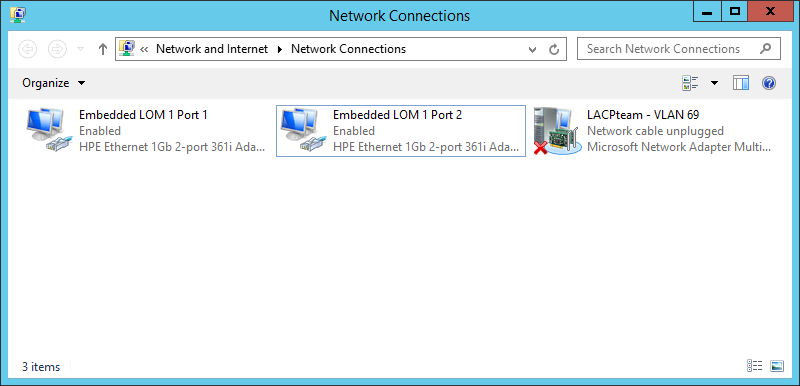

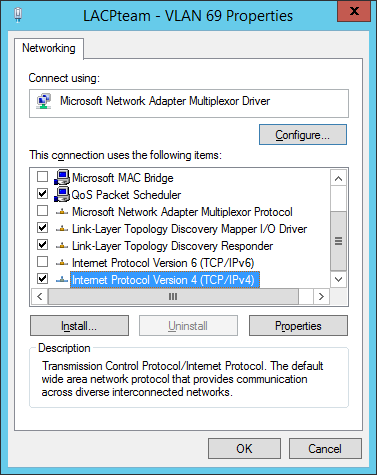

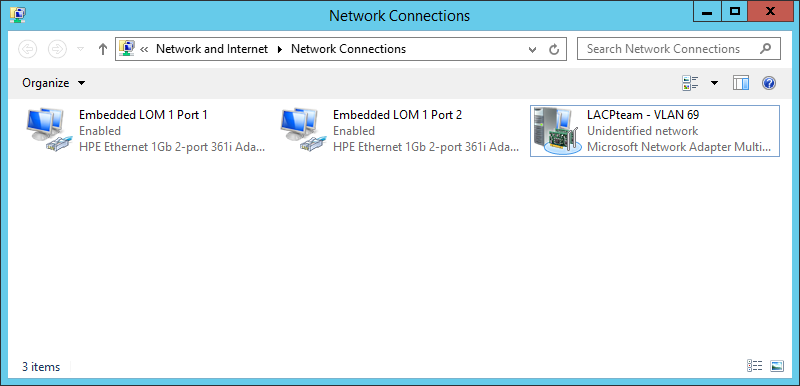

Откройте список сетевых подключения в панели управления Windows. Убедитесь, что в Windows Server появился новый сетевой адаптер Microsoft Network Adapter Multiplexor Driver (его иконка немного отличается). Это и есть виртуальный адаптер группы NIC Teaming.

Дальнейшая настройка параметров сетевой карты (протоколы, IPv4/v6 адрес) осуществляется теперь в свойствах этого адаптера.

У всех остальных сетевых адаптеров, которые вы добавили в группу NIC Teaming уже не будет собственных IP адресов.

При удалении группы NIC Teaming предыдущие настройки сетевых адаптеров восстанавливаются.

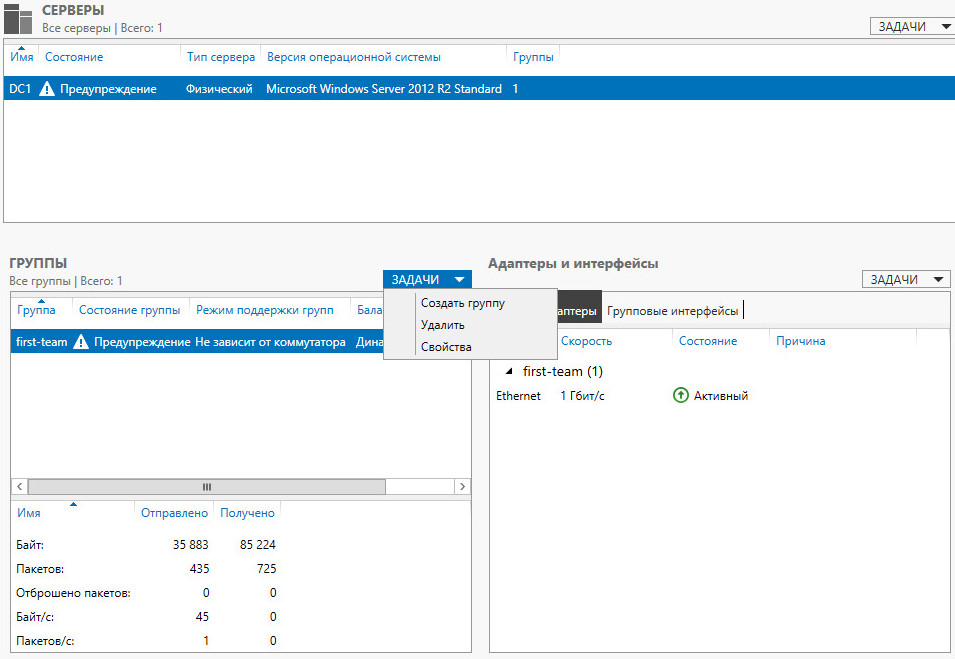

В дальнейшем вы можете добавить или удалить сетевые адаптеры в группу NIC Teaming.

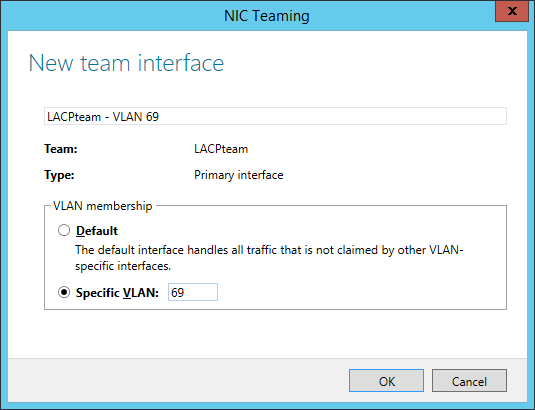

Вы можете использовать группу NIC Teaming для настройки нескольких VLAN интерфейсов в Windows Server. Для этого можно даже создать группу NIC Teaming из одного сетевого адаптера.

Используем PowerShell для настройки NIC Teaming в Windows Server

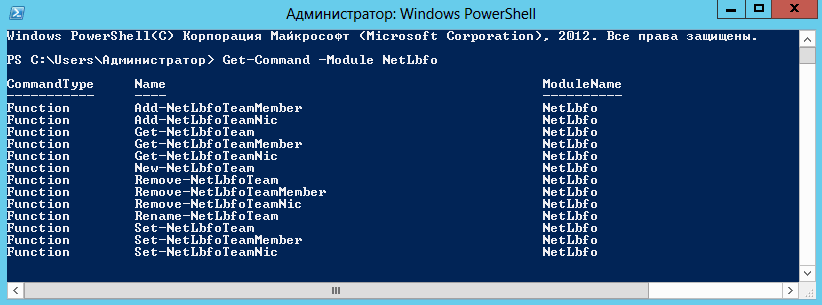

Вы можете создавать и управлять группами NIC Teaming не только из графического интерфейса Windows, но и с помощью PowerShell. Вы можете использовать PowerShell для настройки NIC Teaming в Windows Server Core

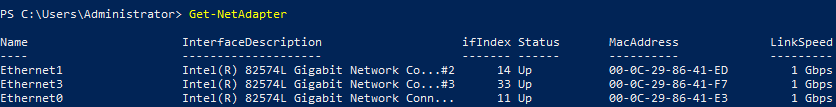

В Windows Server для управления MIC Teaming есть встроенный модуль NetLbfo. Выведите список сетевых адаптеров на сервере:

Get-NetAdapter

Создайте новую группу с Team0 из адаптеров с именами Ethernet1 и Ethernet3. Выберите режим работы NIC Teaming: Switch Independent с динамической балансировкой.

New-NetLbfoTeam -Name Team0 -TeamMembers Ethernet1,Ethernet3 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm Dynamic

Доступные параметры:

- TeamingMode:

Static

,

SwitchIndependent

,

Lacp - LoadBalansingAlgorithm:

TransportPorts

,

IPAddresses

,

MacAddresses

,

HyperVPort

,

Dynamic

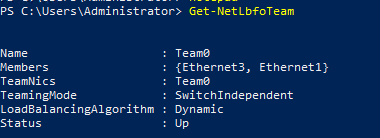

Информацию о группах NIC Teaming на сервере можно вывести с помощью команды:

Get-NetLbfoTeam

Name : Team0

Members : {Ethernet3, Ethernet1}

TeamNics : Team0

TeamingMode : SwitchIndependent

LoadBalancingAlgorithm : Dynamic

Status : Up

Можно настроить IP адрес интерфейса NIC Teaming с помощью PowerShell:

New-NetIPAddress -InterfaceAlias team0 -IPAddress 192.168.13.100 -PrefixLength 24 -DefaultGateway 192.168.13.1

Set-DnsClientServerAddress -InterfaceAlias team0 -ServerAddresses 192.168.13.10

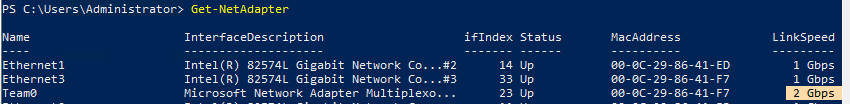

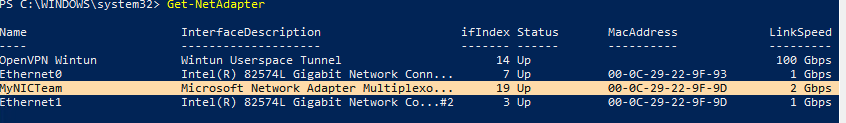

Выполните команду

Get-NetAdapter

. Обратите внимание, что LinkSpeed сетевого адаптера группу NIC Teaming — 2 Гбит/с.

Чтобы изменить настройки группы NIC Teaming используется командлет Set-NetLbfoTeam:

Set-NetLbfoTeam -Name team0 -TeamingMode LACP

Если выполнить эту команду в ВМ, появится ошибка

Set-NetLbfoTeam : 'SwitchIndependent' is the only TeamingMode value supported in a Virtual Machine

Чтобы через NIC Teaming добавить отдельный VLAN интерфейс, используйте команду:

Add-NetLbfoTeamNIC -Team Team0 -VlanID 10

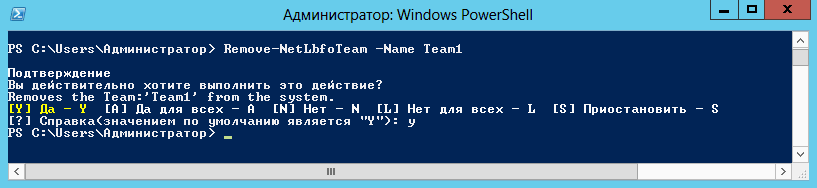

Удалить группу NIC Team можно командой:

Remove-NetLbfoTeam -Name Team0

Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Вы можете использовать NIC Teaming для объединения сетевых карт не только в Windows Server, но и в клиентских версиях Windows 10 и 11. Главное, чтобы производитель вашей сетевой карты поддерживал для нее режим Link aggregation / NIC teaming/ LBFO.

Например, NIC Teaming работает из коробки с драйверами картами Realtek PCIe GbE Family Controller ( 10.35.510.2019) или Intel(R) 82574L Gigabit Network Connection.

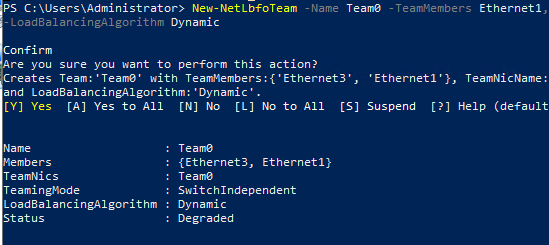

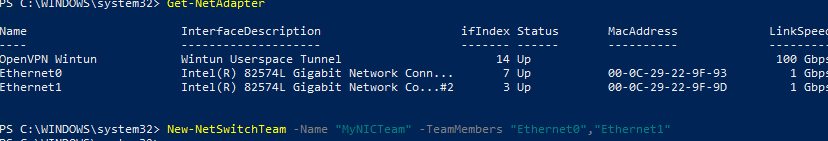

Чтобы собрать группу NIC Teaming в Windows 10 (в этом примере это Windows 10 20H2), откройте консоль PowerShell и выведите список сетевых адаптеров:

Get-NetAdapter

Соберем группу NIC Team из адаптеров Ethernet0 и Ethernet1.

New-NetSwitchTeam -Name "MyNICTeam" -TeamMembers "Ethernet0","Ethernet1"

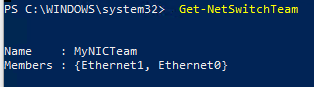

Проверьте, что в системе появился новый интерфейс NIC Teaming.

Get-NetSwitchTeam

Не забудьте задать для него сетевые настройки. Теперь у вас появился новый интерфейс с пропускной способностью 2 Гбит/с.

Для удаления созданной группы NIC Team, также нужно использовать PowerShell:

Remove-NetSwitchTeam -Name "MyNICTeam"

Агрегирование каналов (link aggregation) это технология, позволяющая объединять несколько физических сетевых интерфейсов в один логический, что позволяет увеличивать пропускную способность канала и его отказоустойчивость. Т.е. если объединить два сетевых адаптера со скоростью 1 Гбит/с, то общая полоса пропускания будет уже 2 Гбит/с, а в том случае, если один адаптер выходит из строя, то полоса пропускания упадет до 1 Гбит/с, но связь не прервется.

Применительно к Windows Server 2012 эта технология носит название NIC Teaming. С появлением Windows Server 2012 системные администраторы получили возможность объединять сетевые адаптеры в группу средствами самой операционной системы, причем объединять в группу можно адаптеры разных производителей (одно ограничение – они все должны работать на одной скорости). Максимальное количество адаптеров в группе составляет 32 штуки.

По умолчанию в Server 2012 режим NIC Teaming отключен и для его включения нужно открыть Server Manager, зайти в свойства сервера и нажать ссылку «Объединение сетевых карт» (NIC Teaming). Откроется окно, в котором нужно нажать кнопку «Задачи» (Tasks) и в списке задач выбрать пункт «Создать группу» (New Team).

Теперь вводим название группы и добавляем адаптеры, которые нужно объединить. После этого переходим к дополнительным настройкам группы. Прежде всего, нас интересует «Режим поддержки групп» (Teaming mode) который определяет способ взаимодействия группы с активным сетевым оборудованием, здесь есть следующие варианты:

— «Не зависит от коммутатора» (Switch Independent) – в этом режиме созданная группа работает независимо от коммутатора, в этом режиме не нужна дополнительная настройка сетевого оборудования. В этом режиме можно подключать адаптеры одной группы к разным коммутаторам для обеспечения отказоустойчивости на тот случай, если выйдет из строя один из коммутаторов. Именно этот режим выбирается по умолчанию.

— «Статическая поддержка групп» (Static Teaming) – в этом режиме все адаптеры группы должны быть подключены к одному коммутатору. При этом порты коммутатора, к которым подключены адаптеры группы, должны быть настроены в режим статической агрегации каналов.

— «LACP» – этот режим похож на предыдущий, но коммутатор в этом режиме должен быть настроен на использование динамической агрегации каналов с использованием протокола Link Aggregation Control Protocol (LACP).

Далее, нас интересует «Режим балансировки нагрузки» (Load Balancing mode) который определяет, как именно будет распределяться сетевой трафик между адаптерами группы. Варианты здесь следующие:

— «Хэш адреса» (Address Hash) – в этом режиме при передаче сетевого трафика на основании MAC или IP-адресов отправителя и получателя вычисляется хеш, который привязывается к определенному физическому адаптеру после чего весь дальнейший трафик от этого отправителя будет идти через определенный адаптер к которому привязан хэш.

— «Порт Hyper-V» (Hyper-V Port) – в этом режиме адаптер группы привязывается к определенному порту виртуального коммутатора в Hyper-V. Соответственно, этот режим можно использовать только в том случае, когда на сервере активирована роль Hyper-V.

Следующая настройка – «Резервный адаптер» (Standby adapter) как это уже понятно из названия, позволяет назначить один из адаптеров группы в качестве резервного. При нормальном функционировании адаптеров в группе резервный адаптер не используется, а в случае выхода из строя любого адаптера группы, резервный адаптер автоматически занимает его место и сетевой трафик продолжает бесперебойно передаваться.

В случае отсутствия резервного адаптера выход из строя одного из адаптеров группы также не приведет к остановке сетевого обмена (поскольку нагрузка будет автоматически распределена по оставшимся адаптерам), но уменьшится общая пропускная способность канала. В случае с назначенным резервным адаптером пропускная способность канал не изменится.

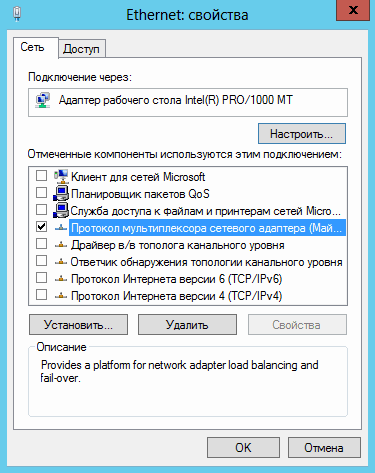

После окончания настроек свойств группы осталось нажать кнопку «ОК». Группа создана и в окне «Сетевые подключения» теперь появится еще один сетевой адаптер. Именно он и является виртуальным адаптером группы. Теперь в свойства физических сетевых адаптеров которые объединены в группу все компоненты кроме протокола мультиплексора сетевого адаптера отключены. Все настройки параметров адаптера теперь нужно осуществлять в свойствах виртуального адаптера.

Для тех, кто пользуется для администрирования сервера PowerShell, в нем присутствует модуль по имени NetLbfo список команд которого можно посмотреть введя команду

Get-Command –Module NetLbfo

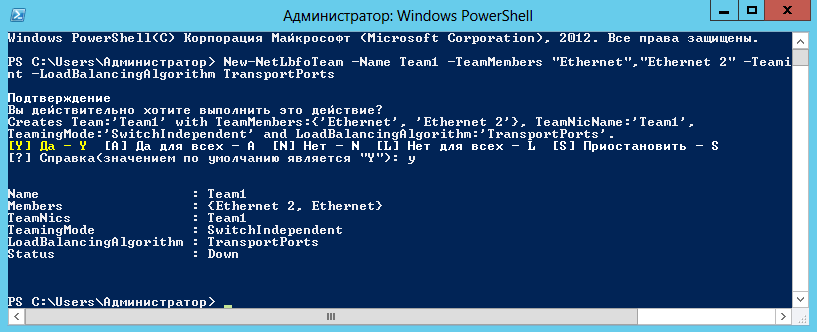

Например для создания группы TeamOne из адаптеров Ethernet и Ethernet 2, включения режима Switch Independent и балансировки нагрузки по хешу адреса нужно ввести команду:

New-NetLbfoTeam -Name TeamOne -TeamMembers ″Ethernet″,″Ethernet 2″

-TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

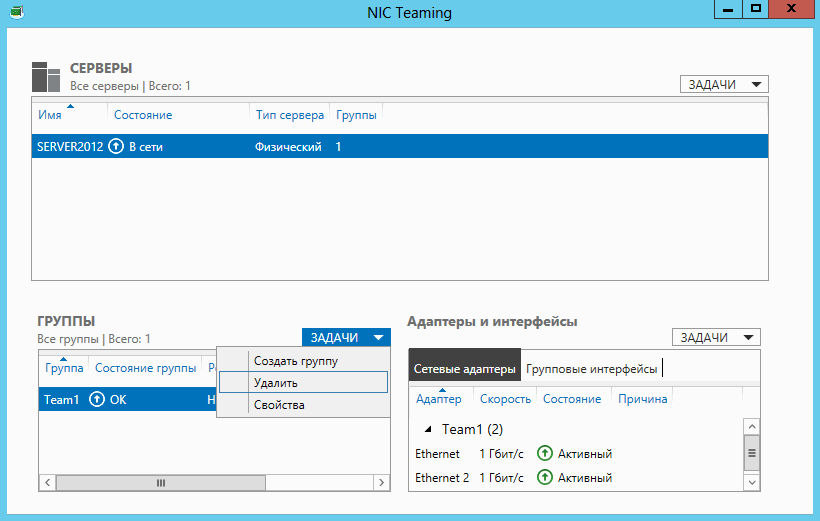

Для отключения режима NIC Teaming нужно просто удалить созданную группу в Server Manager (в окне NIC Teaming) или при помощи PowerShell командой

Remove-NetLbfoTeam -Name TeamOne

После удаления группы предыдущие настройки сетевых адаптеров будут восстановлены на состояние в котором они находились перед объединением их в группу.

Обновлено 11.02.2017

С выходом Windows Server 2012 технология NIC Teaming стала штатным средством серверной операционной системы. Долгое время решения по объединению (группировке) сетевых адаптеров для платформы Windows предоставлялись только сторонними производителями, прежде всего, поставщиками оборудования. Теперь Windows Server 2012 содержит инструменты, которые позволяют группировать сетевые адаптеры, в том числе, адаптеры разных производителей.

Что дает NIC Teaming?

Технология NIC Teaming, именуемая также как Load Balancing/Failover (LBFO), доступна во всех редакциях Windows Server 2012 и во всех режимах работы сервера (Core, MinShell, Full GUI). Объединение (тиминг) нескольких физических сетевых адаптеров в группу приводит к появлению виртуального сетевого интерфейса tNIC, который представляет группу для вышележащих уровней операционной системы.

Объединение адаптеров в группу дает два основных преимущества:

Отказоустойчивость на уровне сетевого адаптера и, соответственно, сетевого трафика. Выход из строя сетевого адаптера группы не приводит к потери сетевого соединения, сервер переключает сетевой трафик на работоспособные адаптеры группы.

Агрегирование полосы пропускания адаптеров, входящих в группу. При выполнении сетевых операций, например, копирования файлов из общих папок, система потенциально может задействовать все адаптеры группы, повышая производительность сетевого взаимодействия.

Особенности NIC Teaming в Windows Server 2012

Windows Server 2012 позволяет объединять в группу до 32 сетевых адаптеров Ethernet. Тиминг не Ethernet адаптеров (Bluetooth, Infiniband и пр.) не поддерживается. В принципе, группа может содержать только один адаптер, например, для разделения трафика по VLAN, но, очевидно, отказоустойчивость в этом случае не обеспечивается.

Драйвер сетевого адаптера, включаемого в группу, должен иметь цифровую подпись Windows Hardware Qualification and Logo (WHQL). В этом случае можно объединять в группу адаптеры разных производителей, и это будет поддерживаемая Microsoft конфигурация.

В одну группу можно включать только адаптеры с одинаковой скоростью подключения (speed connections).

Не рекомендуется использовать на одном сервере встроенный тиминг и тиминг третьих фирм. Не поддерживаются конфигурации, когда адаптер, входящий в тиминг стороннего производителя, добавляется в группу, создаваемую штатными средствами ОС, и наоборот.

Параметры NIC Teaming

При создании тиминговой группы необходимо указать несколько параметров (рассмотрены ниже), два из которых имеют принципиальное значение: режим тиминга (teaming mode) и режим балансировки трафика (load balancing mode).

Режим тиминга

Тиминговая группа может работать в двух режимах: зависимый от коммутатора (switch dependent) и не зависимый от коммутатора (switch independent).

Как следует из названия, в первом варианте (switch dependent) потребуется настройка коммутатора, к которому подключаются все адаптеры группы. Возможны две опции – статическая настройка свича (IEEE 802.3ad draft v1), либо использование протокола Link Aggregation Control Protocol (LACP, IEEE 802.1ax).

В режиме switch independent адаптеры группы могут быть подключены к разным коммутаторам. Подчеркиваю, могут быть, но это необязательно. Просто если это так, отказоустойчивость может быть обеспечена не только на уровне сетевого адаптера, но и на уровне коммутатора.

Режим балансировки

Кроме указания режима работы тиминга, необходимо еще указать режим распределения или балансировки трафика. Таких режимов по сути два: Hyper-V Port и Address Hash.

Hyper-V Port. На хосте с поднятой ролью Hyper-V и n-ым количеством виртуальных машин (ВМ) данный режим может оказаться весьма эффективным. В этом режиме порт Hyper-V Extensible Switch, к которому подключена некоторая ВМ, ставится в соответствие какому-либо сетевому адаптеру тиминговой группы. Весь исходящий трафик данной ВМ всегда передается через этот сетевой адаптер.

Address Hash. В этом режиме для сетевого пакета вычисляется хэш на основе адресов отправителя и получателя. Полученный хэш ассоциируется с каким-либо адаптером группы. Все последующие пакеты с таким же значением хэша пересылаются через этот адаптер.

Хэш может вычисляться на основе следующих значений:

MAC-адрес отправителя и получателя;

IP-адрес отправителя и получателя (2-tuple hash);

TCP-порт отправителя и получателя и IP-адрес отправителя и получателя (4-tuple hash).

Вычисление хэша на основе портов позволяет распределять трафик более равномерно. Однако для трафика отличного от TCP или UDP применяется хэш на основе IP-адреса, для не IP-трафика – хэш на основе MAC-адресов.

Таблица ниже описывает логику распределения входящего/исходящего трафика в зависимости от режима работы группы и выбранного алгоритма распределения трафика. Отталкиваясь от этой таблицы, вы сможете выбрать наиболее подходящий для вашей конфигурации вариант.

Address Hash Hyper-V Port

Switch Independent Исходящий трафик распределяется между всеми активными адаптерами группы

Входящий трафик поступает только на один интерфейс (основной адаптер группы). В случае сбоя в работе основного адаптера группы, его функции передаются другому сетевому адаптеру, и весь входящий трафик направляется к нему К исходящим пакетам присоединяется тег со ссылкой на порт коммутатора Hyper-V, через который эти пакеты были переданы. Все пакеты с одного порта направляются одному и тому же адаптеру группы

Входящий трафик, предназначенный для конкретного порта Hyper-V, поступает тому же адаптеру группы, который используется для отправки пакетов

с этого порта

Static, LACP Исходящий трафик распределяется между всеми активными адаптерами группы

Входящий трафик будет перенаправляться

в соответствии с алгоритмом распределения нагрузки, который реализован в коммутаторе К исходящим пакетам присоединяется тег со ссылкой на порт коммутатора Hyper-V, через который эти пакеты были переданы. Все пакеты с одного порта направляются одному и тому же адаптеру группы. Если группа была переведена в режим распределения портов коммутатора Hyper-V, но не была подключена к коммутатору Hyper-V, весь исходящий трафик будет отправлен одному адаптеру группы

Входящий трафик будет перенаправляться в соответствии с алгоритмом распределения нагрузки, который реализован в коммутаторе

Необходимо отметить еще один параметр. По умолчанию все адаптеры группы являются активными и задействуются для передачи трафика. Однако вы можете один из адаптеров указать в качестве Standby. Это адаптер будет использоваться только в качестве «горячей» замены, если один из активных адаптеров выходит из строя.

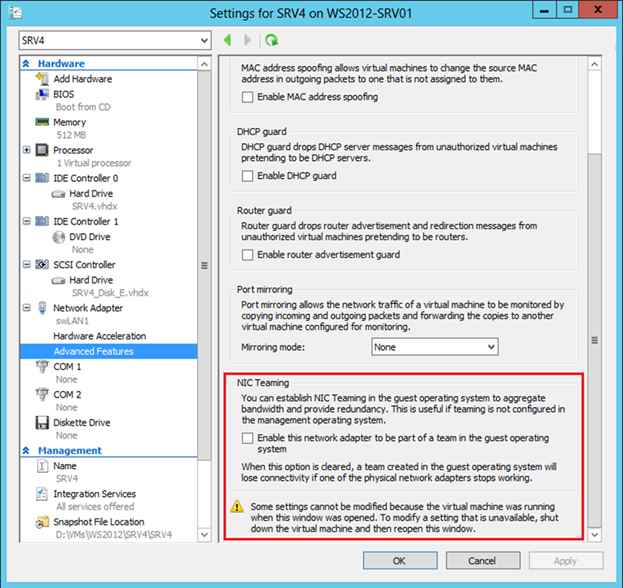

NIC Teaming в гостевой ОС

По разным причинам вы можете не захотеть включать тиминг на хостовой машине. Или же установленные адаптеры не могут быть объединены в тиминг штатными средствами ОС. Последнее справедливо для адаптеров с поддержкой SR-IOV, RDMA или TCP Chimney. Тем не менее, если на хосте более одного даже такого физического сетевого адаптера, можно использовать NIC Teaming внутри гостевой ОС. Представим, что на хосте две сетевые карточки. Если в некоторой ВМ два виртуальных сетевых адаптера, эти адаптеры через два виртуальных свича типа external подключены к, соответственно, двум физическим карточкам, и внутри ВМ установлена ОС Windows Server 2012, то вы можете сконфигурировать NIC Teaming внутри гостевой ОС. И такая ВМ сможет воспользоваться всеми преимуществами тиминга, и отказоустойчивостью, и повышенной пропускной способностью. Но для того, чтобы Hyper-V понимал, что при выходе из строя одного физического адаптера, трафик для этой ВМ нужно перебросить на другой физический адаптер, нужно установить чекбокс в свойствах каждого виртуального NIC, входящего в тиминг.

NIC Teaming в Windows Server 2012R2-01

В PowerShell аналогичная настройка задается следующим образом:

Set-VMNetworkAdapter -VMName srv4 -AllowTeaming On

Добавлю, что в гостевой ОС можно объединить в группу только два адаптера, и для группы возможен только switch independent + address hash режим.

Настройка NIC Teaming

Настройка тиминга возможна в графическом интерфейсе Server Manager, либо в PowerShell. Начнем с Server Manager, в котором необходимо выбрать Local Server и NIC Teaming.

NIC Teaming в Windows Server 2012R2-02

В разделе TEAMS в меню TASKS выбираем New Team.

NIC Teaming в Windows Server 2012R2-03

Задаем имя создаваемой группы, помечаем включаемые в группу адаптеры и выбираем режим тиминга (Static, Switch Independent или LACP).

NIC Teaming в Windows Server 2012R2-04

Выбираем режим балансировки трафика.

NIC Teaming в Windows Server 2012R2-05

Если необходимо, указываем Standby-адаптер.

NIC Teaming в Windows Server 2012R2-06

В результате в списке адаптеров появляется новый сетевой интерфейс, для которого необходимо задать требуемые сетевые настройки.

NIC Teaming в Windows Server 2012R2-07

При этом в свойствах реальных адаптеров можно увидеть включенный фильтр мультиплексирования.

NIC Teaming в Windows Server 2012R2-08

В PowerShell манипуляции с тимингом реализуются набором команд с суффиксом Lbfo. Например, создание группы может выглядеть так

New-NetLbfoTeam

-Name teamSRV1

-TeamMembers LAN1,LAN2

-TeamingMode SwitchIndependent

-LoadBalancingAlgorithm TransportPorts

Здесь TransportPorts означает балансировку с использованием 4-tuple hash.

Замечу, что вновь созданный сетевой интерфейс по умолчанию использует динамическую IP-адресацию. Если в скрипте нужно задать фиксированные настройки IP и DNS, то сделать это можно, например, так:

New-NetIPAddress

-InterfaceAlias teamSRV1

-IPAddress 192.168.1.163

-PrefixLength 24 -DefaultGateway 192.168.1.1

Set-DnsClientServerAddress

-InterfaceAlias teamSRV1

-ServerAddresses 192.168.1.200

Таким образом, встроенными средствами Windows Server 2012 вы можете теперь группировать сетевые адаптеры хостовой или виртуальной машины, обеспечивая отказоустойчивость сетевого трафика и агрегирование пропускной полосы адаптеров.

Увидеть технологию в действии, а также получить дополнительную информацию по этой и другим сетевым возможностям Windows Server 2012 вы можете, просмотрев бесплатные курсы на портале Microsoft Virtual Academy:

Технология объединения сетевых адаптеров NIC Teaming заключается в том, что несколько физических адаптеров (NIC) объединяются в группу, в результате чего получается один единственный логический адаптер. Процесс объединения называют teaming. NIC Teaming решает две основные задачи:

• Увеличение полосы пропускания — полоса увеличивается пропорционально количеству адаптеров в группе. Например, если объединить в NIC Teaming четыре сетевых адаптера со скоростью 1 Гбит/с, то общая полоса пропускания составит 4 Гбит/с;

• Отказоустойчивость — когда один адаптер выходит из строя, остальные берут на себя его функции и связь не прерывается.

NIC Teaming технология не новая, но раньше ее реализация целиком зависела от производителей сетевого оборудования. Возможность объединять сетевые адаптеры в группу средствами операционной системы появилась только в Windows Server 2012. NIC Teaming в Server 2012 позволяет объединять в группу адаптеры разных производителей, единственное ограничение — все они должны работать на одной скорости. Объединить в NIC Teaming можно до 32 сетевых адаптеров.

Включение и настройка

По умолчанию режим NIC Teaming отключен. Чтобы его активировать открываем Server Manager, заходим в свойства сервера и нажимаем ссылку Объединение сетевых карт (NIC Teaming).

В открывшемся окне жмем на кнопку Задачи (Tasks) и выбираем пункт Создать группу (New Team).

Даем группе название и выбираем добавляемые адаптеры.

Затем настраиваем дополнительные свойства группы. Поскольку от этих параметров зависит эффективность работы NIC Teaming, стоит рассмотреть их поподробнее.

Режим поддержки групп (Teaming mode) определяет режим взаимодействия группы с сетевым оборудованием:

• Не зависит от коммутатора (Switch Independent) — группа работает независимо от коммутатора, никакой дополнительной настройки сетевого оборудования не требуется. Этот режим позволяет подключать адаптеры одной тиминговой группы к разным свичам для защиты от сбоя одного из них. Выбирается по умолчанию;

• Статическая поддержка групп (Static Teaming) — режим с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору. Порты коммутатора, к которым подключены адаптеры группы, настраиваются на использование статической агрегации каналов;

• LACP — также зависит от сетевого оборудования. Коммутатор настраивается на использование динамической агрегации каналов с использованием протокола Link Aggregation Control Protocol (LACP).

Режим балансировки нагрузки (Load Balancing mode) определяет, каким образом распределять сетевой трафик между адаптерами группы:

• Хэш адреса (Address Hash) — при передаче сетевого трафика на основании MAC или IP-адресов отправителя и получателя вычисляется хеш (число). Это число привязывается к определенному физическому адаптеру и в дальнейшем весь трафик от этого отправителя будет идти через этот адаптер;

• Порт Hyper-V (Hyper-V Port) — в этом режиме осуществляется привязка адаптера тиминговой группы к определенному порту виртуального свича в Hyper-V. Этот режим используется в том случае, если на сервере активирована роль Hyper-V.

Резервный адаптер (Standby adapter) позволяет назначить один из адаптеров группы в качестве резервного. В нормальном состоянии резервный адаптер не используется для передачи трафика, но при выходе любого адаптера группы из строя сразу занимает его место и трафик продолжает передаваться без перерывов. Впрочем, даже без резервирования выход из строя одного адаптера в NIC Teaming не приведет к прерыванию сетевых операций, т.к. нагрузка будет автоматически распределена по оставшимся адаптерам.

Настроив свойства группы, жмем ОК. Все, группа создана. Теперь в окне «Сетевые подключения» появился еще один сетевой адаптер, который как раз и является виртуальным адаптером группы.

Если посмотреть свойства физических сетевых адаптеров, то мы увидим, что все компоненты кроме протокола мультиплексора сетевого адаптера отключены

А все настройки теперь производятся в свойствах виртуального адаптера.

Включить и управлять NIC Teaming можно и с помощью PowerShell. Для этого в PS есть целый модуль по имени NetLbfo.

К примеру, следующая команда создает группу Team1 из адаптеров Ethernet и Ethernet 2, включает режим Switch Independent и задает балансировку нагрузки по хешу адреса:

New-NetLbfoTeam -Name Team1 -TeamMembers ″Ethernet″,″Ethernet 2″ `

-TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

Отключение NIC Teaming

Отключение NIC Teaming произойдет, если удалить тиминговую группу. Сделать это можно в Server Manager, в окне NIC Teaming.

Также удалить группу можно через PowerShell командой Remove-NetLbfoTeam -Name Team1

Кстати, при удалении группы восстанавливаются предыдущие настройки сетевых адаптеров.

Заключение

Реализация технологии NIC Teaming в Windows Server 2012 откровенно порадовала. Она проста в настройке, не предъявляет специальных требований к оборудованию и может работать работает практически с любыми сетевыми адаптерами. В общем я за ее использование, однозначно.

Увеличение пропускной способности — увеличение полосы пропускания пропорционально количеству адаптеров в группе. К примеру, если объединить в NIC Teaming два сетевых адаптера со скоростью 1 Гбит/с, то общая полоса пропускания составит 2 Гбит/с;

Отказоустойчивость — при выходе из строя одного из адаптеров в группе, связь ни на секунду не прерывается и остальные сетевые адаптеры поменяют вышедший из строя.

Технология NIC Teaming не нова, но ранняя ее реализация зависела от производителей сетевого оборудования. Возможность объединять сетевые адаптеры в группу средствами ОС появилась только в редакции начиная с Windows Server 2012. Эта технология позволяет объединять в группу адаптеры разных производителей, единственное ограничение — все они должны работать на одной скорости. Ограничение по количеству объединяемых сетевых адаптеров в NIC Teaming равна 32.

Настройка

По умолчанию режим «NIC Teaming» в Windows server 2012 R2 отключен. Для его активации открываем «Server Manager» и заходим в свойства сервера, далее нажимаем: Объединение сетевых карт (NIC Teaming).

В Задачах (Tasks) выбираем пункт Создать группу (New Team).

Далее именуем группу, выбираем отмечаем адаптеры и настраиваем дополнительные свойства группы. Далее подробней рассмотрим дополнительные параметры настройки «NIC Teaming» в Windows server 2012 R2:

Режим поддержки групп (Teaming mode) определяет режим взаимодействия группы с сетевым оборудованием:

1. Не зависит от коммутатора (Switch Independent) — группа работает независимо от коммутатора, никакой дополнительной настройки сетевого оборудования не требуется. Этот режим позволяет подключать адаптеры одной тиминговой группы к разным свичам для защиты от сбоя одного из них. настройка по умолчанию;

2. Статическая поддержка групп (Static Teaming) — режим с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору. Порты коммутатора, к которым подключены адаптеры группы, настраиваются на использование статической агрегации каналов;

3. LACP — режим с зависимостью от сетевого оборудования. Коммутатор настраивается на использование динамической агрегации каналов с использованием протокола «Link Aggregation Control Protocol» (LACP).

Режим балансировки нагрузки (Load Balancing mode) определяет, каким образом распределять сетевой трафик между адаптерами группы:

1. Хэш адреса (Address Hash) — при передаче сетевого трафика на основании MAC или IP-адресов отправителя и получателя вычисляется хеш (некое число). Это число привязывается к определенному физическому адаптеру и в дальнейшем весь трафик от этого отправителя будет идти через этот адаптер;

2. Порт Hyper-V (Hyper-V Port) — в этом режиме осуществляется привязка адаптера teaming группы к определенному порту виртуального свича в Hyper-V. Этот режим используется в том случае, если на сервере активирована роль Hyper-V.

Резервный адаптер (Standby adapter) позволяет назначить один из адаптеров группы в качестве резервного. В нормальном состоянии резервный адаптер не используется для передачи трафика, но при выходе любого адаптера группы из строя сразу занимает его место и трафик продолжает передаваться без перерывов. Но даже без резервирования выход из строя одного адаптера в NIC Teaming не приведет к прерыванию сетевого соединения, потому что, нагрузка будет автоматически распределена по оставшимся адаптерам.

Команда создания группы «NIC Teaming» в powerShell:

New-NetLbfoTeam -Name First-team -TeamMembers ″Ethernet″,″Ethernet 2″ ` -TeamingMode SwitchIndependent -LoadBalansingAlgorithm TransportPorts

После создания группы, в окне «Сетевые подключения» появиться еще один сетевой адаптер, который как раз и является виртуальным адаптером созданной группы, при этом если посмотреть свойства физического сетевого адаптера, то мы увидим, что все компоненты кроме протокола мультиплексора сетевого адаптера отключены (выделено желтым).

Удалить группу можно также командой power shell: Remove-NetLbfoTeam -Name First-team или в графическом интерфейсе:

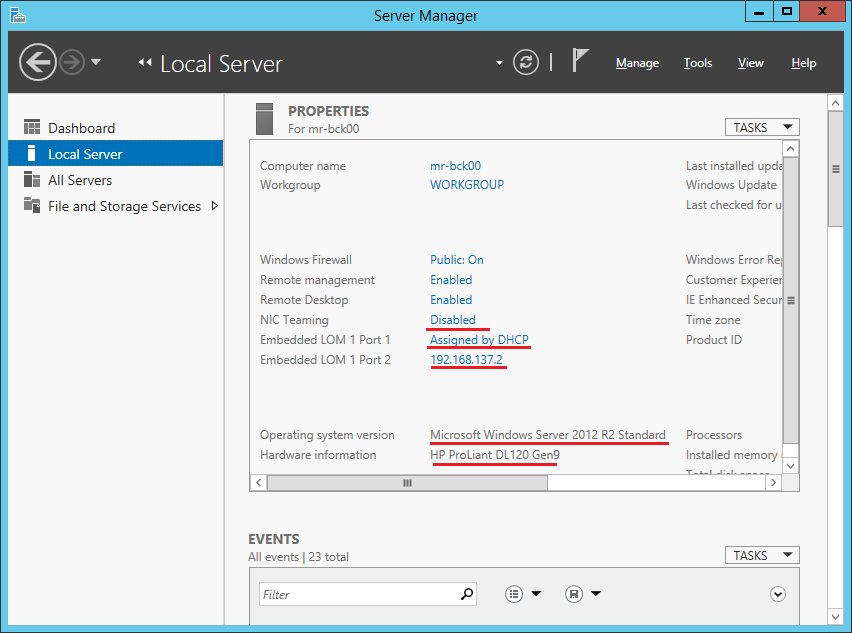

Всем привет, сегодня будем агрегировать две сетевухи на сервере HPE Proliant DL120 Gen9 штатными средствами операционной системы Windows Server 2012 R2. Вы ещё не агрегируете? Тогда мы идём к вам!

Имеется:

- Железный сервер HPE Proliat DL120 Gen9.

- На борту две сетевухи, на одной из них работает iLO в режиме Shared Network — это важно.

- ОС — Windows Server 2012 R2

- Есть возможность настроить порты коммутаторов.

Оффтопик

На серверах HP с iLO на Shared Network Port используйте режим Switch Independent. Адаптеры настраивайте в режим Active-Standby.

Причины для интересующихся ниже.

NIC Teaming в Windows

NIC Teaming или Load Balancing/Failover (LBFO) входит в Windows начиная с Windows Server 2012. Технология позволяет объединить в группу (team) до 32 сетевых адаптеров Ethernet. В группу можно объединять адаптеры разных производителей, условие — наличие цифровой подписи драйвера сетевухи. В группу можно объединять адаптеры одинаковой скорости.

Что даёт NIC Teaming:

- Отказоустойчивость на уровне сетевухи. Перестала работать одна — включается вторая. С точки зрения системного администрирования это позволяет админу перетыкать по очереди провода в стойке не опасаясь, что всё перестанет работать.

- Агрегирование полосы пропускания адаптеров. Один гигабит хорошо, а два ещё лучше.

- Вы можете использовать NIC Teaming не по назначению. Никто не запрещает в группу добавить только один адаптер и использовать NIC Teaming для разделения трафика по VLAN. Я не особо представляю для чего это может понадобиться. Возможно, для работы с виртуальными машинами или ещё для чего-то.

Teaming mode

Тут на ровном месте развели путаницы. Есть три режима:

- Зависимый от коммутатора (switch dependent) — статическая настройка коммутатора (IEEE 802.3ad draft v1).

- Зависимый от коммутатора (switch dependent) — Link Aggregation Control Protocol (LACP, IEEE 802.1ax).

- Независимый от коммутатора (switch independent) — есть возможность подключения к разным коммутаторам для обеспечения ещё большей отказоустойчивости.

Мы с вами сегодня полностью настроим LACP. А потом разберём его и переделаем на switch independent. Потому как iLO нам всю агрегацию портит.

Load balancing mode

Есть три режима балансировки:

- Hyper-V Port. Сделано для Hyper-V. Сетевуха привязывается к виртуалке.

- Address Hash. Хеш на основе отправителя и получателя:

- MAC адреса (для не IP трафика)

- IP адреса (для не TCP и UDP трафика)

- Порт — обычно.

- Dynamic.

Standby adapter

Есть возможность один из адаптеров назначить как резервный. Тогда трафик будет гоняться только через активный.

LACP

Давайте для примера настроим LACP. У нас есть два гигабитных физических адаптера. Винда их видит.

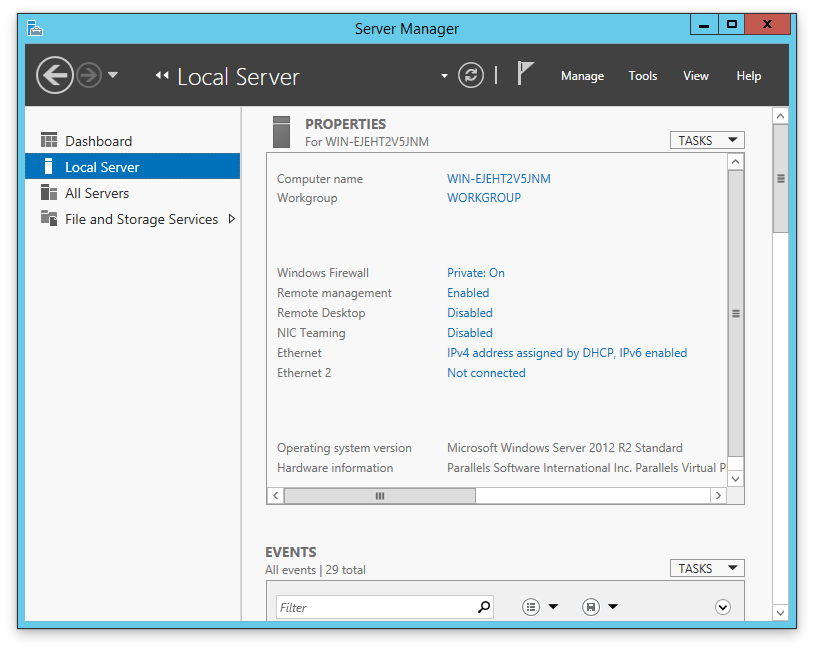

Открываем Server Manager > Local Server.

Очень удобное окошко — всё видно. Видно, что сервер железный HP Proliant DL120 Gen9. Видно ось. Видно что одна сетевуха настроена на получение IP адреса по DHCP, а на второй настроен какой-то статичный адрес. Нас интересует раздел NIC Teaming — Disabled. Тыкаем в него.

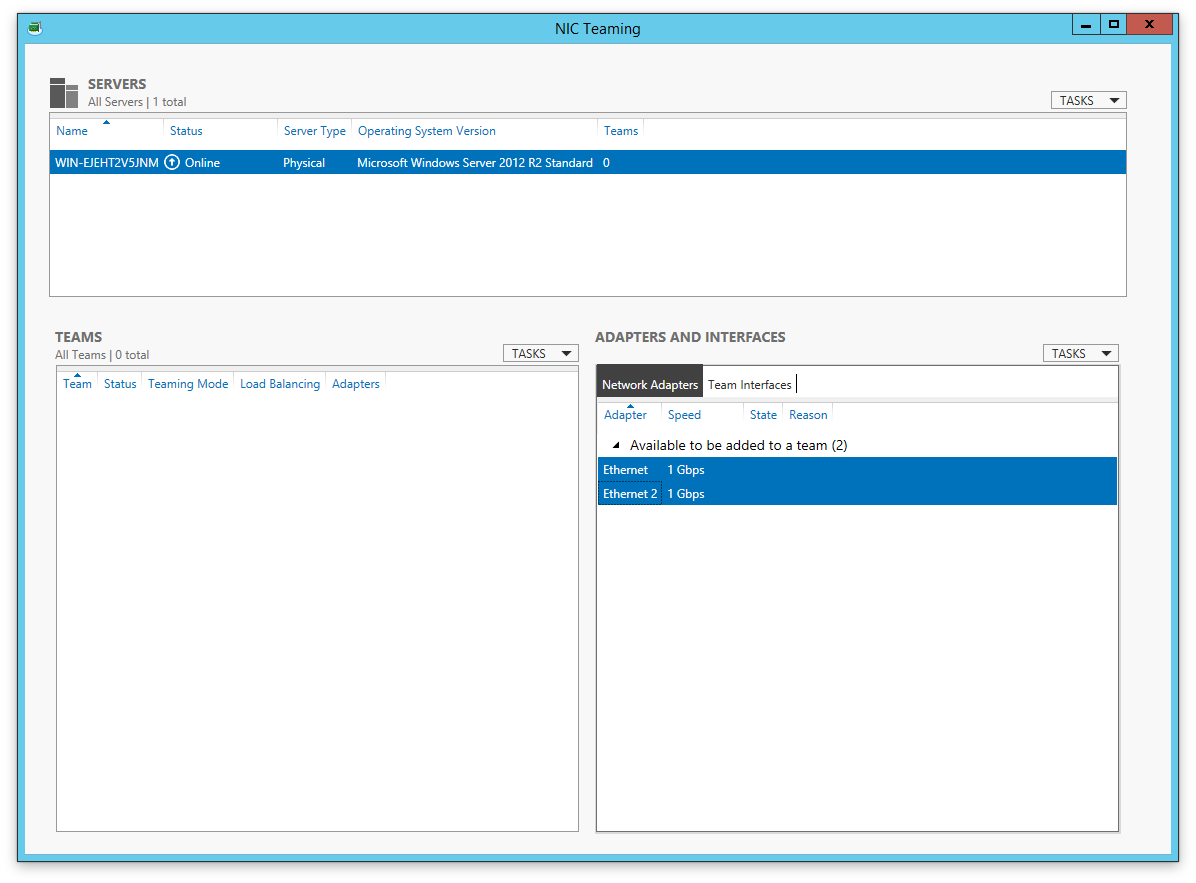

Открывается окно NIC Teaming. Вверху выбираем сервер, он у нас один. Справа ниже видим две сетевухи, которые можно объединить в группу.

Слева ниже нажимаем в TASKS > New Team.

Открывается окошко:

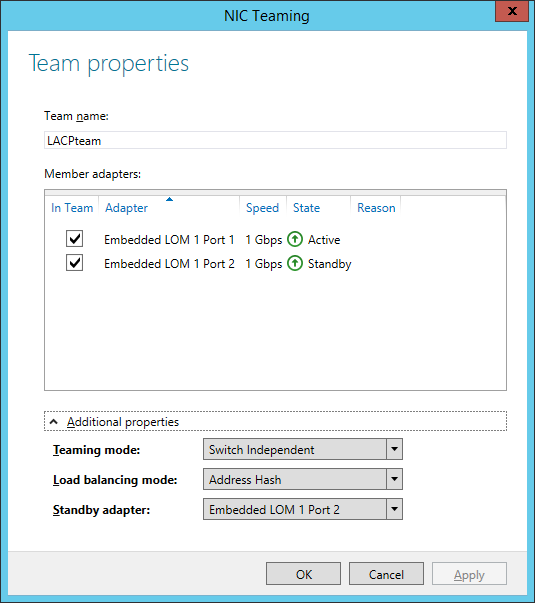

Указываем название группы. Отмечаем галками адаптеры, которые объединяем в группу. У меня их всего два, оба и выделяю. Разворачиваем скрытый ниже раздел Additional properties.

Teaming mode — LACP, его сейчас пробуем собрать.

Load balancing mode — ставлю Address Hash.

Standby adapter в режиме LACP не выбирается.

Кликаем по ссылке Primary team interface:

У нас одна группа. Здесь мы можем только задать VLAN — пишем его при необходимости. OK.

Что-то вроде настроили. Тыкаем ОК. Побежал прогресс.

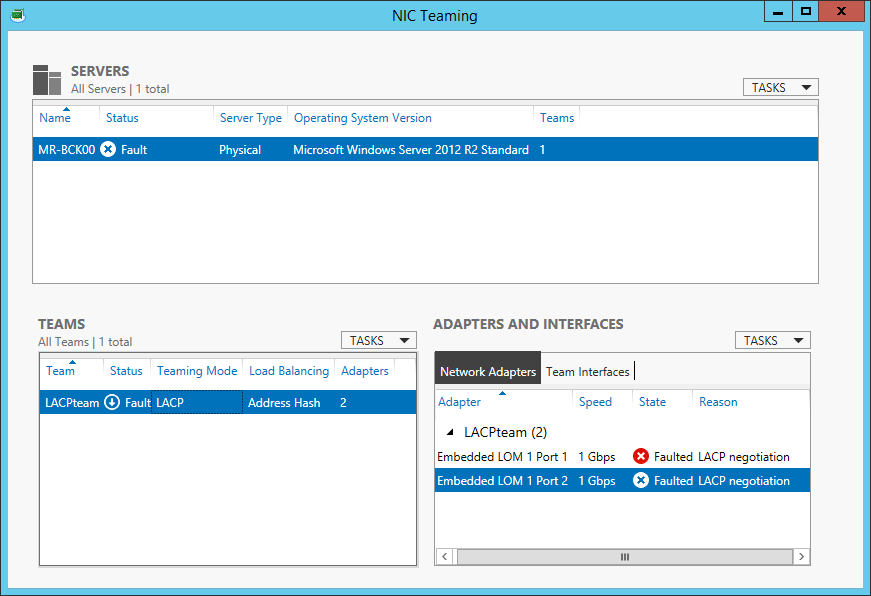

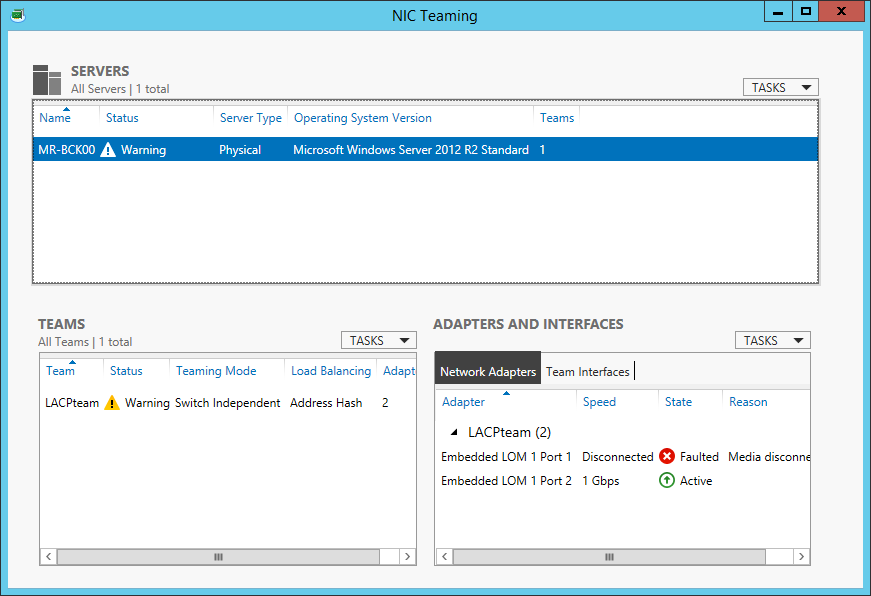

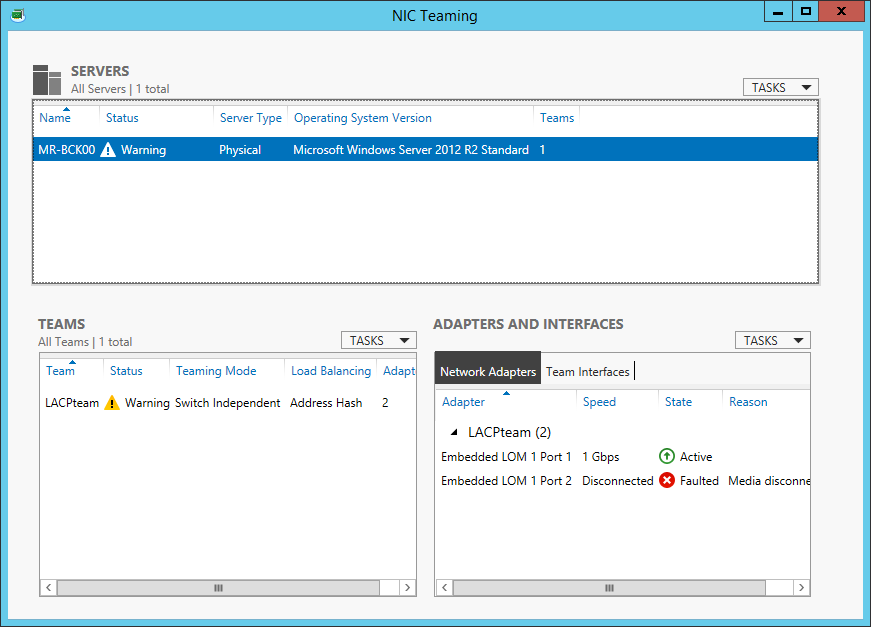

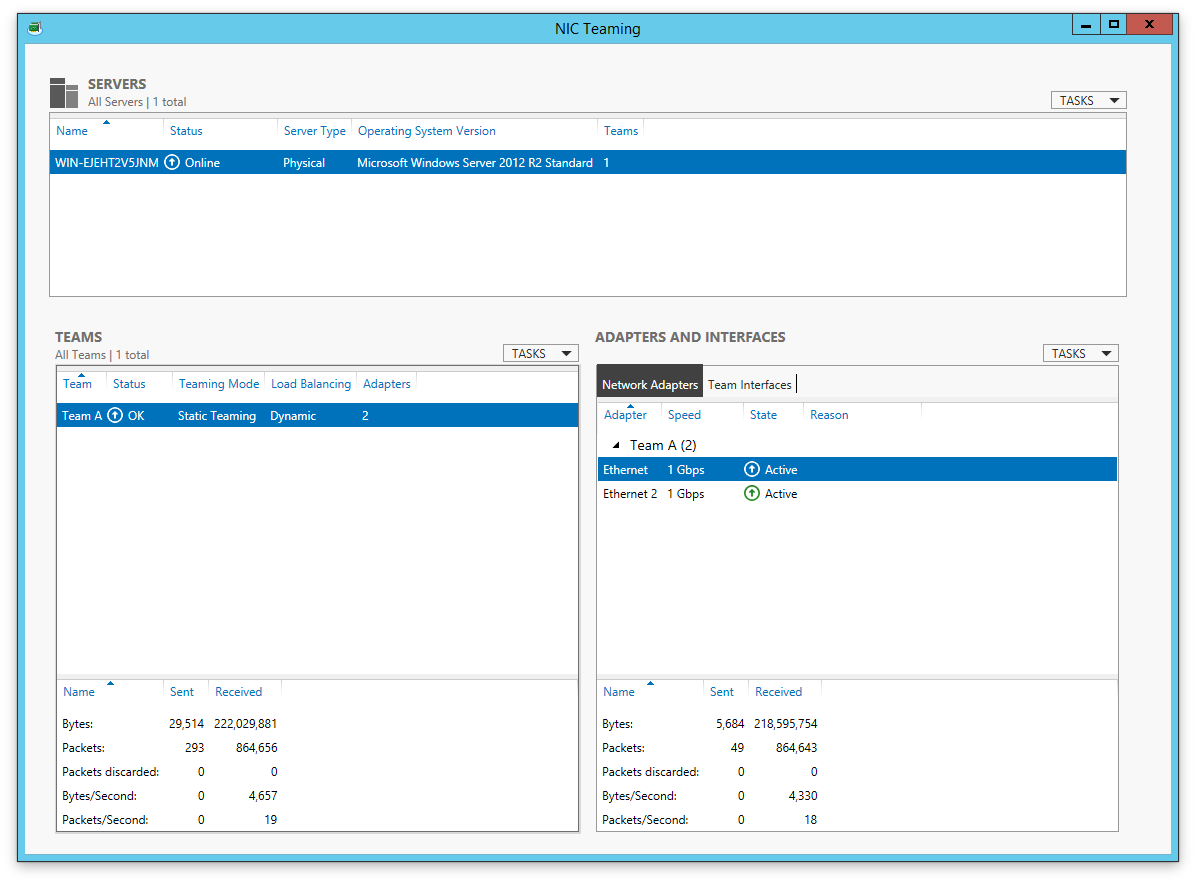

В окне NIC Teaming теперь видно группу. Ещё видно то, что обе сетевухи лежат. Это нормально, на коммутаторе-то мы ничего не настраивали. В списке сетевых адаптеров появляется новый — LACPteam, так мы назвали нашу группу.

Он тоже пока лежит. Сетевые наcтройки теперь нужно производить через него. Задаём их.

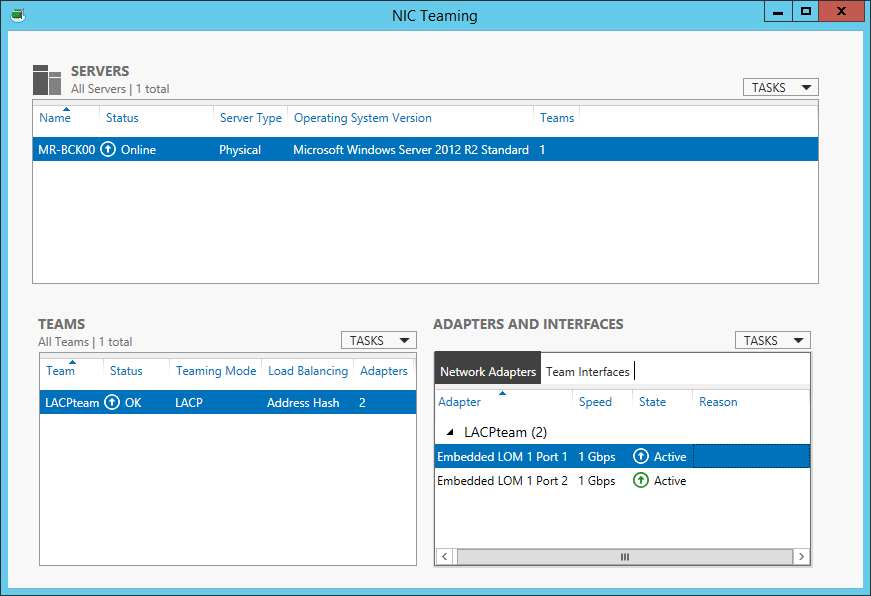

Пора зайти на коммутатор и настроить там LACP. После настройки адаптеры поднимаются.

Можно заметить, что оба адаптера Active. Адаптер группы тоже в работе.

Ура, мы настроили агрегацию!

Тестируем LACP

Отрубаем один провод:

Втыкаем провод обратно. Отрубаем второй провод:

Не LACP

Ложка дёгтя: iLO у нас теперь работает с вероятностью 50%. Либо нам повезло и мы попали на нужный Shared Network Port. Либо не повезло. Такое меня не устраивает — разбираем LACP на коммутаторах и перенастраиваем NIC Teaming.

Team mode: Switch Independent. (Не забываем разобрать LACP на коммутаторах.)

Standby adapter: любой, главное, чтобы оба не были активными.

И… всё снова работает.

Выход Windows Server 2012 в статусе Release Candidate, зафиксировавший основной набор ролей, компонентов и решений, позволяет более подробно остановиться на рекоторых из них.

Несомненный интерес вызывает возможность использования NIC Teaming средствами самой операционной системы. Для начала стоит ознакомиться с моделями подключения объединенных интерфейсов и алгоритмами

распределения трафика.

Модели подключения

NIC Teaming

- Switch-independent teaming, независимая от коммутатора

- Не требует конфигурации сетевого оборудования

- Возможность подключения к разным коммутораторам, как следствие защита от сбоя одного из них

- Switch-dependent teaming, с зависимостью от сетевого оборудования, с необходимым требованием является подключение интерфейсов к одному коммутатору; подразумевает две конфигурации

- Static teaming с использованием стандарта IEEE 802.3ad

- Dynamic teaming с использованием стандарта IEEE 802.1ax, LACP

Алгоритмы распределения трафика

- Hyper-V switch port. Windows Server использует не MAC-адрес, а порт коммутатора Hyper-V в качестве идентификатора исходящего трафика

- Address Hashing. Используются хэши MAC- и IP-адресов источника и назначения

Исходя из двух основных базовых конфигураций объединения интерфейсов и алгоритмов распределения трафика, взаимосвязь между ними можно привести в следующей таблице

|

Address Hashing |

Hyper-V Port |

|

|

Конфигурация, не зависимая от сетевого оборудования |

|

|

|

Зависимая от сетевого оборудования (статика или LACP) |

|

|

Нельзя не отметить появление позможности включения NIC Teaming и в гостевых виртуальных машинах, позволяющих аггрегировать синтетические адаптеры, подключенны�� к разным виртуальным коммутаторам.

Несмотря на то, что функция изначально разрабатывалась для использования с

Single Root I/O Virtualization для оптимизации производительности(об этой возможности, вероятно, еще будет информация в следующих заметках), может использоваться фактически на любых адаптерах

There are times when having a bit more performance is better. Actually, who are we kidding? Having more performance is always better. In the case of networking, this is especially true. You can never have enough bandwidth. There will be some, though, who argue that x number of megabits or gigabits per second is «more than enough.» We refer to this as the «640KB mentality.»

All of today’s motherboards ship with at least one gigabit Ethernet port. Some premium boards come with two. Of course, you can always add more by installing add-in NICs, and there are motherboards with more than two, but for the sake of this article we’re referring to consumer motherboards.

So, what exactly is link aggregation? In a nutshell, link aggregation (or trunking), is the fine, delicate art of combining two or more physical Ethernet links into a single logical link. So if two 1Gb/s ports were aggregated, you would get a total aggregated bandwidth of 2Gb/s. Note that we use the phrase «aggregated bandwidth.»

Think of link aggregation in terms of network link resiliency rather than total available throughput. In that sense, if one physical part of the logical link fails, traffic will failover to the remaining active links. Where you will see increased bandwidth is when you have multiple origin-destination IOs. For example, if you’re transferring a file from one PC to another over a 2Gb aggregated link, you’ll find that the total maximum transfer rate will top out at 1Gb/s. Start two file transfers, however, and you’ll see the benefits of aggregated bandwidth. In simple terms, link aggregation increases the number of lanes on a highway but it doesn’t increase the speed limit.

What this equates to is if you want true higher throughput, moving to a fatter pipe—like 10GbE—is the only way to go.

For the majority of home networks, setting up link aggregation serves little to no advantages. However, if you’re employing a NAS that has multiple Ethernet ports, it may support link aggregation and you’ll have some benefits there. So, how do you do it in a network?

First, you’re going to need a switch/router that supports link aggregation (LACP, 802.1ax/ad, etc.). Unfortunately, most consumer-level switches and routers do not support link aggregation, so you’ll have to link into business-level products, which will carry a premium.

Second, your PC needs to have two Ethernet ports, and whatever device you want to connect to needs to have at least the same. Assuming you have the hardware requirements covered, you’ll need an operating system that supports it. Windows 7, 8.1, and 10 for consumers don’t have link aggregation features baked into them. Microsoft requires that you use Windows Server instead, or you’ll have to use vendor-supplied drivers that have link aggregation features (such as Intel PROSet tools). Linux and OS X have built-in link aggregation features.

After you’ve satisfied all the prerequisites, here’s how to do it.

We used the following setup:

Swipe to scroll horizontally

Configuring the network

First, our NIC is a 10GbE Ethernet adapter from Small Tree that’s fully compatible with Windows, OS X, and Linux. You can get a 10GbE adapter with SFP+ connections, but for the sake of network compatibility, Small Tree sent a 10GBASE-T (RJ45) version.

If you’re going for the ultimate in performance though, we recommend going with SFP+ connections, as 10GbE pushes the limits of CAT6 and RJ45 connectors. Small Tree also has SFP+ adapters available if you want that kind of setup. Keep in mind that SFP+ switches are even more expensive than RJ45 switches.

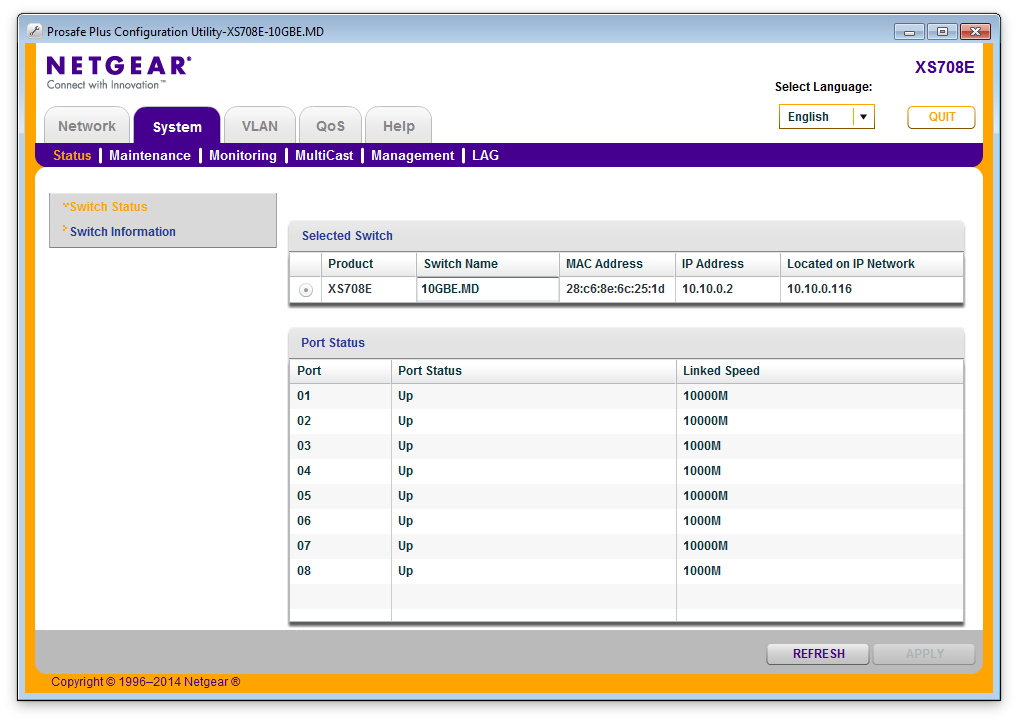

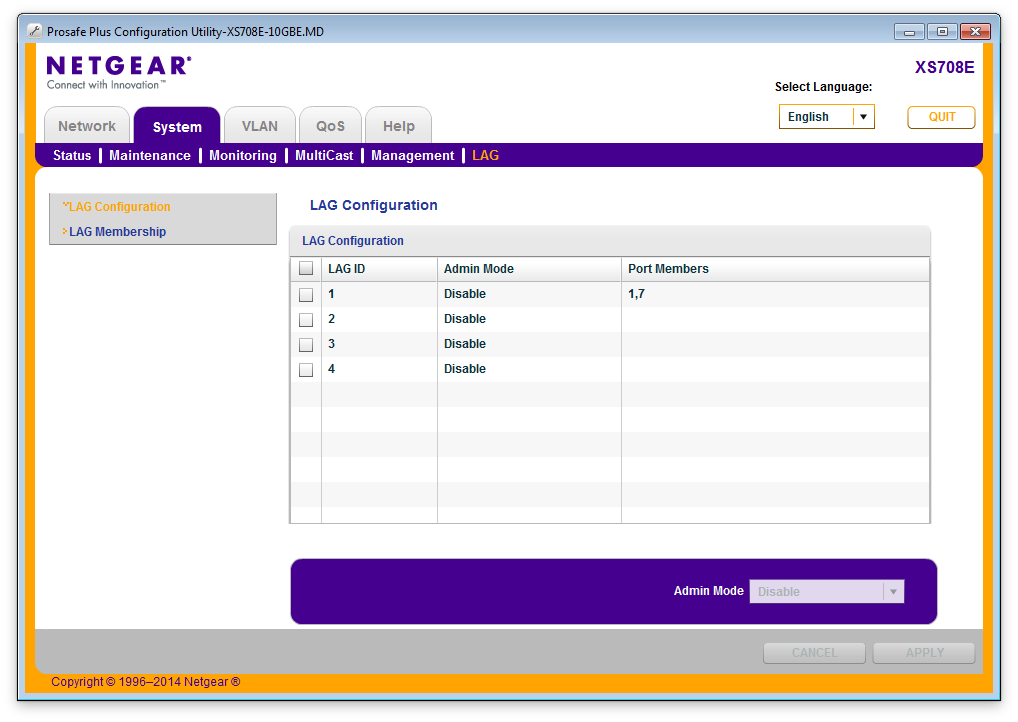

Next up: setting up the switch. You’ll need a switch that supports link aggregation, whereby there’s management capabilities that will allow you to bond individual ports. The Netgear ProSAFE XS708E comes with a utility that allows you to bond specific ports.

Depending on your switch, you’ll have something similar for teaming up ports like what you see in the image above. The above switch isn’t a managed switch, so the tool to set this up comes separately as a standalone application. Your switch may have a web interface.

Windows Server 2012 R2

Unfortunately, NIC teaming isn’t natively available in consumer versions of Windows, so we’ll have to use Windows Server and in this case, it’s Server 2012 R2. To do this in Windows Server, open the Server Manager. From there, click «Local Server» and you’ll see an option called «NIC Teaming.»

Click the option that says «Disabled» and you’ll be presented with the teaming configurator:

You’ll see both of your NIC interfaces listed under Adapters and Interfaces. Now, select both interfaces, right click, and select «New Team.» In the window that pops up, you’ll be given a field to name the new logical interface, as well as to select additional properties related to protocol. The protocol you choose depends on the type of switch you have. Give it a name and click OK.

For maximum compatibility, select «Switch Independent» under Teaming Mode. Once that’s done, you’ll end up back in the main NIC Teaming window where you’ll see your newly named logical interface comprising your two physical interfaces. Easy!

If all goes correctly, both your physical connections will indicate an active state, and you can see the transmission details below, although there’s no stat for packets lost.

OS X

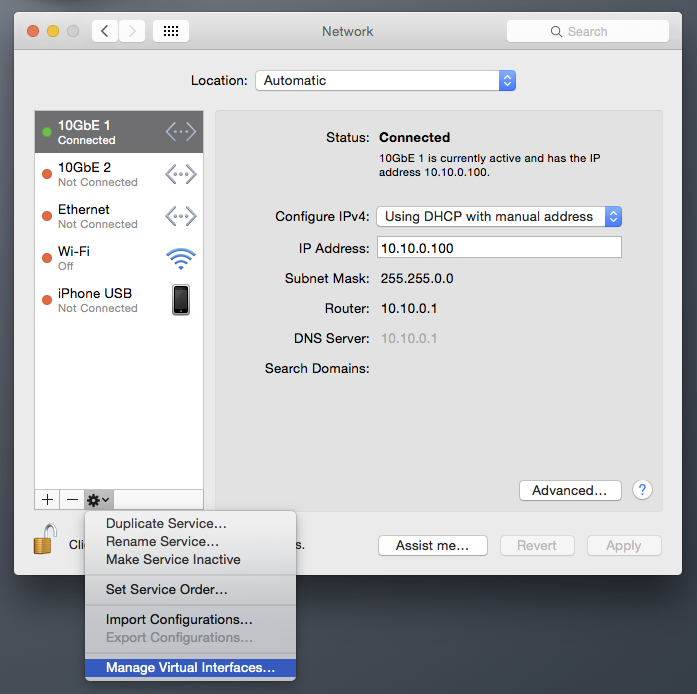

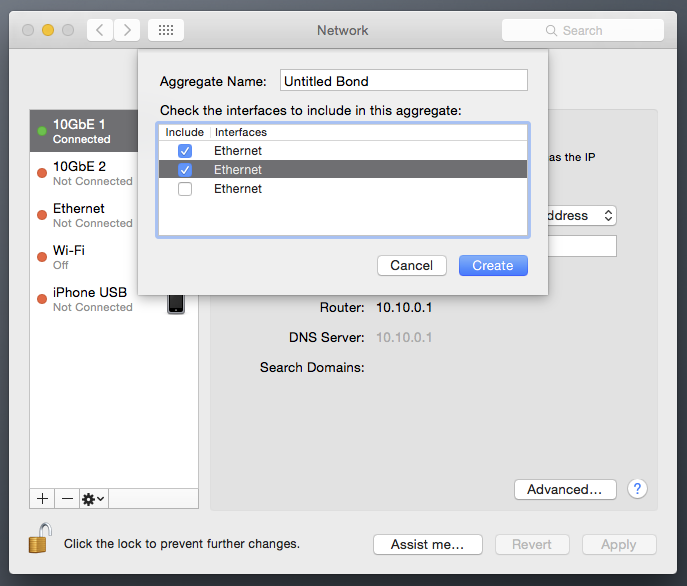

In OS X, setting up an aggregated link is a bit more straightforward, and doesn’t require special tools or third-party drivers—the feature is baked into the default Network preferences. To set it up, open System Preferences and go into the Network options.

You may have to click the padlock icon to make the options available. Click the small gear icon and select «Manage Virtual Interfaces…»

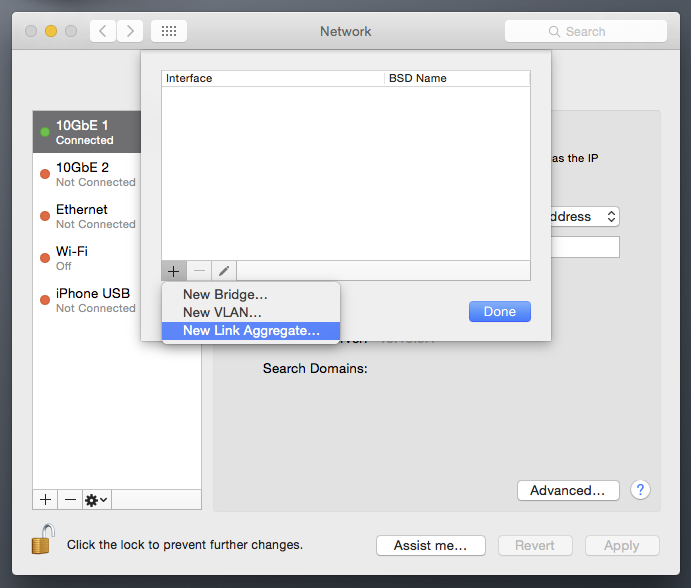

A drop-down menu will appear. Click the + button and select New Link Aggregate. You’ll be presented with a list of your physical interfaces, where you can select the ones you want to bond. Tick the boxes for the interfaces you want to combine, and select Create. Don’t forget to give it a name.

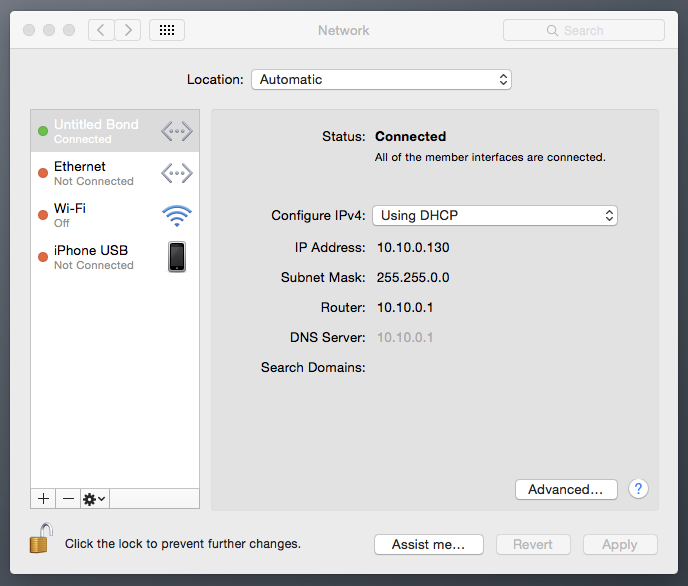

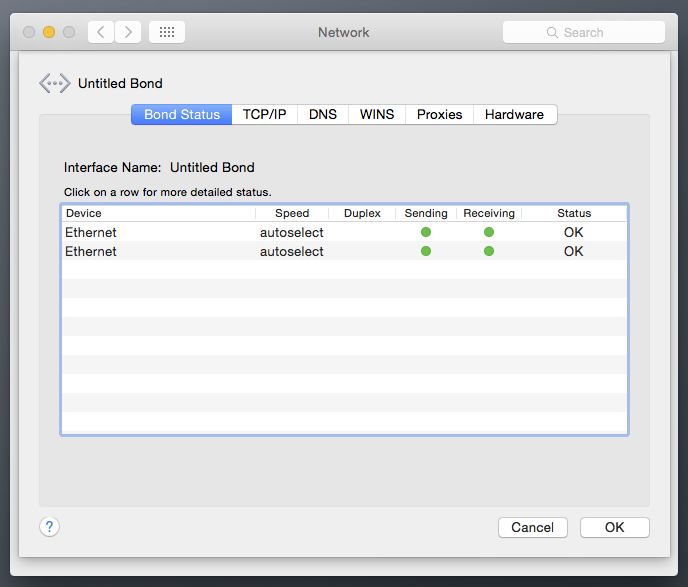

If all goes well, the two or more physical interfaces you bonded will disappear from the Network interfaces list, and instead be replaced with the logical bond you just created. It’s especially good if the light turns green.

To see how your connection is doing, select the logical interface and click Advanced. You’ll be able to see its status as well as configure other options such as IP address, DNS, etc.

To remove the aggregated bond, simply select it in the main Network interfaces window and click the minus (-) button. You’ll then need to re-add the individual physical interfaces.

Linux

One could say that the Linux environment is the most straightforward of all OSes in which to create a logical bond. Open a terminal window (and of course, the same commands apply if you’re not using a GUI), and type in the following:

Here’s a breakdown of what that command means:

modprobe bonding: this loads the bonding driver.

bond0: the name we gave the logical interface.

The third line tells the system to turn on (up) the logical interface.

ifenslave: this tells the bonding interface to aggregate interfaces eth1 and eth2.

If you want to configure how the bonding actually operates, you’ll want to modify the /etc/modprobe.conf file to include the bond you want to create and define its properties. Open the .conf file and add the following lines:

max_bonds: defines the number of bond interfaces to create.

mode: defines bonding policies such as round-robin, etc.

miimon: defines the frequency in milliseconds that link monitoring will occur for high availability failover.

To see how your bond is operating, issue the following command:

And you should get the following output:

Sign up to get the best content of the week, and great gaming deals, as picked by the editors.

Tuan is the Editor-in-Chief of Maximum PC, and loves all things tech. He’s been building PCs and ruffling feathers in the industry for 20 years, and isn’t afraid to call out bad products and services. In fact, it’s very common to hear the words «this is shit» escape his lips. If you want to know if something is «Kick-Ass» or not, email or tweet him.

There are times when having a bit more performance is better. Actually, who are we kidding? Having more performance is always better. In the case of networking, this is especially true. You can never have enough bandwidth. There will be some, though, who argue that x number of megabits or gigabits per second is «more than enough.» We refer to this as the «640KB mentality.»

All of today’s motherboards ship with at least one gigabit Ethernet port. Some premium boards come with two. Of course, you can always add more by installing add-in NICs, and there are motherboards with more than two, but for the sake of this article we’re referring to consumer motherboards.

So, what exactly is link aggregation? In a nutshell, link aggregation (or trunking), is the fine, delicate art of combining two or more physical Ethernet links into a single logical link. So if two 1Gb/s ports were aggregated, you would get a total aggregated bandwidth of 2Gb/s. Note that we use the phrase «aggregated bandwidth.»

Think of link aggregation in terms of network link resiliency rather than total available throughput. In that sense, if one physical part of the logical link fails, traffic will failover to the remaining active links. Where you will see increased bandwidth is when you have multiple origin-destination IOs. For example, if you’re transferring a file from one PC to another over a 2Gb aggregated link, you’ll find that the total maximum transfer rate will top out at 1Gb/s. Start two file transfers, however, and you’ll see the benefits of aggregated bandwidth. In simple terms, link aggregation increases the number of lanes on a highway but it doesn’t increase the speed limit.

What this equates to is if you want true higher throughput, moving to a fatter pipe—like 10GbE—is the only way to go.

For the majority of home networks, setting up link aggregation serves little to no advantages. However, if you’re employing a NAS that has multiple Ethernet ports, it may support link aggregation and you’ll have some benefits there. So, how do you do it in a network?

First, you’re going to need a switch/router that supports link aggregation (LACP, 802.1ax/ad, etc.). Unfortunately, most consumer-level switches and routers do not support link aggregation, so you’ll have to link into business-level products, which will carry a premium.

Second, your PC needs to have two Ethernet ports, and whatever device you want to connect to needs to have at least the same. Assuming you have the hardware requirements covered, you’ll need an operating system that supports it. Windows 7, 8.1, and 10 for consumers don’t have link aggregation features baked into them. Microsoft requires that you use Windows Server instead, or you’ll have to use vendor-supplied drivers that have link aggregation features (such as Intel PROSet tools). Linux and OS X have built-in link aggregation features.

After you’ve satisfied all the prerequisites, here’s how to do it.

We used the following setup:

Swipe to scroll horizontally

Configuring the network

First, our NIC is a 10GbE Ethernet adapter from Small Tree that’s fully compatible with Windows, OS X, and Linux. You can get a 10GbE adapter with SFP+ connections, but for the sake of network compatibility, Small Tree sent a 10GBASE-T (RJ45) version.

If you’re going for the ultimate in performance though, we recommend going with SFP+ connections, as 10GbE pushes the limits of CAT6 and RJ45 connectors. Small Tree also has SFP+ adapters available if you want that kind of setup. Keep in mind that SFP+ switches are even more expensive than RJ45 switches.

Next up: setting up the switch. You’ll need a switch that supports link aggregation, whereby there’s management capabilities that will allow you to bond individual ports. The Netgear ProSAFE XS708E comes with a utility that allows you to bond specific ports.

Depending on your switch, you’ll have something similar for teaming up ports like what you see in the image above. The above switch isn’t a managed switch, so the tool to set this up comes separately as a standalone application. Your switch may have a web interface.

Windows Server 2012 R2

Unfortunately, NIC teaming isn’t natively available in consumer versions of Windows, so we’ll have to use Windows Server and in this case, it’s Server 2012 R2. To do this in Windows Server, open the Server Manager. From there, click «Local Server» and you’ll see an option called «NIC Teaming.»

Click the option that says «Disabled» and you’ll be presented with the teaming configurator:

You’ll see both of your NIC interfaces listed under Adapters and Interfaces. Now, select both interfaces, right click, and select «New Team.» In the window that pops up, you’ll be given a field to name the new logical interface, as well as to select additional properties related to protocol. The protocol you choose depends on the type of switch you have. Give it a name and click OK.

For maximum compatibility, select «Switch Independent» under Teaming Mode. Once that’s done, you’ll end up back in the main NIC Teaming window where you’ll see your newly named logical interface comprising your two physical interfaces. Easy!

If all goes correctly, both your physical connections will indicate an active state, and you can see the transmission details below, although there’s no stat for packets lost.

OS X

In OS X, setting up an aggregated link is a bit more straightforward, and doesn’t require special tools or third-party drivers—the feature is baked into the default Network preferences. To set it up, open System Preferences and go into the Network options.

You may have to click the padlock icon to make the options available. Click the small gear icon and select «Manage Virtual Interfaces…»

A drop-down menu will appear. Click the + button and select New Link Aggregate. You’ll be presented with a list of your physical interfaces, where you can select the ones you want to bond. Tick the boxes for the interfaces you want to combine, and select Create. Don’t forget to give it a name.

If all goes well, the two or more physical interfaces you bonded will disappear from the Network interfaces list, and instead be replaced with the logical bond you just created. It’s especially good if the light turns green.

To see how your connection is doing, select the logical interface and click Advanced. You’ll be able to see its status as well as configure other options such as IP address, DNS, etc.

To remove the aggregated bond, simply select it in the main Network interfaces window and click the minus (-) button. You’ll then need to re-add the individual physical interfaces.

Linux

One could say that the Linux environment is the most straightforward of all OSes in which to create a logical bond. Open a terminal window (and of course, the same commands apply if you’re not using a GUI), and type in the following:

Here’s a breakdown of what that command means:

modprobe bonding: this loads the bonding driver.

bond0: the name we gave the logical interface.

The third line tells the system to turn on (up) the logical interface.

ifenslave: this tells the bonding interface to aggregate interfaces eth1 and eth2.

If you want to configure how the bonding actually operates, you’ll want to modify the /etc/modprobe.conf file to include the bond you want to create and define its properties. Open the .conf file and add the following lines:

max_bonds: defines the number of bond interfaces to create.

mode: defines bonding policies such as round-robin, etc.

miimon: defines the frequency in milliseconds that link monitoring will occur for high availability failover.

To see how your bond is operating, issue the following command:

And you should get the following output:

Sign up to get the best content of the week, and great gaming deals, as picked by the editors.

Tuan is the Editor-in-Chief of Maximum PC, and loves all things tech. He’s been building PCs and ruffling feathers in the industry for 20 years, and isn’t afraid to call out bad products and services. In fact, it’s very common to hear the words «this is shit» escape his lips. If you want to know if something is «Kick-Ass» or not, email or tweet him.