Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном курсе по администрированию MikroTik. Автор курса, сертифицированный тренер MikroTik Дмитрий Скоромнов, лично проверяет лабораторные работы и контролирует прогресс каждого своего студента. В три раза больше информации, чем в вендорской программе MTCNA, более 20 часов практики и доступ навсегда.

Все это способно серьезно охладить энтузиазм по поводу преимуществ виртуализации, но выход есть и заключается он в создании кластера высокой доступности. Мы уже упоминали о том, что термин «отказоустойчивый» не совсем корректен и поэтому сегодня все чаще используется другая характеристика, более точно отражающая положение дел — «высокодоступный».

Для создания полноценной отказоустойчивой системы требуется исключить любые точки отказа, что в большинстве случаев требует серьезных финансовых вложений. В тоже время большинство ситуаций допускает наличие некоторых точек отказа, если устранение последствий их отказа обойдется дешевле, чем вложение в инфраструктуру. Например, можно отказаться от недешевого отказоустойчивого хранилища в пользу двух недорогих серверов с достаточным числом корзин, один из которых настроен на холодный резерв, в случае отказа первого сервера просто переставляем диски и включаем второй.

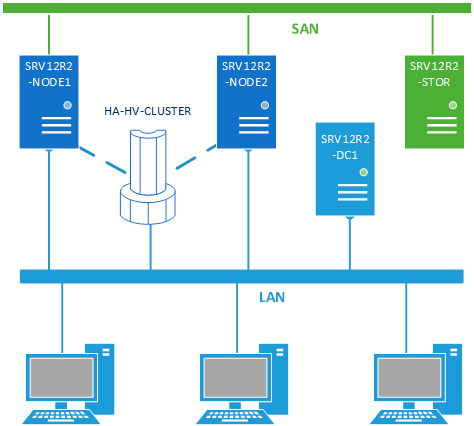

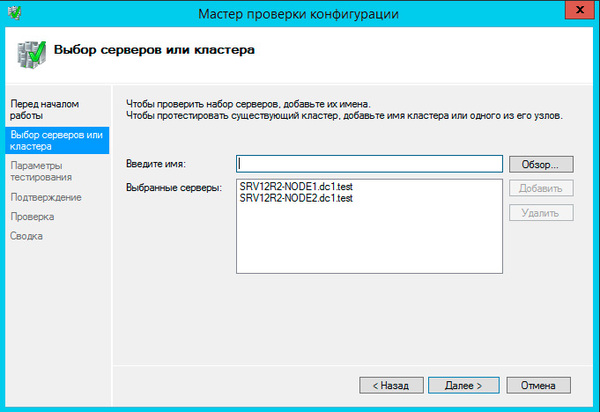

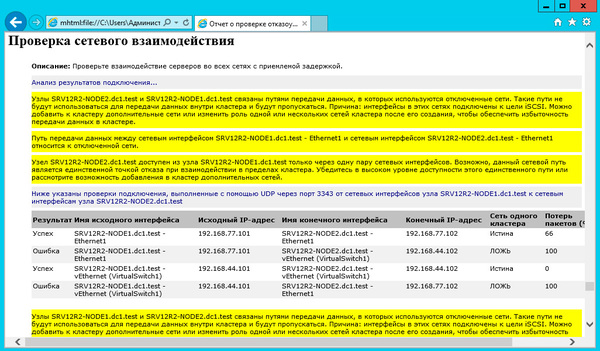

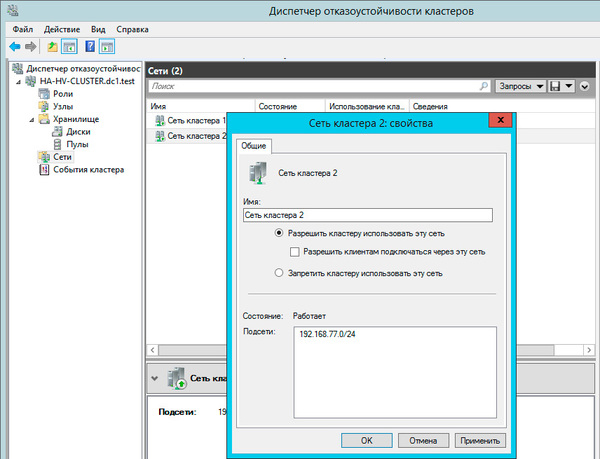

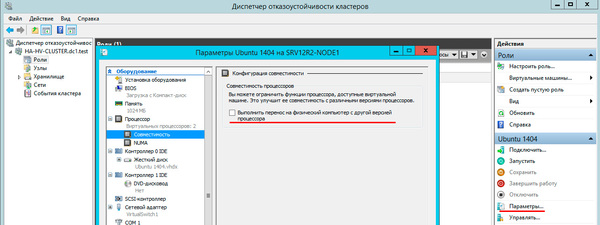

В данном материале мы будем рассматривать наиболее простую конфигурацию отказоустойчивого кластера, состоящего из двух узлов (нод) SRV12R2-NODE1 и SRV12R2-NODE2, каждый из которых работает под управлением Windows Server 2012 R2. Обязательным условием для этих серверов является применение процессоров одного производителя, только Intel или только AMD, в противном случае миграция виртуальных машин между узлами будет невозможна. Каждый узел должен быть подключен к двум сетям: сети предприятия LAN и сети хранения данных SAN.

Вторым обязательным условием для создания кластера является наличие развернутой Active Directory, в нашей схеме она представлена контроллером домена SRV12R2-DC1.

Хранилище выполнено по технологии iSCSI и может быть реализовано на любой подходящей платформе, в данном случае это еще один сервер на Windows Server 2012 R2 — SRV12R2-STOR. Сервер хранилища может быть подключен к сети предприятия и являться членом домена, но это необязательное условие. Пропускная способность сети хранения данных должна быть не ниже 1 Гбит/с.

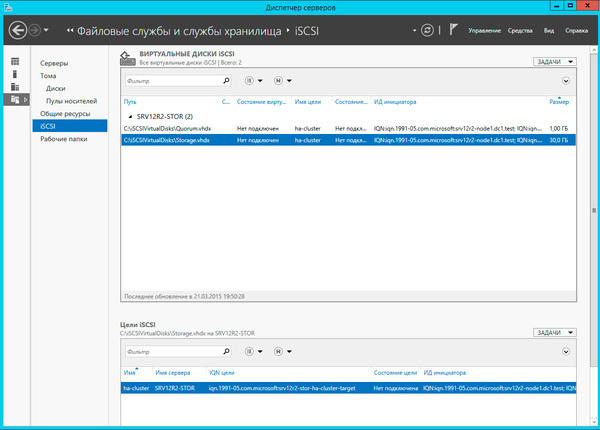

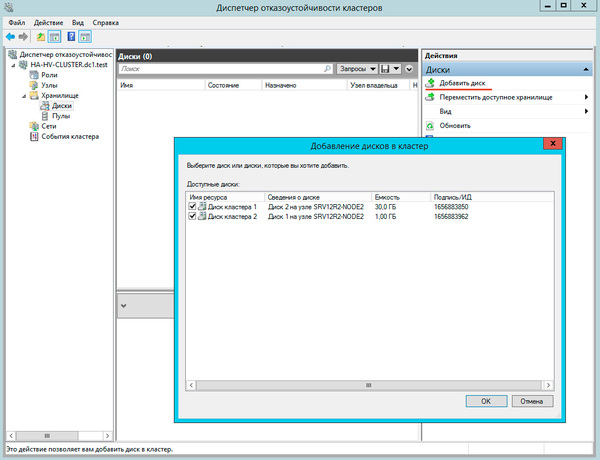

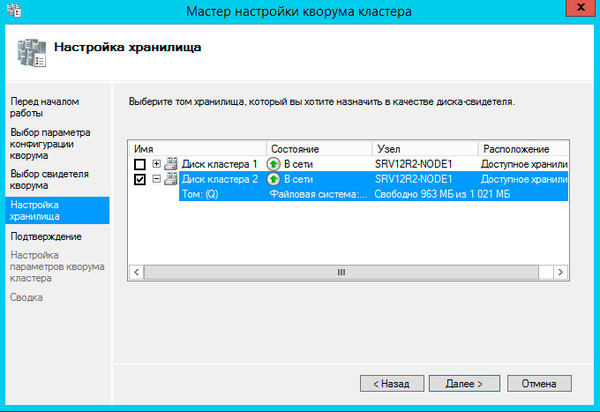

Затем перейдем к серверу хранилища, как настроить iSCSI-хранилище на базе Windows Server 2012 мы рассказывали в данной статье, но это непринципиально, вы можете использовать любой сервер цели iSCSI. Для нормальной работы кластера нам потребуется создать минимум два виртуальных диска: диск свидетеля кворума и диск для хранения виртуальных машин. Диск-свидетель — это служебный ресурс кластера, в рамках данной статьи мы не будем касаться его роли и механизма работы, для него достаточно выделить минимальный размер, в нашем случае 1ГБ.

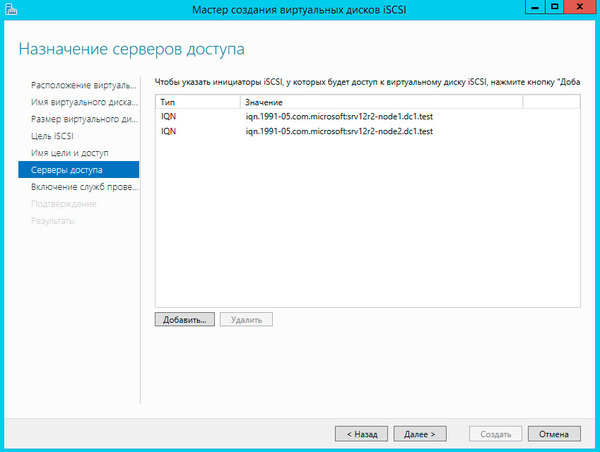

Создайте новую цель iSCSI и разрешите доступ к ней двум инициаторам, в качестве которых будут выступать узлы кластера.

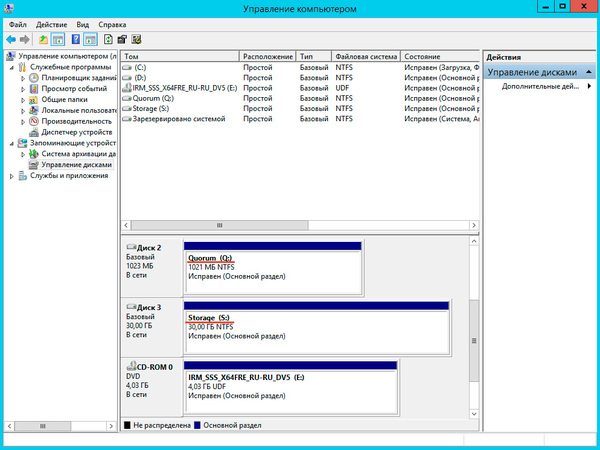

Подключенные диски инициализируем и форматируем.

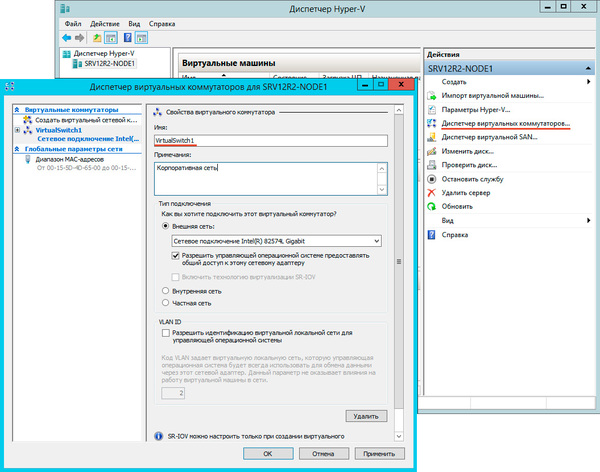

После чего откроем Диспетчер Hyper-V и перейдем к настройке виртуальных коммутаторов. Их название на обоих узлах должно полностью совпадать.

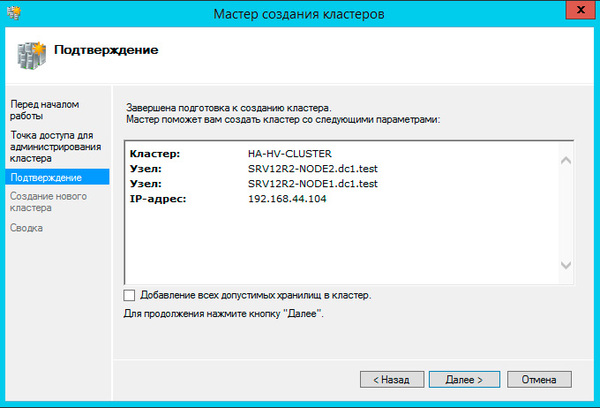

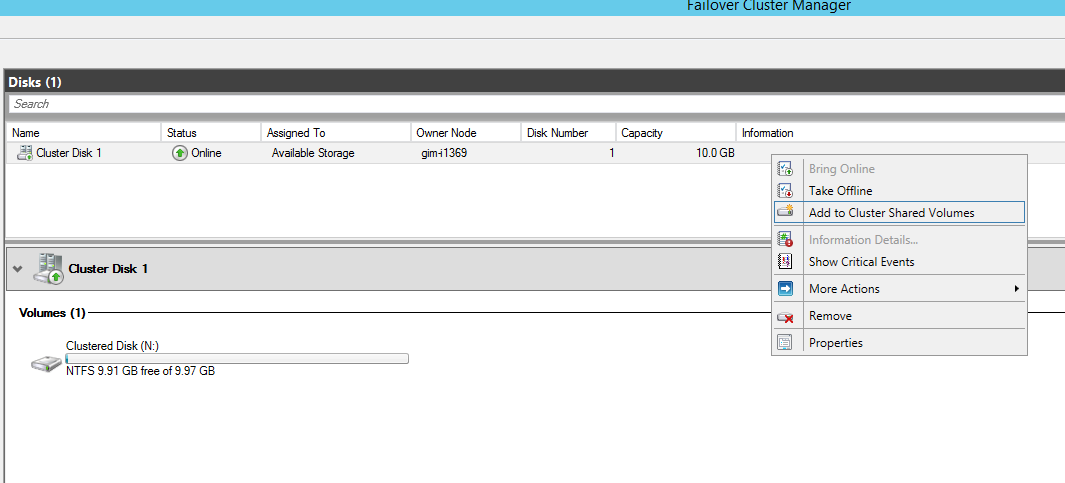

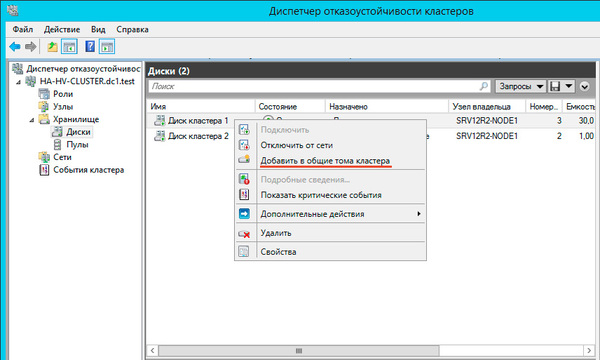

На следующем шаге советуем снять флажок Добавление всех допустимых хранилищ в кластер, так как мастер не всегда правильно назначает роли дискам и все равно придется проверять и, при необходимости исправлять, вручную.

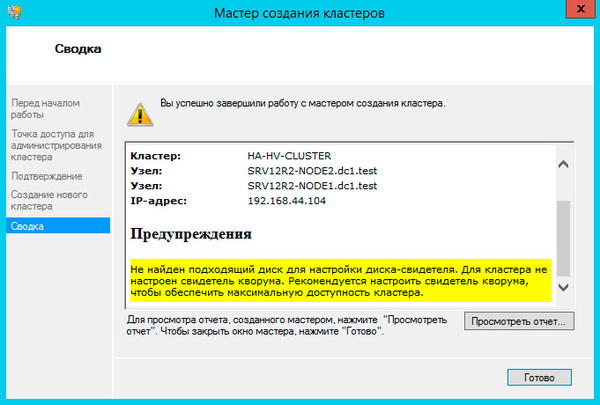

Больше вопросов не последует и мастер сообщит нам, что кластер создан, выдав при этом предупреждение об отсутствии диска-свидетеля.

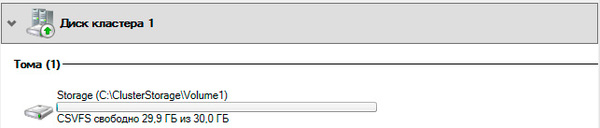

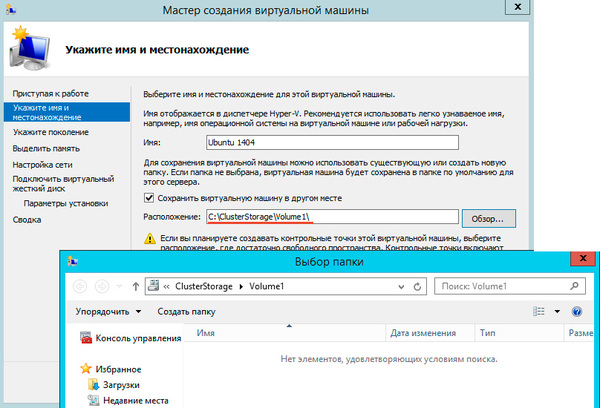

Общие хранилища становятся доступны на всех узлах кластера в расположении C:ClusterStorageVolumeN. Обратите внимание, что это не просто папки на системном диске, а точки монтирования общих томов кластера.

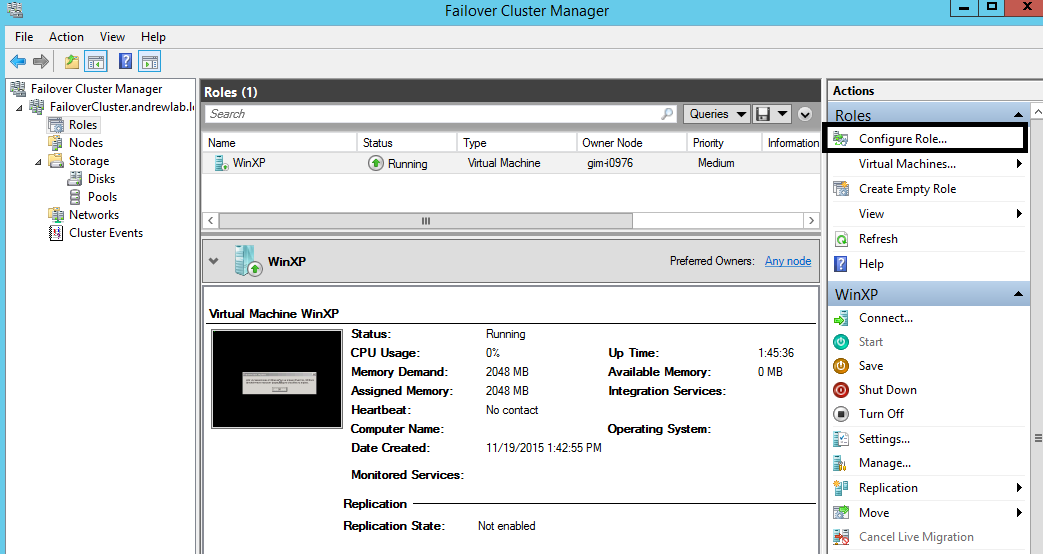

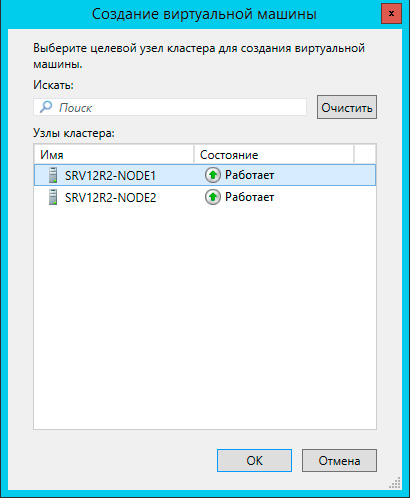

Чтобы создать виртуальную машину перейдите в раздел Роли в меню правой кнопки мыши выберите Виртуальные машины — Создать виртуальную машину, это же можно сделать и через панель Действия справа.

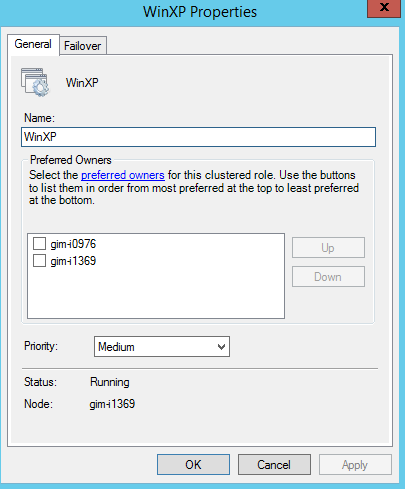

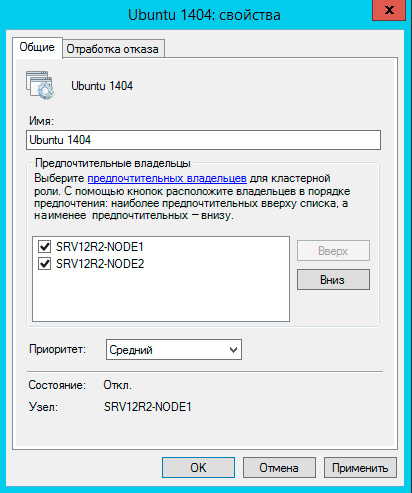

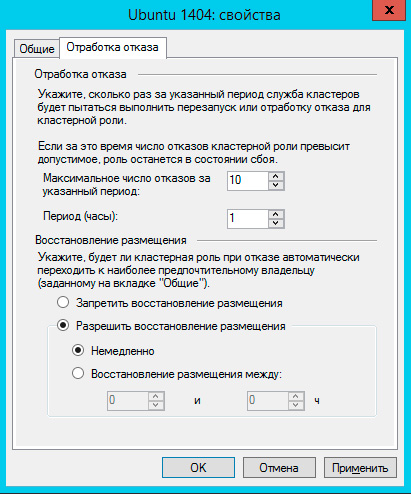

Также настройте Восстановление размещения, эта опция позволяет передавать виртуальные машины обратно наиболее предпочтительному владельцу при восстановлении его нормальной работы. Чтобы избежать чрезмерных нагрузок воспользуйтесь опцией задержки восстановления.

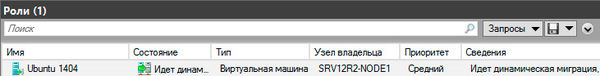

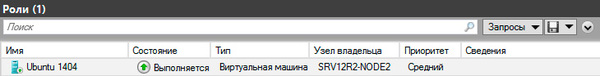

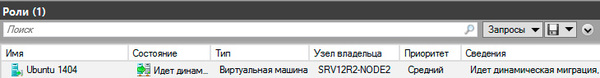

Теперь самое время проверить миграцию, для этого щелкните на машине правой кнопкой мыши и выберите Переместить — Динамическая миграция — Выбрать узел. Виртуалка должна переместиться на выбранную ноду не завершая работы.

Каким образом происходит миграция в рабочей обстановке? Допустим нам надо выключить или перезагрузить первый узел, на котором в данный момент выполняется виртуальная машина. Получив команду на завершение работы узел инициирует передачу виртуальных машин:

Как мы уже говорили, прижившийся в отечественной технической литературе термин «отказоустойчивый» неверен и более правильно его было бы переводить как «с обработкой отказа», либо использовать понятие «высокая доступность», которое отражает положение дел наиболее верно.

Кластер Hyper-V не обеспечивает отказоустойчивости виртуальным машинам, отказ узла приводит к отказу всех размещенных на нем машин, но он позволяет обеспечить вашим службам высокую доступность, автоматически восстанавливая их работу и обеспечивая минимально возможное время простоя. Также он позволяет значительно облегчить администрирование виртуальной инфраструктуры позволяя перемещать виртуальные машины между узлами без прерывания их работы.

Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном курсе по администрированию MikroTik. Автор курса, сертифицированный тренер MikroTik Дмитрий Скоромнов, лично проверяет лабораторные работы и контролирует прогресс каждого своего студента. В три раза больше информации, чем в вендорской программе MTCNA, более 20 часов практики и доступ навсегда.

Проверка предварительных требований.

Перед тем как начать, проверьте указанные ниже предварительные требования.

- Убедитесь в том, что все серверы, которые нужно добавить в качестве узлов кластера, работают под управлением одной и той же версии Windows Server.

Примечание

Средство отказоустойчивости кластеров можно использовать во всех выпусках Windows Server 2012 R2 и Windows Server 2012. Это касается и установок основных серверных компонентов.

- Изучите требования к оборудованию, чтобы убедиться в том, что ваша конфигурация поддерживается. Дополнительные сведения см. в разделе Требования к оборудованию для отказоустойчивой кластеризации и варианты хранилища.

- Если в процессе создания кластера необходимо добавить кластерное хранилище, убедитесь в том, что оно доступно всем серверам. (Кластерное хранилище можно добавить и после создания кластера.)

- Убедитесь в том, что все серверы, которые нужно добавить в качестве узлов кластера, присоединены к одному и тому же домену Active Directory.

- (Необязательно.) Создайте подразделение и переместите в него учетные записи компьютеров для серверов, которые нужно добавить в качестве узлов кластера. Мы рекомендуем размещать отказоустойчивые кластеры в собственном подразделении в AD DS. Это позволит лучше контролировать параметры групповой политики и шаблона безопасности, применяемые к узлам кластера. Изоляция кластеров в собственном подразделении также помогает предотвратить случайное удаление объектов-компьютеров кластера.

Кроме того, проверьте выполнение указанных ниже требований к учетным записям.

- Убедитесь в том, что учетная запись, которую вы хотите использовать для создания кластера, принадлежит пользователю домена с правами администратора на всех серверах, которые нужно добавить в качестве узлов кластера.

- Убедитесь в том, что выполняется одно из указанных ниже условий.

- У пользователя, создающего кластер, есть разрешение на создание объектов-компьютеров для подразделения или контейнера, в котором размещаются серверы, которые войдут в кластер.

- Если у пользователя нет разрешения на создание объектов-компьютеров, попросите администратора домена предварительно подготовить объект-компьютер кластера. Дополнительные сведения см. в разделе Подготовка кластерных объектов-компьютеров в доменных службах Active Directory.

Примечание

Это требование не действует, если вы хотите создать отсоединенный от Active Directory кластер в Windows Server 2012 R2. Дополнительные сведения см. в разделе Развертывание отсоединенного от Active Directory кластера.

Требования к оборудованию для отказоустойчивой кластеризации и варианты хранилища

Применимо к:Windows Server 2012 R2, Windows Server 2012

Для создания отказоустойчивого кластера требуется следующее оборудование. Чтобы оборудование поддерживалось программным обеспечением Майкрософт, оно все должно быть сертифицированным для используемой версии Windows Server, а решение отказоустойчивого кластера должно пройти все тесты в мастере проверки конфигурации. Дополнительные сведения о проверке отказоустойчивого кластера см. в разделе Проверка оборудования для отказоустойчивого кластера.

· Серверы. Рекомендуется использовать набор совпадающих компьютеров, содержащих одинаковые или похожие компоненты.

· Сетевые адаптеры и кабели (для передачи данных по сети). Если используется iSCSI, то каждый сетевой адаптер должен быть выделенным для подключения к сети или для iSCSI, но не для того и другого одновременно.

Избегайте единственных точек отказа в сетевой инфраструктуре, соединяющей узлы кластера. Например, можно соединить узлы кластера несколькими независимыми сетями. Можно также соединить узлы кластера в одну сеть, основанную на сгруппированных сетевых адаптерах, дублированных коммутаторах и маршрутизаторах и аналогичном оборудовании, исключающем появление единственных точек отказа.

Примечание

Если узлы кластера соединены одной сетью, сеть пройдет тест на избыточность мастера проверки конфигурации. Однако отчет мастера будет включать предупреждение, что в сети не должно быть единственных точек отказа.

· Контроллеры устройств или соответствующие адаптеры для хранилища.

o Serial Attached SCSI или Fibre Channel. Если используется Serial Attached SCSI или Fibre Channel во всех кластерных серверах, то все элементы стека хранилища должны быть идентичными. Необходимо, чтобы ПО многоканального ввода-вывода (MPIO) было идентичным. Также идентичным должно быть ПО модуля для конкретного устройства (DSM). Рекомендуется, чтобы контроллеры запоминающих устройств, то есть адаптер шины (HBA), драйверы HBA и встроенное ПО HBA, присоединенные к хранилищу кластера, были идентичными. При использовании различных HBA следует уточнить у поставщика хранилища, обеспечиваются ли при этом поддерживаемые или рекомендуемые конфигурации.

o iSCSI. При использовании iSCSI у каждого кластерного сервера должно быть не менее одного сетевого адаптера или адаптера шины, предназначенного исключительно для хранилища кластера. Сеть, используемая для iSCSI, не может использоваться для сетевого взаимодействия. На всех кластеризованных серверах сетевые адаптеры для подключения к целевому хранилищу iSCSI должны быть одинаковыми. Рекомендуется использовать адаптеры Gigabit Ethernet или с более высокой пропускной способностью.

· Хранилище. Необходимо использовать хранилище общего доступа, совместимое с Windows Server 2012 R2 или Windows Server 2012. Можно использовать подключенное хранилище общего доступа или файловые ресурсы общего доступа SMB 3.0 в качестве хранилища общего доступа для серверов в отказоустойчивом кластере, на которых выполняется Hyper-V. Дополнительные сведения см. в разделе Развертывание Hyper-V через SMB.

В большинстве случаев в подключенном хранилище должно быть несколько отдельных дисков (логических номеров устройств, или LUN), настроенных на аппаратном уровне. Для некоторых кластеров один из дисков работает как диск-свидетель (см. в конце этого подраздела). На других дисках содержатся файлы, необходимые для кластерных ролей (ранее называвшихся кластеризованными службами или приложениями). К хранилищу предъявляются следующие требования.

o Для использования собственной поддержки дисков, включенной в компонент отказоустойчивого кластера, применяйте базовые, а не динамические диски.

o Мы рекомендуем форматировать разделы с использованием файловой системой NTFS. Если вы используете общие тома кластера (CSV), их разделы должны иметь формат NTFS.

Примечание

Если в конфигурации кворума используется диск-свидетель, его можно отформатировать в NTFS или в Resilient File System (ReFS).

o Для разделения диска на разделы можно использовать основную загрузочную запись (MBR) или таблицу разделов GPT.

Диск-свидетель — это диск в системе хранения данных кластера, который предназначен для хранения копии базы данных конфигурации кластера. Отказоустойчивый кластер имеет диск-свидетель, только если он настроен в конфигурации кворума. Дополнительные сведения см. в разделе Настройка и управление кворумом на отказоустойчивом кластере Windows Server 2012.

Требования к оборудованию для Hyper-V

Если вы создаете отказоустойчивый кластер с кластерными виртуальными машинами, то серверы кластера должны отвечать требованиям к оборудованию для роли Hyper-V. Для Hyper-V требуется 64-разрядный процессор, включающий следующие возможности.

· Виртуализация с использованием оборудования. Это возможно на процессорах, допускающих виртуализацию, а именно на процессорах с технологией Intel Virtualization Technology (Intel VT) или AMD Virtualization (AMD-V).

· Должна быть доступна и включена технология аппаратного предотвращения выполнения данных (DEP). То есть необходимо включить атрибут Intel XD (атрибут отключения выполнения) или AMD NX (атрибут запрета выполнения).

Дополнительные сведения о роли Hyper-V см. в статье Обзор Hyper-V.

Развертывание сетей хранения данных с отказоустойчивыми кластерами

При развертывании сети хранения данных (SAN) с отказоустойчивым кластером руководствуйтесь следующими рекомендациями.

· Подтвердите совместимость хранилища. Обратитесь к производителям и поставщикам, чтобы подтвердить, что хранилище, включая драйверы, встроенное ПО и ПО, используемое для хранилища, совместимо с отказоустойчивыми кластерами в используемой версии Windows Server.

· Изолируйте запоминающие устройства по одному кластеру на устройство. Серверы из различных кластеров не должны иметь доступа к одним и тем же запоминающим устройствам. В большинстве случаев LUN, используемый для одного набора серверов кластера, должен быть изолирован от всех остальных серверов с помощью маски или зонирования LUN.

· Рассмотрите использование ПО многоканального ввода-вывода или объединенных сетевых адаптеров. В архитектуре хранилищ с высокой доступностью можно развернуть отказоустойчивые кластеры с несколькими адаптерами шины, используя ПО многоканального ввода-вывода или объединенных сетевых адаптеров (что также называется отказоустойчивой балансировкой нагрузки — LBFO). Это обеспечивает максимальный уровень резервирования и доступности. Для Windows Server 2012 R2 или Windows Server 2012 многоканальное решение должно быть основано на MPIO (Microsoft Multipath I/O). Поставщики оборудования обычно предоставляют модуль MPIO для конкретного устройства (DSM), но в комплект поставки операционной системы Windows Server также входят один или несколько модулей DSM.

Подробнее о LBFO см. раздел Отказоустойчивая балансировка нагрузки в технической библиотеке Windows Server.

Важно

Некоторые адаптеры шины и программное обеспечение многоканального ввода-вывода сильно зависят от версий. При реализации многоканального решения для кластера следует проконсультироваться с поставщиком оборудования, чтобы выбрать правильные адаптеры, встроенное программное обеспечение и программное обеспечение для используемой версии Windows Server.

· Рассмотрите использование дисковых пространств. Если планируется развертывание кластерного хранилища Serial Attached SCSI (SAS), настроенного с помощью дисковых пространств, см. требования в разделе Развертывание кластерных дисковых пространств.

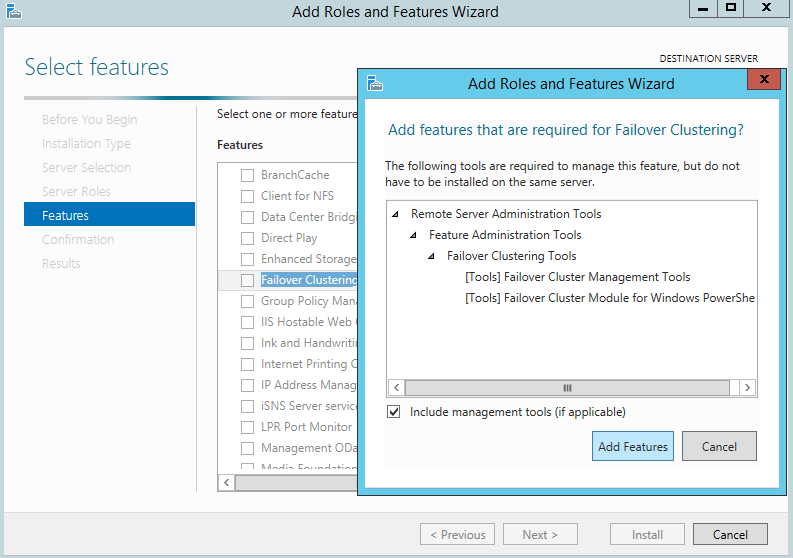

Установка средства отказоустойчивости кластеров

Средство отказоустойчивости кластеров необходимо установить на всех серверах, которые будут добавлены как узлы отказоустойчивого кластера.

Установка средства отказоустойчивости кластеров

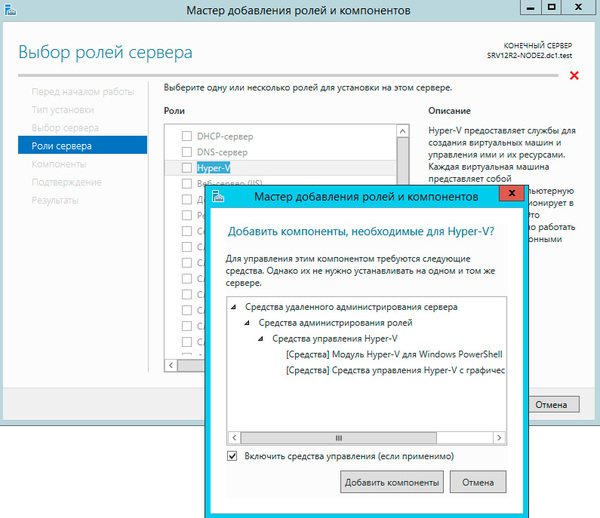

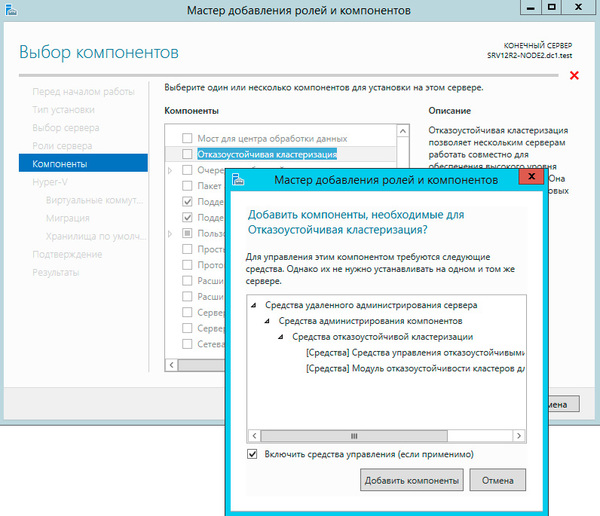

1. Запустите диспетчер сервера.

2. В меню Управление выберите команду Добавить роли и компоненты.

3. На странице Перед работой нажмите кнопку Далее.

4. На странице Выбор типа установки щелкните Установка ролей или компонентов, а затем нажмите кнопку Далее.

5. На странице Выбор целевого сервера щелкните сервер, на котором следует установить средство, и нажмите кнопку Далее.

6. На странице Выбор ролей сервера нажмите кнопку Далее.

7. На странице Выбор компонентов установите флажок Отказоустойчивая кластеризация.

8. Чтобы установить средства управления отказоустойчивыми кластерами, щелкните Добавить компоненты, а затем нажмите кнопку Далее.

9. На странице Подтверждение выбранных элементов для установки нажмите кнопку Установить.

Примечание

После установки средства отказоустойчивости кластеров не нужно перезапускать сервер.

10. По завершении установки нажмите кнопку Закрыть.

11. Повторите эту процедуру на каждом сервере, который необходимо добавить как узел отказоустойчивого кластера.

Примечание

После установки средства отказоустойчивости кластеров рекомендуется применить последние обновления из Центра обновления Windows. При развертывании отказоустойчивого кластера на основе Windows Server 2012 изучите статью службы поддержки Майкрософт Рекомендованные исправления и обновления для отказоустойчивых кластеров на основе Windows Server 2012 и установите все соответствующие обновления.

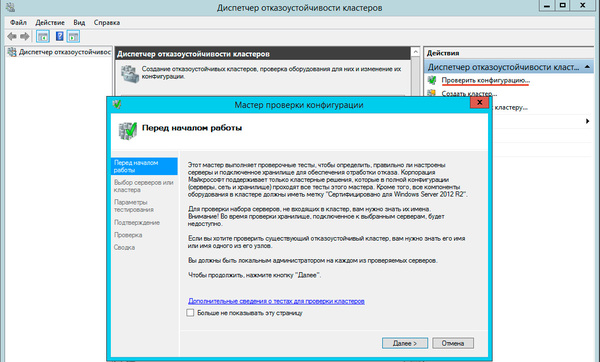

Проверка конфигурации

Перед созданием отказоустойчивого кластера настоятельно рекомендуется проверить конфигурацию, чтобы убедиться в том, что оборудование и его настройки совместимы с отказоустойчивой кластеризацией. Корпорация Майкрософт поддерживает кластерное решение, только если конфигурация прошла все проверочные тесты и все оборудование сертифицировано для версии Windows Server, под управлением которой работают узлы кластера.

Примечание

Для выполнения всех тестов необходимы по крайней мере два узла. Если имеется только один узел, выполнение многих важных тестов хранилища невозможно.

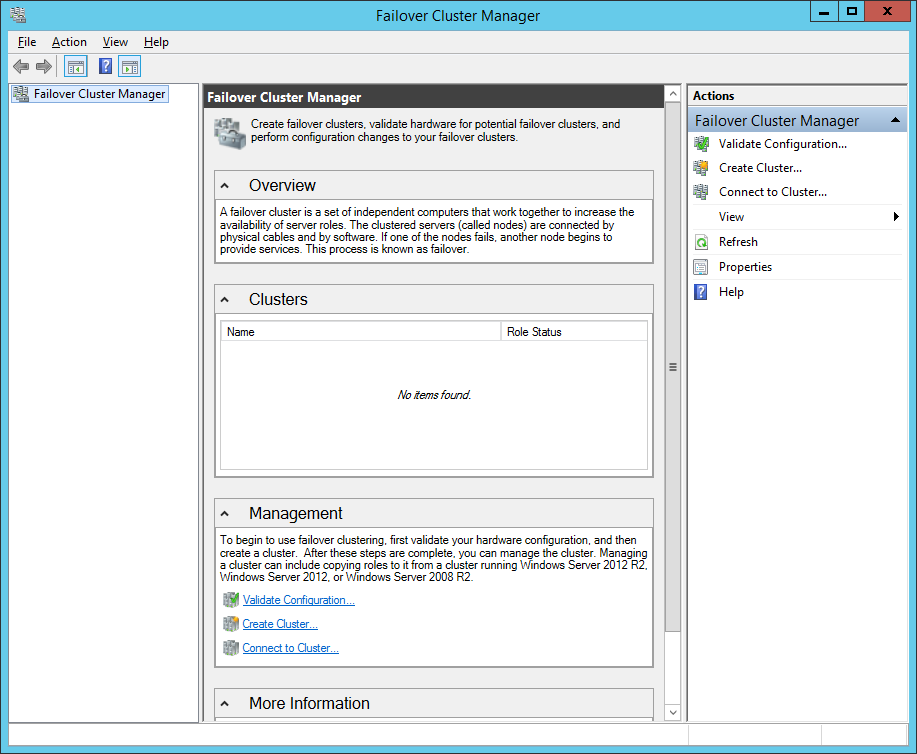

Выполнение проверочных тестов кластера

1. На компьютере, на котором установлены средства управления отказоустойчивыми кластерами из средств удаленного администрирования сервера, или на сервере, на котором установлено средство отказоустойчивости кластеров, запустите диспетчер отказоустойчивости кластеров. Чтобы выполнить это действие на сервере, откройте диспетчер сервера и в меню Средства выберите пункт Диспетчер отказоустойчивости кластеров.

2. Введите Bank в поле Имя

3. На странице Прежде чем приступить к работе нажмите кнопку Далее.

4. На странице Выбор серверов или кластера в поле Введите имя введите имя NetBIOS или полное доменное имя сервера, который планируется добавить как узел отказоустойчивого кластера, а затем нажмите кнопку Добавить. Повторите этот шаг для каждого сервера, который нужно добавить. Чтобы добавить несколько серверов одновременно, разделяйте их имена запятой или точкой с запятой. Например, введите имена в формате server1.contoso.com, server2.contoso.com. Завершив настройку, нажмите кнопку Далее.

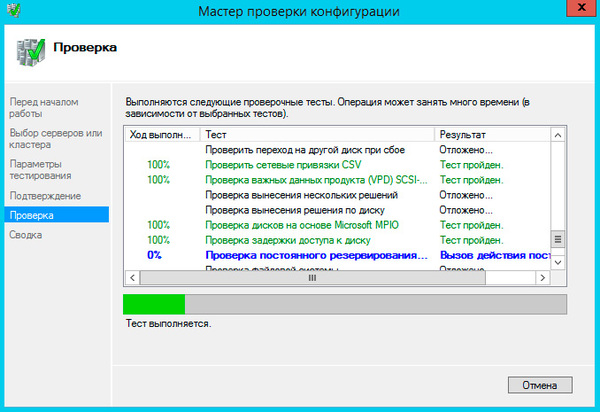

5. На странице Параметры тестирования щелкните Выполнить все тесты (рекомендуется), а затем нажмите кнопку Далее.

6. На странице Подтверждение нажмите кнопку Далее.

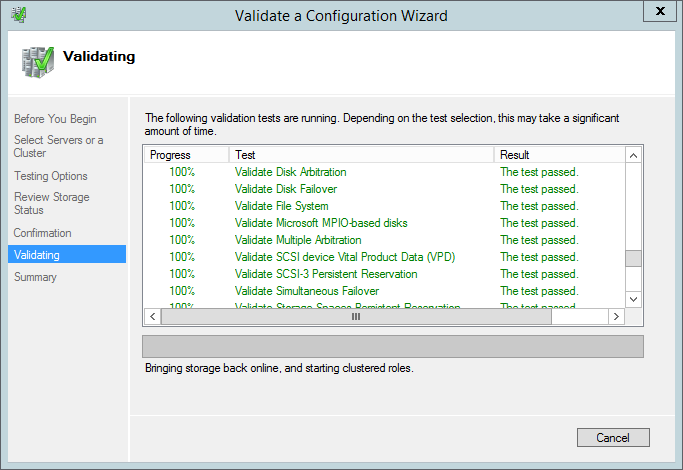

На странице “Проверка” показано состояние выполняющихся тестов.

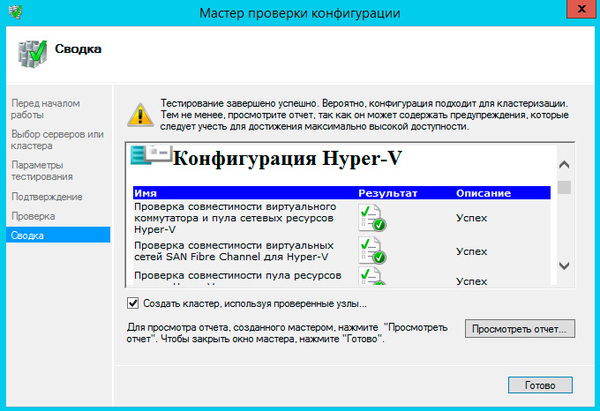

7. На странице Сводка выполните одно из указанных ниже действий.

o Если результаты указывают на то, что тесты были пройдены успешно и конфигурация подходит для кластеризации, то, чтобы создать кластер немедленно, установите флажок Создать кластер, используя проверенные узлы и нажмите кнопку Готово. Теперь перейдите к шагу 4 процедуры Создание отказоустойчивого кластера.

o Если в результатах есть предупреждения или сбои, нажмите кнопку Просмотр отчета, чтобы просмотреть подробные сведения и решить, какие неполадки необходимо исправить. Имейте в виду, что предупреждение в результатах определенного проверочного теста указывает на то, что данный аспект отказоустойчивого кластера поддерживается, но может не соответствовать рекомендациям.

Примечание

Если получено предупреждение для теста «Проверка постоянного резервирования дисковых пространств», дополнительную информацию см. в записи блога Предупреждение при проверке отказоустойчивого кластера Windows указывает на то, что диски не поддерживают постоянное резервирование дисковых пространств.

8. Дополнительные сведения о тестах проверки оборудования см. в разделе Проверка оборудования для отказоустойчивого кластера.

Создание отказоустойчивого кластера

Чтобы выполнить это действие, убедитесь в том, что учетная запись пользователя, с помощью которой вы вошли в систему, соответствует требованиям, указанным в подразделе Проверка предварительных требований этого раздела.

Создание отказоустойчивого кластера

1. Запустите диспетчер сервера.

2. В меню Инструменты выберите пункт Диспетчер отказоустойчивости кластеров.

3. Введите Bank в поле Имя

Откроется мастер создания кластеров.

4. На странице Прежде чем приступить к работе нажмите кнопку Далее.

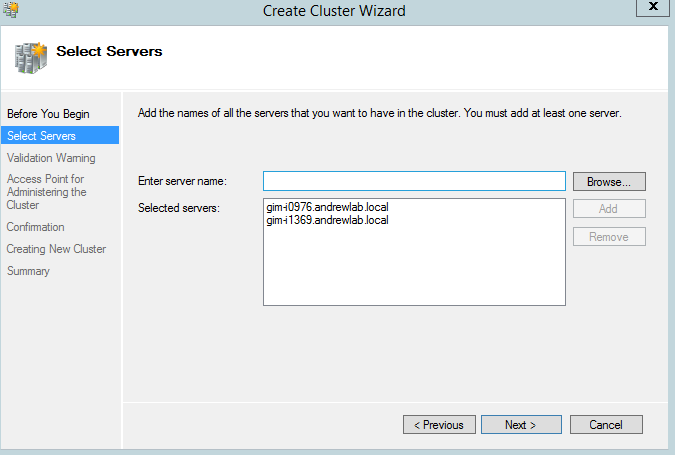

5. Если откроется страница Выбор серверов, в поле Введите имя введите имя NetBIOS или полное доменное имя сервера, который планируется добавить как узел отказоустойчивого кластера, а затем нажмите кнопку Добавить. Повторите этот шаг для каждого сервера, который нужно добавить. Чтобы добавить несколько серверов одновременно, разделяйте их имена запятой или точкой с запятой. Например, введите имена в формате server1.contoso.com; server2.contoso.com. Завершив настройку, нажмите кнопку Далее.

Примечание

Если вы решили создать кластер немедленно после выполнения проверки, описанной в процедуре Проверка конфигурации, страница Выбор серверов не появится. Проверенные узлы автоматически добавляются в мастер создания кластеров, так что вводить их еще раз не нужно.

6. Если ранее вы пропустили проверку, появится страница Предупреждение проверки. Настоятельно рекомендуется выполнить проверку кластера. Корпорация Майкрософт поддерживает только те кластеры, которые прошли все проверочные тесты. Чтобы выполнить проверочные тесты, нажмите кнопку Да, а затем кнопку Далее. Выполните мастер проверки конфигурации, как описано в процедуре Проверка конфигурации.

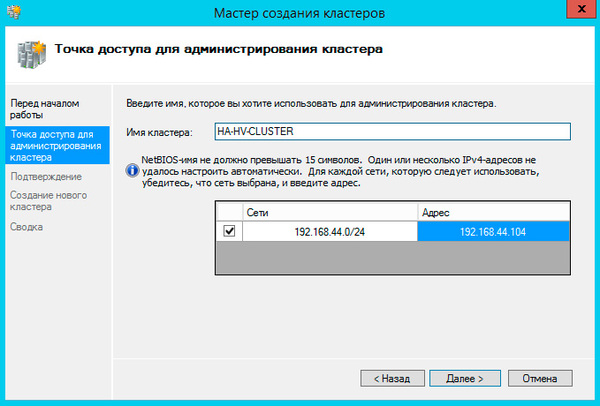

7. На странице Точка доступа для администрирования кластера выполните указанные ниже действия.

1. Введите Bank в поле Имя Перед этим изучите приведенную ниже информацию.

§ В процессе создания кластера это имя регистрируется в качестве объекта-компьютера кластера (также известного как объект имени кластера или CNO) в доменных службах Active Directory. Если для кластера указано имя NetBIOS, объект CNO создается в том же расположении, в котором находятся объекты-компьютеры узлов кластера. Это может быть контейнер “Компьютеры” (по умолчанию) или подразделение.

§ Чтобы указать другое расположение для CNO, можно ввести различающееся имя подразделения в поле Имя кластера. Например: CN=ClusterName, OU=Clusters, DC=Contoso, DC=com.

§ Если администратор домена предварительно подготовил CNO в подразделении, отличном от того, в котором размещаются узлы кластера, укажите различающееся имя, предоставленное администратором домена.

2. Если на сервере нет сетевого адаптера, настроенного на использование DHCP, для отказоустойчивого кластера необходимо настроить один или несколько статических IP-адресов. Установите флажок напротив каждой сети, которую необходимо использовать для управления кластером. Щелкните поле Адрес рядом с выбранной сетью, а затем введите IP-адрес, который нужно назначить кластеру. Этот IP-адрес (или адреса) будет связан с именем кластера в службе доменных имен (DNS).

3. Завершив настройку, нажмите кнопку Далее.

8. Просмотрите параметры на странице Подтверждение. По умолчанию установлен флажок Добавление всех допустимых хранилищ в кластер. Снимите его в указанных ниже случаях.

o Хранилище следует настроить позднее.

o Вы планируете создать кластерные дисковые пространства с помощью диспетчера отказоустойчивости кластеров или командлетов отказоустойчивой кластеризации Windows PowerShell, но еще не создали дисковые пространства в файловых службах и службах хранилища. Дополнительные сведения см. в разделе Развертывание кластерных дисковых пространств.

9. Чтобы создать отказоустойчивый кластер, нажмите кнопку Далее.

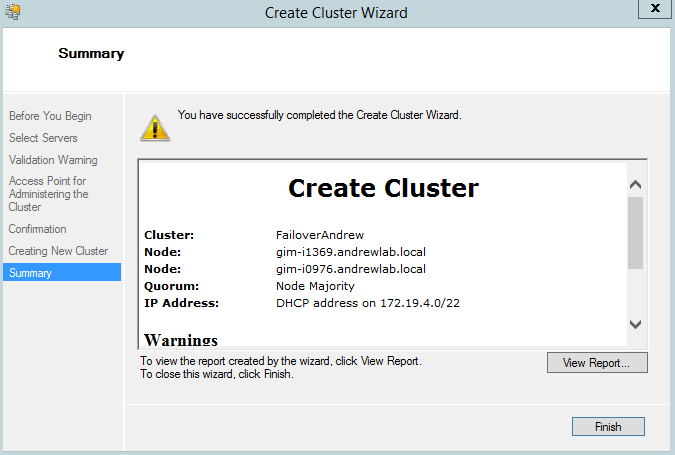

10. На странице Сводка убедитесь в том, что отказоустойчивый кластер успешно создан. Если есть предупреждения или ошибки, просмотрите сводные выходные данные или нажмите кнопку Просмотр отчета, чтобы просмотреть полный отчет. Нажмите кнопку Готово.

11. Чтобы убедиться в том, что кластер создан, проверьте, указано ли его имя в разделе Диспетчер отказоустойчивости кластеров в дереве навигации. Можно развернуть имя кластера, а затем щелкнуть элементы в разделах Узлы, Хранилище или Сети, чтобы просмотреть связанные ресурсы.

Имейте в виду, что на успешную репликацию имени кластера в службе DNS может потребоваться некоторое время. Если после успешной регистрации и репликации в службе DNS щелкнуть Все серверы в диспетчере сервера, имя кластера должно быть указано в списке серверов, а его состояние Управляемость будет иметь значение В сети.

После создания кластера можно выполнить такие действия, как проверка конфигурации кворума кластера и создание общих томов кластера — CSV (необязательно). Дополнительные сведения см. в разделах Настройка и управление кворумом на отказоустойчивом кластере Windows Server 2012 и Использование общих томов кластера в отказоустойчивом кластере.

Создание кластерных ролей

После создания отказоустойчивого кластера можно создать кластерные роли для размещения кластерных рабочих нагрузок.

Примечание

Для кластерных ролей, требующих точки доступа клиента, в доменных службах Active Directory создается виртуальный объект-компьютер (VCO). По умолчанию все объекты VCO для кластера создаются в том же контейнере или подразделении, что и объект CNO. Имейте в виду, что после создания кластера объект CNO можно переместить в любое подразделение.

Создание кластерной роли

1. Чтобы на каждом узле отказоустойчивого кластера установить роль или компонент, необходимый для кластерной роли, используйте диспетчер сервера или Windows PowerShell. Например, чтобы создать кластерный файловый сервер, установите роль файлового сервера на всех узлах кластера.

В таблице ниже приведены кластерные роли, которые можно настроить в мастере высокой доступности, и соответствующие роли или компоненты сервера, которые необходимо установить.

2. В диспетчере отказоустойчивости кластеров разверните имя кластера, щелкните правой кнопкой мыши элемент Роли, а затем выберите пункт Настроить роль.

3. Для создания кластерной роли выполните последовательность действий, предлагаемую мастером высокой доступности.

4. Чтобы проверить, создана ли кластерная роль, на панели Роли убедитесь в том, что роль имеет состояние Выполняется. На панели “Роли” также указан узел владельца. Чтобы проверить отработку отказа, щелкните правой кнопкой мыши роль, наведите указатель на пункт Переместить, а затем щелкните Выбрать узел. В диалоговом окне Переместить кластерную роль щелкните необходимый узел кластера и нажмите кнопку ОК. В столбце Узел владельца убедитесь в том, что узел владельца изменился.

Применимо к:Windows Server 2012

Раздел содержит базовые сведения и инструкции для настройки и управления кворумом в отказоустойчивом кластере Windows Server 2012.

В этом разделе

Общие сведения о кворуме в отказоустойчивом кластере

Обзор параметров настройки кворума

· Настройка свидетеля

· Назначение голосов узлов

· Динамическое управление кворумом

Общие рекомендации по настройке кворума

Настройка кворума кластера

Восстановление кластера путем запуска без кворума

Рекомендации касательно кворума для конфигураций аварийного восстановления

Общие сведения о кворуме в отказоустойчивом кластере

Кворум кластера определяется числом голосующих элементов, являющихся активными членами кластера, которое необходимо для запуска кластера и его правильной работы. По умолчанию каждый узел кластера имеет один голос кворума. Кроме того, свидетель кворума (если он настроен) имеет один дополнительный голос кворума. Для каждого кластера можно настроить один свидетель кворума. Свидетелем кворума может быть ресурс выделенного диска или общий файловый ресурс. Каждый элемент может подать один голос для определения того, можно ли запустить кластер. Наличие кворума в кластере для его правильной работы определяется большинством голосующих элементов, являющихся активными членами кластера.

Зачем настраивать кворум?

Чтобы повысить уровень доступности кластера и размещенных в нем ролей, необходимо правильно настроить конфигурацию кворума для кластера.

Конфигурация кворума кластера непосредственно влияет на доступность кластера по указанным ниже причинам.

· Она помогает обеспечить правильный запуск и работу отказоустойчивого кластера при изменении активного членства в кластере. Изменения членства могут происходить из-за запланированного или незапланированного прекращения работы узлов, а также из-за разрывов соединений между узлами или с хранилищем кластера.

· Если подмножество узлов утрачивает связь с другим подмножеством (то есть происходит расщепление кластера), конфигурация кворума кластера гарантирует, что только одно из подмножеств продолжает работать как кластер. Подмножества, у которых недостаточно голосов кворума, перестанут работать как кластер. Подмножество, имеющее большинство голосов кворума, может и далее использоваться для размещения кластерных ролей. Это позволяет избежать деления кластера на разделы, при котором одно и то же приложение размещается в нескольких разделах.

· Настройка голоса свидетеля позволяет кластеру продолжать работу при отключении одного дополнительного узла в некоторых конфигурациях. Подробнее о настройке свидетеля кворума см. в подразделе Настройка свидетеля далее в этом разделе.

Имейте в виду, что функционирование кластера зависит не только от кворума, но еще и от следующих факторов:

· сетевые соединения между узлами кластера;

· емкость узла, достаточная для размещения назначаемых ему кластерных ролей;

· параметры приоритета, настраиваемые для кластерных ролей.

Например, кластер с пятью узлами может сохранять кворум после отказа двух узлов. Однако каждый оставшийся узел будет обслуживать клиентов только в том случае, если он имеет достаточную емкость для размещения кластерных ролей, перенесенных на него в результате отработки отказа, и если параметрами ролей установлены наиболее приоритетные рабочие нагрузки.

Обзор параметров настройки кворума

Модель кворума в Windows Server 2012 является гибкой. Если необходимо изменить конфигурацию кворума для кластера, воспользуйтесь мастером настройки кворума кластера или командлетами отказоустойчивых кластеров Windows PowerShell. Параметры конфигурации кворума по сравнению с параметрами в Windows Server 2008 R2 стали проще. Инструкции и рекомендации по настройке кворума см. в подразделе Настройка кворума кластера далее в этом разделе.

В таблице ниже перечислены три параметра конфигурации кворума, доступные в мастере настройки кворума кластера.

В зависимости от выбранного варианта конфигурации кворума и заданных параметров для кластера настраивается один из указанных ниже режимов кворума.

Подробнее о дополнительных параметрах конфигурации кворума см. в следующих подразделах.

· Настройка свидетеля

· Назначение голосов узлов

· Динамическое управление кворумом

Настройка свидетеля

Как правило, при настройке кворума число голосующих элементов в кластере должно быть нечетным. Поэтому, если кластер содержит четное число голосующих узлов, следует настроить диск-свидетель или файловый ресурс-свидетель. Кластер сможет продолжать работу при отключении одного дополнительного узла. Кроме того, добавление голоса свидетеля позволяет кластеру продолжать работу в том случае, если половина его узлов одновременно прекращает работу или отключается.

Использовать диск-свидетель обычно рекомендуется, если диск доступен всем узлам. Файловый ресурс-свидетель рекомендуется в том случае, если необходимо реализовать аварийное восстановление нескольких сайтов с реплицированным хранилищем. Настройка диска-свидетеля с реплицированным хранилищем возможна только в том случае, если поставщик хранилища поддерживает доступ для чтения и записи к реплицированному хранилищу со всех сайтов.

В таблице ниже приводится дополнительная информация и рекомендации касательно типов свидетеля кворума.

Назначение голосов узлов

В Windows Server 2012 с помощью дополнительных параметров настройки кворума можно назначать голоса отдельным узлам или удалять их. По умолчанию голоса назначены всем узлам. Вне зависимости от назначения голосов, все узлы продолжают работать в кластере, получать обновления из базы данных кластера и использоваться для размещения приложений.

В некоторых конфигурациях аварийного восстановления может потребоваться удалить голоса, назначенные узлам. Например, в кластере с несколькими сайтами можно удалить голоса узлов на сайте резервного копирования, чтобы они не оказывали влияния на подсчет кворума. Такая конфигурация рекомендуется только при отработке отказа между сайтами вручную. Дополнительные сведения см. ниже в разделе Рекомендации касательно кворума для конфигураций аварийного восстановления.

Узнать, назначен ли узлу голос, можно путем проверки значения общего свойства NodeWeight для узла кластера с помощью командлета Get-ClusterNode Windows PowerShell. Значение 0 указывает на то, что для узла не настроен голос кворума. Значение 1 указывает на то, что узлу назначен голос кворума и управление им осуществляется кластером. Дополнительные сведения об управлении голосами узлов см. в подразделе Динамическое управление кворумом далее в этом разделе.

Назначение голосов всем узлам кластера можно проверить с помощью теста Проверка кворума кластера.

Дополнительные сведения

· Не рекомендуется назначать голоса нечетному числу узлов. Вместо этого следует настроить диск-свидетель или файловый ресурс-свидетель. Дополнительные сведения см. в разделе Настройка свидетеля этой статьи.

· Если включено динамическое управление кворумом, голоса могут динамически назначаться и удаляться только для тех узлов, для которых настроено назначение голосов. Дополнительные сведения см. ниже в разделе Динамическое управление кворумом.

Динамическое управление кворумом

В Windows Server 2012 с помощью дополнительных параметров настройки кворума можно включить динамическое управление кворумом, которое осуществляется кластером. Если этот параметр включен, кластер динамически управляет назначением голосов узлам в соответствии с состоянием каждого узла. Когда узел перестает быть активным членом кластера, он автоматически теряет голос, а когда он снова присоединяется к кластеру, голос автоматически назначается. По умолчанию динамическое управление кворумом включено.

Примечание

При использовании динамического управления кворумом большинство кворума в кластере определяется на основе набора узлов, являющихся активными членами кластера в данный момент. Это важное отличие от кворума кластера в Windows Server 2008 R2, где большинство кворума зависит от первоначальной конфигурации кластера и является фиксированным.

Благодаря динамическому управлению кворумом кластер также может продолжать работать на последнем оставшемся узле. Благодаря динамическому изменению требований к большинству кворума кластер может сохранять работоспособность после последовательного отключения всех узлов, кроме последнего.

Узнать, назначил ли кластер узлу голос в динамическом режиме, можно путем проверки значения общего свойства DynamicWeight для узла кластера с помощью командлета Get-ClusterNode Windows PowerShell. Значение 0 указывает на то, что у узла нет голоса кворума. Значение 1 указывает на то, что у узла есть голос кворума.

Назначение голосов всем узлам кластера можно проверить с помощью теста Проверка кворума кластера.

Дополнительные сведения

· Динамическое управление кворумом не позволяет кластеру сохранять работоспособность при одновременном сбое большинства голосующих членов. Для продолжения работы в кластере должно быть большинство кворума на момент завершения работы или сбоя узла.

· Если вы явно удалили голос узла, кластер не сможет динамически добавить или удалить его.

Общие рекомендации по настройке кворума

Программное обеспечение кластера автоматически настраивает кворум для нового кластера в соответствии с числом настроенных узлов и доступностью общего хранилища. Обычно это оптимальная конфигурация кворума для данного кластера. Однако рекомендуется проверить конфигурацию кворума после создания кластера и перед его запуском. Чтобы просмотреть подробную информацию о конфигурации кворума кластера, можно воспользоваться мастером проверки конфигурации или командлетом Test-Cluster Windows PowerShell для запуска теста Проверка конфигурации кворума. В диспетчере отказоустойчивости кластеров базовая конфигурация кворума содержится в сводной информации о выбранном кластере. Вы также можете просмотреть информацию о ресурсах кворума, которая выводится при запуске командлета Get-ClusterQuorum Windows PowerShell.

В любой момент можно выполнить тест Проверка конфигурации кворума, чтобы проверить, является ли конфигурация кворума оптимальной для кластера. В результатах теста приводятся рекомендации по изменению конфигурации кворума и информация об оптимальных параметрах. Если рекомендуется внести изменение, применить нужные параметры можно с помощью мастера настройки кворума кластера.

После запуска кластера изменять конфигурацию кворума следует только в том случае, если вы уверены, что это изменение необходимо. Изменение конфигурации кворума может потребоваться в следующих ситуациях:

· добавление или исключение узлов;

· добавление или удаление хранилища;

· длительный сбой узла или свидетеля;

· восстановление кластера в сценарии аварийного восстановления на основе нескольких сайтов.

Дополнительные сведения о проверке отказоустойчивого кластера см. в разделе Проверка оборудования для отказоустойчивого кластера.

Настройка кворума кластера

Настроить параметры кворума кластера можно с помощью диспетчера отказоустойчивости кластеров или командлетов отказоустойчивых кластеров Windows PowerShell.

Важно

Как правило, лучше использовать конфигурацию кворума, рекомендованную мастером настройки кворума кластера. Изменять конфигурацию кворума рекомендуется только в том случае, если решено, что изменение соответствует данному кластеру. Дополнительные сведения см. в разделе Общие рекомендации по настройке кворума этой статьи.

Настройка параметров кворума кластера

Для выполнения этой процедуры необходимо быть как минимум участником локальной группы Администраторы на каждом кластерном сервере или иметь равнозначные права. Кроме того, используемая учетная запись должна быть учетной записью пользователя домена.

Примечание

Изменять конфигурацию кворума кластера можно без остановки кластера и без отключения его ресурсов.

Изменение конфигурации кворума в отказоустойчивом кластере с помощью диспетчера отказоустойчивости кластеров

1. В диспетчере отказоустойчивости кластеров выберите или укажите кластер, который нужно изменить.

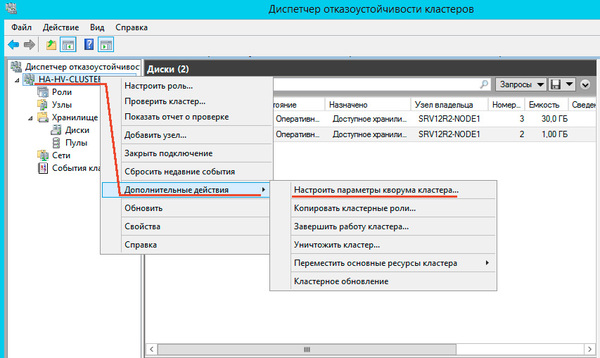

2. Выбрав кластер, на панели Действия выберите пункт Дополнительные действия и щелкните Настроить параметры кворума кластера. Появится мастер настройки кворума кластера. Нажмите кнопку Далее.

3. На странице Выбор параметра конфигурации кворума выберите один из трех параметров конфигурации и выполните необходимые для него действия. Перед настройкой параметров кворума можно изучить возможные варианты. Дополнительные сведения о вариантах см. в подразделе Общие сведения о кворуме в отказоустойчивом кластере ранее в этом разделе.

o Чтобы разрешить кластеру автоматически установить оптимальные параметры кворума для текущей конфигурации кластера, выберите параметр Использовать типичные параметры и выполните инструкции мастера.

o Чтобы добавить или изменить свидетель кворума, выберите параметр Добавить или изменить свидетель кворума, а затем выполните описанные ниже действия. Информацию и рекомендации по настройке свидетеля кворума см. в подразделе Настройка свидетеля ранее в этом разделе.

1. На странице Выбор свидетеля кворума выберите, нужно ли настроить диск-свидетель или файловый ресурс-свидетель. В мастере будут показаны параметры выбора свидетеля, рекомендованные для вашего кластера.

Примечание

Также можно выбрать параметр Не настраивать свидетель кворума и завершить работу мастера. Если число голосующих узлов в кластере четное, такая конфигурация не рекомендуется.

2. Если вы выбрали настройку диска-свидетеля, на странице Настройка хранилища выберите том хранилища, который нужно назначить диском-свидетелем, а затем завершите работу мастера.

3. Если вы выбрали настройку файлового ресурса-свидетеля, на странице Настройка файлового ресурса-свидетеля введите имя файлового ресурса, который будет использоваться в качестве ресурса-свидетеля, или выберите его, а затем завершите работу мастера.

o Чтобы настроить параметры управления кворумом и добавить или изменить свидетель кворума, выберите пункт Дополнительная настройка кворума и выбор свидетеля, а затем выполните описанные ниже действия. Сведения и рекомендации о дополнительных параметрах настройки кворума см. в подразделах Назначение голосов узлов и Динамическое управление кворумом ранее в этом разделе.

1. На странице Выбор конфигурации голосования выберите вариант назначения голосов узлам. По умолчанию голоса назначены всем узлам. Однако в некоторых сценариях можно назначить голоса только подмножеству узлов.

Примечание

Также можно выбрать вариант Нет узлов. Обычно делать это не рекомендуется, так как узлам при этом не разрешено принимать участие в голосовании в кворуме, и необходимо настроить диск-свидетель. Диск-свидетель становится единой точкой отказа в кластере.

2. На странице Настройка управления кворумом можно включить или отключить параметр Разрешить кластеру динамически управлять назначением голосов узлов. Выбор этого параметра, как правило, повышает доступность кластера. По умолчанию он включен, и настоятельно не рекомендуется его отключать. Этот параметр позволяет кластеру продолжать работу в таких сценариях сбоя, в которых его функционирование невозможно, если параметр отключен.

3. На странице Выбор свидетеля кворума выберите, нужно ли настроить диск-свидетель или файловый ресурс-свидетель. В мастере будут показаны параметры выбора свидетеля, рекомендованные для вашего кластера.

Примечание

Также можно выбрать параметр Не настраивать свидетель кворума и завершить работу мастера. Если число голосующих узлов в кластере четное, такая конфигурация не рекомендуется.

4. Если вы выбрали настройку диска-свидетеля, на странице Настройка хранилища выберите том хранилища, который нужно назначить диском-свидетелем, а затем завершите работу мастера.

5. Если вы выбрали настройку файлового ресурса-свидетеля, на странице Настройка файлового ресурса-свидетеля введите имя файлового ресурса, который будет использоваться в качестве ресурса-свидетеля, или выберите его, а затем завершите работу мастера.

4. Нажмите кнопку Далее. На открывшейся странице подтвердите выбранные параметры и нажмите кнопку Далее.

После выполнения мастера и отображения страницы Сводка щелкните пункт Просмотр отчета, чтобы посмотреть отчет о выполненных мастером задачах. Последний отчет находится в папке systemrootClusterReports под именем QuorumConfiguration.mht.

Примечание

После настройки кворума кластера рекомендуем выполнить тест Проверка конфигурации кворума, чтобы проверить обновленные параметры кворума.

Подготовка кластерных объектов-компьютеров в доменных службах Active Directory

Применимо к:Windows Server 2012 R2, Windows Server 2012

В этом разделе показан порядок подготовки кластерных объектов-компьютеров в доменных службах Active Directory (AD DS). Эту процедуру можно использовать, чтобы дать возможность пользователю или группе создавать отказоустойчивые кластеры, если у них нет разрешений на создание объектов-компьютеров в AD DS.

Когда вы создаете отказоустойчивый кластер с помощью мастера создания кластеров или Windows PowerShell, необходимо указать имя кластера. Если при создании кластера у вас достаточно разрешений, процесс создания кластера автоматически создает объект-компьютер в AD DS с соответствующим именем кластера. Этот объект называется объектом имени кластера или CNO. Посредством CNO при настройке кластерных ролей, использующих точки доступа клиентов, автоматически создаются виртуальные объекты-компьютеры (VCO). Например, если вы создали файловый сервер высокой надежности с точкой доступа клиента с именем FileServer1, CNO создаст соответствующий VCO в AD DS.

Примечание

В Windows Server 2012 R2 есть возможность создать отсоединенный от Active Directory кластер. При этом ни CNO, ни VCO в AD DS не создается. Эта возможность предназначена для определенных типов развертывания кластера. Дополнительные сведения см. в разделе Развертывание отсоединенного от Active Directory кластера.

Для автоматического создания CNO у пользователя, создающего отказоустойчивый кластер, должно быть разрешение на создание объектов-компьютеров для подразделения или контейнера, в которых размещаются серверы, которые войдут в кластер. Чтобы позволить пользователям и группам, не имеющим разрешения, создавать кластеры, пользователь с соответствующими разрешениями в AD DS (обычно администратор домена) может подготовить CNO в AD DS. Это также обеспечивает администратору домена больший контроль над именами, используемыми для кластера, и над тем, в каких подразделениях можно создавать кластерные объекты.

С помощью описанных в этом разделе процедур вы сможете сделать следующее.

· Шаг 1. Подготовка CNO в AD DS

· Шаг 2. Предоставление пользователю разрешений на создание кластера

· Шаг 3. Предоставление разрешений CNO подразделению или подготовка VCO для кластерных ролей

Шаг 1. Подготовка CNO в AD DS

Перед началом работы убедитесь, что знаете следующее:

· имя, которое следует присвоить кластеру;

· имя учетной записи пользователя или группы, которой следует предоставить права на создание кластера.

Мы рекомендуем создать подразделение для кластерных объектов. Если подразделение, которое вы хотите использовать, уже существует, для завершения этого шага требуется членство в группе Операторы учета. Если подразделение для кластерных объектов необходимо создать, для завершения этого шага требуется членство в группе Администраторы домена или аналогичной группе.

Примечание

Если вы создали CNO в контейнере компьютеров по умолчанию, а не в подразделении, вам не нужно выполнять шаг 3 этого раздела. В этом сценарии администратор кластера может создать до 10 VCO без какой-либо дополнительной настройки.

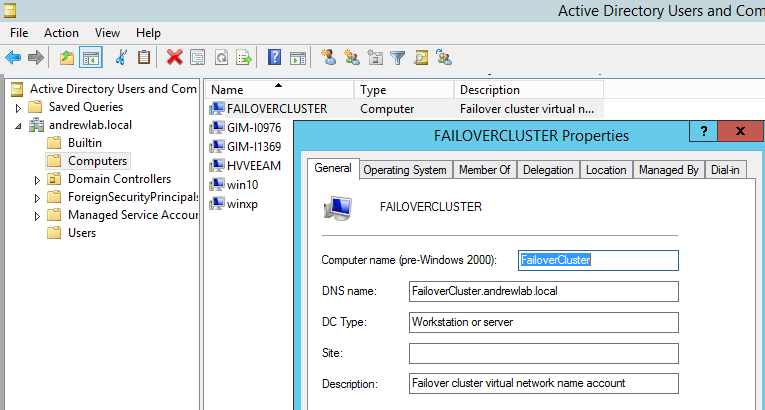

Подготовка CNO в AD DS

1. На компьютере с установленными средствами AD DS из средств удаленного администрирования сервера или на контроллере домена откройте Пользователи и компьютеры Active Directory. Чтобы выполнить это действие на сервере, откройте диспетчер сервера и в меню Средства щелкните Пользователи и компьютеры Active Directory.

2. Чтобы создать подразделение для кластерных объектов-компьютеров, щелкните правой кнопкой мыши имя домена или существующее подразделение, наведите указатель на пункт Создать и щелкните Подразделение. В поле Имя введите имя подразделения и нажмите кнопку ОК.

3. В дереве консоли щелкните правой кнопкой мыши подразделение, в котором следует создать CNO, наведите указатель на пункт Создать и щелкните Компьютер.

4. В поле Имя компьютера введите имя, которое будет использоваться для отказоустойчивого кластера, и нажмите кнопку ОК.

Примечание

Это имя кластера, которое пользователь, создающий кластер, укажет в мастере создания кластеров на странице Точка доступа для администрирования кластера или укажет как значение параметра –Name для командлета New-Cluster Windows PowerShell.

5. Рекомендуется сделать следующее: щелкните правой кнопкой мыши учетную запись компьютера, которую вы только что создали, выберите Свойства и откройте вкладку Объект. На вкладке Объект установите флажок Защитить объект от случайного удаления и нажмите кнопку ОК.

6. Щелкните правой кнопкой мыши только что созданную учетную запись компьютера и выберите команду Отключить учетную запись. Нажмите кнопку Да для подтверждения, а затем нажмите кнопку ОК.

Примечание

Учетную запись необходимо отключить, чтобы во время создания кластера соответствующий процесс подтвердил, что учетная запись не используется в данный момент существующим компьютером или кластером в домене.

8. Рисунок 1. Отключенный CNO в примере подразделения кластеров

Шаг 2. Предоставление пользователю разрешений на создание кластера

Необходимо настроить разрешения, чтобы учетная запись пользователя, которая будет использоваться для создания отказоустойчивого кластера, имела полный доступ к CNO.

Минимальное требование для выполнения этого шага — членство в группе Операторы учета.

Предоставление пользователю разрешений на создание кластера

1. На странице “Пользователи и компьютеры Active Directory” в меню Вид убедитесь, что выбран пункт Дополнительные параметры.

2. Найдите и щелкните правой кнопкой мыши CNO и выберите Свойства.

3. На вкладке Безопасность нажмите кнопку Добавить.

4. В диалоговом окне Выбор пользователей, компьютеров или групп укажите учетную запись пользователя или группу, которым следует предоставить разрешения, и нажмите кнопку ОК.

5. Выберите добавленную учетную запись пользователя или группу и около пункта Полный доступ установите флажок Разрешить.

Рисунок 2. Предоставление полного доступа пользователю или группе, которые будут создавать кластер

6. Нажмите кнопку ОК.

После завершения этого шага пользователь, которому вы предоставили разрешение, сможет создать отказоустойчивый кластер. Однако если CNO расположен в подразделении, до завершения вами шага 3 пользователь не сможет создавать кластерные роли, которые требуют точку доступа клиента.

Примечание

Если CNO находится в контейнере компьютеров по умолчанию, администратор кластера может создать до 10 VCO без какой-либо дополнительной настройки. Чтобы добавить более 10 VCO, необходимо явно предоставить разрешение на создание объектов-компьютеров объекту имени кластера для контейнера компьютеров.

Шаг 3. Предоставление разрешений CNO подразделению или подготовка VCO для кластерных ролей

Когда вы создаете кластерную роль с точкой доступа клиента, кластер создает VCO в том же подразделении, что и CNO. Чтобы это происходило автоматически, CNO должен иметь разрешения на создание объектов-компьютеров в подразделении.

Если вы подготовили CNO в AD DS, для создания VCO можно сделать следующее.

· Вариант 1: Предоставление разрешений CNO подразделению. Если вы воспользуетесь этим вариантом, кластер сможет автоматически создавать VCO в AD DS. Таким образом, администратор отказоустойчивого кластера сможет создавать кластерные роли, не отправляя вам запрос на подготовку VCO в AD DS.

Примечание

Необходимым минимумом для выполнения шагов этого варианта является членство в группе Администраторы домена или эквивалентной группе.

· Вариант 2: Подготовка VCO для кластерной роли. Используйте этот вариант, если есть необходимость в подготовке учетных записей для кластерных ролей из-за требований в вашей организации. Например, если вы хотите контролировать использование имен или создание кластерных ролей.

Примечание

Необходимым минимумом для выполнения шагов этого варианта является членство в группе Операторы учета.

Предоставление разрешений CNO подразделению

1. На странице “Пользователи и компьютеры Active Directory” в меню Вид убедитесь, что выбран пункт Дополнительные параметры.

2. Щелкните правой кнопкой мыши подразделение, в котором вы создали CNO в разделе Шаг 1. Подготовка CNO в AD DS, а затем выберите пункт Свойства.

3. На вкладке Безопасность нажмите кнопку Дополнительно.

4. В диалоговом окне Дополнительные параметры безопасности нажмите кнопку Добавить.

5. Рядом с пунктом Субъект щелкните Выбрать субъект.

6. В диалоговом окне Выбор пользователей, компьютеров, учетной записи службы или групп щелкните Типы объектов, установите флажок Компьютеры и нажмите кнопку ОК.

7. В поле Введите имена выбираемых объектов введите имя CNO, щелкните Проверить имена и нажмите кнопку ОК. В ответ на предупреждающее сообщение о попытке добавить отключенный объект нажмите кнопку ОК.

8. В диалоговом окне Запись разрешения убедитесь, что для списка Тип установлено значение Разрешить, а для списка Применяется к — значение Этот объект и все дочерние объекты.

9. В разделе Разрешения установите флажок Создание объектов-компьютеров.

Рисунок 3. Предоставление CNO разрешения на создание объектов-компьютеров

10. Нажимайте кнопку ОК, пока не вернетесь на страницу “Пользователи и компьютеры Active Directory”.

Теперь администратор отказоустойчивого кластера может создать кластерные роли с точкой доступа клиента и подключить ресурсы.

Подготовка VCO для кластерной роли

1. Прежде чем начать подготовку, убедитесь, что знаете имя кластера и имя, которое будет иметь кластерная роль.

2. На странице “Пользователи и компьютеры Active Directory” в меню Вид убедитесь, что выбран пункт Дополнительные параметры.

3. На странице “Пользователи и компьютеры Active Directory” щелкните правой кнопкой мыши подразделение, в котором находится CNO, наведите указатель на пункт Создать и выберите Компьютер.

4. В поле Имя компьютера введите имя, которое будет использоваться для кластерной роли, и нажмите кнопку ОК.

5. Рекомендуется сделать следующее: щелкните правой кнопкой мыши учетную запись компьютера, которую вы только что создали, выберите Свойства и откройте вкладку Объект. На вкладке Объект установите флажок Защитить объект от случайного удаления и нажмите кнопку ОК.

6. Щелкните правой кнопкой мыши только что созданную учетную запись компьютера и выберите пункт Свойства.

7. На вкладке Безопасность нажмите кнопку Добавить.

8. В диалоговом окне Выбор пользователей, компьютеров, учетной записи службы или групп щелкните Типы объектов, установите флажок Компьютеры и нажмите кнопку ОК.

9. В поле Введите имена выбираемых объектов введите имя CNO, щелкните Проверить имена и нажмите кнопку ОК. Если появится предупреждающее сообщение о попытке добавить отключенный объект, нажмите кнопку ОК.

10. Убедитесь, что CNO выделен, после чего рядом с полем Полный доступ установите флажок Разрешить.

11. Нажмите кнопку ОК.

Теперь администратор отказоустойчивого кластера может создать кластерную роль с точкой доступа клиента, которая соответствует подготовленному имени VCO, и подключить ресурсы.

Развертывание кластера Hyper-V

Применимо к:Windows Server 2012 R2, Windows Server 2012

В этом разделе приводятся инструкции по настройке и развертыванию простого отказоустойчивого кластера с двумя узлами и кластерной виртуальной машины Hyper-V. Благодаря роли Hyper-V вы можете использовать виртуализированную вычислительную среду для повышения эффективности вычислительных ресурсов и доступности серверов при меньшем количестве физических компьютеров, чем потребовалось бы в конфигурации отказоустойчивого кластера, включающей только физические компьютеры. Общие рекомендации и инструкции, приведенные в этом руководстве, можно использовать для развертывания кластеров с большим числом узлов и виртуальных машин. Однако в этом разделе не приводятся указания по развертыванию конкретных рабочих нагрузок в кластеризованных виртуальных машинах и по управлению ими.

Общие сведения о роли Hyper-V и компоненте “Отказоустойчивая кластеризация” см. в разделе Обзор Hyper-V и Обзор отказоустойчивой кластеризации.

Пример сценария развертывания и мониторинга приложения, в котором используются кластеризованные виртуальные машины, см. в разделе Обзор печати высокого уровня доступности.

В этом разделе

· Предварительные условия

· Ограничения

· Шаг 1. Подключите оба физических компьютера к сетям и хранилищу

· Шаг 2. Установите Hyper-V и средство отказоустойчивости кластеров на обоих физических компьютерах

· Шаг 3. Создайте виртуальный коммутатор

· Шаг 4. Проверьте конфигурацию кластера

· Шаг 5. Создайте кластер

· Шаг 6. Добавьте диск в качестве общего тома кластера для хранения данных виртуальной машины

· Шаг 7. Создайте высокодоступную виртуальную машину

· Шаг 8. Установите гостевую операционную систему на виртуальной машине

· Шаг 9. Протестируйте плановую отработку отказа

· Шаг 10. Протестируйте внеплановую отработку отказа

· Шаг 11. Измените параметры виртуальной машины

· Шаг 12. Удалите виртуальную машину из кластера

Примечание

В этом разделе содержатся примеры командлетов Windows PowerShell, которые можно использовать для автоматизации некоторых описанных процедур. Дополнительные сведения см. в статье Запуск Windows PowerShell.

Обязательные компоненты

Предварительные условия

Для использования роли Hyper-V в отказоустойчивом кластере с двумя ролями требуется оборудование, программное обеспечение, учетные записи и сетевая инфраструктура, которые описываются в следующих разделах.

Требования к оборудованию

Общие требования к серверам, сетям, сетевым адаптерам, хранилищу и контроллерам устройств хранения для Hyper-V и отказоустойчивых кластеров см. в подразделе “Требования к оборудованию” статей Обзор Hyper-V и Требования к оборудованию для отказоустойчивой кластеризации и варианты хранилища.

Требования к программному обеспечению

Сведения о требованиях к программному обеспечению для использования роли Hyper-V и компонента “Отказоустойчивая кластеризация” см. в разделе Обзор Hyper-V и Обзор отказоустойчивой кластеризации.

Чтобы установить гостевую операционную систему, которая будет выполняться в кластеризованной виртуальной машине, необходим соответствующий установочный носитель с поддерживаемой операционной системой. Установку можно выполнить с физического носителя либо из файла образа (ISO). Виртуальную машину можно также настроить с помощью виртуального жесткого диска с уже установленной операционной системой. В инструкциях в этом разделе предполагается, что на виртуальной машине будет установлена ОС Windows Server 2012 R2.

Требования к сетевой инфраструктуре и учетным записям домена

Для отказоустойчивого кластера с двумя узлами потребуется указанная ниже сетевая инфраструктура.

· Сети. Для отказоустойчивого кластера рекомендуется иметь по крайней мере две сети: общедоступную сеть, которая позволяет клиентам подключаться к кластеру, и отдельную сеть — только для передачи данных между кластерными серверами. При необходимости можно настроить дополнительные сети для определенных вариантов хранилища или избыточности.

· Сетевые параметры и IP-адреса. Если для сети используются одинаковые сетевые адаптеры, настройте на них одинаковые параметры обмена данными (такие как скорость, дуплексный режим, управление потоком и тип мультимедиа). Кроме того, сравните параметры на сетевом адаптере и коммутаторе, к которому он подключается, и убедитесь в том, что они не конфликтуют.

Если есть частные сети, которые не маршрутизируются в остальную часть сетевой инфраструктуры, убедитесь, что для каждой из этих частных сетей используется уникальная подсеть. Это необходимо даже в том случае, если каждому сетевому адаптеру присвоен уникальный IP-адрес. Например, если в центральном офисе есть узел кластера, использующий одну физическую сеть, а в филиале есть другой узел, использующий отдельную физическую сеть, не указывайте адрес 10.0.0.0/24 для обеих сетей, даже если каждому адаптеру присвоен уникальный IP-адрес.

· DNS. Серверы в кластере должны использовать службу доменных имен (DNS) для разрешения имен. Можно использовать протокол динамического обновления DNS.

· Роль домена. Все серверы в кластере должны входить в один домен Active Directory. Мы рекомендуем, чтобы все кластерные серверы имели одинаковую роль домена (рядовой сервер или контроллер домена). Рекомендованная роль — рядовой сервер. Если кластерные серверы являются рядовыми серверами, то необходим дополнительный сервер, выступающий в роли контроллера домена в содержащем кластер домене.

· Клиенты. При необходимости можно подключить один или несколько связанных клиентов к создаваемому отказоустойчивому кластеру, а затем наблюдать за тем, как влияет на клиент отработка отказа или перенос виртуальной машины высокой доступности с одного узла кластера на другой.

Чтобы создать кластер или добавить узлы, необходимо войти в домен с учетной записью, которая имеет права и разрешения администратора на всех серверах в кластере. Она не обязательно должна входить в группу “Администраторы домена”. Например, это может быть учетная запись пользователя домена, входящая в группу “Администраторы” на каждом кластерном сервере. Кроме того, если учетная запись не входит в группу “Администраторы домена”, ей (или группе, членом которой она является) необходимо предоставить разрешения на создание объектов-компьютеров и чтение всех свойств в домене.

Ограничения

В отношении Hyper-V и отказоустойчивых кластеров действуют указанные ниже общие ограничения.

· Отказоустойчивый кластер может иметь не более 64 узлов.

· При использовании виртуализации серверов в кластере может быть до 8000 виртуальных машин, а в одном узле можно разместить до 1024 виртуальных машин, если аппаратных ресурсов сервера достаточно для их поддержки. Например, если технология Hyper-V используется вместе с инфраструктурой виртуальных рабочих столов (VDI) для виртуализации клиентских компьютеров, в кластере может быть до 8000 виртуальных машин VDI (Windows 8.1, Windows 8 или Windows 7), а на одном узле можно разместить до 1024 виртуальных машин.

Подробнее об ограничениях масштабируемости для Hyper-V см. в разделе Масштабируемость Hyper-V в Windows Server 2012 и Windows Server 2012 R2.

Шаг 1. Подключите оба физических компьютера к сетям и хранилищу

Чтобы подключить выбранные серверы к сетям и хранилищу, выполните приведенные ниже инструкции.

Подключение серверов к сетям и хранилищу

1. Подробные сведения о типах сетевых адаптеров и контроллеров устройств, которые можно использовать в отказоустойчивом кластере, см. в подразделе Предварительные условия выше в этой статье.

2. Подключите и настройте сети, которые будут использовать серверы в кластере.

Примечание

Если вы хотите включить клиенты или некластерный контроллер домена в тестовую конфигурацию, убедитесь в том, что эти компьютеры могут подключаться к серверам отказоустойчивого кластера по крайней мере через одну сеть.

3. Чтобы физически подключить серверы к хранилищу, следуйте инструкциям изготовителя.

4. Убедитесь в том, что диски (LUN), которые вы хотите использовать в кластере, доступны кластерным серверам (и только им). Для предоставления доступа к дискам или LUN можно использовать один из следующих интерфейсов:

o интерфейс, предоставленный изготовителем хранилища;

o соответствующий интерфейс iSCSI.

5. Если вы приобрели программное обеспечение, управляющее форматом или функционированием диска, следуйте инструкциям поставщика по использованию этого ПО с Windows Server 2012 R2 или Windows Server 2012.

6. На одном из серверов, которые будут включены в кластер, в диспетчере сервера или оснастке управления дисками убедитесь в том, что кластерные диски доступны.

7. Если требуется объем хранилища более 2 терабайт, а для управления форматом диска используется интерфейс Windows, преобразуйте тип разделов диска в таблицу разделов GPT. Для этого выполните резервное копирование всех данных на диске и удалите все тома на нем. Затем в оснастке управления дисками щелкните правой кнопкой мыши диск (не раздел) и выберите пункт Преобразовать в GPT-диск.

Если объем меньше 2 терабайт, то вместо таблицы разделов GPT можно использовать тип разделов, называемый основной загрузочной записью (MBR).

Важно

В качестве типа разделов для диска, используемого отказоустойчивым кластером, можно применять как MBR, так и GPT, однако использовать диск, преобразованный в динамический с помощью оснастки управления дисками, нельзя.

8. Проверьте форматы всех предоставленных томов или LUN. Мы рекомендуем использовать формат NTFS (для диска-свидетеля кворума можно использовать NTFS или ReFS).

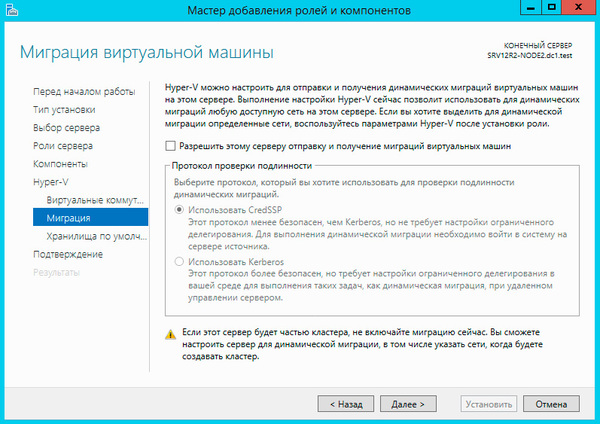

Шаг 2. Установите Hyper-V и средство отказоустойчивости кластеров на обоих физических компьютерах

Чтобы установить роль Hyper-V и средство отказоустойчивости кластеров на каждом физическом компьютере, обратитесь к следующим процедурам.

· Добавление роли Hyper-V в разделе “Установка роли Hyper-V и настройка виртуальной машины”.

· Установка компонентов и инструментов для отказоустойчивых кластеров в Windows Server 2012

Шаг 3. Создайте виртуальный коммутатор

Выполните это действие на обоих физических компьютерах, если вы не создали виртуальный коммутатор при установке роли Hyper-V. Этот виртуальный коммутатор предоставляет виртуальную машину высокой доступности с доступом к физической сети.

Создание виртуального коммутатора

1. Откройте диспетчер Hyper-V.

2. В меню Действия выберите пункт Диспетчер виртуальных коммутаторов.

3. В разделе Создать виртуальный коммутатор выберите пункт Внешний.

4. Щелкните Создать виртуальный коммутатор. Появится страница Создать виртуальный коммутатор.

5. Введите имя нового коммутатора. На обоих серверах с Hyper-V должно использоваться одно и то же имя.

6. В списке Тип подключения выберите пункт Внешняя сеть, а затем — физический сетевой адаптер.

7. Нажмите кнопку ОК, чтобы сохранить виртуальную сеть и закрыть диспетчер виртуальных коммутаторов.

Эквивалентные команды Windows PowerShell

Следующие командлеты Windows PowerShell выполняют ту же функцию, что и предыдущая процедура. Вводите каждый командлет в одной строке, несмотря на то, что здесь они могут отображаться разбитыми на несколько строк из-за ограничений форматирования.

В приведенном ниже примере создается внешний коммутатор VMExternalSwitch, который связан с сетевым адаптером Wired Ethernet Connection 3 и позволяет операционной системе управления совместно использовать сетевой адаптер.

New-VMSwitch “VMExternalSwitch” –NetAdapterName “Wired Ethernet Connection 3” –AllowManagementOS

Шаг 4. Проверьте конфигурацию кластера

Перед созданием кластера настоятельно рекомендуется выполнить полный набор проверочных тестов конфигурации кластера, запустив мастер проверки конфигурации в диспетчере отказоустойчивости кластеров или командлет Test-Cluster Windows PowerShell. В набор тестов включены специальные проверочные тесты для конфигурации роли Hyper-V в отказоустойчивом кластере.

Подробные инструкции и рекомендации по проверке кластера см. в разделе Проверка оборудования для отказоустойчивого кластера.

Шаг 5. Создайте кластер

Сведения о создании отказоустойчивого кластера с помощью диспетчера отказоустойчивости кластеров или командлета New-Cluster Windows PowerShell см. в разделе Создание отказоустойчивого кластера Windows Server 2012.

Шаг 6. Добавьте диск в качестве общего тома кластера для хранения данных виртуальной машины

Для реализации некоторых сценариев использования кластерных виртуальных машин хранилище виртуальной машины и файл виртуального жесткого диска должны быть настроены как общие тома кластера (CSV). Чтобы настроить диск в кластерном хранилище как общий том кластера, можно воспользоваться диспетчером отказоустойчивости кластеров или командлетом Add-ClusterSharedVolume Windows PowerShell. Подробные рекомендации по планированию и инструкции по созданию общего тома кластера см. в разделе Использование общих томов кластера в отказоустойчивом кластере Windows Server 2012.

Тома CSV могут повысить доступность и управляемость виртуальных машин благодаря тому, что несколько узлов могут одновременно обращаться к одному общему тому хранилища. Например, в отказоустойчивом кластере, в котором используются тома CSV, кластеризованные виртуальные машины, распределенные по нескольким узлам кластера, могут одновременно обращаться к файлам на виртуальном жестком диске, даже если эти файлы располагаются на одном диске (LUN) в хранилище. Это означает, что отработка отказа кластеризованных виртуальных машин может осуществляться независимо друг от друга, даже если они используют один LUN. Тома CSV также поддерживают динамическую миграцию виртуальных машин Hyper-V между узлами отказоустойчивого кластера.

Шаг 7. Создайте высокодоступную виртуальную машину

На этом этапе создается виртуальная машина, и для нее настраивается высокая доступность.

Примечание

Запустить мастер создания виртуальной машины Hyper-V можно непосредственно из диспетчера отказоустойчивости кластеров. После создания виртуальной машины таким способом для нее автоматически настраивается высокая доступность.

Рекомендации по созданию виртуальной машины с высокой доступностью

· Начиная с версии Windows Server 2012, конфигурация, предполагающая наличие нескольких виртуальных машин с одной кластерной ролью виртуальной машины, не поддерживается. Примером может служить ситуация, когда несколько виртуальных машин хранят файлы на общем физическом диске, не входящем в том CSV. Выделение только одной виртуальной машины для каждой кластерной роли повышает удобство управления и эффективность виртуальных машин в кластерных средах. Например, улучшается мобильность виртуальных машин.

· Выберите общее хранилище для хранения виртуальной машины и виртуального жесткого диска. В противном случае обеспечить высокую доступность виртуальной машины не удастся. Чтобы сделать общее хранилище доступным для виртуальной машины, необходимо создать ее на физическом компьютере, который является узлом-владельцем хранилища.

· Если общий том кластера создан в Шаг 6. Добавьте диск в качестве общего тома кластера для хранения данных виртуальной машины, то в параметрах виртуального жесткого диска укажите общий том кластера в качестве расположения как для виртуальной машины, так и для виртуального жесткого диска.

· Убедитесь в том, что выбран вариант виртуального жесткого диска, соответствующий способу установки гостевой операционной системы в виртуальной машине (например, с физического носителя или ISO-файла).

Создание виртуальной машины высокой доступности

1. В диспетчере отказоустойчивости кластеров выберите или укажите нужный кластер. Дерево консоли под кластером должно быть развернуто.

2. Щелкните Роли.

3. На панели Действия выберите пункт Виртуальные машины, а затем щелкните Создать виртуальную машину. Откроется мастер создания виртуальной машины. Нажмите кнопку Далее.

4. На странице Укажите имя и расположение введите имя виртуальной машины, например FailoverTest. Выберите пункт Сохранить виртуальную машину в другом месте, а затем введите полный путь или нажмите кнопку Обзор и перейдите к общему хранилищу.

5. На странице Выделить память укажите количество памяти, необходимое операционной системе, которая будет выполняться на этой виртуальной машине. Например, для Windows Server 2012 R2 укажите значение 1024 МБ.

6. На странице Настройка параметров сети подключите сетевой адаптер к виртуальному коммутатору, связанному с физическим сетевым адаптером. Необходимо указать виртуальный коммутатор, настроенный в процедуре Шаг 3. Создайте виртуальный коммутатор.

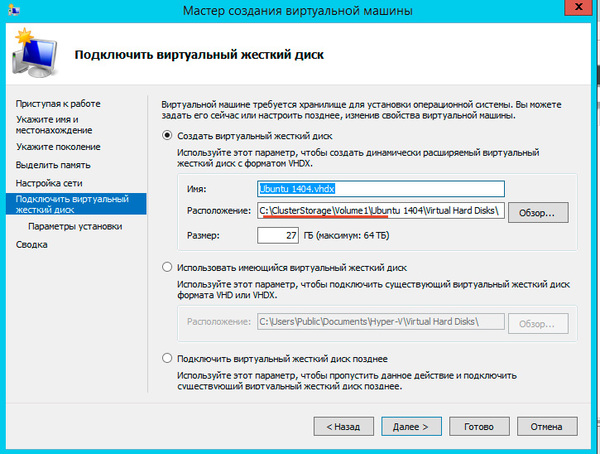

7. На странице Подключить виртуальный жесткий диск щелкните Создать виртуальный жесткий диск. Если вы хотите изменить имя, введите новое имя виртуального жесткого диска. Нажмите кнопку Далее.

8. На странице Параметры установки выберите пункт Установить операционную систему с загрузочного CD или DVD-диска. В поле Носитель укажите расположение носителя, а затем нажмите кнопку Готово.

Виртуальная машина создана. После этого мастер высокой доступности в диспетчере отказоустойчивости кластеров автоматически настраивает высокую доступность для виртуальной машины.

Эквивалентные команды Windows PowerShell

Следующие командлеты Windows PowerShell выполняют ту же функцию, что и предыдущая процедура. Вводите каждый командлет в одной строке, несмотря на то, что здесь они могут отображаться разбитыми на несколько строк из-за ограничений форматирования.

В приведенном ниже примере создается виртуальная машина FailoverTest, которая будет установлена из ISO-файла и для которой будет настроена высокая доступность.

New-VHD -Path <PathToVHDXFile> -Dynamic -SizeBytes 127GB

New-VM -Name FailoverTest -Path <PathToVMFolder> -Memory 1GB –SwitchName “VMExternalSwitch” –BootDevice CD -VHDPath <PathToVHDXFile>

Add-VMDvdDrive -VMName FailoverTest –Path <PathtoISOFile>

Set-VM –Name FailoverTest –AutomaticStartAction Nothing

Add-ClusterVirtualMachineRole -VirtualMachine FailoverTest

Шаг 8. Установите гостевую операционную систему на виртуальной машине

Затем необходимо запустить кластеризованную виртуальную машину, настроенную в процедуре Шаг 7. Создайте высокодоступную виртуальную машину. При этом будет установлена гостевая операционная система (в этом разделе предполагается, что это Windows Server 2012 R2). Сведения о том, как это сделать, см. в разделе Шаг 3. Установка гостевой операционной системы раздела “Установка роли Hyper-V и настройка виртуальной машины”.

Примечание

Если вы устанавливаете операционную систему, отличную от Windows Server 2012 R2, на узле Hyper-V Windows Server 2012 R2 или операционную систему, отличную от Windows Server 2012, на узле Hyper-V Windows Server 2012, может также потребоваться установка служб интеграции Hyper-V для операционной системы.

Шаг 9. Протестируйте плановую отработку отказа

Чтобы протестировать запланированную отработку отказа, можно перенести кластеризованную виртуальную машину, созданную в процедуре Шаг 7. Создайте высокодоступную виртуальную машину, на другой узел.

Возможны следующие варианты переноса кластеризованной виртуальной машины.

· Динамическая миграция. Перенесите владение кластеризованной виртуальной машиной на другой узел, не приостанавливая выполнение роли.

· Быстрая миграция. Приостановите виртуальную машину, сохраните состояние, перенесите роль на другой узел и запустите на нем виртуальную машину.

· Миграция хранилища. Перенесите в другое кластерное хранилище только данные виртуальной машины.

Например, чтобы протестировать запланированную отработку отказа путем динамической миграции, можно воспользоваться диспетчером отказоустойчивости кластеров или командлетом Move-ClusterVirtualMachineRole Windows PowerShell.

Тестирование запланированной отработки отказа

1. В диспетчере отказоустойчивости кластеров выберите или укажите нужный кластер. Дерево консоли под кластером должно быть развернуто.

2. Чтобы выбрать конечный узел для динамической миграции кластеризованной виртуальной машины, щелкните правой кнопкой мыши кластеризованную виртуальную машину FailoverTest (которая была настроена в процедуре Шаг 7. Создайте высокодоступную виртуальную машину), наведите указатель на пункт Переместить, затем на пункт Динамическая миграция и щелкните пункт Выбрать узел.

В процессе переноса виртуальной машины FailoverTest состояние отображается на панели результатов (в центре). Вы также можете повторить эту процедуру, чтобы перенести виртуальную машину на дополнительный или исходный узел.

3. Проверьте успешность переноса, изучив информацию о каждом узле.

Эквивалентные команды Windows PowerShell

Следующие командлеты Windows PowerShell выполняют ту же функцию, что и предыдущая процедура. Вводите каждый командлет в одной строке, несмотря на то, что здесь они могут отображаться разбитыми на несколько строк из-за ограничений форматирования.

В приведенном ниже примере выполняется динамическая миграция виртуальной машины FailoverTest на узел ContosoFCNode2.

Move-ClusterVirtualMachineRole -Name “FailoverTest” –Node ContosoFCNode2

Шаг 10. Протестируйте внеплановую отработку отказа

Чтобы протестировать незапланированную отработку отказа кластерной виртуальной машины, можно остановить службу кластеров на узле, который владеет этой виртуальной машиной.

Тестирование незапланированной отработки отказа

1. В диспетчере отказоустойчивости кластеров выберите или укажите нужный кластер. Дерево консоли под кластером должно быть развернуто.

2. Чтобы свести к минимуму время простоя для клиентов, перед остановкой службы кластеров на узле перенесите кластерные роли, которые в настоящее время принадлежат узлу (кроме FailoverTest), на другой узел, выполнив указанные ниже действия.

1. Разверните дерево консоли под кластером, которым необходимо управлять, а затем разверните элемент Узлы.

2. Выберите узел, которому принадлежит кластеризованная виртуальная машина FailoverTest (настроенная в процедуре Шаг 7. Создайте высокодоступную виртуальную машину).

3. Выберите все кластерные роли на узле, кроме FailoverTest.

4. Чтобы выбрать конечный узел для выбранных кластерных ролей, щелкните их правой кнопкой мыши, наведите указатель на пункт Перенести, а затем щелкните Выбрать узел.

Для переноса кластерных ролей в узел назначения может потребоваться несколько минут.

3. Разверните дерево консоли под элементом Узлы.

4. Щелкните правой кнопкой мыши узел, которому принадлежит виртуальная машина FailoverTest, наведите указатель на пункт Дополнительные действия, а затем выберите пункт Остановить службу кластеров.

Виртуальная машина будет перенесена на другой узел. При этом может возникнуть небольшая задержка.

Эквивалентные команды Windows PowerShell

Следующие командлеты Windows PowerShell выполняют ту же функцию, что и предыдущая процедура. Вводите каждый командлет в одной строке, несмотря на то, что здесь они могут отображаться разбитыми на несколько строк из-за ограничений форматирования.

В приведенном ниже примере служба кластеров останавливается на узле ContosoFCNode2, которому принадлежит кластерная виртуальная машина FailoverTest.

Stop-ClusterNode –Name ContosoFCNode2

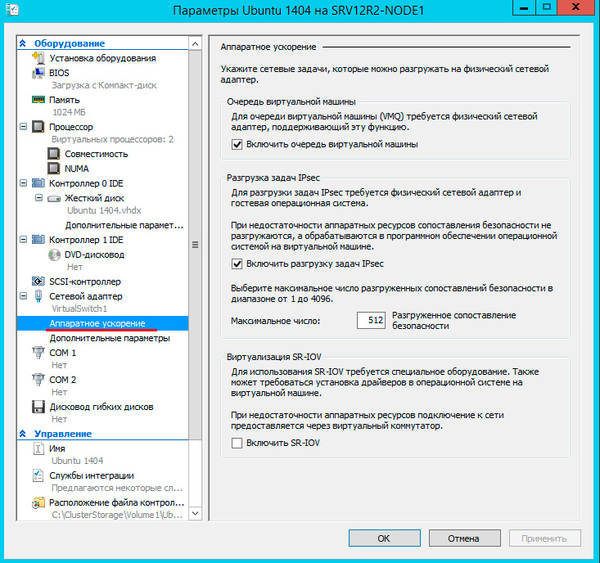

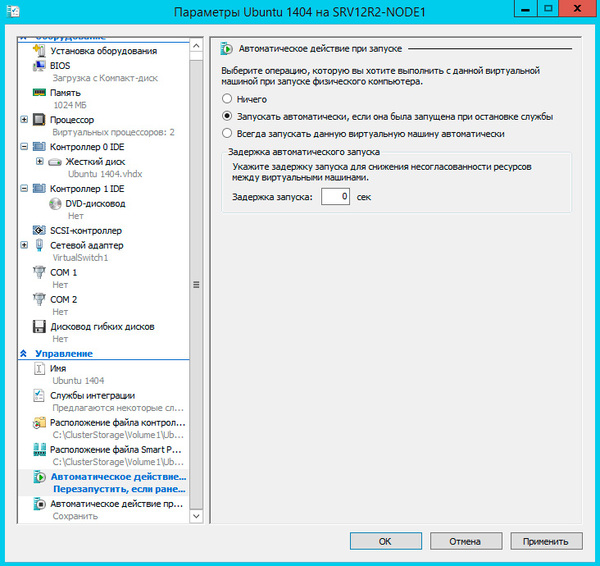

Шаг 11. Измените параметры виртуальной машины