В качестве примера используется Windows Server 2012 R2 (2016, 2019). Инструкция разбита на несколько шагов и представляет из себя полный цикл настройки файлового хранилища для использования в малых и средних компаниях.

Выбор оборудования и подготовка сервера

Установка Windows и настройка системы

Базовые настройки файлового сервера

Тюнинг файлового сервера или профессиональные советы

Настройка средств обслуживания

Тестирование

Шаг 1. Выбор оборудования и подготовка сервера

В качестве сервера, желательно, выбрать профессиональное оборудование. Системные требования для файлового сервера не высокие:

- Процессор может быть самый простой;

- Оперативная память также не сильно используется;

- Дисковая система — самый основной компонент. Ее объем зависит от специфики бизнеса. Примерная формула — не менее 15 Гб на пользователя и не менее 1 Тб на сервер. До 50 пользователей можно рассматривать диски SATA, после — SAS или SSD.

Например, для компании в 300 пользователей подойдет сервер с процессором Xeon E3, 8 Гб ОЗУ и 5 Тб дискового пространства на дисках SAS 10K.

Дополнительные требования

- Для обеспечения сохранности информации при выходе из строя жесткого диска, необходим RAID-контроллер. Настройка последнего выполняется из специального встроенного программного обеспечения, которое запускается при загрузке сервера;

- Сервер должен быть подключен к источнику бесперебойного питания;

- Необходимо предусмотреть резервное копирование. Для этого нужен дисковый накопитель (внешний жесткий диск) или другой сервер.

Подробнее о выборе оборудования читайте статью Как выбрать сервер.

Шаг 2. Установка Windows и настройка системы

Установка системы

На этом шаге все стандартно, за исключением одного нюанса: разбивая во время установки Windows жесткий диск, стараемся выделить небольшую часть (70 — 120 Гб) для системы и все остальное под данные. Если выделить много дискового пространства для системного раздела, увеличится время его обслуживания и фрагментация, что негативно скажется на производительности и надежности системы в целом.

Настройка системы

- Проверяем правильность настройки времени и часового пояса;

- Задаем понятное имя для сервера и, при необходимости, вводим его в домен;

- Если сервер не подключен напрямую к сети Интернет, стоит отключить брандмауэр;

- Для удаленного администрирования, включаем удаленный рабочий стол;

- Устанавливаем все обновления системы.

Шаг 3. Базовые настройки файлового сервера

Это стандартные действия, которые выполняются при настройке обычного файлового сервера.

Установка роли и вспомогательных компонентов

Как правило, данная роль устанавливается вместе с Windows. Остается только это проверить и доустановить компоненты, которые нужны для полноценной эксплуатации сервиса.

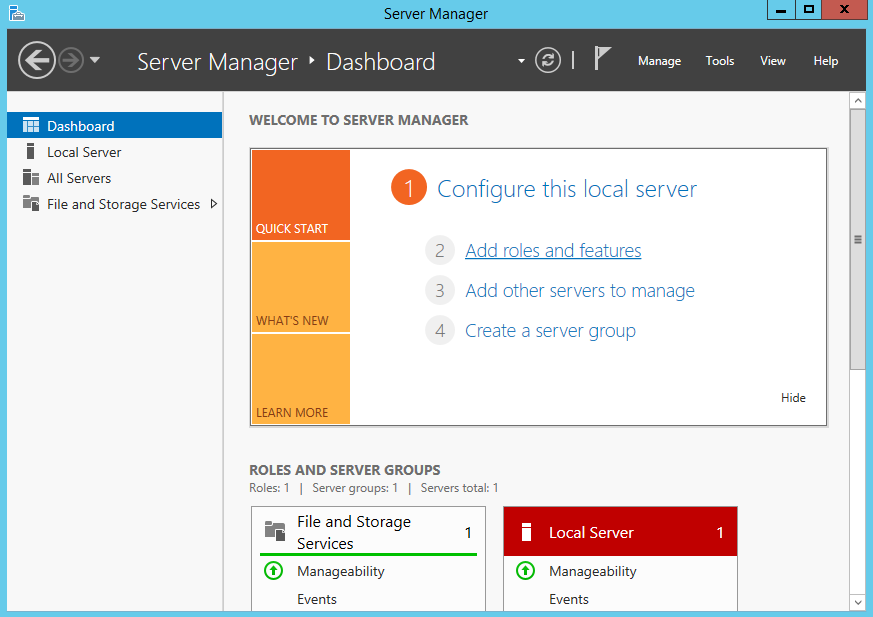

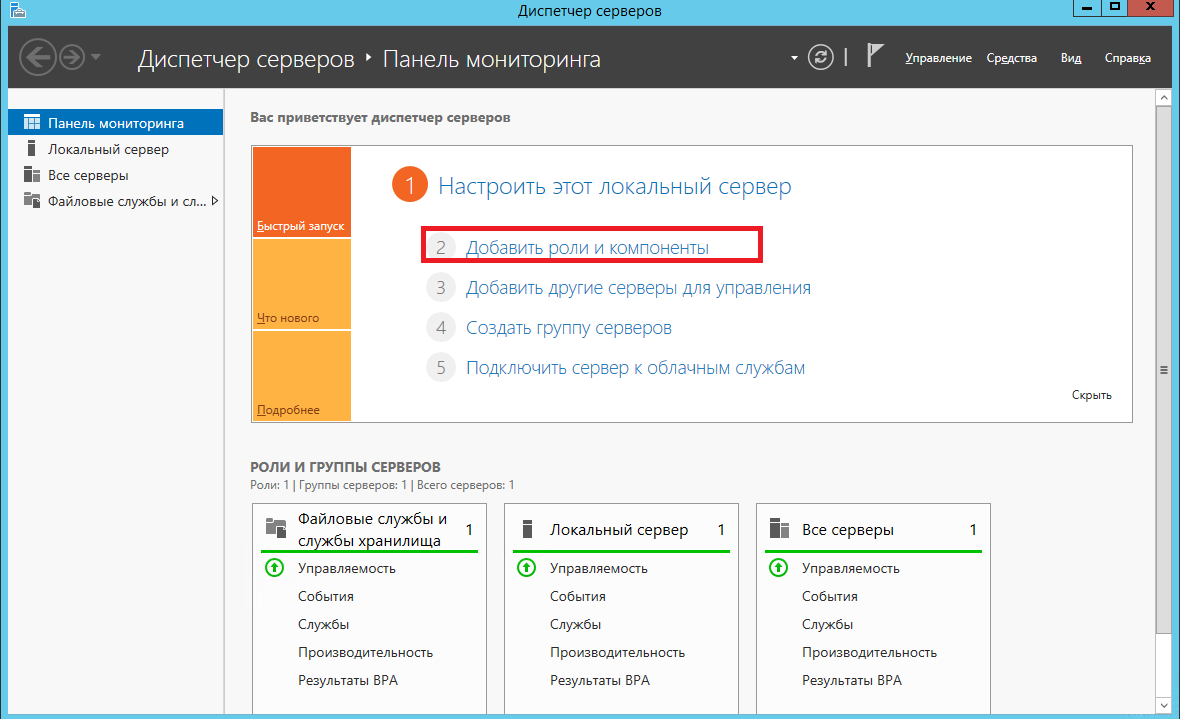

Открываем Диспетчер серверов. Он может быть запущен из панели быстрого запуска.

Нажимаем Управление — Добавить роли и компоненты.

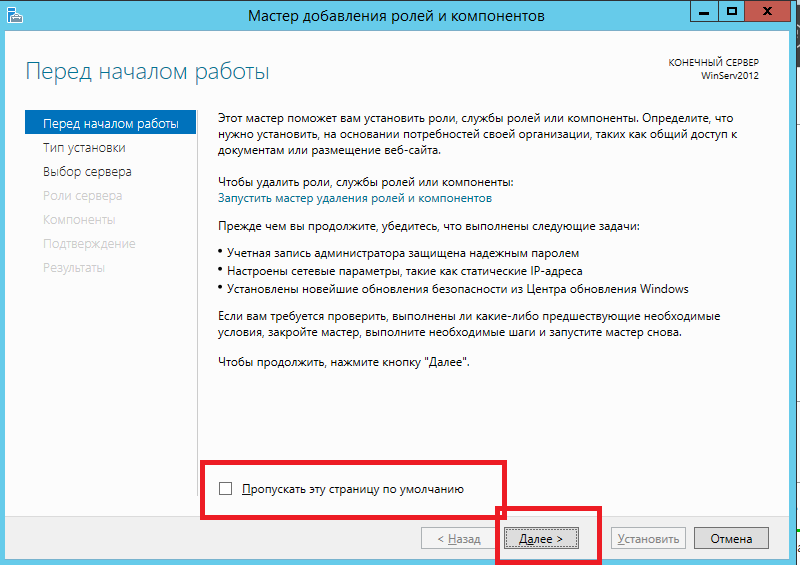

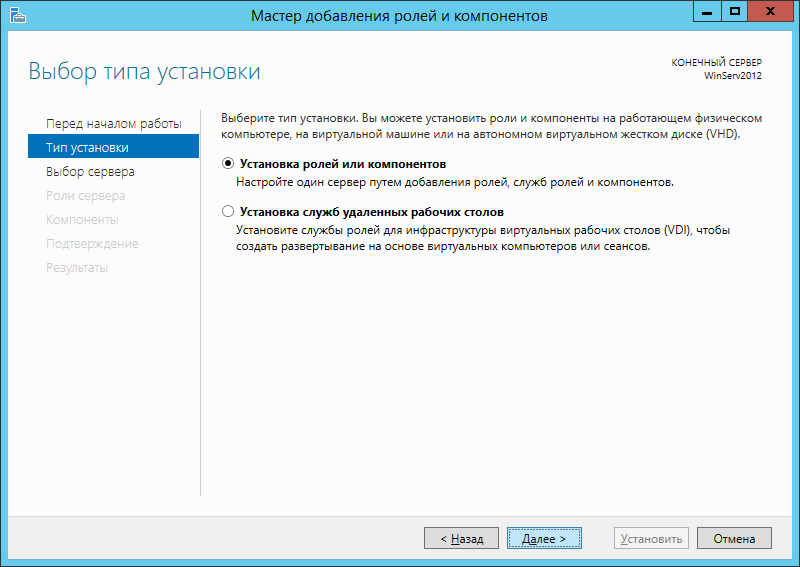

В открывшемся окне оставляем Установка ролей и компонентов и нажимаем Далее.

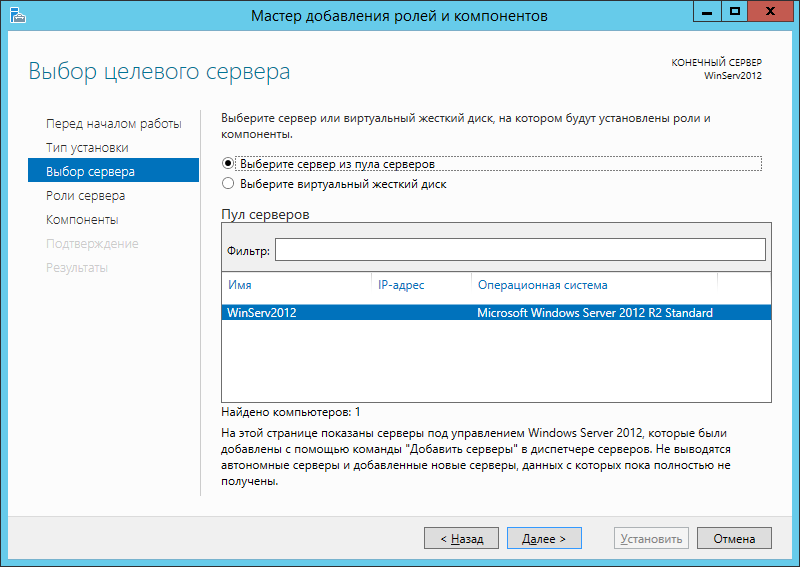

В следующем окне выбираем нужный сервер (выбран по умолчанию, если работаем на сервере, а не через удаленную консоль) и нажимаем Далее.

Среди ролей находим Файловые службы и службы хранилища, раскрываем ее и проверяем, что установлены галочки напротив следующих компонентов:

- Службы хранения;

- Файловый сервер;

Если данные службы не установлены, выбираем их и нажимаем Далее.

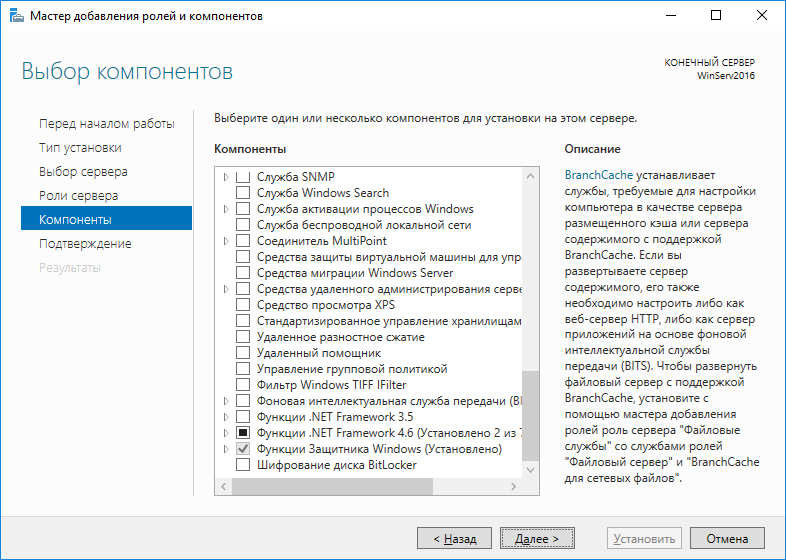

В окне Выбор компонентов просто нажимаем Далее.

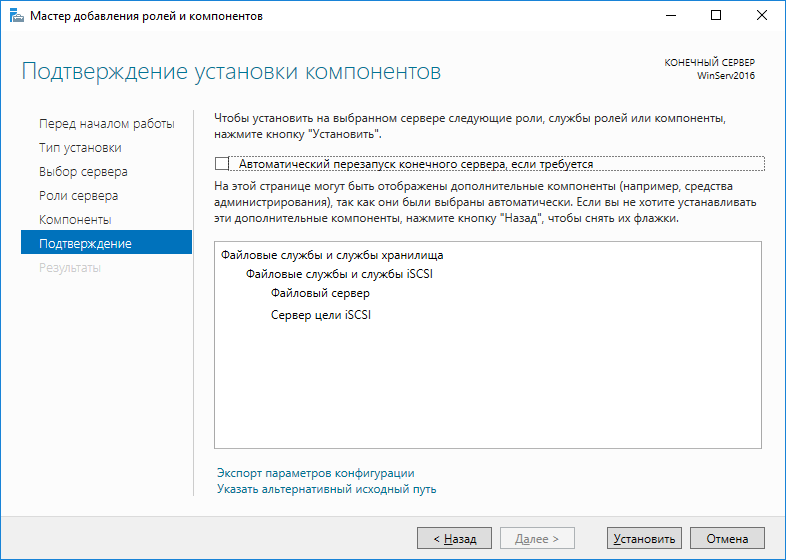

Откроется окно Подтверждение установки компонентов. Нажимаем Установить и после окончания процесса перезагружаем сервер.

Настройка шары (общей папки)

Создаем первую папку, которую хотим предоставить в общее использование. Затем кликаем по ней правой кнопкой мыши и нажимаем Свойства:

В открывшемся окне переходим на вкладку Доступ и нажимаем Расширенная настройка:

Ставим галочку Открыть общий доступ к этой папке и нажимаем кнопку Разрешения:

Предоставляем полный доступ всем пользователям:

* конечно же, мы не будем давать доступ всем пользователям, но для этого есть вкладка безопасность (см. ниже).

Нажимаем OK и еще раз OK.

Теперь переходим на вкладку Безопасность и нажимаем Дополнительно:

В открывшемся окне нажимаем Отключение наследования и Преобразовать унаследованные разрешения в явные разрешения этого объекта.

Нажимаем OK и Изменить.

Выставляем необходимые права на папку, например:

Совет: старайтесь управлять правами на ресурсы только при помощи групп. Даже если доступ необходимо предоставить только одному человеку!

Теперь нажимаем OK два раза. Папка настроена для общего использования и в нашем примере доступна по сетевому пути \fs1Общая папка.

Шаг 4. Тюнинг файлового сервера или профессиональные советы

Данные настройки, по сути, представляют секреты того, как сделать файловый сервер лучше, надежнее и безопаснее. Применяя их, администраторы создают более правильную и профессиональную среду ИТ.

DFS

С самого начала стоит создавать общие папки в пространстве имен DFS. На это есть две основные причины:

- При наличии или появлении нескольких файловых серверов пользователям будет удобнее находить общие папки в одном месте.

- Администратор легко сможет создать отказоустойчивую систему при необходимости.

Как создать и настроить DFS читайте в статьях Как установить и настроить DFS и Как установить и настроить DFS с помощью Powershell.

Теневые копии

Позволят вернуться к предыдущим версиям файлов. Это очень полезная функция позволит не только восстановить некорректно отредактированный документ, но и вернуть случайно удаленный файл или папку.

Как настроить и пользоваться данной возможностью, читайте подробнее в инструкции Как включить и настроить теневые копии.

Аудит

Аудит позволит вести протокол доступа к данным — понять, кто и когда удалил важные данные или внес в них изменения.

О том, как настроить данную возможность читайте статью Как включить аудит доступа к файлам Windows.

Анализатор соответствия рекомендациям

В диспетчер управления серверами Windows встроен инструмент для проверки конфигурации сервера — анализатор соответствия рекомендациям. Чтобы им воспользоваться переходим в диспетчере в Локальный сервер:

Находим раздел «Анализатор соответствия рекомендациям» и справа кликаем по ЗАДАЧИ — Начать проверку BPA:

Рассмотрим решения некоторых рекомендаций.

1. Для XXX должно быть задано рекомендованное значение.

Это набор однотипных рекомендаций, для выполнения которых нужно обратить внимание на описание и задать значение параметро, которое в нем указано. Например, для CachedOpenLimit в описании проблемы есть описание решения — «Задайте для CachedOpenLimit рекомендуемое значение 5». Чтобы это сделать, открываем Powershell от администратора и вводим команду:

Set-SmbServerConfiguration -CachedOpenLimit 5

* мы задаем параметру CachedOpenLimit значение 5, как это и рекомендовано анализатором.

На запрос, уверены ли мы, что хотим выполнить команду, отвечаем утвердительно.

Остальные параметры задаем аналогичными действиями.

2. Файл Srv.sys должен быть настроен на запуск по требованию.

В командной строке от имени администратора вводим:

sc config srv start= demand

3. Создание коротких имен файлов должно быть отключено.

В командной строке от имени администратора вводим:

fsutil 8dot3name set 1

Шаг 5. Настройка средств обслуживания

Ни одна инфраструктура не может полноценно существовать без мониторинга и резервного копирования. Предупредить о возможной проблеме, узнать о последней раньше пользователей или иметь возможность восстановить данные — показатели высокой ответственности и профессионализма системного администратора.

Резервное копирование

Для файлового сервера все просто — необходимо резервировать все рабочие папки и файлы. Лучшим решением будет ежедневное копирование новых данных, и с определенной периодичностью (например, раз в месяц), создавать полный архив.

Мониторинг

Мониторить стоит:

- Сетевую доступность сервера;

- Свободное дисковое пространство;

- Состояние жестких дисков.

Шаг 6. Тестирование

Тестирование состоит из 3-х основных действий:

- Проверить журналы Windows и убедиться в отсутствие ошибок. В случае их обнаружения, необходимо устранить все проблемы.

- Выполнить действия анализатора соответствий рекомендациям.

- Провести живой тест работы сервиса с компьютера пользователя.

Продолжая тему создания систем высокой доступности, в данном материале мы рассмотрим настройку iSCSI-хранилищ в современной версии серверных ОС от Microsoft. Мы не будем повторяться и снова обсуждать общие вопросы, поэтому, если вы только начинаете работать с iSCSI, то настоятельно рекомендуем ознакомиться с вступительной частью к нашему предыдущему материалу.

Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном курсе по администрированию MikroTik. Автор курса, сертифицированный тренер MikroTik Дмитрий Скоромнов, лично проверяет лабораторные работы и контролирует прогресс каждого своего студента. В три раза больше информации, чем в вендорской программе MTCNA, более 20 часов практики и доступ навсегда.

Широкое распространение виртуализации и потребности в создании отказоустойчивых систем даже при небольших внедрениях заставили компанию Microsoft пересмотреть свое отношение к доступным из коробки ролям Windows Server и политике лицензирования. Если раньше iSCSI Target предлагался только в редакции Windows Storage Server, то начиная с Server 2008 R2 он стал доступен в виде отдельно устанавливаемого компонента, а с выходом Windows Server 2012 закономерно стал частью ОС.

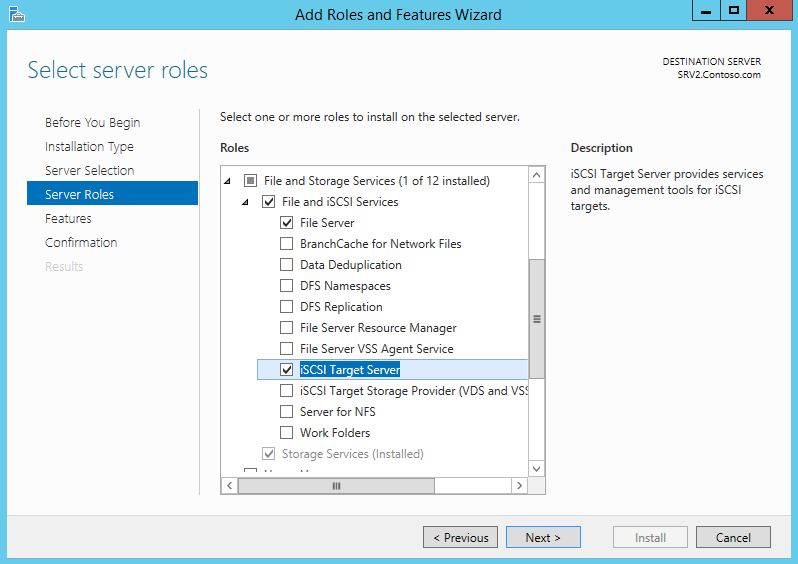

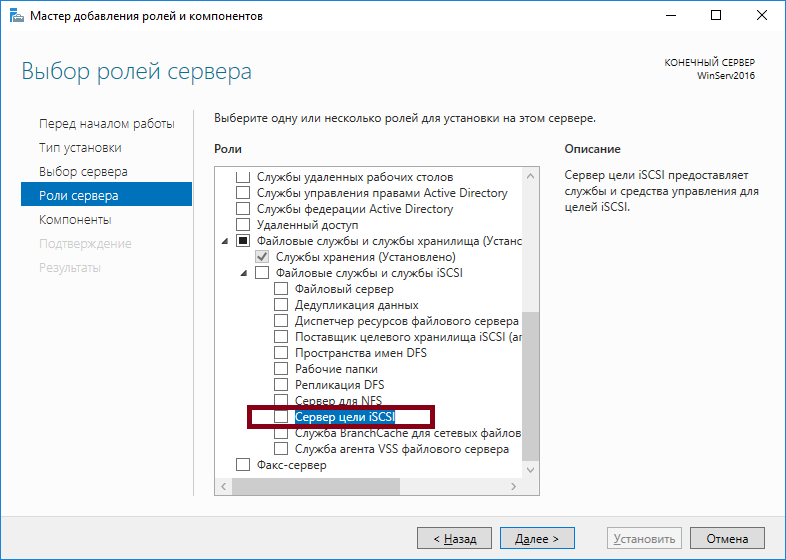

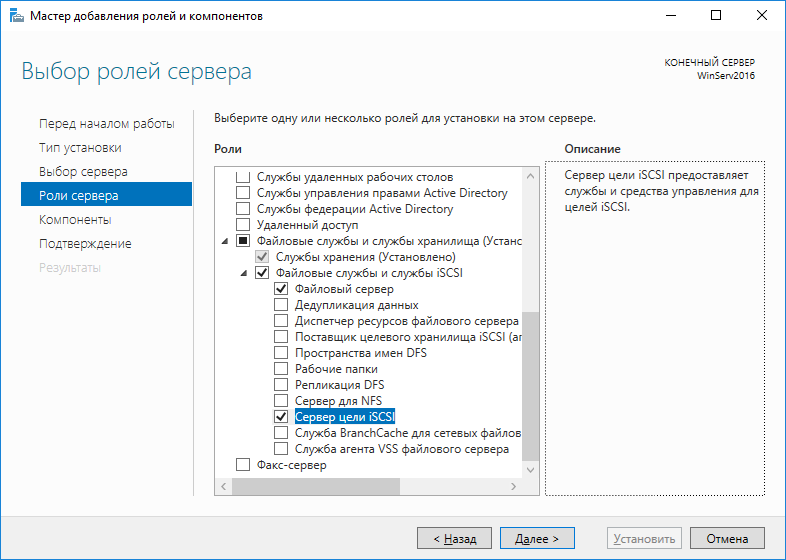

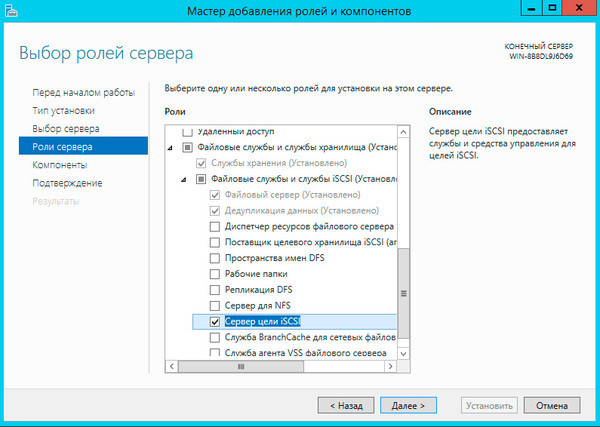

Для установки роли Cервера цели iSCSI запустите Мастер добавления ролей и компонентов, затем последовательно разверните пункты Файловые службы и службы хранилища — Файловый службы и службы iSCSI и укажите одноименную роль.

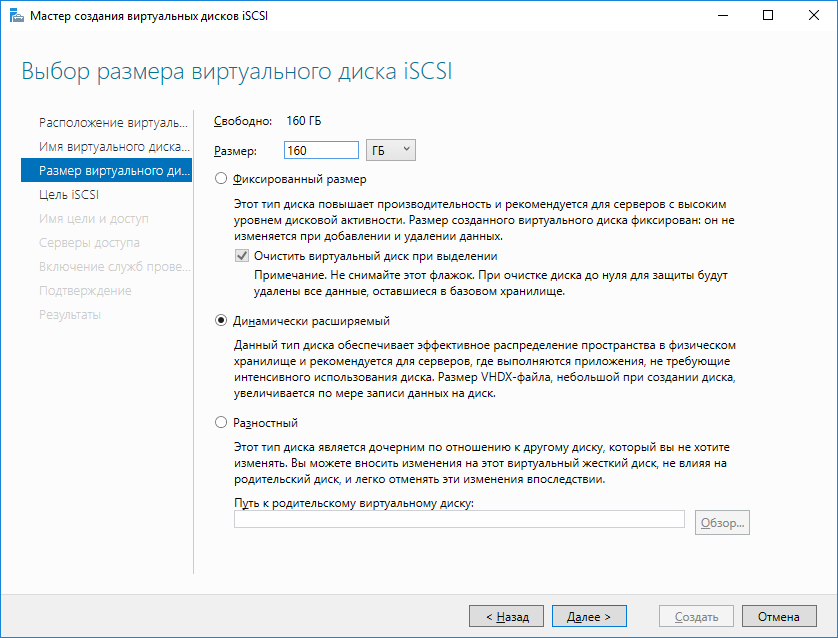

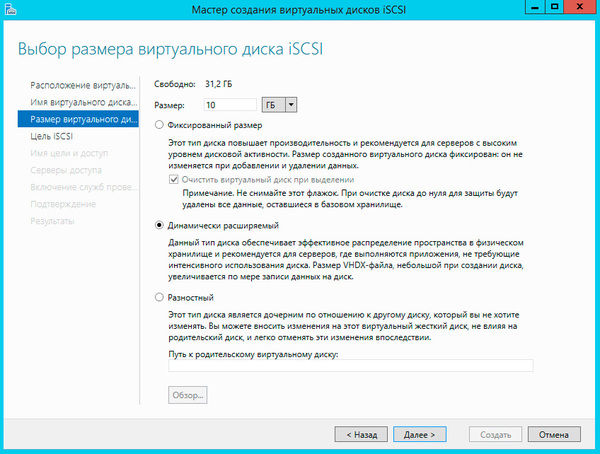

Следующим шагом укажите имя и размер создаваемого диска. Windows Server 2012 поддерживает новый формат виртуальных дисков — VHDX, а также динамически расширяемые диски. Если доступные ранее диски фиксированного размера резервировали дисковое пространство хранилища сразу при создании, то динамически расширяемые диски увеличивают размер согласно реально записанным в них данным. Это позволяет существенно экономить дисковое пространство хранилища, нарезая виртуальные диски с запасом.

Не рекомендуется данный тип дисков для систем с высокой дисковой активностью, так как за счет возможной фрагментации и операций по приращению размера диска производительность будет ниже, чем у дисков фиксированного размера. В тоже время динамически расширяемые диски неплохо подходят для файловых хранилищ, резервного копирования и т.п. задачам, где в первую очередь требуется хранение данных, а не скорость доступа к ним.

Еще один поддерживаемый тип дисков — разностный, когда все изменения пишутся не на исходный виртуальный диск, а на вновь созданный, к использованию в производственных средах не рекомендуется ввиду существенно более низкой производительности, но может оказаться полезным при отладке и разного рода экспериментах, когда надо иметь возможность быстро откатиться к исходному состоянию.

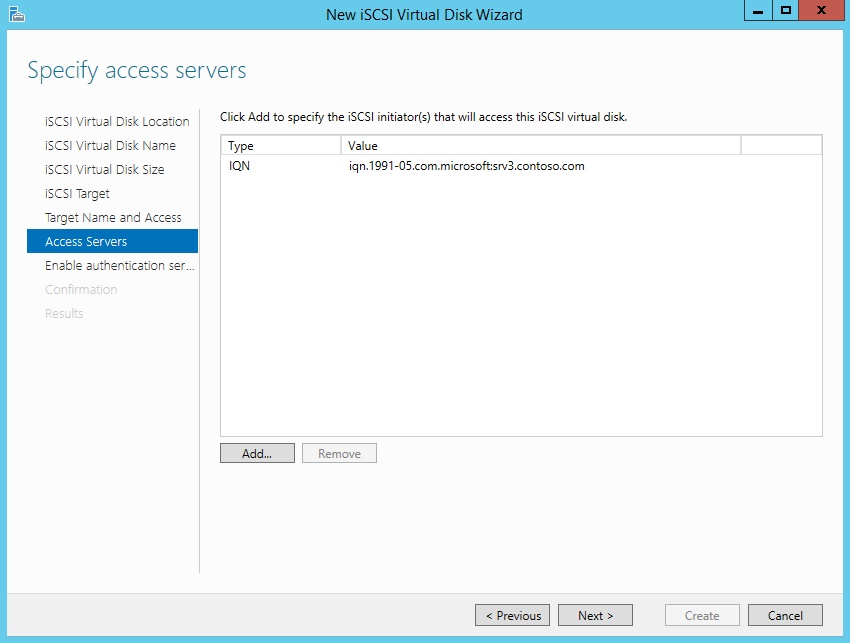

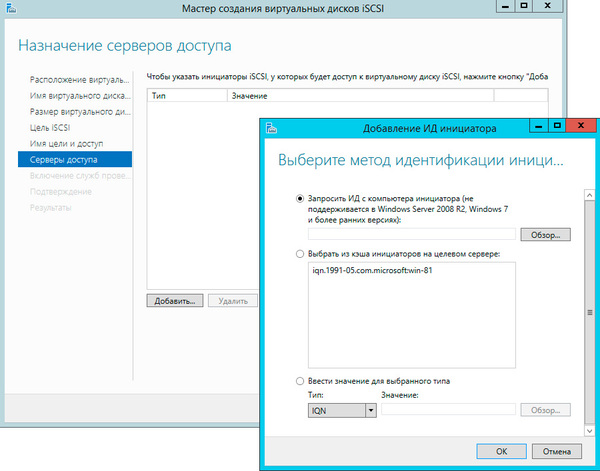

Вернемся на сервер и нажав кнопку Добавить выберем IQN инициатора из кэша, для современных систем вы также можете получить IQN инициатора выполнив подключение к нему по IP-адресу или имени хоста:

Если вам потребуется изменить параметры подключения уже подключенного объекта, то его следует отключить и подключить заново. После выполнения всех этих действий подключенное устройство будет обнаружено системой как еще один локальный диск и последующая работа с ним ничем не отличается от работы с обычным жестким диском.

Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном курсе по администрированию MikroTik. Автор курса, сертифицированный тренер MikroTik Дмитрий Скоромнов, лично проверяет лабораторные работы и контролирует прогресс каждого своего студента. В три раза больше информации, чем в вендорской программе MTCNA, более 20 часов практики и доступ навсегда.

Internet Small Computer System Interface (iSCSI) — это протокол передачи данных, предназначенный для обмена данными между серверами и системами хранения данных (Storage Area Network, SAN). iSCSI представляет из себя комбинацию протокола SCSI и стека протоколов TCP/IP и предназначен для передачи блоков данных через сети Ethernet. Управляющие команды SCSI передаются внутри IP-пакетов, а протокол TCP обеспечивает управление потоком и надежность передачи данных.

При использовании iSCSI данные между сервером и системой хранения передаются блоками, в необработанном виде. Это позволяет использовать SAN практически так же, как если бы они были подключены к серверу напрямую, а не по сети. Хост-система может создавать на SAN логические разделы, форматировать их и использовать как обычные локальные жесткие диски. В этом заключается основное отличие SAN от сетевых хранилищ (Network Area Storage, NAS), которые работают на уровне файловой системы и используют протоколы передачи файлов, такие как SMB или CIFS.

Технология iSCSI была разработана как более дешевая альтернатива Fibre Channel (FC). Системы на базе iSCSI поддерживают стандартные протоколы и могут быть построены на базе любой существующей сетевой инфраструктуры, поддерживающей протокол IP. Для работы iSCSI может использовать самые обычные сетевые устройства (коммутаторы, маршрутизаторы, сетевые адаптеры и т.п), тогда как для FC требуются специальные HBA-адаптеры, оптические кабеля и прочее дорогостоящее оборудование.

Архитектура iSCSI является клиент-серверной и включает в себя следующие компоненты:

iSCSI Initiator — клиентский компонент, который отправляет запросы на подключение компоненту iSCSI Target, находящемуся на стороне сервера. Инициатор может быть реализован программно, в виде драйвера, либо аппаратно, в виде специального iSCSI адаптера.

iSCSI Target — серверный компонент, слушающий клиентские запросы и обеспечивающий установку соединения между клиентом и сервером iSCSI. Кроме того, таргет связан с виртуальными дисками iSCSI, и после установки соединения все виртуальные диски, связанные с этим таргетом, становятся доступны через инициатор. В качестве iSCSI Target может выступать как специализированная СХД, так и обычный Windows сервер с установленной ролью iSCSI Target.

Виртуальные диски iSCSI — используются для разбиения дискового пространства на логические разделы (Logical Unit Number, LUN). В Windows Server 2012 iSCSI LUN представляют из себя обычные виртуальные диски формата VHDVHDX. Кстати, в Windows Server 2012 для iSCSI поддерживался только формат VHD, что ставило ограничение в 2ТБ на максимальный размер LUN. В Windows Server 2012 R2 используется формат VHDX, что позволяет создавать LUN-ы размером до 64ТБ.

А теперь остановимся и уточним некоторые моменты:

• На каждом iSCSI сервере может быть один или несколько iSCSI Target;

• Каждый iSCSI Target может быть подключен к одному или нескольким виртуальным дискам;

• Каждый iSCSI Target может обслуживать одно или несколько подключений от iSCSI Initiator;

• В свою очередь, каждый iSCSI Initiator может подключаться к одному или нескольким iSCSI Target и, следовательно, к одному или нескольким виртуальным дискам.

Кроме того, в Windows Server 2012 поддерживается loopback-конфигурация, в которой и Target и Initiator могут находиться на одном и том же сервере.

В операционных системах Microsoft поддержка iSCSI появилась довольно давно. Первая версия Microsoft iSCSI Initiator устанавливалась в качестве отдельного компонента в Windows 2000, Windows XP SP2 и Windows Server 2003 SP1, а начиная с Windows Server 2008 и Vista iSCSI Initiator был встроен в операционную систему.

Что касается iSCSI Target, то изначально он входил в специальную версию серверной ОС Windows Data Storage Server 2003, которая была предназначена для построения систем хранения и поставлялась только в предустановленом виде. Однако с 2011 года компонент Microsoft iSCSI Software Target 3.3 стал доступен для загрузки и установки на Windows Server 2008R2, а в Windows Server 2012 он полностью интегрирован в систему и устанавливается в качестве роли сервера.

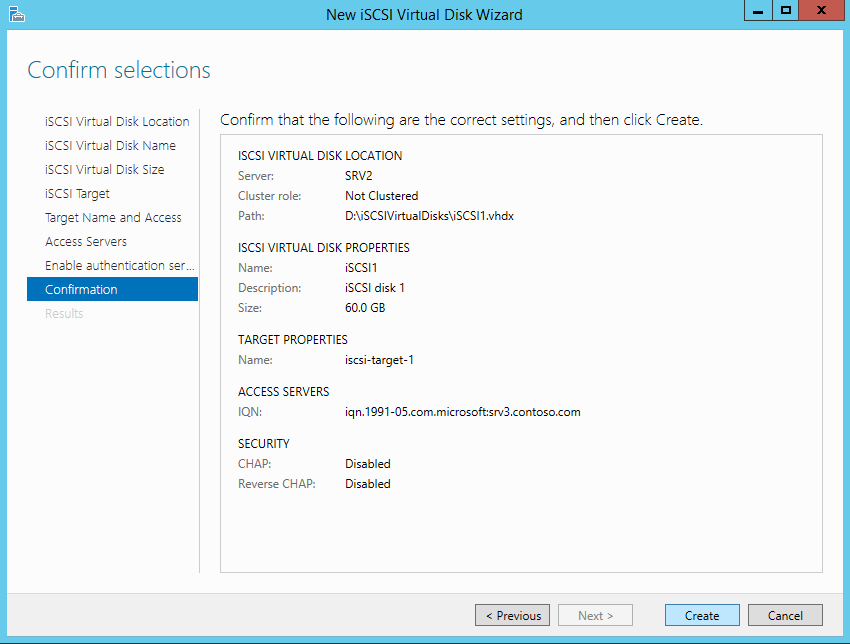

На этом закончим теоретическую часть и приступим к практике. Для настройки возьмем самый простой вариант, в качестве подопытных используем два сервера с установленной Windows Server 2012 R2: SRV2 для роли iSCSI Target и SRV3 для iSCSI Initiator.

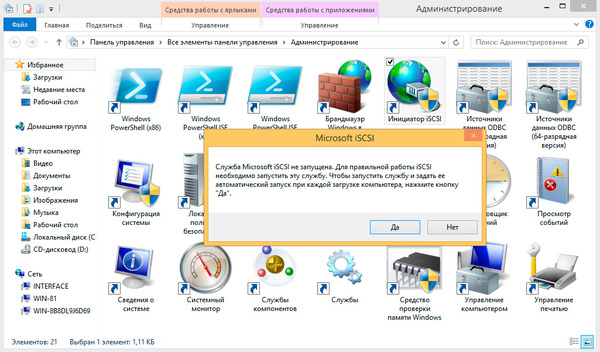

Запуск службы iSCSI Initiator

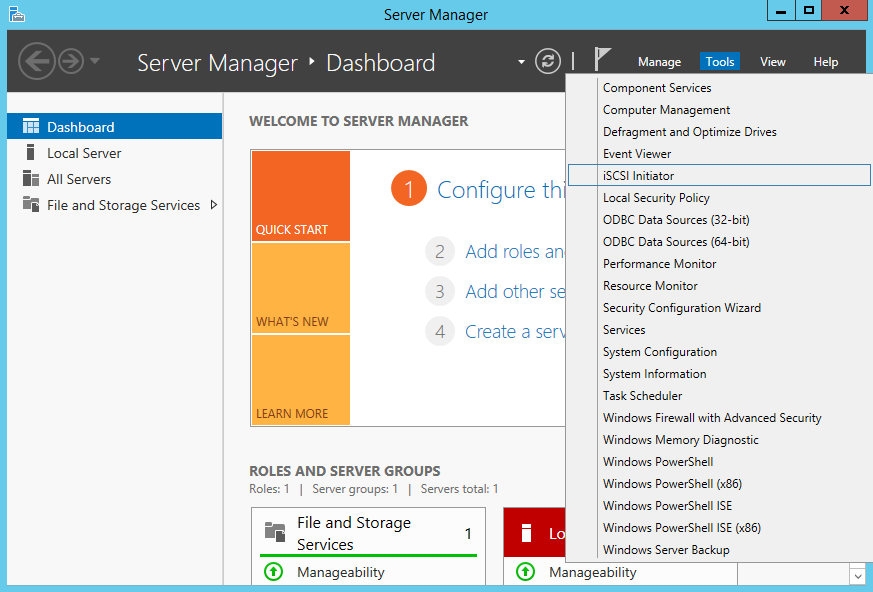

Для начала проверим состояние службы инициатора на SRV3. Для этого открываем Server Manager и в меню «Tools» выбираем пункт «iSCSI Initiator».

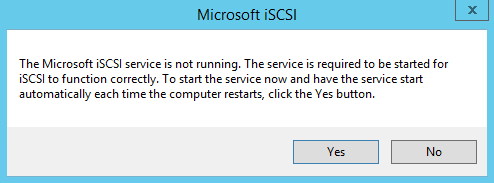

Как видите, по умолчанию служба не запущена. Нажав на «Yes» в диалоговом окне, мы стартуем службу iSCSI Initiator и поставим ее в режим автоматического запуска.

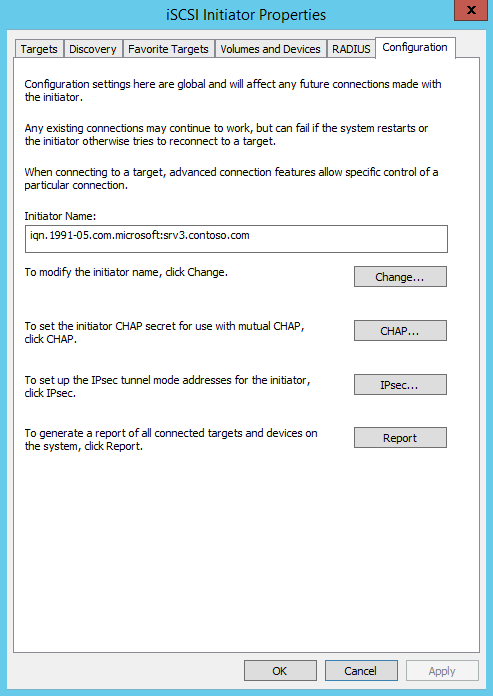

Затем в окне свойств переходим на вкладку «Configuration» и запоминаем значение IQN, оно пригодится нам при настройке сервера.

IQN (iSCSI qualified name) — это уникальный идентификатор, назначаемый для каждого iSCSI Target и Initiator. IQN формируется из даты (месяц и год) регистрации домена, официального имени домена, написанного в обратном порядке и любого произвольного имени, например имени сервера. Получается примерно так: iqn:1991-05.com.microsoft:srv3.contoso.com

Стартовать сервис iSCSI Initiator и установить режим его запуска можно и из консоли PowerShell, следующими командами:

Start-Service msiscsi

Set-Service msiscsi -StartupType automatic

Установка роли iSCSI Target Server

Теперь перейдем на SRV2 и приступим к настройке серверной части. Первое, что нам надо сделать — это установить на сервер роль iSCSI Target. Открываем Server Manager, переходим по ссылке «Add roles and features»

И выбираем роль «iSCSI Target Server», которая находится в разделе File and Storage ServicesFile and iSCSI Services.

Либо воспользуемся командой PowerShell:

Install-WindowsFeature -Name FS-iSCSITarget-Server

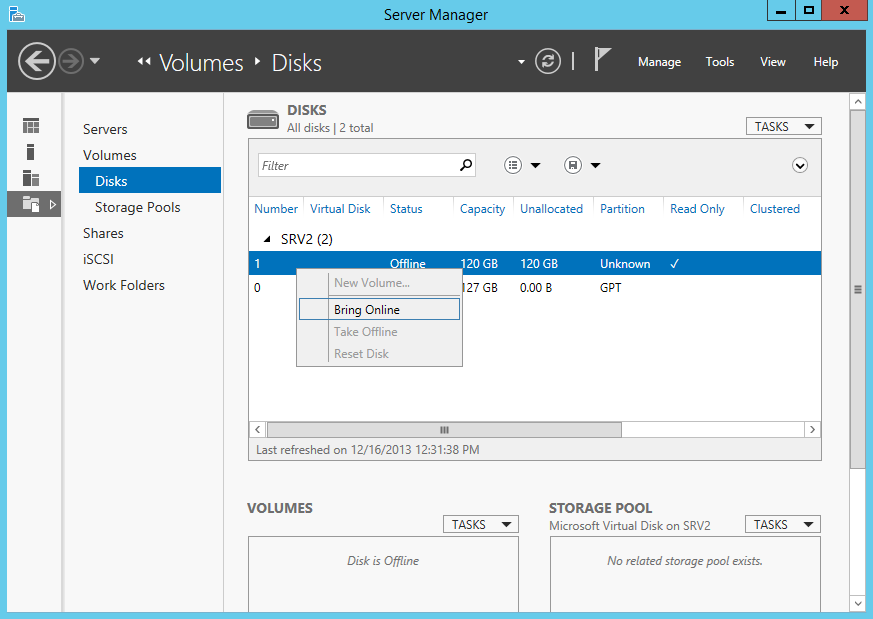

Подготовка диска

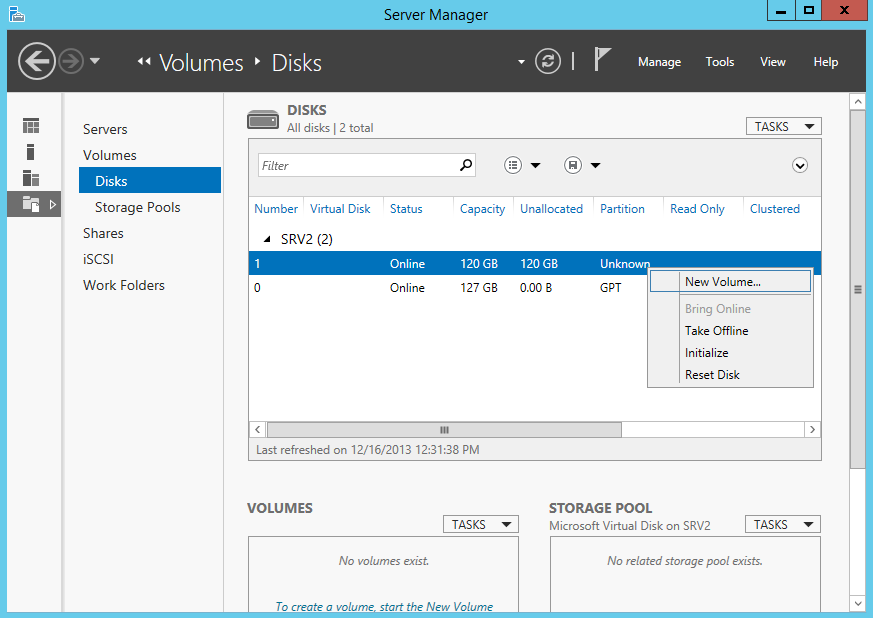

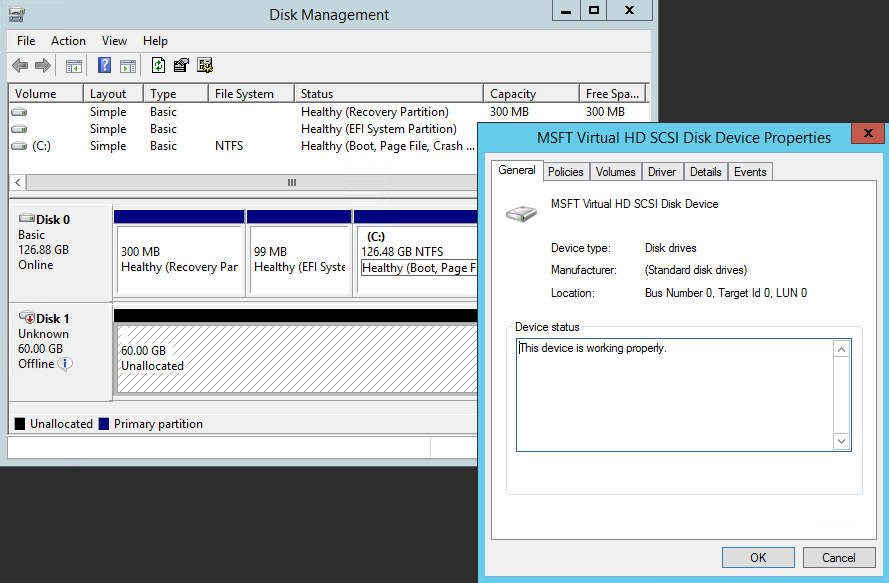

Теперь подготовим физический диск, который будет использоваться для хранения виртуальных iSCSI дисков. Специально для этой цели к серверу подключен новый жесткий диск размером 120Гб. На данный момент диск неактивен (Offline). Для его активации в Server Manager переходим в раздел File and Storage Services -> Disks, кликаем на диске и переводим его в Online.

Теперь на этом диске надо создать новый раздел (или том), для чего в контекстном меню выбираем пункт New Volume.

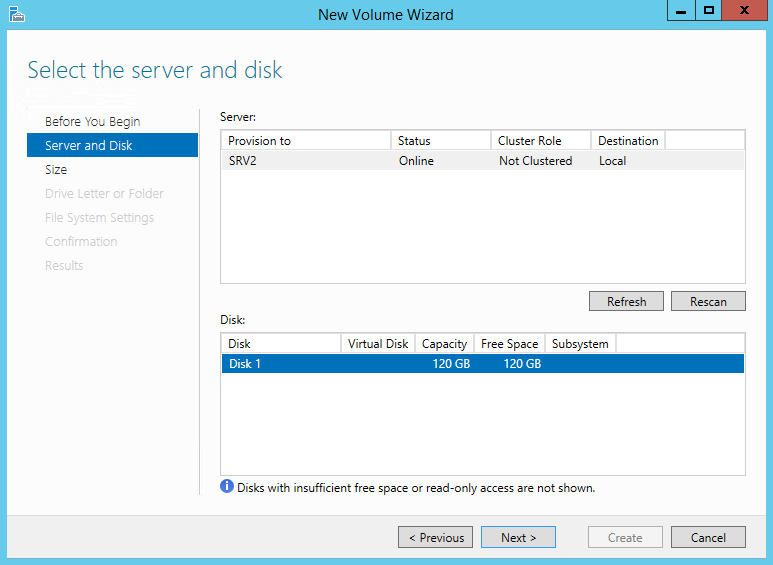

Выбираем физический диск, на котором будет создаваться том

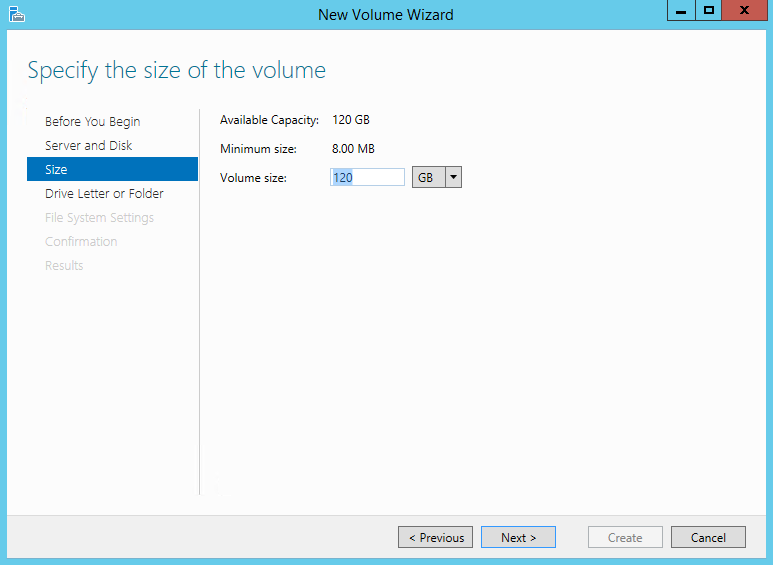

указываем размер тома

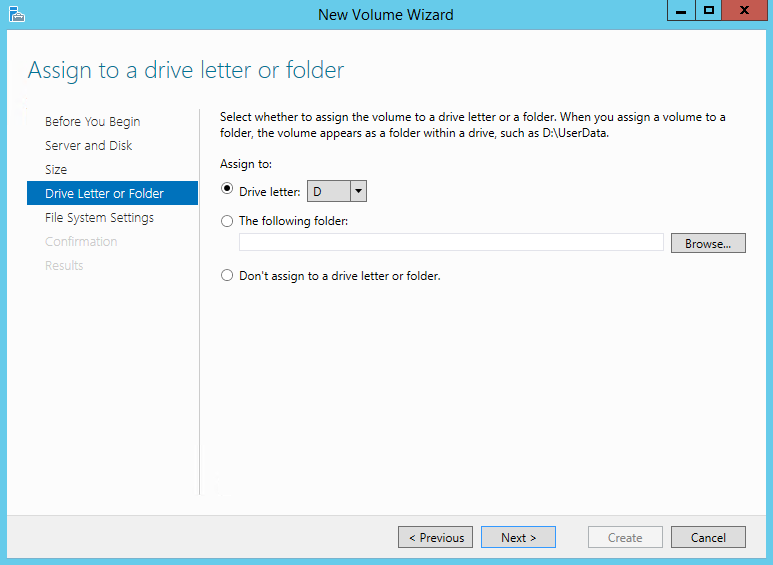

и выбираем букву диска.

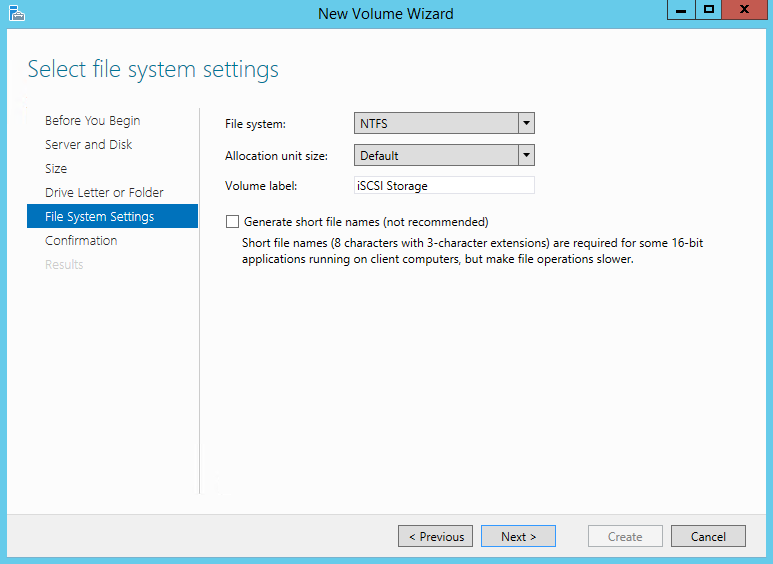

Затем выбираем для диска файловую систему, размер сектора и указываем метку тома. Здесь напомню, что виртуальные диски iSCSI можно создавать только на томах NTFS, новая файловая система ReFS (Resilient File System) не поддерживается.

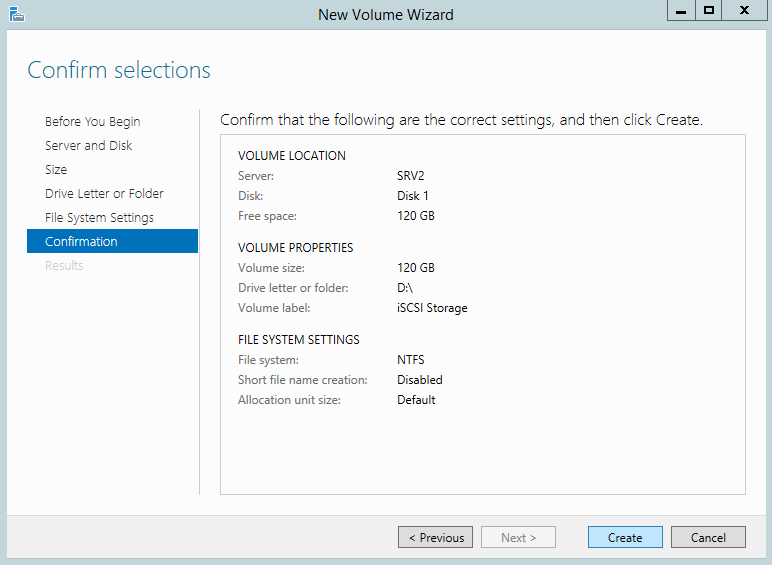

Смотрим суммарную информацию, и если все правильно, то жмем «Create», запуская создание тома.

Те же действия можно проделать с помощью PowerShell. Находим нужный диск:

Get-Disk | where {$_.OperationalStatus -eq ″Offline″}

Переводим его в online:

Set-Disk -Number 1 -IsOffline $false

Инициализируем:

Initialize-Disk -Number 1

Создаем раздел:

New-Partition -DiskNumber 1 -UseMaximumSize -DriveLetter D

И форматируем его в NTFS:

Format-Volume -DriveLetter D -FileSystem NTFS -NewFileSystemLabel ″iSCSI Storage″

Создание виртуальных дисков iSCSI

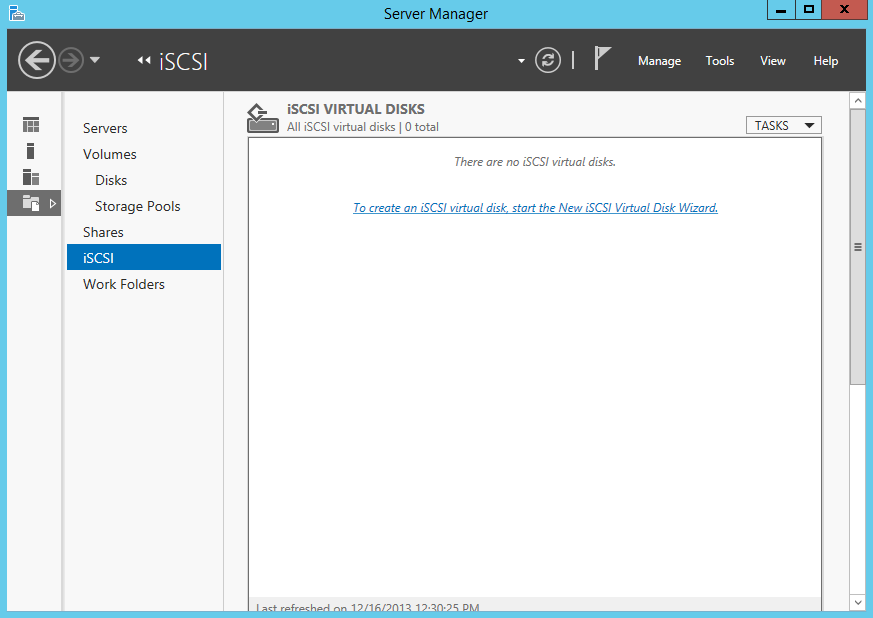

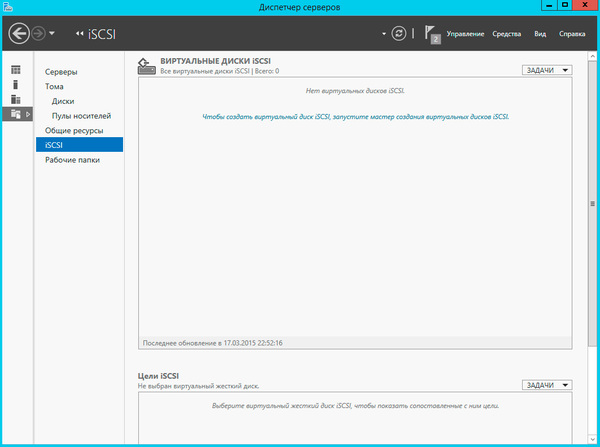

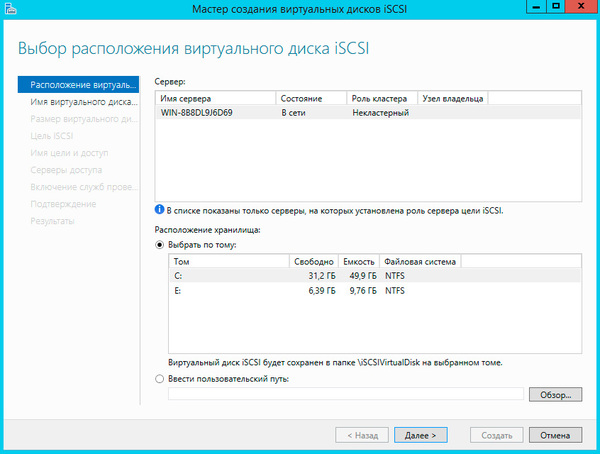

Следующим пунктом нашей программы идет создание виртуальных iSCSI дисков. Для этого переходим в раздел iSCSI и кликаем по ссылке, запуская очередной мастер.

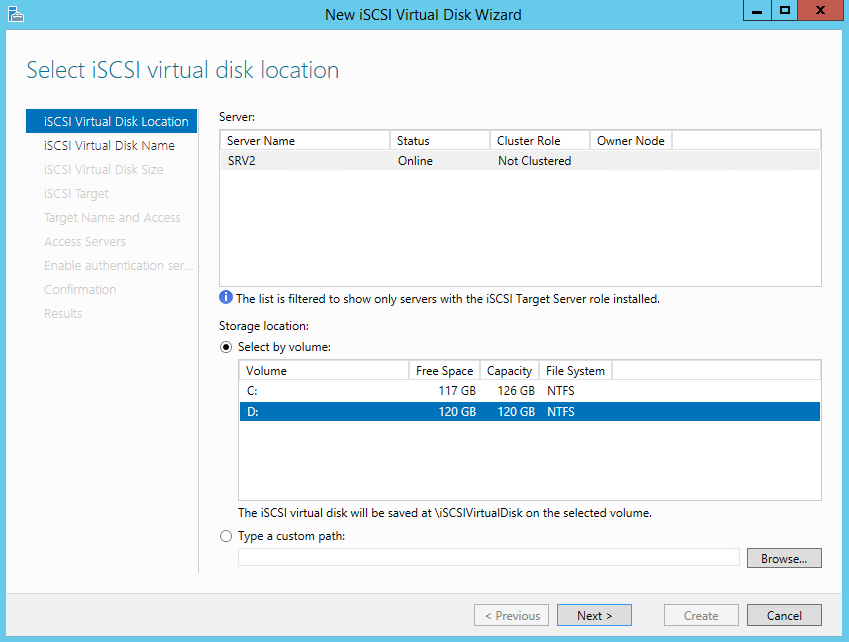

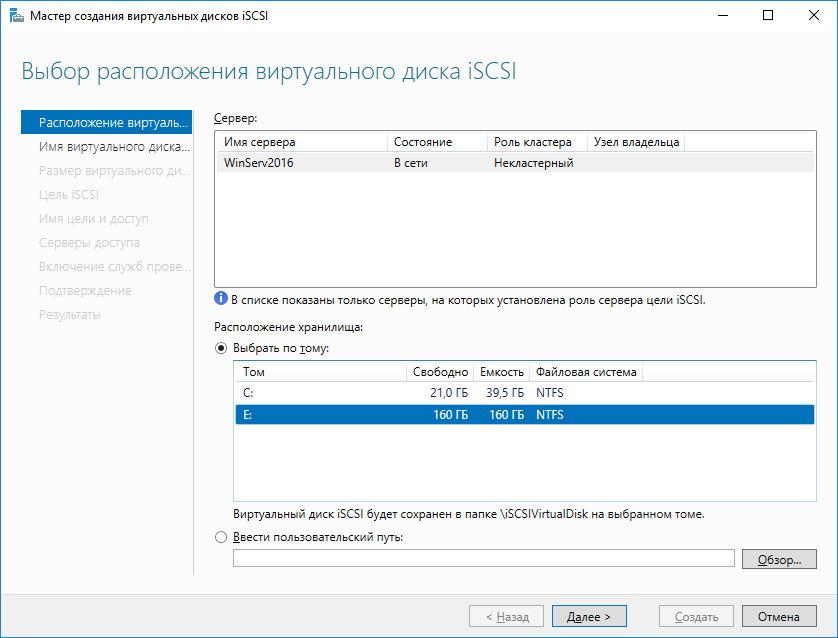

Выбираем том, на котором будет храниться виртуальный диск.

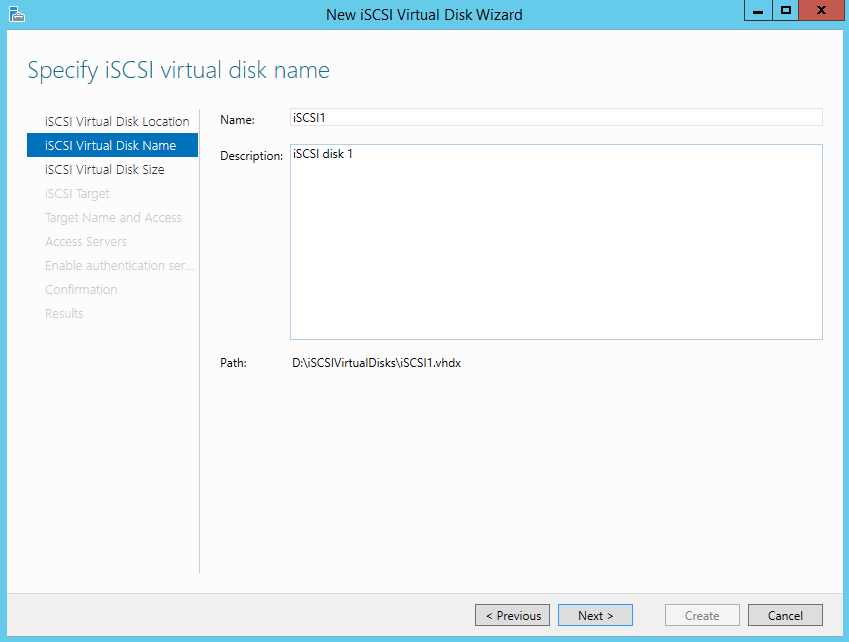

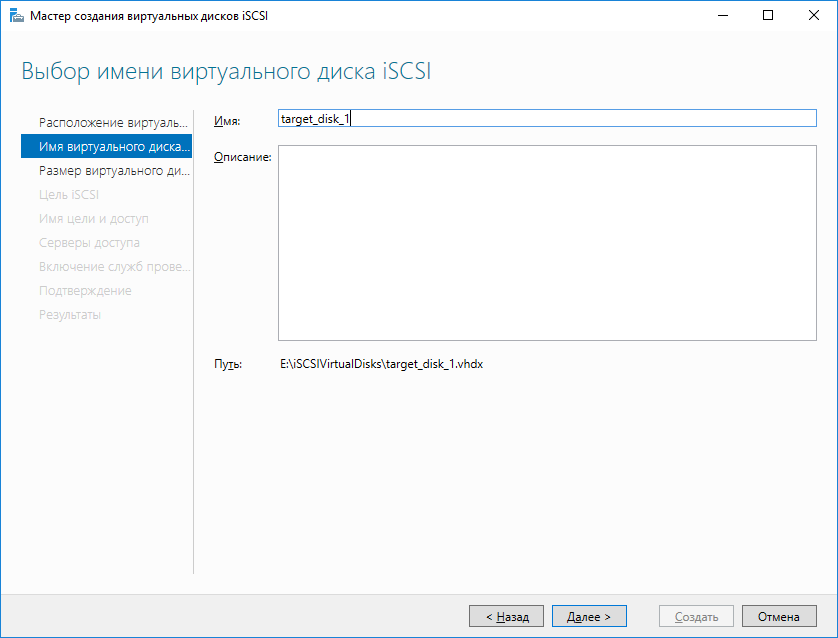

Даем диску имя и описание.

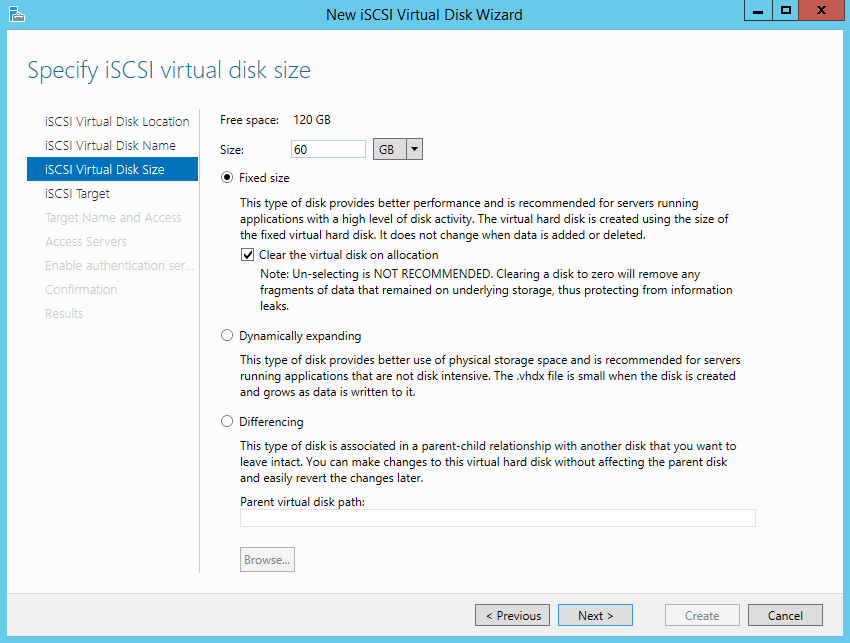

Указываем размер виртуального диска и его тип. Выбирать можно из трех вариантов:

• Fixed size (фиксированного размера) — создаваемый диск сразу занимает весь выделенный объем. Это наиболее производительный, но наименее экономичный вариант;

• Dynamically expanding (динамически расширяемый) — изначально создается диск минимального размера, который затем динамически изменяется в зависимости от количества записанных на него данных. Наилучший вариант в плане использования дискового пространства;

• Differencing (разностный) — в этом варианте нужно указать расположение родительского диска, с которым будет связан создаваемый диск. Разностный диск может быть как фиксированным, так и динамическим, в зависимости от типа родителя. У этого типа дисков есть свои преимущества, но использовать их для iSCSI лично я особого смысла не вижу.

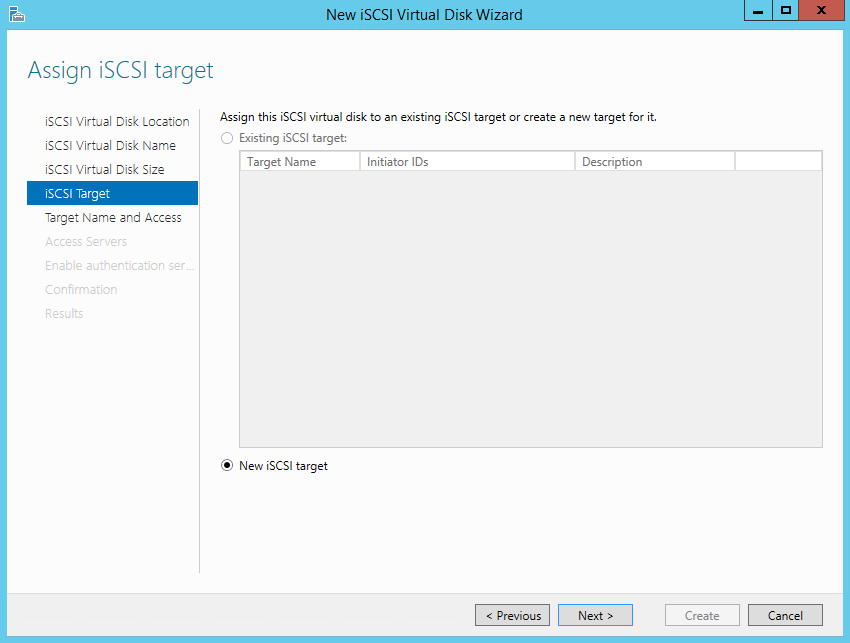

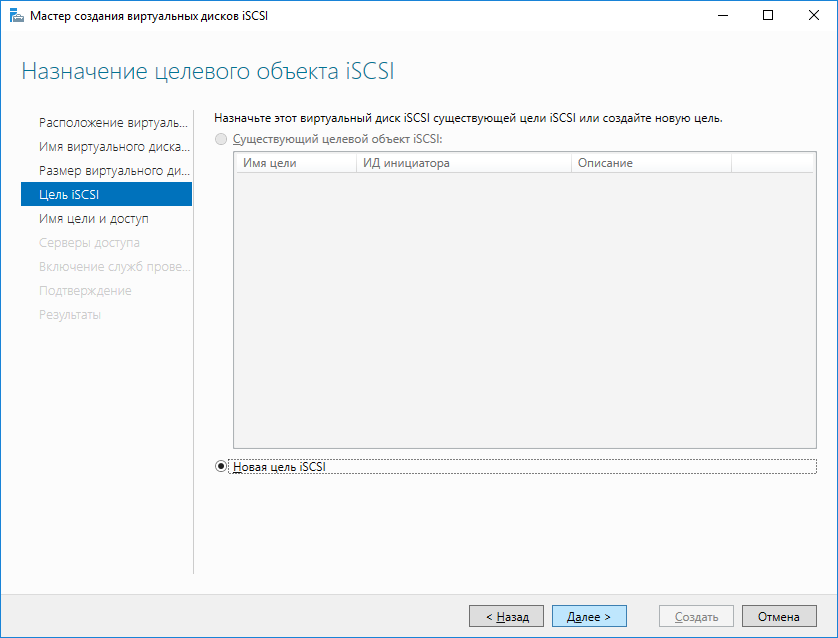

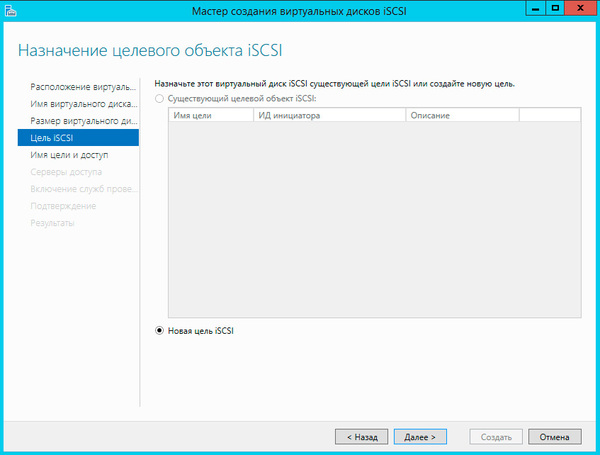

Теперь нужно указать iSCSI Target, к которому будет подключен данный диск. Поскольку на сервере не создано ни одного таргета, выбираем «New iSCSI target».

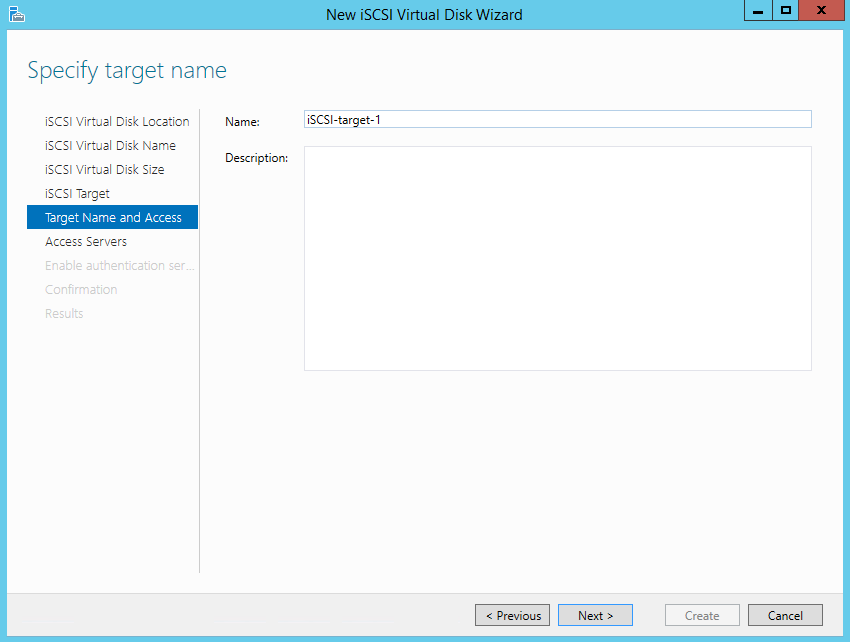

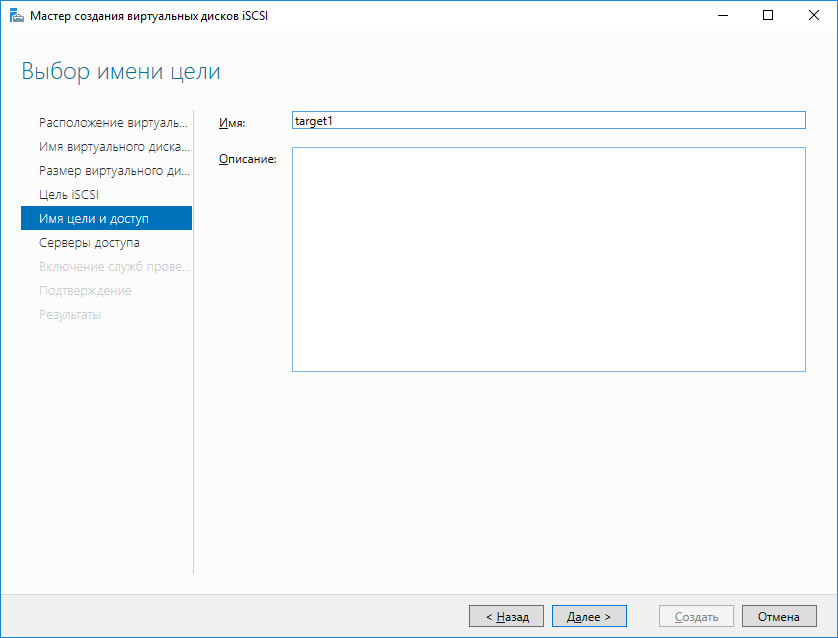

Даем таргету имя и описание.

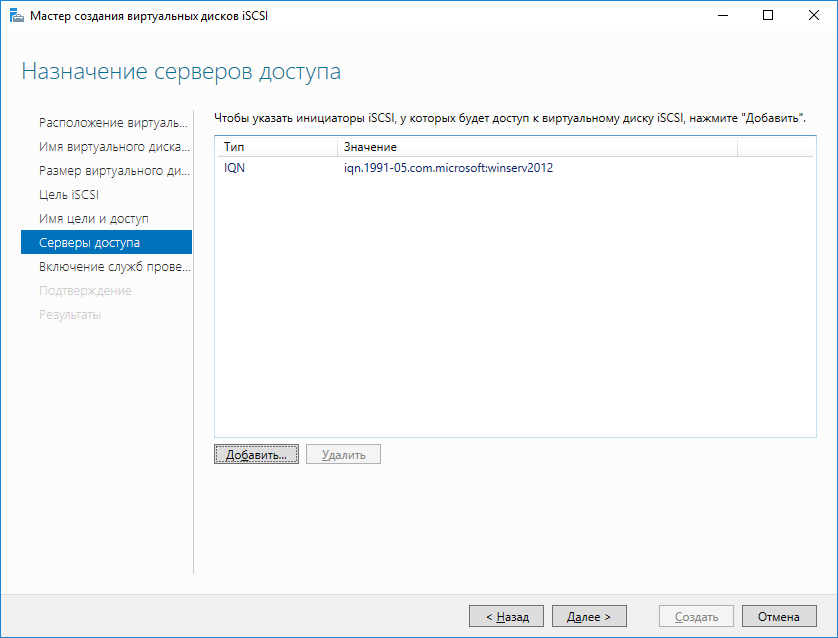

И указываем сервера, которые могут получить к нему доступ.

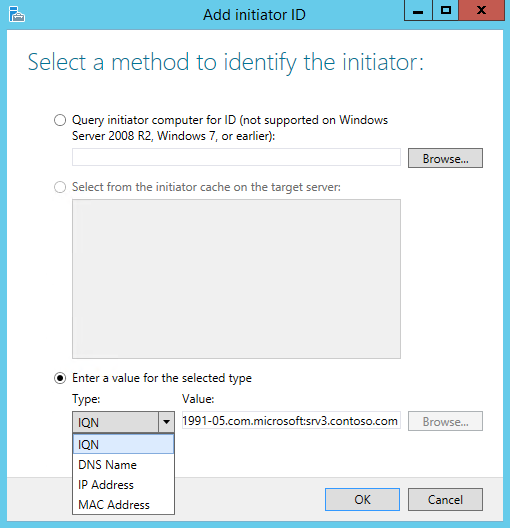

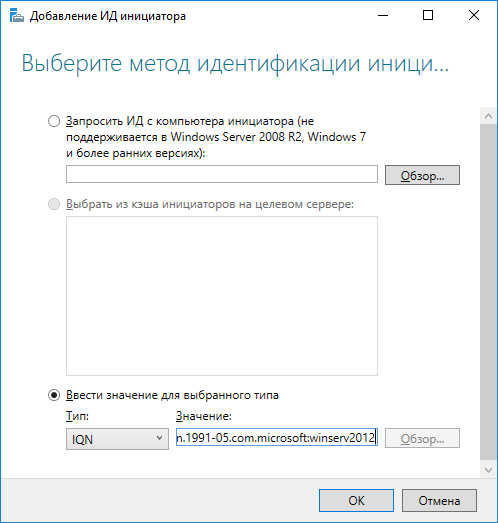

При выборе серверов можно воспользоваться двумя способами. Если инициатор находится на Windows Server 2012 или Windows 8, то можно просто нажать «Browse» и выбрать нужный сервер из списка. Для более старых систем надо вручную ввести идентификатор сервера. В качестве идентификатора можно указать IQN инициатора, DNS имя или IP-адрес сервера, либо MAC-адрес сетевого адаптера.

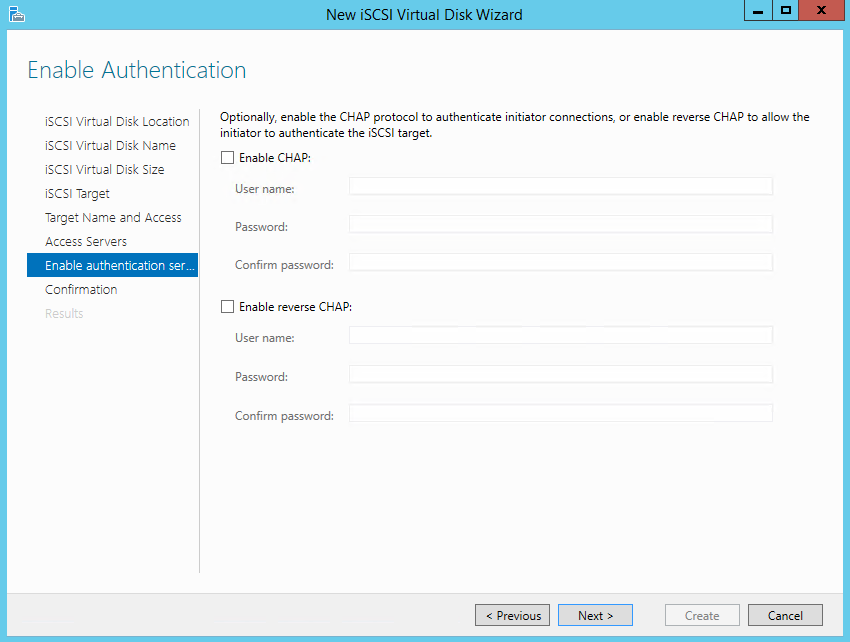

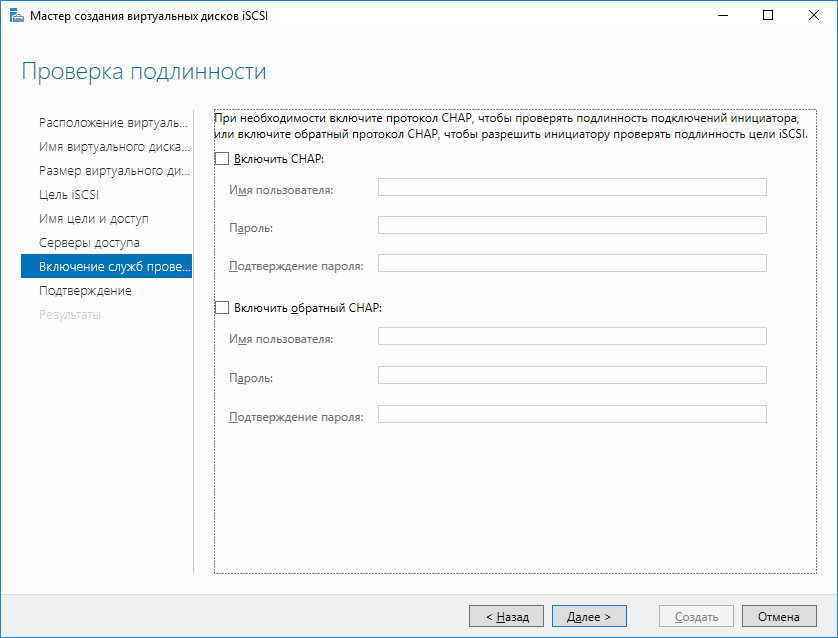

Идем дальше. На следующей странице можно настроить аутентификацию по протоколу CHAP между серверами. CHAP (Challenge Handshake Authentication Protocol) — это протокол для проверки подлинности партнера по подключению, основанный на использовании общего пароля или секрета. Для iSCSI можно задействовать как одностороннюю, так и двухстороннюю (reverse) проверку подлинности CHAP.

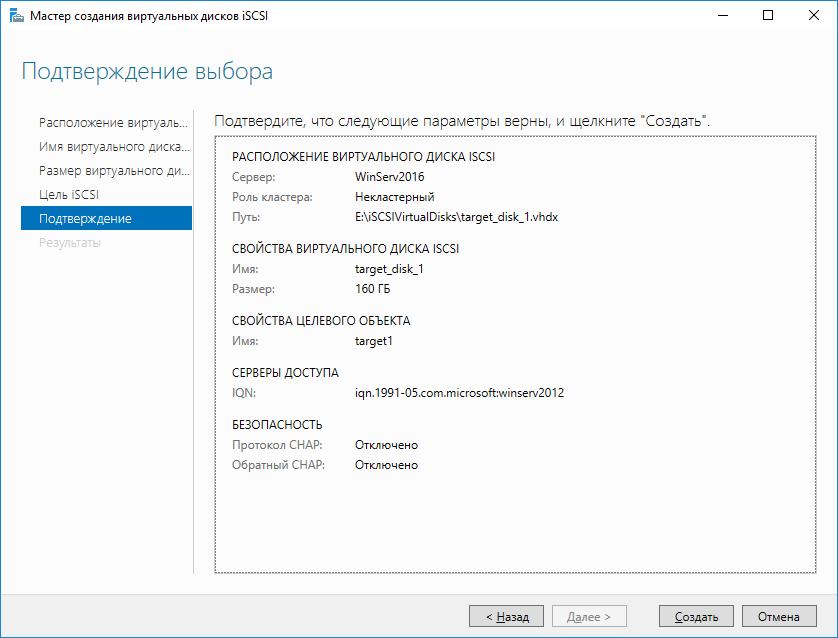

Проверяем правильность настроек и запускаем создание диска.

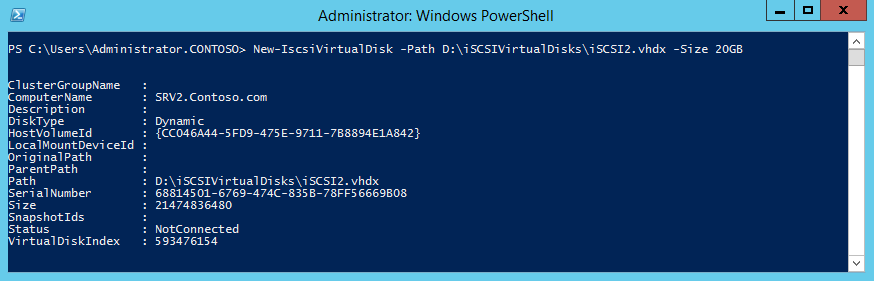

Попробуем сделать все то же с помощью PowerShell. Создадим еще один виртуальный iSCSI диск на 20ГБ командой:

New-IscsiVirtualDisk -Path D:iSCSIVirtualDisksiSCSI2.vhdx

Обратите внимание, что по умолчанию создается динамический диск, для создания VHD фиксированного размера надо воспользоваться ключом -UseFixed.

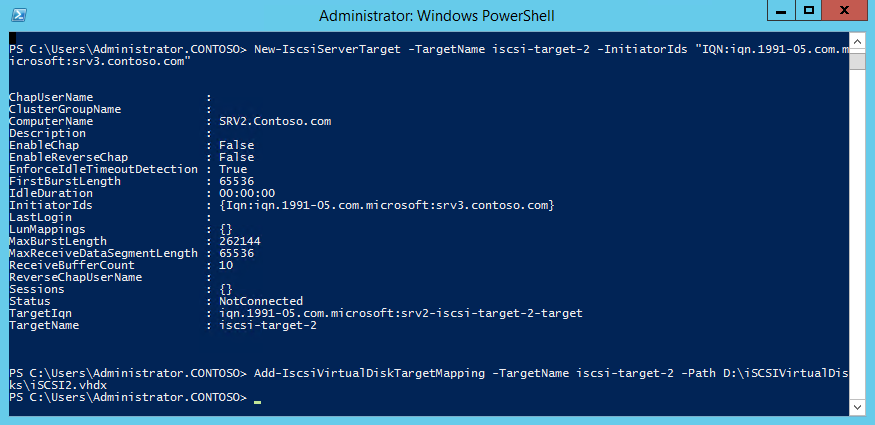

Теперь создаем второй iSCSI Target c именем iscsi-target-2 и в качестве сервера доступа укажем IQN SRV3:

New-IscsiServerTarget -TargetName iscsi-target-2 -InitiatorIds ″IQN:iqn.1991-05.com.microsoft:srv3.contoso.com″

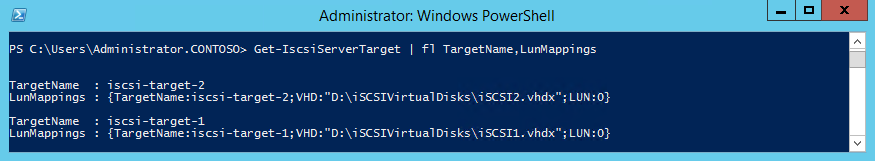

И проверим результат командой:

Get-IscsiServerTarget | fl TargetName, LunMappings

Подключение

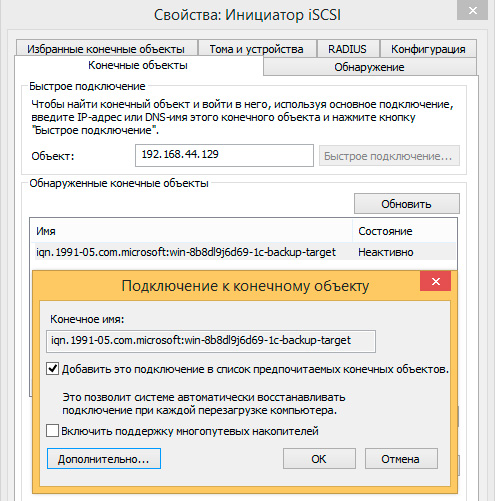

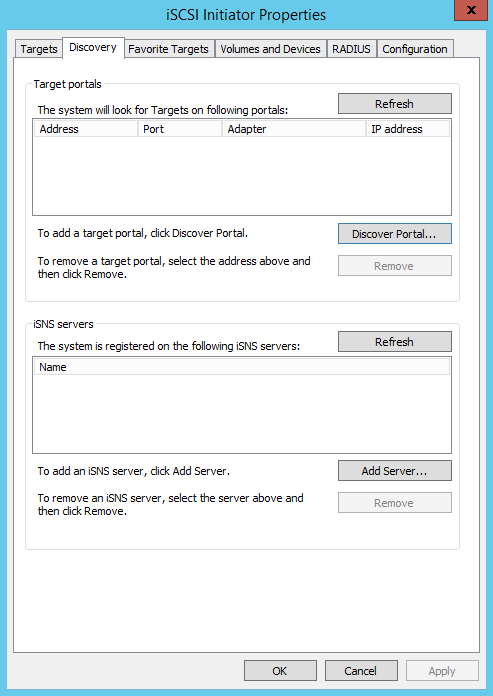

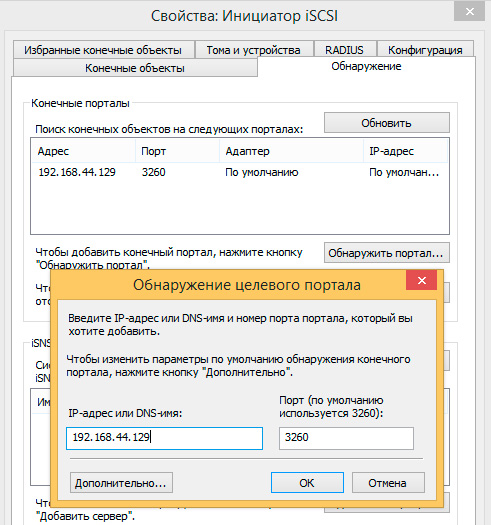

Возвращаемся на SRV3, открываем окно свойств инициатора, переходим на вкладку Discovery и жмем кнопку Discover Portal.

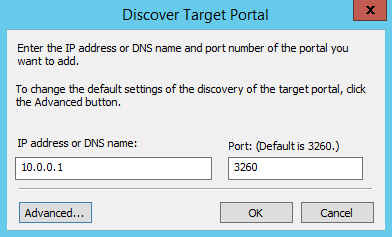

Вводим имя или IP-адрес портала и жмем ОК.

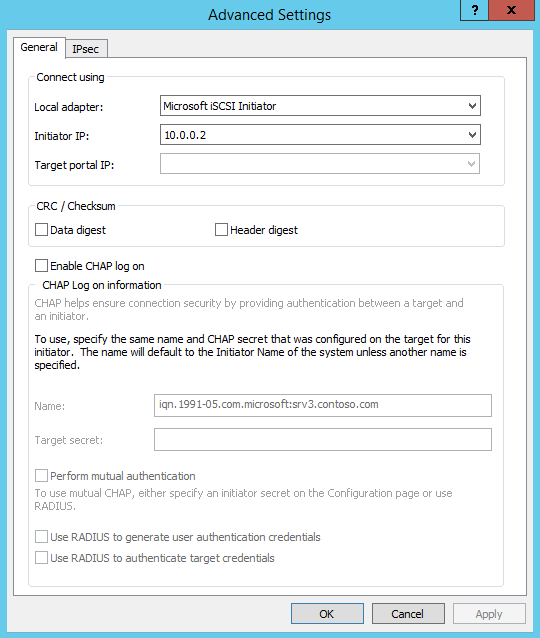

По умолчанию iSCSI использует все доступные IP-адреса, и если вы хотите, чтобы трафик iSCSI шел только через определенный сетевой интерфейс, то надо перейти в расширенные настройки и в поле «Connect using» указать нужный IP.

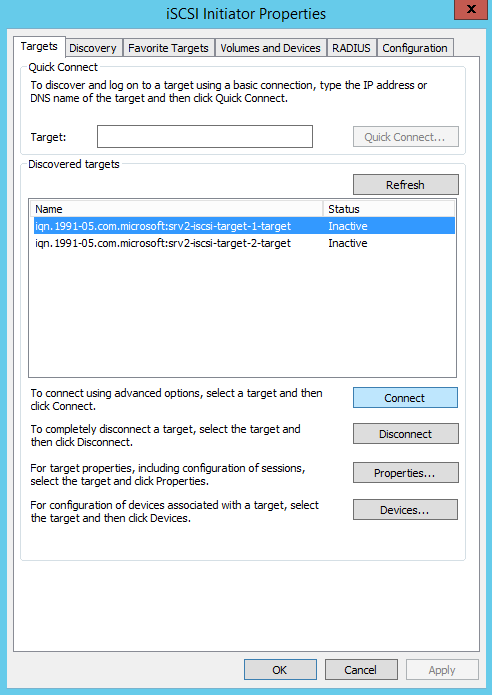

Теперь переходим на вкладку Targets, где должны отобразиться все доступные для подключения iSCSI Target. Выбираем нужный таргет и жмем «Connect».

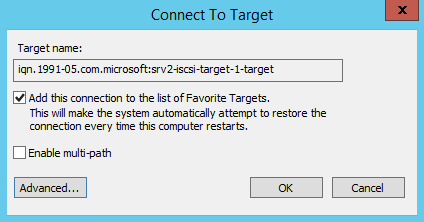

Не забудьте отметить чекбокс «Add this connection to the list of Favorite Targets», который обеспечивает автоматическое подключение к таргету при выключении или перезагрузке машины.

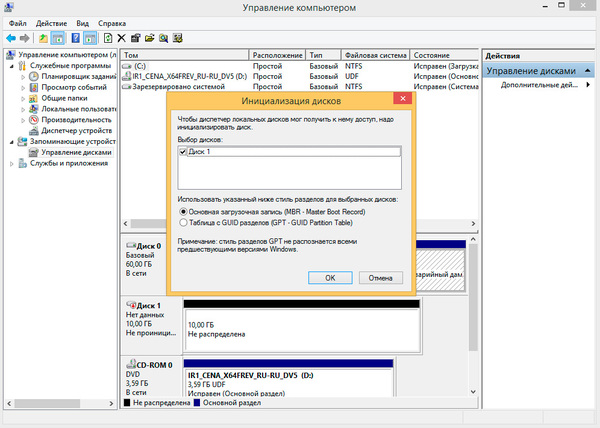

Подключение состоялось, и если открыть оснастку управления дисками, то там появится новый диск. Дальше с этим диском поступаем так же, как с обычным жестким диском, подключенным локально — переводим в Online, инициализируем, создаем на нем разделы и форматируем.

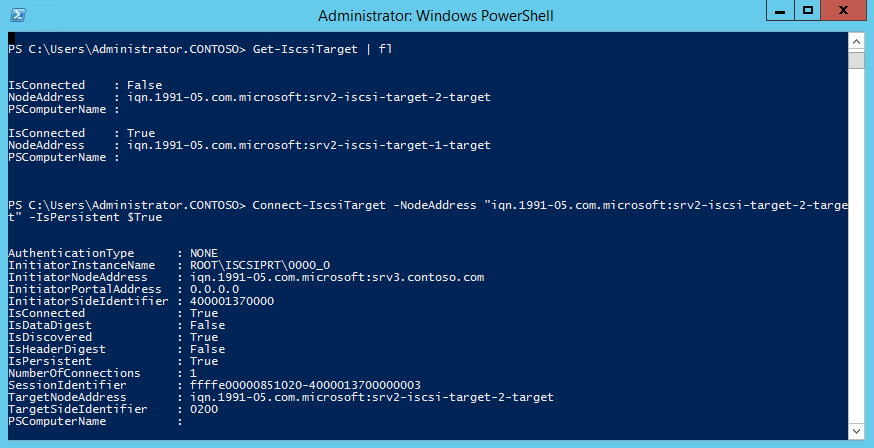

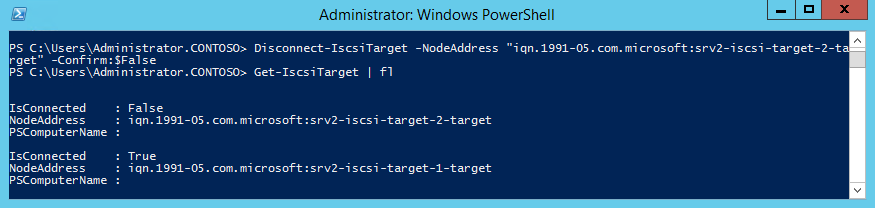

То же самое можно выполнить с помощью PowerShell. Выводим список доступных таргетов:

Get-IscsiTarget | fl

И подключаемся к нужному:

Connect-IscsiTarget -NodeAddress ″iqn.1995-05.com.microsoft:srv2-iscsi-target-2-target″ -IsPersistent $true

Ключ -IsPersistent $true обеспечивает автоматическое подключение при выключении или перезагрузке.

Ну и для отключения можно воспользоваться командой Disconnect-IscsiTarge, вот так:

Disconnect-IscsiTarget -NodeAddress ″iqn.1995-05.com.microsoft:srv2-iscsi-target-2-target″ -Confirm:$false

Заключение

На этом настройка завершена. Как я говорил, это самый простой, базовый вариант настройки хранилища. В iSCSI имеется еще много интересных возможностей. Например, можно использовать службу имен iSCSI (iSNS) для простоты управления, многопутевой ввод-вывод (MPIO) для обеспечения отказоустойчивости, а для безопасности настроить аутентификацию по протоколу CHAP и шифрование трафика с помощью IPSec. О некоторых из этих фич я планирую написать в следующих статьях.

И в заключение важные моменты, которые надо учесть при организации системы хранения iSCSI:

• Развертывать iSCSI желательно в быстрой сети, не ниже Gigabit Ethernet;

• Сетевой трафик iSCSI рекомендуется отделить от остального трафика и вынести в отдельную сеть, например с помощью VLAN или физического разделения на подсети;

• Для обеспечения высокой доступности на сетевом уровне необходимо использовать технологию MPIO, либо сеансы с несколькими подключениями (MCS). Объединение сетевых адаптеров (NIC Teaming) для подключения к устройствам хранения iSCSI не поддерживается;

• При использовании технологии Storage Spaces можно хранить виртуальные диски iSCSI на Storage Spaces, но нельзя использовать LUN-ы iSCSI для создания Storage Spaces;

• Для хранения виртуальных дисков iSCSI нельзя использовать общие кластерные тома CSV (Cluster Shared Volume).

Итак, вы только что закончили восстанавливать систему после сбоя. К счастью, на этот раз обошлось — сервисы, слава богу, поднялись. Но ваш босс недоволен — требует «сделать выводы и принять меры». Очевидно, настало время задуматься о том, как жить дальше. Возможно стоит пересмотреть существующие подходы к построению инфраструктуры и предпринять шаги к обеспечению отказоустойчивости вашей продакшн-системы.

Дисклеймер: заранее прощу прощения у специалистов по SAN и благородного хабрасообщества за некоторые вольности и упрощения, допущенные мной при подготовке материала. Он рассчитан на тех, кто пока еще не знаком с технологиями хранения данных, заложенными в Windows Server 2012 R2, а также тех, кто не имеет возможности развернуть у себя полноценную сеть хранения данных на базе FC или iSCSI.

С чего же начать? Рискну предположить, что для решения проблемы отказоустойчивости требуется две вещи:

- Хороший план.

- Деньги (смета).

Строго говоря, есть еще и третий пункт – «прямые руки», но его обсуждение выходит за рамки данной статьи.

С деньгами все понятно. Что касается плана, то нам необходимо разработать такую архитектуру, чтобы в следующий раз, когда случится сбой (а он обязательно случится!), система устояла. Тут придется сделать небольшое отступление. Дело в том, что в современной терминологии есть несколько устоявшихся понятий, которые часто путают между собой. Вот они:

Высокая доступность (High Availability, HA) — способность минимизировать как запланированные, так и незапланированные простои. То есть, мы (читай — заказчик) заранее соглашаемся с тем, что в случае сбоя, понадобится некоторое разумное время для переключения на резервное оборудование и запуск на нем «упавших» сервисов. Разрыв соединения при этом неизбежен. Типичный пример: кластер Hyper-V.

Отказоустойчивовсть (Fault Tolerance, FT) — способность сохранять работоспособность в случае отказа одного или нескольких компонентов. Это когда сбой произошел, но никто, кроме админа, его не заметил. Или, когда мы отключаем один из узлов, чтобы провести на нем плановое обслуживание (например, установку обновлений), а второй узел в это время берет на себя всю нагрузку. Соединение не рвется, приложения доступны, только немного увеличивается время отклика. Типичный пример: RAID 1-го уровня.

Катастрофоустойчивость — способность относительно быстро запустить сервис в случае глобальных катаклизмов. Это когда рухнуло все и сразу. В качестве глобальных катаклизмов, любят приводить в пример ураганы, цунами и наводнения. Однако, в реалиях нашей страны гораздо более вероятным представляется отключение электричества в ЦОД-е: локальное (экскаватор кабель задел) или веерное, а также затопление подвальных помещений. Пример: резервный ЦОД.

Почему важна терминология? Да потому, что перечисленные задачи принципиально разные. Соответственно, и подходы к их решению должны быть разными. Прежде всего, мы должны определиться, что именно хотим получить: высокую доступность, отказоустойчивость или катастрофоустойчивость.

В контексте данной статьи будем обсуждать только один из трех пунктов, а именно, отказоустойчивость. Справедливости ради, надо отметить, что реальная необходимость в ней возникает не часто. В самом деле, большинство заказчиков вполне готовы мириться с небольшими, прописанными в SLA, простоями в обмен на существенную экономию денежных средств за счет отказа от непомерно дорогих «сверхнадежных» решений. К примеру, если у пользователей на несколько минут подвиснет Excel, это не станет большой проблемой для бизнеса – скорее поводом немного размяться и выпить кофе. Однако, есть и такие сервисы, которые крайне чувствительны даже к небольшому разрыву сетевого соединения. Например, СУБД и гипервизоры. Если Hyper-V потеряет связь со своими виртуальными жесткими дисками, на которых запущены виртуальные машины, это может привести к печальным последствиям. Также и SQL — внезапная потеря сервером своих баз может надолго занять интересным делом DB-админа.

Итак, мы решили, что будем строить отказоустойчивое решение. Другими словами, необходимо убрать возможные точки отказа на всех существующих уровнях: серверном, сетевом и уровне хранения данных. Чем это достигается? Конечно, дублированием всего, чего только можно: серверов, сетевых интерфейсов, каналов передачи данных и, конечно, дисковой подсистемы. Тут перед нашими глазами встает светлый образ SAN. Действительно, что может быть лучше для обеспечения отказоустойчивости, чем старый добрый аппаратный FC SAN? Так-то оно так… Только есть у этого решения один убийственный недостаток. Цена. Стоимость подобной системы начинается с семизначных чисел. А верхний предел практически не ограничен. Поэтому, ее нельзя просто взять и купить – как минимум, придется забюджетировать.

Кроме того, закупая дорогущее железо, мы попадаем в серьезную зависимость от вендора, поскольку совместимость с его оборудованием сторонних производителей далеко не гарантируется. Ну и масштабирование таких систем может потребовать значительных временных затрат. Ведь дорогие комплектующие никто на складе не держит – их надо заказывать и ждать неделями, а то и месяцами. А босс требует «здесь и сейчас». И чтобы все работало «как часы». И чтобы с минимальными затратами!

Где же выход? Неужели светлым мечтам о SAN-е не суждено сбыться? Подождите… А что вообще такое SAN? По сути, это просто способ разделения ресурсов высокопроизводительных устройств хранения данных между серверами на блочном уровне. Когда-то давно классические файберные сети SAN были практически безальтернативной технологией там, где требовалась исключительная производительность, отказоустойчивость и масштабируемость. Скорость FC на порядок превышала типичный Ethernet с его 100 Mb/s.

Но со временем появились сетевые адаптеры 1 и 10 Gbit Ethernet, возникли программные и аппаратные технологии увеличения пропускной способности сети (NIC teaming, сжатие данных и т.д.), что несколько снизило преимущества FC и привело к взрывному росту популярности интерфейса iSCSI. Что касается отказоустойчивости и масштабируемости, то и тут случился прогресс. К примеру, появились варианты реализации SAN на базе хранилищ с интерфейсом SAS, который, вообще говоря, изначально предназначался для прямого подключения хранилища к серверу – DAS. Дело в том, что интерфейс SAS, помимо высоких скоростей (6-12 Gbit/s), обладает еще одним существенным преимуществом – очень малыми задержками (latency). Это весьма важно для высоконагруженных хостов, вроде Hyper-V.

А что у нас есть, кроме SAN? А кроме SAN есть только NAS. Если сравнивать SAN и NAS, то главным отличием первого от второго является работа на блочном уровне. Хост-система может создавать на SAN логические разделы, форматировать их и использовать как обычные локальные жесткие диски. NAS же работает на уровне файловой системы и использует протоколы передачи файлов, такие как SMB или CIFS. Поэтому NAS, конечно, дешево и просто, но о-о-очень медленно. А потому, для высоконагруженных продакшн-систем бесперспективно.

А нельзя ли как-то совместить высокую скорость и надежность SAN с простотой реализации и доступностью NAS? Что, если часть функционала SAN попробовать реализовать программно? Видимо как-то-так рассуждали инженеры одной скромной компании из Рэдмонда, когда готовили к выходу на рынок свою новую технологию. В итоге, у них действительно получилось нечто, по формальным признакам напоминающее SAN. Но при этом в несколько раз дешевле. Нам предлагают использовать весьма недорогие и доступные комплектующие для приготовления изысканного блюда под названием «Scale-Out File Server», т.е. масштабируемый файловый сервер. Слово «масштабируемый», на мой взгляд, не совсем точно отражает суть, поскольку, в первую очередь, сервер получился отказоустойчивым.

Итак, сегодня будем готовить «Суп из SAN» на основе технологий Microsoft Windows Server 2012 R2.

В качестве ингредиентов, нам понадобятся:

- серверы без дисков (только небольшие «зеркала» под систему) — 2 шт.;

- недорогая дисковая полка JBOD с двумя SAS интерфейсами – 1 шт.;

- HDD SAS – не менее 10 шт. (лучше – больше);

- SSD SAS – хотя бы 2 шт.;

- сетевые адаптеры 1-10 GBit (лучше – с поддержкой RDMA) – 2-4 шт.;

В качестве приправы, будем использовать рекомендованный набор специй: Storage Spaces, Tiering, SMB Direct, SMB Multichannel, CSV. Время приготовления: 1-1,5 часа при наличии опыта или 1-2 дня без такового.

Немного теории

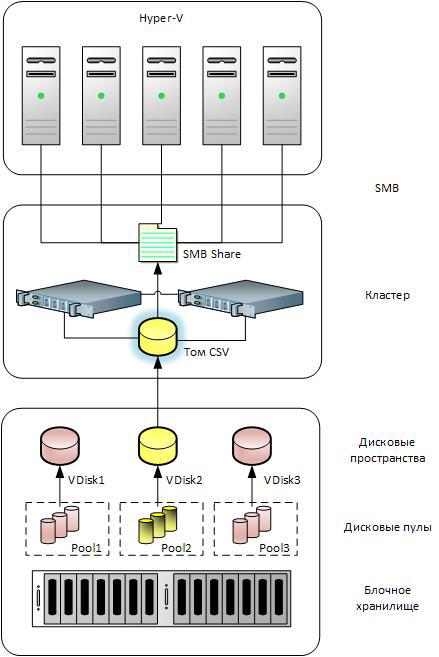

В Windows Server 2012 и Windows 8 появилась интересная технология под названием «Дисковые пространства» (Storage Spaces). Предназначена она для абстрагирования от физического уровня дисковой подсистемы. По сути — это драйвер операционной системы, расположенный после менеджера разделов и перед менеджером томов, который позволяет виртуализировать блочное хранилище, скрывая его от операционной системы. Достигается это группировкой физических дисков в пулы и созданием на основе пулов виртуальных дисков (LUN-ов в терминологии SAN). Таким образом, все приложения будут иметь дело именно с виртуальными дисками, даже не подозревая, из чего они состоят. Но постойте… Опять виртуальные диски? Ведь эта технология под именем «динамических дисков» была реализована Microsoft (точнее, лицензирована у Veritas) аж в 2000 г. — в составе Windows 2000! Опять нам пытаются всучить залежалый товар?

Все не так просто… В отличие от динамических дисков, дисковые пространства — технология гораздо более умная, в чем мы убедимся позже. А пока уточним термины:

Пулы носителей (Storage Pools) — коллекция физических дисков, которая позволяет объединять диски, гибко увеличивать емкость и делегировать администрирование.

Дисковые пространства (Storage Spaces) — виртуальные диски, созданные из свободного пространства в пуле носителей. К атрибутам дисковых пространств относятся уровень устойчивости, уровни хранилища, фиксированная подготовка и точный административный контроль.

Кластеризованные дисковые пространства (Clustered Storage Spaces) – те же дисковые пространства, размещенные на общем хранилище — то, что нам надо!

Как создать виртуальный диск? В нашем случае, для начала, нужно объединить в пул физические SAS диски — HDD и SSD. Вообще говоря, объединять в пулы можно диски с разными интерфейсами: SATA, SCSI и даже USB. Но для развертывания отказоустойчивого кластера (Scale-Out File Server) подходят только диски с интерфейсом SAS. Объединение дисков в пул не представляет каких-либо сложностей и делается с помощью мастера буквально в два клика. Разумеется, на объединяемых дисках не должно быть никаких разделов, либо их придется удалить. Объединив диски в пулы, мы их сгруппируем. Но еще надо объяснить операционной системе, что с ними делать дальше. Теперь можно создать из дискового пула виртуальный жесткий диск (LUN). Технология Storage Spaces позволяет создавать 3 варианта виртуальных жестких дисков, подобных RAID-уровням:

- Simple (аналог RAID0) – рекомендуется только для тестов;

- Mirroring (аналог RAID1) – рекомендуется для рабочих нагрузок;

- Parity (аналог RAID5) – рекомендуется для формирования разделов с архивами данных.

Как и в аппаратных RAID, можно оставить один или два диска в горячем резерве (Hot Spare). Перечисленные возможности представлены в графическом интерфейсе по умолчанию. Однако, если этого мало, с помощью командлетов PowerShell можно получить и более хитрые комбинации, соответствующие, к примеру, RAID уровня 10.

Позвольте, скажет читатель, если это программный RAID, он ведь должен работать медленнее аппаратного! И будет совершенно прав. Да, медленнее. Но насколько? Тут все не так однозначно. Во-первых, как показывает практика, скорость дисков легко компенсируется их количеством. Поэтому, разница в производительности будет тем менее заметна, чем больше дисков мы объединим в пул. Для промышленного применения рекомендуется использовать от 12 дисков. Во-вторых, в Windows Server 2012 R2 появилась одна замечательная фича: объединение в один пул дисков SSD и HDD с формированием т.н. «гибридного пула» (Tiered Storage). В этом случае система сама будет отслеживать и перемещать на быстрые SSD диски наиболее часто используемые данные (помните я говорил, что система умная!). Причем, перемещение «горячих» данных на SSD происходит поблочно, а не на уровне файлов. Более того, с помощью командлетов PowerShell можно явно указать, какие файлы необходимо разместить на SSD, а какие — на HDD. И в-третьих, Storage Spaces поддерживают т.н. «кэш обратной записи» (WriteBack Cache). При кратковременных всплесках операций записи система перехватывает данные и размещает их в специальной области на SSD. Таким образом сглаживается падение производительности при внезапных пиковых нагрузках. Все вместе — большое кол-во дисков, гибридный пул и кэш обратной записи – способно существенно поднять быстродействие системы, сведя к минимуму негативный эффект от программного RAID. Что касается экономии свободного места на дисках, то в Storage Spaces поддерживается такая привычная для SAN технология, как Thin Provisioning – для более экономного распределения дисковых ресурсов. Справедливости ради, заметим, что пока она несовместима с гибридным пулом – придется выбрать что-нибудь одно.

Итак, средствами Storage Spaces мы можем обеспечить отказоустойчивость на уровне СХД. Теперь поднимемся на уровень выше. Серверы необходимо объединить в кластер. Эта возможность появилась у Microsoft уже достаточно давно. Однако, ранее такой кластер можно было назвать лишь высокодоступным (вспоминаем терминологию). И только с выходом Windows Server 2012 появилась возможность сделать его по-настоящему отказоустойчивым. Называется эта фича «Scale-Out File Server». Тут будет уместно напомнить, что файловые кластеры могут работать в одном из двух режимов:

- «Active — Passive»; отработка отказа с прерыванием сервиса – failover.

- «Active — Active»; прозрачная отработка отказа – transparent failover.

В первом случае только один из узлов активный – именно с ним происходит обмен данными, а второй находится в ожидании. В случае отказа первого узла, второй принимает на себя всю нагрузку. Однако, при этом происходит неизбежный разрыв соединения и прерывание в работе сервиса. Именно по такому принципу работает файловый кластер в Windows Server 2008 R2. Во втором случае оба узла активны и способны одновременно принимать данные от клиентов. В случае отказа одного из узлов, потери SMB-сессии не происходит, соответственно, работа приложений не прерывается. Эта технология появилась только в версии Windows Server 2012.

Но чтобы такая одновременная работа с хранилищем стала возможной, потребовалась очередная технология под названием Cluster Shared Volume (CSV). Если не вдаваться в подробности, это логический том, специальным образом подготовленный для одновременной работы с несколькими узлами в составе кластера.

А что на сетевом уровне? Здесь у Microsoft припасено сразу несколько приятных сюрпризов. Первый – это SMB Direct поверх технологии RDMA. Если говорить упрощенно, это технология прямого доступа к памяти через сетевой интерфейс, без накладных расходов на использование центрального процессора. При включении данной фичи сетевые адаптеры фактически начинают работать на скорости интерфейса, обеспечивая высокую пропускную способность и чрезвычайно быстрый отклик на сетевые запросы, что дает огромный выигрыш в производительности для таких рабочих нагрузок, как Hyper-V и SQL Server. Скажем так, работа с удаленным файловым сервером становится похожа на работу с локальным хранилищем. И хотя сетевые адаптеры с поддержкой RDMA пока еще достаточно дороги, их стоимость непрерывно снижается (на момент написания данной статьи составляет около 20 т.р.).

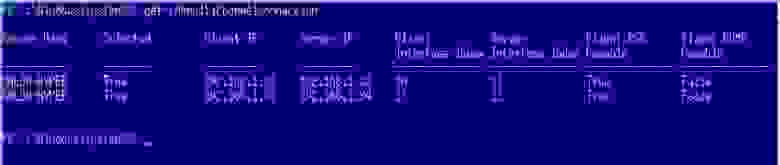

Второй сюрприз называется SMB Multichannel. Если на потребителе нагрузки (например, SQL Server) и на принимающей стороне (файловый кластер) установлено по два сетевых адаптера, то между клиентом и сервером создается многоканальное SMB-подключение. Это означает, что если, к примеру, по сети копируется файл и в процессе копирования что-то происходит с одним из сетевых адаптеров, это не приводит к прерыванию процесса – файл продолжает копироваться, как ни в чем не бывало. Чтобы убедиться в наличии SMB Multichannel, запустите командлет PowerShell: Get-SmbMultichannelConnection. Вы увидите, что-то вроде этого:

Как видно, соединение установлено при помощи сразу двух сетевых интерфейсов.

Наконец, в протоколе SMB 3.0 проведена оптимизация работы балансировки нагрузки между узлами. Как раз для конфигурации Scale-Out File Server.

Ну а теперь, когда мы кратко пробежались по технологиям, самое время перейти к практике. Для упрощения задачи будем строить двухузловой кластер, хотя ничто не мешает поднять отказоустойчивый файловый кластер, имеющий до 8 узлов. Опишем порядок действий с самого начала и приступим к его выполнению.

Подготовительные работы

Итак, берем дисковую полку в режиме JBOD. Набиваем ее дисками, хотя бы два из которых должны быть SSD. У корзины должно быть два SAS-экспандера, по два разъема на каждом. Через них подключаем корзину к двум серверам, желательно одинаковым. Для этой цели вполне подойдут простые одноюнитовые серверы. На серверах в качестве контроллеров устанавливаем обычные SAS HBA.

Далее по пунктам:

- Устанавливаем на каждый сервер ОС Windows Server 2012 R2.

- Настраиваем сетевые подключения, устанавливаем обновления, вводим серверы в домен.

- Добавляем роль Файловый сервер на каждом сервере.

- На одном из серверов открываем консоль Диспетчер отказоустойчивости кластеров.

- С помощью мастера создаем стандартный кластер с отработкой отказа (Failover Cluster).

- Создаем новый пул: Хранилище -> Пулы -> Создать новый пул.

- Добавляем в пул SSD и HDD диски, при необходимости указываем параметры доступа.

- Создаем виртуальный диск: Пул –> правый клик –> Новый виртуальный диск.

- С помощью мастера задаем тип дисковой подсистемы (Mirror).

- C помощью мастера создаем том на диске, присваиваем букву, форматируем в NTFS.

- Создаем общий кластерный том (CSV): Выбираем нужный диск -> Добавить в общие тома кластера.

- Задаем роль: Роли -> Настроить роль -> Файловый сервер -> Масштабируемый файловый сервер.

- Чтобы не ждать, сбрасываем кэш распознавателя DNS (ipconfig /flushdns).

- Выбираем роль -> Добавить общий файловый ресурс -> Общий ресурс SMB –> Профиль приложений.

- Указываем расположение общего ресурса, даем ему название.

Все. Конечным итогом наших усилий стало создание файловой шары, расположенной по стандартному UNC-пути, типа: \ScaleOutFSShare. Теперь можем размещать на ней критические файловые ресурсы, такие как виртуальные жесткие диски Hyper-V или базы данных SQL сервера. Таким образом, мы получили готовую сеть хранения данных. Принципиальное отличие ее от традиционных SAN состоит в том, что для подключения используется протокол SMB 3.0, а не какой-то из блочных протоколов (iSCSI/FC), что в определенном смысле является даже преимуществом. У кого-то может возникнуть желание развернуть роль Hyper-V прямо на кластерном сервере, разместив виртуальные диски на общем хранилище. Придется огорчить. К сожалению, такая конфигурация пока не поддерживается. Для ролей Hyper-V и SQL Server необходимо поднимать отдельные серверы, которые будут работать с нашей СХД по SMB-протоколу.

Осталось подвести итоги…

Отказоустойчивость

Обеспечивается на всех уровнях: хранения данных, серверов, сетевого взаимодействия.

Производительность

Будет зависеть от нескольких факторов. В типичном случае сопоставима с производительностью решений на базе iSCSI. А в случае задействования всех имеющихся возможностей, включая технологию RDMA, пропускная способность СХД окажется даже выше, чем при FC-подключении (до 56 GBit/s).

Масштабируемость

На уровне дисковой подсистемы обеспечивается простым добавлением дисков или каскадированием хранилищ JBOD. На уровне серверов – добавлением узлов в кластер. На сетевом уровне – добавлением сетевых адаптеров, объединением их в группы (NIC teaming) или заменой их на другие, с большей пропускной способностью.

Безопасность

Дисковые пулы можно контролировать с помощью списков контроля доступа (ACL), а также делегировать полномочия администраторам. Управление хранилищами может быть полностью интегрировано с ADDS.

Стоимость

Очевидно, что даже при использовании всех возможностей, заложенных в данную технологию, стоимость готового решения будет в несколько раз ниже традиционного SAN.

А как же недостатки? Разумеется, они тоже имеются. К примеру, СХД и серверы нельзя разнести на значительное расстояние, как в случае FC или iSCSI. Нельзя выстроить сложную топологию. Коммутаторы SAS – пока еще редкость. Кроме того, SAS не поддерживает аппаратную репликацию – ее придется реализовывать программными средствами. Поэтому, описанная выше концепция – не панацея, а всего лишь альтернатива традиционным СХД. Если у вас уже есть развернутый аппаратный SAN, это ни коим образом не повод от него отказываться. Железо должно отрабатывать вложенные в него деньги. Но если вы пока еще только задумываетесь об архитектуре будущей системы хранения данных, имеет смысл рассмотреть и данный вариант, как вполне обоснованный с инженерной и экономической точек зрения. Ну и напоследок хотелось бы отметить, что «суп из SAN» можно сварить не только на технологиях Microsoft. Если у вас имеется хранилище с интерфейсом iSCSI, можете воспользоваться такими продуктами, как StarWind iSCSI SAN, VMware Virtual SAN, Openfiler, FreeNAS, Open-E DSS V6 и т.п.

Приятного аппетита!

При подготовке статьи были использованы материалы портала Microsoft Virtual Academy.

Арсен Азгальдов, dpandme@gmail.com

iSCSI — это сетевой протокол для работы с системами хранения данных (СХД). Он позволяет взаимодействовать по сети с различными системами хранения данных. В упрощенном виде она состоит из следующих частей:

- iSCSI-target (таргет) — это ресурс, к которому осуществляется доступ посредством протокола iscsi

- iSCSI-initiator (инициатор) — это хост который инициирует (устанавливает) iSCSI-соединение

- IQN (iSCSI Qualified Name) — это полный уникальный идентификатор устройства iSCSI, однозначно определяющий данное устройство (есть и у таргета и у инициатора)

Такая система хранения данных может быть организована на практически любой ОС, так как строится на логическом уровне и не требует обязательного наличия специальных устройств хранения данных (дисков, дисковых контроллеров). В большинство ОС эта функция уже включена, и может быть достаточно легко активирована.

Не является исключением и ОС Windows, где компоненты iSCSI являются дополнительными компонентами системы.

Установка iSCSI-таргета.

Для создания таргета нам необходимо через мастер добавления ролей и компонентов диспетчера серверов добавить роль “Сервер цели iSCSI” из раздела “Файловые службы и службы хранилища”.

Для этого необходимо нажать комбинацию клавиш Win-R и в командную строку ввести compmgmt.msc.

Далее запустить мастер установки ролей и компонентов нажав кнопку “добавить роли и компоненты”.

Откроется страница приветствия. Можно просто нажать “Вперед”, а также поставить галочку “Пропускать эту страницу по умолчанию”, если вы не хотите постоянно видеть эту страницу при запуске мастера установки ролей и компонентов, так как эта страница чисто информационная.

После этого, ОС задаст уточняющий вопрос.Выберем установку ролей и компонентов.

Укажем на какие сервера устанавливать роли и компоненты. Выберем интересующий нас сервер и нажмем далее.

Выбираем необходимые из списка ролей сервера. Надо раскрыть Файловые службы и поставить галочку “Сервер цели iSCSI”.

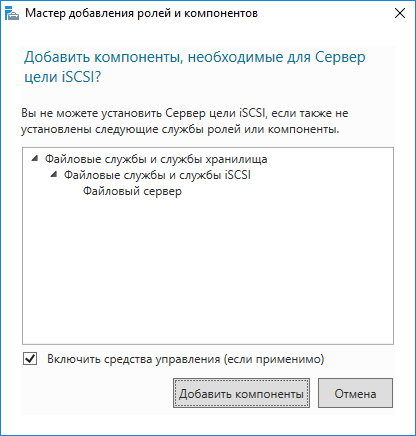

Установка дополнительных компонентов — добавляем нажатием соответствующей кнопки.

После этого выбранная роль отметится галочкой и можно переходить к следующему этапу нажатием кнопки “Далее”.

Установку компонентов можно пропустить, так как они нам в данный момент не нужны, нажав кнопку далее.

После этого, предупреждение о готовности роли к установке. Нажимаем “Установить”. Можно также поставить галочку “Автоматический перезапуск конечного сервера, если требуется” чтобы не перезапускать сервер вручную. Следует иметь ввиду, что нажатие этой галочки перезапускает конечный сервер после установки без дополнительных предупреждений, поэтому используйте ее с осторожностью.

После нажатия кнопки установить запустится процесс установки, можно закрыть это окно нажатием соответствующей кнопки. Следует иметь ввиду что это действие не отменяет процесс установки, а только скрывает текущее окно.

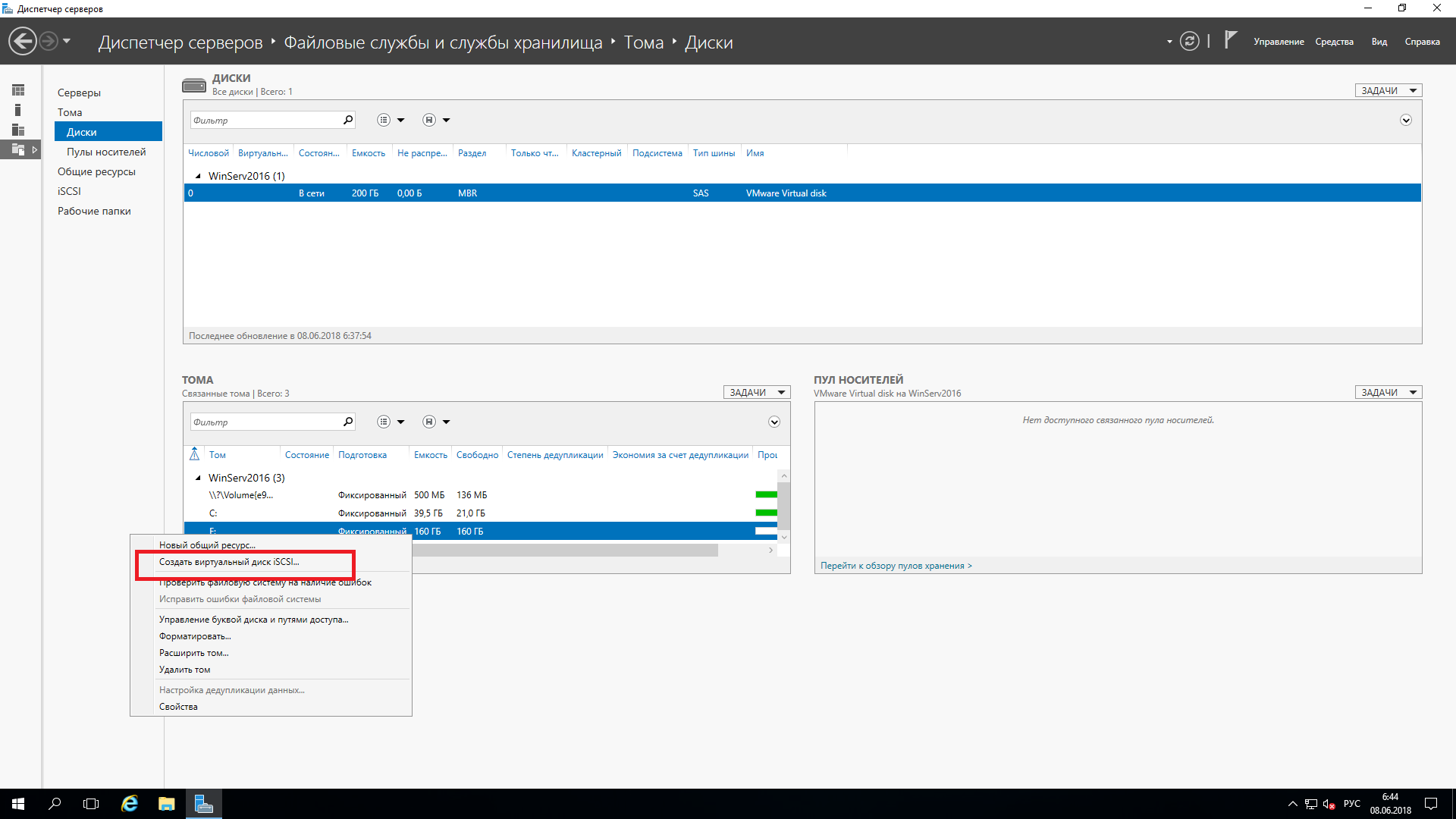

Заходим последовательно в “Диспетчер серверов”-”Файловые службы и службы хранилища”-”Тома”-”Диски”.

Выбираем на каком томе будет храниться наш таргет и в контекстном меню пустого тома выбираем “Создать виртуальный диск iSCSI”.

На первой странице еще раз определяем том на котором будет храниться таргет.

Задаем имя и по желанию описание нашего диска и жмем далее.

Вводим размер диска и определяем как будет выделяться под него пространство — сразу или динамически. Доступный размер под iSCSI-диск показан в самом верху.

Определяем создавать ли новый таргет или присоединить диск к существующему (если они есть).

Задаем имя и описание нового таргета.

Выбираем инициаторы которым можно подключаться к данному таргету (может быть переопределено) посредством кнопки “добавить”. Можно добавить инициаторы через поиск, выбрать из кеша, если ранее инициаторы уже подключались или задать вручную через IQN, DNS-имя, ip или mac-адрес. Как минимум один инициатор должен быть задан. Введем например IQN вручную.

Нам стала доступна кнопка далее.

Можно включить дополнительную проверку подлинности если это необходимо (например таргет публикуется в сети интернет).

На последнем шаге выводится сводная информация по таргету. Проверяем и нажимаем “Создать”.

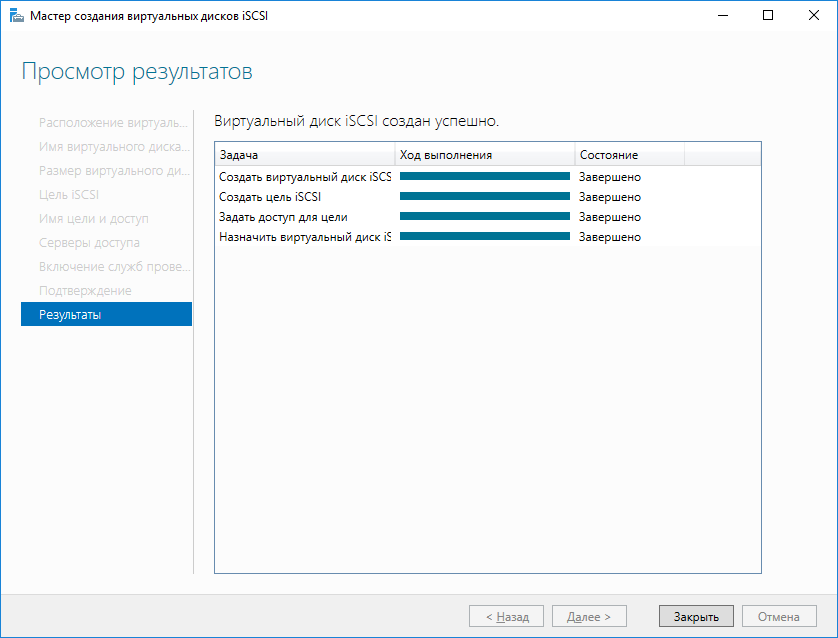

Начнется процесс создания таргета.

После этого можно подключаться к данному таргету инициатором, заданным на этапе создания.

На этом настройка хранилища iSCSI на Windows Server 2012R2 окончена. В нашей базе знаний вы найдёте ещё множество статей посвящённых различным аспектам работы в Windows, а если вы ищете надежный виртуальный сервер под управлением Windows, обратите внимания на нашу услугу — Аренда виртуального сервера Windows.

Содержание

Основы общего хранилища

Сеть хранения данных

iSCSI

Волоконно-оптический канал

Корпуса SAS

RAID?

SMB 3.0

Службы файлов и хранилища Windows Server 2012 R2

Кластеризация

Требования кластеризации

Функциональность кластеризации

Общие тома кластера

Кластеры и виртуализация

Понятие кворумов

Высоко доступное хранилище

Пространства хранения

Кластеризация внутри виртуальных машин

Настройка кластера

Конфигурация кластера

Хранилище

Добавление в кластер первого узла

Добавление в кластер второго узла

Настройка гостевого кластера

Общее хранилище и кластеризация в Windows Server 2012 R2 предоставляют,

вероятно, наиболее важную функциональность, которая требуется любой инфраструктуре крупного предприятия или центра данных. Гарантирование того, что ресурсы вроде приложений, служб, файлов и папок доставляются с обеспечением высокой готовности (high availability — НА), централизации и масштабируемости,

должно быть первостепенной целью каждого IТ-администратора и консультанта.

Использование общего хранилища и кластеризации предоставляет организациям

возможность масштабировать хранилище по требованию, создавать централизо

ванные местоположения для ресурсов и делать их высоко доступными для бизнес

деятельности.

Концепции общего хранилища и кластеризации не являются новыми или экс

клюзивными для Windows Server 2012 R2, но обретение четкого понимания каждой концепции позволит уверенно развертывать расширенные предложения НА, которые поступают в готовом виде вместе с операционной системой. В этой главе вы изучите следующие темы:

• использование опций хранилища, доступных для кластеризации;

• применение кворума для помощи в кластеризации;

• построение кластеров хостов и гостей.

Основы общего хранилища

В наиболее базовой форме общее хранилище предоставляет центральное мес

тоположение внутри IТ-инфраструктуры организации, предназначенное для размещения специального набора файлов или приложений, так что многочисленные

пользователи могут иметь к ним одновременный доступ. В этой технологии могут

быть задействованы самые разнообразные устройства хранения, примерами которыхявляются сети хранения данных (storage area network — SAN), сетевое хранилище (Network Attached Storage — NAS) и последовательно присоединенные устройства SCSI (Serial Attached SCSI — SAS). В зависимости от сушествуюших требований(и бюджета), вы по своему усмотрению развертываете те или иные опции. В конечном счете, при объединении посредством кластеризации все эти опции преследуют одну и ту же цель — позволить пользователям продолжать работу с их приложениями и файлами в случае выхода сервера из строя. Рассмотрим простой пример с сотрудником отдела кадров по имени Сара. Она должна убедиться в наличии местоположения мя безопасного хранения критически важных документов, связанных с кадрами, которые могут содержать номера карточек социального страхования. При правильно спроектированном и реализованном решении общего хранилища Сара может поместить эти файлы в совместно используемое местоположение, которое подвергается шифрованию и резервному копированию, и потенциально могла бы иметь права на управление настройками безопасности. Другие сотрудники с соответствующими правами мя этого местоположения имеют доступ к своим файлам, и Саре не придется беспокоиться об открытии совместного доступа к файлам на ее собственной рабочей станции или о риске утратить файлы в результате аварии.

Хранилище и возможность предоставления к нему управляемого доступа являются наиболее распространенными требованиями в любой организации. Доступно множество опций хранения. Прежде чем приступить к рассмотрению опций, доступных в Windows Server 201 2 R2, давайте ознакомимся с базовыми компонентами:

• iSCSI SAN

• Fiber Channel SAN

• Корпуса SAS

• SMB 3.0 Server 2012

Благодаря развитию средств, касающихся хранилища, в Windows Server 2012 R2

вы можете начать пользоваться этими компонентами в имеющейся инфраструктуре.

Ниже приведен краткий обзор указанных технологий.

сеть хранения данных

Сеть хранения данных — это подключенная к сети сущность, выделенная специально для хранения. Технология SAN является просто базовой инфраструктурой, каждое конкретное решение SAN представляет хранилище собственным уникальным способом. В действительности речь идет о хранилище на уровне блоков, которое доступно ресурсам через сеть. SAN обычно выглядит как крупное устройство с многочисленными жесткими дисками, которые вы разделяете и форматируете для представления серверам и компьютерам в сети.

Вдобавок SAN не обязательно должна быть традиционной сетью; например, она

может быть волоконно-оптическим каналом (FiЬer Channel). В случае волоконно

оптического канала применяется тот же самый базовый принцип: это устройство,

заполненное дисками, но сеть основана на оптоволокне. В большинстве органи

заций сети хранения данных имеет сетевой коммутатор, специально выделенный

и оптимизированный мя SAN. Сеть передачи данных, с которой взаимодействует

SAN, обычно называют фабрикой хранилищ. Главная цель SAN — разрешить различным типам серверов, приложений и пользователей из множества мест иметь доступ

к пулу хранения, который может быть доступен из любого устройства, связанного с этой фабрикой хранилищ. Часть фабрики хранилищ является хает-адаптером шины (host bus adapter — Н ВА), представляющим собой сетевую интерфейсную плату (network interface card — NIC), которая соединяет фабрику хранилищ с ресурсами всети, нужлающимися в доступе к хранилищу.

Многие организации и П-профессионалы уверены, что SAN предоставляет им

гибкость развертывания и повторного развертывания серверов и хранилища в намного более динамической манере.

Серверы могут загружаться напрямую из SAN,что предоставляет им операционную систему и конфигурации в крупном местоположении с высокой готовностью. Если физический сервер утрачивает работоспособность, его место может занять новый сервер, а операционная система и связанные диски могут быть направлены на новый сервер намного быстрее, чем в случае перестройки и восстановления с ленты.

Мы рекомендуем уделить некоторое время на более глубокие исследования этих

тем, и если в вашей организации имеется SAN, то вы должны начать с чтения сопутствующих руководств по развертыванию и администрированию.

iSCSI

Интерфейс малых компьютерных систем, основанный на TCP/IP (lnternet Small

Computer System Interface — iSCSI), существует на протяжении многих лет, и он применялся в качестве способа коммуникации компьютеров или серверов с дисковыми устройствами или другими устройствами хранения, такими как библиотеки лент. С развитием SCSI развивалась также сетевая инфраструктура, соединяющая серверы и компьютеры. Гигабитные сети стали намного более распространенным явлением, что обеспечивает подключение к хранилищам с широкой полосой пропускания. Протокол iSCSI используется для упрощения передачи данных по сети TCP/IP (Ethemet). Протокол iSCSI позволяет предоставлять дисковые устройства, расположенные в SAN, через существующую сеть вашим серверам.

Инициатор iSCSI (iSCSI lnitiator) от Microsoft является программным компо

нентом, который встроен во все операционные системы Windows Server, начиная с Windows Server 2008, и также включен в Windows 7 и Windows 8. Инициатор iSCSI делает возможными подключения устройств Windows для утилизации этой технологии.

Как и с другими технологиями хранения, о которых здесь пойдет ре’IЬ, мы не

собираемся вдаваться в самые мелкие детали, касающиеся всех доступных опций

масштабирования и производительности. Цель этой главы — предоставить введение

в эти области.

Волоконно-оптический канал

Волоконно-оптический канал (Fiber Chaпnel — FC) является еще одним высо

коскоростным сетевым каналом, работающим через медную витую пару или оптоволоконный кабель. Подключение к серверам и хранилищу поддерживается через хает-адаптер шины (НВА) с применением протокола, похожего на ТСР, который называется протоколом 1ю;юконно-оптического канала (Fiber Channel Protoco — FCP).

Адаптеры НВА взаимодействуют в группе зон со специальными мировыми име

нами, которые по существу действуют подобно I Р-адресам. Подключение Fibeг

Channel к устройствам и хранилищу производится через оптоволоконный коммутатор и управляется в зонах, которые вьщелены специальным сетевым интерфейсам.

Это давно было самым быстрым типом подключаемости к сетевым хранилищам, доступным мя организаций, но он далеко не дешев!

Корпуса SAS

Последовательно присоединенные устройства SCSI (SAS) — это метод доступа к

устройствам, которые используют последовательное подклю,1ение по локально соединенным кабелям. В отличие от iSCSI и FC, решения корпусов SAS не располагают сетевой подключаемостью.

Технология SAS поддерживает ранние технологииSCSI, в том числе принтеры, сканеры и другие периферийные устройства. Корпуса SAS представляют собой большие устройства, подобные SAN, которые имеют множество дисков, сконфигурированных с применением различных уровней RAID мя обеспечения избыточности на случай отказа диска.

RAID

Избыточный массив независимых дисков (Redundant Аrгау of Independent

Disks — RAI D) состоит из множества дискоn, сгруппированных вместе. Этот массив

позnоляет настраивать отказоустойчивые диски и масштабировать их мя достижения высокого уровня производительности. Сушествует много типов RAI D, которые премаrают разнообразные методы поддержки производительности и обхода отказа.

Технологии RAID ямяются основой внутренней работы iSCSI, SAS и корпусов FiЬer Channel SAN. По следующей ссылке вы найдете подробные сведения по типам RAID и ситуаuиям, в которых они используются: http : / /technet . microsoft . сот/

en-us/library/cc786889 (v=WS . 10 ) . aspx.

SMB 3.0

Блок сообщений сервера (Serveг Message Block — SMB) — это протокол, специ

ально разработанный мя общих файловых ресурсов и масштабирования этих ресурсов или серверов. Он функционирует поверх TCP/IP, но может использовать другие сетевые протоколы. SMB применяется мя доступа к пользовательским данным и приложениям в ресурсах, которые существуют на удаленном сервере. Для настройки

SM В должны быть удометворены специфические требования.

• Требуется кластер с обходом отказа Windows Serveг 2012/2012 R2, имеющий

минимум два узла.

• Должна быть возможность создания общих файловых ресурсов со свойством

Continuous Availability (Постоянная доступность); по умолчанию так и есть.

• Общие файловые ресурсы должны находиться на томах CSV.

• На клиентских компьютерах, получающих доступ к этим ресурсам, должна

быть установлена ОС Windows 8 или последующей версии.

• На серверах, использующих или обращающихся к этим ресурсам, должна быть

установлена ОС Windows Serveг 2012 или выше.

ВВЕДЕНИЕ В ОБЩЕЕ ХРАНИЛИЩЕ И КЛАСТЕРИЗАЦИЮ 615

На серверах Юiастера с обходом отказа, на которых функционирует ОС Windows

Server 2012/2012 R2, дополнительные компоненты или роли устанавливать не нужно.

Протокол SMB 3.0 вКТiючен по умолчанию. Ниже перечислены новые возможности

SMB, доступные в Windows Server 2012/2012 R2.

• SMB Тransparent Failover (Прозрачный обход отказа SMB). Эта возможность

позволяет прозрачно подКТiючать КТiиентов к другому узлу гладким образом,

чтобы работа приложений и хранилища не прерывалась.

• SMB Scale Out (Масштабирование SMB). Применяя общие тома КТiастера

(Cluster Shared Volume — CSV), вы создаете общий диск, который все узлы в

Юiастере используют через прямой ввод-вывод, чтобы эффективнее расходо

вать полосу пропускания сети и нагрузку на файловых серверах. Это оптими

зирует производительность и в то же время обеспечивает улучшенный доступ

КТiиентам.

• SMB Direct (Прямой доступ SMB). Эта возможность задействует сетевые ин

терфейсные платы, которые поддерживают функции RDMA (Remote Direct

Memory Access — дистанционный прямой доступ в память), и позволяет раз

грузить центральный процессор и обеспечить более высокие скорости переда

чи данных с минимальной задержкой.

Новых возможностей SMB появилось совсем немного. Существует множест

во других компонентов, таких как специфичные для SMB командлеты PowerShell,

шифрование и счетчики производительности.

Более подробную информацию по SMB и набору новых возможностей можно найти

по ссылке http : ! /technet . microsoft . com/en-us/ library /hh8317 95 . aspx.

службы файлов и хранилища Windows Server 2012 R2

Роль File and Storage Services (Службы файлов и хранилища) в Windows Server, показанная на рис. 1 1.1, предоставляет все службы и функции, необходимые для управления и создания файловых серверов и хранилища разных типов в Windows Server.

Как видите, компонент Storage Services (Службы хранилища) устанавливается по

умолчанию и не может быть удален. Другие компоненты при необходимости могут быть установлены либо удалены.

Компонент File and iSCSl Services (Службы файлов и iSCSJ) этой роли предо

ставляет множество других компонентов, которые помогают управлять общими

файлами, размером диска, репликацией и офисами филиалов. В следующем списке

представлен обзор этих компонентов с указанием возможностей, которые они предлагают для файлов и хранилища в Windows Server 2012 R2.

• File Seгver (Файловый сервер). Этот компонент позволяет управлять общими

ресурсами и предоставляет пользователям возможность доступа к файлам на

конкретном сервере в сети организации.

• BranchCache for Network Files (BranchCache для сетевых файлов). Этот компо

нент позволяет серверам BranchCache иметь сетевые файловые службы.

• Data Deduplication (Дедупликация данных). Эта служба помогает управлять и

экономить дисковое пространство, анализируя содержимое тома и удостоверя

ясь в существовании только одной версии каждого файла.

Продолжая приведенный ранее пример с Сарой и ее файлами из отдела кадров, предположим, что Метгью, коллега Сары в отделе кадров, сохранил копию файла в каком-то другом месте, подумав о том, что она недоступна. Служба Data Dedupication обеспечивает существование только одной версии конкретного файла, но делает доступными ссылки на него, так что Меттью сможет найти свой файл.

• DFS Namespaces (Пространства имен DFS). Распределенная файловая система

(Distributed File System — DFS) позволяет настроить группу общих папок, ко

торые могли бы располагаться на других серверах в организации, но выглядеть

как имеющие одно имя. Вот пример:

• сервер 1 имеет общую папку по имени Serverl Files;

• сервер 2 имеет общую папку по имени Server2Stuff.

С помощью DFS Namespaces можно было бы определить их как Bigfirm

Shared.

• DFS Replication (Репликация DFS). Этот компонент позволяет синхронизи

ровать общие папки по сети WAN. Он не требует DFS Namespaces, но может

применяться совместно.

• File Seгver Resource Manager (Дисnе1Чер ресурсов файлового сервера). Диспетчер

ресурсов файлового сервера (File Server Resource Manager — FSRM) — это

инструмент для управления и мониторинга производительности, который

предоставит более детальные отчеты о том, что происходит с хранилищем.

Посредством FSRM можно также строить файловые политики, квоты и кпас

сификаuии.

• File Seгver VSS Agent Service (Служба агента VSS файлового сервера). Эту службу можно использовать для копирования приложений и данных, хранящихся

на конкретном сервере, на котором установлена роль File and Storage Services,

с применением службы теневого копирования томов (Volume Shadow Сору

Service — VSS). За дополнительными сведениями о службе VSS обращайтесь

по ссылке !1ttp: / /tinyurl . com/cllwhatisvss.

• iSCSI Target Server (ЦеJJевой сервер iSCSI). Это предоставляет инструменты и

связанные службы для управления серверами iSCSI.

• iSCSI Target Storage Provider (VDS and VSS Hardware Providers) (Поставщик

целевого хранилища iSCSI (поставщики оборудования VDS и VSS)). Работает

подобно службе File Server YSS Agent Service, но специфичен для серверов,

которые используют цели iSCSI и службу виртуальных дисков (Yirtual Disk

Service — VDS).

• Server for NFS (Сервер для NFS). Вы можете включить сетевую файловую

систему (Network File System — N FS), которая применяется в компьютерах с

Unix/Linux, так что общие ресурсы из установки Windows Server 201 2 R2 будут

видимыми таким клиентам.

• Work Folders (Рабочие папки). Этот новый компонент Windows Server 2012 R2

предоставяет простой способ управления файлами, которые существуют на

множестве рабочих станций и персональных устройств.

Рабочая папка будетдействовать в качестве хоста и синхронизировать файлы пользователей с этим местоположением, так что пользователи могут получать доступ к своим файлам изнутри или снаружи сети.

Отличие от компонента File Server или DFS Namespaces в том, что файлы размещены на клиентах.

Снова возвратившись к примеру с Сарой и Меттью из отдела кадров, отмет И м, что они могли бы использовать Work Folders для обеспечения синхронизации и обновления файлов, храняшихся в определенных местоположениях на их рабочих станциях, с файловым сервером.

Если они работают над проектом вместе, но находятся в

разных местах, нужные файлы будут всегда доступны и синхронизированы.

Все эти компоненты можно установить через управляющую панель диспетчера

серверов, которая предоставляет детальные сведения о каждом компоненте и любые предварительные условия.

В следующем разделе мы определим кластер и поможем построить высоко доступные службы при участии кластеризации с обходом отказа.

Кластеризация

В наиболее базовой форме кластер — это два или большее количество серве

ров (физических или виртуальных), сконфигурированных как логический объект и единственная сущность, которая управляет общими ресурсами и представляет их конечным пользователям. Серверы, являющиеся членами кластера, называются узлами.

Тремя самыми распространенными типами кластеров в Windows Server 2012 R2 являются кластеры файловых серверов, кластеры SQL и кластеры Hyper-Y.

Двухузловой кластер, например, можно было бы сконфигурировать с уз.1ами

(физическими либо виртуальными), множеством сетевых интерфейсных плат и каким-то решением общего хранилища наподобие iSCSI, SAN или напрямую присоединенных дисков.

Цель кластеризации заключается в том, чтобы разрешить определенной группе

узлов работать вместе, пользуясь общей мощностью высоко доступных ресурсов.

Это обеспечит вашим конечным пользователям высокую готовность в отношении

рабочих нагрузок, которые им нужны.

Кластеризация предоставляет следующие преимущества.

• Возможность сохранения работоспособности в случае отказа или отключения

узла.

• Возможность перезапуска виртуальной машины или сохранения работоспо

собности при отказе какой-то виртуальной машины.

• Нулевое время простоя для любых исправлений или обслуживания узлов кластера.

• Возможность переноса и рассредоточения нагрузки серверов (такого как гостевые виртуальные машины).

Опции масштабируемости выходят далеко за рамки двух хает-серверов и могут

быть расширены вплоть до 64 узлов на кластер, даже с поддержкой разнесенных географических местоположений. Сложности географически распределенных кластеров для доступности и восстановления не являются темой этого раздела, но они станут более важными, как только вы начнете понимать возможности кластеризации.

Кластеры обычно используются в сценариях с высокой емкостью, высокой ви

димостью и устойчивостью к отказам. Вы проектируете размер и тип кластера на основе определенных потребностей службы или бизнес-деятельности, а также на базересурсов, которые должны быть размещены.

При любом сценарии всегда думайте о кластеризации как о решении, предназначенном для увеличения доступности ваших служб, приложений и компонентов конечным пользователям.

В течение многих лет Windows Server росла как операционная система, и требования по созданию кластера всегда были ключом к успешной реализации кластера.

В следующем примере мы рассмотрим эти требования.

Требования кластеризации

Мы посвятим некоторое время исследованиям требований к настройке класте

ра и ознакомлением с несколькими рекомендуемыми подходами. Но перед тем как

приступить к изучению специфики оборудования, прочитайте статью «Проверка

оборудования для отказоустойчивого кластера», доступную по ссылке http : / /

technet .microsoft . com/ru-ru/library/j j l34244 . aspx.

ИНФОРМАЦИЯ О ПРОВЕРКЕ ДЛЯ WINDOWS 5ERVER 2012 R2

На момент написания этой книги информация о проверке для Windows Server 2012 R2 не была опубликована. Требования, указанные в статье » Проверка оборудования для отказоустойчивого кластера», применимы и продолжат поддерживаться.

Ниже перечислены эти требования.

• Серверы. Наша бригада экспертов, обладатели звания MVP и специалисты из

Microsoft рекомендуют использовать набор оборудования, который содержит

одинаковые или похожие элементы и конфигурацию.

• Сеть. Всегда следует применять несколько сетевых интерфейсных rmaт. Кроме

того, если кластеры используют iSCSI, вы должны разделять трафик сети и

трафик нормальных коммуникаuий либо за счет применения физически разного сетевого оборудования, либо путем логического сегментирования трафи

ка, используя виртуальные сети (VLAN) на коммутаторах.

• Хранилище. Если в кластере задействовано хранилище Seria Attached SCSI или Fiber Channe, то все элементы должны быть идентичны, включая драйверы

НВА и прошитого ПО (finnware). Вы не должны применять множество версий

прошитого ПО или драйверов, даже если производитель их поддерживает.

• Общее хранилище. Общее хранилище представляет собой обязательное требование. В Windows Server 201 2 (и Windows Server 20 12 R2) можно использовать общее хранилище, являющееся локальным через SAS на сервере, наряду с общими файловыми ресурсами SMB 3.0 для всех потребностей кластера.

• Пространства хранения. Если вы ШJанируете применять Serial Attached SCSI, то

в Windows Server 201 2 и Windows Server 201 2 R2 поддерживаются пространства

хранения (Storage Spaces). Пространства хранения обсуждаются в главе 12, но

в отношении пространств хранения и кластеров можно указать несколько ба

зовых требований.

• Необходимо иметь минимум три физических дисковых устройства SAS.

• Устройства должны обладать емкостью минимум 4 Гбайт.

• Устройства не могут быть загрузочными дисками; они должны быть выделе

ны в качестве пула хранения.

• При конфигурировании пространств хранения кластеры поддерживают

только простые или зеркальные типы.

Функциональность кластеризации

Кластеризация — это сочетание программного обеспечения и оборудования, и

она может охватывать физические серверы или виртуальные машины. В Windows

Server 2012 R2 имеются встроенные компоненты и инструменты для развертывания кластеров, включая удобный мастер предварительных условий, который позволяет проверить, что для успешной настройки кластера присутствуют все компоненты и конфигурации.

Со времен версии Windows Server 2008 R2 в кластеризаuию бьvти внесены многие

усовершенствования. На кластеризацию оказывают влияние улучшения операuион

ной системы, но ее средства остались на прежних местах и обладают теми же возможностями, что и в предшествующих версиях, с крупным усовершенствованием, таким как масштабируемость кластеров. В Windows Server 2012 и Windows Server 2012

R2 предлагается увеличенная масштабируемость в рамках компонента Hyper-V

Failover Clustering (Кластеризация с обходом отказа Hyper-V), который теперь поддерживает вплоть до 64 узлов и 8 ООО виртуальных машин на кластер.

Кроме того, в Microsoft представили концепuию постоянной доступности. Она

включает объединение сетевых интерфейсных плат, поддержку обновления с учетом кластера (Cluster-Aware Updating) и масштабируемые файловые серверы (Scale-Out File Server — SOFS). Постоянная доступность — это сквозной мониторинг с вариантами его проведения вверх и вниз внутри целого стека кластеров.

• Обновления с учетом кластера. Cluster-Aware Updating — это служба, поддерживаемая заново сконструированными службами обновления Windows Seller

Update Sellices (дополнительные сведения ищите в главе 3 1 тома 2). Данный компонент переместит рабочую нагрузку или виртуальные машины в другой

узел кластера, обработает обновление (при необходимости инициируя перезагрузку), после чего возвратит рабочую нагрузку обратно и продолжит со следующим узлом кластера.

• Использование виртуальных дисков Hyper-V как открытого хранилища. Вероятно,

одной из лучших особенностей Windows Seller 2012 и Windows Seller 201 2 R2

считается возможность употребления виртуальных дисков Hyper-V (только в

формате VHDX) в качестве открытого хранилища для гостевой кластеризации,

что значительно расширяет масштабируемость и доступность внутри виртуаль

ной инфраструктуры, а также позволяет строить масштабируемые файловые

серверы. Наиболее важно то, что появляется возможность применения файлов

VHDX для кластеризации без SAN.

Правильно реализованное решение кластеризации с обходом отказа доведет до

максимума продуктивность бизнес-деятельности и отточит уровни обслуживания.

Отказоустойчивым центром данных является такой центр, который располагает

пулами ресурсов для вычислительной мощности, хранилищем и сетевыми ресурсами.

При построении среды кластеризации с обходом отказа с помощью Windows Server 201 2 R2 вы начинаете с физического уровня, т.е. с сети.

На рис. 1 1 .2 показан отдельный сервер с двумя физическими платами N IC и

множеством виртуальных адаптеров.

Благодаря постоянной доступности, вы получаете не только более высокую надежность, но также улучшенные показатели производительности. При таком подходе вы объединяете множество подключений для увеличения полосы пропускания, доступной операционной системе, и обеспечения отказоустойчивости, если отказывает порт NIC, отключается кабель или перестает работать физическая плата .

…

Виртуальный сетевой коммутатор

Сетевое объединение

Физический адаптер 1

Физический адаптер 2

Рис. 1 1 .2. Физические и виртуальные адаптеры

Общие тома кластера

Общие тома кластера (Cluster Shared Yolurne — CSV) являются компонентом

кластеризации с обходом отказа и впервые были введены в Windows Seiver 2008 R2.

Тома CSV проектировались специально дЛЯ виртуализации. Их базовое применение

было связано с упрощением хранилища для виртуальных машин. Если вы не ис

пользуете том CSV с серверами Hyper-Y, то доступ к вашему диску возможен только со стороны одного узла в каждый момент времени. Конфигурирование тома CSV позволяет применять обычный общий диск, упрощает задачи управления хранилищем дЛЯ Hyper-V и допускает существование множества файлов VHD.