В статье приводится краткий обзор

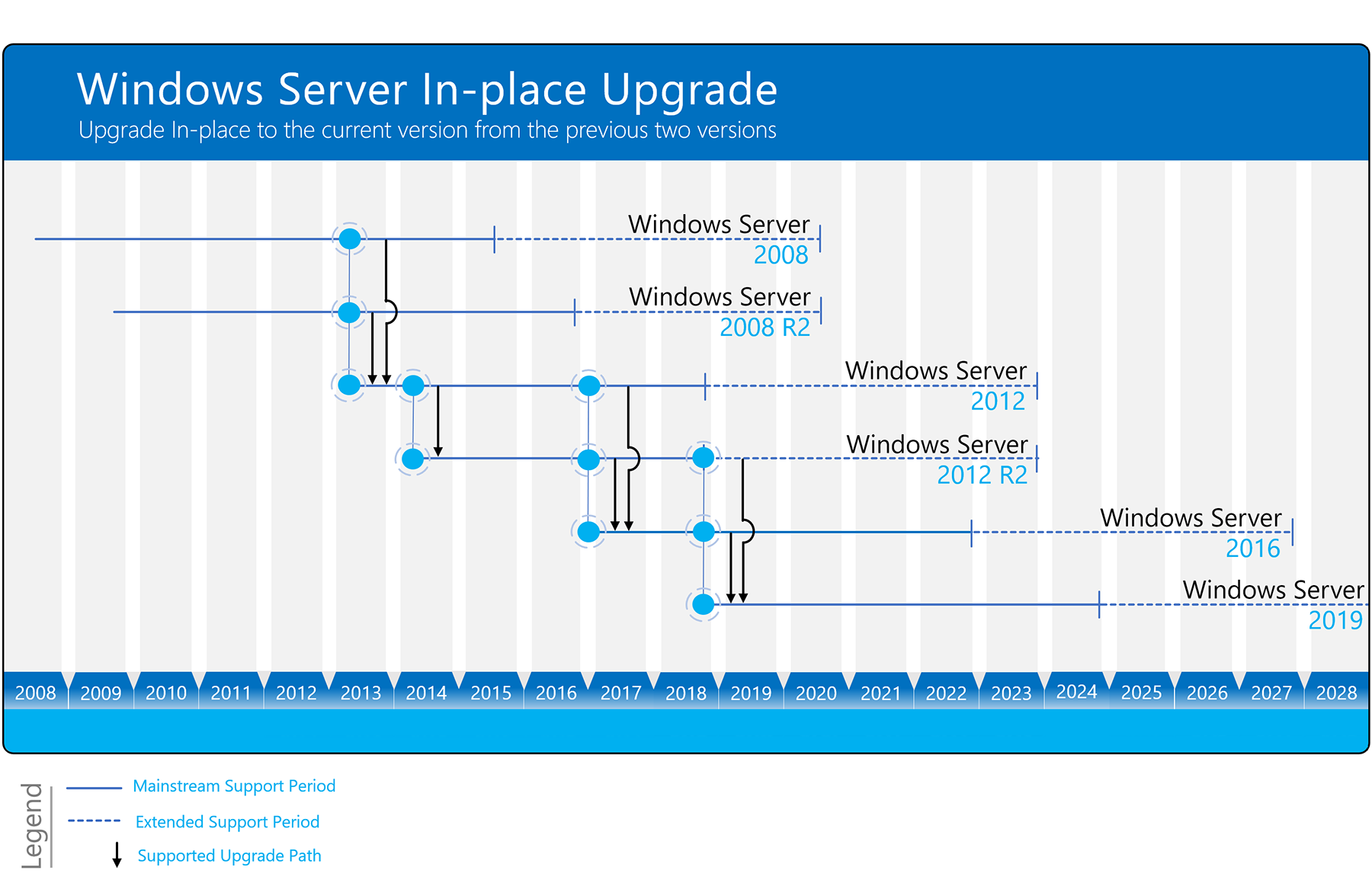

создания отказоустойчивого кластера Microsoft Windows (WFC) в ОС Windows Server

2019 или 2016. В результате вы получите двухузловой кластер с одним общим

диском и кластерный вычислительный ресурс (объект «компьютер» в Active

Directory).

Подготовка

Не имеет значения, какие машины вы

используете — физические или виртуальные, главное, чтобы технология подходила

для создания кластеров Windows. Перед тем, как начать, проверьте соответствие

необходимым требованиям:

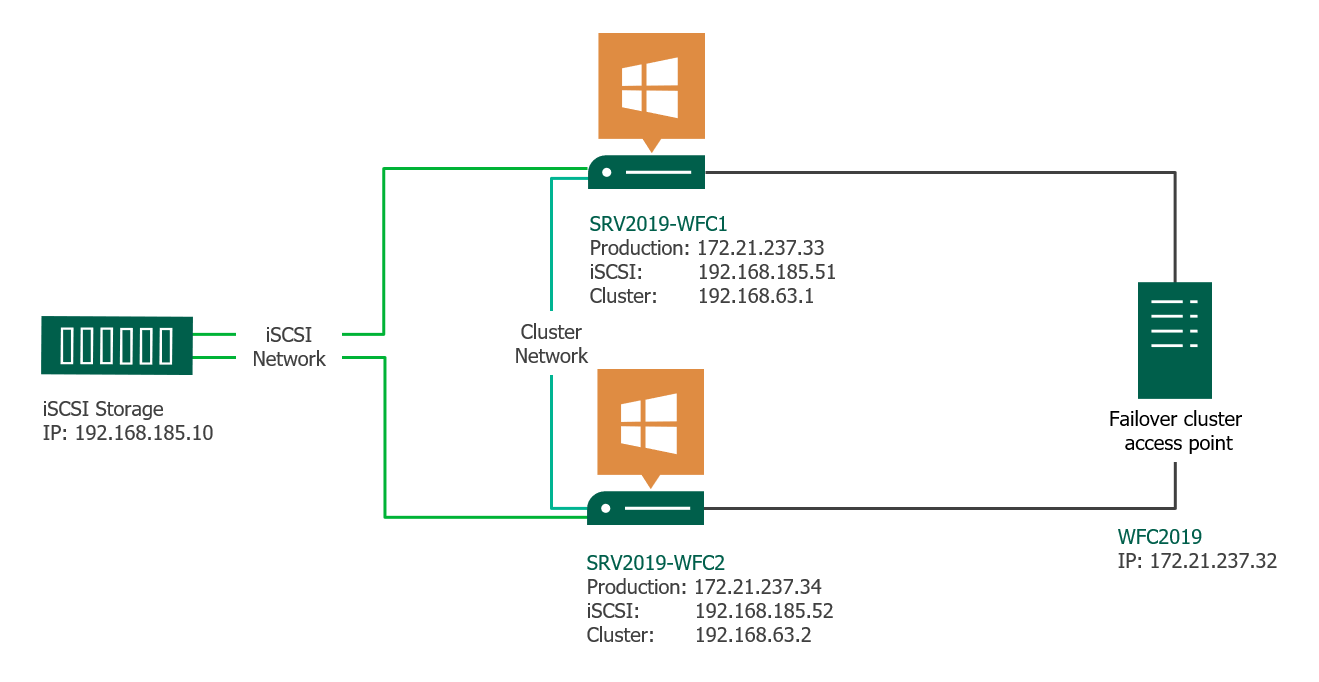

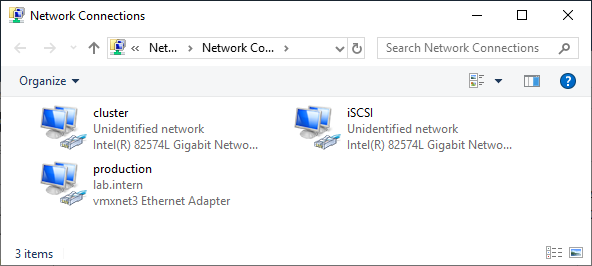

Две машины Windows 2019 с установленными последними обновлениями. У них должно быть по крайней мере два сетевых интерфейса: один для производственного трафика и один для кластерного трафика. В моем примере у машин три сетевых интерфейса (один дополнительный для трафика iSCSI). Я предпочитаю статические IP-адреса, но также можно использовать DHCP.

Введите оба сервера в домен

Microsoft Active Directory и убедитесь, что они видят общий ресурс хранения,

доступный в Disk Management. Пока не переводите диск в режим «онлайн».

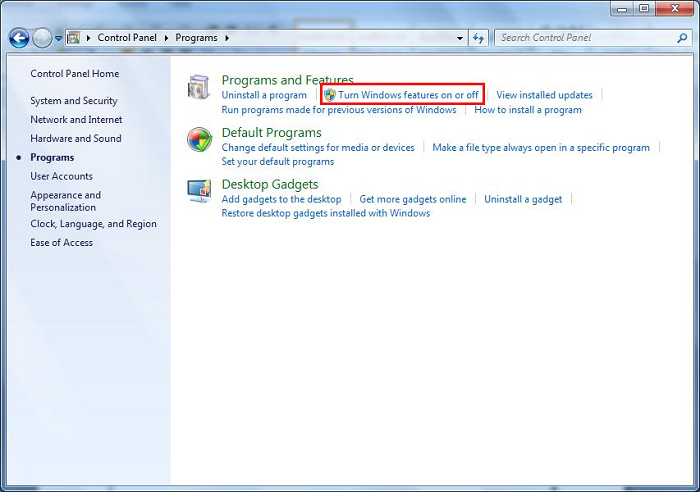

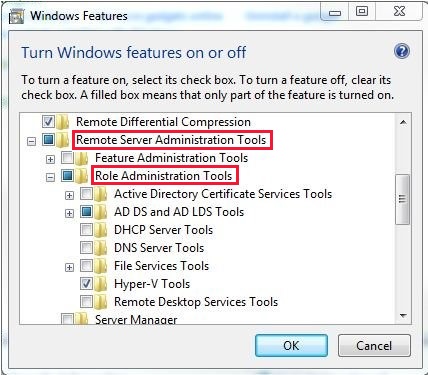

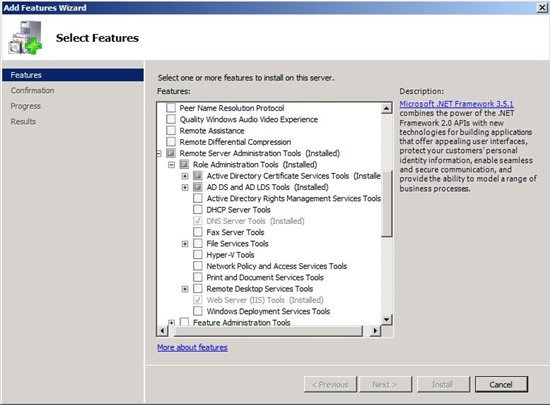

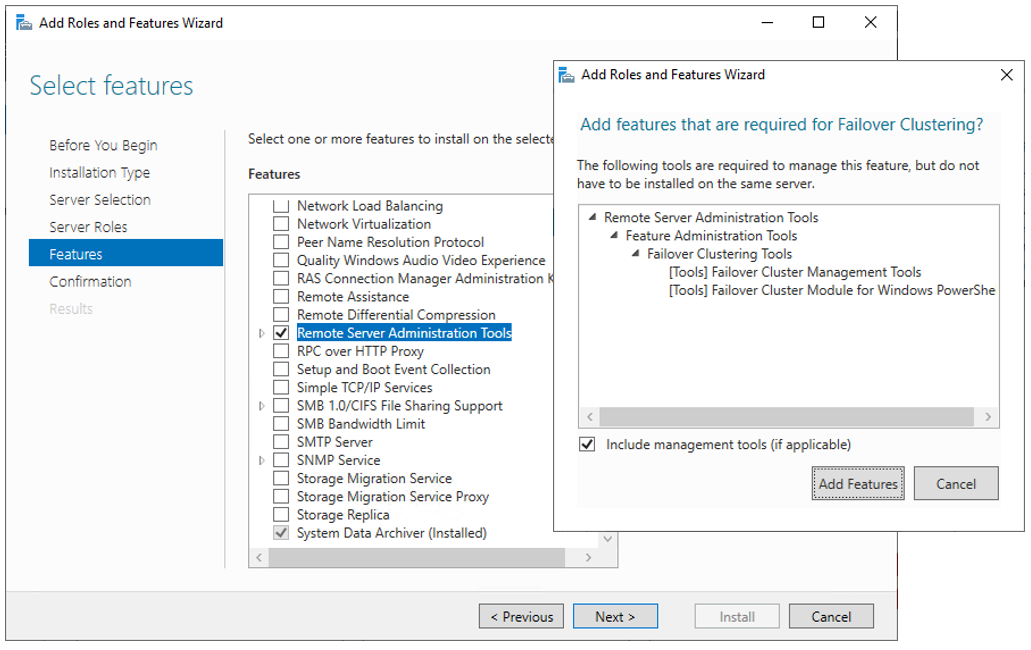

Далее необходимо добавить функциональность Failover clustering (Server Manager > Аdd roles and features).

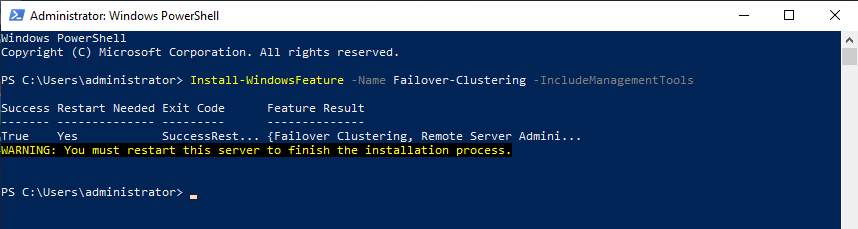

Перезапустите сервер, если требуется. В качестве альтернативы можно использовать следующую команду PowerShell:

Install-WindowsFeature -Name Failover-Clustering –IncludeManagementTools

После успешной установки в меню

Start, в Windows

Administrative Tools появится Failover Cluster Manager .

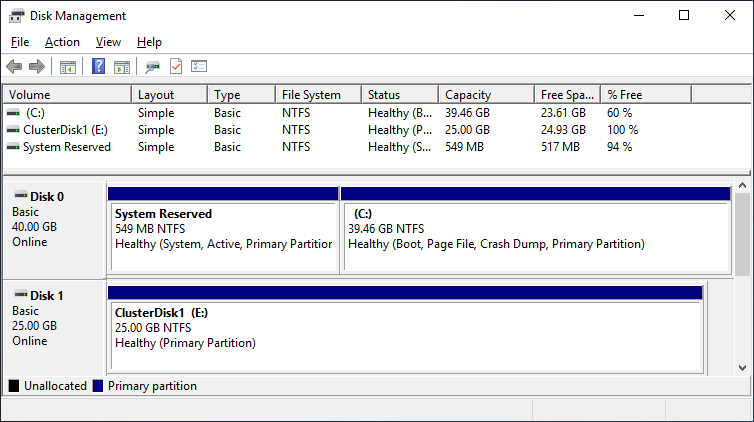

После установки Failover-Clustering

можно перевести общий диск в режим «онлайн» и отформатировать его на одном из

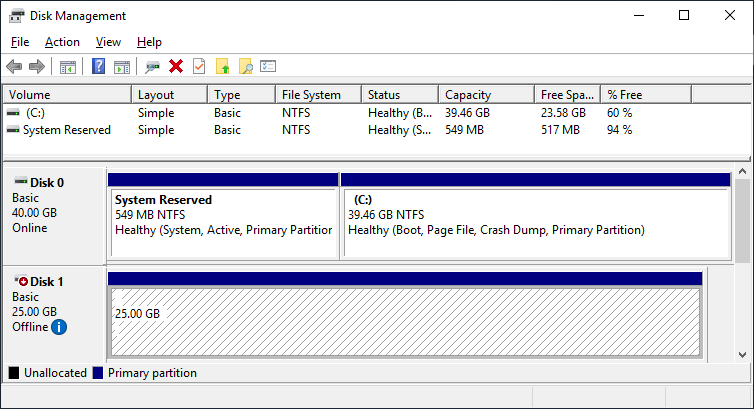

серверов. Не меняйте ничего на втором сервере. Там диск остается в режиме

offline.

Обновив Disk Management, вы увидите

что-то типа такого:

Server 1 Disk Management (disk status online)

Server 2 Disk Management (disk status offline)

Проверка готовности

отказоустойчивого кластера

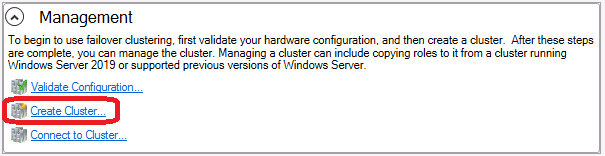

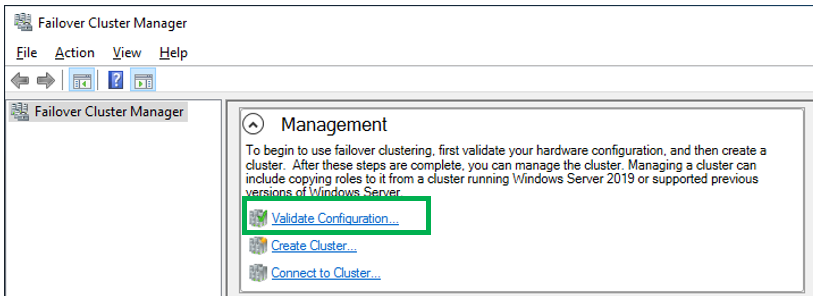

Перед созданием кластера необходимо убедиться, что все настройки правильно сконфигурированы. Запустите Failover Cluster Manager из меню Start, прокрутите до раздела Management и кликните Validate Configuration.

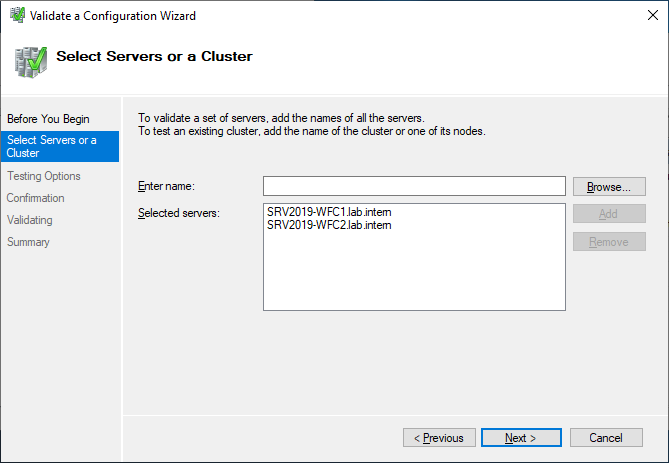

Выберите для валидации оба сервера.

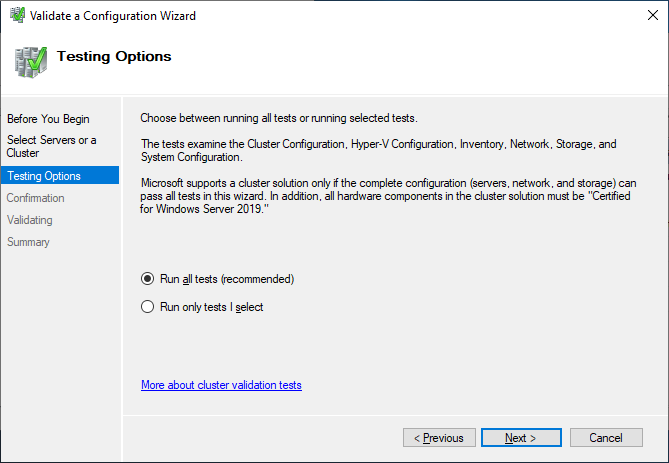

Выполните все тесты. Там же есть описание того, какие решения поддерживает Microsoft.

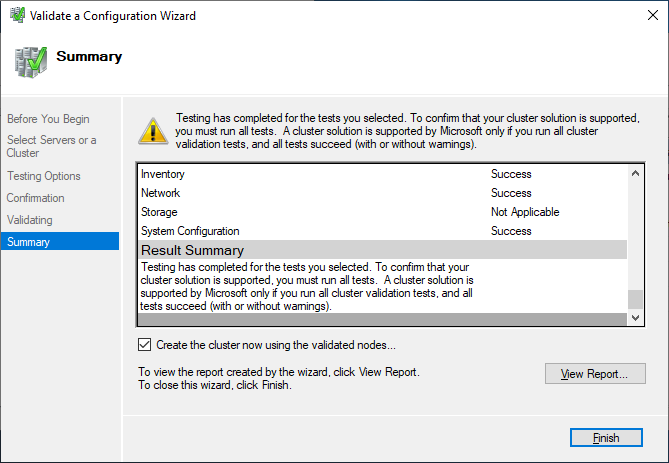

После успешного прохождения всех нужных тестов, можно создать кластер, установив флажок Create the cluster now using the validated nodes (создать кластер с помощью валидированных узлов), или это можно сделать позже. Если во время тестирования возникали ошибки или предупреждения, можно просмотреть подробный отчет, кликнув на View Report.

Создание отказоустойчивого

кластера

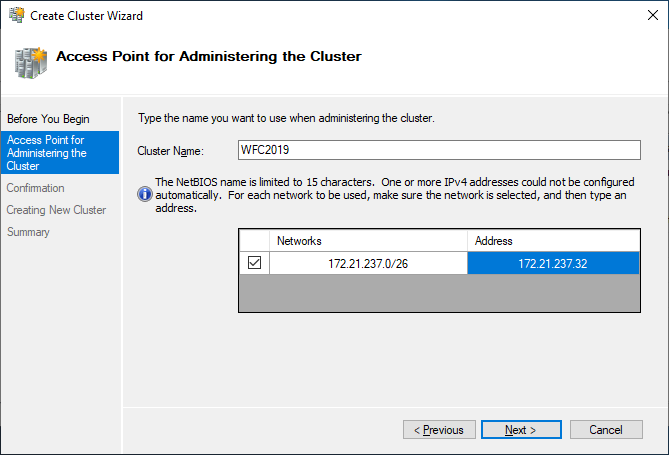

Если вы решите создать кластер,

кликнув на Create Cluster в Failover Cluster Manager,

потребуется снова выбрать узлы кластера. Если вы используете флажок Create

the cluster now using the validated nodes в мастере валидации

кластера, выбирать узлы не понадобится. Следующим шагом будет создание точки

доступа для администрирования кластера — Access Point for

Administering the Cluster. Это будет виртуальный объект, с которым позже

будут коммуницировать клиенты. Это объект «компьютер» в Active Directory.

В мастере нужно будет задать имя кластера — Cluster Name и сетевую конфигурацию.

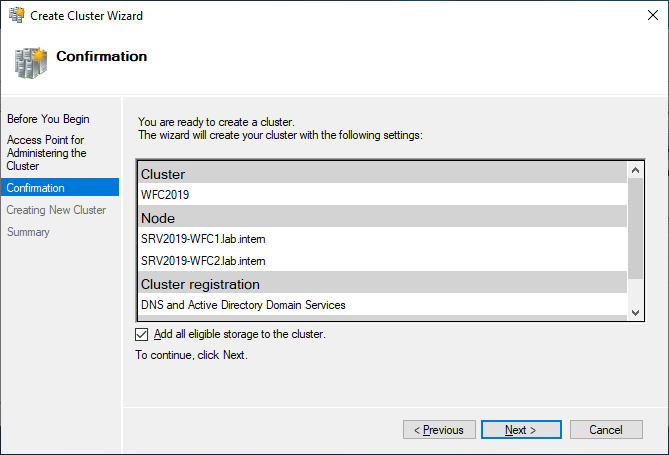

На последнем шаге подтвердите выбранные настройки и подождите создания кластера.

По умолчанию мастер автоматически

добавит общий диск к кластеру. Если вы его еще не сконфигурировали, будет

возможность сделать это позже.

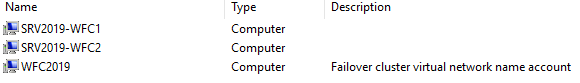

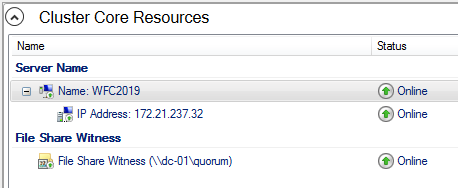

В результате вы увидите новый объект «компьютер» Active Directory под названием WFC2019.

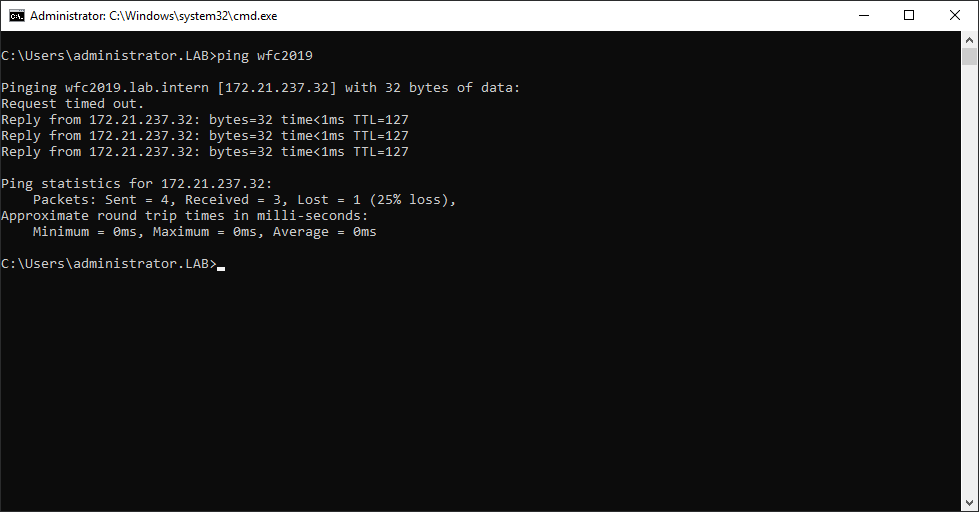

Вы можете отправить запрос к новому компьютеру, чтобы убедиться в его доступности (если ICMP-запросы разрешены в брандмауере Windows).

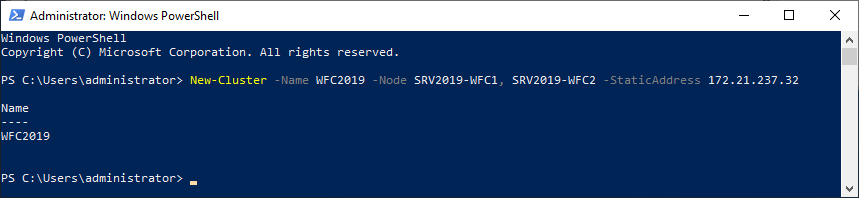

В качестве альтернативы можно создать кластер с помощью PowerShell. Следующая команда автоматически добавит подходящее хранилище:

New-Cluster -Name WFC2019 -Node SRV2019-WFC1, SRV2019-WFC2 -StaticAddress 172.21.237.32

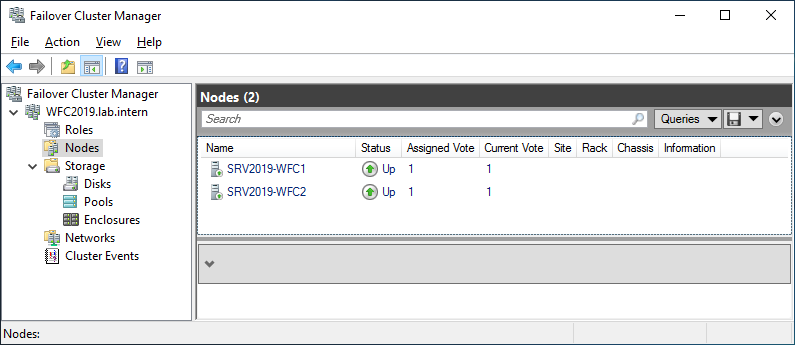

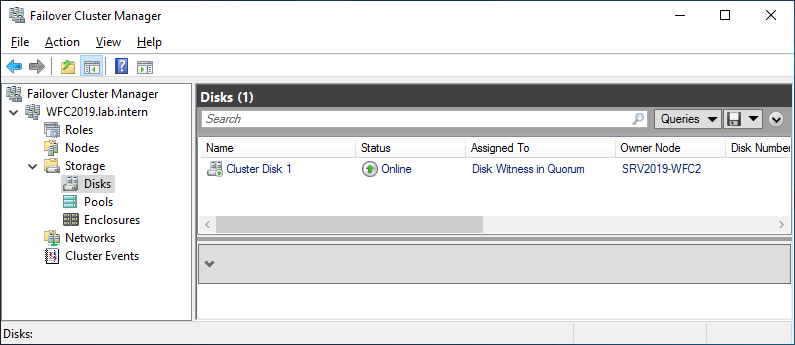

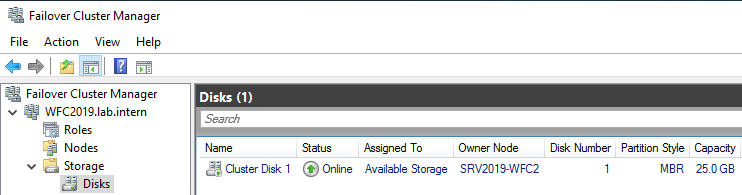

Результат можно будет увидеть в Failover Cluster Manager, в разделах Nodes и Storage > Disks.

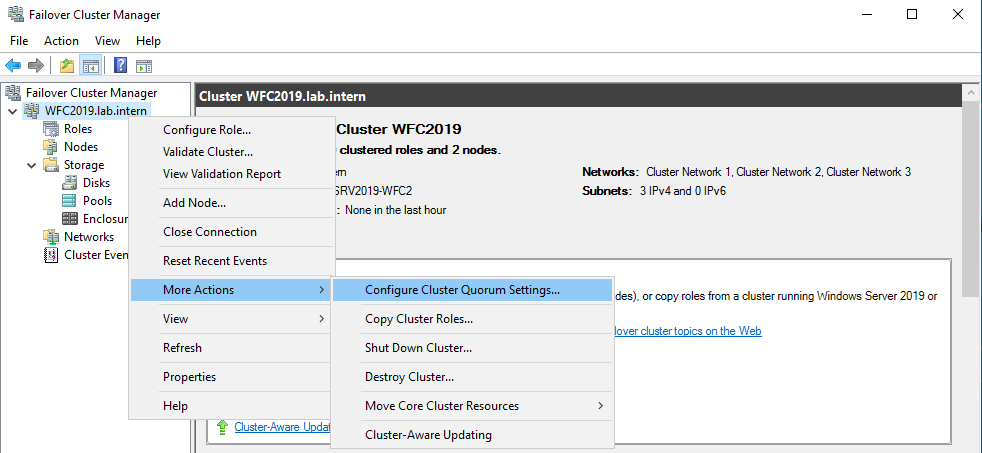

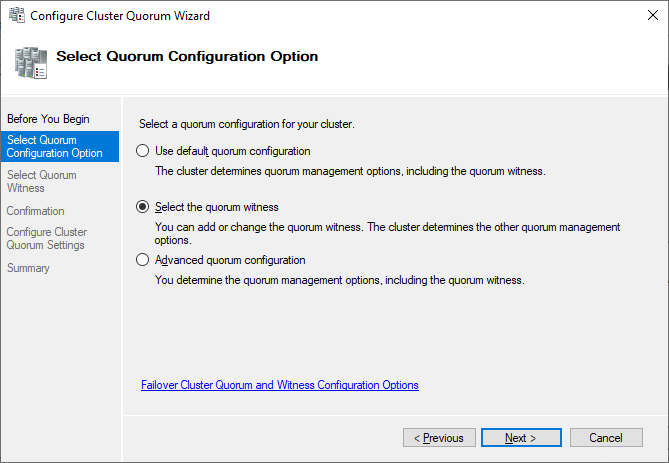

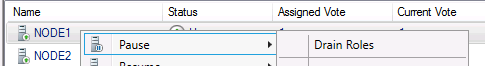

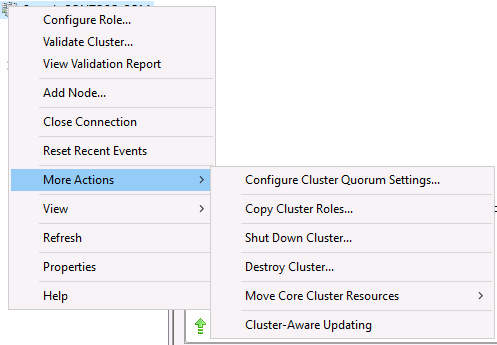

Иллюстрация показывает, что в данный момент диск используется в качестве кворума. Поскольку мы хотим использовать этот диск для данных, нам необходимо сконфигурировать кворум вручную. Из контекстного меню кластера выберите More Actions > Configure Cluster Quorum Settings (конфигурирование настроек кворума).

Мы хотим выбрать диск-свидетель вручную.

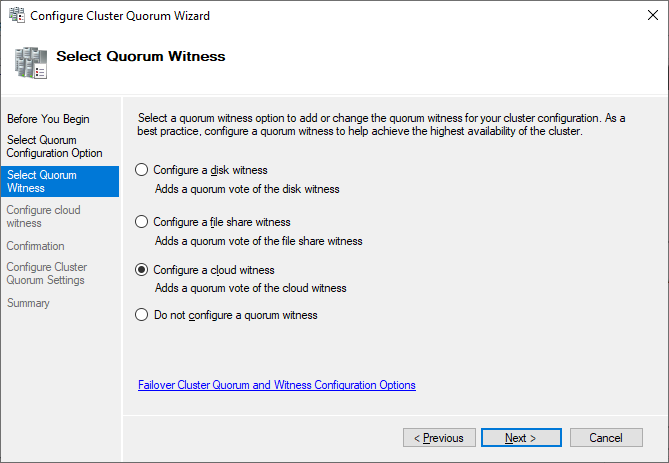

В данный момент кластер использует диск, ранее сконфигурированный как диск-свидетель. Альтернативно можно использовать в качестве свидетеля общую папку или учетную запись хранилища Azure. В этом примере мы используем в качестве свидетеля общую папку. На веб-сайте Microsoft представлены пошаговые инструкции по использованию свидетеля в облаке. Я всегда рекомендую конфигурировать свидетель кворума для правильной работы. Так что, последняя опция для производственной среды не актуальна.

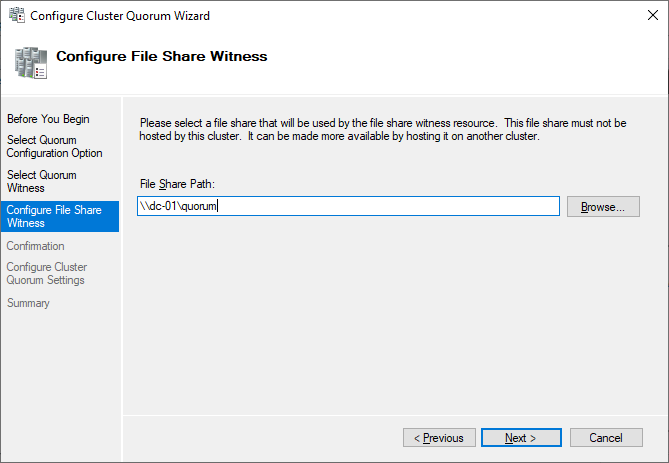

Просто укажите путь и завершите мастер установки.

После этого общий диск можно использовать для работы с данными.

Поздравляю, вы сконфигурировали отказоустойчивый кластер Microsoft с одним общим диском.

Следующие шаги и резервное

копирование

Одним из следующих шагов будет

добавление роли для кластера, но это выходит за рамки данной статьи. Когда

кластер будет содержать данные, пора будет подумать о его резервном копировании.

Veeam Agent for Microsoft Windows может применяться для

резервного копирования отказоустойчивых кластеров Windows с общими дисками. Мы

также рекомендуем осуществлять резервное копирование «всей системы» кластера.

При этом выполняется резервное копирование операционных систем узлов кластера.

Это поможет ускорить восстановление отказавшего узла кластера, так как вам не

придется искать драйверы и прочее при восстановлении.

Руководство по созданию отказоустойчивых

кластеров для Windows Server 2019

Для того, для чего вы хотите — никак не создать.

Кластер — это даже согласно статье из Википедии, которую вы приводите — это слабо связанная вычислительная система.

Попробую объяснить, используя аналогию.

Вы считаете, что компьютеры можно объединять также, как можно объединять усилия людей, наполняющих бочку водой, таская ее ведрами. Один человек наполнит за час, два — за полчаса, и так далее. Но это процесс, который распараллеливается элементарно.

А на самом деле, кластер работает подобно команде сценаристов, которые пишут сценарий сериала из двадцати серий, работая удаленно по бумажной почте: сначала главный сценарист придумывает персонажей и общий сюжет, записывает это, потом ему нужно разбить его на серии и отослать каждому из сценаристов, указав, какую серию тому нужно прописать в подробностях. Если бы он писал все сам, ему бы понадобилось по неделе на серию, итого — двадцать недель. А съемки можно начинать, когда готова первая серия (через неделю). Поскольку съемки одной серии занимают три дня, съемочная группа будет простаивать четыре дня из каждой недели, пока не будет готова следующая серия (деньги во время простоя тоже расходуются, хотя ничего не производится). Съемки будут, таким образом, завершены через 20*7+3=143 дня.

Наемным сценаристам тоже нужно по неделе на написании серий, но начальная работа главного сценариста тоже занимает неделю, плюс — три дня на доставку «каркаса сценария» наемным сценаристам, три дня на доставку сценария серий обратно, еще пять дней на проверку и исправление нестыковок. Итог — начинать съемки можно только через 25 дней, а не через семь, но продолжать их можно уже непрерывно. Съемки будут завершены через 25+3*20=85 дней.

Ровно как здесь нельзя ускорить процесс еще больше, заставив больше сценаристов писать по половине серии (потому что при этом растет сложность стыковки кусков сюжета, которые написаны разными людьми, потому им придется переписываться, теряя время), так и пытаясь запустить на кластере условную игру, придется просадить кучу времени на медленное общение узлов между собой по сети.

Чтобы всё «летало» в реальном времени в игре, вам нужен один мощный компьютер с многоядерным процессором, мощной видеокартой и быстрой шиной, которая всех их объединяет. А собрать кластер из сотни древних ноутов на медленном Ethernet и получить производительность в сто раз больше в играх — это фантастика из дурацких фильмов про хакеров.

(К слову, говоря, при этом есть возможность собрать недорогой и эффективный кластер из xbox 360 или PS3, процессоры там примерно как Power, и на миллион можно купить не одну приставку.)

Исходя из этого отметим интересные по цене варианты построения высокопроизводительной системы. Разумеется, она должна быть многопроцессорной. У Intel для таких задач используются процессоры Xeon, у AMD – Opteron.

Если много денег

Топовый процессор этой серии – E7-8870 с десятью ядрами 2,4 ГГц. Его цена $4616. Для таких CPU фирмы HP и Supermicro выпускают! восьмипроцессорные! серверные шасси. Восемь 10-ядерных процессоров Xeon E7-8870 2.4 ГГц с поддержкой HyperThreading поддерживают 8*10*2=160 потоков, что в диспетчере задач Windows отображается как сто шестьдесят графиков загрузки процессоров, матрицей 10×16.

Для того, чтобы восемь процессоров уместились в корпусе, их размещают не сразу на материнской плате, а на отдельных платах, которые втыкаются в материнскую плату. На фотографии показаны установленные в материнскую плату четыре платы с процессорами (по два на каждой). Это решение Supermicro. В решении HP на каждый процессор приходится своя плата. Стоимость решения HP составляет два-три миллиона, в зависимости от наполнения процессорами, памятью и прочим. Шасси от Supermicro стоит $10 000, что привлекательнее. Кроме того в Supermicro можно поставить четыре сопроцессорных платы расширения в порты PCI-Express x16 (кстати, еще останется место для Infiniband-адаптера чтобы собирать кластер из таких), а в HP только две. Таким образом, для создания суперкомпьютера восьмипроцессорная платформа от Supermicro привлекательнее. На следующем фото с выставки представлен суперкомпьютер в сборе с четырьмя GPU платами.

Однако это очень дорого.

Что подешевле

Зато есть перспектива сборки суперкомпьютера на более доступных процессорах AMD Opteron G34, Intel Xeon LGA2011 и LGA 1366.

Чтобы выбрать конкретную модель, я составил таблицу, в которой сосчитал для каждого процессора показатель цена/(число ядер*частота). Я отбросил из расчета процессоры частотой ниже 2 ГГц, и для Intel — с шиной ниже 6,4GT/s.

| Модель |

Кол-во ядер |

Частота |

Цена, $ |

Цена/ядро, $ |

Цена/Ядро/ГГц |

| AMD |

|||||

| 6386 SE |

16 | 2,8 | 1392 | 87 | 31 |

| 6380 | 16 | 2,5 | 1088 | 68 | 27 |

| 6378 | 16 | 2,4 | 867 | 54 | 23 |

| 6376 | 16 | 2,3 | 703 | 44 | 19 |

| 6348 | 12 | 2,8 | 575 | 48 | 17 |

| 6344 |

12 | 2,6 | 415 | 35 | 13 |

| 6328 | 8 | 3,2 | 575 | 72 | 22 |

| 6320 | 8 | 2,8 | 293 | 37 | 13 |

| INTEL |

|||||

| E5-2690 | 8 | 2,9 | 2057 | 257 | 89 |

| E5-2680 | 8 | 2,7 | 1723 | 215 | 80 |

| E5-2670 | 8 | 2,6 | 1552 | 194 | 75 |

| E5-2665 | 8 | 2,4 | 1440 | 180 | 75 |

| E5-2660 | 8 | 2,2 | 1329 | 166 | 76 |

| E5-2650 | 8 | 2 | 1107 | 138 | 69 |

| E5-2687W |

8 | 3,1 | 1885 | 236 | 76 |

| E5-4650L | 8 | 2,6 | 3616 | 452 | 174 |

| E5-4650 | 8 | 2,7 | 3616 | 452 | 167 |

| E5-4640 | 8 | 2,4 | 2725 | 341 | 142 |

| E5-4617 | 6 | 2,9 | 1611 | 269 | 93 |

| E5-4610 | 6 | 2,4 | 1219 | 203 | 85 |

| E5-2640 | 6 | 2,5 | 885 | 148 | 59 |

| E5-2630 |

6 | 2,3 | 612 | 102 | 44 |

| E5-2667 | 6 | 2,9 | 1552 | 259 | 89 |

| X5690 | 6 | 3,46 | 1663 | 277 | 80 |

| X5680 | 6 | 3,33 | 1663 | 277 | 83 |

| X5675 | 6 | 3,06 | 1440 | 240 | 78 |

| X5670 | 6 | 2,93 | 1440 | 240 | 82 |

| X5660 | 6 | 2,8 | 1219 | 203 | 73 |

| X5650 | 6 | 2,66 | 996 | 166 | 62 |

| E5-4607 | 6 | 2,2 | 885 | 148 | 67 |

| X5687 | 4 | 3,6 | 1663 | 416 | 115 |

| X5677 | 4 | 3,46 | 1663 | 416 | 120 |

| X5672 | 4 | 3,2 | 1440 | 360 | 113 |

| X5667 | 4 | 3,06 | 1440 | 360 | 118 |

| E5-2643 | 4 | 3,3 | 885 | 221 | 67 |

Жирным курсивом выделена модель с минимальным показателем соотношения, подчеркнутым – самый мощный AMD и на мой взгляд наиболее близкий по производительности Xeon.

Таким, образом, мой выбор процессоров для суперкомпьютера – Opteron 6386 SE, Opteron 6344, Xeon E5-2687W и Xeon E5-2630.

Материнские платы

PICMG

На обычные материнские платы невозможно поставить более четырех двухслотовых плат расширения. Есть и другая архитектура – использование кросс-плат, таких как BPG8032 PCI Express Backplane.

В такую плату ставятся платы расширения PCI Express и одна процессорная плата, чем-то похожая на те, которые установлены в восьмипроцессорных серверах на базе Supermicro, о которых речь шла выше. Но только эти процессорные платы подчиняются отраслевым стандартам PICMG. Стандарты развиваются медленно и такие платы зачастую не поддерживают самые современные процессоры. Максимум такие процессорные платы сейчас выпускают на два Xeon E5-2448L — Trenton BXT7059 SBC.

Стоить такая система будет без GPU не меньше $5000.

Готовые платформы TYAN

За ту же примерно сумму можно приобрести готовую платформу для сборки суперкомпьютеров TYAN FT72B7015 . В такой можно установить до восьми GPU и два Xeon LGA1366.

«Обычные» серверные материнские платы

Для LGA2011

Supermicro X9QR7-TF — на эту материнскую плату можно установить 4 Платы расширения и 4 процессора.

Supermicro X9DRG-QF — эта плата специально разработана для сборки высокопроизводительных систем.

Для Opteron

Supermicro H8QGL-6F — эта плата позволяет установить четыре процессора и три платы расширения

Усиление платформы платами расширения

Этот рынок почти полностью захвачен NVidia, которые выпускают помимо геймерских видеокарт еще и вычислительные карты. Меньшую долю рынка имеет AMD, и относительно недавно на этот рынок пришла корпорация Intel.

Особенностью таких сопроцессоров является наличие на борту большого объема оперативной памяти, быстрые расчеты с двойной точностью и энергоэффективность.

| FP32, Tflops | FP64, Tflops | Цена | Память, Гб | |

| Nvidia Tesla K20X | 3.95 | 1.31 | 5.5 | 6 |

| AMD FirePro S10000 | 5.91 | 1.48 | 3.6 | 6 |

| Intel Xeon Phi 5110P | 1 | 2.7 | 8 | |

| Nvidia GTX Titan | 4.5 | 1.3 | 1.1 | 6 |

| Nvidia GTX 680 | 3 | 0.13 | 0.5 | 2 |

| AMD HD 7970 GHz Edition | 4 | 1 | 0.5 | 3 |

| AMD HD 7990 Devil 13 | 2×3,7 | 2х0.92 | 1.6 | 2×3 |

Топовое решение от Nvidia называется Tesla K20X на архитектуре Kepler. Именно такие карты стоят в самом мощном в мире суперкомпьютере Titan. Однако недавно Nvidia выпустила видеокарту Geforce Titan. Старые модели были с урезанной производительностью FP64 до 1/24 от FP32 (GTX680). Но в Титане производитель обещает довольно высокую производительность в расчетах с двойной точностью. Решения от AMD тоже неплохи, но они построены на другой архитектуре и это может создать трудности для запуска вычислений, оптимизированных под CUDA (технология Nvidia).

Решение от Intel — Xeon Phi 5110P интересно тем, что все ядра в сопроцессоре выполнены на архитектуре x86 и не требуется особой оптимизации кода для запуска расчетов. Но мой фаворит среди сопроцессоров – относительно недорогая AMD HD 7970 GHz Edition. Теоретически эта видеокарта покажет максимальную производительность в расчете на стоимость.

Можно соединить в кластер

Для повышения производительности системы несколько компьютеров можно объединить в кластер, который будет распределять вычислительную нагрузку между входящими в состав кластера компьютерами.

Использовать в качестве сетевого интерфейса для связи компьютеров обычный гигабитный Ethernet слишком медленно. Для этих целей чаще всего используют Infiniband. Хост адаптер Infiniband относительно сервера стоит недорого. Например, на международном аукционе Ebay такие адаптеры продают по цене от $40. Например, адаптер X4 DDR (20Gb/s) обойдется с доставкой до России примерно в $100.

При этом коммутационное оборудование для Infiniband стоит довольно дорого. Да и как уже было сказано выше, классическая звезда в качестве топологии вычислительной сети – не лучший выбор.

Однако хосты InfiniBand можно подключать друг к другу напрямую, без свича. Тогда довольно интересным становится, например, такой вариант: кластер из двух компьютеров, соединенных по infiniband. Такой суперкомпьютер вполне можно собрать дома.

Сколько нужно видеокарт

В самом мощном суперкомпьютере современности Cray Titan отношение процессоров к «видеокартам» 1:1, то есть в нем 18688 16-ядерных процессоров и 18688 Tesla K20X.

В Тяньхэ-1А – китайском суперкомпьютере на ксеонах отношение следующее. Два шестиядерных процессора к одной «видюшке» Nvidia M2050 (послабее, чем K20X).

Такое отношение мы и примем для наших сборок за оптимальное (ибо дешевле). То есть 12-16 ядер процессоров на один GPU. На таблице ниже жирным обозначены практически возможные варианты, подчеркиванием – наиболее удачные с моей точки зрения.

| GPU | Cores | 6-core CPU | 8-core CPU | 12-core CPU | 16-core CPU | |||||

| 2 | 24 | 32 | 4 |

5 | 3 |

4 |

2 |

3 |

2 |

2 |

| 3 | 36 | 48 | 6 | 8 | 5 | 6 | 3 |

4 |

2 |

3 |

| 4 | 48 | 64 | 8 | 11 | 6 | 8 | 4 |

5 | 3 |

4 |

Если система с уже установленным отношением процессоров/видеокарт сможет принять «на борт» еще дополнительно вычислительных устройств, то мы их добавим, чтобы увеличить мощность сборки.

Итак, сколько стоит

Представленные ниже варианты – шасси суперкомпьютера без оперативной памяти, жестких дисков и ПО. Во всех моделях используется видеоадаптер AMD HD 7970 GHz Edition. Его можно заменить на другой, по требованию задачи (например, на xeon phi). Там, где система позволяет, одна из AMD HD 7970 GHz Edition заменена на трехслотовую AMD HD 7990 Devil 13.

Вариант 1 на материнской плате Supermicro H8QGL-6F

| Материнская плата | Supermicro H8QGL-6F |

1 | 1200 | 1200 |

| Процессор | AMD Opteron 6344 | 4 | 500 | 2000 |

| Кулер Процессора | Thermaltake CLS0017 | 4 | 40 | 160 |

| Корпус 1400Вт | SC748TQ-R1400B | 1 | 1000 | 1000 |

| Графический ускоритель | AMD HD 7970 GHz Edition | 3 | 500 | 1500 |

| 5860 |

Теоретически, производительность составит около 12 Tflops.

Вариант 2 на материнской плате TYAN S8232, кластерный

Эта плата не поддерживает Opteron 63xx, поэтому используется 62xx. В этом варианте два компьютера объединены в кластер по Infiniband x4 DDR двумя кабелями. Теоретически скорость соединения в этом случае упрется в скорость PCIe x8 то есть 32Гб/с. Блоков питания используется два. Как их согласовать между собой, можно найти в интернете.

| Количество | Цена | Сумма | ||

| Материнская плата | TYAN S8232 | 1 | 790 | 790 |

| Процессор | AMD Opteron 6282SE | 2 | 1000 | 2000 |

| Кулер Процессора | Noctua NH-U12DO A3 | 2 | 60 | 120 |

| Корпус | Antec Twelve Hundred Black | 1 | 200 | 200 |

| Блок питания | FSP AURUM PRO 1200W | 2 | 200 | 400 |

| Графический ускоритель | AMD HD 7970 GHz Edition | 2 | 500 | 1000 |

| Графический ускоритель | AX7990 6GBD5-A2DHJ | 1 | 1000 | 1000 |

| Infiniband адаптер | X4 DDR Infiniband | 1 | 140 | 140 |

| Infiniband кабель | X4 DDR Infiniband | 1 | 30 | 30 |

| 5680 (за один блок) |

Для кластера таких конфигураций нужно две и стоимость их составит $11360

. Его энергопотребление при полной нагрузке будет около 3000Вт. Теоретически, производительность составит до 31Tflops.

Сегодня бизнес-процессы многих компаний полностью завязаны на информационных

технологиях. С ростом такой зависимости организаций от работы вычислительных

сетей доступность сервисов в любое время и под любой нагрузкой играет большую

роль. Один компьютер может обеспечить лишь начальный уровень надежности и

масштабируемости, максимального же уровня можно добиться за счет объединения в

единую систему двух или нескольких компьютеров — кластер.

Для чего нужен кластер

Кластеры применяют в организациях, которым нужна круглосуточная и

бесперебойная доступность сервисов и где любые перерывы в работе нежелательны и

недопустимы. Или в тех случаях, когда возможен всплеск нагрузки, с которым может

не справиться основной сервер, тогда ее помогут компенсировать дополнительные

хосты, выполняющие обычно другие задачи. Для почтового сервера, обрабатывающего

десятки и сотни тысяч писем в день, или веб-сервера, обслуживающего

онлайн-магазины, использование кластеров очень желательно. Для пользователя

подобная система остается полностью прозрачной — вся группа компьютеров будет

выглядеть как один сервер. Использование нескольких, пусть даже более дешевых,

компьютеров позволяет получить весьма существенные преимущества перед одиночным

и шустрым сервером. Это равномерное распределение поступающих запросов,

повышенная отказоустойчивость, так как при выходе одного элемента его нагрузку

подхватывают другие системы, масштабируемость, удобное обслуживание и замена

узлов кластера, а также многое другое. Выход из строя одного узла автоматически

обнаруживается, и нагрузка перераспределяется, для клиента все это останется

незамеченным.

Возможности Win2k3

Вообще говоря, одни кластеры предназначены для повышения доступности данных,

другие — для обеспечения максимальной производительности. В контексте статьи нас

будут интересовать MPP (Massive Parallel Processing)

— кластеры, в

которых однотипные приложения выполняются на нескольких компьютерах, обеспечивая

масштабируемость сервисов. Существует несколько технологий, позволяющих

распределять нагрузку между несколькими серверами: перенаправление трафика

,

трансляция адресов

, DNS Round Robin

, использование специальных

программ

, работающих на прикладном уровне, вроде веб-акселераторов. В

Win2k3, в отличие от Win2k, поддержка кластеризации заложена изначально и

поддерживается два типа кластеров, отличающихся приложениями и спецификой

данных:

1. Кластеры NLB (Network Load Balancing)

— обеспечивают

масштабируемость и высокую доступность служб и приложений на базе протоколов TCP

и UDP, объединяя в один кластер до 32 серверов с одинаковым набором данных, на

которых выполняются одни и те же приложения. Каждый запрос выполняется как

отдельная транзакция. Применяются для работы с наборами редко изменяющихся

данных, вроде WWW, ISA, службами терминалов и другими подобными сервисами.

2. Кластеры серверов

– могут объединять до восьми узлов, их главная

задача — обеспечение доступности приложений при сбое. Состоят из активных и

пассивных узлов. Пассивный узел большую часть времени простаивает, играя роль

резерва основного узла. Для отдельных приложений есть возможность настроить

несколько активных серверов, распределяя нагрузку между ними. Оба узла

подключены к единому хранилищу данных. Кластер серверов используется для работы

с большими объемами часто изменяющихся данных (почтовые, файловые и

SQL-серверы). Причем такой кластер не может состоять из узлов, работающих под

управлением различных вариантов Win2k3: Enterprise или Datacenter (версии Web и

Standart кластеры серверов не поддерживают).

В Microsoft Application Center 2000

(и только) имелся еще один вид

кластера — CLB (Component Load Balancing)

, предоставляющий возможность

распределения приложений COM+ между несколькими серверами.

NLB-кластеры

При использовании балансировки нагрузки на каждом из хостов создается

виртуальный сетевой адаптер со своим независимым от реального IP и МАС-адресом.

Этот виртуальный интерфейс представляет кластер как единый узел, клиенты

обращаются к нему именно по виртуальному адресу. Все запросы получаются каждым

узлом кластера, но обрабатываются только одним. На всех узлах запускается

служба балансировки сетевой нагрузки (Network Load Balancing Service)

,

которая, используя специальный алгоритм, не требующий обмена данными между

узлами, принимает решение, нужно ли тому или иному узлу обрабатывать запрос или

нет. Узлы обмениваются heartbeat-сообщениями

, показывающими их

доступность. Если хост прекращает выдачу heartbeat или появляется новый узел,

остальные узлы начинают процесс схождения (convergence)

, заново

перераспределяя нагрузку. Балансировка может быть реализована в одном из двух

режимов:

1) unicast

– одноадресная рассылка, когда вместо физического МАС

используется МАС виртуального адаптера кластера. В этом случае узлы кластера не

могут обмениваться между собой данными, используя МАС-адреса, только через IP

(или второй адаптер, не связанный с кластером);

В пределах одного кластера следует использовать только один из этих режимов.

Можно настроить несколько NLB-кластеров

на одном сетевом адаптере,

указав конкретные правила для портов. Такие кластеры называют виртуальными. Их

применение дает возможность задать для каждого приложения, узла или IP-адреса

конкретные компьютеры в составе первичного кластера, или блокировать трафик для

некоторого приложения, не затрагивая трафик для других программ, выполняющихся

на этом узле. Или, наоборот, NLB-компонент может быть привязан к нескольким

сетевым адаптерам, что позволит настроить ряд независимых кластеров на каждом

узле. Также следует знать, что настройка кластеров серверов и NLB на одном узле

невозможна, поскольку они по-разному работают с сетевыми устройствами.

Администратор может сделать некую гибридную конфигурацию, обладающую

достоинствами обоих методов, например, создав NLB-кластер и настроив репликацию

данных между узлами. Но репликация выполняется не постоянно, а время от времени,

поэтому информация на разных узлах некоторое время будет отличаться.

С теорией на этом закончим, хотя о построении кластеров можно рассказывать

еще долго, перечисляя возможности и пути наращивания, давая различные

рекомендации и варианты конкретной реализации. Все эти тонкости и нюансы оставим

для самостоятельного изучения и перейдем к практической части.

Настройка NLB-кластера

Для организации NLB-кластеров

дополнительное ПО не требуется, все

производится имеющимися средствами Win2k3. Для создания, поддержки и мониторинга

NLB-кластеров используют компонент «Диспетчер балансировки сетевой нагрузки»

(Network Load Balancing Manager)

, который находится во вкладке

«Администрирование» «Панели управления» (команда NLBMgr). Так как компонент

«Балансировка нагрузки сети» ставится как стандартный сетевой драйвер Windows,

установку NLB можно выполнять и при помощи компонента «Сетевые подключения», в

котором доступен соответствующий пункт. Но лучше использовать только первый

вариант, одновременное задействование диспетчера NLB и «Сетевых подключений»

может привести к непредсказуемым результатам.

Диспетчер NLB позволяет настраивать и управлять из одного места работой сразу

нескольких кластеров и узлов.

Возможна также установка NLB-кластера на компьютере с одним сетевым

адаптером, связанным с компонентом «Балансировка нагрузки сети», но в этом

случае при режиме unicast диспетчер NLB на этом компьютере не может быть

использован для управления другими узлами, а сами узлы не могут обмениваться

друг с другом информацией.

Теперь вызываем диспетчер NLB. Кластеров у нас пока нет, поэтому появившееся

окно не содержит никакой информации. Выбираем в меню «Кластер» пункт «Новый» и

начинаем заполнять поля в окне «Параметры кластера». В поле «Настройка

IP-параметров кластера» вводим значение виртуального IP-адреса кластера, маску

подсети и полное имя. Значение виртуального МАС-адреса устанавливается

автоматически. Чуть ниже выбираем режим работы кластера: одноадресный или

многоадресный. Обрати внимание на флажок «Разрешить удаленное управление» — во

всех документах Microsoft настоятельно рекомендует его не использовать во

избежание проблем, связанных с безопасностью. Вместо этого следует применять

диспетчер или другие средства удаленного управления, например инструментарий

управления Windows (WMI). Если же решение об его использовании принято, следует

выполнить все надлежащие мероприятия по защите сети, прикрыв дополнительно

брандмауэром UDP-порты 1717 и 2504.

После заполнения всех полей нажимаем «Далее». В окне «IP-адреса кластера» при

необходимости добавляем дополнительные виртуальные IP-адреса, которые будут

использоваться этим кластером. В следующем окне «Правила для портов» можно

задать балансировку нагрузки для одного или для группы портов всех или

выбранного IP по протоколам UDP или TCP, а также блокировать доступ к кластеру

определенным портам (что межсетевой экран не заменяет). По умолчанию кластер

обрабатывает запросы для всех портов (0–65365); лучше этот список ограничить,

внеся в него только действительно необходимые. Хотя, если нет желания возиться,

можно оставить все, как есть. Кстати, в Win2k по умолчанию весь трафик,

направленный к кластеру, обрабатывал только узел, имевший наивысший приоритет,

остальные узлы подключались только при выходе из строя основного.

Например, для IIS потребуется включить только порты 80 (http) и 443 (https).

Причем можно сделать так, чтобы, например, защищенные соединения обрабатывали

только определенные серверы, на которых установлен сертификат. Для добавления

нового правила нажимаем «Добавить», в появившемся диалоговом окне вводим

IP-адрес узла, или если правило распространяется на всех, то оставляем флажок

«Все». В полях «С» и «По» диапазона портов устанавливаем одно и то же значение –

80. Ключевым полем является «Режим фильтрации» (Filtering Mode) — здесь

задается, кем будет обработан этот запрос. Доступно три поля, определяющие режим

фильтрации: «Несколько узлов», «Один узел» и «Отключить этот диапазон портов».

Выбор «Один узел» означает, что трафик, направленный на выбранный IP (компьютера

или кластера) с указанным номером порта, будет обрабатываться активным узлом,

имеющим наименьший показатель приоритета (о нем чуть ниже). Выбор «Отключить…»

значит, что такой трафик будет отбрасываться всеми участниками кластера.

В режиме фильтрации «Несколько узлов» можно дополнительно указать вариант

определения сходства клиентов, чтобы направлять трафик от заданного клиента к

одному и тому же узлу кластера. Возможны три варианта: «Нет», «Одно» или «Класс

C». Выбор первого означает, что на любой запрос будет отвечать произвольный

узел. Но не следует его использовать, если в правиле выбран протокол UDP или

«Оба». При избрании остальных пунктов сходство клиентов будет определяться по

конкретному IP или диапазону сети класса С.

Итак, для нашего правила с 80-м портом остановим свой выбор на варианте

«Несколько узлов — класс C». Правило для 443 заполняем аналогично, но используем

«Один узел», чтобы клиенту всегда отвечал основной узел с наименьшим

приоритетом. Если диспетчер обнаружит несовместимое правило, будет выведено

предупреждающее сообщение, дополнительно в журнал событий Windows будет внесена

соответствующая запись.

Далее подключаемся к узлу будущего кластера, введя его имя или реальный IP, и

определяем интерфейс, который будет подключен к сети кластера. В окне «Параметры

узла» выбираем из списка приоритет, уточняем сетевые настройки, задаем начальное

состояние узла (работает, остановлен, приостановлен). Приоритет одновременно

является уникальным идентификатором узла; чем меньше номер, тем выше приоритет.

Узел с приоритетом 1 является мастер-сервером, в первую очередь получающим

пакеты и действующим как менеджер маршрутизации.

Флажок «Сохранить состояние после перезагрузки компьютера» позволяет в случае

сбоя или перезагрузки этого узла автоматически ввести его в строй. После нажатия

на «Готово» в окне Диспетчера появится запись о новом кластере, в котором пока

присутствует один узел.

Следующий узел добавить также просто. Выбираем в меню «Добавить узел» либо

«Подключить к существующему», в зависимости от того, с какого компьютера

производится подключение (он уже входит в кластер или нет). Затем в окне

указываем имя или адрес компьютера, если прав для подключения достаточно, новый

узел будет подключен к кластеру. Первое время значок напротив его имени будет

отличаться, но когда завершится процесс схождения, он будет такой же, как и у

первого компьютера.

Так как диспетчер отображает свойства узлов на момент своего подключения, для

уточнения текущего состояния следует выбрать кластер и в контекстном меню пункт

«Обновить». Диспетчер подключится к кластеру и покажет обновленные данные.

После установки NLB-кластера

не забудь изменить DNS-запись, чтобы

разрешение имени теперь показывало на IP-кластера.

Изменение загрузки сервера

В такой конфигурации все серверы будут загружены равномерно (за исключением

варианта «Один узел»). В некоторых случаях необходимо перераспределить нагрузку,

большую часть работы возложив на один из узлов (например, самый мощный).

Применительно к кластеру правила после их создания можно изменить, выбрав в

контекстном меню, появляющемся при щелчке на имени, пункт «Свойства кластера».

Здесь доступны все те настройки, о которых мы говорили выше. Пункт меню

«Свойства узла» предоставляет несколько больше возможностей. В «Параметрах узла»

можно изменить значение приоритета для конкретно выбранного узла. В «Правилах

для портов» добавить или удалить правило нельзя, это доступно только на уровне

кластера. Но, выбрав редактирование конкретного правила, мы получаем возможность

скорректировать некоторые настройки. Так, при установленном режиме фильтрации

«Несколько узлов» становится доступным пункт «Оценка нагрузки», позволяющий

перераспределить нагрузку на конкретный узел. По умолчанию установлен флажок

«Равная», но в «Оценке нагрузки» можно указать другое значение нагрузки на

конкретный узел, в процентах от общей загрузки кластера. Если активирован режим

фильтрации «Один узел», в этом окне появляется новый параметр «Приоритет

обработки». Используя его, можно сделать так, что трафик к определенному порту

будет в первую очередь обрабатываться одним узлом кластера, а к другому – другим

узлом.

Журналирование событий

Как уже говорилось, компонент «Балансировка нагрузки сети» записывает все

действия и изменения кластера в журнал событий Windows. Чтобы их увидеть,

выбираем «Просмотр событий – Система», к NLB относятся сообщения WLBS (от

Windows Load Balancing Service, как эта служба называлась в NT). Кроме того, в

окне диспетчера выводятся последние сообщения, содержащие информацию об ошибках

и обо всех изменениях в конфигурации. По умолчанию эта информация не

сохраняется. Чтобы она записывалась в файл, следует выбрать «Параметры –>

Параметры журнала», установить флажок «Включить ведение журнала» и указать имя

файла. Новый файл будет создан в подкаталоге твоей учетной записи в Documents

and Settings.

Настраиваем IIS с репликацией

Кластер кластером, но без службы он смысла не имеет. Поэтому добавим IIS (Internet

Information Services)

. Сервер IIS входит в состав Win2k3, но, чтобы свести к

минимуму возможность атак на сервер, он по умолчанию не устанавливается.

Инсталлировать IIS можно двумя способами: посредством «Панели управления» или

мастером управления ролями данного сервера. Рассмотрим первый. Переходим в

«Панель управления – Установка и удаление программ» (Control Panel — Add or

Remove Programs), выбираем «Установку компонентов Windows» (Add/Remove Windows

Components). Теперь переходим в пункт «Сервер приложений» и отмечаем в «Службах

IIS» все, что необходимо. По умолчанию рабочим каталогом сервера является Inetpubwwwroot.

После установки IIS может выводить статические документы.

На сегодняшний день возможно построение домашнего суперкомпьютера, о чем и пойдет речь.

В статье рассмотрены способы аппаратного построения высокопроизводительных вычислительных комплексов. Одно из интересных применений – криптография. Например, благодаря современным технологиям, любому стал доступен взлом MD5 или WPA. Если постараться (информацию быстро выпиливают), в Интернете можно найти способ взлома алгоритма A5/2, используемого в GSM. Другое применение – инженерные, финансовые, медицинские расчеты, биткойнмайнинг.

Немного истории

Касаясь взятой нами темы, нельзя не упомянуть, что сегодня одно из перспективных направлений развития суперкомпьютеров является использование в стандартной компьютерной архитектуре сопроцессоров, по архитектуре напоминающих видеокарты.

Выбор процессора

Сегодня основные производители процессоров – это Intel и AMD. RISC-процессоры, такие как Power 7+ , несмотря на привлекательность, достаточно экзотичны и дороги. Вот, например, не самая новая модель такого сервера стоит больше миллиона .

(К слову, говоря, при этом есть возможность собрать недорогой и эффективный кластер из xbox 360 или PS3, процессоры там примерно как Power, и на миллион можно купить не одну приставку.)

Исходя из этого отметим интересные по цене варианты построения высокопроизводительной системы. Разумеется, она должна быть многопроцессорной. У Intel для таких задач используются процессоры Xeon, у AMD – Opteron.

Если много денег

Топовый процессор этой серии – E7-8870 с десятью ядрами 2,4 ГГц. Его цена $4616. Для таких CPU фирмы HP и Supermicro выпускают! восьмипроцессорные! серверные шасси. Восемь 10-ядерных процессоров Xeon E7-8870 2.4 ГГц с поддержкой HyperThreading поддерживают 8*10*2=160 потоков, что в диспетчере задач Windows отображается как сто шестьдесят графиков загрузки процессоров, матрицей 10×16.

Для того, чтобы восемь процессоров уместились в корпусе, их размещают не сразу на материнской плате, а на отдельных платах, которые втыкаются в материнскую плату. На фотографии показаны установленные в материнскую плату четыре платы с процессорами (по два на каждой). Это решение Supermicro. В решении HP на каждый процессор приходится своя плата. Стоимость решения HP составляет два-три миллиона, в зависимости от наполнения процессорами, памятью и прочим. Шасси от Supermicro стоит $10 000, что привлекательнее. Кроме того в Supermicro можно поставить четыре сопроцессорных платы расширения в порты PCI-Express x16 (кстати, еще останется место для Indiniband-адаптера чтобы собирать кластер из таких), а в HP только две. Таким образом, для создания суперкомпьютера восьмипроцессорная платформа от Supermicro привлекательнее. На следующем фото с выставки представлен суперкомпьютер в сборе с четырьмя GPU платами.

Однако это очень дорого.

Что подешевле

Зато есть перспектива сборки суперкомпьютера на более доступных процессорах AMD Opteron G34, Intel Xeon LGA2011 и LGA 1366.

Чтобы выбрать конкретную модель, я составил таблицу, в которой сосчитал для каждого процессора показатель цена/(число ядер*частота). Я отбросил из расчета процессоры частотой ниже 2 ГГц, и для Intel — с шиной ниже 6,4GT/s.

| Модель |

Кол-во ядер |

Частота |

Цена, $ |

Цена/ядро, $ |

Цена/Ядро/ГГц |

| AMD |

|||||

| 6386 SE |

16 | 2,8 | 1392 | 87 | 31 |

| 6380 | 16 | 2,5 | 1088 | 68 | 27 |

| 6378 | 16 | 2,4 | 867 | 54 | 23 |

| 6376 | 16 | 2,3 | 703 | 44 | 19 |

| 6348 | 12 | 2,8 | 575 | 48 | 17 |

| 6344 |

12 | 2,6 | 415 | 35 | 13 |

| 6328 | 8 | 3,2 | 575 | 72 | 22 |

| 6320 | 8 | 2,8 | 293 | 37 | 13 |

| INTEL |

|||||

| E5-2690 | 8 | 2,9 | 2057 | 257 | 89 |

| E5-2680 | 8 | 2,7 | 1723 | 215 | 80 |

| E5-2670 | 8 | 2,6 | 1552 | 194 | 75 |

| E5-2665 | 8 | 2,4 | 1440 | 180 | 75 |

| E5-2660 | 8 | 2,2 | 1329 | 166 | 76 |

| E5-2650 | 8 | 2 | 1107 | 138 | 69 |

| E5-2687W |

8 | 3,1 | 1885 | 236 | 76 |

| E5-4650L | 8 | 2,6 | 3616 | 452 | 174 |

| E5-4650 | 8 | 2,7 | 3616 | 452 | 167 |

| E5-4640 | 8 | 2,4 | 2725 | 341 | 142 |

| E5-4617 | 6 | 2,9 | 1611 | 269 | 93 |

| E5-4610 | 6 | 2,4 | 1219 | 203 | 85 |

| E5-2640 | 6 | 2,5 | 885 | 148 | 59 |

| E5-2630 |

6 | 2,3 | 612 | 102 | 44 |

| E5-2667 | 6 | 2,9 | 1552 | 259 | 89 |

| X5690 | 6 | 3,46 | 1663 | 277 | 80 |

| X5680 | 6 | 3,33 | 1663 | 277 | 83 |

| X5675 | 6 | 3,06 | 1440 | 240 | 78 |

| X5670 | 6 | 2,93 | 1440 | 240 | 82 |

| X5660 | 6 | 2,8 | 1219 | 203 | 73 |

| X5650 | 6 | 2,66 | 996 | 166 | 62 |

| E5-4607 | 6 | 2,2 | 885 | 148 | 67 |

| X5687 | 4 | 3,6 | 1663 | 416 | 115 |

| X5677 | 4 | 3,46 | 1663 | 416 | 120 |

| X5672 | 4 | 3,2 | 1440 | 360 | 113 |

| X5667 | 4 | 3,06 | 1440 | 360 | 118 |

| E5-2643 | 4 | 3,3 | 885 | 221 | 67 |

Жирным курсивом выделена модель с минимальным показателем соотношения, подчеркнутым – самый мощный AMD и на мой взгляд наиболее близкий по производительности Xeon.

Таким, образом, мой выбор процессоров для суперкомпьютера – Opteron 6386 SE, Opteron 6344, Xeon E5-2687W и Xeon E5-2630.

Материнские платы

PICMG

На обычные материнские платы невозможно поставить более четырех двухслотовых плат расширения. Есть и другая архитектура – использование кросс-плат, таких как BPG8032 PCI Express Backplane.

В такую плату ставятся платы расширения PCI Express и одна процессорная плата, чем-то похожая на те, которые установлены в восьмипроцессорных серверах на базе Supermicro, о которых речь шла выше. Но только эти процессорные платы подчиняются отраслевым стандартам PICMG. Стандарты развиваются медленно и такие платы зачастую не поддерживают самые современные процессоры. Максимум такие процессорные платы сейчас выпускают на два Xeon E5-2448L — Trenton BXT7059 SBC.

Стоить такая система будет без GPU не меньше $5000.

Готовые платформы TYAN

За ту же примерно сумму можно приобрести готовую платформу для сборки суперкомпьютеров TYAN FT72B7015 . В такой можно установить до восьми GPU и два Xeon LGA1366.

(К слову, говоря, при этом есть возможность собрать недорогой и эффективный кластер из xbox 360 или PS3, процессоры там примерно как Power, и на миллион можно купить не одну приставку.)

Исходя из этого отметим интересные по цене варианты построения высокопроизводительной системы. Разумеется, она должна быть многопроцессорной. У Intel для таких задач используются процессоры Xeon, у AMD – Opteron.

Если много денег

Топовый процессор этой серии – E7-8870 с десятью ядрами 2,4 ГГц. Его цена $4616. Для таких CPU фирмы HP и Supermicro выпускают! восьмипроцессорные! серверные шасси. Восемь 10-ядерных процессоров Xeon E7-8870 2.4 ГГц с поддержкой HyperThreading поддерживают 8*10*2=160 потоков, что в диспетчере задач Windows отображается как сто шестьдесят графиков загрузки процессоров, матрицей 10×16.

Для того, чтобы восемь процессоров уместились в корпусе, их размещают не сразу на материнской плате, а на отдельных платах, которые втыкаются в материнскую плату. На фотографии показаны установленные в материнскую плату четыре платы с процессорами (по два на каждой). Это решение Supermicro. В решении HP на каждый процессор приходится своя плата. Стоимость решения HP составляет два-три миллиона, в зависимости от наполнения процессорами, памятью и прочим. Шасси от Supermicro стоит $10 000, что привлекательнее. Кроме того в Supermicro можно поставить четыре сопроцессорных платы расширения в порты PCI-Express x16 (кстати, еще останется место для Infiniband-адаптера чтобы собирать кластер из таких), а в HP только две. Таким образом, для создания суперкомпьютера восьмипроцессорная платформа от Supermicro привлекательнее. На следующем фото с выставки представлен суперкомпьютер в сборе с четырьмя GPU платами.

Однако это очень дорого.

Что подешевле

Зато есть перспектива сборки суперкомпьютера на более доступных процессорах AMD Opteron G34, Intel Xeon LGA2011 и LGA 1366.

Чтобы выбрать конкретную модель, я составил таблицу, в которой сосчитал для каждого процессора показатель цена/(число ядер*частота). Я отбросил из расчета процессоры частотой ниже 2 ГГц, и для Intel — с шиной ниже 6,4GT/s.

| Модель |

Кол-во ядер |

Частота |

Цена, $ |

Цена/ядро, $ |

Цена/Ядро/ГГц |

| AMD |

|||||

| 6386 SE |

16 | 2,8 | 1392 | 87 | 31 |

| 6380 | 16 | 2,5 | 1088 | 68 | 27 |

| 6378 | 16 | 2,4 | 867 | 54 | 23 |

| 6376 | 16 | 2,3 | 703 | 44 | 19 |

| 6348 | 12 | 2,8 | 575 | 48 | 17 |

| 6344 |

12 | 2,6 | 415 | 35 | 13 |

| 6328 | 8 | 3,2 | 575 | 72 | 22 |

| 6320 | 8 | 2,8 | 293 | 37 | 13 |

| INTEL |

|||||

| E5-2690 | 8 | 2,9 | 2057 | 257 | 89 |

| E5-2680 | 8 | 2,7 | 1723 | 215 | 80 |

| E5-2670 | 8 | 2,6 | 1552 | 194 | 75 |

| E5-2665 | 8 | 2,4 | 1440 | 180 | 75 |

| E5-2660 | 8 | 2,2 | 1329 | 166 | 76 |

| E5-2650 | 8 | 2 | 1107 | 138 | 69 |

| E5-2687W |

8 | 3,1 | 1885 | 236 | 76 |

| E5-4650L | 8 | 2,6 | 3616 | 452 | 174 |

| E5-4650 | 8 | 2,7 | 3616 | 452 | 167 |

| E5-4640 | 8 | 2,4 | 2725 | 341 | 142 |

| E5-4617 | 6 | 2,9 | 1611 | 269 | 93 |

| E5-4610 | 6 | 2,4 | 1219 | 203 | 85 |

| E5-2640 | 6 | 2,5 | 885 | 148 | 59 |

| E5-2630 |

6 | 2,3 | 612 | 102 | 44 |

| E5-2667 | 6 | 2,9 | 1552 | 259 | 89 |

| X5690 | 6 | 3,46 | 1663 | 277 | 80 |

| X5680 | 6 | 3,33 | 1663 | 277 | 83 |

| X5675 | 6 | 3,06 | 1440 | 240 | 78 |

| X5670 | 6 | 2,93 | 1440 | 240 | 82 |

| X5660 | 6 | 2,8 | 1219 | 203 | 73 |

| X5650 | 6 | 2,66 | 996 | 166 | 62 |

| E5-4607 | 6 | 2,2 | 885 | 148 | 67 |

| X5687 | 4 | 3,6 | 1663 | 416 | 115 |

| X5677 | 4 | 3,46 | 1663 | 416 | 120 |

| X5672 | 4 | 3,2 | 1440 | 360 | 113 |

| X5667 | 4 | 3,06 | 1440 | 360 | 118 |

| E5-2643 | 4 | 3,3 | 885 | 221 | 67 |

Жирным курсивом выделена модель с минимальным показателем соотношения, подчеркнутым – самый мощный AMD и на мой взгляд наиболее близкий по производительности Xeon.

Таким, образом, мой выбор процессоров для суперкомпьютера – Opteron 6386 SE, Opteron 6344, Xeon E5-2687W и Xeon E5-2630.

Материнские платы

PICMG

На обычные материнские платы невозможно поставить более четырех двухслотовых плат расширения. Есть и другая архитектура – использование кросс-плат, таких как BPG8032 PCI Express Backplane.

В такую плату ставятся платы расширения PCI Express и одна процессорная плата, чем-то похожая на те, которые установлены в восьмипроцессорных серверах на базе Supermicro, о которых речь шла выше. Но только эти процессорные платы подчиняются отраслевым стандартам PICMG. Стандарты развиваются медленно и такие платы зачастую не поддерживают самые современные процессоры. Максимум такие процессорные платы сейчас выпускают на два Xeon E5-2448L — Trenton BXT7059 SBC.

Стоить такая система будет без GPU не меньше $5000.

Готовые платформы TYAN

За ту же примерно сумму можно приобрести готовую платформу для сборки суперкомпьютеров TYAN FT72B7015 . В такой можно установить до восьми GPU и два Xeon LGA1366.

«Обычные» серверные материнские платы

Для LGA2011

Supermicro X9QR7-TF — на эту материнскую плату можно установить 4 Платы расширения и 4 процессора.

Supermicro X9DRG-QF — эта плата специально разработана для сборки высокопроизводительных систем.

Для Opteron

Supermicro H8QGL-6F — эта плата позволяет установить четыре процессора и три платы расширения

Усиление платформы платами расширения

Этот рынок почти полностью захвачен NVidia, которые выпускают помимо геймерских видеокарт еще и вычислительные карты. Меньшую долю рынка имеет AMD, и относительно недавно на этот рынок пришла корпорация Intel.

Особенностью таких сопроцессоров является наличие на борту большого объема оперативной памяти, быстрые расчеты с двойной точностью и энергоэффективность.

| FP32, Tflops | FP64, Tflops | Цена | Память, Гб | |

| Nvidia Tesla K20X | 3.95 | 1.31 | 5.5 | 6 |

| AMD FirePro S10000 | 5.91 | 1.48 | 3.6 | 6 |

| Intel Xeon Phi 5110P | 1 | 2.7 | 8 | |

| Nvidia GTX Titan | 4.5 | 1.3 | 1.1 | 6 |

| Nvidia GTX 680 | 3 | 0.13 | 0.5 | 2 |

| AMD HD 7970 GHz Edition | 4 | 1 | 0.5 | 3 |

| AMD HD 7990 Devil 13 | 2×3,7 | 2х0.92 | 1.6 | 2×3 |

Топовое решение от Nvidia называется Tesla K20X на архитектуре Kepler. Именно такие карты стоят в самом мощном в мире суперкомпьютере Titan. Однако недавно Nvidia выпустила видеокарту Geforce Titan. Старые модели были с урезанной производительностью FP64 до 1/24 от FP32 (GTX680). Но в Титане производитель обещает довольно высокую производительность в расчетах с двойной точностью. Решения от AMD тоже неплохи, но они построены на другой архитектуре и это может создать трудности для запуска вычислений, оптимизированных под CUDA (технология Nvidia).

Решение от Intel — Xeon Phi 5110P интересно тем, что все ядра в сопроцессоре выполнены на архитектуре x86 и не требуется особой оптимизации кода для запуска расчетов. Но мой фаворит среди сопроцессоров – относительно недорогая AMD HD 7970 GHz Edition. Теоретически эта видеокарта покажет максимальную производительность в расчете на стоимость.

Можно соединить в кластер

Для повышения производительности системы несколько компьютеров можно объединить в кластер, который будет распределять вычислительную нагрузку между входящими в состав кластера компьютерами.

Использовать в качестве сетевого интерфейса для связи компьютеров обычный гигабитный Ethernet слишком медленно. Для этих целей чаще всего используют Infiniband. Хост адаптер Infiniband относительно сервера стоит недорого. Например, на международном аукционе Ebay такие адаптеры продают по цене от $40. Например, адаптер X4 DDR (20Gb/s) обойдется с доставкой до России примерно в $100.

При этом коммутационное оборудование для Infiniband стоит довольно дорого. Да и как уже было сказано выше, классическая звезда в качестве топологии вычислительной сети – не лучший выбор.

Однако хосты InfiniBand можно подключать друг к другу напрямую, без свича. Тогда довольно интересным становится, например, такой вариант: кластер из двух компьютеров, соединенных по infiniband. Такой суперкомпьютер вполне можно собрать дома.

Сколько нужно видеокарт

В самом мощном суперкомпьютере современности Cray Titan отношение процессоров к «видеокартам» 1:1, то есть в нем 18688 16-ядерных процессоров и 18688 Tesla K20X.

В Тяньхэ-1А – китайском суперкомпьютере на ксеонах отношение следующее. Два шестиядерных процессора к одной «видюшке» Nvidia M2050 (послабее, чем K20X).

Такое отношение мы и примем для наших сборок за оптимальное (ибо дешевле). То есть 12-16 ядер процессоров на один GPU. На таблице ниже жирным обозначены практически возможные варианты, подчеркиванием – наиболее удачные с моей точки зрения.

| GPU | Cores | 6-core CPU | 8-core CPU | 12-core CPU | 16-core CPU | |||||

| 2 | 24 | 32 | 4 |

5 | 3 |

4 |

2 |

3 |

2 |

2 |

| 3 | 36 | 48 | 6 | 8 | 5 | 6 | 3 |

4 |

2 |

3 |

| 4 | 48 | 64 | 8 | 11 | 6 | 8 | 4 |

5 | 3 |

4 |

Если система с уже установленным отношением процессоров/видеокарт сможет принять «на борт» еще дополнительно вычислительных устройств, то мы их добавим, чтобы увеличить мощность сборки.

Итак, сколько стоит

Представленные ниже варианты – шасси суперкомпьютера без оперативной памяти, жестких дисков и ПО. Во всех моделях используется видеоадаптер AMD HD 7970 GHz Edition. Его можно заменить на другой, по требованию задачи (например, на xeon phi). Там, где система позволяет, одна из AMD HD 7970 GHz Edition заменена на трехслотовую AMD HD 7990 Devil 13.

Вариант 1 на материнской плате Supermicro H8QGL-6F

| Материнская плата | Supermicro H8QGL-6F |

1 | 1200 | 1200 |

| Процессор | AMD Opteron 6344 | 4 | 500 | 2000 |

| Кулер Процессора | Thermaltake CLS0017 | 4 | 40 | 160 |

| Корпус 1400Вт | SC748TQ-R1400B | 1 | 1000 | 1000 |

| Графический ускоритель | AMD HD 7970 GHz Edition | 3 | 500 | 1500 |

| 5860 |

Теоретически, производительность составит около 12 Tflops.

Вариант 2 на материнской плате TYAN S8232, кластерный

Эта плата не поддерживает Opteron 63xx, поэтому используется 62xx. В этом варианте два компьютера объединены в кластер по Infiniband x4 DDR двумя кабелями. Теоретически скорость соединения в этом случае упрется в скорость PCIe x8 то есть 32Гб/с. Блоков питания используется два. Как их согласовать между собой, можно найти в интернете.

| Количество | Цена | Сумма | ||

| Материнская плата | TYAN S8232 | 1 | 790 | 790 |

| Процессор | AMD Opteron 6282SE | 2 | 1000 | 2000 |

| Кулер Процессора | Noctua NH-U12DO A3 | 2 | 60 | 120 |

| Корпус | Antec Twelve Hundred Black | 1 | 200 | 200 |

| Блок питания | FSP AURUM PRO 1200W | 2 | 200 | 400 |

| Графический ускоритель | AMD HD 7970 GHz Edition | 2 | 500 | 1000 |

| Графический ускоритель | AX7990 6GBD5-A2DHJ | 1 | 1000 | 1000 |

| Infiniband адаптер | X4 DDR Infiniband | 1 | 140 | 140 |

| Infiniband кабель | X4 DDR Infiniband | 1 | 30 | 30 |

| 5680 (за один блок) |

Для кластера таких конфигураций нужно две и стоимость их составит $11360

. Его энергопотребление при полной нагрузке будет около 3000Вт. Теоретически, производительность составит до 31Tflops.

Как объединить компьютеры в кластер

Содержание

- Содержание

- Классификация кластеров [ править | править код ]

- Кластеры высокой доступности [ править | править код ]

- Кластеры распределения нагрузки (Network Load Balancing, NLB) [ править | править код ]

- Вычислительные кластеры [ править | править код ]

- Системы распределенных вычислений (grid) [ править | править код ]

- Кластер серверов, организуемых программно [ править | править код ]

- Применение [ править | править код ]

- Самые производительные кластеры [ править | править код ]

- История [ править | править код ]

- Программные средства [ править | править код ]

- 4 ответа 4

Кластер — группа компьютеров, объединённых высокоскоростными каналами связи, представляющая с точки зрения пользователя единый аппаратный ресурс. Кластер — слабо связанная совокупность нескольких вычислительных систем, работающих совместно для выполнения общих приложений, и представляющихся пользователю единой системой. Один из первых архитекторов кластерной технологии Грегори Пфистер дал кластеру следующее определение: «Кластер — это разновидность параллельной или распределённой системы, которая:

- состоит из нескольких связанных между собой компьютеров;

- используется как единый, унифицированный компьютерный ресурс».

Обычно различают следующие основные виды кластеров:

- отказоустойчивые кластеры (High-availability clusters, HA, кластеры высокой доступности)

- кластеры с балансировкой нагрузки (Load balancing clusters)

- вычислительные кластеры (High performance computing clusters, HPC)

- системы распределенных вычислений

Содержание

Классификация кластеров [ править | править код ]

Кластеры высокой доступности [ править | править код ]

Обозначаются аббревиатурой HA (англ. High Availability — высокая доступность). Создаются для обеспечения высокой доступности сервиса, предоставляемого кластером. Избыточное число узлов, входящих в кластер, гарантирует предоставление сервиса в случае отказа одного или нескольких серверов. Типичное число узлов — два, это минимальное количество, приводящее к повышению доступности. Создано множество программных решений для построения такого рода кластеров.

Отказоустойчивые кластеры и системы разделяются на 3 основных типа:

- с холодным резервом или активный/пассивный. Активный узел выполняет запросы, а пассивный ждет его отказа и включается в работу, когда таковой произойдет. Пример — резервные сетевые соединения, в частности, Алгоритм связующего дерева. Например, связка DRBD и HeartBeat/Corosync.

- с горячим резервом или активный/активный. Все узлы выполняют запросы, в случае отказа одного нагрузка перераспределяется между оставшимися. То есть кластер распределения нагрузки с поддержкой перераспределения запросов при отказе. Примеры — практически все кластерные технологии, например, Microsoft Cluster Server. OpenSource проект OpenMosix.

- с модульной избыточностью. Применяется только в случае, когда простой системы совершенно недопустим. Все узлы одновременно выполняют один и тот же запрос (либо части его, но так, что результат достижим и при отказе любого узла), из результатов берется любой. Необходимо гарантировать, что результаты разных узлов всегда будут одинаковы (либо различия гарантированно не повлияют на дальнейшую работу). Примеры — RAID и Triple modular redundancy.

Конкретная технология может сочетать данные принципы в любой комбинации. Например, Linux-HA поддерживает режим обоюдной поглощающей конфигурации (англ. takeover ), в котором критические запросы выполняются всеми узлами вместе, прочие же равномерно распределяются между ними. [1]

Кластеры распределения нагрузки (Network Load Balancing, NLB) [ править | править код ]

Принцип их действия строится на распределении запросов через один или несколько входных узлов, которые перенаправляют их на обработку в остальные, вычислительные узлы. Первоначальная цель такого кластера — производительность, однако, в них часто используются также и методы, повышающие надёжность. Подобные конструкции называются серверными фермами. Программное обеспечение (ПО) может быть как коммерческим (OpenVMS, MOSIX, Platform LSF HPC, Solaris Cluster, Moab Cluster Suite, Maui Cluster Scheduler), так и бесплатным (OpenMosix, Sun Grid Engine, Linux Virtual Server).

Вычислительные кластеры [ править | править код ]

Кластеры используются в вычислительных целях, в частности в научных исследованиях. Для вычислительных кластеров существенными показателями являются высокая производительность процессора в операциях над числами с плавающей точкой (flops) и низкая латентность объединяющей сети, и менее существенными — скорость операций ввода-вывода, которая в большей степени важна для баз данных и web-сервисов. Вычислительные кластеры позволяют уменьшить время расчетов, по сравнению с одиночным компьютером, разбивая задание на параллельно выполняющиеся ветки, которые обмениваются данными по связывающей сети. Одна из типичных конфигураций — набор компьютеров, собранных из общедоступных компонентов, с установленной на них операционной системой Linux, и связанных сетью Ethernet, Myrinet, InfiniBand или другими относительно недорогими сетями. Такую систему принято называть кластером Beowulf. Специально выделяют высокопроизводительные кластеры (Обозначаются англ. аббревиатурой HPC Cluster — High-performance computing cluster). Список самых мощных высокопроизводительных компьютеров (также может обозначаться англ. аббревиатурой HPC) можно найти в мировом рейтинге TOP500. В России ведется рейтинг самых мощных компьютеров СНГ. [2]

Системы распределенных вычислений (grid) [ править | править код ]

Такие системы не принято считать кластерами, но их принципы в значительной степени сходны с кластерной технологией. Их также называют grid-системами. Главное отличие — низкая доступность каждого узла, то есть невозможность гарантировать его работу в заданный момент времени (узлы подключаются и отключаются в процессе работы), поэтому задача должна быть разбита на ряд независимых друг от друга процессов. Такая система, в отличие от кластеров, не похожа на единый компьютер, а служит упрощённым средством распределения вычислений. Нестабильность конфигурации, в таком случае, компенсируется больши́м числом узлов.

Кластер серверов, организуемых программно [ править | править код ]

Кластер серверов (в информационных технологиях) — группа серверов, объединённых логически, способных обрабатывать идентичные запросы и использующихся как единый ресурс. Чаще всего серверы группируются посредством локальной сети. Группа серверов обладает большей надежностью и большей производительностью, чем один сервер. Объединение серверов в один ресурс происходит на уровне программных протоколов.

В отличие от аппаратного кластера компьютеров, кластеры организуемые программно, требуют:

- наличия специального программного модуля (Cluster Manager), основной функцией которого является поддержание взаимодействия между всеми серверами — членами кластера:

- синхронизации данных между всеми серверами — членами кластера;

- распределение нагрузки (клиентских запросов) между серверами — членами кластера;

Примеры программных кластерных решений

- IBM Lotus Notes

- HP MC/ServiceGuard

Применение [ править | править код ]

В большинстве случаев, кластеры серверов функционируют на раздельных компьютерах. Это позволяет повышать производительность за счёт распределения нагрузки на аппаратные ресурсы и обеспечивает отказоустойчивость на аппаратном уровне.

Однако, принцип организации кластера серверов (на уровне программного протокола) позволяет исполнять по нескольку программных серверов на одном аппаратном. Такое использование может быть востребовано:

- при разработке и тестировании кластерных решений;

- при необходимости обеспечить доступность кластера только с учётом частых изменений конфигурации серверов — членов кластера, требующих их перезагрузки (перезагрузка производится поочерёдно) в условиях ограниченных аппаратных ресурсов.

Самые производительные кластеры [ править | править код ]

Дважды в год организацией TOP500 публикуется список пятисот самых производительных вычислительных систем в мире, среди которых в последнее время часто преобладают кластеры. Самым быстрым кластером является IBM Roadrunner (Лос-Аламосская национальная лаборатория, США, созданный в 2008 году), его максимальная производительность (на июль 2008) составляет 1,026 Петафлопс. Самая быстрая система в Европе (на июль 2008) — суперкомпьютер, BlueGene/P находится в Германии, в исследовательском центре города Юлих, земля Северный Рейн-Вестфалия, максимально достигнутая производительность 167,3 Терафлопс.

Кластерные системы занимают достойное место в списке самых быстрых, при этом значительно выигрывая у суперкомпьютеров в цене. На июль 2008 года на 7 месте рейтинга TOP500 находится кластер SGI Altix ICE 8200 (Chippewa Falls, Висконсин, США).

Сравнительно дешёвую альтернативу суперкомпьютерам представляют кластеры, основанные на концепции Beowulf, которые строятся из обыкновенных недорогих компьютеров на основе бесплатного программного обеспечения. Один из практических примеров такой системы — Stone Soupercomputer в Национальной лаборатории Ок-Ридж (Теннесси, США, 1997).

Крупнейший кластер, принадлежащий частному лицу (из 1000 процессоров), был построен Джоном Козой (John Koza).

История [ править | править код ]

История создания кластеров неразрывно связана с ранними разработками в области компьютерных сетей. Одной из причин для появления скоростной связи между компьютерами стали надежды на объединение вычислительных ресурсов. В начале 1970-х годов группой разработчиков протокола TCP/IP и лабораторией Xerox PARC были закреплены стандарты сетевого взаимодействия. Появилась и операционная система Hydra для компьютеров PDP-11 производства DEC, созданный на этой основе кластер был назван C.mpp (Питтсбург, штат Пенсильвания, США, 1971 год). Тем не менее, только около 1983 года были созданы механизмы, позволяющие с лёгкостью пользоваться распределением задач и файлов через сеть, по большей части это были разработки в SunOS (операционной системе на основе BSD от компании Sun Microsystems).

Первым коммерческим проектом кластера стал ARCNet, созданный компанией Datapoint в 1977 году. Прибыльным он не стал, и поэтому строительство кластеров не развивалось до 1984 года, когда DEC построила свой VAXcluster на основе операционной системы VAX/VMS. ARCNet и VAXcluster были рассчитаны не только на совместные вычисления, но и совместное использование файловой системы и периферии с учётом сохранения целостности и однозначности данных. VAXCluster (называемый теперь VMSCluster) — является неотъемлемой компонентой операционной системы HP OpenVMS, использующих процессоры DEC Alpha и Itanium.

Два других ранних кластерных продукта, получивших признание, включают Tandem Hymalaya (1994, класс HA) и IBM S/390 Parallel Sysplex (1994).

История создания кластеров из обыкновенных персональных компьютеров во многом обязана проекту Parallel Virtual Machine. В 1989 году это программное обеспечение для объединения компьютеров в виртуальный суперкомпьютер открыло возможность мгновенного создания кластеров. В результате суммарная производительность всех созданных тогда дешёвых кластеров обогнала по производительности сумму мощностей «серьёзных» коммерческих систем.

Создание кластеров на основе дешёвых персональных компьютеров, объединённых сетью передачи данных, продолжилось в 1993 году силами Американского аэрокосмического агентства NASA, затем в 1995 году получили развитие кластеры Beowulf, специально разработанные на основе этого принципа. Успехи таких систем подтолкнули развитие grid-сетей, которые существовали ещё с момента создания UNIX.

Программные средства [ править | править код ]

Широко распространённым средством для организации межсерверного взаимодействия является библиотека MPI, поддерживающая языки C и Fortran. Она используется, например, в программе моделирования погоды MM5.

Операционная система Solaris предоставляет программное обеспечение Solaris Cluster, которое служит для обеспечения высокой доступности и безотказности серверов, работающих под управлением Solaris. Для OpenSolaris существует реализация с открытым кодом под названием OpenSolaris HA Cluster.

Среди пользователей GNU/Linux популярны несколько программ:

- distcc, MPICH и др. — специализированные средства для распараллеливания работы программ. distcc допускает параллельную компиляцию в GNU Compiler Collection.

- Linux Virtual Server, Linux-HA — узловое ПО для распределения запросов между вычислительными серверами.

- MOSIX, openMosix, Kerrighed, OpenSSI — полнофункциональные кластерные среды, встроенные в ядро, автоматически распределяющие задачи между однородными узлами. OpenSSI, openMosix и Kerrighed создают среду единой операционной системы между узлами.

Кластерные механизмы планируется встроить и в ядро DragonFly BSD, ответвившуюся в 2003 году от FreeBSD 4.8. В дальних планах также превращение её в среду единой операционной системы.

Компанией Microsoft выпускается HA-кластер для операционной системы Windows. Существует мнение, что он создан на основе технологии Digital Equipment Corporation, поддерживает до 16 (с 2010 года) узлов в кластере, а также работу в сети SAN (Storage Area Network). Набор API-интерфейсов служит для поддержки распределяемых приложений, есть заготовки для работы с программами, не предусматривающими работы в кластере.

Windows Compute Cluster Server 2003 (CCS), выпущенный в июне 2006 года разработан для высокотехнологичных приложений, которые требуют кластерных вычислений. Издание разработано для развертывания на множестве компьютеров, которые собираются в кластер для достижения мощностей суперкомпьютера. Каждый кластер на Windows Compute Cluster Server состоит из одного или нескольких управляющих машин, распределяющих задания и нескольких подчиненных машин, выполняющих основную работу. В ноябре 2008 года представлен Windows HPC Server 2008, призванный заменить Windows Compute Cluster Server 2003.

Novell Open Enterprise Server (OES) — сетевая операционная система, « сплав » Novell NetWare и SUSE Linux Enterprise Server; кроме прочего способная создавать смешанные кластеры, в которых ресурсы при сбое могут перемещаться с сервера NetWare на сервер Linux и наоборот.

Кластер — группа компьютеров, объединённых высокоскоростными каналами связи и представляющая с точки зрения пользователя единый аппаратный ресурс.

Один из первых архитекторов кластерной технологии Грегори Пфистер (Gregory F. Pfister) дал кластеру следующее определение: «Кластер — это разновидность параллельной или распределённой системы, которая:

состоит из нескольких связанных между собой компьютеров;

используется как единый, унифицированный компьютерный ресурс» .

Итак: берешь свитч (коммутатор) 1000 МБитсек 5-8 портов (стоит от 1000 рублей) . Покупаешь стандартные кабели (витую пару) c разъемом RJ-45 (проще купить готовые, если нужно всего 2-3, потому что обжимать еще нужно научиться, да и скримпер дорого стоит) .

Далее подключаешь компьютеры к свитчу. Ву-а-ля! Физически кластер готов (принципиально он не отличается от локалки) . Но тут получается самое интересное. Чтобы компьютеры решали одну задачу нужноустаноыить соответствующий софт.

Если задачи хостинга — то проблем нет, устанавливаешь бесплатную Ubuntu Server (погугли как синхронизировать) и все. А если нужно рендерить 3D, либо осуществлять сверхсложные расчеты — нужно устанавливать Windows Server и специальные софтины.

К тому же чтобы рендерилось хорошо — видеокарты нужны мощные.

В офисе валяется куча ненужных, рабочих системных блоков. Вот я и решил объединить их в единую вычислительную сеть, а по сути в обычный компьютер управляемый единой ОС, но представляющий собой 3+ системных блока.

Итог: Мне нужно что бы 5+ коробок работала как одна, при этом я не хочу управлять каждым серваком отдельно, моя цель единая машина состоящая физически из нескольких под управлением одной системы. Что она будет делать? Да что угодно, хоть пусть будет web сервером с ip в интернете или просто рабочей станцией Ubuntu или fedora

4 ответа 4

обычно решения строятся от задачи, а не от платформы

что конкретно вы хотите делать?

из личного опыта — анализ логов на биллинге, и ретарификация: делал ручным шардингом на уровне приложения (скрипты на Python), на пачке списанных десктопов, аккаунте на конторском IBM eServer, и паре десктопов под windows.

если у вас межсоединения на древнем 100mbit ethernet, а не как минимум 1G (не говоря уж о спецжелезе типа Infiniband) — дешевле будет пойти в магазин, купить самую поганую материнку и набить ее памятью под завязку, съэкономите на дорогом быстром 1G свитче и энергопотреблении

ваш вариант конфигурации может быть эффективен только в одном случае: все параллельные потоки полностью независиммы, и каждый блок задачи польностью влазит в ОЗУ и ресурсы одного узла, неплохо решаются вычислительные задачи с полным отсутствием зависимостей в архитектуре «одна нода — один расчетный блок»

с другой стороны, в качестве кластерной рабочей станции подобная утилизация вполне интересная и имеет право на жизнь, и может оказаться выигрышным вариантом: на рабочей станции активно не более 2-3 тяжелых задач, остальные ресурсы тратятся на хранение гигабайтных вкладок в браузере, текстовые редакторы и редкие пробежки утилит по файловой системе

Linux реализаций похоже нет:

так что решение задачи в оригинальной постановке сводится по факту к освоению системного программирования в полном объеме: написать аналог ядра Linux обеспечивающий весь необходимый функционал DOS, адаптировать базовые библиотеки в т.ч. из поставки копиляторов GNU (libc, libatomic, gomp. ) и пересобрать всю систему до состояния, когда сможет работать весь компплект ПО который вы используете

возможно более простым решением может оказаться написание слоя виртуализации: переписать только слой всех системных библиотек, который использует ваше прикладное ПО, с реализацией функционала distributed POSIX поверх обычных дистрибутивов, поставленных на каждый узел, или гипервизоров (желаю много весеслья с исходниками Xen и libgcc/libstdc++ 😎

с практической точки зрения:

- ищите задачи с минимальным объемом обмена данными между потоками, и

- пишите свое ПО: смотрите в сторону готовых распределенных платформ для веб/микросервисов, требующие для работы минимальных ресурсов

- перетаскивайте бизнес-процессы в вашей конторе на веб-технологии, чтобы можно было раздать хилое железо юзерам в качестве терминалов/запускалок браузеров

к сожалению, насколько знаю бесплатных реализаций распределенного Smalltalk не существует, а то бы в первую очередь посоветовал его — как вариант, искать библиотеки для программирования на распределенном обмене сообщениями между объектами для mainstream языков

Данная статья подойдёт для новичков, которые хотят потренироваться в настройке кластера Hyper-V 2019. Итак, имеется:

— Тестовый комп1 «железный»

— Тестовый комп2 «железный»

— Тестовый комп3 «виртуальный» с Windows srv 2019 и настроенной ролью контроллера домена.

— Тестовый комп4 «железный» с расшаренным диском по протоколу iSCSI.

— Всё это соединено через обычный пассивный коммутатор.

На тестовый комп1 установлена Windows Srv 2019 Standard Evaluation с графической оболочкой. На тестовый комп2 установлена Microsoft Hyper-V Server 2019 — данная ОС бесплатна и устанавливается как обычная Windows 10/2019. Скачать эту ОС можно с оф.сайта Microsoft:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-hyper-v-server-2019

Собственно, на этой же странице можно скачать и Windows Srv 2019 Standard Evaluation. И если, после установки Windows Srv 2019 с графической оболочкой, вопросов о том, как ей пользоваться дальше, нету, то после установки Hyper-V Server 2019 могут возникнуть вопросы, что с этой ОС делать дальше. Ведь у Hyper-V Server 2019 графической оболочки нет. После установки есть лишь вот такое окно:

Здесь можно сделать самые основные настройки: задать имя компьютера, прописать статический IP, включить доступ по RDP.

Для дальнейшего удобства администрирования данной ОС, я установлю пару инструментов. Первый из них — это банальный Total Commander portable, который я просто скопирую на диск C: с флэшки. Сделать это можно командой:

xcopy f:totalcmd c:totalcmd /y /e

Где f:totalcmd — это каталог с total командером на флэшке, а c:totalcmd — каталог, в который копирую.

Потом перехожу в этот каталог и запускаю тотал командер:

c:

cd c:totalcmd

totalcmd.exe

Дальше уже будет проще. Пользуясь тотал командером, нахожу каталог с драйверами и устанавливаю их.

Следующий инструмент, который облегчит администрирование Hyper-V Server 2019 — это WINDOWS ADMIN CENTER. Это вэб-админка от Microsoft, с помощью которой можно администрировать сервер через вэб-интерфейс. Некий аналог Webmin, но для Windows-систем. Скачать его можно на той же странице, где скачивались установочные образы операционных систем:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-windows-admin-center

Дистрибутив Windows админ центра можно тоже перенести через флэшку на сервер.

Установка данного программного обеспечения самая обычная, где все параметры можно оставить по умолчанию.

После установки Windows админ центра нужно зайти на сервер через обычный браузер по https протоколу:

https://192.168.0.206/

Сообщение безопасности нужно игнорировать, т.к. используется самоподписанный сертификат. Логин и пароль при подключении — это виндовый «администратор» с его паролем в самой ОС. Вот так выглядит Windows Admin Центр:

В списке серверов выбираю свой, который также стал шлюзом Windows AdminЦентра. Ну и подробно на всех возможностях останавливаться не буду, т.к. их много. Вэб-интерфейс хоть и тормозной, но довольно функциональный — через него можно будет управлять и виртуальными машинами в том числе. Или, например, если какие-то драйвера не установлены, то их можно доустановить уже через Windows AdminЦентр:

Я же пробую ввести данный сервер в домен. Жму на меню «Обзор» и затем на «Изменить идентификатор компьютера».

Ну а дальше, всё как обычно:

Сервер перезагрузится. После чего, в Windows Admin Центр рекомендуется войти уже под доменным администратором! Имя пользователя надо вводить в таком формате:

Ну и кстати, желательно бы установить обновления для Windows Admin Центра, если они есть. Для этого надо нажать на шестерёнку и выбрать пункт «расширения». Ну и там дальше всё понятно будет:

Разобравшись с сервером на ОС Hyper-V Server 2019, сделаю всё то же самое и на сервере под управлением Windows Srv 2019 Standard Evaluation. Там уже всё делается в привычном виде — через графическую оболочку Windows. Установил драйверы, ввел сервер в домен AD — подробности этого всего описывать не буду.

Следующим шагом будет подключение сетевого диска iSCSI. Захожу в «Средства администрирования»:

И там выбираю Инициатор iSCSI:

При первом запуске выйдет сообщение о том, что служба iSCSI не запущена, и будет предложено запустить эту службу и включить её автозапуск при старте сервера. Ну а потом появится окно, в котором надо будет перейти на вкладку «Обнаружение» и нажать на кнопку «Обнаружить портал»:

Затем надо ввести IP-адрес сервера iSCSI:

В моём случае, этого будет достаточно. Но если iSCSI сервер требует пароль для подключения к себе, то надо нажать кнопку «Дополнительно» и там ввести этот пароль.

Далее, надо перейти на вкладку «Конечные объекты» и нажать кнопку «Подключить»:

В появившемся окне надо нажать на «ОК», после чего диск перейдёт в состояние «Подключено»:

Всё, это окно можно закрывать. Дальше надо зайти в диспетчер управления дисками, в котором отобразится подключенный iSCSI диск. Его надо проинициализировать и отформатировать в NTFS:

Сильно подробно это не буду расписывать. Уверен, что форматировать диск под NTFS умеют все ИТ-специалисты. После форматирования можно попробовать что-нибудь записать на него, чтобы убедиться в работоспособности диска.

Далее, этот же диск надо подключить на втором сервере под управлением Hyper-V Server 2019. На самом деле, там это всё делается точно также. Надо лишь в командной строке ввести:

iscsicpl

Появится точно такое же окно, как и на сервере с графической оболочкой:

Нужно проделать те же действия, что и на первом сервере. Но в диспетчер дисков заходить уже не нужно. Достаточно просто подключить диск по iSCSI.