Дата: 19.05.2015 Автор Admin

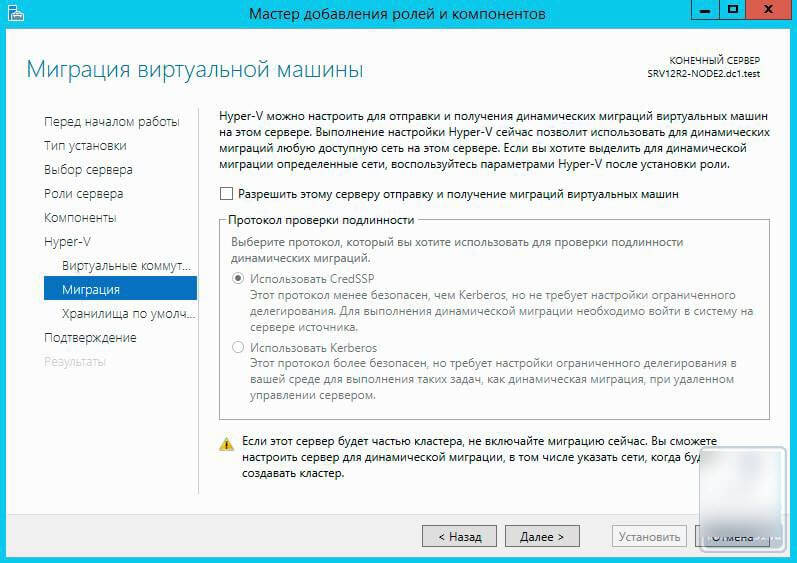

В данной статье мы рассмотрим как настроить Отказоустойчивый ISCSI кластер на Windows Server 2012 R2.Для настройки нам понадобятся 2 сервера.

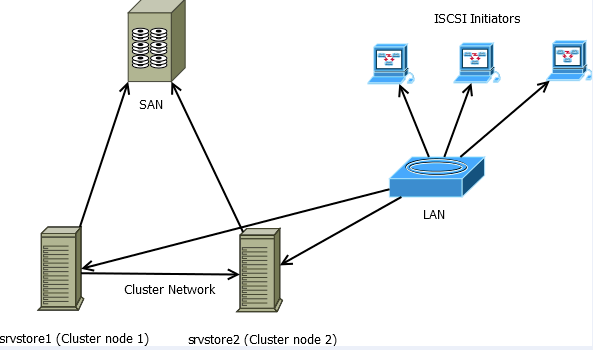

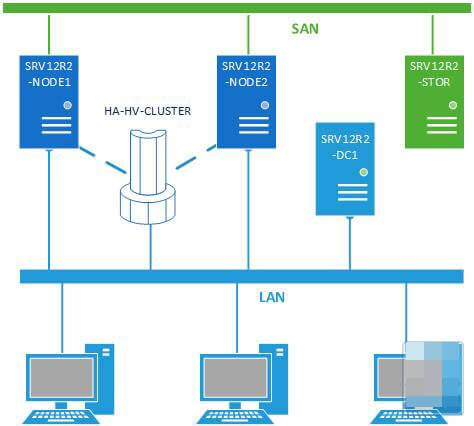

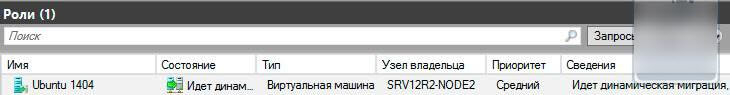

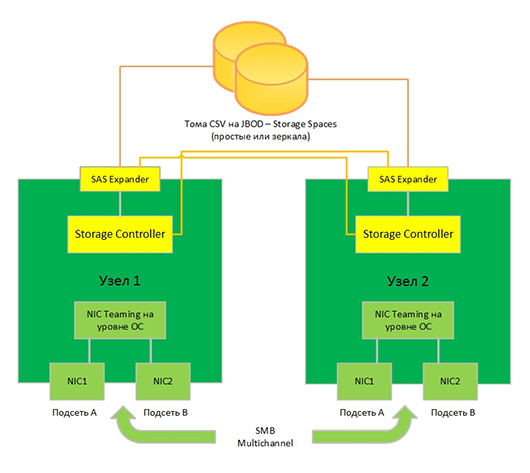

Кластер в данной статье будет настраиваться по следующей схеме:

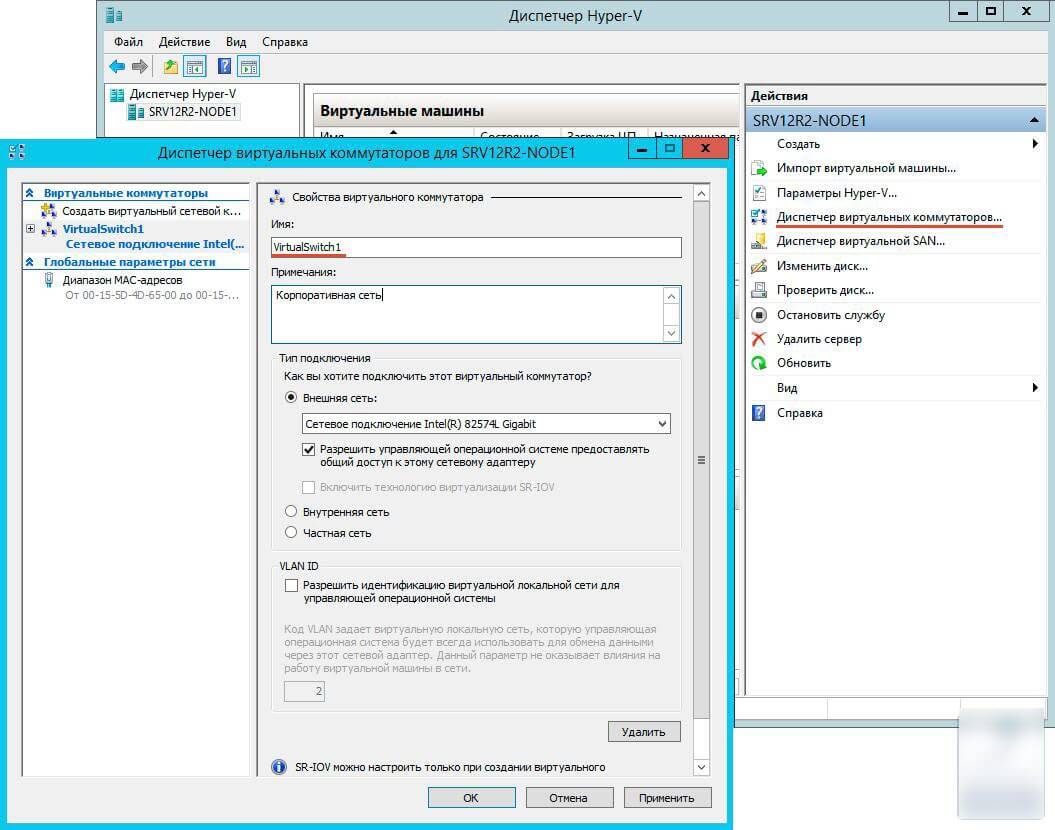

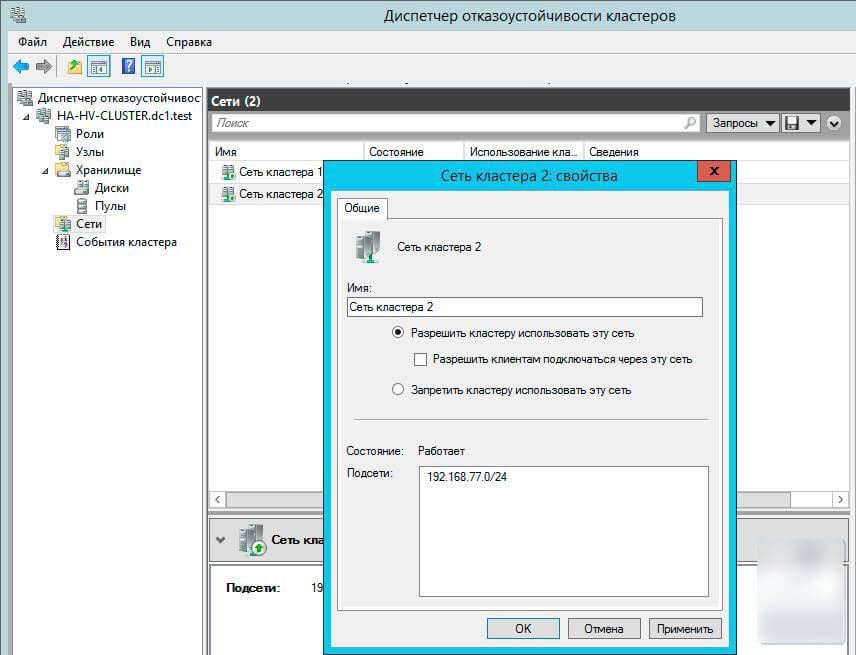

Соответственно у вас должна быть сеть хранения данных, подключенная по FC, SAS или ISCSI (необходим ISCSI протокол версии не ниже iSCSI-3)

Должна быть настроена LAN сеть на каждом узле кластера, и отдельная сеть между кластерами.

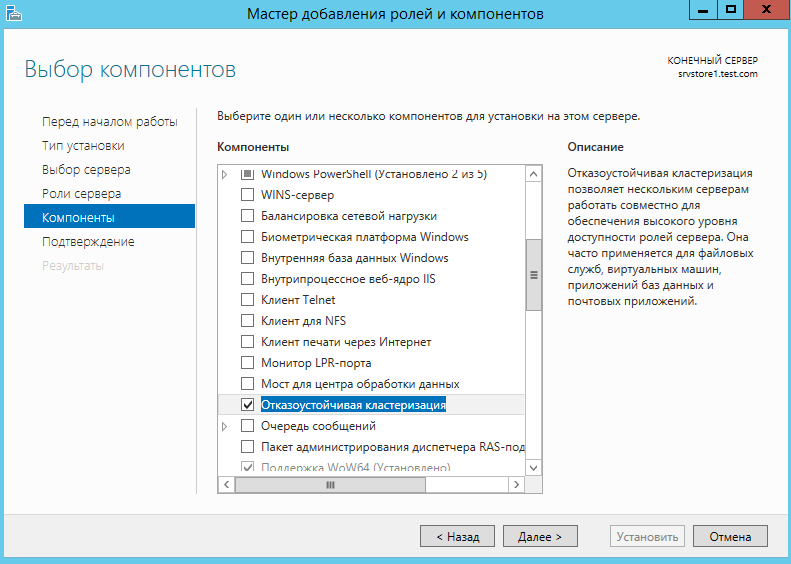

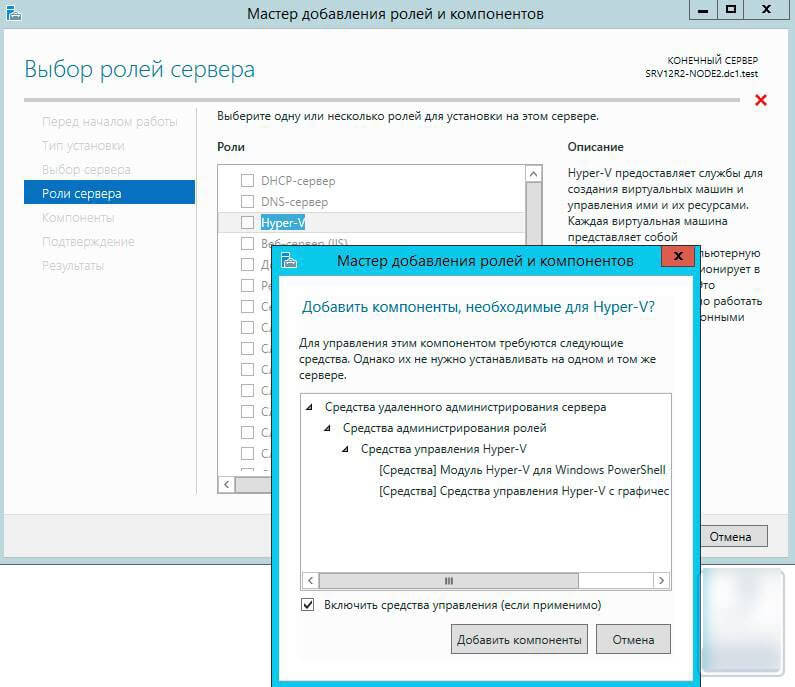

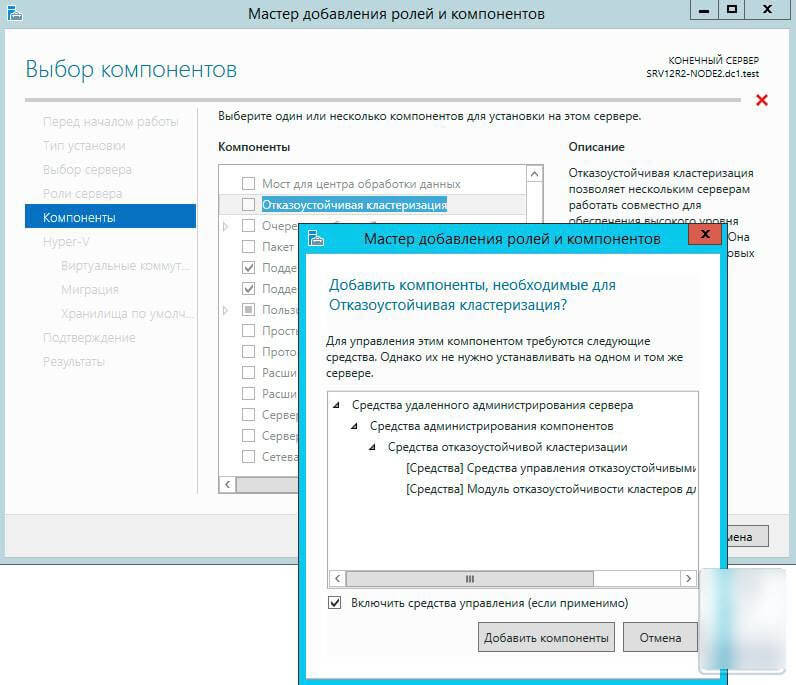

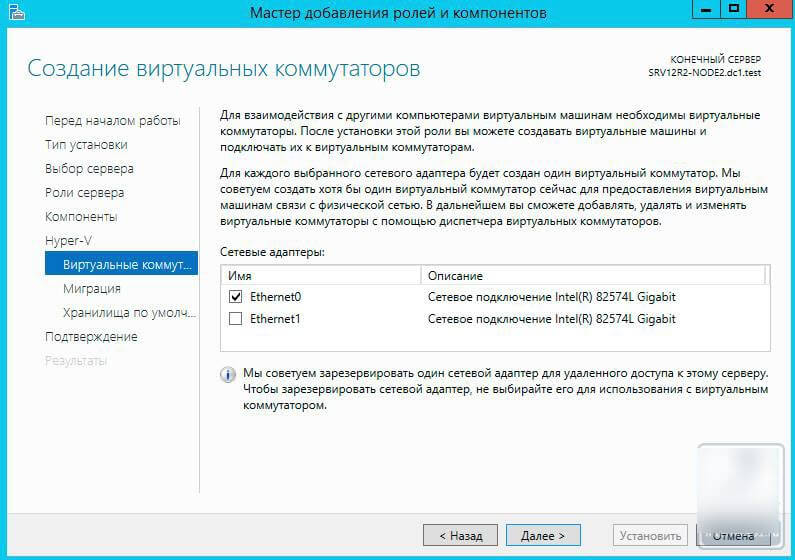

На первом сервере включаем компонент «отказоустойчивая кластеризация»

Нажимаем далее, и выбираем установить.

По аналогии устанавливаем компонент на втором сервере.

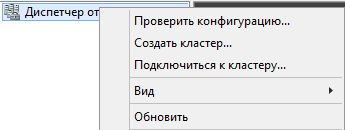

Перейдем на первый сервер и перейдем к созданию кластера.

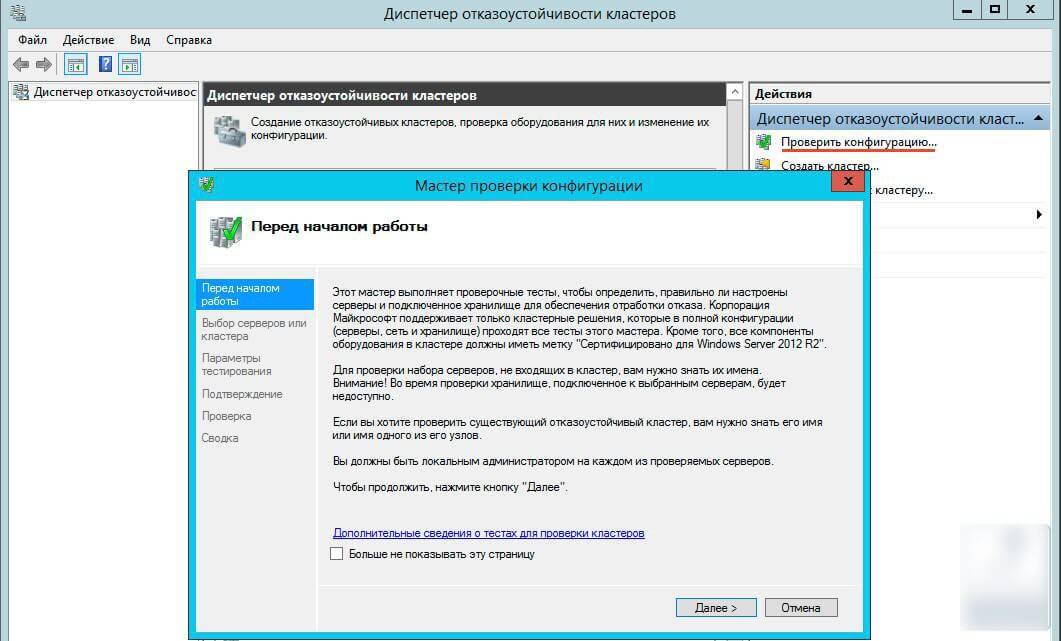

Открываем Диспетчер отказоустойчивости кластеров.

Выбираем создать кластер

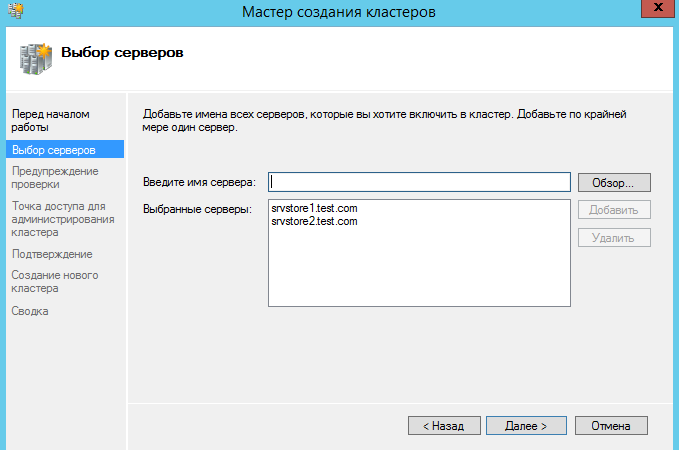

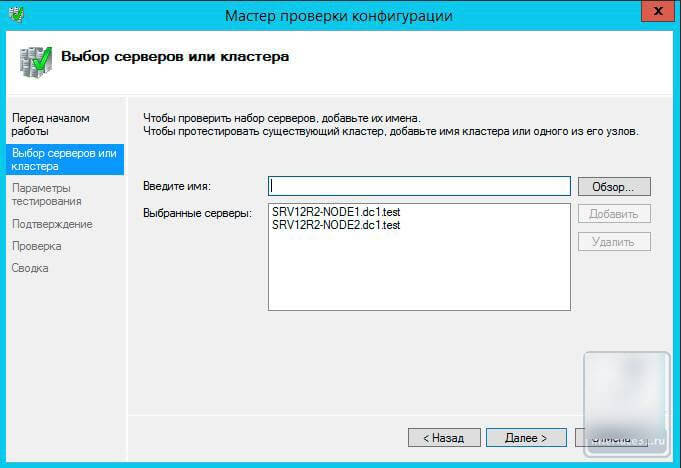

Добавляем сервера (узлы кластера)

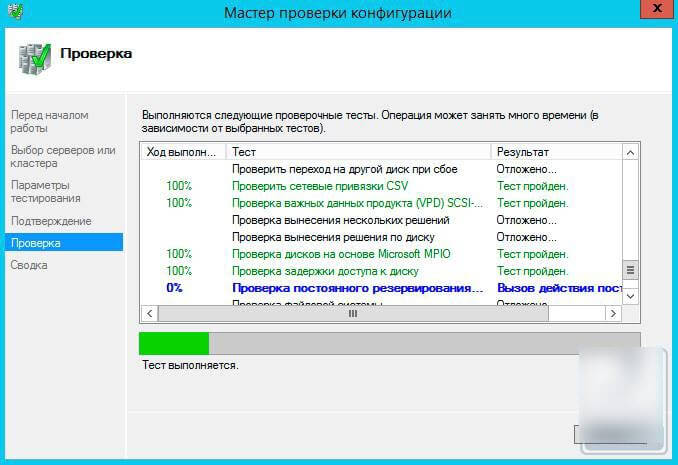

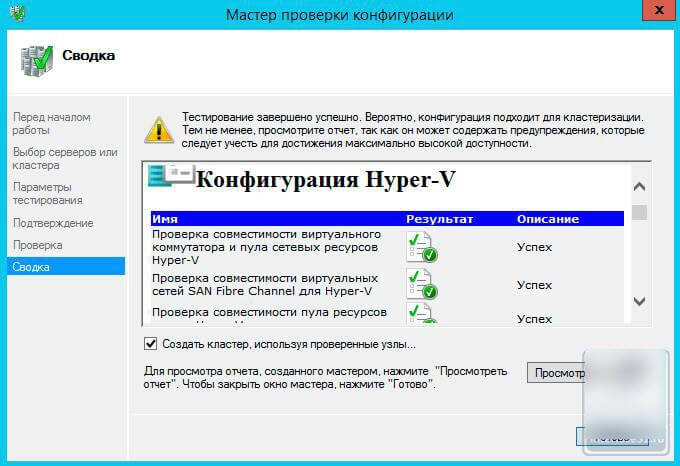

Далее по желанию запускаем проверочные тесты.

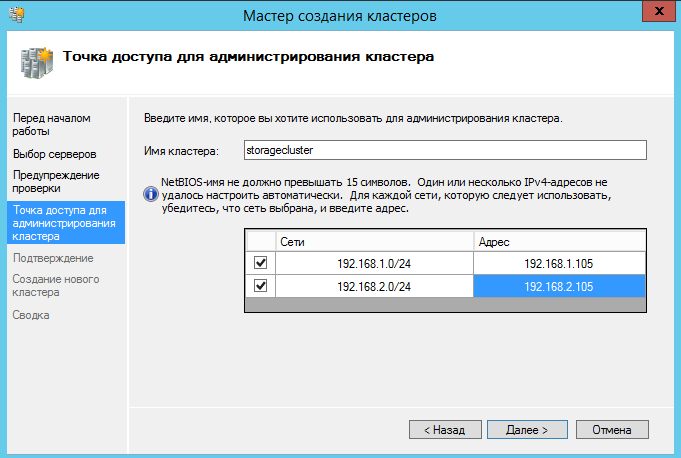

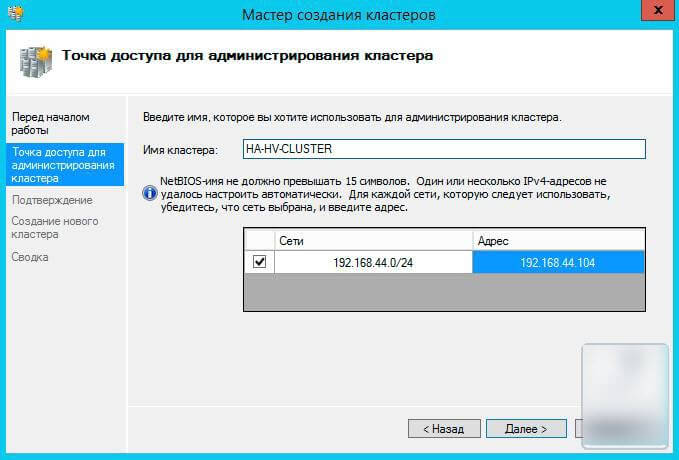

Вводим имя кластера и адреса.

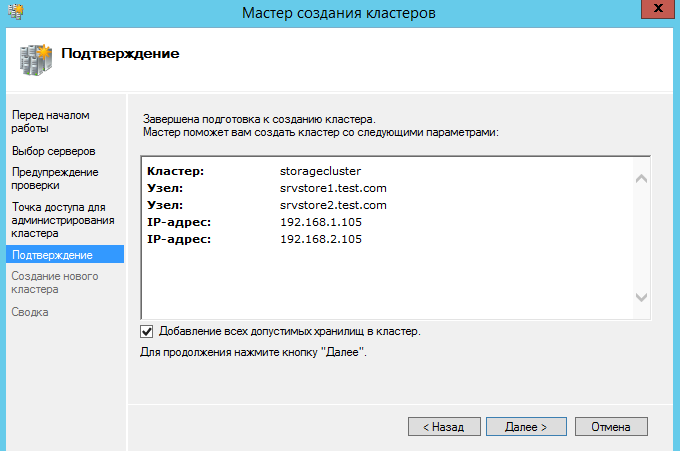

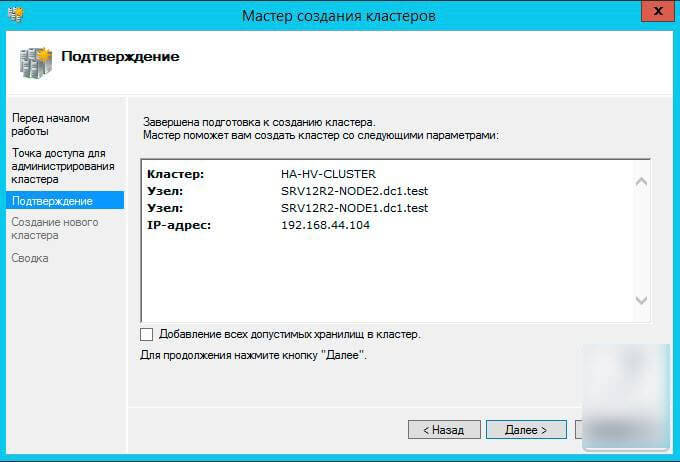

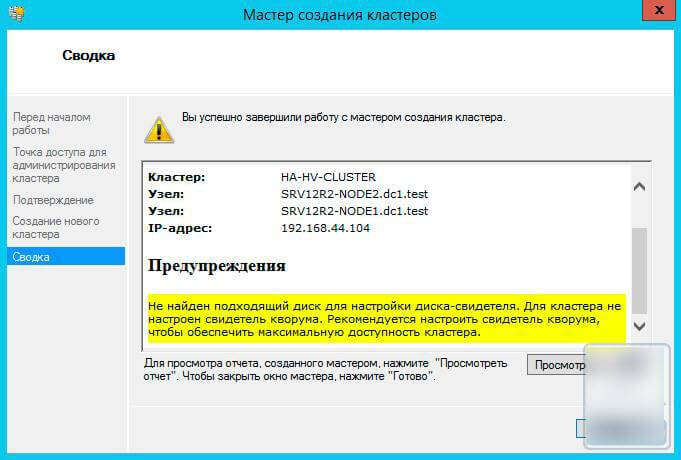

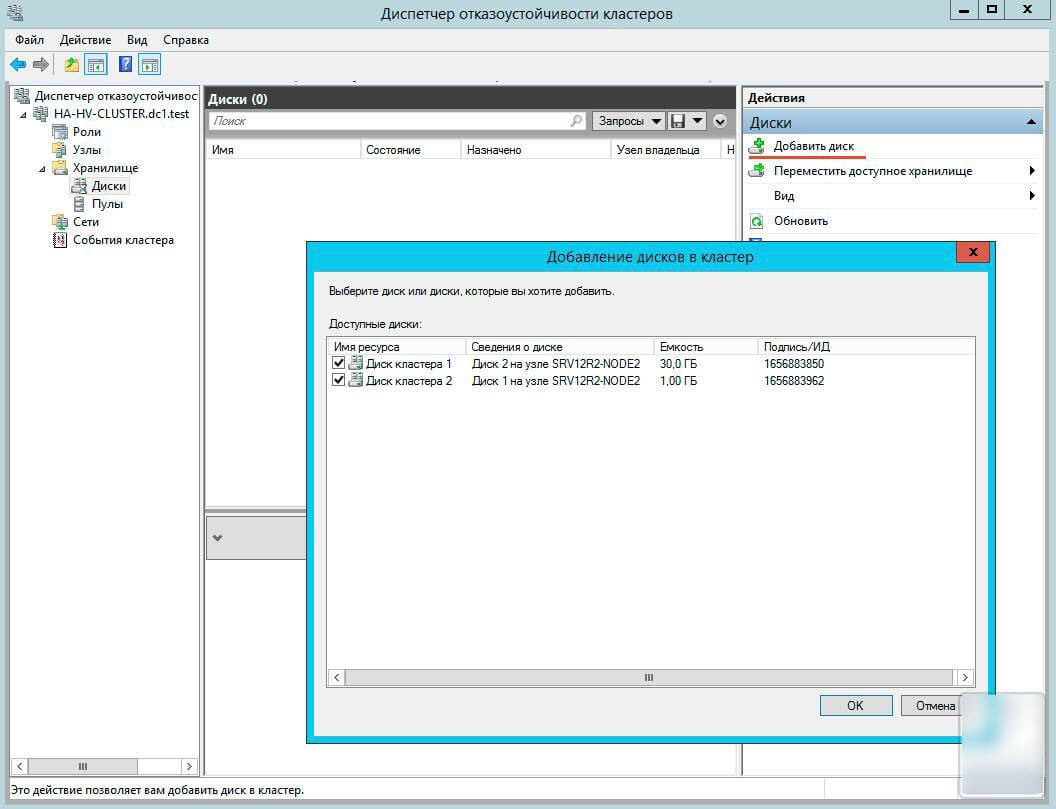

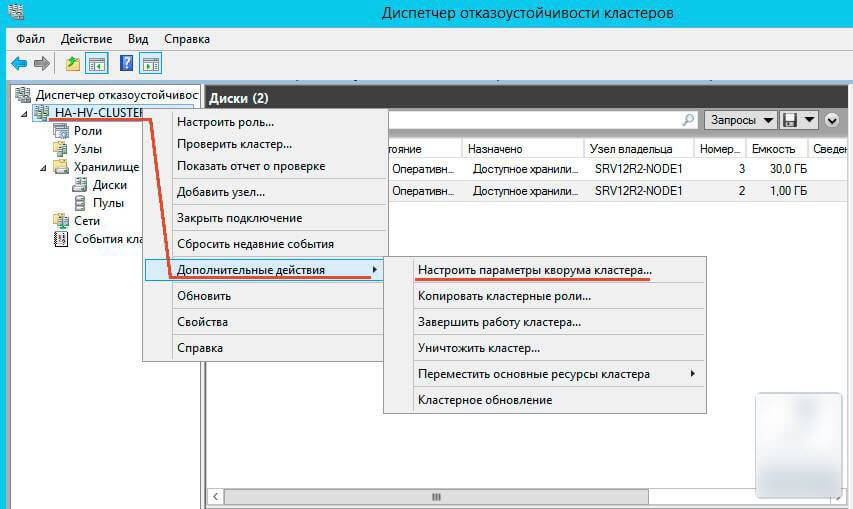

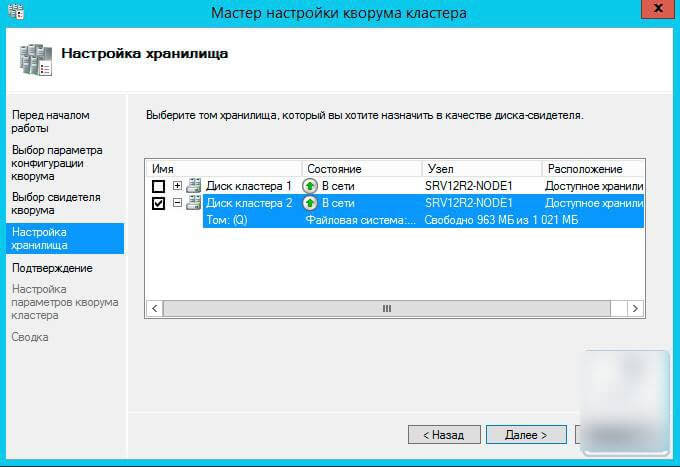

Создаем кластер. Обязательно добавляем все допустимые хранилища.

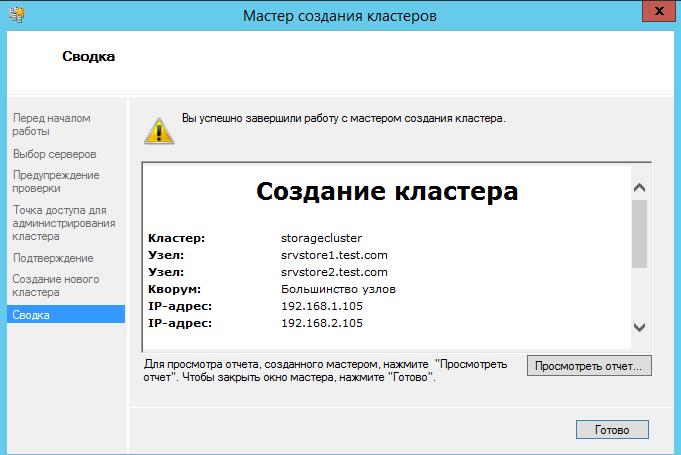

Дождитесь окончания работы мастера. Если мастер не находит узлы кластера, проверьте настройки брандмауэра или сети.

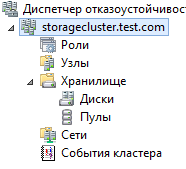

Далее в консоли должен появится созданный кластер.

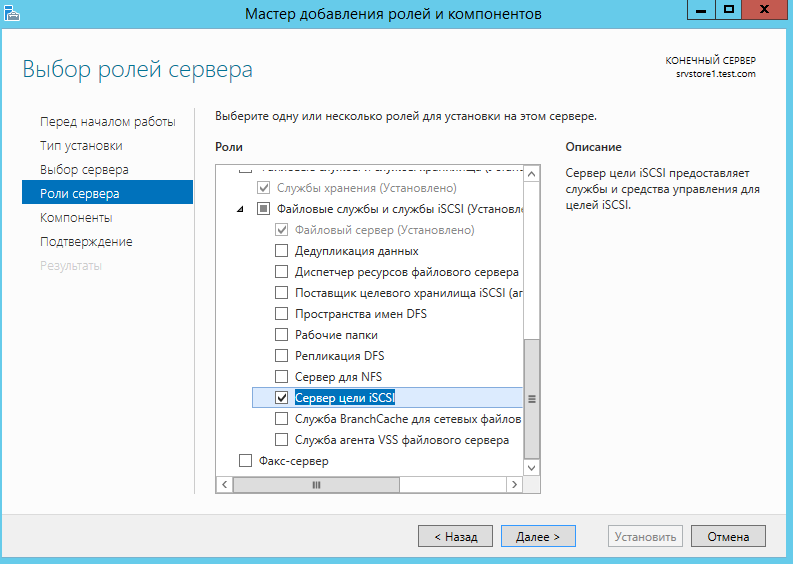

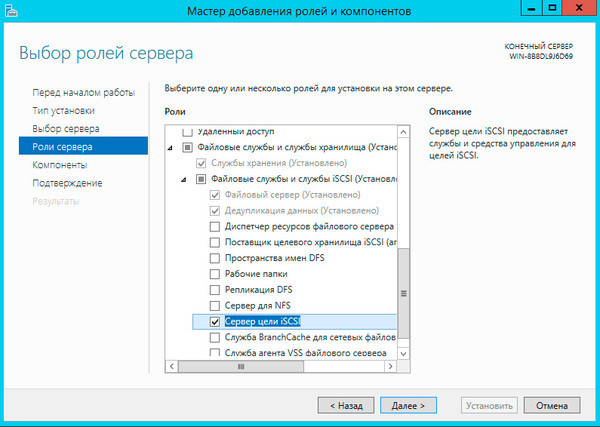

Добавляем роль ISCSI target на каждый узел кластера.

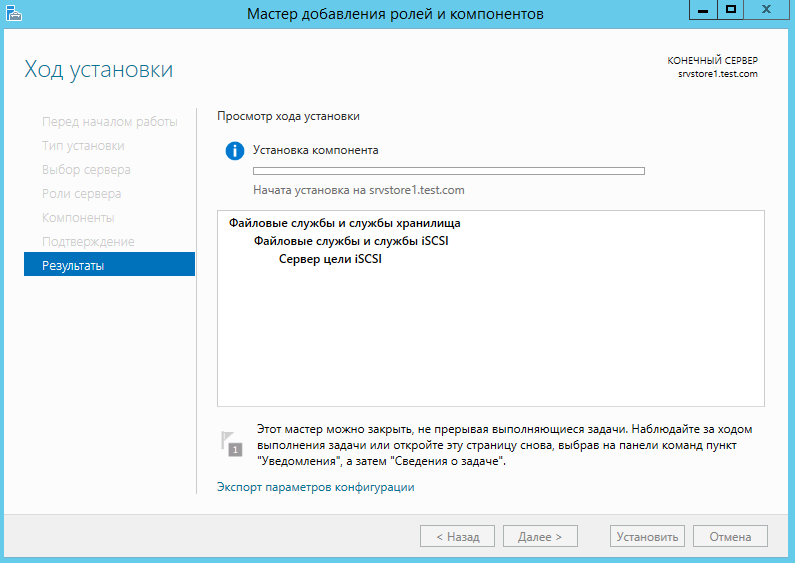

Дожидаемся установки компонента роли.

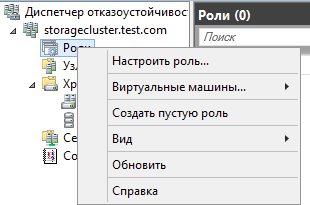

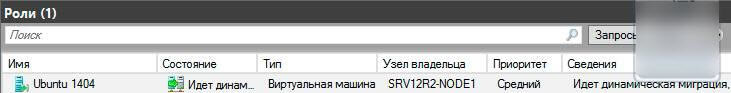

Возвращаемся в консоль управления кластером, и добавляем новую роль кластера.

Выбираем «Настроить роль»

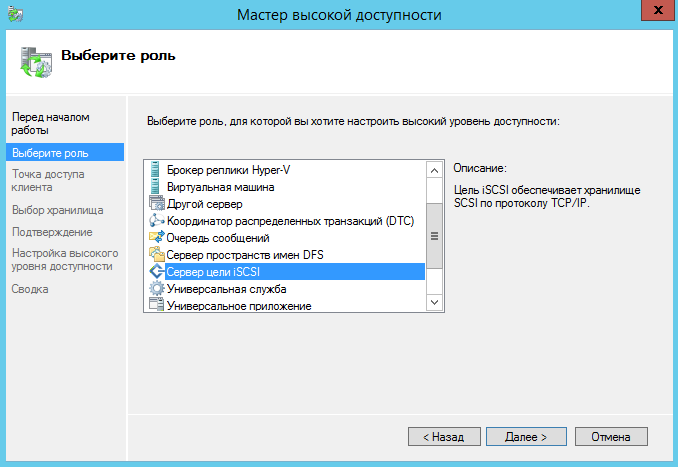

Выбираем роль ISCSI сервера

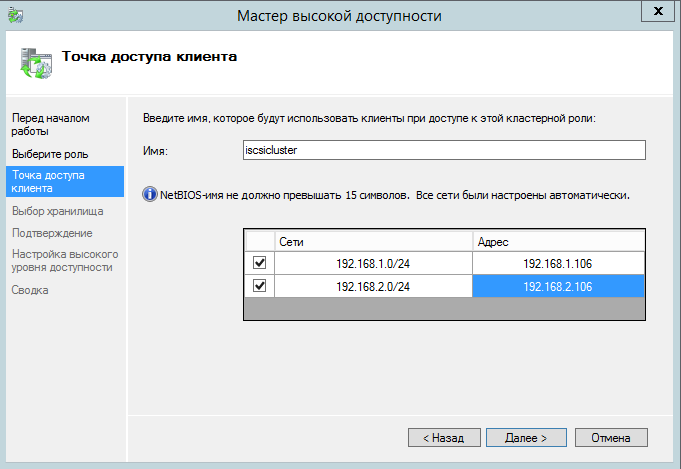

Указываем название кластера и сетевые адреса.

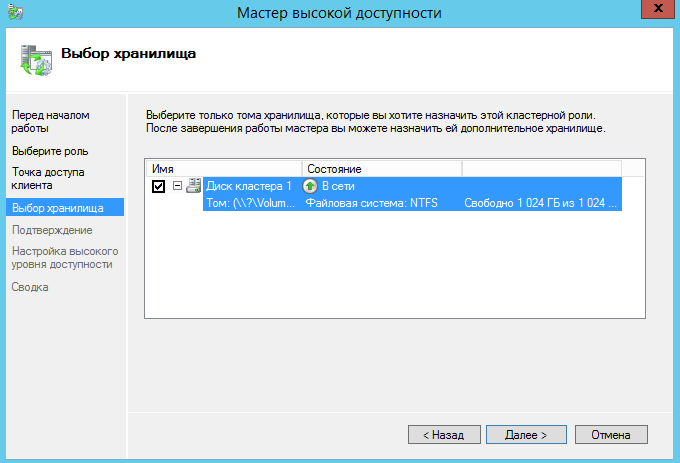

Выбираем диск кластера.

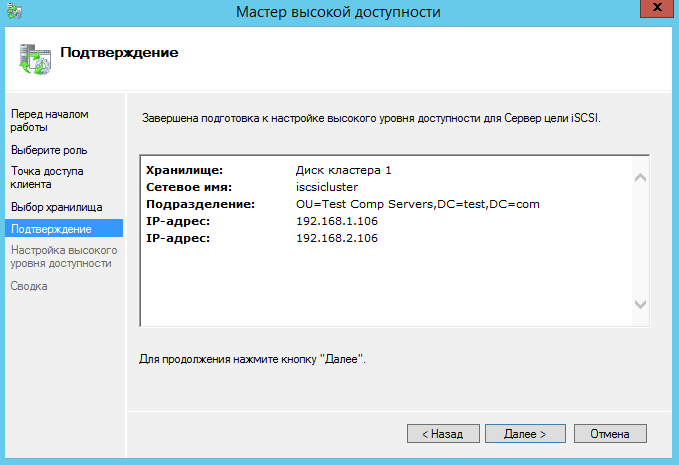

Подтверждаем создание роли.

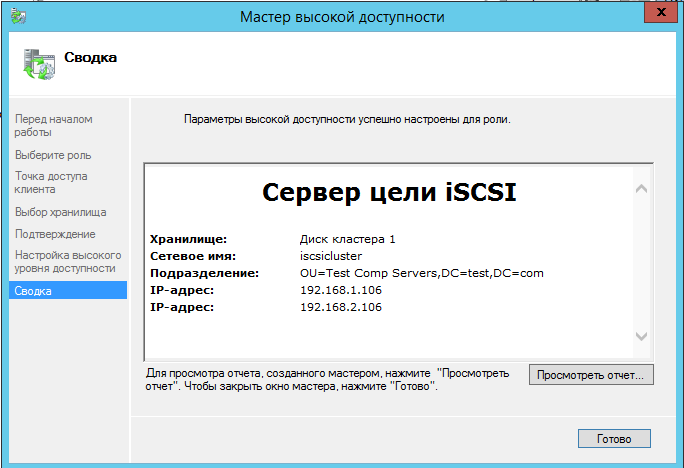

Дожидаемся установки роли.

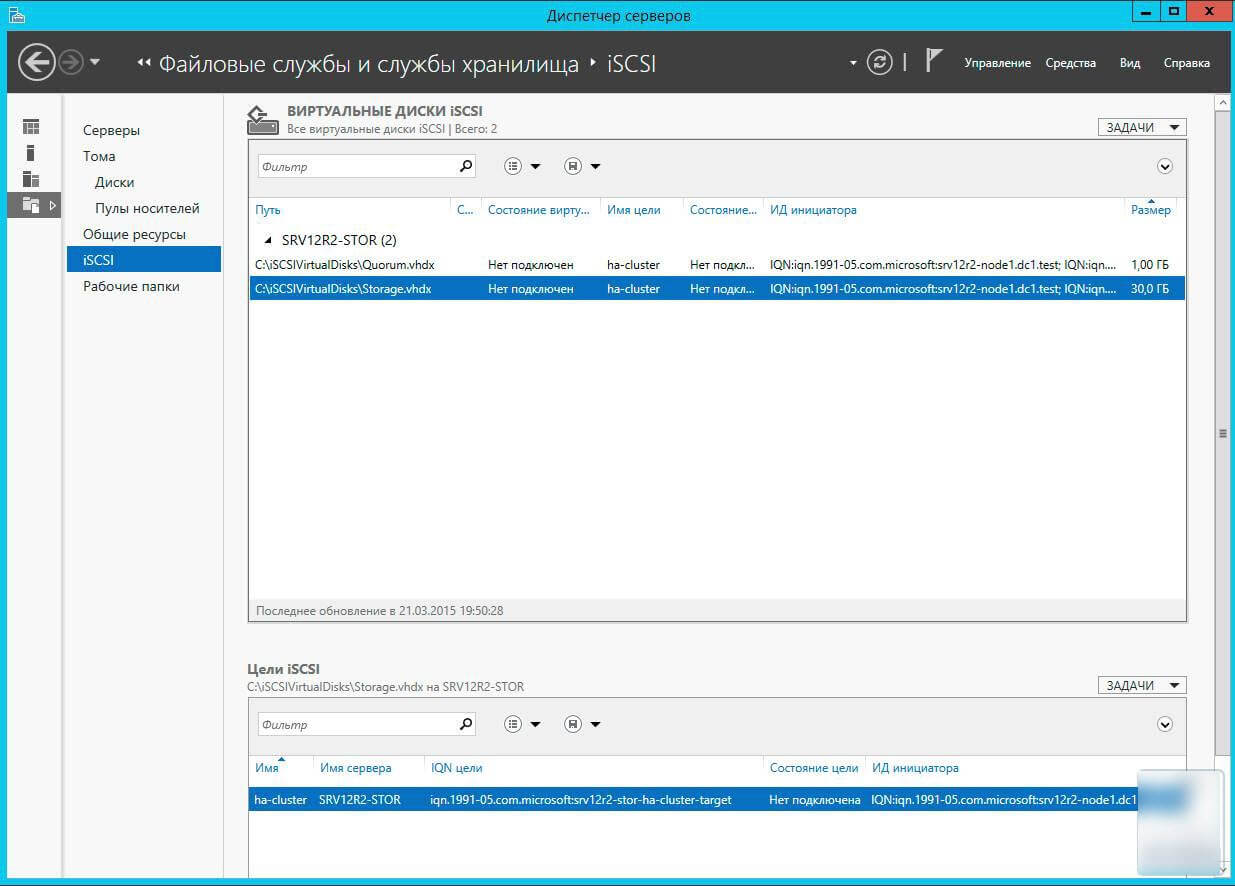

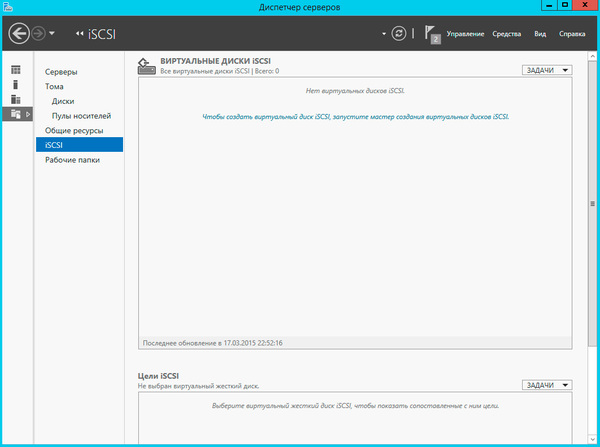

Теперь перейдем к настройке ISCSI сервера.

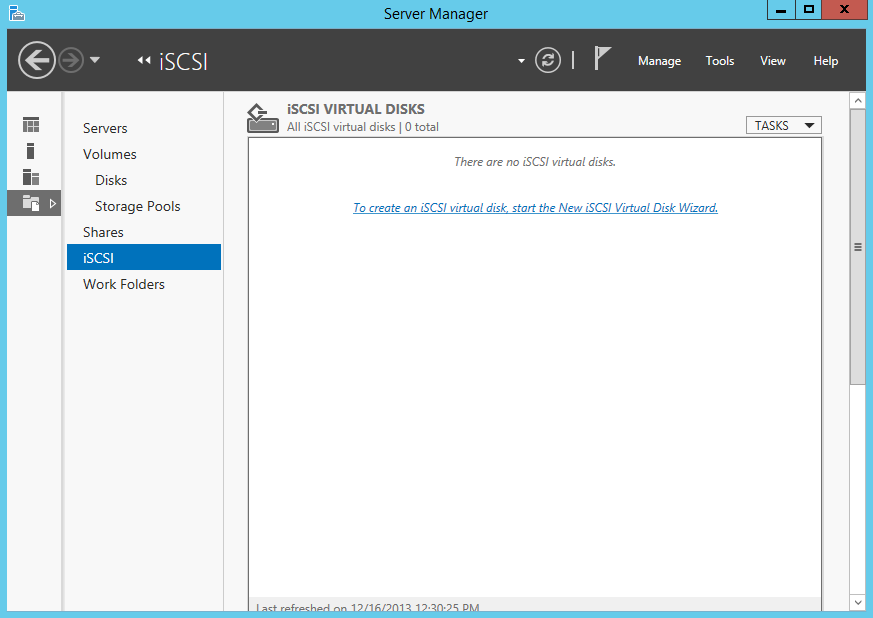

На одном из узлов кластера открываем диспетчер сервера, в нем открываем файловые службы и выбираем ISCSI.

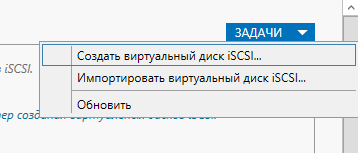

Запускаем мастер создания ISCSI диска.

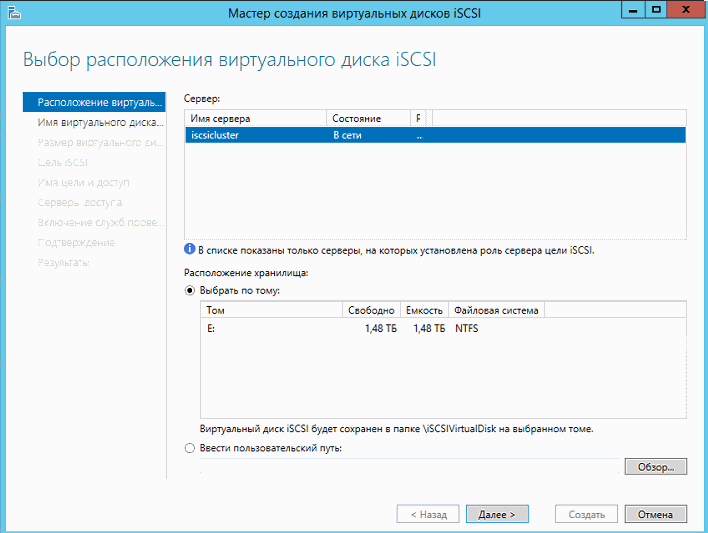

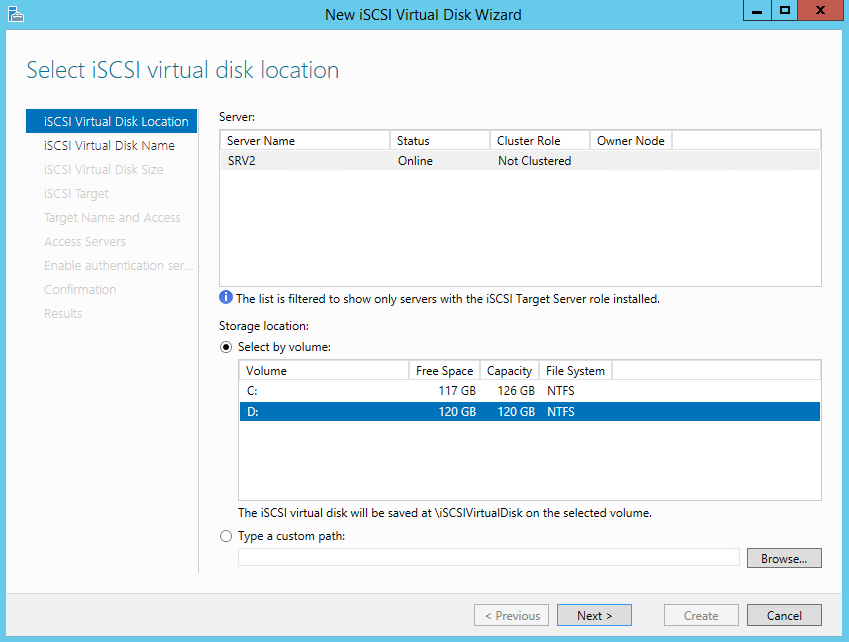

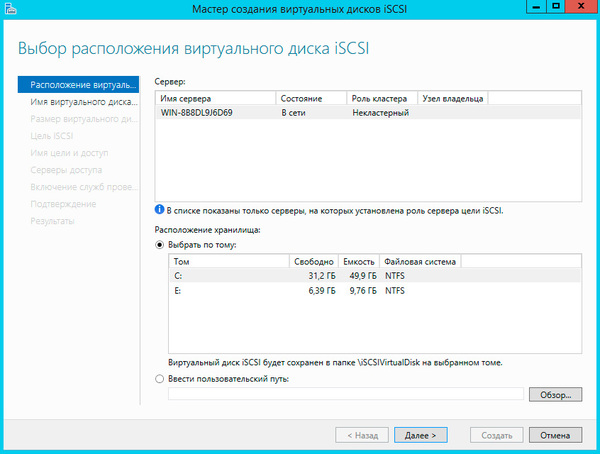

Выбираем кластер и общий кластерный диск.

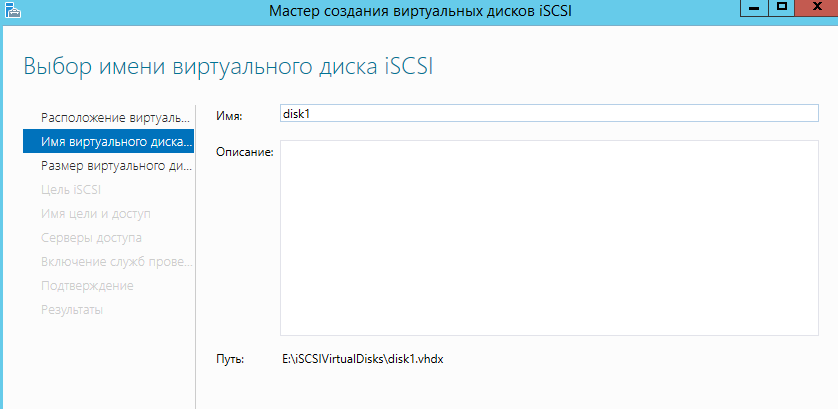

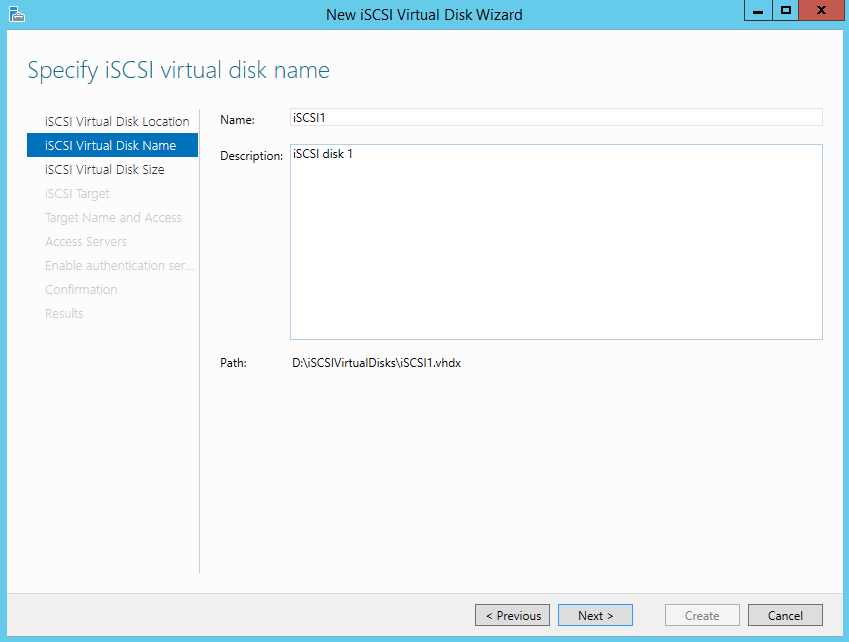

Вводим название диска.

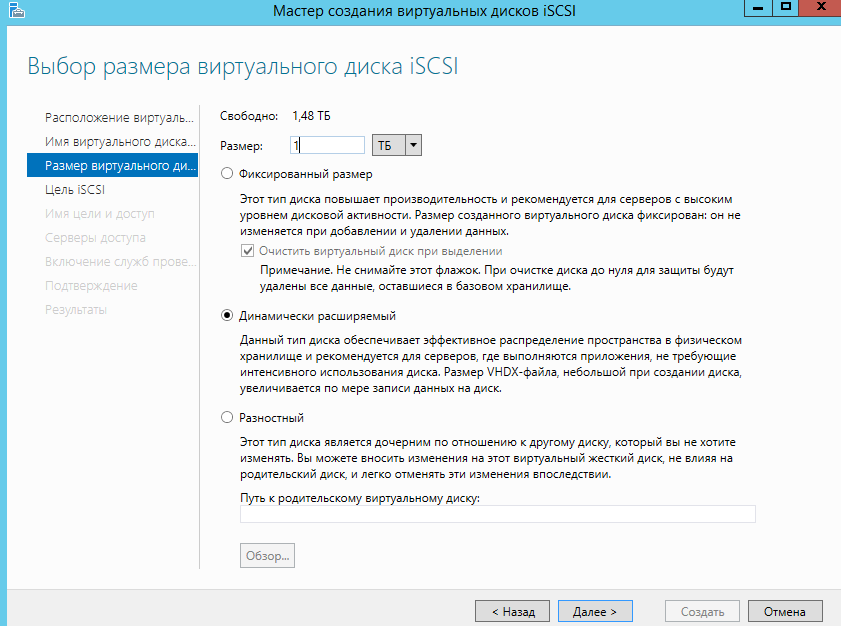

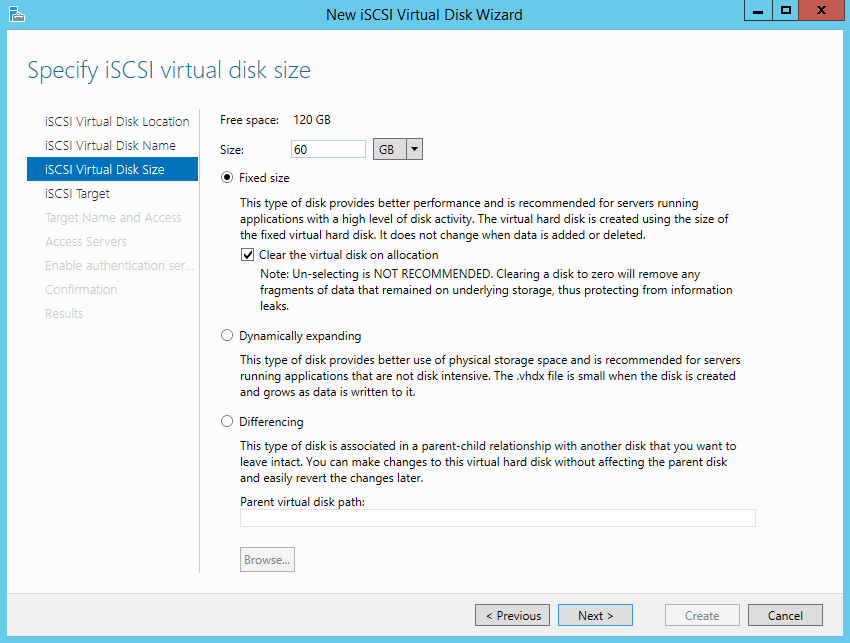

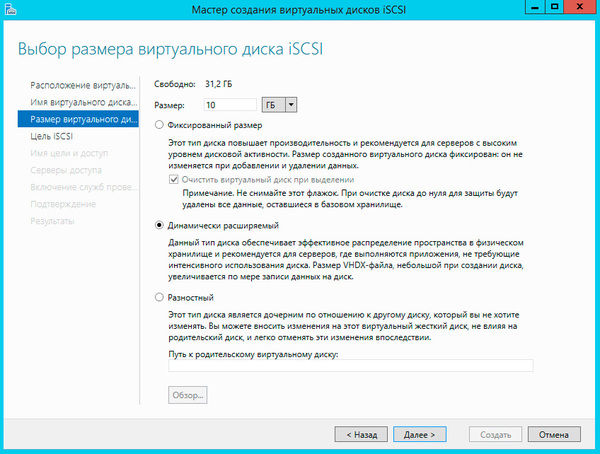

Указываем размер диска и его тип.

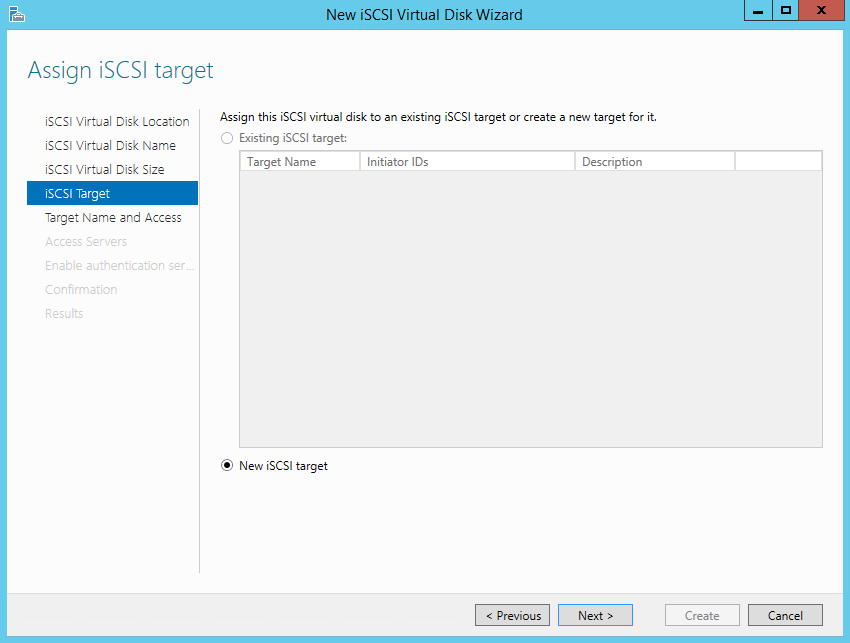

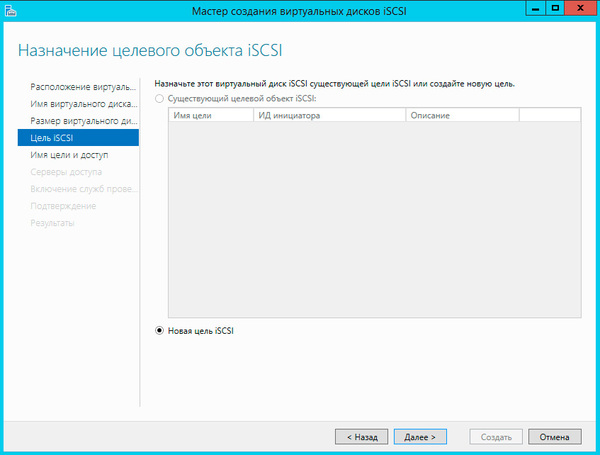

Далее выбираем пункт — «Новая цель ISCSI»

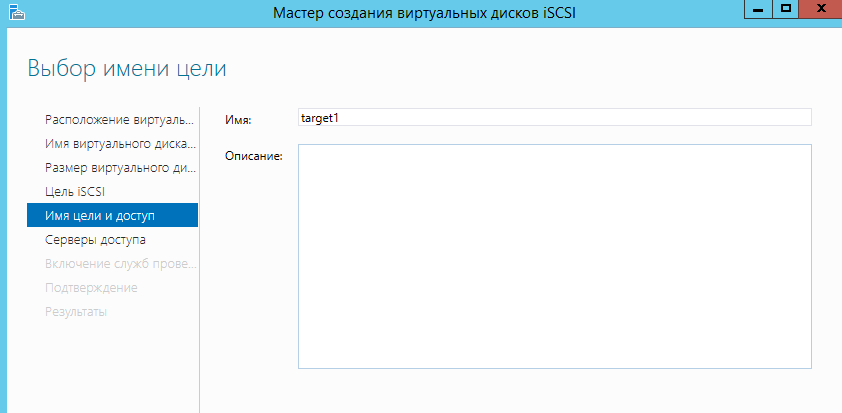

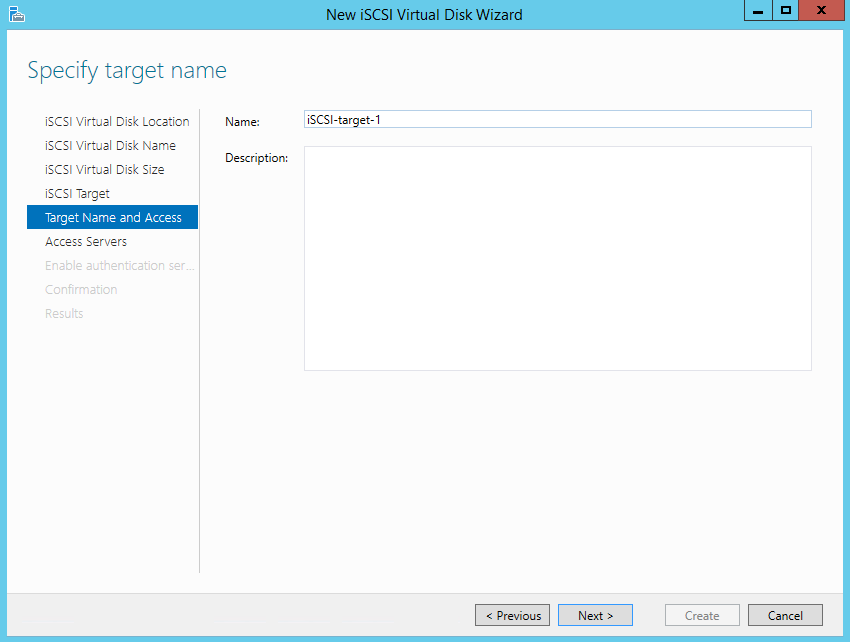

Далее вводим название цели ISCSI.

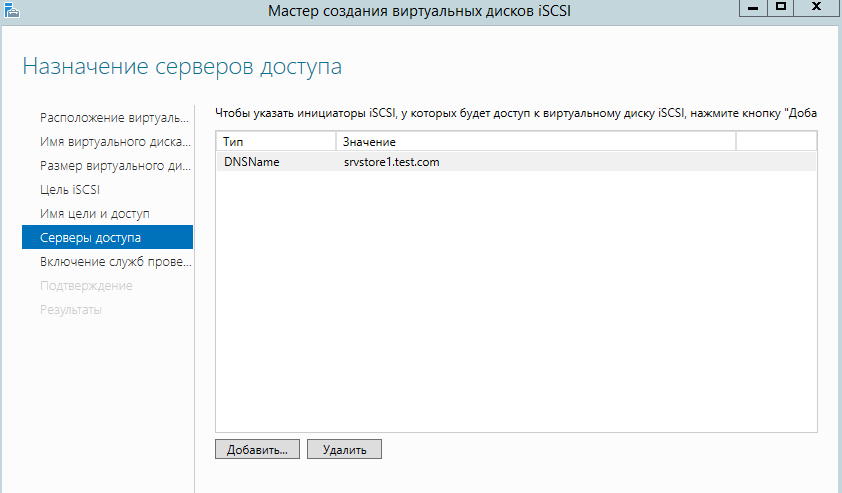

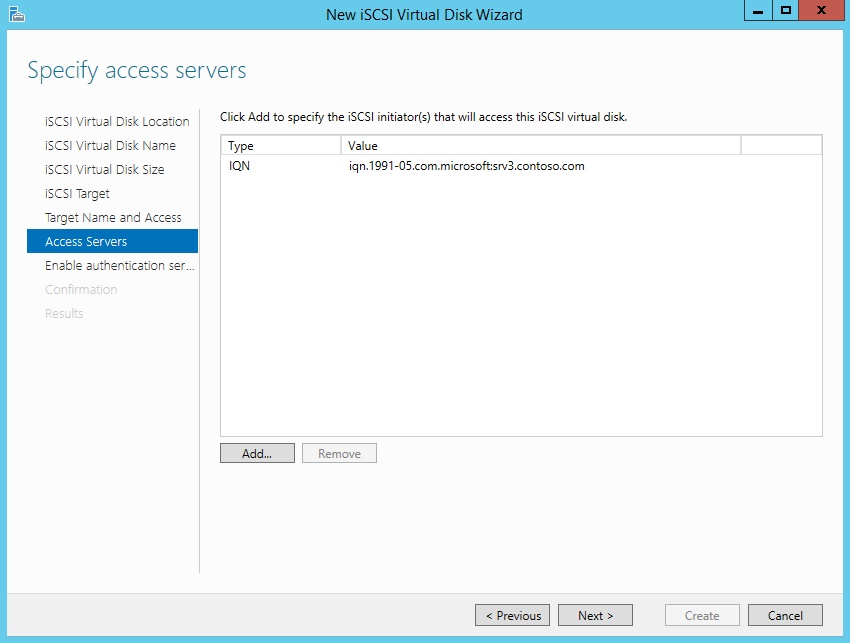

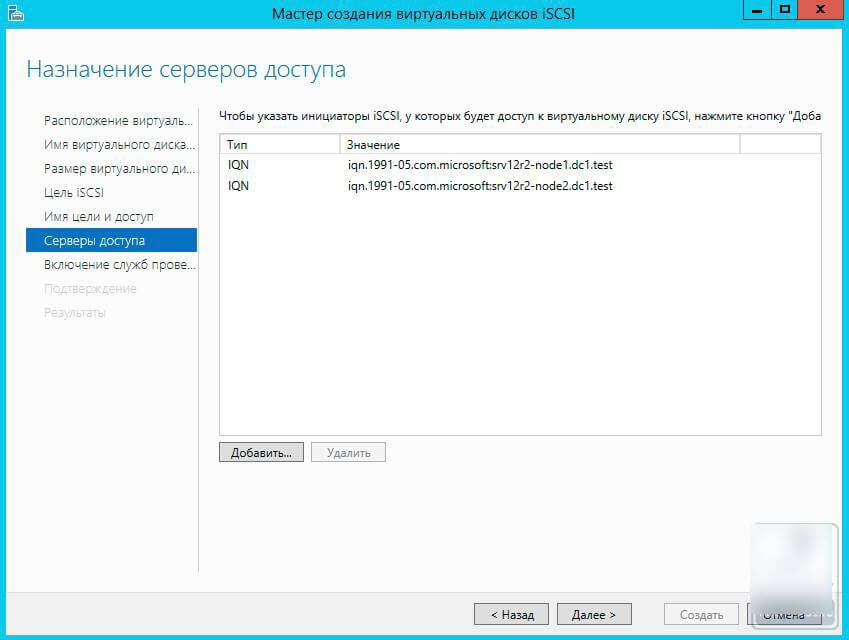

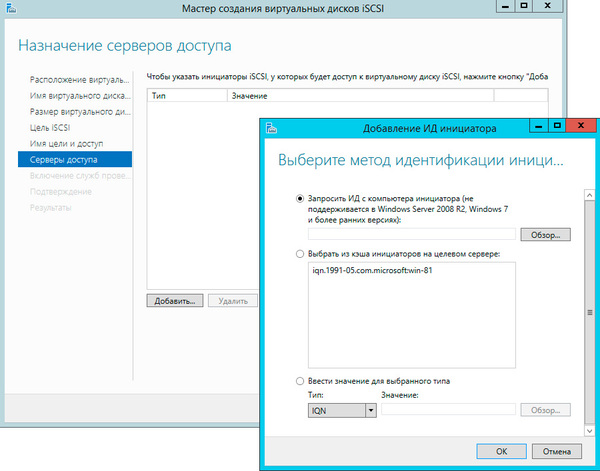

Указываем каким серверам можно подключаться к ISCSI цели.

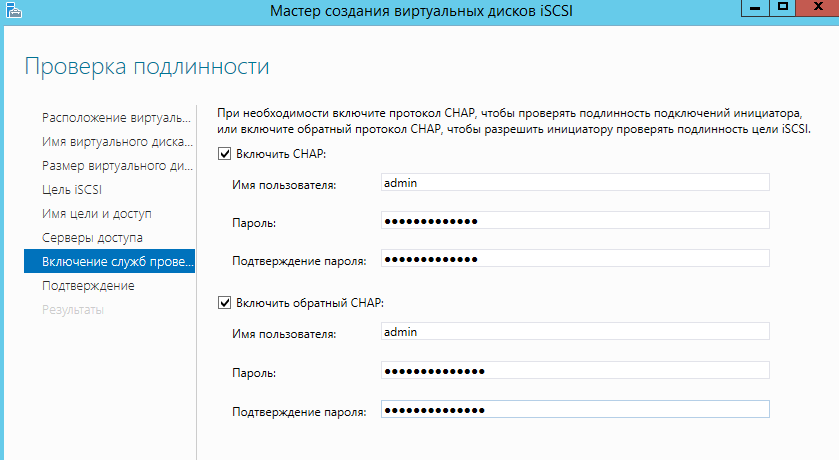

Указываем учетные данные для подключения.

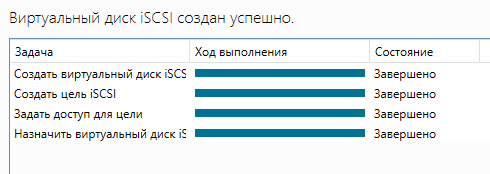

Далее нажимаем «Создать» и ожидаем окончания работы мастера.

Готово! Теперь указанные клиенты могут подключаться к кластеру ISCSI. Для подключения нужно использовать DNS имя кластера.

Удачной установки!

Related posts:

В данной статье будет показано, как построить отказоустойчивый кластер Server 2012 с двумя узлами. Сначала я перечислю обязательные условия и представлю обзор настроек аппаратной среды, сети и хранилища данных. Затем будет подробно описано, как дополнить Server 2012 функциями отказоустойчивой кластеризации и использовать диспетчер отказоустойчивого кластера для настройки кластера с двумя узлами

В Windows Server 2012 появилось так много новшеств, что за всеми уследить трудно. Часть наиболее важных строительных блоков новой ИТ-инфраструктуры связана с улучшениями в отказоустойчивой кластеризации. Отказоустойчивая кластеризация зародилась как технология для защиты важнейших приложений, необходимых для производственной деятельности, таких как Microsoft SQL Server и Microsoft Exchange. Но впоследствии отказоустойчивая кластеризация превратилась в платформу высокой доступности для ряда служб и приложений Windows. Отказоустойчивая кластеризация — часть фундамента Dynamic Datacenter и таких технологий, как динамическая миграция. Благодаря Server 2012 и усовершенствованиям нового протокола Server Message Block (SMB) 3.0 область действия отказоустойчивой кластеризации стала увеличиваться, обеспечивая непрерывно доступные файловые ресурсы с общим доступом. Обзор функциональности отказоустойчивой кластеризации в Server 2012 приведен в опубликованной в этом же номере журнала статье «Новые возможности отказоустойчивой кластеризации Windows Server 2012».

.

Обязательные условия отказоустойчивой кластеризации

Для построения двухузлового отказоустойчивого кластера Server 2012 необходимы два компьютера, работающие с версиями Server 2012 Datacenter или Standard. Это могут быть физические компьютеры или виртуальные машины. Кластеры с виртуальными узлами можно построить с помощью Microsoft Hyper-V или VMware vSphere. В данной статье используются два физических сервера, но этапы настройки кластера для физических и виртуальных узлов одни и те же. Ключевая особенность заключается в том, что узлы должны быть настроены одинаково, чтобы резервный узел мог выполнять рабочие нагрузки в случае аварийного переключения или динамической миграции. Компоненты, использованные в тестовом отказоустойчивом кластере Server 2012 представлены на рисунке.

|

| Рисунок. Просмотр компонентов кластера |

Для отказоустойчивого кластера Server 2012 необходимо общее хранилище данных типа iSCSI, Serially Attached SCSI или Fibre Channel SAN. В нашем примере используется iSCSI SAN. Следует помнить о следующих особенностях хранилищ этого типа.

- Каждый сервер должен располагать по крайней мере тремя сетевыми адаптерами: одним для подключения хранилища iSCSI, одним для связи с узлом кластера и одним для связи с внешней сетью. Если предполагается задействовать кластер для динамической миграции, то полезно иметь четвертый сетевой адаптер. Однако динамическую миграцию можно выполнить и через внешнее сетевое соединение — она просто будет выполняться медленнее. Если серверы используются для виртуализации на основе Hyper-V и консолидации серверов, то нужны дополнительные сетевые адаптеры для передачи сетевого трафика виртуальных машин.

- В быстрых сетях работать всегда лучше, поэтому быстродействие канала связи iSCSI должно быть не менее 1 ГГц.

- Цель iSCSI должна соответствовать спецификации iSCSI-3, в частности обеспечивать постоянное резервирование. Это обязательное требование динамической миграции. Оборудование почти всех поставщиков систем хранения данных соответствует стандарту iSCSI 3. Если нужно организовать кластер в лабораторной среде с небольшими затратами, обязательно убедитесь, что программное обеспечение цели iSCSI соответствует iSCSI 3 и требованиям постоянного резервирования. Старые версии Openfiler не поддерживают этот стандарт, в отличие от новой версии Openfiler с модулем Advanced iSCSI Target Plugin (http://www.openfiler.com/products/advanced-iscsi-plugin). Кроме того, бесплатная версия StarWind iSCSI SAN Free Edition компании StarWind Software (http://www.starwindsoftware.com/starwind-free) полностью совместима с Hyper-V и динамической миграцией. Некоторые версии Microsoft Windows Server также могут функционировать в качестве цели iSCSI, совместимой со стандартами iSCSI 3. В состав Server 2012 входит цель iSCSI. Windows Storage Server 2008 R2 поддерживает программное обеспечение цели iSCSI. Кроме того, можно загрузить программу Microsoft iSCSI Software Target 3.3 (http://www.microsoft.com/en-us/download/details.aspx?id=19867), которая работает с Windows Server 2008 R2.

Дополнительные сведения о настройке хранилища iSCSI для отказоустойчивого кластера приведены во врезке «Пример настройки хранилища iSCSI». Более подробно о требованиях к отказоустойчивой кластеризации рассказано в статье «Failover Clustering Hardware Requirements and Storage Options» (http://technet.microsoft.com/en-us/library/jj612869.aspx).

Добавление функций отказоустойчивой кластеризации

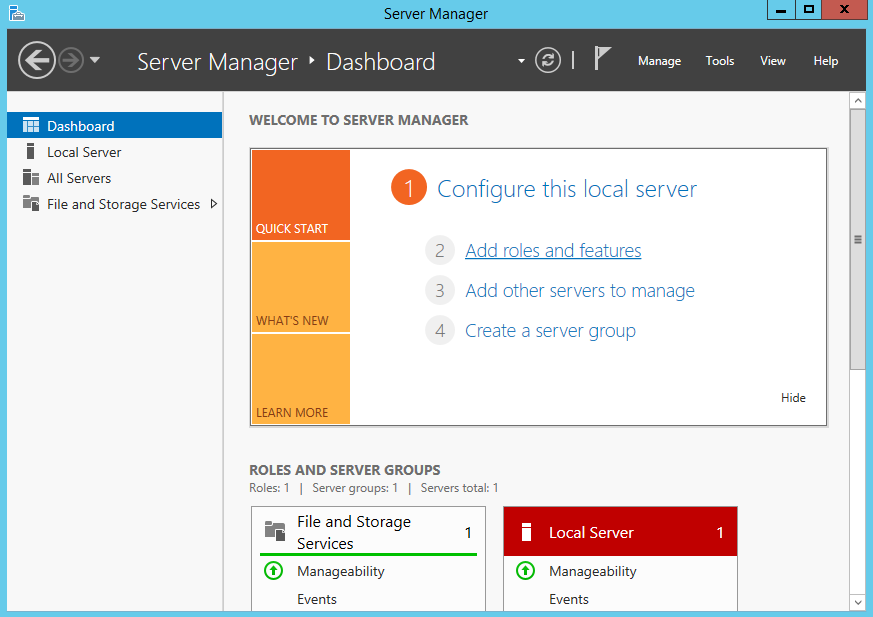

Первый шаг к созданию двухузлового отказоустойчивого кластера Server 2012 — добавление компонента отказоустойчивого кластера с использованием диспетчера сервера. Диспетчер сервера автоматически открывается при регистрации в Server 2012. Чтобы добавить компонент отказоустойчивого кластера, выберите Local Server («Локальный сервер») и прокрутите список вниз до раздела ROLES AND FEATURES. Из раскрывающегося списка TASKS выберите Add Roles and Features, как показано на экране 1. В результате будет запущен мастер добавления ролей и компонентов.

|

| Экран 1. Запуск мастера добавления ролей и компонентов |

Первой после запуска мастера откроется страница приветствия Before you begin. Нажмите кнопку Next для перехода к странице выбора типа установки, на которой задается вопрос, нужно ли установить компонент на локальном компьютере или в службе Remote Desktop. Для данного примера выберите вариант Role-based or feature-based installation и нажмите кнопку Next.

На странице Select destination server выберите сервер, на котором следует установить функции отказоустойчивого кластера. В моем случае это локальный сервер с именем WS2012-N1. Выбрав локальный сервер, нажмите кнопку Next, чтобы перейти к странице Select server roles. В данном примере роль сервера не устанавливается, поэтому нажмите кнопку Next. Или можно щелкнуть ссылку Features в левом меню.

На странице Select features прокрутите список компонентов до пункта Failover Clustering. Щелкните в поле перед Failover Clustering и увидите диалоговое окно со списком различных компонентов, которые будут установлены как части этого компонента. Как показано на экране 2, по умолчанию мастер установит средства управления отказоустойчивыми кластерами и модуль отказоустойчивого кластера для Windows PowerShell. Нажмите кнопку Add Features, чтобы вернуться на страницу выбора компонентов. Щелкните Next.

|

| Экран 2. Добавление средства отказоустойчивого кластера и инструментов |

На странице Confirm installation selections будет показана функция отказоустойчивого кластера наряду с инструментами управления и модулем PowerShell. С этой страницы можно вернуться и внести любые изменения. При нажатии кнопки Install начнется собственно установка компонентов. После завершения установки работа мастера будет завершена и функция отказоустойчивого кластера появится в разделе ROLES AND FEATURES диспетчера сервера. Этот процесс необходимо выполнить на обоих узлах.

Проверка отказоустойчивого кластера

Следующий шаг после добавления функции отказоустойчивого кластера — проверка настроек среды, в которой создан кластер. Здесь можно воспользоваться мастером проверки настроек в диспетчере отказоустойчивого кластера. Этот мастер проверяет параметры аппаратных средств и программного обеспечения всех узлов кластера и сообщает обо всех проблемах, которые могут помешать организации кластера.

Чтобы открыть диспетчер отказоустойчивого кластера, выберите параметр Failover Cluster Manager в меню Tools в диспетчере сервера. В области Management щелкните ссылку Validate Configuration, как показано на экране 3, чтобы запустить мастер проверки настроек.

|

| Экран 3. Запуск мастера проверки конфигурации |

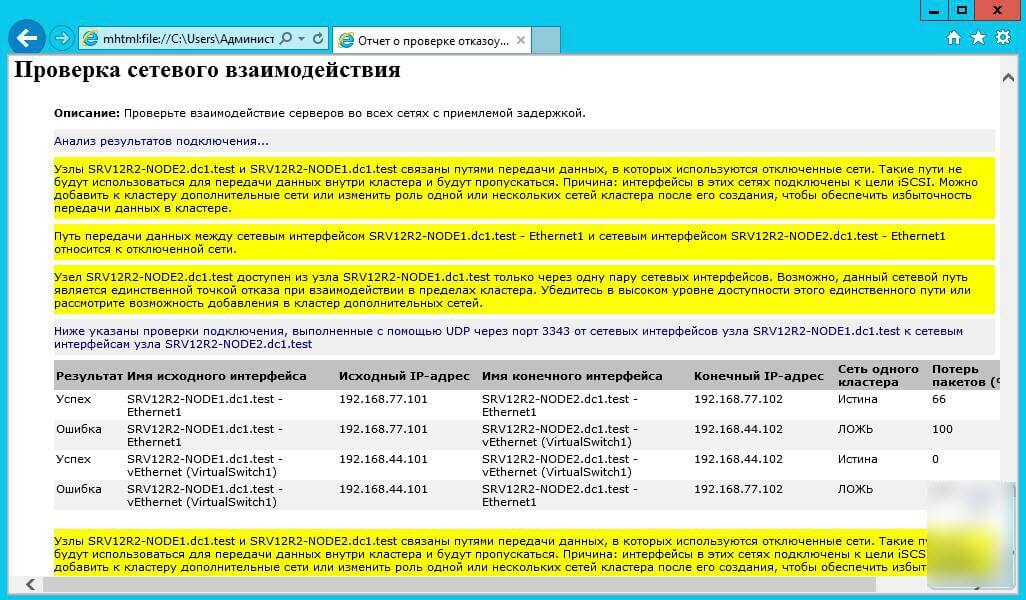

Сначала выводится страница приветствия мастера. Нажмите кнопку Next, чтобы перейти к выбору серверов или странице Cluster. На этой странице введите имена узлов кластера, который необходимо проверить. Я указал WS2012-N1 и WS2012-N2. Нажмите кнопку Next, чтобы показать страницу Testing Options, на которой можно выбрать конкретные наборы тестов или запустить все тесты. По крайней мере в первый раз я рекомендую запустить все тесты. Нажмите кнопку Next, чтобы перейти на страницу подтверждения, на которой показаны выполняемые тесты. Нажмите кнопку Next, чтобы начать процесс тестирования кластера. В ходе тестирования проверяется версия операционной системы, настройки сети и хранилища всех узлов кластера. Сводка результатов отображается после завершения теста.

Если тесты проверки выполнены успешно, можно создать кластер. На экране 4 показан экран сводки для успешно проверенного кластера. Если при проверке обнаружены ошибки, то отчет будет отмечен желтым треугольником (предупреждения) или красным значком «X» в случае серьезных ошибок. С предупреждениями следует ознакомиться, но их можно игнорировать. Серьезные ошибки необходимо исправить перед созданием кластера.

|

| Экран 4. Просмотр отчета о проверке |

Создание отказоустойчивого кластера

На данном этапе можно создать кластер, начиная с любого узла кластера. Я организовал кластер, начав на первом узле (WS2012-N1).

Чтобы создать новый кластер, выберите ссылку Create Cluster на панели Management или панели Actions, как показано на экране 5.

|

| Экран 5. Запуск мастера создания кластера |

В результате будет запущен мастер создания кластера, работа которого начинается со страницы приветствия. Нажмите кнопку Next, чтобы перейти на страницу выбора серверов, показанную на экране 6. На этой странице введите имена всех узлов кластера, затем нажмите кнопку Next.

|

| Экран 6. Выбор серверов для кластера |

На странице Access Point for Administering the Cluster следует указать имя и IP-адрес кластера, которые должны быть уникальными в сети. На экране 7 видно, что имя моего кластера WS2012-CL01, а IP-адрес — 192.168.100.200. При использовании Server 2012 IP-адрес кластера может быть назначен через DHCP, но я предпочитаю для своих серверов статически назначаемый IP-адрес.

|

| Экран 7. Настройка точки доступа кластера |

После ввода имени и IP-адреса нажмите кнопку Next, чтобы увидеть страницу подтверждения (экран 8). На этой странице можно проверить настройки, сделанные при создании кластера. При необходимости можно вернуться и внести изменения.

|

| Экран 8. Подтверждение параметров, выбранных при создании кластера |

После нажатия кнопки Next на странице подтверждения формируется кластер на всех выбранных узлах. На странице хода выполнения показаны шаги мастера в процессе создания нового кластера. По завершении мастер покажет страницу сводки с настройками нового кластера.

Мастер создания кластера автоматически выбирает хранилище для кворума, но часто он выбирает не тот диск кворума, который хотелось бы администратору. Чтобы проверить, какой диск используется для кворума, откройте диспетчер отказоустойчивого кластера и разверните кластер. Затем откройте узел Storage и щелкните узел Disks. Диски, доступные в кластере, будут показаны на панели Disks. Диск, выбранный мастером для кворума кластера, будет указан в разделе Disk Witness in Quorum.

В данном примере для кворума был использован Cluster Disk 4. Его размер 520 Мбайт, чуть больше минимального значения для кворума 512 Мбайт. Если нужно использовать другой диск для кворума кластера, можно изменить настройки кластера, щелкнув правой кнопкой мыши имя кластера в диспетчере отказоустойчивого кластера, выбрав пункт More Actions и Configure Cluster Quorum Settings. В результате появится мастер выбора конфигурации кворума, с помощью которого можно изменить параметры кворума кластера.

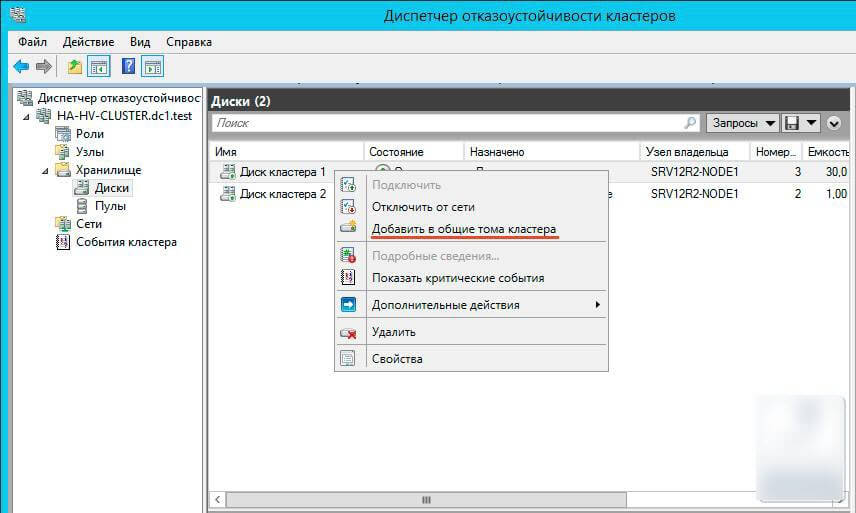

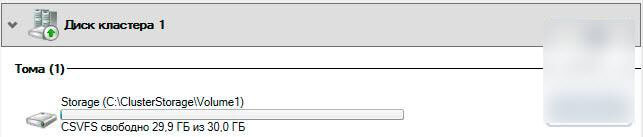

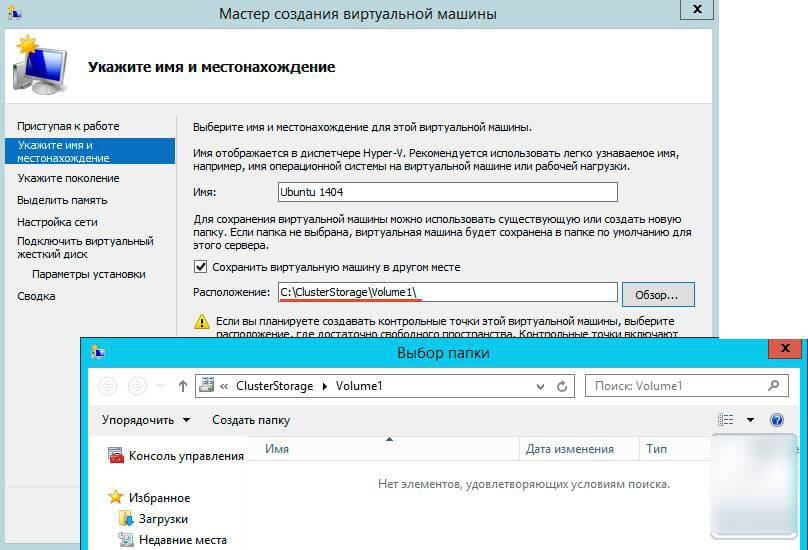

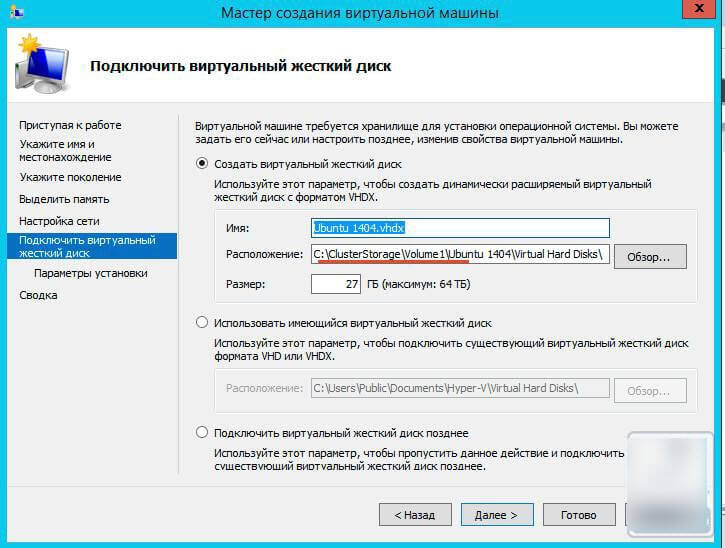

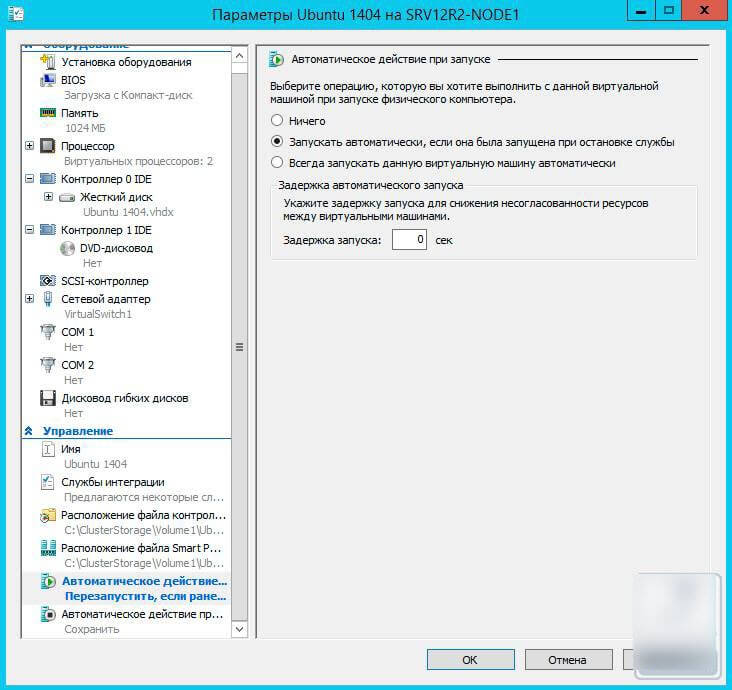

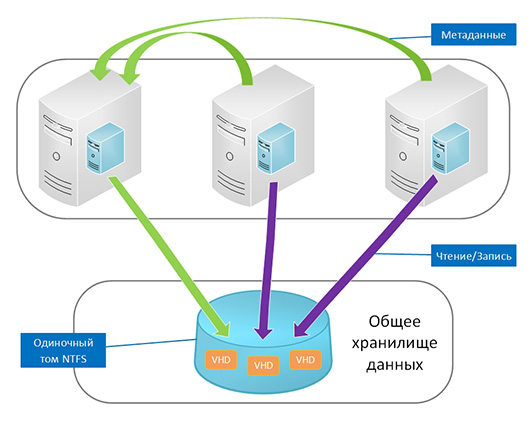

Настройка общих томов кластера и роли виртуальных машин

Оба узла в моем кластере имеют роль Hyper-V, так как кластер предназначен для виртуальных машин с высокой доступностью, обеспечивающих динамическую миграцию. Чтобы упростить динамическую миграцию, далее требуется настроить общие тома кластера Cluster Shared Volumes (CSV). В отличие от Server 2008 R2, в Server 2012 общие тома кластера включены по умолчанию. Однако все же требуется указать, какое хранилище следует использовать для общих томов кластера. Чтобы включить CSV на доступном диске, разверните узел Storage и выберите узел Disks. Затем выберите диск кластера, который нужно использовать как CSV, и щелкните ссылку Add to Cluster Shared Volumes на панели Actions диспетчера отказоустойчивого кластера (экран 9). Поле Assigned To этого диска кластера изменится с Available Storage на Cluster Shared Volume (общий том кластера), как показано на экране 9.

|

| Экран 9. Добавление CSV |

В это время диспетчер отказоустойчивого кластера настраивает хранилище диска кластера для CSV, в частности добавляет точку подключения в системном диске. В данном примере общие тома кластера включаются как на Cluster Disk 1, так и на Cluster Disk 3 с добавлением следующих точек подключения:

* C:ClusterStorageVolume1 * C:ClusterStorageVolume2

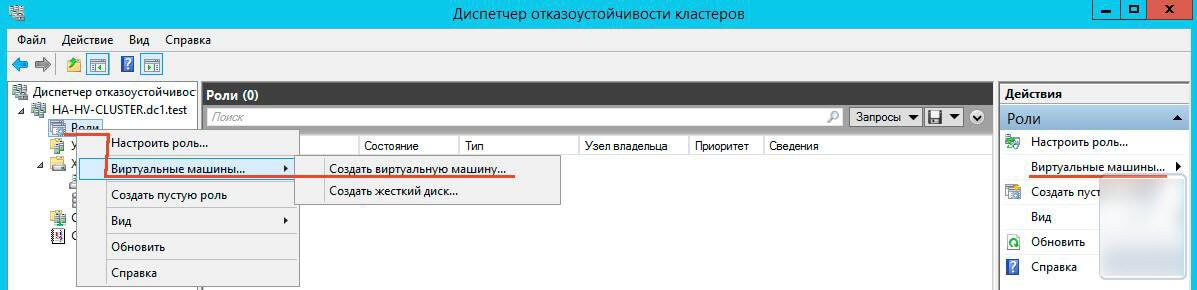

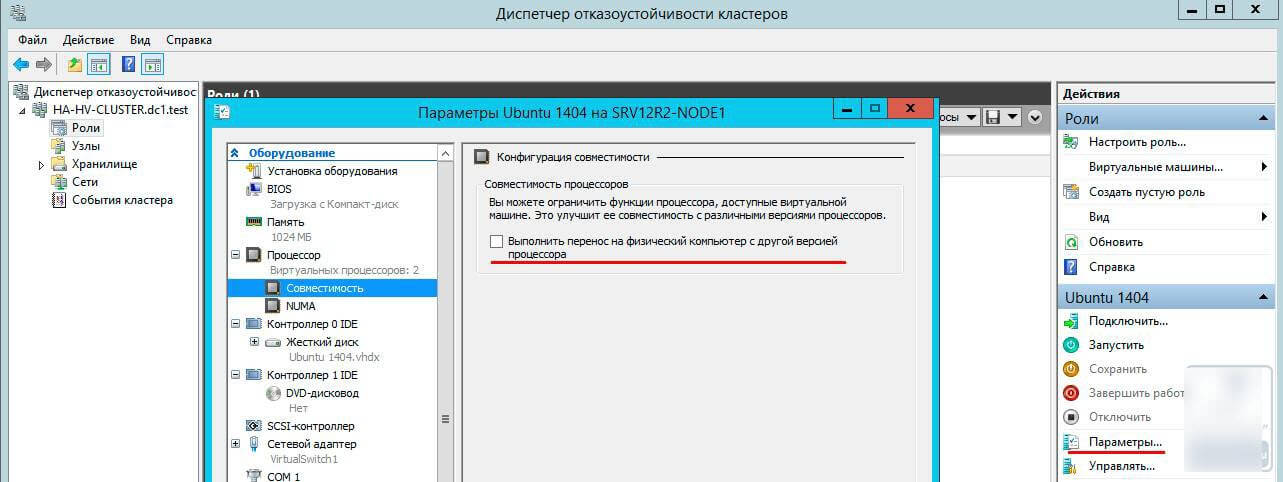

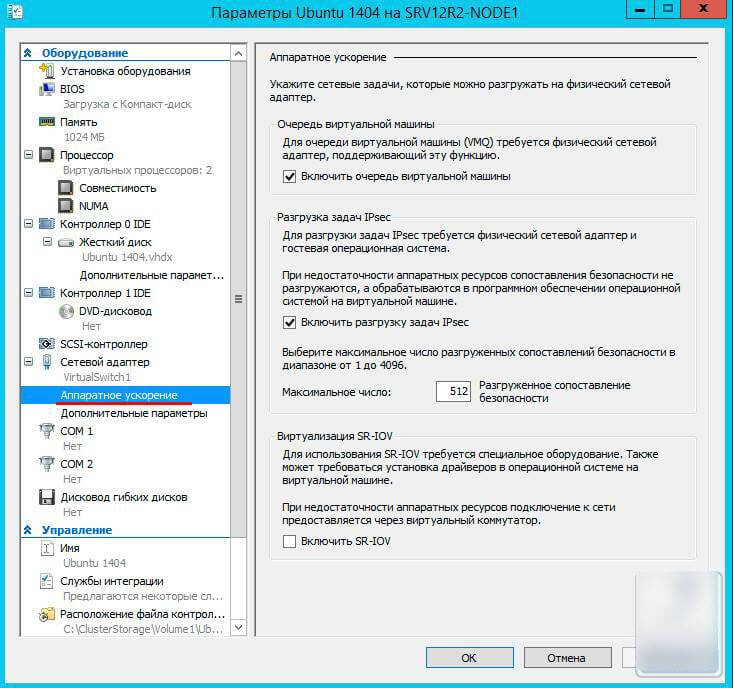

На данном этапе построен двухузловой кластер Server 2012 и включены общие тома кластера. Затем можно установить кластеризованные приложения или добавить в кластер роли. В данном случае кластер создан для виртуализации, поэтому добавляем роль виртуальной машины в кластер.

Чтобы добавить новую роль, выберите имя кластера на панели навигации диспетчера отказоустойчивого кластера и щелкните ссылку Configure Roles на панели Actions, чтобы запустить мастер высокой готовности. Нажмите кнопку Next на странице приветствия, чтобы перейти на страницу выбора роли. Прокрутите список ролей, пока не увидите роль виртуальной машины, как показано на экране 10. Выберите роль и нажмите кнопку Next.

|

| Экран 10. Добавление роли виртуальной машины |

На странице выбора виртуальной машины будут перечислены все VM на всех узлах кластера, как показано на экране 11. Прокрутите список и выберите виртуальные машины, которым необходимо обеспечить высокую готовность. Нажмите кнопку Next. Подтвердив свой выбор, нажмите Next, чтобы добавить роли виртуальной машины в диспетчер отказоустойчивого кластера.

|

| Экран 11. Выбор виртуальных машин, которым необходимо обеспечить высокую надежность |

Пример настройки хранилища iSCSI

Для отказоустойчивого кластера Windows Server 2012 требуется общее хранилище, которое может быть типа iSCSI, Serially Attached SCSI или Fibre Channel SAN. В данном отказоустойчивом кластере используется Channel SAN.

Сначала в сети iSCSI SAN были созданы три логических устройства LUN. Один LUN был создан для диска кворума кластера (520 Мбайт). Другой LUN предназначен для 10 виртуальных машин и имеет размер 375 Гбайт. Третий LUN выделен для небольшой тестовой виртуальной машины. Все три LUN представлены в формате NTFS.

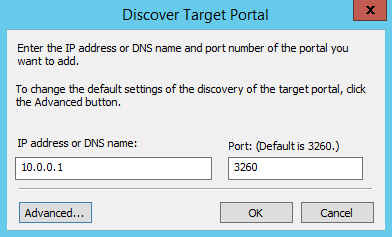

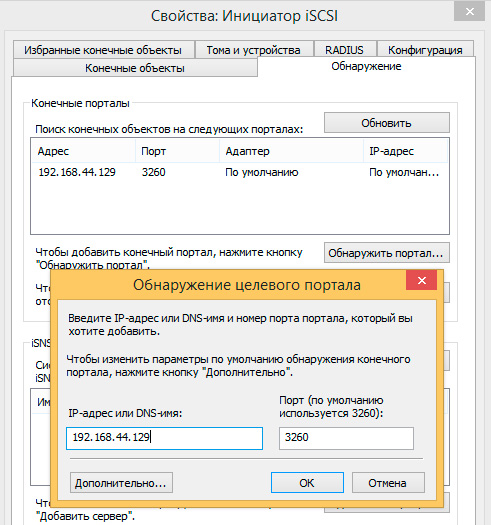

После того, как были созданы LUN, была выполнена настройка iSCSI Initiator на обоих узлах Server 2012. Чтобы добавить цели iSCSI, был выбран iSCSI Initiator в меню Tools в диспетчере сервера. На вкладке Discovery я нажал кнопку Discover Portal. В результате появилось диалоговое окно Discover Portal, куда были введены IP-адрес (192.168.0.1) и порт iSCSI (3260) сети SAN.

Затем я перешел на вкладку Targets и нажал кнопку Connect. В диалоговом окне Connect To Target («Подключение к целевому серверу») я ввел целевое имя iSCSI SAN. Оно было получено из свойств SAN. Имя зависит от поставщика SAN, имени домена и имен созданных LUN. Помимо целевого имени я установил режим Add this connection to the list of Favorite Targets.

По завершении настройки iSCSI эти LUN появились на вкладке Targets iSCSI Initiator. Чтобы автоматически подключать LUN при запуске Server 2012, я убедился, что они перечислены на вкладке Favorite Targets, как показано на экране A.

|

| Экран A. Настройка iSCSI Initiator |

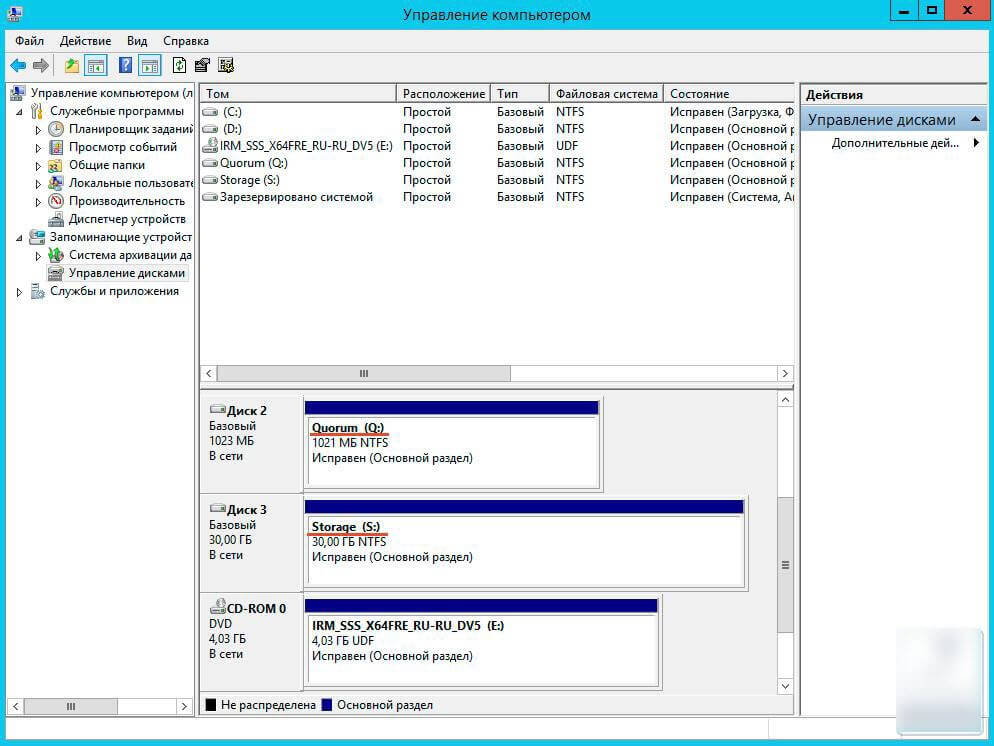

Наконец, были назначены буквенные обозначения устройствам LUN с помощью оснастки Disk Management консоли управления Microsoft (MMC). Я выбрал Q для диска кворума и W для диска, используемого для виртуальных машин и общих томов кластера (CSV). При назначении буквенных обозначений необходимо сначала назначить их на одном узле. Затем нужно перевести диски в автономный режим и сделать аналогичные назначения на втором узле. Результаты назначения букв дискам для одного узла приведены на экране B. При создании кластера диски будут показаны как доступное хранилище.

|

| Экран B. Буквенные обозначения, назначенные дискам iSCSI узла |

Internet Small Computer System Interface (iSCSI) — это протокол передачи данных, предназначенный для обмена данными между серверами и системами хранения данных (Storage Area Network, SAN). iSCSI представляет из себя комбинацию протокола SCSI и стека протоколов TCP/IP и предназначен для передачи блоков данных через сети Ethernet. Управляющие команды SCSI передаются внутри IP-пакетов, а протокол TCP обеспечивает управление потоком и надежность передачи данных.

При использовании iSCSI данные между сервером и системой хранения передаются блоками, в необработанном виде. Это позволяет использовать SAN практически так же, как если бы они были подключены к серверу напрямую, а не по сети. Хост-система может создавать на SAN логические разделы, форматировать их и использовать как обычные локальные жесткие диски. В этом заключается основное отличие SAN от сетевых хранилищ (Network Area Storage, NAS), которые работают на уровне файловой системы и используют протоколы передачи файлов, такие как SMB или CIFS.

Технология iSCSI была разработана как более дешевая альтернатива Fibre Channel (FC). Системы на базе iSCSI поддерживают стандартные протоколы и могут быть построены на базе любой существующей сетевой инфраструктуры, поддерживающей протокол IP. Для работы iSCSI может использовать самые обычные сетевые устройства (коммутаторы, маршрутизаторы, сетевые адаптеры и т.п), тогда как для FC требуются специальные HBA-адаптеры, оптические кабеля и прочее дорогостоящее оборудование.

Архитектура iSCSI является клиент-серверной и включает в себя следующие компоненты:

iSCSI Initiator — клиентский компонент, который отправляет запросы на подключение компоненту iSCSI Target, находящемуся на стороне сервера. Инициатор может быть реализован программно, в виде драйвера, либо аппаратно, в виде специального iSCSI адаптера.

iSCSI Target — серверный компонент, слушающий клиентские запросы и обеспечивающий установку соединения между клиентом и сервером iSCSI. Кроме того, таргет связан с виртуальными дисками iSCSI, и после установки соединения все виртуальные диски, связанные с этим таргетом, становятся доступны через инициатор. В качестве iSCSI Target может выступать как специализированная СХД, так и обычный Windows сервер с установленной ролью iSCSI Target.

Виртуальные диски iSCSI — используются для разбиения дискового пространства на логические разделы (Logical Unit Number, LUN). В Windows Server 2012 iSCSI LUN представляют из себя обычные виртуальные диски формата VHDVHDX. Кстати, в Windows Server 2012 для iSCSI поддерживался только формат VHD, что ставило ограничение в 2ТБ на максимальный размер LUN. В Windows Server 2012 R2 используется формат VHDX, что позволяет создавать LUN-ы размером до 64ТБ.

А теперь остановимся и уточним некоторые моменты:

• На каждом iSCSI сервере может быть один или несколько iSCSI Target;

• Каждый iSCSI Target может быть подключен к одному или нескольким виртуальным дискам;

• Каждый iSCSI Target может обслуживать одно или несколько подключений от iSCSI Initiator;

• В свою очередь, каждый iSCSI Initiator может подключаться к одному или нескольким iSCSI Target и, следовательно, к одному или нескольким виртуальным дискам.

Кроме того, в Windows Server 2012 поддерживается loopback-конфигурация, в которой и Target и Initiator могут находиться на одном и том же сервере.

В операционных системах Microsoft поддержка iSCSI появилась довольно давно. Первая версия Microsoft iSCSI Initiator устанавливалась в качестве отдельного компонента в Windows 2000, Windows XP SP2 и Windows Server 2003 SP1, а начиная с Windows Server 2008 и Vista iSCSI Initiator был встроен в операционную систему.

Что касается iSCSI Target, то изначально он входил в специальную версию серверной ОС Windows Data Storage Server 2003, которая была предназначена для построения систем хранения и поставлялась только в предустановленом виде. Однако с 2011 года компонент Microsoft iSCSI Software Target 3.3 стал доступен для загрузки и установки на Windows Server 2008R2, а в Windows Server 2012 он полностью интегрирован в систему и устанавливается в качестве роли сервера.

На этом закончим теоретическую часть и приступим к практике. Для настройки возьмем самый простой вариант, в качестве подопытных используем два сервера с установленной Windows Server 2012 R2: SRV2 для роли iSCSI Target и SRV3 для iSCSI Initiator.

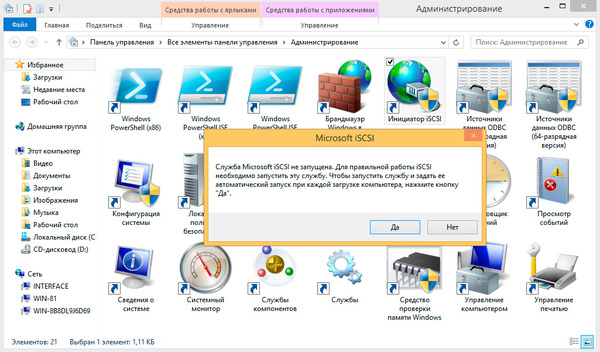

Запуск службы iSCSI Initiator

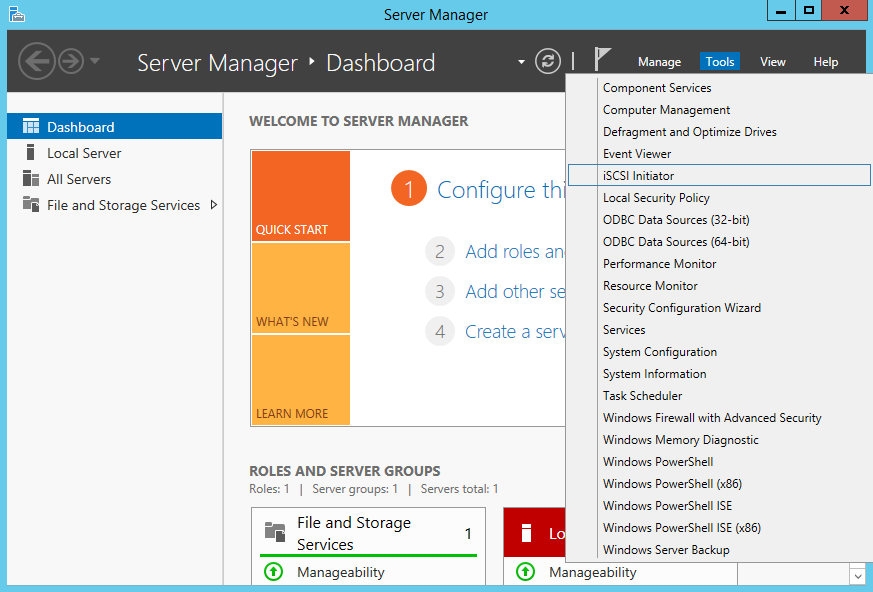

Для начала проверим состояние службы инициатора на SRV3. Для этого открываем Server Manager и в меню «Tools» выбираем пункт «iSCSI Initiator».

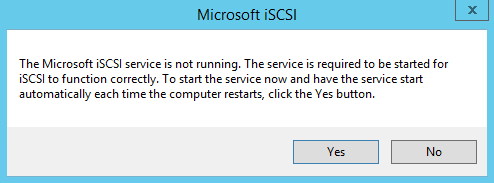

Как видите, по умолчанию служба не запущена. Нажав на «Yes» в диалоговом окне, мы стартуем службу iSCSI Initiator и поставим ее в режим автоматического запуска.

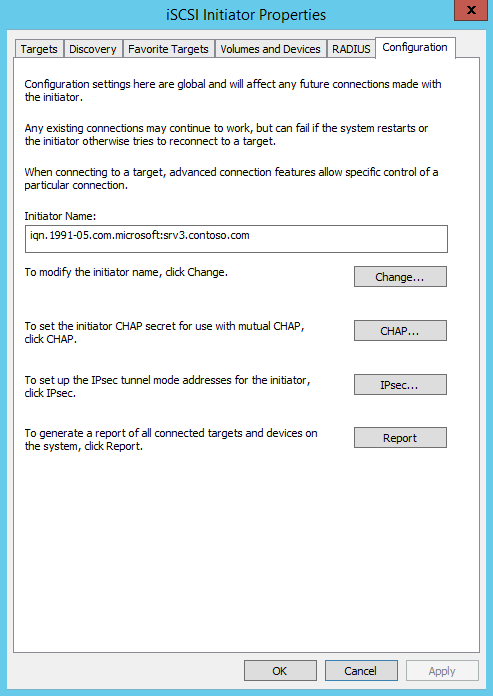

Затем в окне свойств переходим на вкладку «Configuration» и запоминаем значение IQN, оно пригодится нам при настройке сервера.

IQN (iSCSI qualified name) — это уникальный идентификатор, назначаемый для каждого iSCSI Target и Initiator. IQN формируется из даты (месяц и год) регистрации домена, официального имени домена, написанного в обратном порядке и любого произвольного имени, например имени сервера. Получается примерно так: iqn:1991-05.com.microsoft:srv3.contoso.com

Стартовать сервис iSCSI Initiator и установить режим его запуска можно и из консоли PowerShell, следующими командами:

Start-Service msiscsi

Set-Service msiscsi -StartupType automatic

Установка роли iSCSI Target Server

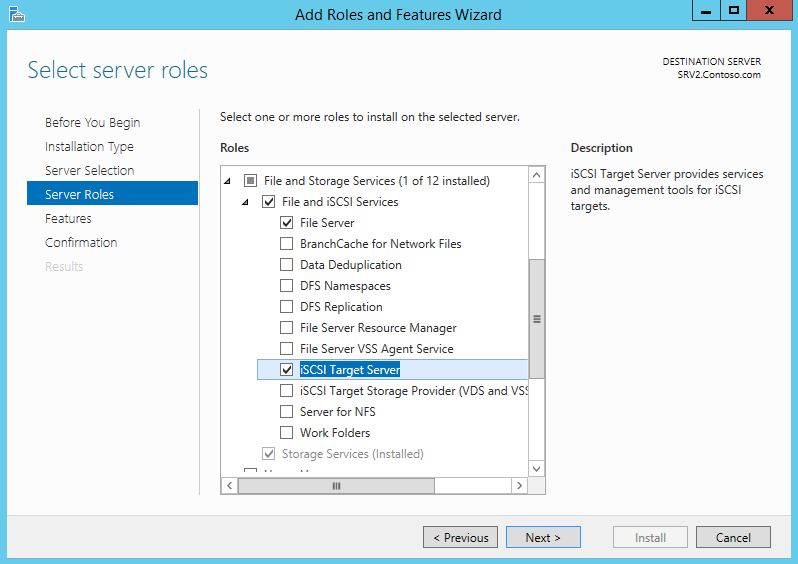

Теперь перейдем на SRV2 и приступим к настройке серверной части. Первое, что нам надо сделать — это установить на сервер роль iSCSI Target. Открываем Server Manager, переходим по ссылке «Add roles and features»

И выбираем роль «iSCSI Target Server», которая находится в разделе File and Storage ServicesFile and iSCSI Services.

Либо воспользуемся командой PowerShell:

Install-WindowsFeature -Name FS-iSCSITarget-Server

Подготовка диска

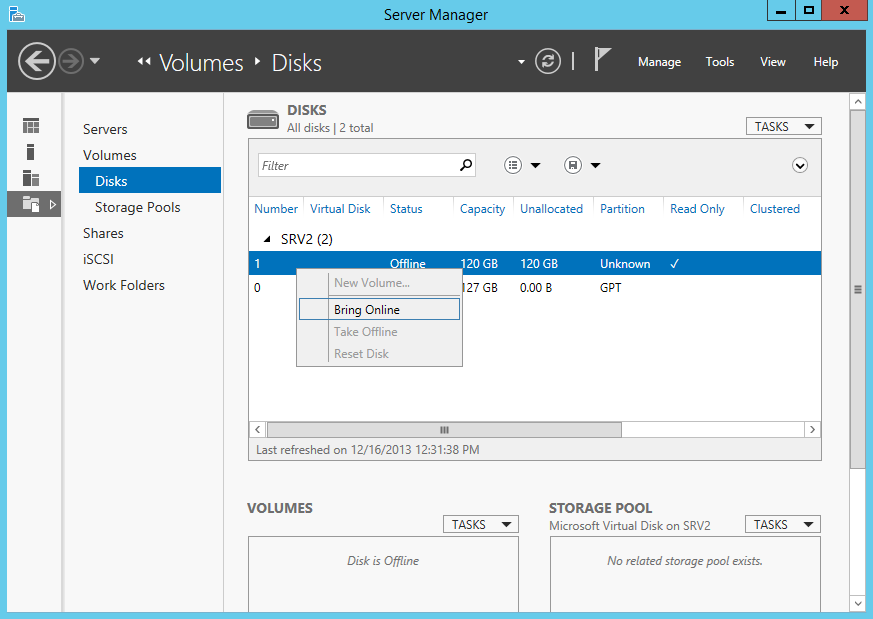

Теперь подготовим физический диск, который будет использоваться для хранения виртуальных iSCSI дисков. Специально для этой цели к серверу подключен новый жесткий диск размером 120Гб. На данный момент диск неактивен (Offline). Для его активации в Server Manager переходим в раздел File and Storage Services -> Disks, кликаем на диске и переводим его в Online.

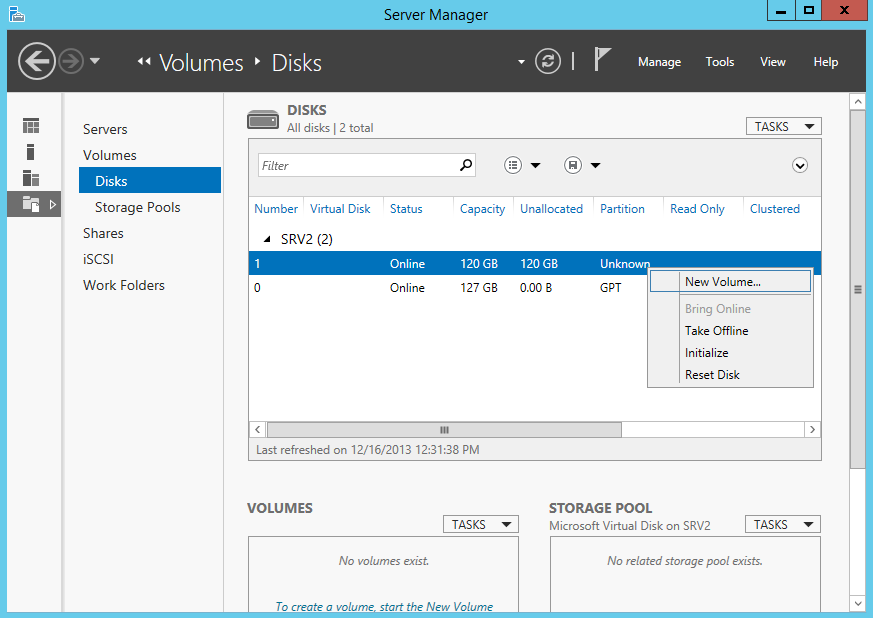

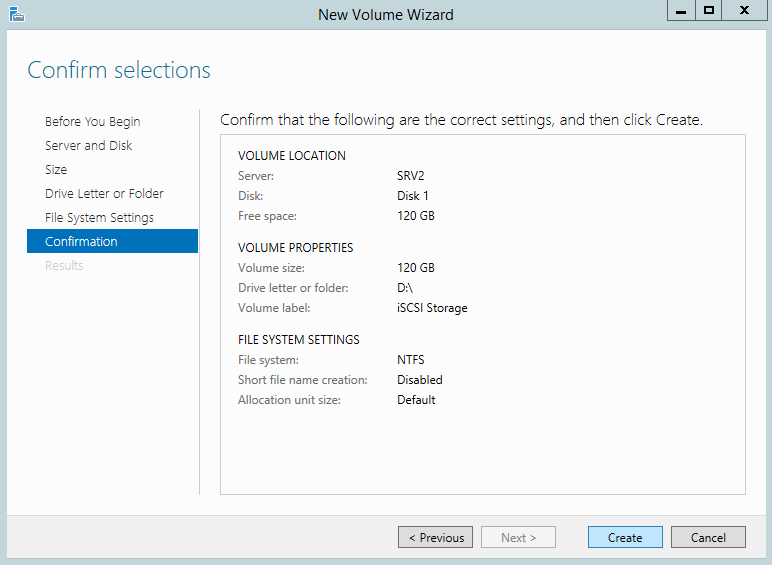

Теперь на этом диске надо создать новый раздел (или том), для чего в контекстном меню выбираем пункт New Volume.

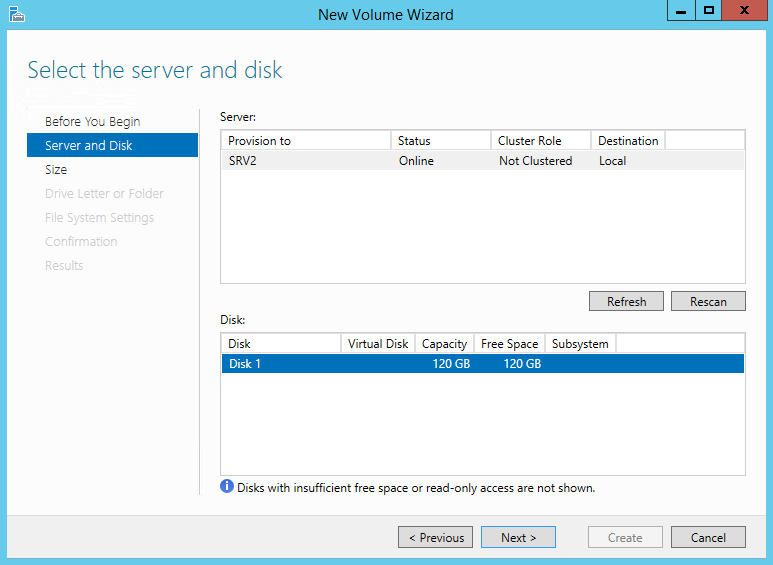

Выбираем физический диск, на котором будет создаваться том

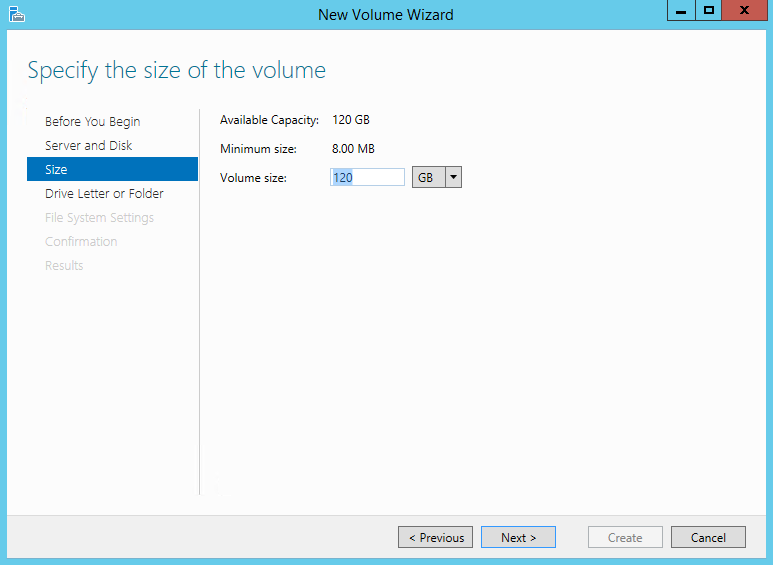

указываем размер тома

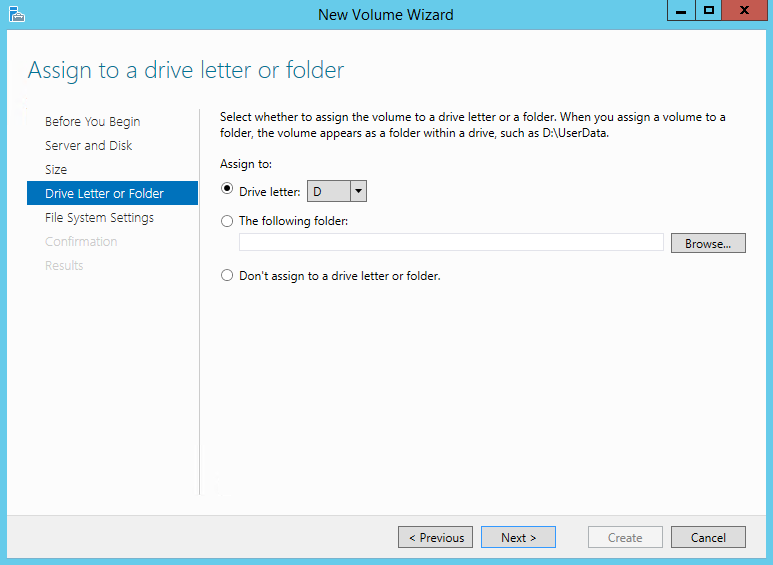

и выбираем букву диска.

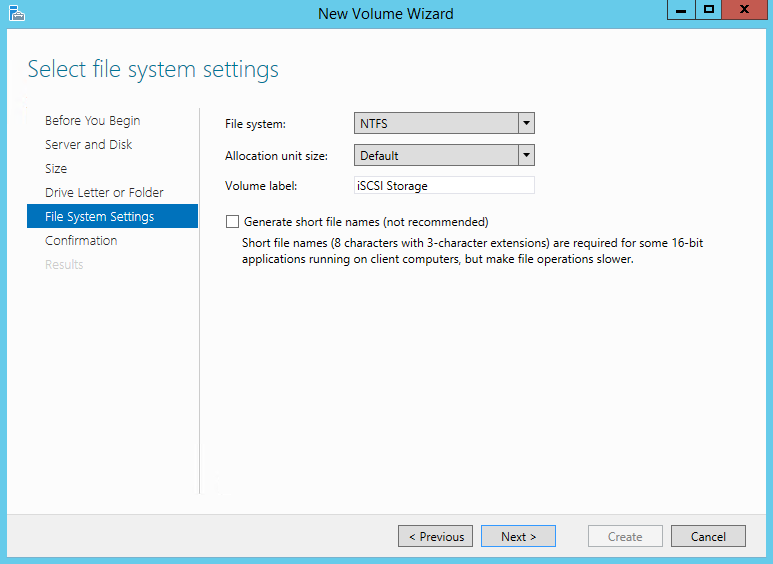

Затем выбираем для диска файловую систему, размер сектора и указываем метку тома. Здесь напомню, что виртуальные диски iSCSI можно создавать только на томах NTFS, новая файловая система ReFS (Resilient File System) не поддерживается.

Смотрим суммарную информацию, и если все правильно, то жмем «Create», запуская создание тома.

Те же действия можно проделать с помощью PowerShell. Находим нужный диск:

Get-Disk | where {$_.OperationalStatus -eq ″Offline″}

Переводим его в online:

Set-Disk -Number 1 -IsOffline $false

Инициализируем:

Initialize-Disk -Number 1

Создаем раздел:

New-Partition -DiskNumber 1 -UseMaximumSize -DriveLetter D

И форматируем его в NTFS:

Format-Volume -DriveLetter D -FileSystem NTFS -NewFileSystemLabel ″iSCSI Storage″

Создание виртуальных дисков iSCSI

Следующим пунктом нашей программы идет создание виртуальных iSCSI дисков. Для этого переходим в раздел iSCSI и кликаем по ссылке, запуская очередной мастер.

Выбираем том, на котором будет храниться виртуальный диск.

Даем диску имя и описание.

Указываем размер виртуального диска и его тип. Выбирать можно из трех вариантов:

• Fixed size (фиксированного размера) — создаваемый диск сразу занимает весь выделенный объем. Это наиболее производительный, но наименее экономичный вариант;

• Dynamically expanding (динамически расширяемый) — изначально создается диск минимального размера, который затем динамически изменяется в зависимости от количества записанных на него данных. Наилучший вариант в плане использования дискового пространства;

• Differencing (разностный) — в этом варианте нужно указать расположение родительского диска, с которым будет связан создаваемый диск. Разностный диск может быть как фиксированным, так и динамическим, в зависимости от типа родителя. У этого типа дисков есть свои преимущества, но использовать их для iSCSI лично я особого смысла не вижу.

Теперь нужно указать iSCSI Target, к которому будет подключен данный диск. Поскольку на сервере не создано ни одного таргета, выбираем «New iSCSI target».

Даем таргету имя и описание.

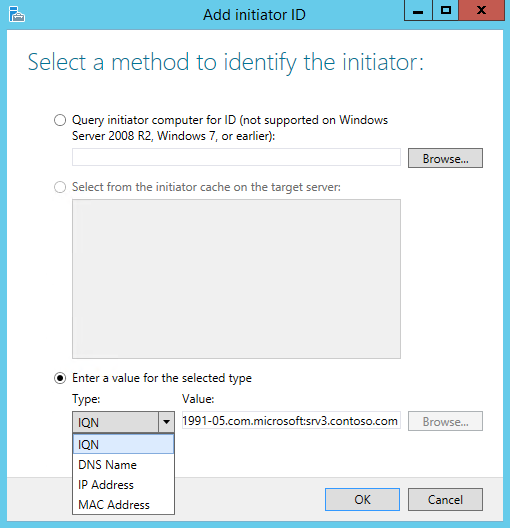

И указываем сервера, которые могут получить к нему доступ.

При выборе серверов можно воспользоваться двумя способами. Если инициатор находится на Windows Server 2012 или Windows 8, то можно просто нажать «Browse» и выбрать нужный сервер из списка. Для более старых систем надо вручную ввести идентификатор сервера. В качестве идентификатора можно указать IQN инициатора, DNS имя или IP-адрес сервера, либо MAC-адрес сетевого адаптера.

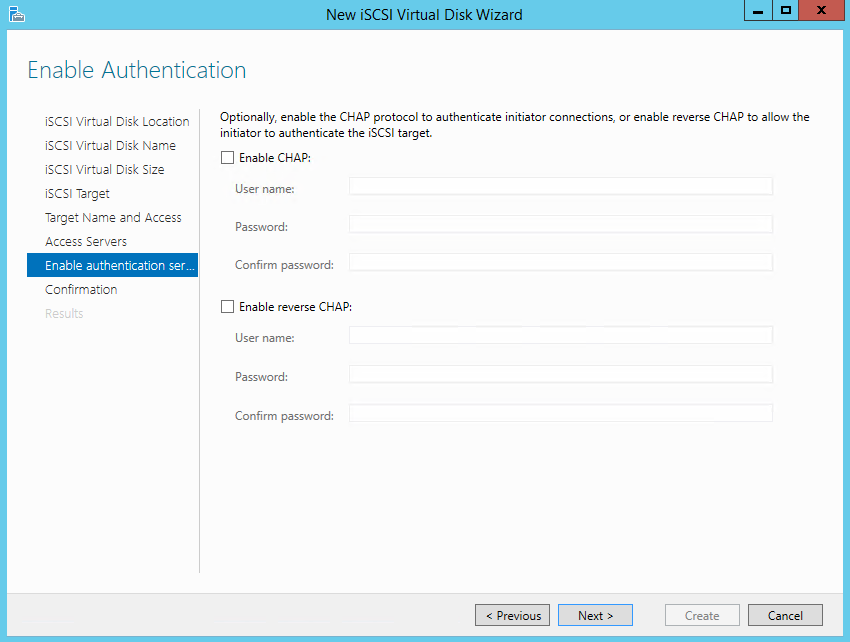

Идем дальше. На следующей странице можно настроить аутентификацию по протоколу CHAP между серверами. CHAP (Challenge Handshake Authentication Protocol) — это протокол для проверки подлинности партнера по подключению, основанный на использовании общего пароля или секрета. Для iSCSI можно задействовать как одностороннюю, так и двухстороннюю (reverse) проверку подлинности CHAP.

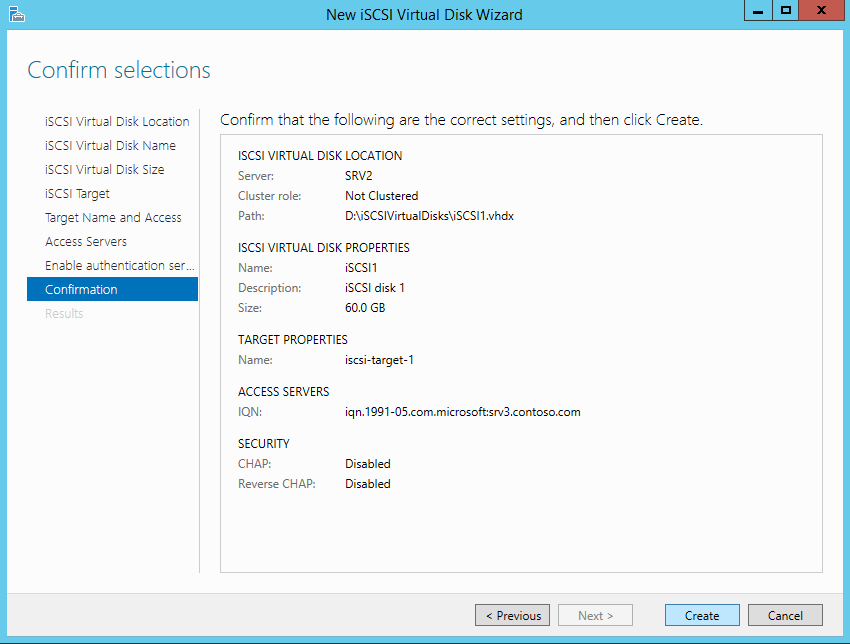

Проверяем правильность настроек и запускаем создание диска.

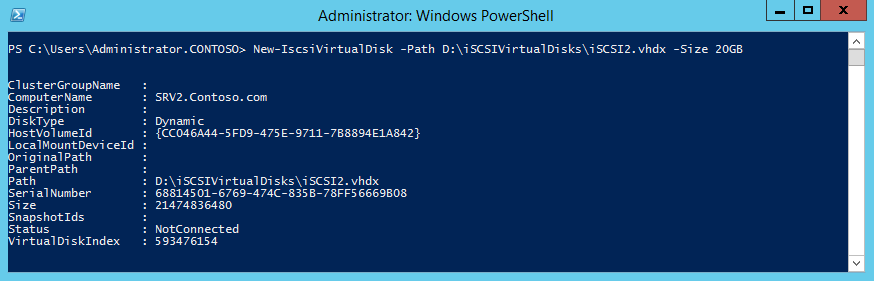

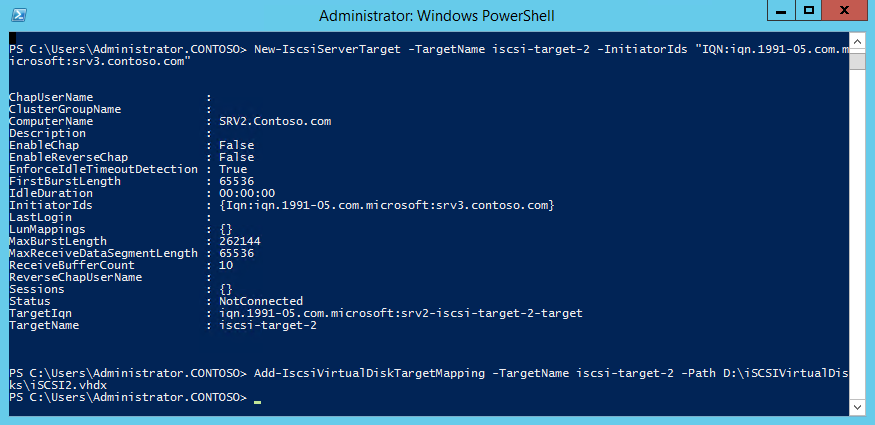

Попробуем сделать все то же с помощью PowerShell. Создадим еще один виртуальный iSCSI диск на 20ГБ командой:

New-IscsiVirtualDisk -Path D:iSCSIVirtualDisksiSCSI2.vhdx

Обратите внимание, что по умолчанию создается динамический диск, для создания VHD фиксированного размера надо воспользоваться ключом -UseFixed.

Теперь создаем второй iSCSI Target c именем iscsi-target-2 и в качестве сервера доступа укажем IQN SRV3:

New-IscsiServerTarget -TargetName iscsi-target-2 -InitiatorIds ″IQN:iqn.1991-05.com.microsoft:srv3.contoso.com″

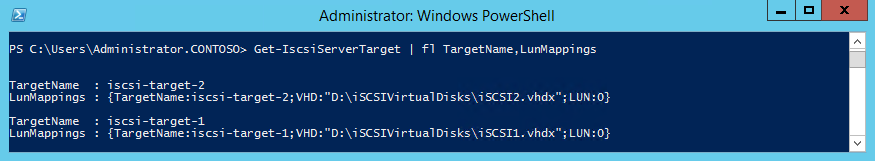

И проверим результат командой:

Get-IscsiServerTarget | fl TargetName, LunMappings

Подключение

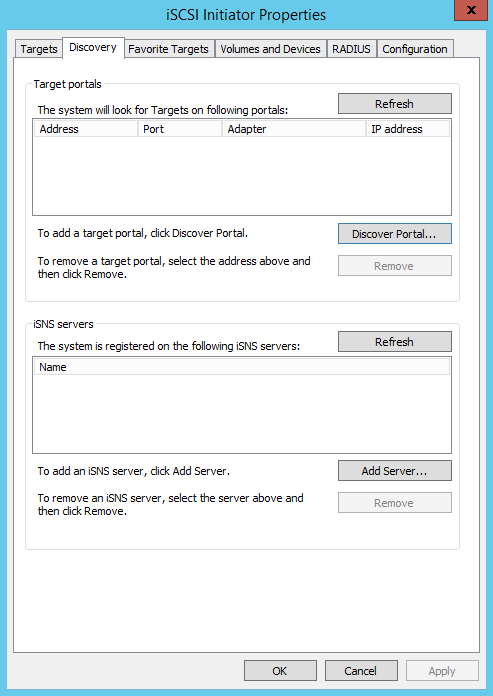

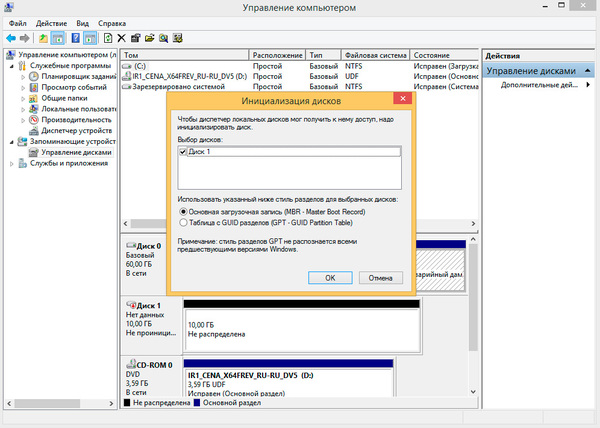

Возвращаемся на SRV3, открываем окно свойств инициатора, переходим на вкладку Discovery и жмем кнопку Discover Portal.

Вводим имя или IP-адрес портала и жмем ОК.

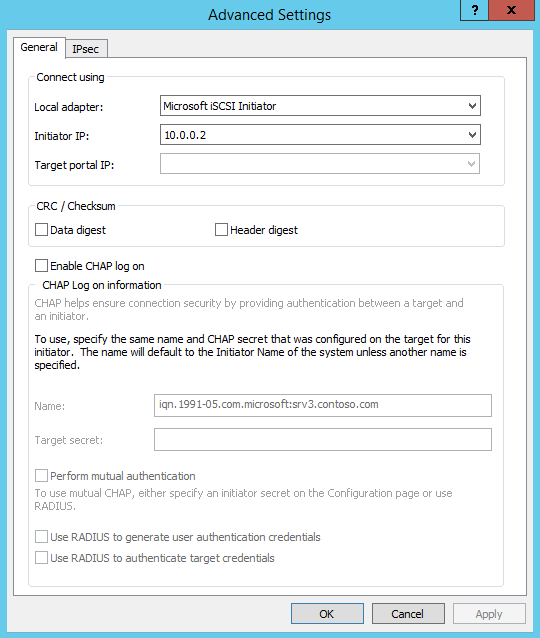

По умолчанию iSCSI использует все доступные IP-адреса, и если вы хотите, чтобы трафик iSCSI шел только через определенный сетевой интерфейс, то надо перейти в расширенные настройки и в поле «Connect using» указать нужный IP.

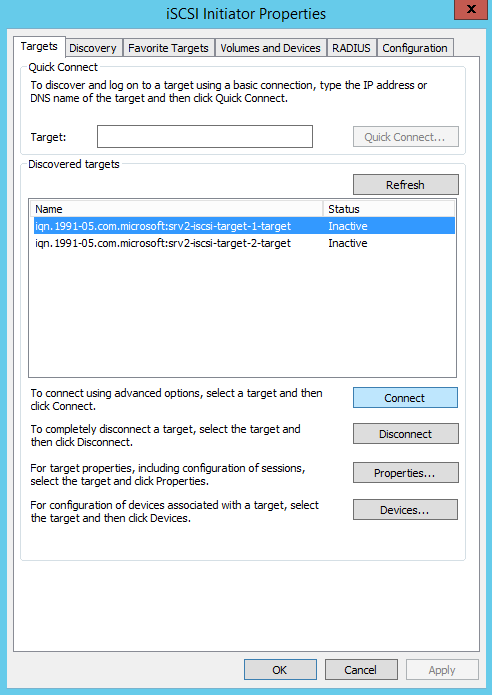

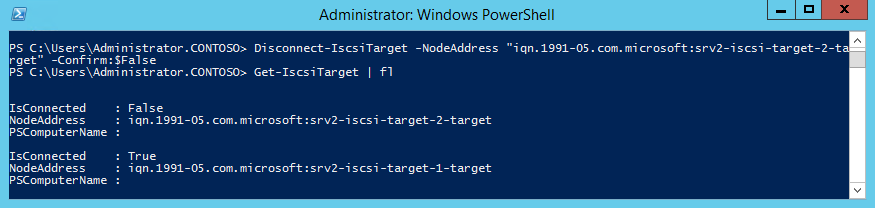

Теперь переходим на вкладку Targets, где должны отобразиться все доступные для подключения iSCSI Target. Выбираем нужный таргет и жмем «Connect».

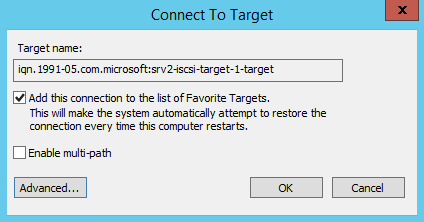

Не забудьте отметить чекбокс «Add this connection to the list of Favorite Targets», который обеспечивает автоматическое подключение к таргету при выключении или перезагрузке машины.

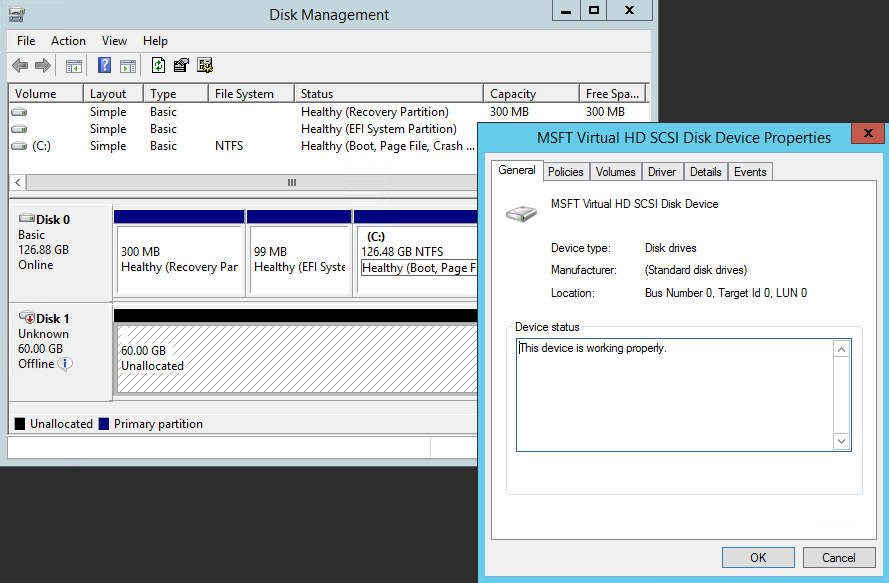

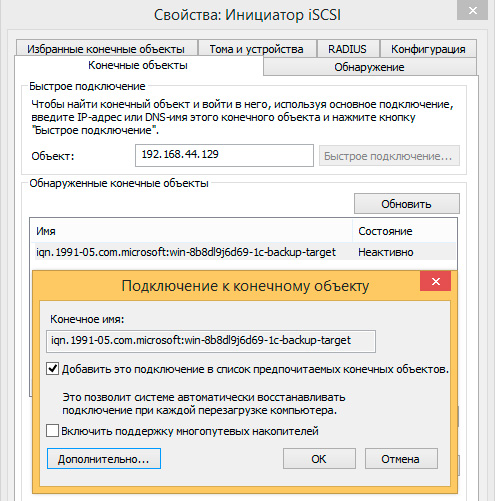

Подключение состоялось, и если открыть оснастку управления дисками, то там появится новый диск. Дальше с этим диском поступаем так же, как с обычным жестким диском, подключенным локально — переводим в Online, инициализируем, создаем на нем разделы и форматируем.

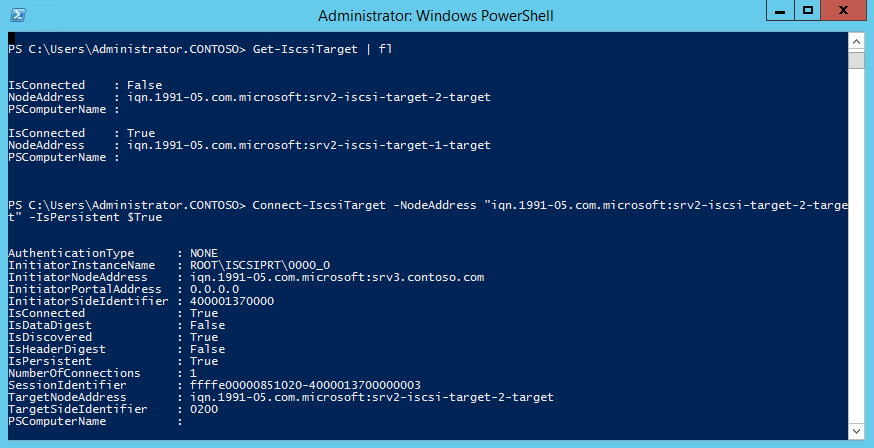

То же самое можно выполнить с помощью PowerShell. Выводим список доступных таргетов:

Get-IscsiTarget | fl

И подключаемся к нужному:

Connect-IscsiTarget -NodeAddress ″iqn.1995-05.com.microsoft:srv2-iscsi-target-2-target″ -IsPersistent $true

Ключ -IsPersistent $true обеспечивает автоматическое подключение при выключении или перезагрузке.

Ну и для отключения можно воспользоваться командой Disconnect-IscsiTarge, вот так:

Disconnect-IscsiTarget -NodeAddress ″iqn.1995-05.com.microsoft:srv2-iscsi-target-2-target″ -Confirm:$false

Заключение

На этом настройка завершена. Как я говорил, это самый простой, базовый вариант настройки хранилища. В iSCSI имеется еще много интересных возможностей. Например, можно использовать службу имен iSCSI (iSNS) для простоты управления, многопутевой ввод-вывод (MPIO) для обеспечения отказоустойчивости, а для безопасности настроить аутентификацию по протоколу CHAP и шифрование трафика с помощью IPSec. О некоторых из этих фич я планирую написать в следующих статьях.

И в заключение важные моменты, которые надо учесть при организации системы хранения iSCSI:

• Развертывать iSCSI желательно в быстрой сети, не ниже Gigabit Ethernet;

• Сетевой трафик iSCSI рекомендуется отделить от остального трафика и вынести в отдельную сеть, например с помощью VLAN или физического разделения на подсети;

• Для обеспечения высокой доступности на сетевом уровне необходимо использовать технологию MPIO, либо сеансы с несколькими подключениями (MCS). Объединение сетевых адаптеров (NIC Teaming) для подключения к устройствам хранения iSCSI не поддерживается;

• При использовании технологии Storage Spaces можно хранить виртуальные диски iSCSI на Storage Spaces, но нельзя использовать LUN-ы iSCSI для создания Storage Spaces;

• Для хранения виртуальных дисков iSCSI нельзя использовать общие кластерные тома CSV (Cluster Shared Volume).

Проверка предварительных требований.

Перед тем как начать, проверьте указанные ниже предварительные требования.

- Убедитесь в том, что все серверы, которые нужно добавить в качестве узлов кластера, работают под управлением одной и той же версии Windows Server.

Примечание

Средство отказоустойчивости кластеров можно использовать во всех выпусках Windows Server 2012 R2 и Windows Server 2012. Это касается и установок основных серверных компонентов.

- Изучите требования к оборудованию, чтобы убедиться в том, что ваша конфигурация поддерживается. Дополнительные сведения см. в разделе Требования к оборудованию для отказоустойчивой кластеризации и варианты хранилища.

- Если в процессе создания кластера необходимо добавить кластерное хранилище, убедитесь в том, что оно доступно всем серверам. (Кластерное хранилище можно добавить и после создания кластера.)

- Убедитесь в том, что все серверы, которые нужно добавить в качестве узлов кластера, присоединены к одному и тому же домену Active Directory.

- (Необязательно.) Создайте подразделение и переместите в него учетные записи компьютеров для серверов, которые нужно добавить в качестве узлов кластера. Мы рекомендуем размещать отказоустойчивые кластеры в собственном подразделении в AD DS. Это позволит лучше контролировать параметры групповой политики и шаблона безопасности, применяемые к узлам кластера. Изоляция кластеров в собственном подразделении также помогает предотвратить случайное удаление объектов-компьютеров кластера.

Кроме того, проверьте выполнение указанных ниже требований к учетным записям.

- Убедитесь в том, что учетная запись, которую вы хотите использовать для создания кластера, принадлежит пользователю домена с правами администратора на всех серверах, которые нужно добавить в качестве узлов кластера.

- Убедитесь в том, что выполняется одно из указанных ниже условий.

- У пользователя, создающего кластер, есть разрешение на создание объектов-компьютеров для подразделения или контейнера, в котором размещаются серверы, которые войдут в кластер.

- Если у пользователя нет разрешения на создание объектов-компьютеров, попросите администратора домена предварительно подготовить объект-компьютер кластера. Дополнительные сведения см. в разделе Подготовка кластерных объектов-компьютеров в доменных службах Active Directory.

Примечание

Это требование не действует, если вы хотите создать отсоединенный от Active Directory кластер в Windows Server 2012 R2. Дополнительные сведения см. в разделе Развертывание отсоединенного от Active Directory кластера.

Требования к оборудованию для отказоустойчивой кластеризации и варианты хранилища

Применимо к:Windows Server 2012 R2, Windows Server 2012

Для создания отказоустойчивого кластера требуется следующее оборудование. Чтобы оборудование поддерживалось программным обеспечением Майкрософт, оно все должно быть сертифицированным для используемой версии Windows Server, а решение отказоустойчивого кластера должно пройти все тесты в мастере проверки конфигурации. Дополнительные сведения о проверке отказоустойчивого кластера см. в разделе Проверка оборудования для отказоустойчивого кластера.

· Серверы. Рекомендуется использовать набор совпадающих компьютеров, содержащих одинаковые или похожие компоненты.

· Сетевые адаптеры и кабели (для передачи данных по сети). Если используется iSCSI, то каждый сетевой адаптер должен быть выделенным для подключения к сети или для iSCSI, но не для того и другого одновременно.

Избегайте единственных точек отказа в сетевой инфраструктуре, соединяющей узлы кластера. Например, можно соединить узлы кластера несколькими независимыми сетями. Можно также соединить узлы кластера в одну сеть, основанную на сгруппированных сетевых адаптерах, дублированных коммутаторах и маршрутизаторах и аналогичном оборудовании, исключающем появление единственных точек отказа.

Примечание

Если узлы кластера соединены одной сетью, сеть пройдет тест на избыточность мастера проверки конфигурации. Однако отчет мастера будет включать предупреждение, что в сети не должно быть единственных точек отказа.

· Контроллеры устройств или соответствующие адаптеры для хранилища.

o Serial Attached SCSI или Fibre Channel. Если используется Serial Attached SCSI или Fibre Channel во всех кластерных серверах, то все элементы стека хранилища должны быть идентичными. Необходимо, чтобы ПО многоканального ввода-вывода (MPIO) было идентичным. Также идентичным должно быть ПО модуля для конкретного устройства (DSM). Рекомендуется, чтобы контроллеры запоминающих устройств, то есть адаптер шины (HBA), драйверы HBA и встроенное ПО HBA, присоединенные к хранилищу кластера, были идентичными. При использовании различных HBA следует уточнить у поставщика хранилища, обеспечиваются ли при этом поддерживаемые или рекомендуемые конфигурации.

o iSCSI. При использовании iSCSI у каждого кластерного сервера должно быть не менее одного сетевого адаптера или адаптера шины, предназначенного исключительно для хранилища кластера. Сеть, используемая для iSCSI, не может использоваться для сетевого взаимодействия. На всех кластеризованных серверах сетевые адаптеры для подключения к целевому хранилищу iSCSI должны быть одинаковыми. Рекомендуется использовать адаптеры Gigabit Ethernet или с более высокой пропускной способностью.

· Хранилище. Необходимо использовать хранилище общего доступа, совместимое с Windows Server 2012 R2 или Windows Server 2012. Можно использовать подключенное хранилище общего доступа или файловые ресурсы общего доступа SMB 3.0 в качестве хранилища общего доступа для серверов в отказоустойчивом кластере, на которых выполняется Hyper-V. Дополнительные сведения см. в разделе Развертывание Hyper-V через SMB.

В большинстве случаев в подключенном хранилище должно быть несколько отдельных дисков (логических номеров устройств, или LUN), настроенных на аппаратном уровне. Для некоторых кластеров один из дисков работает как диск-свидетель (см. в конце этого подраздела). На других дисках содержатся файлы, необходимые для кластерных ролей (ранее называвшихся кластеризованными службами или приложениями). К хранилищу предъявляются следующие требования.

o Для использования собственной поддержки дисков, включенной в компонент отказоустойчивого кластера, применяйте базовые, а не динамические диски.

o Мы рекомендуем форматировать разделы с использованием файловой системой NTFS. Если вы используете общие тома кластера (CSV), их разделы должны иметь формат NTFS.

Примечание

Если в конфигурации кворума используется диск-свидетель, его можно отформатировать в NTFS или в Resilient File System (ReFS).

o Для разделения диска на разделы можно использовать основную загрузочную запись (MBR) или таблицу разделов GPT.

Диск-свидетель — это диск в системе хранения данных кластера, который предназначен для хранения копии базы данных конфигурации кластера. Отказоустойчивый кластер имеет диск-свидетель, только если он настроен в конфигурации кворума. Дополнительные сведения см. в разделе Настройка и управление кворумом на отказоустойчивом кластере Windows Server 2012.

Требования к оборудованию для Hyper-V

Если вы создаете отказоустойчивый кластер с кластерными виртуальными машинами, то серверы кластера должны отвечать требованиям к оборудованию для роли Hyper-V. Для Hyper-V требуется 64-разрядный процессор, включающий следующие возможности.

· Виртуализация с использованием оборудования. Это возможно на процессорах, допускающих виртуализацию, а именно на процессорах с технологией Intel Virtualization Technology (Intel VT) или AMD Virtualization (AMD-V).

· Должна быть доступна и включена технология аппаратного предотвращения выполнения данных (DEP). То есть необходимо включить атрибут Intel XD (атрибут отключения выполнения) или AMD NX (атрибут запрета выполнения).

Дополнительные сведения о роли Hyper-V см. в статье Обзор Hyper-V.

Развертывание сетей хранения данных с отказоустойчивыми кластерами

При развертывании сети хранения данных (SAN) с отказоустойчивым кластером руководствуйтесь следующими рекомендациями.

· Подтвердите совместимость хранилища. Обратитесь к производителям и поставщикам, чтобы подтвердить, что хранилище, включая драйверы, встроенное ПО и ПО, используемое для хранилища, совместимо с отказоустойчивыми кластерами в используемой версии Windows Server.

· Изолируйте запоминающие устройства по одному кластеру на устройство. Серверы из различных кластеров не должны иметь доступа к одним и тем же запоминающим устройствам. В большинстве случаев LUN, используемый для одного набора серверов кластера, должен быть изолирован от всех остальных серверов с помощью маски или зонирования LUN.

· Рассмотрите использование ПО многоканального ввода-вывода или объединенных сетевых адаптеров. В архитектуре хранилищ с высокой доступностью можно развернуть отказоустойчивые кластеры с несколькими адаптерами шины, используя ПО многоканального ввода-вывода или объединенных сетевых адаптеров (что также называется отказоустойчивой балансировкой нагрузки — LBFO). Это обеспечивает максимальный уровень резервирования и доступности. Для Windows Server 2012 R2 или Windows Server 2012 многоканальное решение должно быть основано на MPIO (Microsoft Multipath I/O). Поставщики оборудования обычно предоставляют модуль MPIO для конкретного устройства (DSM), но в комплект поставки операционной системы Windows Server также входят один или несколько модулей DSM.

Подробнее о LBFO см. раздел Отказоустойчивая балансировка нагрузки в технической библиотеке Windows Server.

Важно

Некоторые адаптеры шины и программное обеспечение многоканального ввода-вывода сильно зависят от версий. При реализации многоканального решения для кластера следует проконсультироваться с поставщиком оборудования, чтобы выбрать правильные адаптеры, встроенное программное обеспечение и программное обеспечение для используемой версии Windows Server.

· Рассмотрите использование дисковых пространств. Если планируется развертывание кластерного хранилища Serial Attached SCSI (SAS), настроенного с помощью дисковых пространств, см. требования в разделе Развертывание кластерных дисковых пространств.

Установка средства отказоустойчивости кластеров

Средство отказоустойчивости кластеров необходимо установить на всех серверах, которые будут добавлены как узлы отказоустойчивого кластера.

Установка средства отказоустойчивости кластеров

1. Запустите диспетчер сервера.

2. В меню Управление выберите команду Добавить роли и компоненты.

3. На странице Перед работой нажмите кнопку Далее.

4. На странице Выбор типа установки щелкните Установка ролей или компонентов, а затем нажмите кнопку Далее.

5. На странице Выбор целевого сервера щелкните сервер, на котором следует установить средство, и нажмите кнопку Далее.

6. На странице Выбор ролей сервера нажмите кнопку Далее.

7. На странице Выбор компонентов установите флажок Отказоустойчивая кластеризация.

8. Чтобы установить средства управления отказоустойчивыми кластерами, щелкните Добавить компоненты, а затем нажмите кнопку Далее.

9. На странице Подтверждение выбранных элементов для установки нажмите кнопку Установить.

Примечание

После установки средства отказоустойчивости кластеров не нужно перезапускать сервер.

10. По завершении установки нажмите кнопку Закрыть.

11. Повторите эту процедуру на каждом сервере, который необходимо добавить как узел отказоустойчивого кластера.

Примечание

После установки средства отказоустойчивости кластеров рекомендуется применить последние обновления из Центра обновления Windows. При развертывании отказоустойчивого кластера на основе Windows Server 2012 изучите статью службы поддержки Майкрософт Рекомендованные исправления и обновления для отказоустойчивых кластеров на основе Windows Server 2012 и установите все соответствующие обновления.

Проверка конфигурации

Перед созданием отказоустойчивого кластера настоятельно рекомендуется проверить конфигурацию, чтобы убедиться в том, что оборудование и его настройки совместимы с отказоустойчивой кластеризацией. Корпорация Майкрософт поддерживает кластерное решение, только если конфигурация прошла все проверочные тесты и все оборудование сертифицировано для версии Windows Server, под управлением которой работают узлы кластера.

Примечание

Для выполнения всех тестов необходимы по крайней мере два узла. Если имеется только один узел, выполнение многих важных тестов хранилища невозможно.

Выполнение проверочных тестов кластера

1. На компьютере, на котором установлены средства управления отказоустойчивыми кластерами из средств удаленного администрирования сервера, или на сервере, на котором установлено средство отказоустойчивости кластеров, запустите диспетчер отказоустойчивости кластеров. Чтобы выполнить это действие на сервере, откройте диспетчер сервера и в меню Средства выберите пункт Диспетчер отказоустойчивости кластеров.

2. Введите Bank в поле Имя

3. На странице Прежде чем приступить к работе нажмите кнопку Далее.

4. На странице Выбор серверов или кластера в поле Введите имя введите имя NetBIOS или полное доменное имя сервера, который планируется добавить как узел отказоустойчивого кластера, а затем нажмите кнопку Добавить. Повторите этот шаг для каждого сервера, который нужно добавить. Чтобы добавить несколько серверов одновременно, разделяйте их имена запятой или точкой с запятой. Например, введите имена в формате server1.contoso.com, server2.contoso.com. Завершив настройку, нажмите кнопку Далее.

5. На странице Параметры тестирования щелкните Выполнить все тесты (рекомендуется), а затем нажмите кнопку Далее.

6. На странице Подтверждение нажмите кнопку Далее.

На странице “Проверка” показано состояние выполняющихся тестов.

7. На странице Сводка выполните одно из указанных ниже действий.

o Если результаты указывают на то, что тесты были пройдены успешно и конфигурация подходит для кластеризации, то, чтобы создать кластер немедленно, установите флажок Создать кластер, используя проверенные узлы и нажмите кнопку Готово. Теперь перейдите к шагу 4 процедуры Создание отказоустойчивого кластера.

o Если в результатах есть предупреждения или сбои, нажмите кнопку Просмотр отчета, чтобы просмотреть подробные сведения и решить, какие неполадки необходимо исправить. Имейте в виду, что предупреждение в результатах определенного проверочного теста указывает на то, что данный аспект отказоустойчивого кластера поддерживается, но может не соответствовать рекомендациям.

Примечание

Если получено предупреждение для теста «Проверка постоянного резервирования дисковых пространств», дополнительную информацию см. в записи блога Предупреждение при проверке отказоустойчивого кластера Windows указывает на то, что диски не поддерживают постоянное резервирование дисковых пространств.

8. Дополнительные сведения о тестах проверки оборудования см. в разделе Проверка оборудования для отказоустойчивого кластера.

Создание отказоустойчивого кластера

Чтобы выполнить это действие, убедитесь в том, что учетная запись пользователя, с помощью которой вы вошли в систему, соответствует требованиям, указанным в подразделе Проверка предварительных требований этого раздела.

Создание отказоустойчивого кластера

1. Запустите диспетчер сервера.

2. В меню Инструменты выберите пункт Диспетчер отказоустойчивости кластеров.

3. Введите Bank в поле Имя

Откроется мастер создания кластеров.

4. На странице Прежде чем приступить к работе нажмите кнопку Далее.

5. Если откроется страница Выбор серверов, в поле Введите имя введите имя NetBIOS или полное доменное имя сервера, который планируется добавить как узел отказоустойчивого кластера, а затем нажмите кнопку Добавить. Повторите этот шаг для каждого сервера, который нужно добавить. Чтобы добавить несколько серверов одновременно, разделяйте их имена запятой или точкой с запятой. Например, введите имена в формате server1.contoso.com; server2.contoso.com. Завершив настройку, нажмите кнопку Далее.

Примечание

Если вы решили создать кластер немедленно после выполнения проверки, описанной в процедуре Проверка конфигурации, страница Выбор серверов не появится. Проверенные узлы автоматически добавляются в мастер создания кластеров, так что вводить их еще раз не нужно.

6. Если ранее вы пропустили проверку, появится страница Предупреждение проверки. Настоятельно рекомендуется выполнить проверку кластера. Корпорация Майкрософт поддерживает только те кластеры, которые прошли все проверочные тесты. Чтобы выполнить проверочные тесты, нажмите кнопку Да, а затем кнопку Далее. Выполните мастер проверки конфигурации, как описано в процедуре Проверка конфигурации.

7. На странице Точка доступа для администрирования кластера выполните указанные ниже действия.

1. Введите Bank в поле Имя Перед этим изучите приведенную ниже информацию.

§ В процессе создания кластера это имя регистрируется в качестве объекта-компьютера кластера (также известного как объект имени кластера или CNO) в доменных службах Active Directory. Если для кластера указано имя NetBIOS, объект CNO создается в том же расположении, в котором находятся объекты-компьютеры узлов кластера. Это может быть контейнер “Компьютеры” (по умолчанию) или подразделение.

§ Чтобы указать другое расположение для CNO, можно ввести различающееся имя подразделения в поле Имя кластера. Например: CN=ClusterName, OU=Clusters, DC=Contoso, DC=com.

§ Если администратор домена предварительно подготовил CNO в подразделении, отличном от того, в котором размещаются узлы кластера, укажите различающееся имя, предоставленное администратором домена.

2. Если на сервере нет сетевого адаптера, настроенного на использование DHCP, для отказоустойчивого кластера необходимо настроить один или несколько статических IP-адресов. Установите флажок напротив каждой сети, которую необходимо использовать для управления кластером. Щелкните поле Адрес рядом с выбранной сетью, а затем введите IP-адрес, который нужно назначить кластеру. Этот IP-адрес (или адреса) будет связан с именем кластера в службе доменных имен (DNS).

3. Завершив настройку, нажмите кнопку Далее.

8. Просмотрите параметры на странице Подтверждение. По умолчанию установлен флажок Добавление всех допустимых хранилищ в кластер. Снимите его в указанных ниже случаях.

o Хранилище следует настроить позднее.

o Вы планируете создать кластерные дисковые пространства с помощью диспетчера отказоустойчивости кластеров или командлетов отказоустойчивой кластеризации Windows PowerShell, но еще не создали дисковые пространства в файловых службах и службах хранилища. Дополнительные сведения см. в разделе Развертывание кластерных дисковых пространств.

9. Чтобы создать отказоустойчивый кластер, нажмите кнопку Далее.

10. На странице Сводка убедитесь в том, что отказоустойчивый кластер успешно создан. Если есть предупреждения или ошибки, просмотрите сводные выходные данные или нажмите кнопку Просмотр отчета, чтобы просмотреть полный отчет. Нажмите кнопку Готово.

11. Чтобы убедиться в том, что кластер создан, проверьте, указано ли его имя в разделе Диспетчер отказоустойчивости кластеров в дереве навигации. Можно развернуть имя кластера, а затем щелкнуть элементы в разделах Узлы, Хранилище или Сети, чтобы просмотреть связанные ресурсы.

Имейте в виду, что на успешную репликацию имени кластера в службе DNS может потребоваться некоторое время. Если после успешной регистрации и репликации в службе DNS щелкнуть Все серверы в диспетчере сервера, имя кластера должно быть указано в списке серверов, а его состояние Управляемость будет иметь значение В сети.

После создания кластера можно выполнить такие действия, как проверка конфигурации кворума кластера и создание общих томов кластера — CSV (необязательно). Дополнительные сведения см. в разделах Настройка и управление кворумом на отказоустойчивом кластере Windows Server 2012 и Использование общих томов кластера в отказоустойчивом кластере.

Создание кластерных ролей

После создания отказоустойчивого кластера можно создать кластерные роли для размещения кластерных рабочих нагрузок.

Примечание

Для кластерных ролей, требующих точки доступа клиента, в доменных службах Active Directory создается виртуальный объект-компьютер (VCO). По умолчанию все объекты VCO для кластера создаются в том же контейнере или подразделении, что и объект CNO. Имейте в виду, что после создания кластера объект CNO можно переместить в любое подразделение.

Создание кластерной роли

1. Чтобы на каждом узле отказоустойчивого кластера установить роль или компонент, необходимый для кластерной роли, используйте диспетчер сервера или Windows PowerShell. Например, чтобы создать кластерный файловый сервер, установите роль файлового сервера на всех узлах кластера.

В таблице ниже приведены кластерные роли, которые можно настроить в мастере высокой доступности, и соответствующие роли или компоненты сервера, которые необходимо установить.

2. В диспетчере отказоустойчивости кластеров разверните имя кластера, щелкните правой кнопкой мыши элемент Роли, а затем выберите пункт Настроить роль.

3. Для создания кластерной роли выполните последовательность действий, предлагаемую мастером высокой доступности.

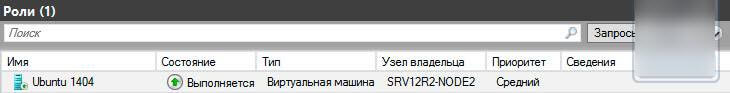

4. Чтобы проверить, создана ли кластерная роль, на панели Роли убедитесь в том, что роль имеет состояние Выполняется. На панели “Роли” также указан узел владельца. Чтобы проверить отработку отказа, щелкните правой кнопкой мыши роль, наведите указатель на пункт Переместить, а затем щелкните Выбрать узел. В диалоговом окне Переместить кластерную роль щелкните необходимый узел кластера и нажмите кнопку ОК. В столбце Узел владельца убедитесь в том, что узел владельца изменился.

Применимо к:Windows Server 2012

Раздел содержит базовые сведения и инструкции для настройки и управления кворумом в отказоустойчивом кластере Windows Server 2012.

В этом разделе

Общие сведения о кворуме в отказоустойчивом кластере

Обзор параметров настройки кворума

· Настройка свидетеля

· Назначение голосов узлов

· Динамическое управление кворумом

Общие рекомендации по настройке кворума

Настройка кворума кластера

Восстановление кластера путем запуска без кворума

Рекомендации касательно кворума для конфигураций аварийного восстановления

Общие сведения о кворуме в отказоустойчивом кластере

Кворум кластера определяется числом голосующих элементов, являющихся активными членами кластера, которое необходимо для запуска кластера и его правильной работы. По умолчанию каждый узел кластера имеет один голос кворума. Кроме того, свидетель кворума (если он настроен) имеет один дополнительный голос кворума. Для каждого кластера можно настроить один свидетель кворума. Свидетелем кворума может быть ресурс выделенного диска или общий файловый ресурс. Каждый элемент может подать один голос для определения того, можно ли запустить кластер. Наличие кворума в кластере для его правильной работы определяется большинством голосующих элементов, являющихся активными членами кластера.

Зачем настраивать кворум?

Чтобы повысить уровень доступности кластера и размещенных в нем ролей, необходимо правильно настроить конфигурацию кворума для кластера.

Конфигурация кворума кластера непосредственно влияет на доступность кластера по указанным ниже причинам.

· Она помогает обеспечить правильный запуск и работу отказоустойчивого кластера при изменении активного членства в кластере. Изменения членства могут происходить из-за запланированного или незапланированного прекращения работы узлов, а также из-за разрывов соединений между узлами или с хранилищем кластера.

· Если подмножество узлов утрачивает связь с другим подмножеством (то есть происходит расщепление кластера), конфигурация кворума кластера гарантирует, что только одно из подмножеств продолжает работать как кластер. Подмножества, у которых недостаточно голосов кворума, перестанут работать как кластер. Подмножество, имеющее большинство голосов кворума, может и далее использоваться для размещения кластерных ролей. Это позволяет избежать деления кластера на разделы, при котором одно и то же приложение размещается в нескольких разделах.

· Настройка голоса свидетеля позволяет кластеру продолжать работу при отключении одного дополнительного узла в некоторых конфигурациях. Подробнее о настройке свидетеля кворума см. в подразделе Настройка свидетеля далее в этом разделе.

Имейте в виду, что функционирование кластера зависит не только от кворума, но еще и от следующих факторов:

· сетевые соединения между узлами кластера;

· емкость узла, достаточная для размещения назначаемых ему кластерных ролей;

· параметры приоритета, настраиваемые для кластерных ролей.

Например, кластер с пятью узлами может сохранять кворум после отказа двух узлов. Однако каждый оставшийся узел будет обслуживать клиентов только в том случае, если он имеет достаточную емкость для размещения кластерных ролей, перенесенных на него в результате отработки отказа, и если параметрами ролей установлены наиболее приоритетные рабочие нагрузки.

Обзор параметров настройки кворума

Модель кворума в Windows Server 2012 является гибкой. Если необходимо изменить конфигурацию кворума для кластера, воспользуйтесь мастером настройки кворума кластера или командлетами отказоустойчивых кластеров Windows PowerShell. Параметры конфигурации кворума по сравнению с параметрами в Windows Server 2008 R2 стали проще. Инструкции и рекомендации по настройке кворума см. в подразделе Настройка кворума кластера далее в этом разделе.

В таблице ниже перечислены три параметра конфигурации кворума, доступные в мастере настройки кворума кластера.

В зависимости от выбранного варианта конфигурации кворума и заданных параметров для кластера настраивается один из указанных ниже режимов кворума.

Подробнее о дополнительных параметрах конфигурации кворума см. в следующих подразделах.

· Настройка свидетеля

· Назначение голосов узлов

· Динамическое управление кворумом

Настройка свидетеля

Как правило, при настройке кворума число голосующих элементов в кластере должно быть нечетным. Поэтому, если кластер содержит четное число голосующих узлов, следует настроить диск-свидетель или файловый ресурс-свидетель. Кластер сможет продолжать работу при отключении одного дополнительного узла. Кроме того, добавление голоса свидетеля позволяет кластеру продолжать работу в том случае, если половина его узлов одновременно прекращает работу или отключается.

Использовать диск-свидетель обычно рекомендуется, если диск доступен всем узлам. Файловый ресурс-свидетель рекомендуется в том случае, если необходимо реализовать аварийное восстановление нескольких сайтов с реплицированным хранилищем. Настройка диска-свидетеля с реплицированным хранилищем возможна только в том случае, если поставщик хранилища поддерживает доступ для чтения и записи к реплицированному хранилищу со всех сайтов.

В таблице ниже приводится дополнительная информация и рекомендации касательно типов свидетеля кворума.

Назначение голосов узлов

В Windows Server 2012 с помощью дополнительных параметров настройки кворума можно назначать голоса отдельным узлам или удалять их. По умолчанию голоса назначены всем узлам. Вне зависимости от назначения голосов, все узлы продолжают работать в кластере, получать обновления из базы данных кластера и использоваться для размещения приложений.

В некоторых конфигурациях аварийного восстановления может потребоваться удалить голоса, назначенные узлам. Например, в кластере с несколькими сайтами можно удалить голоса узлов на сайте резервного копирования, чтобы они не оказывали влияния на подсчет кворума. Такая конфигурация рекомендуется только при отработке отказа между сайтами вручную. Дополнительные сведения см. ниже в разделе Рекомендации касательно кворума для конфигураций аварийного восстановления.

Узнать, назначен ли узлу голос, можно путем проверки значения общего свойства NodeWeight для узла кластера с помощью командлета Get-ClusterNode Windows PowerShell. Значение 0 указывает на то, что для узла не настроен голос кворума. Значение 1 указывает на то, что узлу назначен голос кворума и управление им осуществляется кластером. Дополнительные сведения об управлении голосами узлов см. в подразделе Динамическое управление кворумом далее в этом разделе.

Назначение голосов всем узлам кластера можно проверить с помощью теста Проверка кворума кластера.

Дополнительные сведения

· Не рекомендуется назначать голоса нечетному числу узлов. Вместо этого следует настроить диск-свидетель или файловый ресурс-свидетель. Дополнительные сведения см. в разделе Настройка свидетеля этой статьи.

· Если включено динамическое управление кворумом, голоса могут динамически назначаться и удаляться только для тех узлов, для которых настроено назначение голосов. Дополнительные сведения см. ниже в разделе Динамическое управление кворумом.

Динамическое управление кворумом

В Windows Server 2012 с помощью дополнительных параметров настройки кворума можно включить динамическое управление кворумом, которое осуществляется кластером. Если этот параметр включен, кластер динамически управляет назначением голосов узлам в соответствии с состоянием каждого узла. Когда узел перестает быть активным членом кластера, он автоматически теряет голос, а когда он снова присоединяется к кластеру, голос автоматически назначается. По умолчанию динамическое управление кворумом включено.

Примечание

При использовании динамического управления кворумом большинство кворума в кластере определяется на основе набора узлов, являющихся активными членами кластера в данный момент. Это важное отличие от кворума кластера в Windows Server 2008 R2, где большинство кворума зависит от первоначальной конфигурации кластера и является фиксированным.

Благодаря динамическому управлению кворумом кластер также может продолжать работать на последнем оставшемся узле. Благодаря динамическому изменению требований к большинству кворума кластер может сохранять работоспособность после последовательного отключения всех узлов, кроме последнего.

Узнать, назначил ли кластер узлу голос в динамическом режиме, можно путем проверки значения общего свойства DynamicWeight для узла кластера с помощью командлета Get-ClusterNode Windows PowerShell. Значение 0 указывает на то, что у узла нет голоса кворума. Значение 1 указывает на то, что у узла есть голос кворума.

Назначение голосов всем узлам кластера можно проверить с помощью теста Проверка кворума кластера.

Дополнительные сведения

· Динамическое управление кворумом не позволяет кластеру сохранять работоспособность при одновременном сбое большинства голосующих членов. Для продолжения работы в кластере должно быть большинство кворума на момент завершения работы или сбоя узла.

· Если вы явно удалили голос узла, кластер не сможет динамически добавить или удалить его.

Общие рекомендации по настройке кворума

Программное обеспечение кластера автоматически настраивает кворум для нового кластера в соответствии с числом настроенных узлов и доступностью общего хранилища. Обычно это оптимальная конфигурация кворума для данного кластера. Однако рекомендуется проверить конфигурацию кворума после создания кластера и перед его запуском. Чтобы просмотреть подробную информацию о конфигурации кворума кластера, можно воспользоваться мастером проверки конфигурации или командлетом Test-Cluster Windows PowerShell для запуска теста Проверка конфигурации кворума. В диспетчере отказоустойчивости кластеров базовая конфигурация кворума содержится в сводной информации о выбранном кластере. Вы также можете просмотреть информацию о ресурсах кворума, которая выводится при запуске командлета Get-ClusterQuorum Windows PowerShell.

В любой момент можно выполнить тест Проверка конфигурации кворума, чтобы проверить, является ли конфигурация кворума оптимальной для кластера. В результатах теста приводятся рекомендации по изменению конфигурации кворума и информация об оптимальных параметрах. Если рекомендуется внести изменение, применить нужные параметры можно с помощью мастера настройки кворума кластера.

После запуска кластера изменять конфигурацию кворума следует только в том случае, если вы уверены, что это изменение необходимо. Изменение конфигурации кворума может потребоваться в следующих ситуациях:

· добавление или исключение узлов;

· добавление или удаление хранилища;

· длительный сбой узла или свидетеля;

· восстановление кластера в сценарии аварийного восстановления на основе нескольких сайтов.

Дополнительные сведения о проверке отказоустойчивого кластера см. в разделе Проверка оборудования для отказоустойчивого кластера.

Настройка кворума кластера

Настроить параметры кворума кластера можно с помощью диспетчера отказоустойчивости кластеров или командлетов отказоустойчивых кластеров Windows PowerShell.

Важно

Как правило, лучше использовать конфигурацию кворума, рекомендованную мастером настройки кворума кластера. Изменять конфигурацию кворума рекомендуется только в том случае, если решено, что изменение соответствует данному кластеру. Дополнительные сведения см. в разделе Общие рекомендации по настройке кворума этой статьи.

Настройка параметров кворума кластера

Для выполнения этой процедуры необходимо быть как минимум участником локальной группы Администраторы на каждом кластерном сервере или иметь равнозначные права. Кроме того, используемая учетная запись должна быть учетной записью пользователя домена.

Примечание

Изменять конфигурацию кворума кластера можно без остановки кластера и без отключения его ресурсов.

Изменение конфигурации кворума в отказоустойчивом кластере с помощью диспетчера отказоустойчивости кластеров

1. В диспетчере отказоустойчивости кластеров выберите или укажите кластер, который нужно изменить.

2. Выбрав кластер, на панели Действия выберите пункт Дополнительные действия и щелкните Настроить параметры кворума кластера. Появится мастер настройки кворума кластера. Нажмите кнопку Далее.

3. На странице Выбор параметра конфигурации кворума выберите один из трех параметров конфигурации и выполните необходимые для него действия. Перед настройкой параметров кворума можно изучить возможные варианты. Дополнительные сведения о вариантах см. в подразделе Общие сведения о кворуме в отказоустойчивом кластере ранее в этом разделе.

o Чтобы разрешить кластеру автоматически установить оптимальные параметры кворума для текущей конфигурации кластера, выберите параметр Использовать типичные параметры и выполните инструкции мастера.

o Чтобы добавить или изменить свидетель кворума, выберите параметр Добавить или изменить свидетель кворума, а затем выполните описанные ниже действия. Информацию и рекомендации по настройке свидетеля кворума см. в подразделе Настройка свидетеля ранее в этом разделе.

1. На странице Выбор свидетеля кворума выберите, нужно ли настроить диск-свидетель или файловый ресурс-свидетель. В мастере будут показаны параметры выбора свидетеля, рекомендованные для вашего кластера.

Примечание

Также можно выбрать параметр Не настраивать свидетель кворума и завершить работу мастера. Если число голосующих узлов в кластере четное, такая конфигурация не рекомендуется.

2. Если вы выбрали настройку диска-свидетеля, на странице Настройка хранилища выберите том хранилища, который нужно назначить диском-свидетелем, а затем завершите работу мастера.

3. Если вы выбрали настройку файлового ресурса-свидетеля, на странице Настройка файлового ресурса-свидетеля введите имя файлового ресурса, который будет использоваться в качестве ресурса-свидетеля, или выберите его, а затем завершите работу мастера.

o Чтобы настроить параметры управления кворумом и добавить или изменить свидетель кворума, выберите пункт Дополнительная настройка кворума и выбор свидетеля, а затем выполните описанные ниже действия. Сведения и рекомендации о дополнительных параметрах настройки кворума см. в подразделах Назначение голосов узлов и Динамическое управление кворумом ранее в этом разделе.

1. На странице Выбор конфигурации голосования выберите вариант назначения голосов узлам. По умолчанию голоса назначены всем узлам. Однако в некоторых сценариях можно назначить голоса только подмножеству узлов.

Примечание

Также можно выбрать вариант Нет узлов. Обычно делать это не рекомендуется, так как узлам при этом не разрешено принимать участие в голосовании в кворуме, и необходимо настроить диск-свидетель. Диск-свидетель становится единой точкой отказа в кластере.

2. На странице Настройка управления кворумом можно включить или отключить параметр Разрешить кластеру динамически управлять назначением голосов узлов. Выбор этого параметра, как правило, повышает доступность кластера. По умолчанию он включен, и настоятельно не рекомендуется его отключать. Этот параметр позволяет кластеру продолжать работу в таких сценариях сбоя, в которых его функционирование невозможно, если параметр отключен.

3. На странице Выбор свидетеля кворума выберите, нужно ли настроить диск-свидетель или файловый ресурс-свидетель. В мастере будут показаны параметры выбора свидетеля, рекомендованные для вашего кластера.

Примечание

Также можно выбрать параметр Не настраивать свидетель кворума и завершить работу мастера. Если число голосующих узлов в кластере четное, такая конфигурация не рекомендуется.

4. Если вы выбрали настройку диска-свидетеля, на странице Настройка хранилища выберите том хранилища, который нужно назначить диском-свидетелем, а затем завершите работу мастера.

5. Если вы выбрали настройку файлового ресурса-свидетеля, на странице Настройка файлового ресурса-свидетеля введите имя файлового ресурса, который будет использоваться в качестве ресурса-свидетеля, или выберите его, а затем завершите работу мастера.

4. Нажмите кнопку Далее. На открывшейся странице подтвердите выбранные параметры и нажмите кнопку Далее.

После выполнения мастера и отображения страницы Сводка щелкните пункт Просмотр отчета, чтобы посмотреть отчет о выполненных мастером задачах. Последний отчет находится в папке systemrootClusterReports под именем QuorumConfiguration.mht.

Примечание

После настройки кворума кластера рекомендуем выполнить тест Проверка конфигурации кворума, чтобы проверить обновленные параметры кворума.

Подготовка кластерных объектов-компьютеров в доменных службах Active Directory

Применимо к:Windows Server 2012 R2, Windows Server 2012

В этом разделе показан порядок подготовки кластерных объектов-компьютеров в доменных службах Active Directory (AD DS). Эту процедуру можно использовать, чтобы дать возможность пользователю или группе создавать отказоустойчивые кластеры, если у них нет разрешений на создание объектов-компьютеров в AD DS.

Когда вы создаете отказоустойчивый кластер с помощью мастера создания кластеров или Windows PowerShell, необходимо указать имя кластера. Если при создании кластера у вас достаточно разрешений, процесс создания кластера автоматически создает объект-компьютер в AD DS с соответствующим именем кластера. Этот объект называется объектом имени кластера или CNO. Посредством CNO при настройке кластерных ролей, использующих точки доступа клиентов, автоматически создаются виртуальные объекты-компьютеры (VCO). Например, если вы создали файловый сервер высокой надежности с точкой доступа клиента с именем FileServer1, CNO создаст соответствующий VCO в AD DS.

Примечание

В Windows Server 2012 R2 есть возможность создать отсоединенный от Active Directory кластер. При этом ни CNO, ни VCO в AD DS не создается. Эта возможность предназначена для определенных типов развертывания кластера. Дополнительные сведения см. в разделе Развертывание отсоединенного от Active Directory кластера.

Для автоматического создания CNO у пользователя, создающего отказоустойчивый кластер, должно быть разрешение на создание объектов-компьютеров для подразделения или контейнера, в которых размещаются серверы, которые войдут в кластер. Чтобы позволить пользователям и группам, не имеющим разрешения, создавать кластеры, пользователь с соответствующими разрешениями в AD DS (обычно администратор домена) может подготовить CNO в AD DS. Это также обеспечивает администратору домена больший контроль над именами, используемыми для кластера, и над тем, в каких подразделениях можно создавать кластерные объекты.

С помощью описанных в этом разделе процедур вы сможете сделать следующее.

· Шаг 1. Подготовка CNO в AD DS

· Шаг 2. Предоставление пользователю разрешений на создание кластера

· Шаг 3. Предоставление разрешений CNO подразделению или подготовка VCO для кластерных ролей

Шаг 1. Подготовка CNO в AD DS

Перед началом работы убедитесь, что знаете следующее:

· имя, которое следует присвоить кластеру;

· имя учетной записи пользователя или группы, которой следует предоставить права на создание кластера.

Мы рекомендуем создать подразделение для кластерных объектов. Если подразделение, которое вы хотите использовать, уже существует, для завершения этого шага требуется членство в группе Операторы учета. Если подразделение для кластерных объектов необходимо создать, для завершения этого шага требуется членство в группе Администраторы домена или аналогичной группе.

Примечание

Если вы создали CNO в контейнере компьютеров по умолчанию, а не в подразделении, вам не нужно выполнять шаг 3 этого раздела. В этом сценарии администратор кластера может создать до 10 VCO без какой-либо дополнительной настройки.

Подготовка CNO в AD DS

1. На компьютере с установленными средствами AD DS из средств удаленного администрирования сервера или на контроллере домена откройте Пользователи и компьютеры Active Directory. Чтобы выполнить это действие на сервере, откройте диспетчер сервера и в меню Средства щелкните Пользователи и компьютеры Active Directory.

2. Чтобы создать подразделение для кластерных объектов-компьютеров, щелкните правой кнопкой мыши имя домена или существующее подразделение, наведите указатель на пункт Создать и щелкните Подразделение. В поле Имя введите имя подразделения и нажмите кнопку ОК.

3. В дереве консоли щелкните правой кнопкой мыши подразделение, в котором следует создать CNO, наведите указатель на пункт Создать и щелкните Компьютер.

4. В поле Имя компьютера введите имя, которое будет использоваться для отказоустойчивого кластера, и нажмите кнопку ОК.

Примечание

Это имя кластера, которое пользователь, создающий кластер, укажет в мастере создания кластеров на странице Точка доступа для администрирования кластера или укажет как значение параметра –Name для командлета New-Cluster Windows PowerShell.

5. Рекомендуется сделать следующее: щелкните правой кнопкой мыши учетную запись компьютера, которую вы только что создали, выберите Свойства и откройте вкладку Объект. На вкладке Объект установите флажок Защитить объект от случайного удаления и нажмите кнопку ОК.

6. Щелкните правой кнопкой мыши только что созданную учетную запись компьютера и выберите команду Отключить учетную запись. Нажмите кнопку Да для подтверждения, а затем нажмите кнопку ОК.

Примечание

Учетную запись необходимо отключить, чтобы во время создания кластера соответствующий процесс подтвердил, что учетная запись не используется в данный момент существующим компьютером или кластером в домене.

8. Рисунок 1. Отключенный CNO в примере подразделения кластеров

Шаг 2. Предоставление пользователю разрешений на создание кластера

Необходимо настроить разрешения, чтобы учетная запись пользователя, которая будет использоваться для создания отказоустойчивого кластера, имела полный доступ к CNO.

Минимальное требование для выполнения этого шага — членство в группе Операторы учета.

Предоставление пользователю разрешений на создание кластера

1. На странице “Пользователи и компьютеры Active Directory” в меню Вид убедитесь, что выбран пункт Дополнительные параметры.

2. Найдите и щелкните правой кнопкой мыши CNO и выберите Свойства.

3. На вкладке Безопасность нажмите кнопку Добавить.

4. В диалоговом окне Выбор пользователей, компьютеров или групп укажите учетную запись пользователя или группу, которым следует предоставить разрешения, и нажмите кнопку ОК.

5. Выберите добавленную учетную запись пользователя или группу и около пункта Полный доступ установите флажок Разрешить.

Рисунок 2. Предоставление полного доступа пользователю или группе, которые будут создавать кластер

6. Нажмите кнопку ОК.

После завершения этого шага пользователь, которому вы предоставили разрешение, сможет создать отказоустойчивый кластер. Однако если CNO расположен в подразделении, до завершения вами шага 3 пользователь не сможет создавать кластерные роли, которые требуют точку доступа клиента.

Примечание

Если CNO находится в контейнере компьютеров по умолчанию, администратор кластера может создать до 10 VCO без какой-либо дополнительной настройки. Чтобы добавить более 10 VCO, необходимо явно предоставить разрешение на создание объектов-компьютеров объекту имени кластера для контейнера компьютеров.

Шаг 3. Предоставление разрешений CNO подразделению или подготовка VCO для кластерных ролей

Когда вы создаете кластерную роль с точкой доступа клиента, кластер создает VCO в том же подразделении, что и CNO. Чтобы это происходило автоматически, CNO должен иметь разрешения на создание объектов-компьютеров в подразделении.

Если вы подготовили CNO в AD DS, для создания VCO можно сделать следующее.

· Вариант 1: Предоставление разрешений CNO подразделению. Если вы воспользуетесь этим вариантом, кластер сможет автоматически создавать VCO в AD DS. Таким образом, администратор отказоустойчивого кластера сможет создавать кластерные роли, не отправляя вам запрос на подготовку VCO в AD DS.

Примечание

Необходимым минимумом для выполнения шагов этого варианта является членство в группе Администраторы домена или эквивалентной группе.

· Вариант 2: Подготовка VCO для кластерной роли. Используйте этот вариант, если есть необходимость в подготовке учетных записей для кластерных ролей из-за требований в вашей организации. Например, если вы хотите контролировать использование имен или создание кластерных ролей.

Примечание

Необходимым минимумом для выполнения шагов этого варианта является членство в группе Операторы учета.

Предоставление разрешений CNO подразделению

1. На странице “Пользователи и компьютеры Active Directory” в меню Вид убедитесь, что выбран пункт Дополнительные параметры.

2. Щелкните правой кнопкой мыши подразделение, в котором вы создали CNO в разделе Шаг 1. Подготовка CNO в AD DS, а затем выберите пункт Свойства.