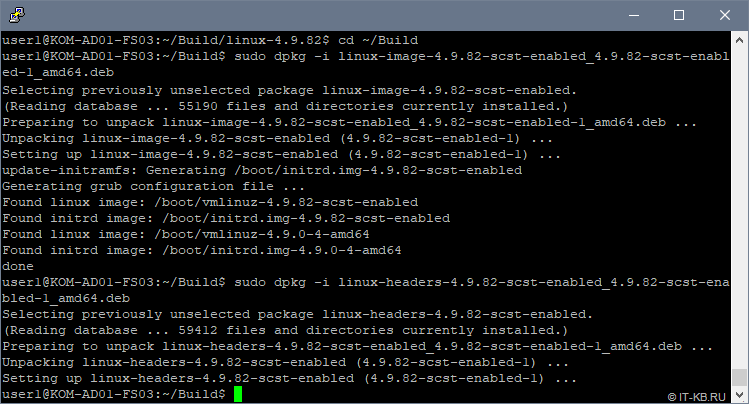

Обновите операционную систему, скачайте с сайта, извлеките из архива, установите пакет QConvergeConsole CLI for Windows и пакет UltraPath for Windows.

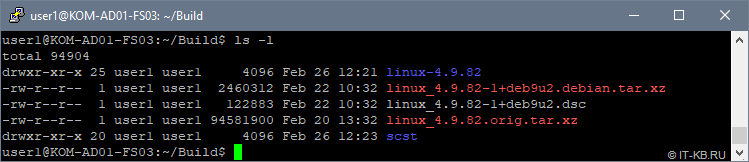

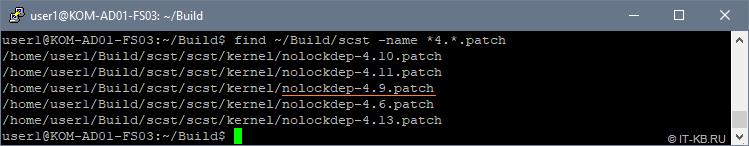

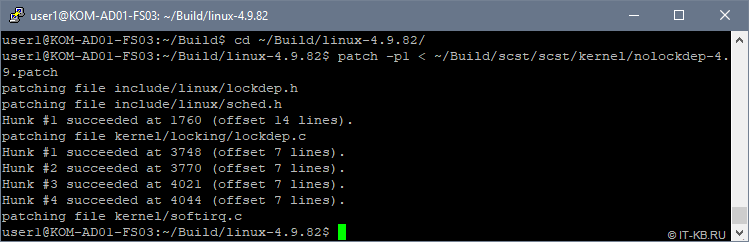

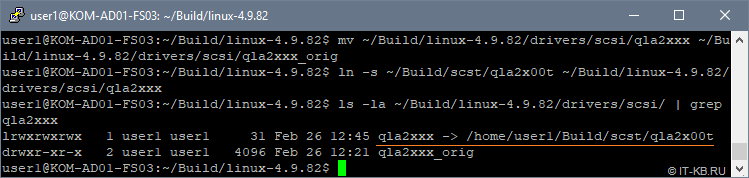

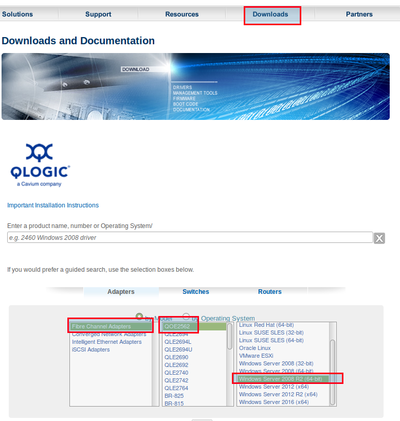

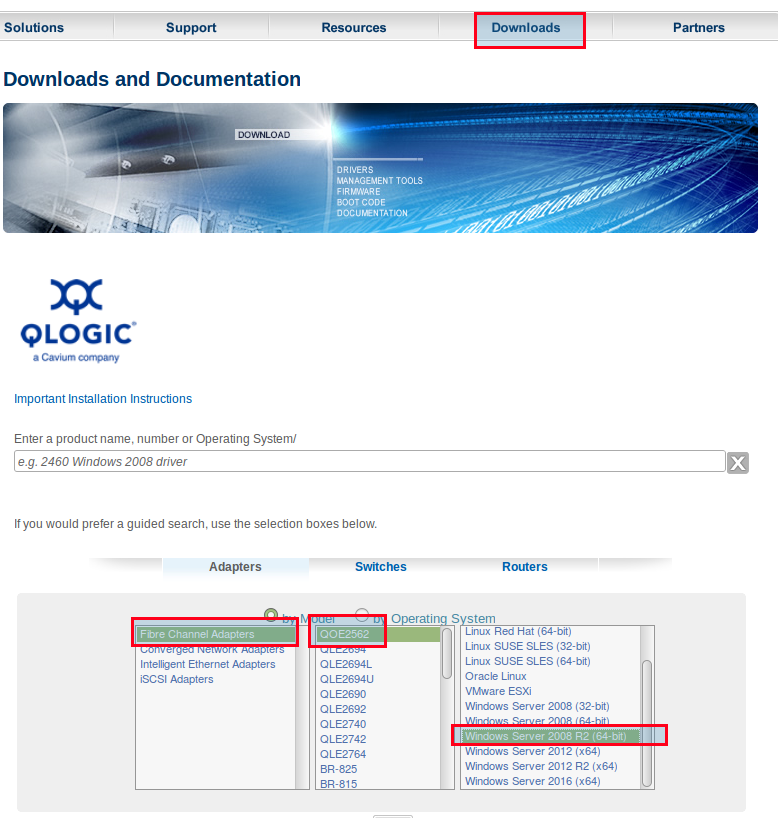

1. Зайти по ссылке на сайт http://driverdownloads.qlogic.com/QLogicDriverDownloads_UI/Defaultnewsearch.aspx, указать операционную систему:

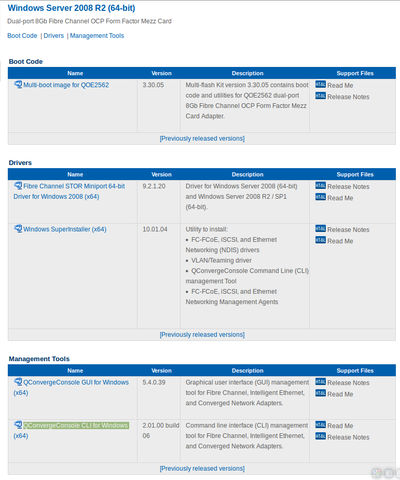

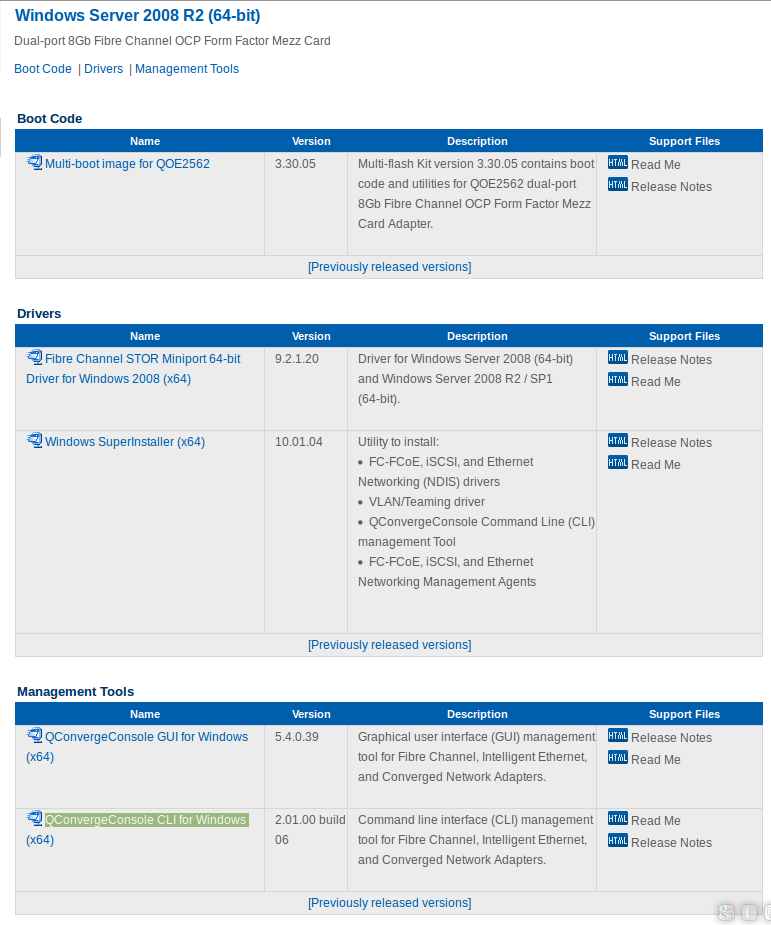

2. Выбрать пакет для загрузки:

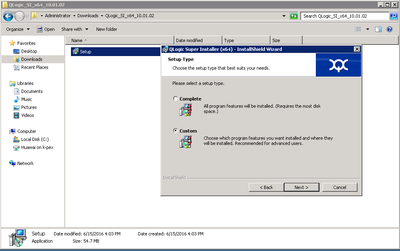

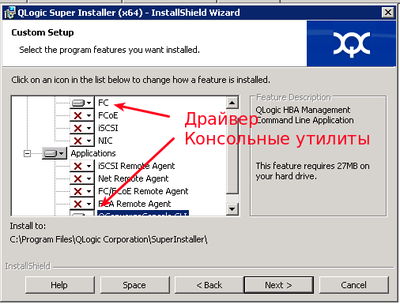

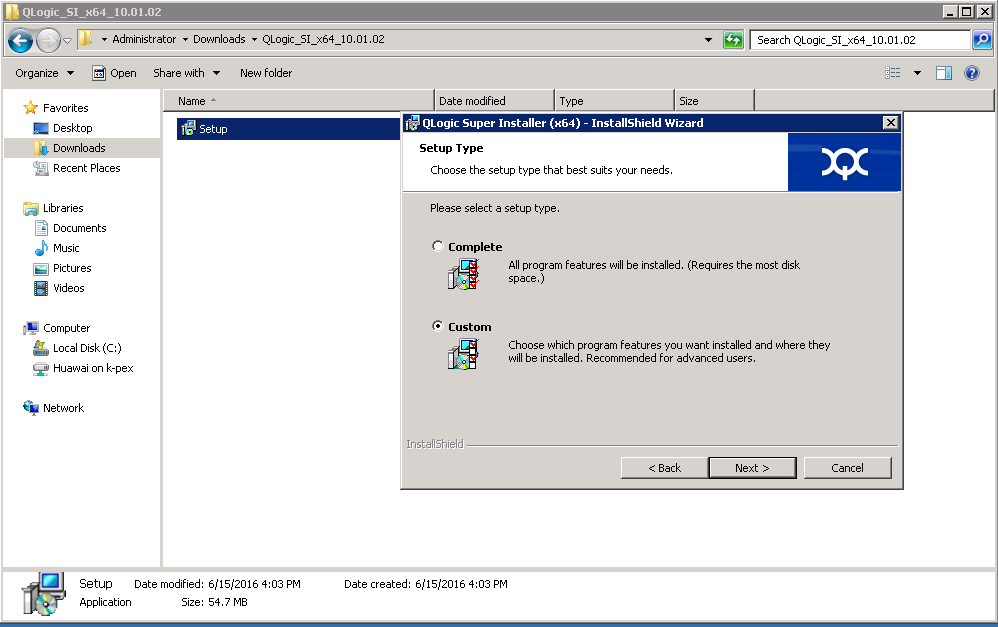

3. Установку пакета выполнять в режиме Custom:

4. Отключить все кроме драйвераFC и консольных утилит QConvergeConsole CLI:

5. Скачать и установить пакет UltraPath for Windows. Ссылку для скачивания последней версии пакета вам должен передать служба технической поддержки.

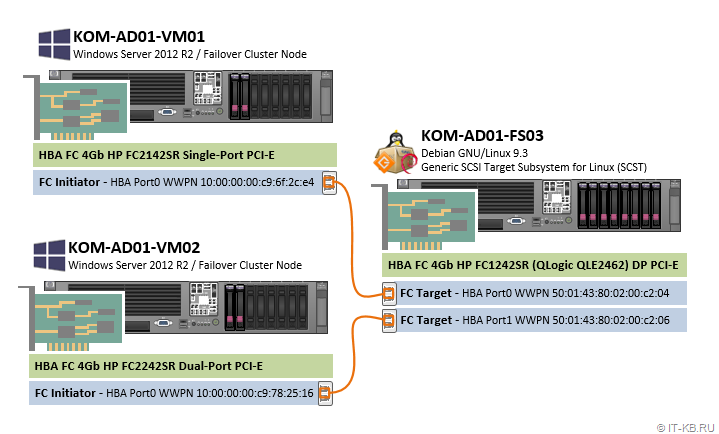

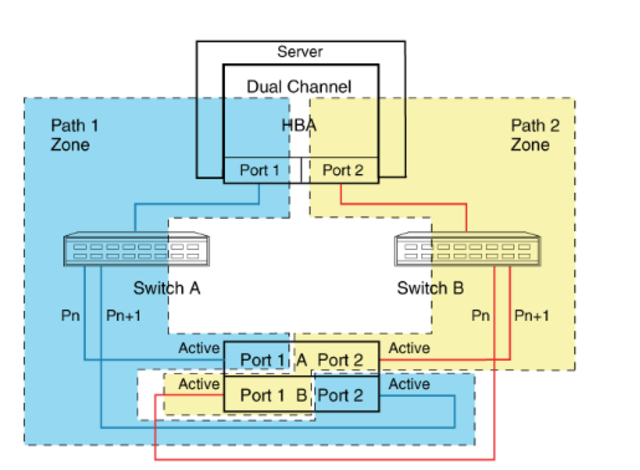

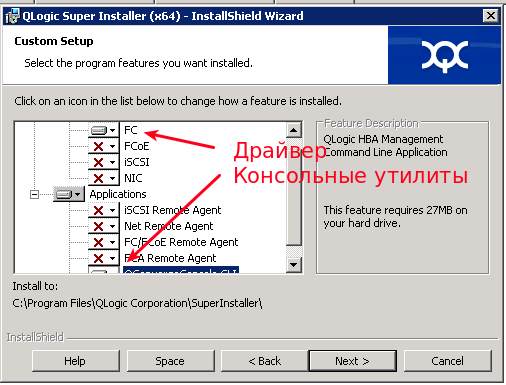

Сервер подключается к СХД по такой схеме:

Использовать много-путевой доступ необходимо даже в том случае если на вашем сервере используется 1 порт.

Иначе, например, в случае обновления прошивки на одном из контроллеров СХД произойдет временное отключение вашего сервера от СХД и данные на вашем LUN могу быть повреждены.

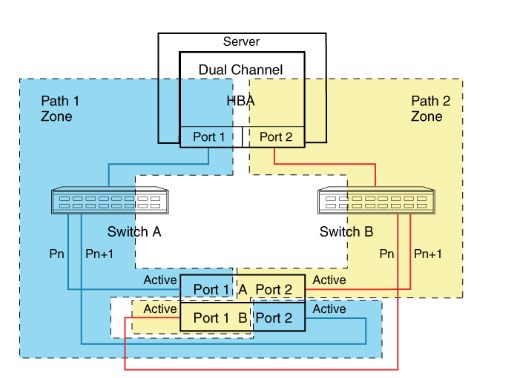

Многопутевой ввод-вывод (Multipath I/O) — технология подключения узлов сети хранения данных с использованием нескольких маршрутов. В случае отказа одного из контроллеров, операционная система будет использовать другой для доступа к устройству. Это повышает отказоустойчивость системы и позволяет распределять нагрузку.

Multipath устройства объединяются в одно устройство с помощью специализированного программного обеспечения в новое устройство. Multipath обеспечивает выбор пути и переключение на новый маршрут при отказе текущего. Это происходит невидимо для программ и процессов использующих это устройство. Кроме того Multipath способен распределять передачу данных по разным путям посредством различных алгоритмов, например:

Без Ultrapath ваша система будет видеть 4 устройства вместо одного.

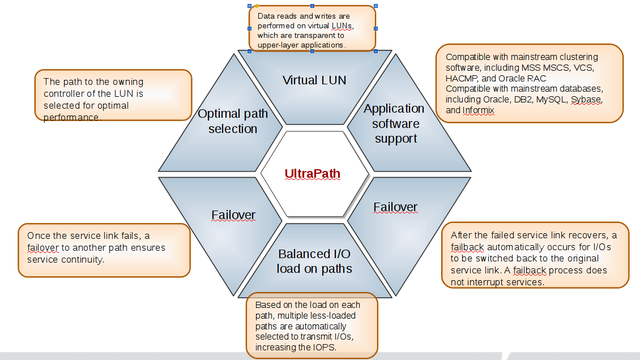

Преимущества Huawei UltraPath

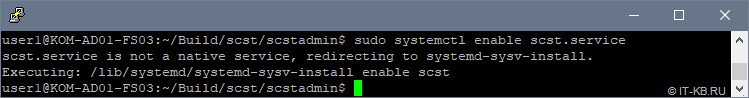

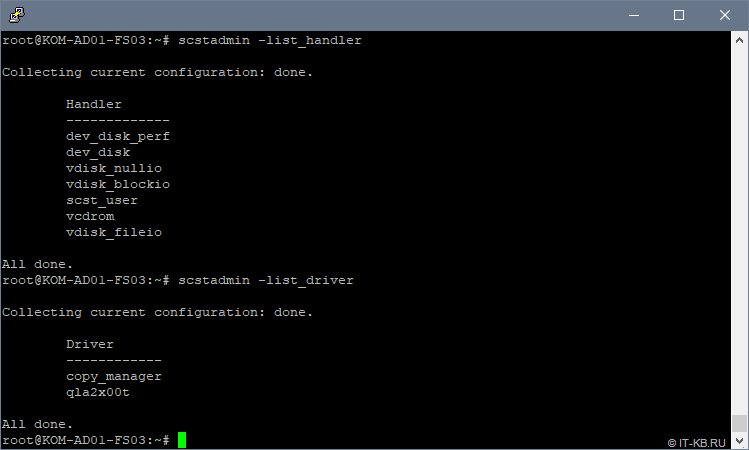

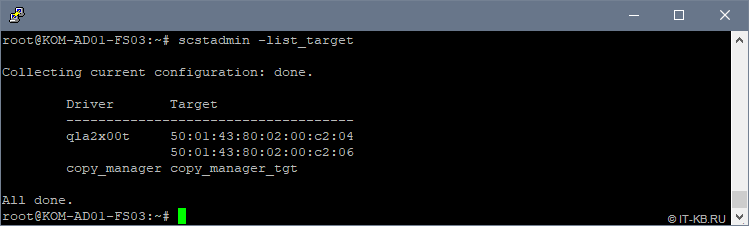

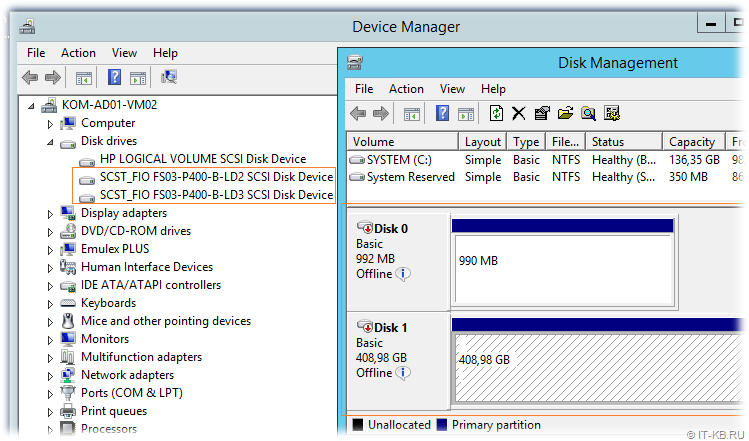

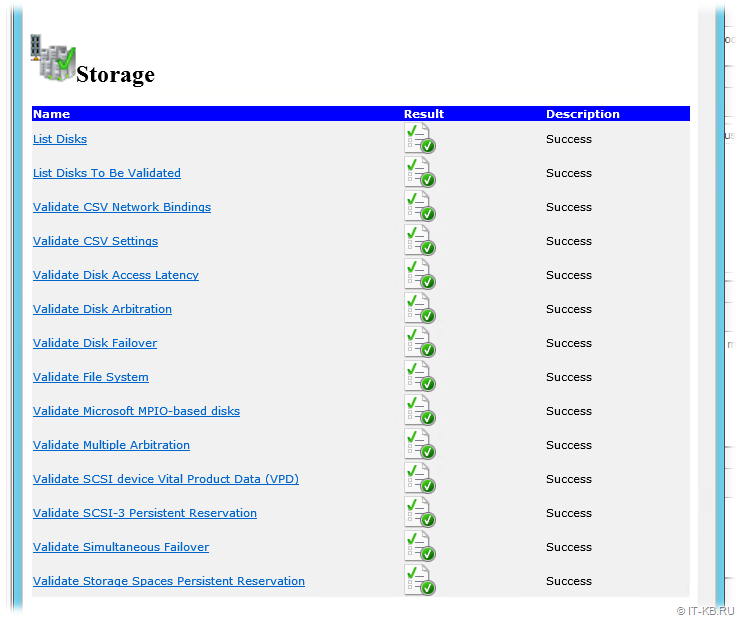

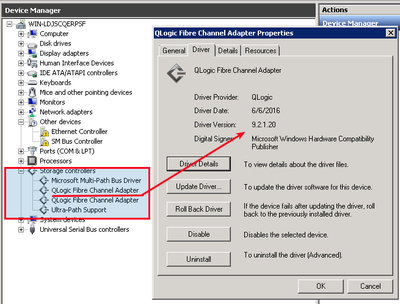

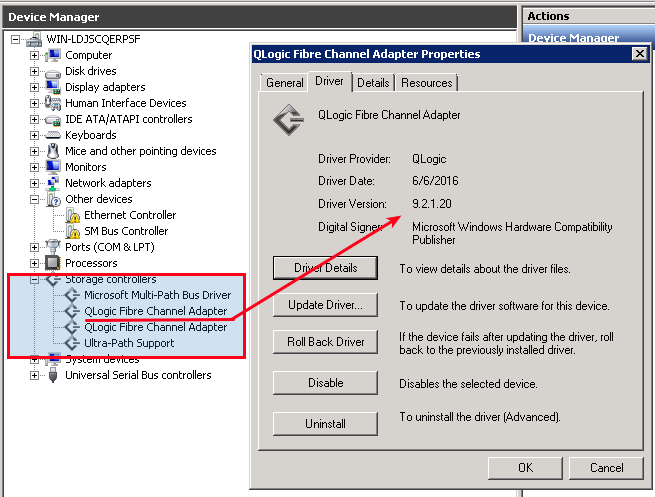

6. После перезагрузки системы в менеджере устройств (Секция Storage Controllers)убедитесь что установлена актуальная версия драйвера Qlogic и Ultra-Path support

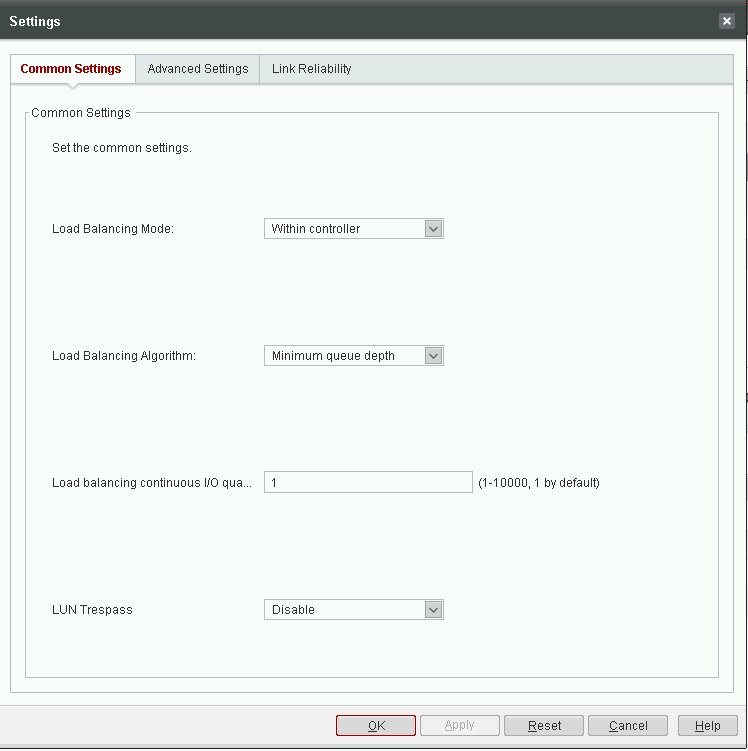

7. Запустить консоль Ultra-Path, зайти в меню System > Global Settings и установить параметры как на этом снимке:

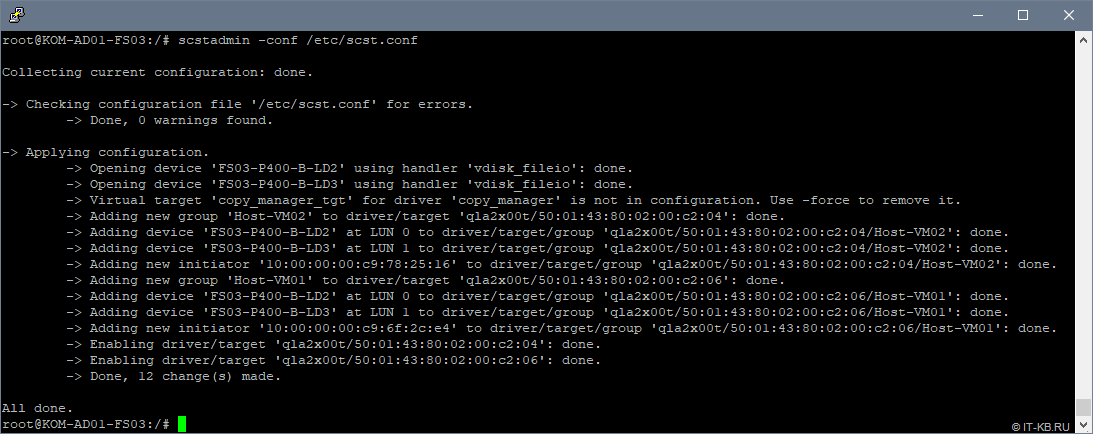

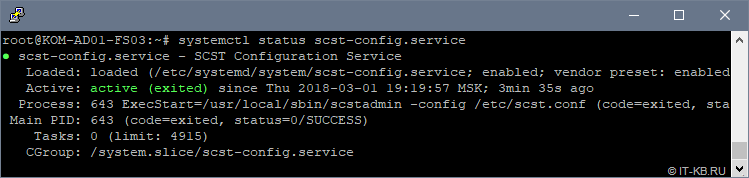

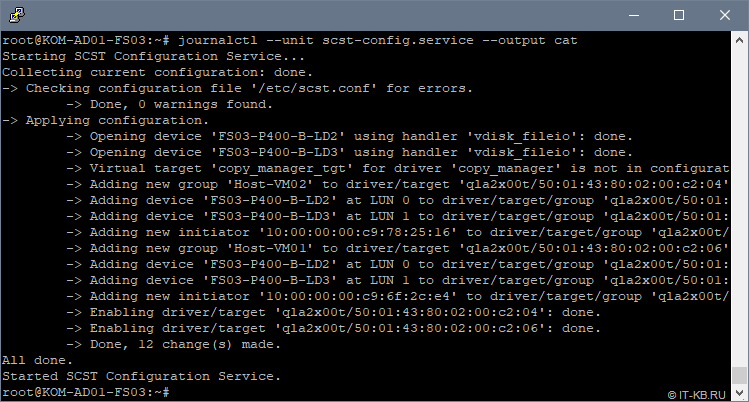

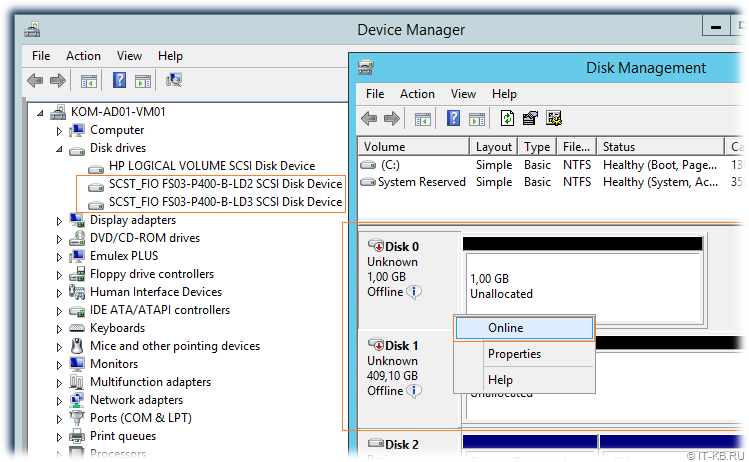

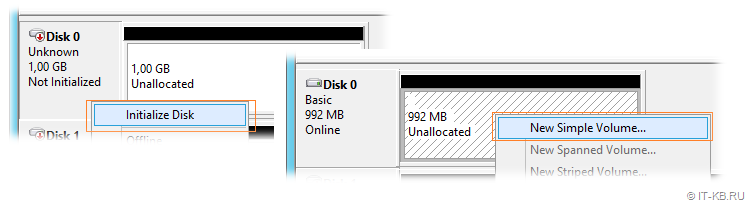

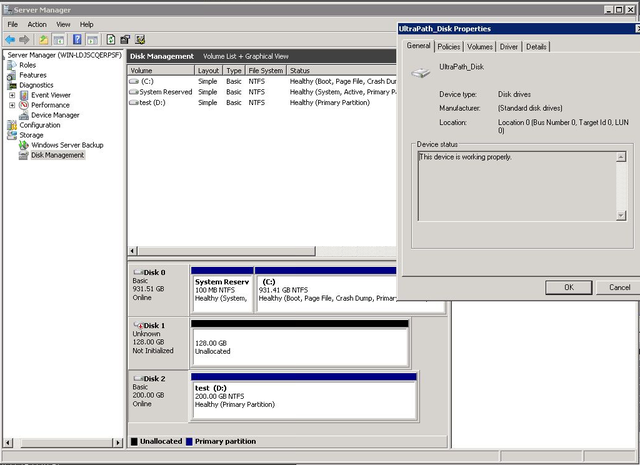

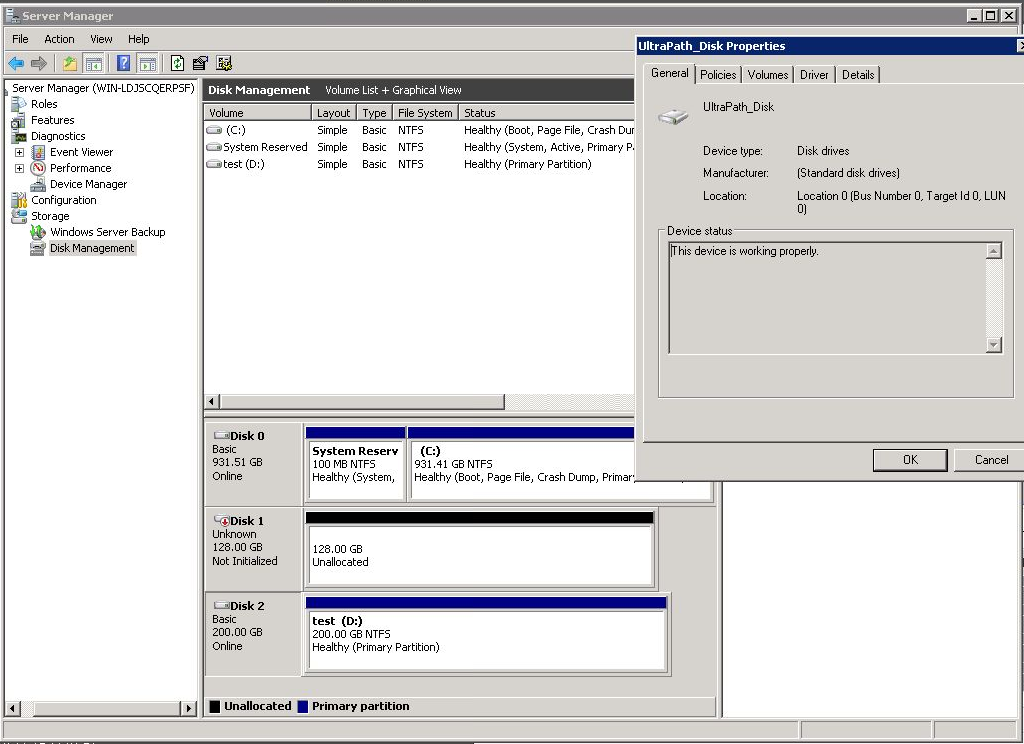

8. Зайдите в менеджер дисков, активируйте диск, создайте раздел с файловой системой.

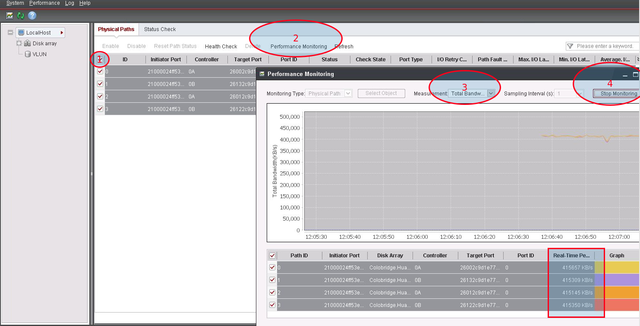

9. В консоли Ultra-Path выберите все пути (1), запустите Performance Monitor (2), выберите тип измерений / measurement (3), запустите мониторинг (4), дайте нагрузку на диск и убедитесь что данные передаются по всем путям.

Содержание

- Подключение Multipath LUN СХД к Windows Server 2008 и Windows Server 2012

- Установка и настройка MPIO в Windows Server 2016/2012R2

- Установка MPIO в Windows Server 2016/2012R2

- Установка MPIO с помощью консоли Server Manager

- Установка MPIO с помощью Powershell

- Настройка MPIO в Windows Server 2016

- SAN Policy

- Подключение СХД Qsan к серверам в среде Windows Server и Hyper-V

- Физическая и логическая коммутация

- Действия на стороне СХД

- Действия на стороне хоста

- Настройка виртуального адаптера Fibre Channel Hyper-V в структуре хранилища VMM

- Перед началом работы

- Развертывание виртуального адаптера Fibre Channel

- Обнаружение и классификация структур Fibre Channel

- Создание виртуальных сетей хранения данных (vSAN) и назначение адаптеров шины

- Создание шаблона виртуальной машины

- Создание зон

- Создание и регистрация LUN

- Создание и развертывание уровня службы

- Дальнейшие действия

- База знаний wiki

- Содержание

- fc подключение к схд сервера под windows

- Задача:

- Решение:

- Многопутевой ввод-вывод (Multipath I/O)

Подключение Multipath LUN СХД к Windows Server 2008 и Windows Server 2012

В предыдущей статье мы рассматривали «Подключение Multipath LUN СХД к VMware ESXi и Debian GNU/Linux». В данной статье продолжаем. Напомню, что используется конфигурация с двумя SAN-свитчами, к каждому из которых, СХД подключена двумя линками.

Подключение Multipath LUN СХД к Windows Server 2012

Multipath Input Output — это система многопутевого подключения блочных устройств. Требуется она для дублирования каналов подключения в целях повышения отказоустойчивости и производительности за счет того, что сервер может обращаться к устройству по нескольким каналам.

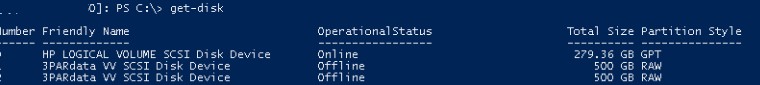

Вот так система видит LUN’ы без поддержки MPIO:

Если MPIO по какой-либо причине отключен, требуется включить. Для этого в «панели мониторинга» выбираем меню «управление» и пункт «добавить роли и компоненты».

В «мастере добавления ролей и компонентов» переходим к пункту «компоненты» и выбираем в списке «Multipath I/O», после чего нажимаем виртуальную кнопку «установить».

После этого переходим в систему управления дисковыми массивами в «диспетчере серверов» и через меню «средства» вызываем диалог MPIO:

На вкладке «Обнаружение многопутевых устройств» видим нужные нам LUN’ы и нажимаем кнопку «добавить».

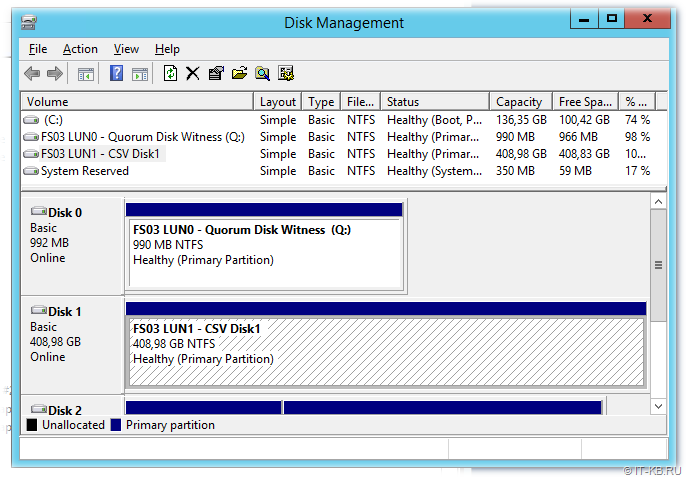

Система предложит перезагрузиться. Соглашаемся. После перезагрузки все LUN’ы доступны как MPIO устройства:

Теперь их требуется подключить к системе, после чего можно создавать тома:

Готово. Теперь созданные тома доступны в системе:

Подключение Multipath LUN СХД к системе Windows Server 2008

Выше мы рассмотрели как подключить LUN к системе Windows Server 2012. В системе Windows Server 2008 процедура несколько отличается.

После загрузки системы, запускаем «Диспетчер сервера»:

В меню «Действие» выбираем пункт «Добавить компоненты»:

В списке активируем переключатель «Многопутевой ввод-вывод» и проходим все этапы установки:

Готово. Теперь нужно активировать распознавание путей. Для этого переходим на «Панель управления» и переключаемся на режим просмотра «Мелкие значки:

Вызываем панель конфигурации „MPIO“:

Где переходим на вкладку „Обнаружение многопутевых устройств“. В списке „Код оборудования“ будут представлены нужные LUN’ы. Нажимаем виртуальную кнопку „Добавить“:

Система предложит перезагрузиться. Соглашаемся:

После перезагрузки в „Диспетчере сервера“ переходим по пунктам „Хранилище“ → „Управление дисками“ и видим LUN’ы как Multipath устройства:

Теперь можно создать тома и подключить к системе:

Готово. Теперь диск доступен в системе. Чтобы убедиться, можно открыть „Мой компьютер“:

Источник

Установка и настройка MPIO в Windows Server 2016/2012R2

В этой статье мы рассмотрим особенности реализации, установки и настройки MPIO в Windows Server 2016/2012 R2. MPIO (Multi—Path Input Output) или многопутевой ввод-вывод, это технология для построения отказоустойчивого транспорта к системе хранения данных (СХД) или выполняющему эти функции серверу за счет использования избыточных путей. Дополнительные пути между сервером и хранилищем создаются с использованием избыточных физических компонентов (коммутаторы, кабели, адаптеры или сетевые карты). Обратная сторона такой избыточности – операционная система может видеть один и тот же LUN по разным путям и считать их разными устройствами.

На следующем скриншоте видно (список подключенных дисков можно вывести с помощью get-disk), что Windows видит без MPIO видит 2 диска по разным путям, которые по факту являются одним LUN:

Если ОС поддерживает MPIO, она будет видеть каждый из презентованных ей дисков в одном экземпляре. При включенном MPIO сервер может обращаться к данным на СХД по нескольким путям, что увеличивает скорость доступа к подключенному LUN и позволяет задействовать для доступа несколько сетевых или HBA-адаптеров.

MPIO может задействовать альтернативный логический путь при выходе из строя одного/нескольких компонентов, заставив операционную систему использовать для доступа к логическому диску (LUN) резервный маршрут, сохраняя непрерывность доступа к данным. Таким образом MPIO является важным компонентом при реализации отказоустойчивой системы доступа к данным, кроме того входящие в состав MPIO модули позволяют распределять нагрузку между различными путями к одному и тому же LUN-у.

Установка MPIO в Windows Server 2016/2012R2

Windows Server поддерживает многопутевой ввод-вывода MPIO начиная с версии Windows Server 2008 R2. Технология Microsoft MPIO позволяет обеспечить высокую доступность и балансировку нагрузки посредством возможности организации нескольких подключений к СХД, не зависит от протоколов и поддерживает подключение дисковых массивов и хранилищ по iSCSI, Fiber Channel и хранилищ SAS.

MPIO-модуль в Windows Server по умолчанию не включен. Установить его в Windows Server 2016 можно двумя способами:

Установка MPIO с помощью консоли Server Manager

Установка MPIO с помощью Powershell

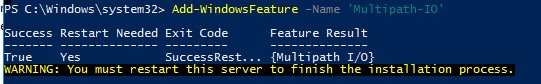

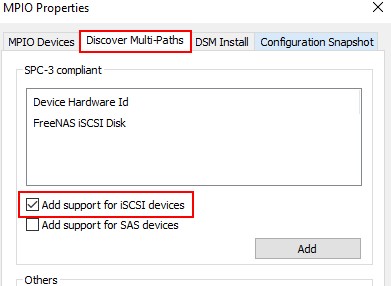

Запустите консоль PowerShell с правами администратора и для установки компонента выполните команду:

Чтобы убедиться, что модуль MPIO установлен в вашем Windows Server, выполните:

Настройка MPIO в Windows Server 2016

После установки MPIO модуля, необходимо активировать его для LUN, которые доступны по нескольким путям. По умолчанию ОС видит каждое подключение к диску как разные логические диски (LUN).

Разрешите модулю DSM от Microsoft (MSDSM) автоматически объединять SAN диски в зависимости от типа подключений. MSDSM автоматически определяет наличие LUN, имеющих несколько путей к СХД и поддерживает большинство популярных систем хранения.

Сделать это можно из командной строки:

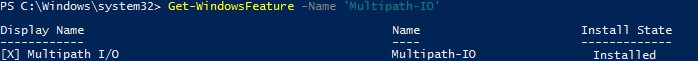

Также вы можете включить DSM через графический интерфейс. Откройте консоль управления Server Manager и в меню Tools выберите пункт MPIO (или выполните команду mpiocpl).

Перейдите на вкладку Discover Multi—Paths, включите опцию Add support for SAS devices (или Add support for iSCSI devices, если вы используете iSCSI хранилище) и нажмите Add. После этого перезагрузите сервер.

После перезагрузки откройте диспетчер устройств или диспетчер дисков и убедитесь, что количество подключенных дисков (LUN), доступных серверу уменьшилось в 2 раза (при наличии подключений к СХД по двум путям).

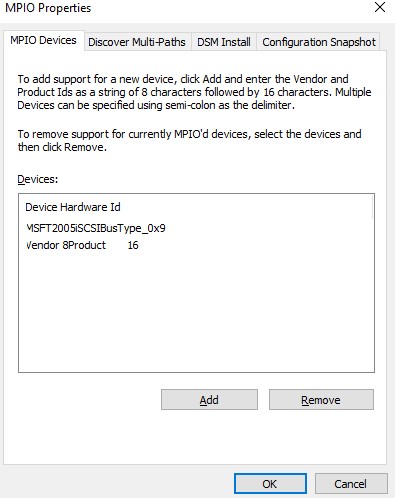

Вы можете управлять списком устройств, для которых включена поддержка MPIO на вкладке MPIO Devices (или командой Get-MSDSMSupportedHw ).

Вы можете добавить новые MPIO устройства, нажав кнопку Add или из PowerShell:

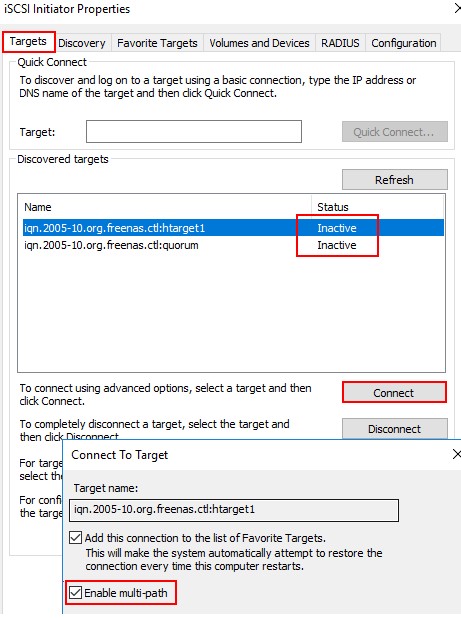

Если вы подключаете iSCSI таргет по 2 путям и хотите использовать MPIO для этого подключения, нужно при подключении Target выбрать iSCSI LUN, нажать кнопку Connect и включить опцию Enable multi—path.

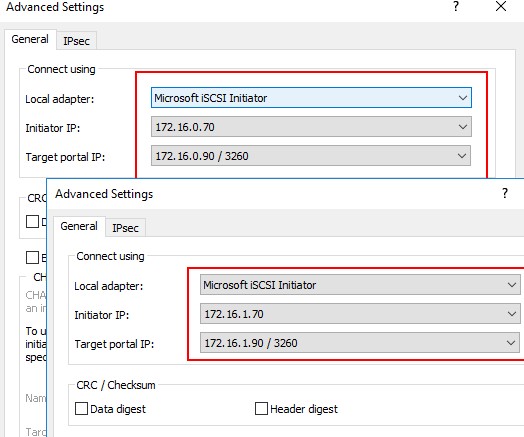

Затем нажмите на кнопку Advanced и привяжите разные IP адреса инициатора к разным IP адресами target.

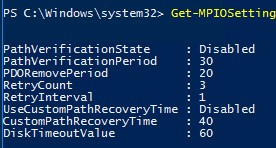

С помощью PowerShell можно получить текущие настройки MPIO:

Можно изменить настройки MPIO таймеров так (например, установим рекомендованные настройки для flash массива):

Доступны следующие политики балансировки MPIO:

Чтобы задать политику балансировки (например, Round Robin):

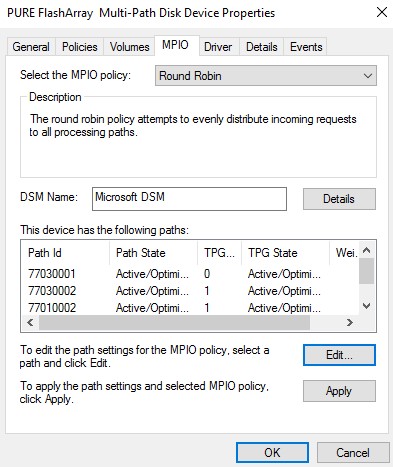

Также политику балансировки можно изменить в свойствах подключенного LUN на вкладке MPIO. В этом примере для массива выбрана политика Round Robin.

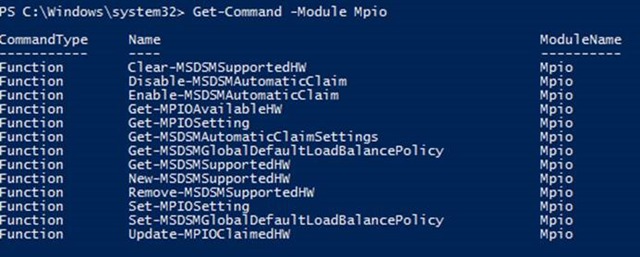

Чтобы увидеть полный список PowerShell команд, доступных в модуле MPIO, выполните команду:

Get-Command –Module Mpio

SAN Policy

В Windows имеется специальная политика дисков (SAN Policy), которая определяет, нужно ли автоматически монтировать диски при их подключении к хосту.

Текущую настройку SAN Policy можно получить с помощью diskpart. По умолчанию используется SAN политика Offline Shared.

Чтобы автоматически монтировать диски, нужно изменить значение SAN Policy на OnlineAll.

Источник

Подключение СХД Qsan к серверам в среде Windows Server и Hyper-V

Мы продолжаем цикл публикаций из серии How To для пользователей СХД Qsan. В данной статье пойдет речь о подключении СХД к серверам на базе Windows Server, в том числе при использовании функционала виртуализации Hyper-V.

В статье мы будем рассматривать подключения СХД Qsan с использованием блочных протоколов доступа iSCSI и Fibre Channel. Сам процесс подключения можно разделить на несколько основных этапов:

В статье приведены скриншоты настройки операционной системы Windows Server 2016/2019 с нелокализованным интерфейсом. Часть описания, не относящаяся напрямую к ОС, взята из нашего предыдущего обзора по настройке ESXi.

Физическая и логическая коммутация

Совокупность оборудования и линий связи между СХД и серверами образуют так называемую SAN сеть. Отказоустойчивое подключение участников SAN сети подразумевает постоянное наличие хотя бы одного пути между инициатором (хост) и таргетом (СХД). Т.к. СХД сейчас практически поголовно имеют минимум два контроллера, каждый сервер должен иметь связь с каждым из них. В простейшем варианте серверы подключаются к СХД напрямую. Такой режим работы называют Direct Attach. СХД Qsan поддерживают такой режим работы. В этом случае каждый сервер должен иметь двухпортовую HBA для соединения с каждым контроллером СХД. Т.е. между сервером и СХД будет 2 пути. При наличии максимального количества опциональных портов в таком режиме к СХД можно подключить до 10 серверов через iSCSI или до 8 серверов через Fibre Channel.

В большинстве случаев серверы соединяются с СХД через коммутаторы. Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

В Windows Server параметр MTU меняется в настройках драйвера адаптера:

Control PanelNetwork and InternetNetwork Connections → Свойства конкретного адаптера → Configure → Advanced → Jumbo Packet (у некоторых адаптеров этот пункт может называться что-то типа Large Packets)

Для получения инструкций по изменению MTU у физических коммутаторов рекомендуем обратиться к документации конкретного производителя.

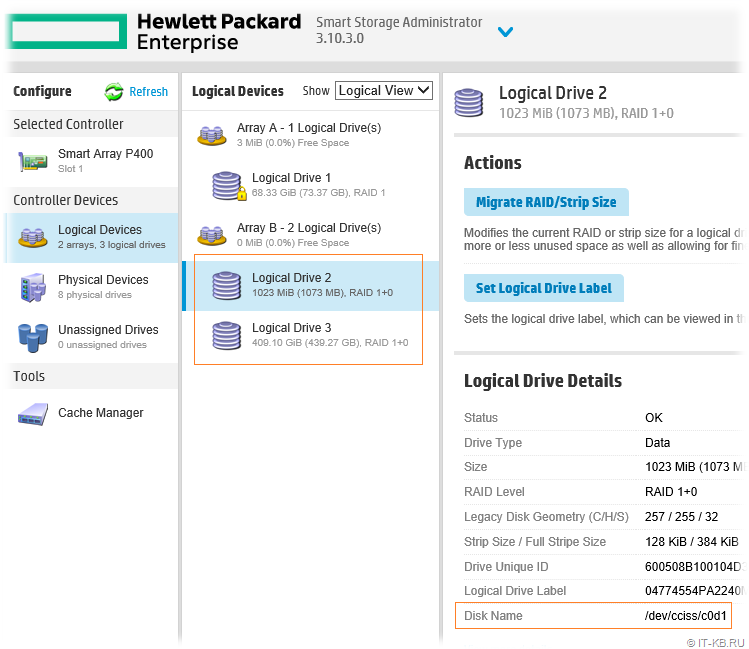

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

Помимо обычных пулов Qsan поддерживает создание AutoTiering пулов при условии активации соответствующей лицензии. С принципом работы таких пулов можно ознакомиться в отдельной статье.

После создания пула(ов) необходимо создать тома (volume): Volumes → Create volumes. Также запустится пошаговый мастер создания тома.

Необходимо задать требуемый размер тома, тип тома выбирается как RAID volume. Рассмотрим их более подробно.

Заключительным этапом в настройке СХД является публикация томов для доступа к ним со стороны хостов через функционал LUN mapping → Map LUN.

Действия на стороне хоста

Первоначально необходимо один раз установить на сервере компонент Multipath IO, который обеспечивает работу многопутевого ввода/вывода. Данное действие производится через стандартный диалог Add Roles and Features

При использовании протокола iSCSI необходимо выполнить:

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN доступный по 4 путям. Как и в случае с iSCSI следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

Важное замечание касательно конфигурирования MPIO. По умолчанию Windows видит дисковые устройства по отдельности, т.е. каждый путь к устройству – это отдельный диск.

Чтобы ОС «склеила» все одинаковые диски в единое устройство, необходимо в стандартной оснастке MPIO добавить новое устройство как многопутевое. Для iSCSI устройств устанавливается отдельное разрешение. По окончании настройки потребуется перезагрузить сервер. Данную настройку необходимо произвести однократно для каждой СХД. После чего все вновь презентованные диски будут опознаваться ОС как многопутевые.

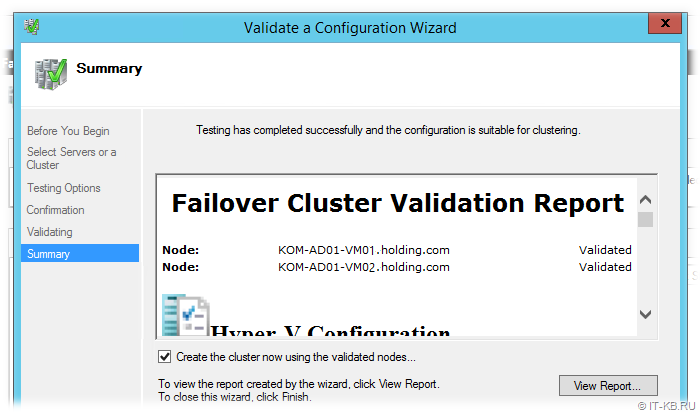

В случае использования кластера из нескольких хостов Windows Server, действия, описанные выше, необходимо повторить на каждом из хостов. После чего диски, появившиеся в системе, можно добавлять в дисковые ресурсы кластера.

В рамках этой статьи были рассмотрены преимущественно базовые операции, необходимые для подключения серверов Windows Server к СХД Qsan. Для получения более полной информации настоятельно рекомендуется ознакомиться с руководствами пользователей, предоставляемыми обоими вендорами.

Источник

Настройка виртуального адаптера Fibre Channel Hyper-V в структуре хранилища VMM

Поддержка этой версии Virtual Machine Manager (VMM) прекращена. Рекомендуем перейти на VMM 2019.

В этой статье описывается настройка виртуального адаптера Fibre Channel Hyper-V в структуре хранилища System Center Virtual Machine Manager (VMM).

Виртуальный адаптер Fibre Channel позволяет виртуальным машинам Hyper-V напрямую подключаться к хранилищу на основе Fibre Channel. Hyper-V предоставляет порты Fibre Channel в операционных системах на виртуальных машинах, что позволяет виртуализировать приложения и рабочие нагрузки, которые имеют зависимости от хранилища Fibre Channel. Кроме того, можно кластеризовать операционные системы на виртуальных машинах по Fibre Channel.

Перед началом работы

Вам потребуется следующее.

Развертывание виртуального адаптера Fibre Channel

Необходимо сделать следующее:

Обнаружение и классификация структур Fibre Channel

Создание виртуальных сетей хранения данных (vSAN) и назначение адаптеров шины

Вы можете создать виртуальные сети хранения данных и назначить для них адаптеры шины. На каждом узле может быть создана одна или несколько виртуальных сетей хранения данных. Каждая виртуальная сеть хранения данных может содержать только адаптеры шины, принадлежащие одной и той же структуре.

Виртуальные адаптеры шины, представляющие виртуализацию адаптеров шины Fibre Channel, используются виртуальными машинами для подключения к виртуальным сетям хранения данных. Каждый виртуальный адаптер шины имеет имя узла в Интернете (WWNN), отличающееся от WWNN адаптера шины узла. С помощью NPIV адаптер шины главного компьютера можно сопоставить с несколькими виртуальными адаптерами шины. Порты адаптеров шины, назначенные виртуальной сети хранения данных, при необходимости могут добавляться или удаляться.

Создание шаблона виртуальной машины

Виртуальные адаптеры шины используются виртуальными машинами для подключения к виртуальным сетям хранения данных. Чтобы подключить виртуальные адаптеры шины к виртуальным сетям хранения данных, сначала необходимо их добавить в профиль оборудования шаблона виртуальной машины.

После развертывания виртуальной машины в узле можно соотнести зоны массива хранения данных виртуального адаптера Fibre Channel с виртуальной машиной. Затем необходимо создать LUN и зарегистрировать его (снять маску) на виртуальной машине.

Создание зон

Зоны используются для подключения массива Fibre Channel к узлу или виртуальной машине. Целевые порты массива хранения данных сопоставляются с портами адаптеры шины на узле или портами виртуального адаптера шины на виртуальной машине. Вы можете создать зоны для узла, виртуальной машины или их обоих. Для отказоустойчивых кластеров Hyper-V зона необходима для каждого узла в кластере. Обратите внимание на следующее.

Настройте зоны следующим образом.

Создание и регистрация LUN

Для доступа к ресурсам массивов хранения данных узла, виртуальной машины или уровня службы узла на них должны быть созданы и зарегистрированы (сняты маски) номера LUN.

Создание и развертывание уровня службы

Дальнейшие действия

Настройте хранилище для узлов и кластеров Hyper-V.

Источник

База знаний wiki

Продукты

Статьи

Содержание

fc подключение к схд сервера под windows

Задача:

Как подключиться к LUN выделенному на системе хранения

Решение:

Обновите операционную систему, скачайте с сайта, извлеките из архива, установите пакет QConvergeConsole CLI for Windows и пакет UltraPath for Windows.

2. Выбрать пакет для загрузки:

3. Установку пакета выполнять в режиме Custom:

4. Отключить все кроме драйвераFC и консольных утилит QConvergeConsole CLI:

5. Скачать и установить пакет UltraPath for Windows. Ссылку для скачивания последней версии пакета вам должен передать служба технической поддержки.

Сервер подключается к СХД по такой схеме:

Многопутевой ввод-вывод (Multipath I/O)

Использовать много-путевой доступ необходимо даже в том случае если на вашем сервере используется 1 порт.

Иначе, например, в случае обновления прошивки на одном из контроллеров СХД произойдет временное отключение вашего сервера от СХД и данные на вашем LUN могу быть повреждены.

Многопутевой ввод-вывод (Multipath I/O) — технология подключения узлов сети хранения данных с использованием нескольких маршрутов. В случае отказа одного из контроллеров, операционная система будет использовать другой для доступа к устройству. Это повышает отказоустойчивость системы и позволяет распределять нагрузку.

Multipath устройства объединяются в одно устройство с помощью специализированного программного обеспечения в новое устройство. Multipath обеспечивает выбор пути и переключение на новый маршрут при отказе текущего. Это происходит невидимо для программ и процессов использующих это устройство. Кроме того Multipath способен распределять передачу данных по разным путям посредством различных алгоритмов, например:

Без Ultrapath ваша система будет видеть 4 устройства вместо одного.

Преимущества Huawei UltraPath

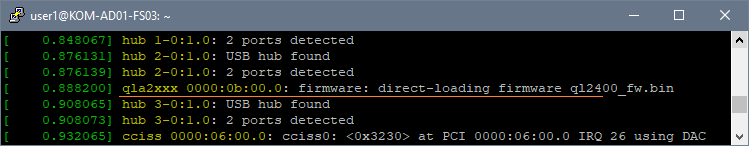

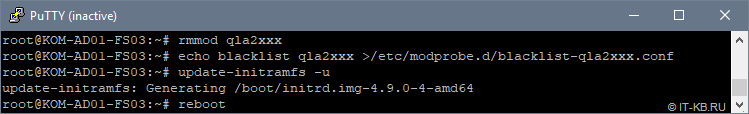

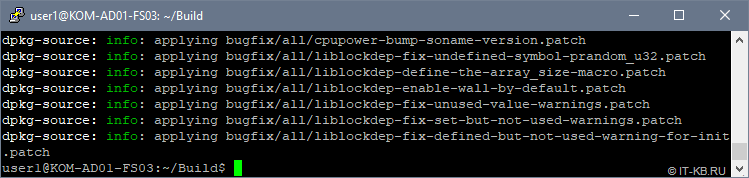

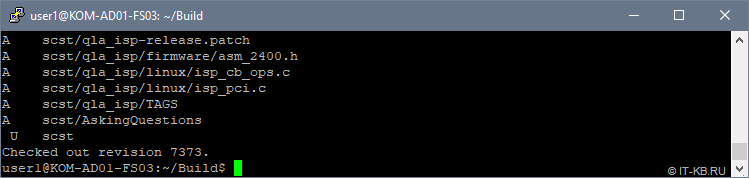

6. После перезагрузки системы в менеджере устройств (Секция Storage Controllers)убедитесь что установлена актуальная версия драйвера Qlogic и Ultra-Path support

7. Запустить консоль Ultra-Path, зайти в меню System > Global Settings и установить параметры как на этом снимке:

8. Зайдите в менеджер дисков, активируйте диск, создайте раздел с файловой системой.

9. В консоли Ultra-Path выберите все пути (1), запустите Performance Monitor (2), выберите тип измерений / measurement (3), запустите мониторинг (4), дайте нагрузку на диск и убедитесь что данные передаются по всем путям.

Источник

SANsurfer FC HBA CLI

User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

Information furnished in this manual is believed to be accurate and reliable. However, QLogic Corporation assumes no responsibility for its use, nor for any infringements of patents or other rights of third parties which may result from its use. QLogic Corporation reserves the right to change product specifications at any time without notice. Applications described in this document for any of these products are for illustrative purposes only. QLogic Corporation makes no representation nor warranty that such applications are suitable for the specified use without further testing or modification. QLogic Corporation assumes no responsibility for any errors that may appear in this document.

Apple, Finder, Mac OS, Macintosh, and Power Mac registered trademarks, and Safari is a trademark of Apple, Inc., registered in the U.S. and other countries.

EMC is a registered trademark of EMC Corporation.

Intel and Pentium are trademarks of Intel Corporation in the U.S. and other countries. Linux is a registered trademark of Linus Torvalds.

Microsoft, Windows, Windows NT operating system, Windows 2000 operating system, Windows Server 2003 operating system, Windows XP Professional operating system, and Windows Vista operating system are registered trademarks of Microsoft Corporation in the United States and other countries.

Novell and NetWare are registered trademarks of Novell, Inc.

IBM and PowerPC are registered trademarks of International Business Machines Corporation in the United States, other countries, or both.

QLogic, the QLogic logo, QLA, and SANsurfer are registered trademarks of QLogic Corporation. Red Hat and all Red Hat-based are trademarks or registered trademarks of Red Hat, Inc.

Solaris is a registered trademark of Sun Microsystems, Inc., in the United States and other countries

SPARC is a registered trademark of SPARC International, Inc. Products bearing SPARC trademarks are based on an architecture developed by Sun Microsystems, Inc.

StuffIt is a registered trademark of Smith Micro Software, Inc. SuSE is a registered trademark of SuSE Linux AG.

VMware is a registered trademark of VMware, Inc. in the United States and/or other jurisdictions.

All other brand and product names are trademarks or registered trademarks of their respective owners.

Document Revision History

Revision A, August 20, 2004

Revision B, September 28, 2005

Revision C, June 7, 2006

Revision D, October 1, 2006

Revision E, February 1, 2007

Revision F, February 2008

|

Changes |

Sections Affected |

|

Revision F Changes: |

|

|

Changed NVRAM to HBA Parameters. |

All |

|

Changed Option ROM to Flash. |

All |

© 2004–2008 QLogic Corporation. All Rights Reserved Worldwide.

First Published: March 2004

QLogic Corporation, 26650 Aliso Viejo Parkway, Aliso Viejo, CA 92656, (800) 662-4471 or (949) 389-6000

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

Changed HBA No. to HBA Instance. |

All |

||

|

Changed SFF DMI to HBA transceiver details. |

All |

||

|

Updated supported QLogic HBA list. |

Section 1.3 |

||

|

Updated supported operating system list. |

Section 1.4 |

||

|

All non-interactive information moved from |

Section 4, Section 5 |

||

|

Section 4 to Section 5. |

|||

|

Command line options put in alphabetical order. |

Table 2-1, Section 4 |

||

|

Added Appendix B: XML Format 2. |

Appendix B |

||

|

Added port virtualization (NPIV) information. |

Section 4.14, Section 5.3.33 |

||

|

Added support for Red Hat Linux REL 5.1. |

Section 3.2.2 |

||

|

Removed installation/uninstallation instructions for |

Section 3.2.3 |

||

|

Solaris SPARC 6 and 7. |

|||

|

Added NPIV information. |

Section 4.14.1 |

||

|

Added OS LUN Name (Solaris and Linux). |

Section 4.4 |

||

|

Added guide overview section, including a descrip- |

Section 1.2 |

||

|

tion of what’s in the guide and documentation con- |

|||

|

ventions used. |

|||

|

Added interactive mode exit codes listing. |

Appendix C |

||

|

Moved tables other than help commands from |

Section 4 |

||

|

Help Commands appendix to appropriate interac- |

|||

|

tive commands sections. |

|||

|

Expanded iiDMA settings information. |

Section 4.5 |

||

|

Added Virtual Menu information. |

Section 4.14 |

||

|

Expanded HBA parameter templates information. |

Section 4.10.5 |

||

|

Expanded diagnostic testing information. |

Section 4.12 |

||

|

Revision E Changes: |

|||

|

Expanded product description. |

Section 1.1 |

||

|

Split supported HBAs and operating systems into |

Section 1.3, Section 1.4 |

||

|

two sections. Updated list of supported operating |

|||

|

systems. |

|||

|

Added system requirements section. |

Section 1.5 |

||

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

Changed bullets describing interactive and non-interactive modes.

Clarified the note about starting SANsurfer FC HBA CLI on a Solaris console serial port.

Added Macintosh column to Table 2-1.

Added support for Linux IOCTL module driver and driver on the OS installation CD (inbox driver).

Split Windows command line installation into two sections (standard and silent). Changed installation instructions. Added new parameters to command line for silent installation.

Split Solaris installation and uninstallation into three sections:

Solaris SPARC 6 and 7

Solaris SPARC 8, 9, 10 Solaris x86 8, 9, 10

Added Mac OS X command line installation instructions.

In Windows uninstall (standard), added how to invoke the exe package and remove the installed features.

In Windows uninstall (command line), changed the uninstall directions.

Added Mac OS X instructions to manually uninstall the package.

Replaced node name, port name, WWPN, and WWNN with variables (xx) in screen shots for security purposes.

Added a note to Display LUN List and Selective LUNs sections defining the maximum number of LUNs supported by the Solaris QLA and QLC drivers.

Added text to the Target Persistent Binding section defining the number of targets and the range of target IDs for Solaris, which is based in the HBA type.

Changed Boot Device Selection to Boot Device

Settings.

Section 2.2, Section 2.3

Section 2.2

Section 2.3

Section 3, Section 4, Section 5

Section 3.2.1.2

(These Solaris versions no longer supported.) Section 3.2.3.1, Section 3.3.3.1

Section 3.2.3.2, Section 3.3.3.2

Section 3.2.4.2

Section 3.3.1.1

Section 3.3.1.2

Section 3.3.4

Section 4

Section 4.7

Section 4.6, Section 4.6.2

Section 4.8

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

Expanded Save/Update Flash section to list which |

Section 4.10 |

||

|

OSs and HBAs save/update flash, BIOS, or the |

|||

|

option ROM image. |

|||

|

Added description and preparation instructions for |

Section 4.12.1.1, Section 4.12.2 |

||

|

loopback and read/write buffer tests. Added |

|||

|

description of these test results. |

|||

The following options and commands were added in Rev. E:

|

Host Topology (command line option -tp) |

Section 4.1.2, Section 5.3.31 |

|

|

HBA Alias (command line option -ha) |

Section 4.2.1.2, Section 5.3.14 |

|

|

HBA Port Alias (command line option -pa) |

Section 4.2.1.3, Section 5.3.25 |

|

|

SFF DMI (command line option -dm) |

Section 4.12, Section 5.3.5 |

|

|

The following options and commands were changed in Rev. E: |

||

|

Host Information (command line option -g): |

Section 4.2.1 |

|

|

removed QLogic direct driver version from the list |

||

|

of displayed information. |

||

|

For Host Configuration (command line option -z), |

Section 4.2 |

|

|

made the following changes to the list of displayed |

||

|

information: |

||

|

Added VPD information to display HBA information |

||

|

(command line option -I). |

||

|

Added view driver settings (command line option |

||

|

-fg). |

||

|

Removed run loopback test (command line option |

||

|

-kl). |

||

|

Removed run read/write test (command line option |

||

|

-kr). |

||

|

Removed display and change HBA statistics (com- |

||

|

mand line option -gs). |

||

|

Removed display and change link status (com- |

||

|

mand line option -ls). |

||

|

Also changed the list order to reflect the order in |

||

|

which the commands are displayed. |

||

|

Show HBA Information (command line option -i): |

Section 4.2, Section 4.3.1 |

|

|

Added HBA Alias and Port Alias to list of shown |

||

|

information. |

||

|

Changed PCI bus number to PCI device number. |

||

|

Show Device List (command line option -t): added |

4.5, 4.4.1 |

|

|

Serial Number to the list of displayed information. |

||

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

|

Configure HBA Settings (-n): added option to |

4.7.1, Section 5.3.22 |

|

|

restore the BIOS (QLA/QLE/QEM24xx HBAs). |

||

|

Selective LUNs (command line option -m): added |

4.8.1.2, Section 5.3.21 |

|

|

ALL option to command line to view all selective |

||

|

LUNs for all HBA ports. |

||

|

Set Boot Device (-e): removed references to OSs |

4.9.2.1.1 |

|

|

from the third paragraph; this command now |

||

|

applies to all OSs. |

||

|

Diagnostics (command line options -kl and -dr): |

4.17.1.2.1, 5.3.17 |

|

|

DataPattern (DP) parameter: added CRPAT, |

||

|

CSPAT, and CJTPAT. |

4.17.1.2.2, Table 5-5 |

|

|

DataSize (DS) parameter: added 128-byte value |

||

|

for read/write buffer test. Added 128, 256, 512, |

||

|

1024, 2048, 4096, 8192, 16384, 32768, 65535 |

||

|

byte values for loopback test. Added default val- |

||

|

ues. |

4.17.1.2.3, Table 5-5 |

|

|

TestCount (TC) parameter: changed the number of |

||

|

loopback tests that can be run from 0–10000 to |

||

|

0–65535. |

||

|

TestIncrement (TI) parameter: increased test incre- |

4.17.1.2.4, Table 5-5 |

|

|

ment for the loopback test from 1–10000 to |

||

|

1–65535. |

||

|

Output in XML Format (command line option -x): |

Section 5.3.34 |

|

|

Added XML format for HBA alias (command line |

Section 5.3.14 |

|

|

option -ha). |

Section 5.3.25 |

|

|

Added XML format for HBA port alias (command |

||

|

line option -pa). |

Section 5.3.5 |

|

|

Added XML format for SFF DMI (command line |

||

|

option -dm). |

Section 5.3.31 |

|

|

Added XML format for host topology (command |

||

|

line option -tp). |

||

|

Target Persistent Binding (command line option |

Section 5.3.24 |

|

|

-p): added ALL parameter to show target persistent |

||

|

binding information for all HBA ports. |

||

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

Revision D Changes: |

|||

|

Operating systems supported: |

All |

||

|

Windows 2003 Server™ and Enterprise Server: |

|||

|

added x64; removed IEM64T and AMD64. Added |

|||

|

Windows® XP. |

|||

|

Red Hat™ Linux® AS: added x86_64; removed |

|||

|

IEM64T and AMD64. |

|||

|

SuSE® Linux Enterprise Server (SLES) 8 and 9: |

|||

|

added x86_64; removed IEM64T and AMD64. |

|||

|

Removed Power PC (PPC) SLES 8 and 9. |

|||

|

Solaris® SPARC®: removed v2.7; added version 7. |

|||

|

Solaris: removed 9 x86 and 10 x86; added x86, |

|||

|

v2.9, 10. |

|||

|

Removed the sentence “SANsurfer FC HBA CLI |

Section 1 |

||

|

does not provide any features that require a GUI.” |

|||

|

Added QEM2462 and QLA/QLE2xx to list of sup- |

Section 1 |

||

|

ported HBAs. |

|||

|

Changed standard (GUI) install instructions for |

3.1.1.1 |

||

|

Windows operating systems. |

|||

|

Changed package name version to xx, which indi- |

3.1.1.2, 3.1.3.1, 3.12.3.3 |

||

|

cates the current version of SANsurfer FC HBA |

|||

|

CLI. |

|||

|

Changed step 1 of the Mac OX installation proce- |

3.1.4 |

||

|

dure. Removed the steps to create the root user, |

|||

|

log out of the current user account, and log into the |

|||

|

root user (previously steps 2, 3, 4). |

|||

|

Changed WWPN in example text to generic xx for |

Section 4 |

||

|

consistency. |

|||

|

Changed name of Show System Information sub- |

4.2.1, 4.2.2, 4.2.4, 4.2.5 |

||

|

menus. |

|||

|

Changed name of Boot Device to Boot Device |

4.10 |

||

|

Selection in interactive mode. |

|||

|

HBA Parameters (Table 4-2, Table 6-12): |

4.6.1.2, Table 5-9 |

||

|

Changed value of ResetDelay, ExecutionThrottle, |

|||

|

and LinkDownTimeOut parameters. Added |

|||

|

(QLA/QLE23xx HBAs) quantifier to EnableEx- |

|||

|

tended Logging and EnableLIPFullLogin parame- |

|||

|

ters. |

|||

|

Added a list of valid data patterns for the DataPat- |

4.17.1.2.1, Table 5-6 |

||

|

tern diagnostic parameter (Table 4-4, Table 5-6). |

|||

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

The following options and commands were changed in Rev. D:

|

Interactive mode commands: Changed instructions |

||

|

and the example text to new port sorting and num- |

||

|

bering scheme. No change to command function. |

||

|

Non-interactive mode commands: Changed the |

||

|

HBA Port No. parameter to HBA No. parameter |

||

|

to support new port sorting and numbering |

||

|

scheme. No change to command function. |

||

|

Display HBA Settings (-c) |

4.3, 5.3.3 |

|

|

DisplayHBA Information (-i) |

4.4, 5.3.1 |

|

|

Display Device List (-t) |

5 4.5, 5 |

|

|

Display LUN List (-l) |

4.6, 5 |

|

|

Configure HBA Settings (-n) |

4.7, 5 |

|

|

Target Persistent Binding (-p) |

4.8, 5 |

|

|

Selective LUNs (-m) |

4.9, 5 |

|

|

Boot Device Selection (-e) |

4.10, 5 |

|

|

Driver Settings (-fs) |

4.11, 5 |

|

|

View Driver Settings (-fg) |

4.12, 5 |

|

|

Save/Update Flash (-b) |

4.12, 5 |

|

|

Save/Update NVRAM (-r) |

4.11, 5 |

|

|

Flash HBA Beacon (-a and -tb) |

4.16, 5 |

|

|

Diagnostics (-kl and -kr) |

4.17, 5 |

|

|

Statistics (-gs and -ls) |

4.18, 5 |

|

|

Host Information (-g): |

4.2.1, 4.2.4 |

|

|

Quantified that the direct driver version is only |

||

|

displayed in Windows. No longer shows firm- |

||

|

ware version. Shows new HBA number (HBA 0–n) |

||

|

Display HBA Information (-I). |

4.4, 5.4.8 |

|

|

The following new general information shows: |

||

|

HBA instance, HBA ID, OptionROM BIOS version, |

||

|

OptionROM FCode version, OptionROM EFI ver- |

||

|

sion, OptionROM firmware version, total number of |

||

|

devices. |

||

|

The following general information has been |

||

|

removed: |

Device target count |

|

|

The following VPD information has been removed: |

||

|

Asset tag |

End tag |

|

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

Display LUN List (-l): |

4.6 |

|||

|

In interactive mode, added target type to infor- |

||||

|

mation displayed. |

||||

|

Removed asset tag and end tag from list of |

||||

|

VPD information. |

||||

|

In example text, changed the first two option |

||||

|

names of the Selective LUN(s) Display Configura- |

||||

|

tion menu. |

||||

|

In example text, changed the first two option |

||||

|

names of the Selective LUN(s) Configuration — |

||||

|

HBA/Device menu. |

||||

|

Boot Device Selection (-eE): In interactive mode, |

4.10, 5.3.6 |

|||

|

added new HBA Boot Device menu to example |

||||

|

text. |

||||

|

Target Persistent Binding (-p): |

4.8, 5.9 |

|||

|

In interactive mode, changed first two option |

||||

|

names of Target Persistent Binding menu in the |

||||

|

example text. |

||||

|

Driver Settings (-fs): Changed from bind By |

4.11 |

|||

|

WWPN to bind by Port ID. |

||||

|

Save/Update Flash (-b): |

4.12, 5.3.2 |

|||

|

In interactive mode, removed secondary subti- |

||||

|

tles of Option ROM Update menu in the example |

||||

|

text. |

||||

|

In non-interactive mode, added new all |

||||

|

parameter following the boot parameter. |

||||

|

Save/Update NVRAM (-r): In interactive mode, |

4.11 |

|||

|

removed the secondary subtitles of the NVRAM |

||||

|

Update Menu in the example text. |

||||

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

Notes

S

Table of Contents

|

Section 1 |

Introduction |

||

|

1.1 |

Product Overview . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-1 |

|

|

1.2 |

Guide Overview . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-1 |

|

|

1.2.1 |

How this Guide is Organized. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-1 |

|

|

1.2.2 |

Documentation Conventions . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-2 |

|

|

1.3 |

Supported QLogic HBAs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-4 |

|

|

1.4 |

Supported Operating Systems . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-4 |

|

|

1.5 |

System Requirements . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-5 |

|

|

1.5.1 |

Hardware Requirements . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-5 |

|

|

1.5.2 |

Software Requirements . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-6 |

|

|

1.5.2.1 |

Unsupported Features . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-6 |

|

|

1.6 |

Technical Support. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-7 |

|

|

1.6.1 |

Availability . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-8 |

|

|

1.6.2 |

Training . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-8 |

|

|

1.7 |

Contact Information . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

1-8 |

|

Section 2 |

Getting Started |

|

|

2.1 |

Introduction. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

2-1 |

|

2.2 |

Starting Interactive Mode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

2-1 |

|

2.3 |

Starting Non-interactive Mode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

2-3 |

|

2.4 |

Terminology . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

2-6 |

|

Section 3 |

Initial Installation |

||

|

3.1 |

Downloading the Installation Package . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-1 |

|

|

3.2 |

Installing SANsurfer FC HBA CLI. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-2 |

|

|

3.2.1 |

Windows Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-2 |

|

|

3.2.1.1 |

Standard (GUI) Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-2 |

|

|

3.2.1.2 |

Command Line Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-5 |

|

|

3.2.2 |

Linux Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-7 |

|

|

3.2.3 |

Solaris Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-8 |

|

|

3.2.3.1 |

Solaris SPARC 8, 9, 10 Installation . . . . . . . . . . . . . . . . . . . . . . |

3-8 |

|

|

3.2.3.2 |

Solaris x86 9 and 10 Installation. . . . . . . . . . . . . . . . . . . . . . . . . |

3-9 |

|

|

3.2.4 |

Macintosh Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-11 |

|

|

3.2.4.1 |

Standard (GUI) Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-11 |

|

|

3.2.4.2 |

Command Line Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-11 |

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

|

3.3 |

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .Uninstalling SANsurfer FC HBA CLI |

3-12 |

||

|

3.3.1 |

Windows Uninstall . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-13 |

||

|

3.3.1.1 |

Standard (GUI) Uninstall. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-13 |

||

|

3.3.1.2 |

Command Line Uninstall. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-13 |

||

|

3.3.2 |

Linux Uninstall . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-13 |

||

|

3.3.3 |

Solaris Uninstall. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-13 |

||

|

3.3.3.1 |

Solaris SPARC 8, 9, and 10 Uninstall. . . . . . . . . . . . . . . . . . . . . |

3-14 |

||

|

3.3.3.2 |

Solaris x86 8, 9, and 10 Uninstall . . . . . . . . . . . . . . . . . . . . . . . . |

3-14 |

||

|

3.3.4 |

Macintosh Uninstall . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

3-15 |

|

Section 4 |

Interactive Commands |

||

|

4.1 |

General Information Menu (Command Line Option -g) . . . . . . . . . . . . . . . . |

4-2 |

|

|

4.1.1 |

Host Information (Command Line Option -g). . . . . . . . . . . . . . . . . . . . |

4-2 |

|

|

4.1.2 |

Host Topology (Command Line Option -tp | -topology) . . . . . . . . . . . . |

4-3 |

|

|

4.1.2.1 |

Display (Host Topology) (Command Line Option -tp | |

||

|

-topology) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-4 |

||

|

4.1.2.2 |

Save As Txt File (Command Line Option -b) . . . . . . . . . . . . . . . |

4-8 |

|

|

4.1.2.3 |

Save As XML File . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-8 |

|

|

4.1.3 |

Generate Report (Command Line Option -z) . . . . . . . . . . . . . . . . . . . |

4-9 |

|

|

4.1.3.1 |

Generate Report (Per HBA Port) . . . . . . . . . . . . . . . . . . . . . . . . |

4-9 |

|

|

4.1.3.2 |

Generate Report (All HBAs) (Command Line Option -z) . . . . . . |

4-17 |

|

|

4.1.4 |

Refresh . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-17 |

|

|

4.2 |

HBA Information Menu (Command Line Option -i) . . . . . . . . . . . . . . . . . . . |

4-17 |

|

|

4.2.1 |

HBA General Information (per HBA Port) . . . . . . . . . . . . . . . . . . . . . . |

4-18 |

|

|

4.2.1.1 |

HBA Information (Command Line Option -i). . . . . . . . . . . . . . . . |

4-18 |

|

|

4.2.1.2 |

HBA Alias (Command Line Option -ha) . . . . . . . . . . . . . . . . . . . |

4-18 |

|

|

4.2.1.3 |

HBA Port Alias (Command Line Option -pa) . . . . . . . . . . . . . . . |

4-19 |

|

|

4.2.1.4 |

HBA VPD Information (Command Line Option -l and |

||

|

Reserved Word “vpd”) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-20 |

||

|

4.2.2 |

HBA Information (All HBAs). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-21 |

|

|

4.2.2.1 |

Information . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-21 |

|

|

4.3 |

HBA Parameters Menu . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-21 |

|

|

4.3.1 |

HBA Parameters (Per HBA Port). . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-22 |

|

|

4.3.1.1 |

Display HBA Parameters (Command Line Option -c#). . . . . . . . |

4-22 |

|

|

4.3.1.2 |

Configure HBA Parameters (Command Line Option -n). . . . . . . |

4-23 |

|

|

4.3.1.3 |

Restore Defaults . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-29 |

|

|

4.3.2 |

HBA Parameters (All HBAs) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-29 |

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

4.4 |

. . . . . . . . . . . . . .Target/LUN List Menu (Command Line Options -t and -l) |

4-30 |

||

|

4.4.1 |

Target/LUN List (Per HBA Port). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-31 |

||

|

4.4.1.1 |

Per Target/LUN. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-31 |

||

|

4.4.1.2 |

Per Target/All LUNs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-32 |

||

|

4.4.1.3 |

All Targets. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-33 |

||

|

4.4.2 |

Target/LUN List (All HBAs) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-33 |

||

|

4.4.2.1 |

Individual Target . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-33 |

||

|

4.4.2.2 |

Individual LUN . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-34 |

||

|

4.4.2.3 |

All Targets. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-35 |

||

|

4.4.2.4 |

All Target(s) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-36 |

||

|

4.4.2.5 |

All LUN(s) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-37 |

4.5Target Link Speed or iiDMA Settings Menu (Command Line Option -q) . . . 4-38

|

4.5.1 |

Configuring the iiDMA Settings . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-39 |

|

4.5.2 |

HBA Port Instance . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-40 |

|

4.5.3 |

HBA Port . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-41 |

|

4.5.3.1 |

Advanced Configuration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-42 |

|

4.5.4 |

Target Link Speed – All HBAs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-43 |

|

4.5.4.1 |

Target Link Speed – All HBAs – Basic Configuration . . . . . . . . . |

4-43 |

4.5.4.2Target Link Speed – All HBAs – Advanced Configuration . . . . . 4-43

|

4.5.4.3 |

iiDMA Settings – Disk . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-45 |

|

|

4.5.5 |

iiDMA – All HBAs. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-45 |

|

|

4.6 |

Target Persistent Bindings Menu (Command Line Option -p) . . . . . . . . . . . |

4-45 |

4.6.1Target Persistent Bindings (Per HBA Port) (Command Line

Option -p). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-46

4.6.1.1Display Target Persistent Binding (Command Line

Option -p) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-46

4.6.1.2Target Persistent Bindings – Bind Target(s) (Command Line

Option -p) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-47

4.6.1.3Target Persistent Binding – Unbind Targets (Command Line

|

Option -p) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-48 |

||

|

4.6.2 |

Target Persistent Binding (All HBAs). . . . . . . . . . . . . . . . . . . . . . . . . . |

4-48 |

|

|

4.6.2.1 |

Display Target Persistent Binding. . . . . . . . . . . . . . . . . . . . . . . . |

4-49 |

|

|

4.6.2.2 |

Target Persistent Binding – Bind Targets . . . . . . . . . . . . . . . . . . |

4-49 |

|

|

4.6.2.3 |

Target Persistent Binding – Unbind Targets . . . . . . . . . . . . . . . . |

4-49 |

|

|

4.7 |

Selective LUNs Menu (Command Line Option -m) . . . . . . . . . . . . . . . . . . . |

4-49 |

|

|

4.7.1 |

Selective LUNs (Per HBA Port) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-49 |

|

|

4.7.2 |

Selective LUNs (All HBAs) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-50 |

|

|

4.7.2.1 |

Display LUN Configuration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-50 |

|

|

4.7.2.2 |

Manual Configure LUNs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-51 |

|

|

4.7.2.3 |

Auto Configure LUNs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-51 |

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

|

4.8 |

. . . . . . . . . . . . . . . . . . . . . .Boot Device Menu (Command Line Option -e) |

4-51 |

||

|

4.8.1 |

HBA Port Instance . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-52 |

||

|

4.8.1.1 |

Boot Device(s) (Per HBA Port) . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-52 |

||

|

4.8.1.2 |

Configure Boot Device(s) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-53 |

||

|

4.8.2 |

Boot Device(s) (All HBAs) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-54 |

||

|

4.9 |

Driver Settings Menu (Command Line Option -fg) . . . . . . . . . . . . . . . . . . . . |

4-54 |

||

|

4.10 |

Utilities Menu . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-56 |

4.10.1Flash Update (Per HBA Port or All HBAs) (Command Line

Option -b). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-56

4.10.2Flash Save (Per HBA Port) (Command Line Option -b and

Reserved Word “save”) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-56

4.10.3HBA Parameters Update (Per HBA Port or All HBAs) (Command

Line Option -r) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-57

4.10.4HBA Parameters Save (Per HBA Port) (Command Line Option

-r and Reserved Word “save”) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-57

4.10.5HBA Parameters Template (Per HBA or All HBAs) (Command

|

Line Option -n and OEM Name) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-57 |

||

|

4.10.5.1 |

Using HBA Parameter Templates. . . . . . . . . . . . . . . . . . . . . . . . |

4-58 |

|

|

4.10.6 |

Driver Update (Command Line Option -d). . . . . . . . . . . . . . . . . . . . . . |

4-60 |

|

|

4.10.7 |

Driver Rescan (Command Line Option -rs) . . . . . . . . . . . . . . . . . . . . . |

4-60 |

|

|

4.11 |

Beacon Menu . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-61 |

|

|

4.11.1 |

Locate HBA – HBA Beacon (Command Line Option -a) . . . . . . . . . . . |

4-61 |

|

|

4.11.2 |

Locate Target(s) – Target Beacon (Command Line Option -tb). . . . . . |

4-61 |

|

|

4.11.2.1 |

Beacon Selected Target(s) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-62 |

|

|

4.12 |

Diagnostics Menu (Command Line Options -kl, -kr, and -dm) . . . . . . . . . . . |

4-62 |

|

|

4.12.1 |

Diagnostics Loopback Test (Command Line Option -kl) . . . . . . . . . . . |

4-63 |

|

|

4.12.1.1 |

Configure Loopback Test Parameters . . . . . . . . . . . . . . . . . . . . |

4-64 |

|

|

4.12.1.2 |

Run Loopback Test. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-66 |

|

|

4.12.2 |

Diagnostics Read/Write Buffer Test. . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-66 |

|

|

4.12.2.1 |

Configure Read/Write Test Parameters . . . . . . . . . . . . . . . . . . . |

4-67 |

|

|

4.12.2.2 |

Run Read/Write Buffer Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-71 |

4.12.3Diagnostics Transceiver Details – DMI (Command Line

|

Option -dm) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-72 |

||

|

4.12.3.1 |

Transceiver Details – General . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-72 |

|

|

4.12.3.2 |

Transceiver Details – Details . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-73 |

|

|

4.13 |

Statistics Menu (Command Line Options -gs and -ls) . . . . . . . . . . . . . . . . . |

4-76 |

|

|

4.13.1 |

HBA Statistics – Monitoring (Command Line Option -gs) . . . . . . . . . . |

4-76 |

|

|

4.13.1.1 |

Configuration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-76 |

|

|

4.13.1.2 |

Show HBA Statistics . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

4-79 |

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

4.13.2 |

. . . . . .Link Status (Command Line Option -ls) |

. . . . . . . . . . . . . . . . . . 4-80 |

|

|

4.13.2.1 |

Configuration . . . . . . . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-80 |

|

|

4.13.2.2 |

Show Link Status . . . . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-82 |

|

|

4.14 |

Virtual Menu (Command Line Option -vp) . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-83 |

|

|

4.14.1 |

Virtual Menu for HBA Instance . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-85 |

|

|

4.14.1.1 |

List Virtual Port(s) . . . . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-85 |

|

|

4.14.1.2 |

Delete Virtual Port(s) . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-86 |

|

|

4.14.1.3 |

Create Virtual Port(s) . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-86 |

|

|

4.15 |

Help Menu (Command Line Option -h) . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-87 |

|

|

4.15.1 |

Contents . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-88 |

|

|

4.15.2 |

Exit Codes . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-88 |

|

|

4.15.3 |

About . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

. . . . . . . . . . . . . . . . . . 4-88 |

|

Section 5 |

Non-interactive Commands |

|

|

5.1 |

Introduction. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-1 |

|

5.2 |

Display System Information (Command Line Options -g, -z, and -tp) . . . . . |

5-1 |

|

5.2.1 |

Host Information (Command Line Option -g). . . . . . . . . . . . . . . . . . . . |

5-1 |

|

5.2.2 |

Host Configuration (Command Line Option -z) . . . . . . . . . . . . . . . . . . |

5-2 |

|

5.2.3 |

Host Topology (Command Line Option -tp) . . . . . . . . . . . . . . . . . . . . . |

5-3 |

|

5.2.4 |

Host Configuration. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-4 |

|

5.3 |

Command Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-5 |

|

5.3.1 |

-a (View or Toggle Beacon Status) . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-6 |

|

5.3.2 |

-b (Save or Update the Flash BIOS or Fcode) . . . . . . . . . . . . . . . . . . |

5-7 |

|

5.3.3 |

-c (Show Parameter Settings) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-8 |

|

5.3.4 |

-d (Update Device Driver) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-8 |

|

5.3.5 |

-dm (Display Diagnostics Monitoring Info). . . . . . . . . . . . . . . . . . . . . . |

5-9 |

|

5.3.6 |

-e (Boot Device View | Select | Disable) . . . . . . . . . . . . . . . . . . . . . . . |

5-9 |

|

5.3.7 |

-ei (List SANsurfer FC HBA CLI Error Codes). . . . . . . . . . . . . . . . . . . |

5-12 |

|

5.3.8 |

-f (Input Parameter Options from a Text File) . . . . . . . . . . . . . . . . . . . |

5-12 |

|

5.3.9 |

-fg (Show Driver Settings) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-13 |

|

5.3.10 |

-fs (Configure Driver Settings). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-13 |

|

5.3.11 |

-g (Display System Information) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-14 |

|

5.3.12 |

-gs (Show HBA Statistics) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-14 |

|

5.3.13 |

-h (Help). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-15 |

|

5.3.14 |

-ha (Set | Delete HBA Alias) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-16 |

5.3.15-i (Display HBA General Information or VPD Information for

One or All HBAs) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5-17

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S

|

5.3.16 |

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .-kl (Loopback Test) |

5-17 |

||

|

5.3.16.1 |

DataPattern (DP) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-18 |

||

|

5.3.16.2 |

DataSize (DS). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-19 |

||

|

5.3.16.3 |

TestCount (TC) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-20 |

||

|

5.3.16.4 |

Test Increment (TI) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-20 |

||

|

5.3.16.5 |

OnError (OE) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-20 |

||

|

5.3.16.6 |

Run a Loopback Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-21 |

||

|

5.3.17 |

-kl (Run HBA Diagnostics Loopback Test). . . . . . . . . . . . . . . . . . . . . . |

5-23 |

||

|

5.3.18 |

-kr (Run Read/Write Buffer Test) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-23 |

||

|

5.3.18.1 |

Run a Read/Write Buffer Test . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-24 |

||

|

5.3.18.2 |

Run HBA Diagnostics Read-write Buffer Test. . . . . . . . . . . . . . . |

5-26 |

||

|

5.3.19 |

-l (Display LUN Info) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-28 |

||

|

5.3.20 |

-ls (Display Link Status) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-28 |

||

|

5.3.21 |

-m (View, Enable, or Disable LUNs) . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-29 |

||

|

5.3.22 |

-n (Set Selected HBA Parameter) . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-31 |

||

|

5.3.23 |

-o (Output to a File) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-33 |

||

|

5.3.24 |

-p (Display Persistent Target Binding Info) . . . . . . . . . . . . . . . . . . . . . |

5-34 |

||

|

5.3.25 |

-pa (Define Port Alias) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-36 |

||

|

5.3.26 |

-q (View or Set Target Link Speed) . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-36 |

||

|

5.3.27 |

-r (Update HBA Parameters) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-38 |

||

|

5.3.28 |

-s (Silent Mode) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-38 |

||

|

5.3.29 |

-t (Display Target Information) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-39 |

||

|

5.3.30 |

-tb (Target Beacon On/Off) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-39 |

||

|

5.3.31 |

-tp (Display Host Topology) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-40 |

||

|

5.3.32 |

-v (Display Version) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-40 |

||

|

5.3.33 |

-vp (Virtual Port) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-40 |

||

|

5.3.34 |

-x (Output in XML Format 1) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-41 |

||

|

5.3.35 |

-x2 (Output in XML Format 2) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

5-42 |

||

|

5.3.36 |

-z (Display All HBA information for One or All HBAs) . . . . . . . . . . . . . |

5-42 |

||

|

Appendix A XML Format 1 |

||||

|

A.1 |

Introduction. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-1 |

||

|

A.1.1 |

Main Tag . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-1 |

||

|

A.1.2 |

Utility Header. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-1 |

||

|

A.1.3 |

Status Message. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-2 |

||

|

A.1.4 |

Reboot Message . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-2 |

||

|

A.1.5 |

Error Message. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-2 |

||

|

A.2 |

XML Format 1 Tags for Each Option . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-2 |

||

|

A.2.1 |

Display System Information (Command Line Option -g) . . . . . . . . . . . |

A-3 |

||

|

A.2.2 |

Display Adapter Settings (Command Line Option -c) . . . . . . . . . . . . . |

A-3 |

A

SANsurfer FC HBA CLI User’s Guide Command Line Interface for QLogic Fibre Channel Host Bus Adapters

|

A.2.3 |

. . . . . . . . . . . . . .Display HBA Information (Command Line Option -i) |

A-4 |

|

|

A.2.4 |

Display Device List (Command Line Option -t) . . . . . . . . . . . . . . . . . . |

A-6 |

|

|

A.2.5 |

Display LUN List (Command Line Option -l) . . . . . . . . . . . . . . . . . . . . |

A-7 |

|

|

A.2.6 |

Target Persistent Binding (Command Line Option -p) . . . . . . . . . . . . . |

A-7 |

|

|

A.2.7 |

Selective LUNs (Command Line Option -m) . . . . . . . . . . . . . . . . . . . . |

A-8 |

|

|

A.2.8 |

Boot Device (Command Line Option -e) . . . . . . . . . . . . . . . . . . . . . . . |

A-8 |

|

|

A.2.9 |

Diagnostics Results –Loopback Test (Command Line Option -kl) . . . |

A-9 |

|

|

A.2.10 |

Diagnostics Results – Read/Write Buffer Test (Command Line |

||

|

Option -kr) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-9 |

||

|

A.2.11 |

View Driver Settings (Command Line Option -fg) . . . . . . . . . . . . . . . . |

A-10 |

|

|

A.2.12 |

Display All Information for One or All HBAs (Command Line |

||

|

Option -z). . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

A-10 |

||

|

A.2.13 |

Link Statistics (Command Line Option -ls). . . . . . . . . . . . . . . . . . . . . . |

A-13 |

|

|

A.2.14 |

HBA Statistics (Command Line Option -gs). . . . . . . . . . . . . . . . . . . . . |

A-13 |

|

|

A.2.15 |

HBA Alias (Command Line Option -ha). . . . . . . . . . . . . . . . . . . . . . . . |

A-14 |

|

|

A.2.16 |

HBA Port Alias (Command Line Option -pa) . . . . . . . . . . . . . . . . . . . . |

A-14 |

|

|

A.2.17 |

SFF DMI (Command Line Option -dm) . . . . . . . . . . . . . . . . . . . . . . . . |

A-15 |

|

|

A.2.18 |

Host Topology (Command Line Option -tp) . . . . . . . . . . . . . . . . . . . . . |

A-20 |

Appendix B XML Format 2

|

B.1 |

Introduction. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-1 |

|

B.2 |

Main Tag. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-1 |

|

B.3 |

Utility Header . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-1 |

|

B.4 |

Status Message . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-2 |

|

B.5 |

Error Message . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-2 |

|

B.6 |

Reboot Message . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-2 |

|

B.7 |

XML2 Tags for Each Option . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-2 |

|

B.7.1 |

Display Adapter Settings (Command Line Option -c) . . . . . . . . . . . . . |

B-2 |

|

B.7.2 |

SFF DMI (Command Line Option -dm) . . . . . . . . . . . . . . . . . . . . . . . . |

B-3 |

|

B.7.3 |

Boot Device (Command Line Option -e) . . . . . . . . . . . . . . . . . . . . . . . |

B-8 |

|

B.7.4 |

View Driver Settings (Command Line Option -fg) . . . . . . . . . . . . . . . . |

B-10 |

|

B.8 |

Display System Information (Command Line Option -g) . . . . . . . . . . . . . . . |

B-10 |

|

B.8.1 |

Display HBA Information (Command Line Option -I). . . . . . . . . . . . . . |

B-11 |

|

B.8.2 |

Diagnostics Results – Loopback Test (Command Line |

|

|

Option -kl) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-13 |

|

|

B.8.3 |

Diagnostics Results – Read/Write Buffer Test (Command Line |

|

|

Option -kr) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . |

B-13 |

|

|

B.8.4 |

Display LUN List (Command Line Option -l) . . . . . . . . . . . . . . . . . . . . |

B-14 |

|

B.8.5 |

Selective LUNs (Command Line Option -m) . . . . . . . . . . . . . . . . . . . . |

B-15 |

|

B.8.6 |

Target Persistent Binding (Command Line Option -p) . . . . . . . . . . . . . |

B-15 |

SANsurfer FC HBA CLI User’s Guide

Command Line Interface for QLogic Fibre Channel Host Bus Adapters

S