Обновлено 02.10.2019

Что такое Nic Teaming

Сейчас когда бизнес уже очень сильно зависит от доступности его сервисов, таких как корпоративная почта, файловый сервер, сайт с веб приложениями и CRM, и многое другое очень сильно встает вопрос по организации отказоустойчивости на разных уровнях. Одним из таких уровней является сетевой. В данной статье нам нужно рассмотреть про организацию отказоустойчивой сети в вашем Windows Server 2019. Сейчас уже себе сложно представить сервер, у которого было бы сетевых интерфейсов меньше двух, чаще всего их четыре и более. Раз они есть, то было бы здорово их объединить и использовать, как одно целое решая тем самым:

- Отказоустойчивость сетевой доступности

- Увеличение пропускной способности

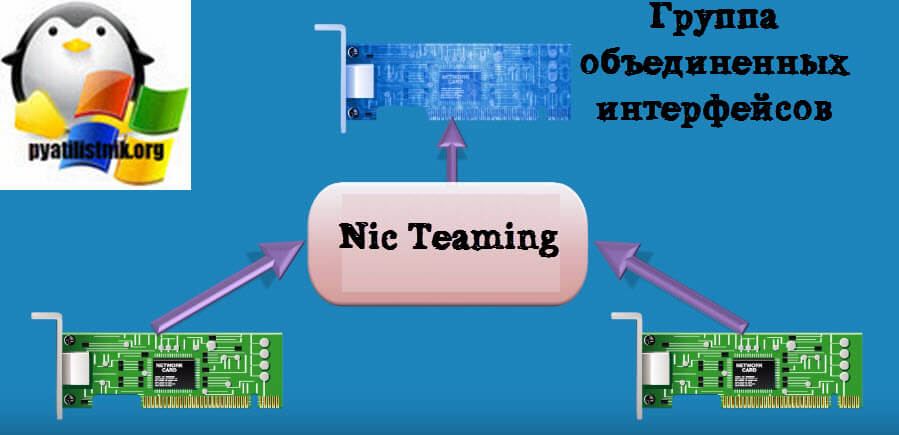

Microsoft начиная с Windows Server 2012 услышала администраторов и внедрила в свою операционную систему функционал Nic Teaming. Объединение сетевых карт (Nic Teaming Network Interface Card Teaming (Load Balancing/Fail Over (LBFO))) — это технология группировки физических или виртуальных сетевых карт в один или несколько программных сетевых адаптеров, решающих проблемы в случае сбоя оборудования.

На текущий момент вы можете спокойно объединить в Windows Server 2019 от двух до 32 сетевых карт в один или несколько пулов.

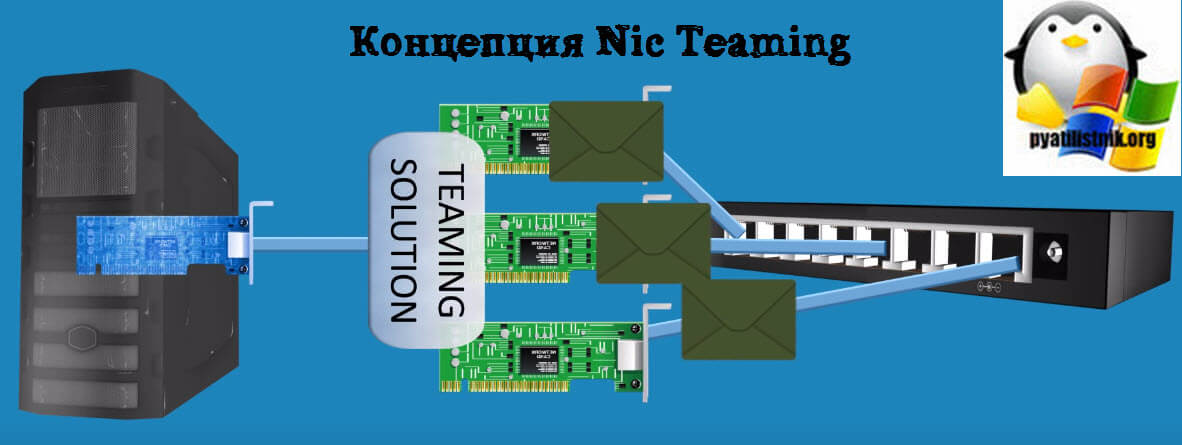

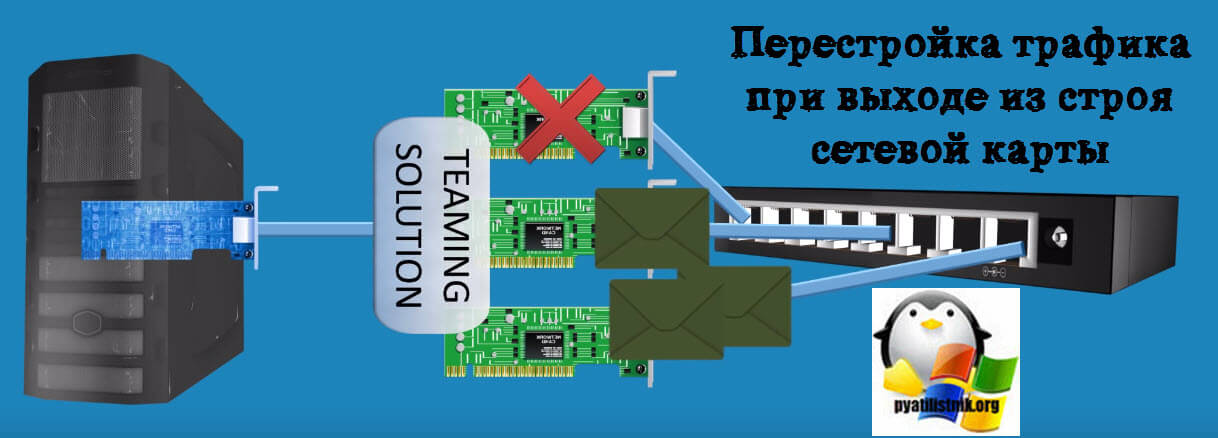

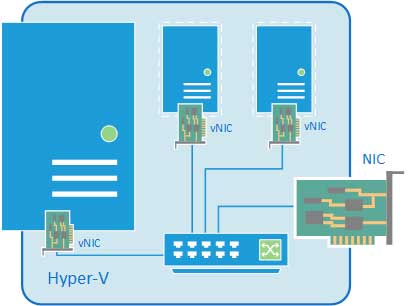

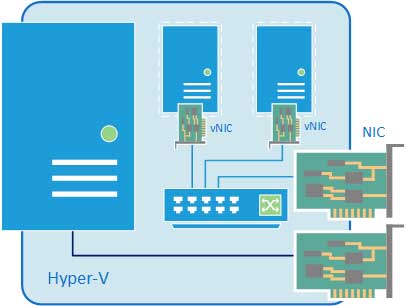

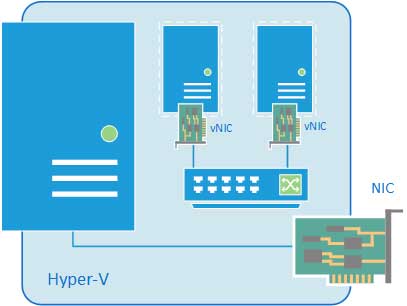

Предположим, что у нас вышел из строя один сетевой адаптер, в результате прохождение трафика перестроилось.

Ранее Nic Teaming мог быть реализован только посредством установки специальных драйверов на ваши сетевые карты. Эти драйвера позволяли вам через свойства сетевых адаптеров собирать пулы. Бывало так, что у вас на физическом сервере могли быть сетевые карты разных производителей, и в таком сценарии вы могли иметь проблемы с объединением сетевых карт. Благодаря встроенной возможности Windows Server 2019 эта проблема минимизируется.

Хочу отметить, что данная технология не нова и давно уже реализована и используется на сетевом оборудовании, там она называется LACP, или на системах хранения, например у Synology, там она называется Bonding, в Linux то же Bonding.

Требования и ограничения к Nic Teaming в Windows Server 2019

Как сказано в документации Microsoft драйвер сетевой карты должен иметь цифровую подпись Windows Hardware Qualification and Logo (WHQL). Если WHQL имеется, то вы может объединять адаптеры разных производителей.

https://docs.microsoft.com/ru-ru/windows-server/networking/technologies/nic-teaming/nic-teaming

Нужно учитывать, что для работы Nic Teaming сетевые карточки должны иметь одинаковую пропускную способность, если вы используете объединение от других производителей, то не используйте их совместно с инструментом Microsoft.

Так же вы не сможете объединить в группу карточки которые работают не по технологии Ethernet, такие как WWAN, Wi-FiInfiniband, сетевые адаптеры отладки ядра (KDNIC). Так же есть ряд технологий, которые не поддерживаются технологией объединения сетевых карт:

- TCP Chimney. TCP Chimney не поддерживается, так как TCP Chimney разгружает весь сетевой стек непосредственно к сетевому адаптеру.

- Для SR-IOV данные доставляются непосредственно на сетевой Адаптер без передачи через стек сети в виртуализации. Таким образом он не поддерживается для сетевых карт, для проверки или перенаправлять данные на другой маршрут в объединении.

- При настройке Qos, когда вы активируете политику качества обслуживания, тут могут быть проблемы из-за ограничения полосы пропускания

Методы настройки объединения сетевых интерфейсов

Существует три метода и два подхода по настройке ваших сетевых карт в общую сетевую группу:

- Первый метод, это локальный непосредственно на вашем сервере

- Второй метод, это удаленный подразумевает, что вы используете инструменты позволяющие вам выполнить настройку на удаленной системе.

Из инструментов я могу выделить:

- Использование оснастки «Диспетчер серверов»

- Командлеты PowerShell

Настройка Nic Teaming в Windows Server 2019

Производить настройку Nic Teaming я буду в моем тестовом домене Active Directory root.pyatilistnik.org. У меня есть виртуальная машина с установленной Windows Server 2019, где выполнена базовая настройка перед вводом в эксплуатацию. Так как я этот сервер использую, как хост управления Windows Admin Center и WDS сервер ,то мне хочется, чтобы он был более отказоустойчивый и производительный в плане пропускной способности.

Использование диспетчера серверов

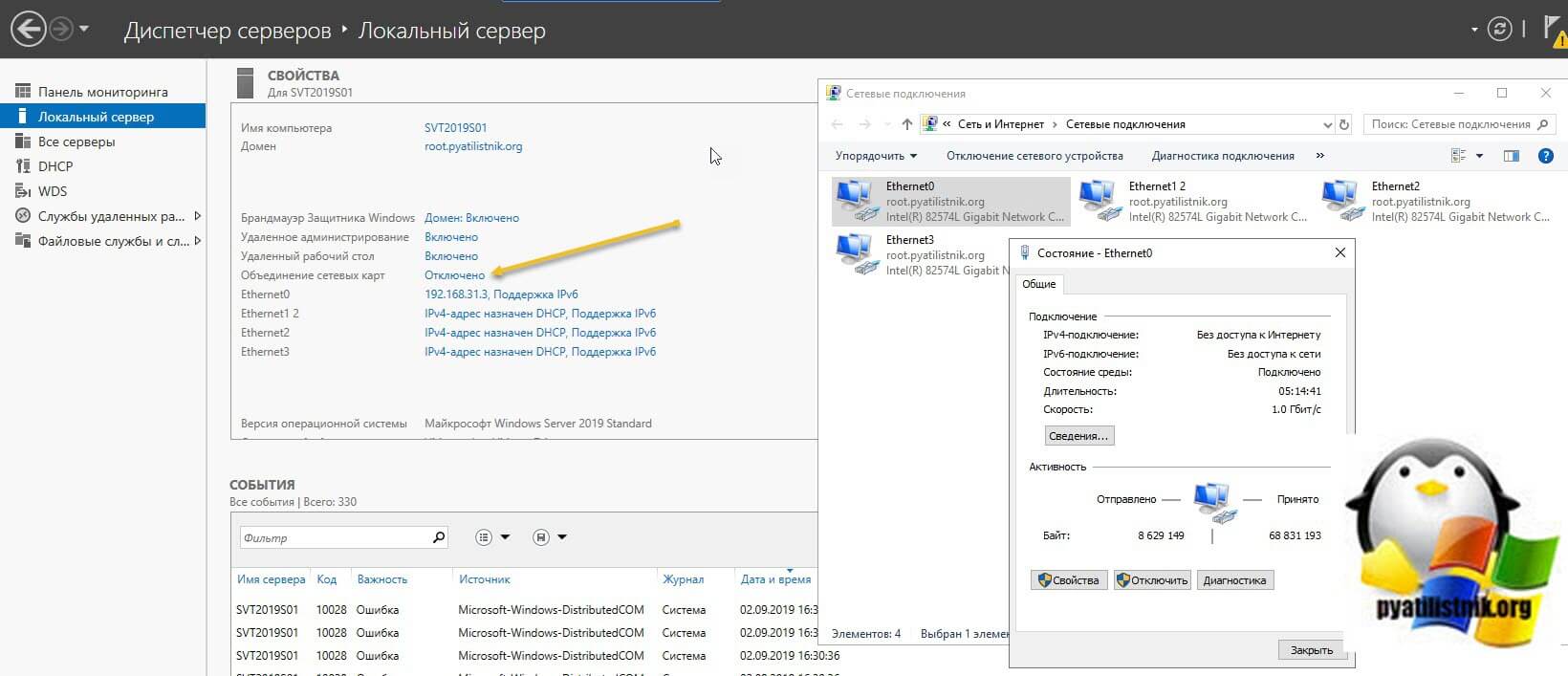

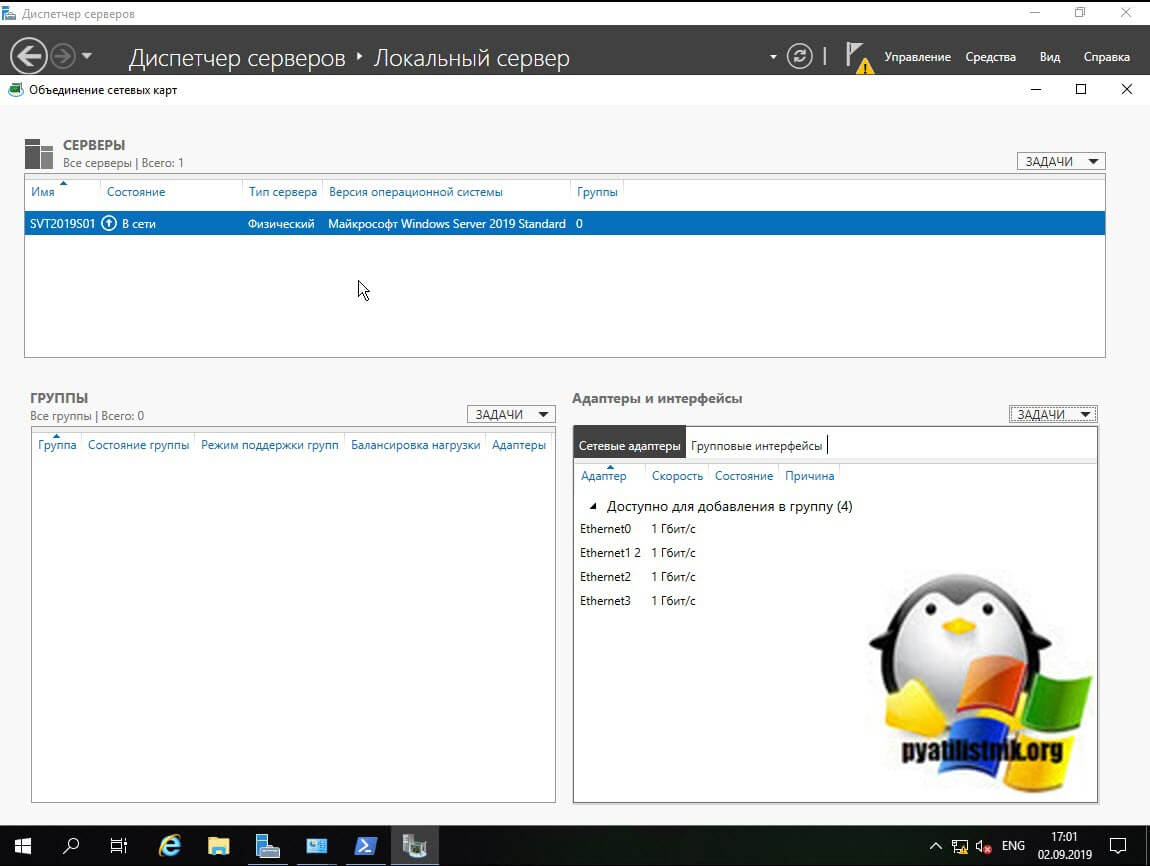

Данный метод самый простой и часто используемый, так как подходит большинству системных администраторов, он позволит вам производить настройки тиминга и на серверах Windows Core. Открываем диспетчер серверов, в моем примере на сервере SVT2019S01, у него есть четыре гигабитные сетевые карты intel 82574L. Как видно по умолчанию в Windows Server 2019 объединение сетевых карт отключено, щелкаем по настройке.

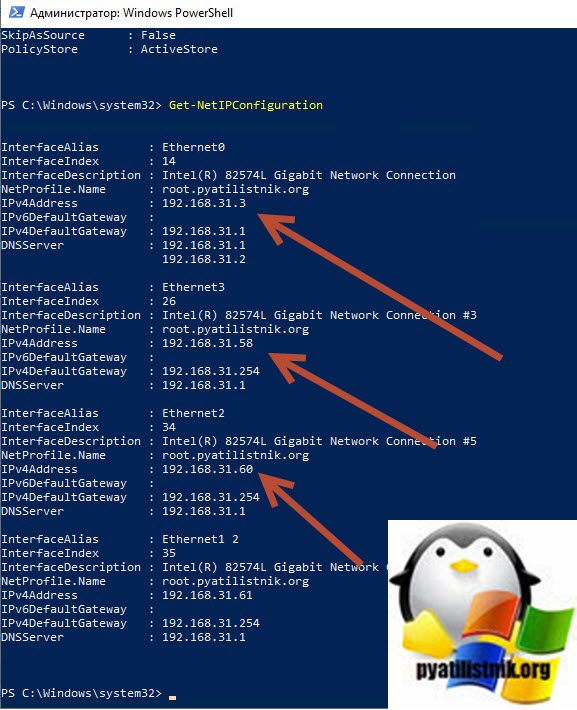

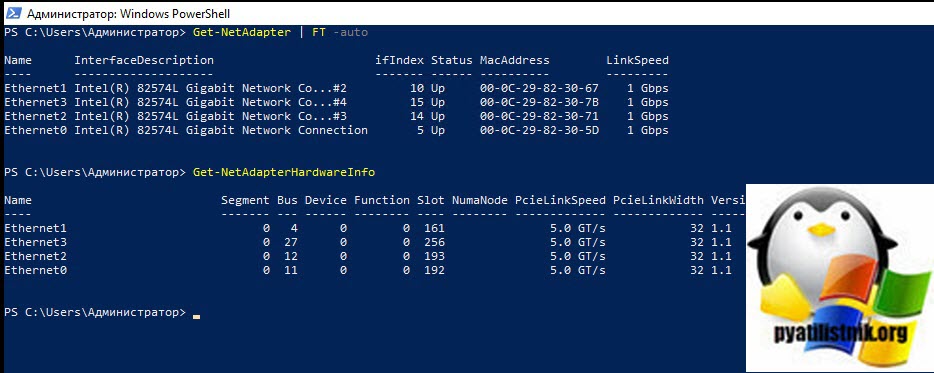

В статье по настройке сети в Windows Server 2019 я вам показывал команду PowerShell показывающую вам сетевые настройки:

В результате видно, что мои адаптеры имеют 4 разных Ip-адреса, один статический 192.168.31.3 и три динамических, полученных от DHCP-сервера. Я сделаю пул состоящий из четырех сетевых адаптеров и назначу ему IP-адрес 192.168.31.3.

В результате у вас должно открыться окно «Объединение сетевых карт«, оно будет разбито на три раздела:

- Раздел серверы — тут вы можете добавлять удаленные сервера для управления тимингом

- Раздел группы — тут вы создаете группы «Windows Nic Teaming»

- Адаптеры и интерфейсы — список ваших сетевых адаптеров, которые вы будите добавлять в группы

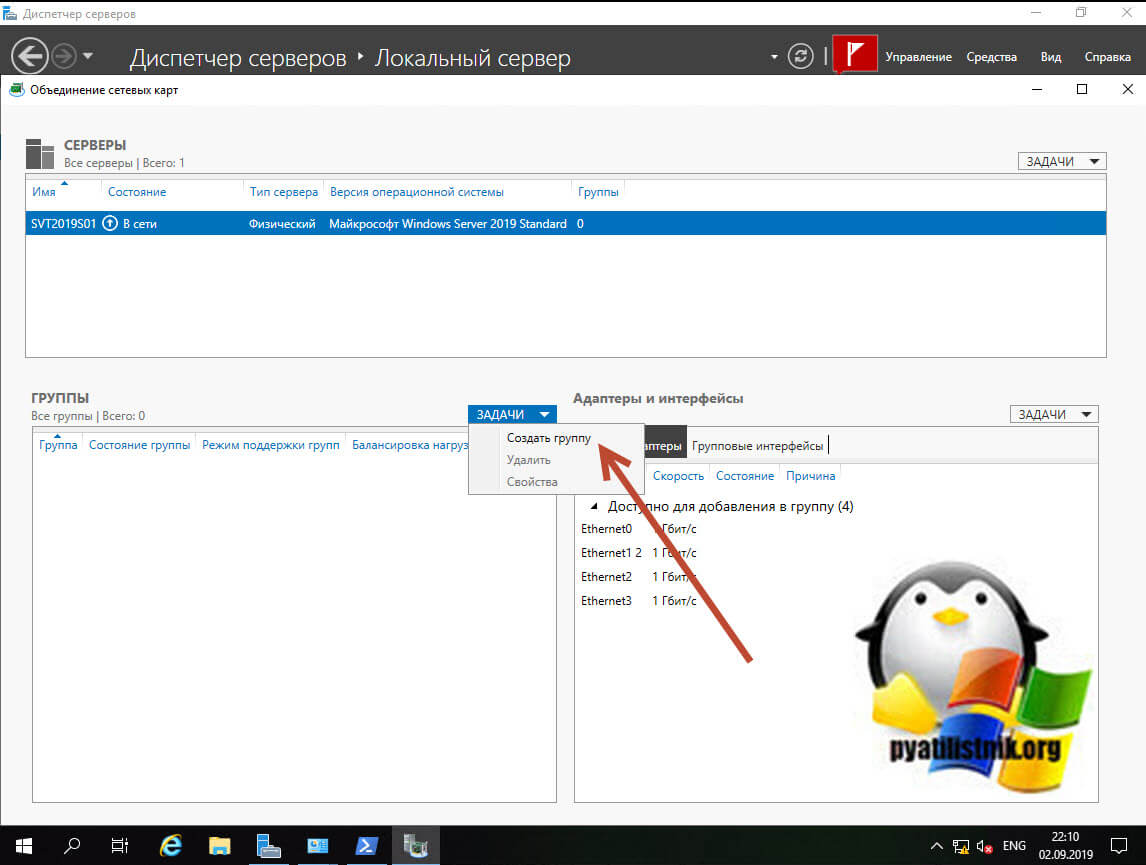

Объединение сетевых карт у нас начинается с создания новой группы. В разделе группы, нажмите кнопку «Задачи» и выберите пункт «Создать группу».

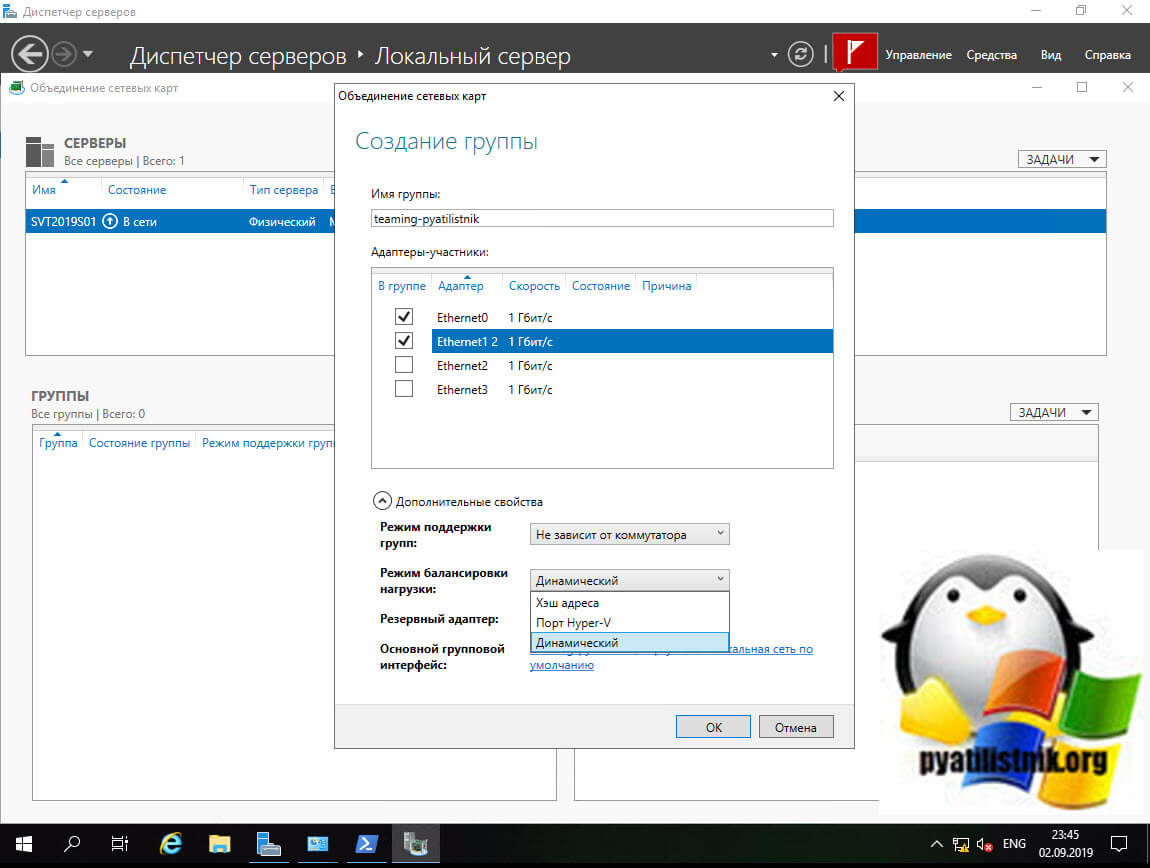

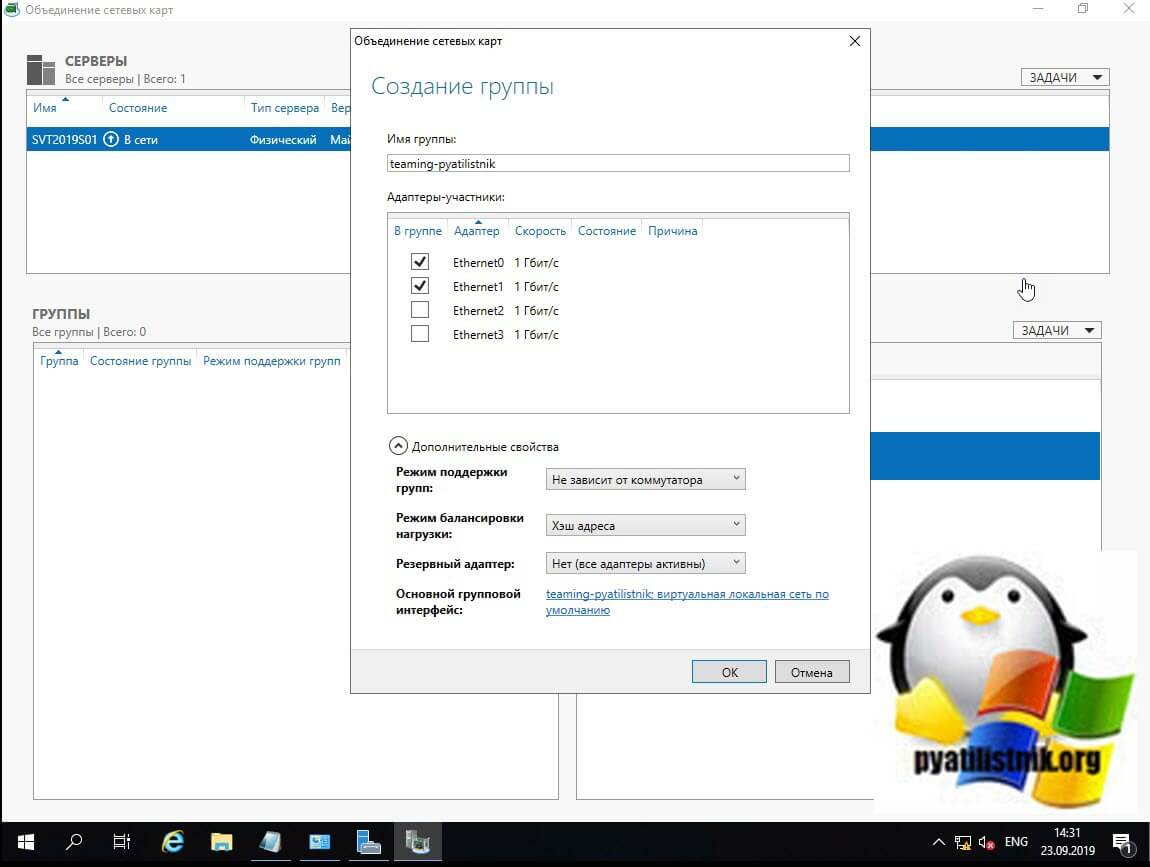

Откроется окно создания группы. Тут вам нужно выбрать под себя и свои задачи ряд параметров, а именно:

- Задайте удобное для вас имя Nic Teaming, отмечу, что оно ни на что не влияет

- Выберите адаптеры участники — это те сетевые адаптеры которые вы хотели бы видеть у себя в группе интерфейсов, я пока выберу два, остальные добавлю в момент, когда группа уже создана

Нажмите кнопку «Дополнительные свойства«, в ней весь сок. Тут вы сможете настроить:

-

- Режим поддержки групп

- Режим балансировки нагрузки

- Резервный адаптер — это если вы хотите какой-то сетевой интерфейс держать про запас и если кто-то из группы будут не доступны, то он включится в дело и всех спасет, Нужно учитывать, что он не будет участвовать в передачи данных.

- Основной групповой интерфейс

Режимы поддержки групп

Режим поддержки групп (Teaming Mode) — это два режима, которые задают как у вас будет работать ваше объединение сетевых карт. Как я писал выше у вас три варианта: «Не зависит от коммутатора (Switch Independent)», «Статическая поддержка групп (Static Teaming) (IEEE 802.3ad draft v1)» и LACP (Link Aggregation Control Protocol (LACP, IEEE 802.1ax)).

- Не зависит от коммутатора (Switch Independent) — данный режим позволяет вам подключать сетевые адаптеры сервера к разным коммутаторам, добиваясь тем самым отказоустойчивости. Независимые от коммутатора опции означают, что нам не нужно вносить какие-либо изменения конфигурации на стороне коммутатора. Использование «Не зависит от коммутатора» означает, что исходящий трафик будет сбалансирован по нагрузке с использованием выбранного нами алгоритма, но поскольку коммутаторы не знают о балансировке нагрузки, входящий трафик не будет сбалансирован по нагрузке. Входящий трафик получает основной сетевой интерфейс, в случае если он сбоит, его функции перейдут другому адаптеру.

- Статическая поддержка групп (Static Teaming) (IEEE 802.3ad draft v1) — данный режим требует настройки коммутатора, чтобы он мог работать с командами Nic Teaming Windows Server 2019, и сетевые адаптеры должны быть подключены к одному и тому же коммутатору. Еще раз, цитируя официальную документацию : «Команды, зависящие от коммутатора, требуют, чтобы все члены объединения были подключены к одному и тому же физическому коммутатору или коммутатору с несколькими шасси, который разделяет идентификатор коммутатора между несколькими шасси». При статической поддержке групп вам необходимо в ручном режиме произвести настройки на вашем коммутаторе, вы выделяете под это дело статические порты и формируете группу. Этот режим обычно поддерживается коммутаторами серверного класса.

В режиме «Статическая поддержка групп» исходящий трафик при режиме балансировки (Хэш адреса «Address Hash») будет распределяться между всеми активными адаптерами в группе объединенных сетевых карт. Входящий трафик так же будет перенаправлен в соответствии с заданным алгоритмом нагрузки, который задан на коммутаторе.

- LACP (Link Aggregation Control Protocol (LACP, IEEE 802.1ax)) — данный режим требует настройки коммутатора, режим намного более динамичен. Мы настраиваем коммутатор, а не отдельные порты, что означает, что мы можем перемещать кабели, и мы все равно получим сценарий с балансировкой нагрузки. Когда коммутатор настроен, он узнает о вашей сетевой группе и обрабатывает динамическое согласование портов.

Режим балансировки нагрузки

При объединении сетевых карт вам не только нужно выбрать режим поддержки, но и еще необходимо задать режим балансировки, коих целых три:

- Хэш адреса (Address Hash)

- Порт Hyper-V (Hyper-V Port)

- Динамический (Dynamic)

Ниже я расскажу про каждый из них.

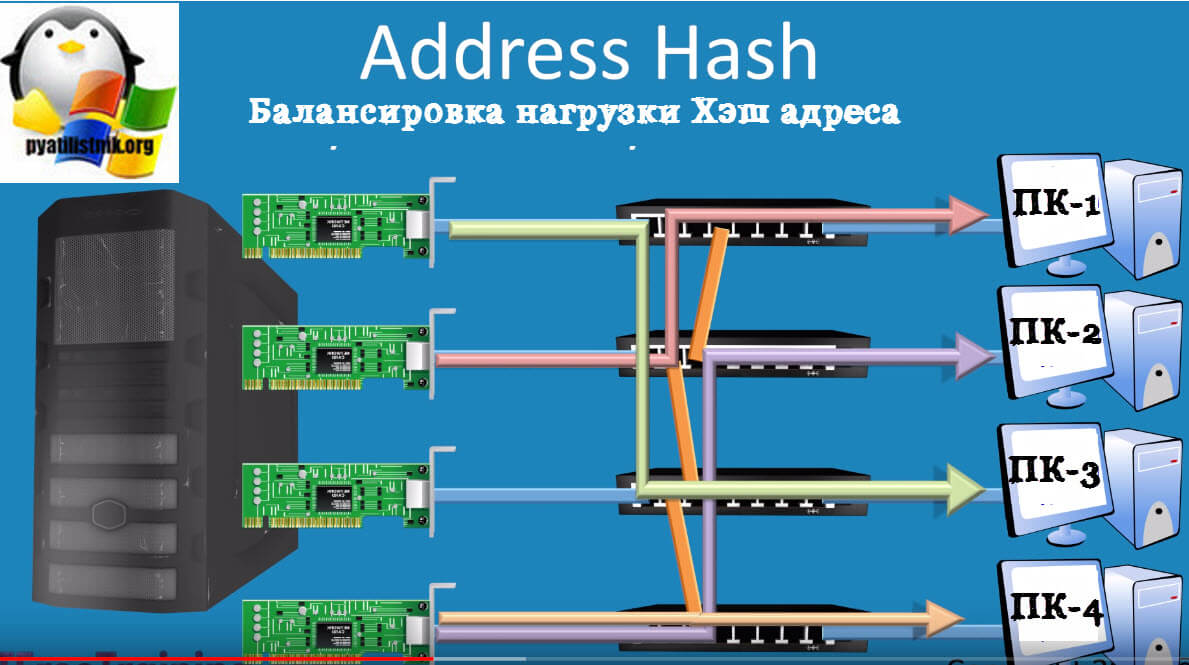

- Хэш адреса (Address Hash) — как можно догадаться из названия в данном режиме балансировки происходит вычисление хэш на основе адреса отправителя и получателя. Вычисленный хэш будет ассоциироваться с каким либо сетевым адаптером, и пакеты с таким хэшем будут прилетать именно ему. Хэш может вычисляться на основе следующих значений (Задаются через PowerShell):

- MAC-адрес отправителя и получателя;

- IP-адрес отправителя и получателя (2-tuple hash);

- TCP-порт отправителя и получателя и IP-адрес отправителя и получателя (4-tuple hash).

Если вы выбираете режим на основе портов, то это равномерное распределение трафика, но если у вас трафик не TCP/UPD, то применяться будет режим IP-адреса, если трафик не IP, то будет хэш на основе MAC-адреса.

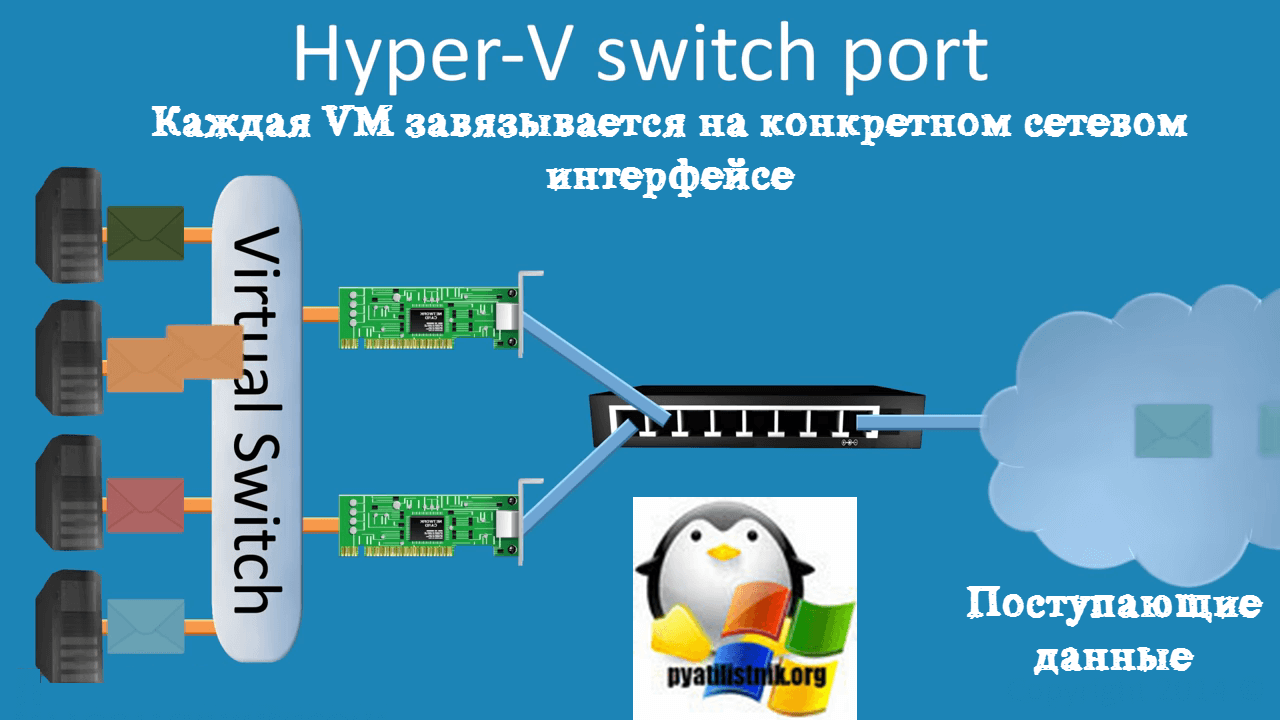

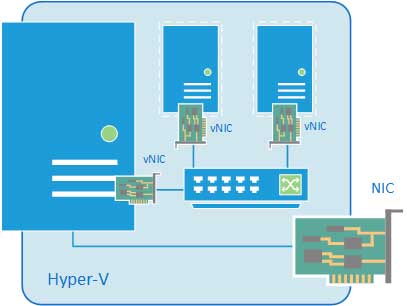

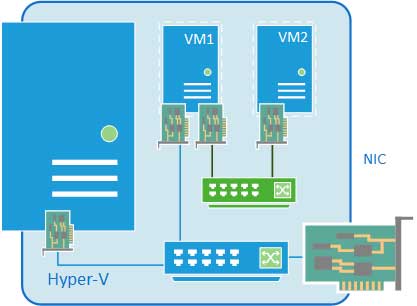

- Порт Hyper-V (Hyper-V Switch Port) — Балансировка нагрузки порта Hyper-V связывает виртуальную машину с конкретным сетевым адаптером в группе, что может хорошо работать для хоста Hyper-V с многочисленными виртуальными машинами, так что вы распределяете их сетевой адаптер между несколькими сетевыми картами в вашей группе. Весь исходящий трафик данной ВМ всегда передается через этот сетевой адаптер. В данном режиме такой вид балансировки назначает независимые MAC-адреса виртуальным машинам. Этот режим очень хорошо работает в сценариях, где вы объединяете много виртуальных машин на физическом хосте Hyper-V, но ни одна из них не генерирует сетевую нагрузку, превышающую пропускную способность одного сетевого адаптера в группе. Объединение сетевых карт использует порт коммутатора Hyper-V Virtual в качестве идентификатора, вместо того чтобы использовать MAC-адрес источника, так как в некоторых случаях виртуальные машины могут быть настроены с использованием более одного MAC-адреса на порту коммутатора.

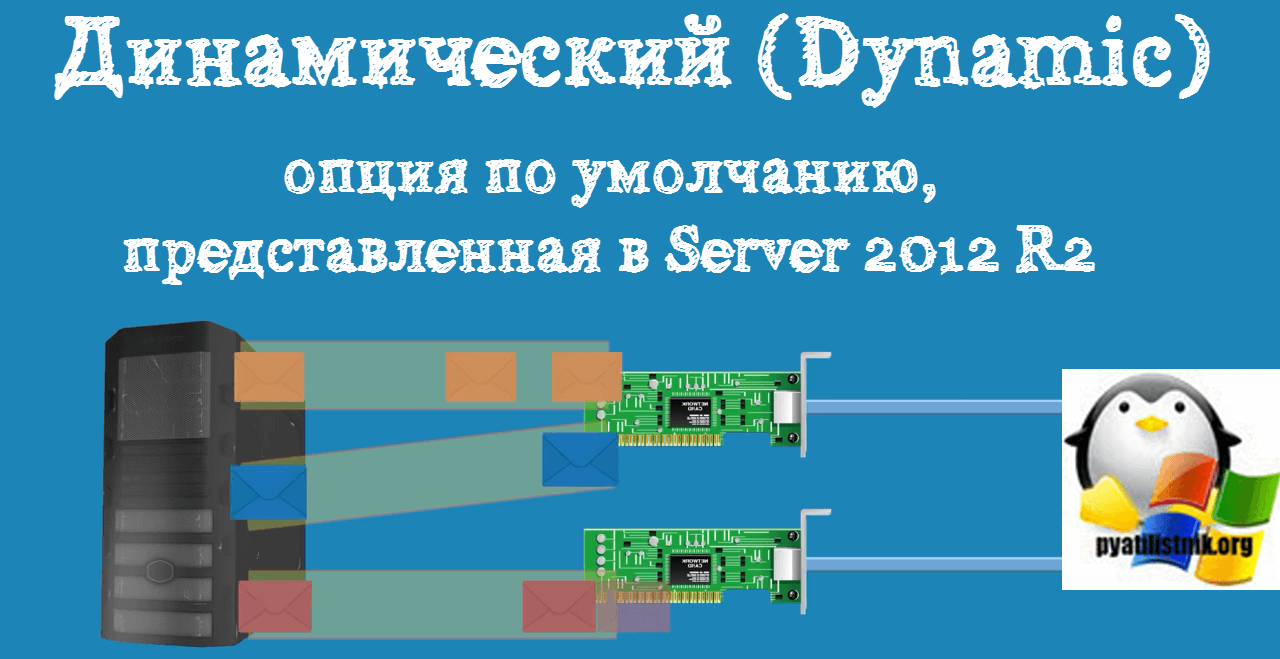

- Динамический (Dynamic) — это опция по умолчанию, представленная в Server 2012 R2, которая рекомендована Microsoft и дает вам преимущества обоих ранее упомянутых алгоритмов: он использует хеширование адресов для исходящего трафика и балансировку портов Hyper-V для входящего с дополнительной встроенной логикой для балансировки в случае сбоев/затыков

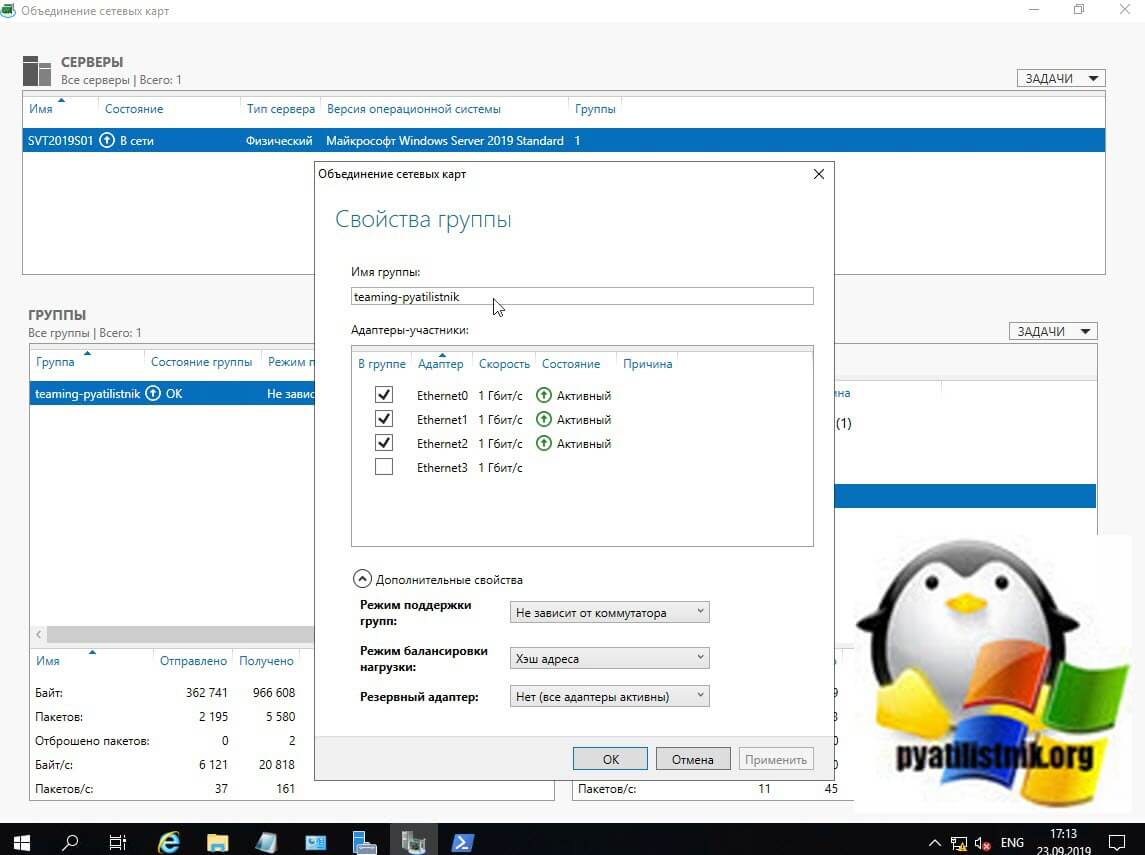

Разобравшись с основными понятиями, можно продолжить объединение сетевых карт. В своем примере я для начала объединю в NIC Teaming два сетевых интерфейса «Ethernet0» и «Ethernet1». Дополнительные настройки я выберу:

- Режим поддержки групп — Не зависит от коммутатора

- Режим балансировки нагрузки — Хэш адреса

- Резервный адаптер — нет (все адаптеры активны)

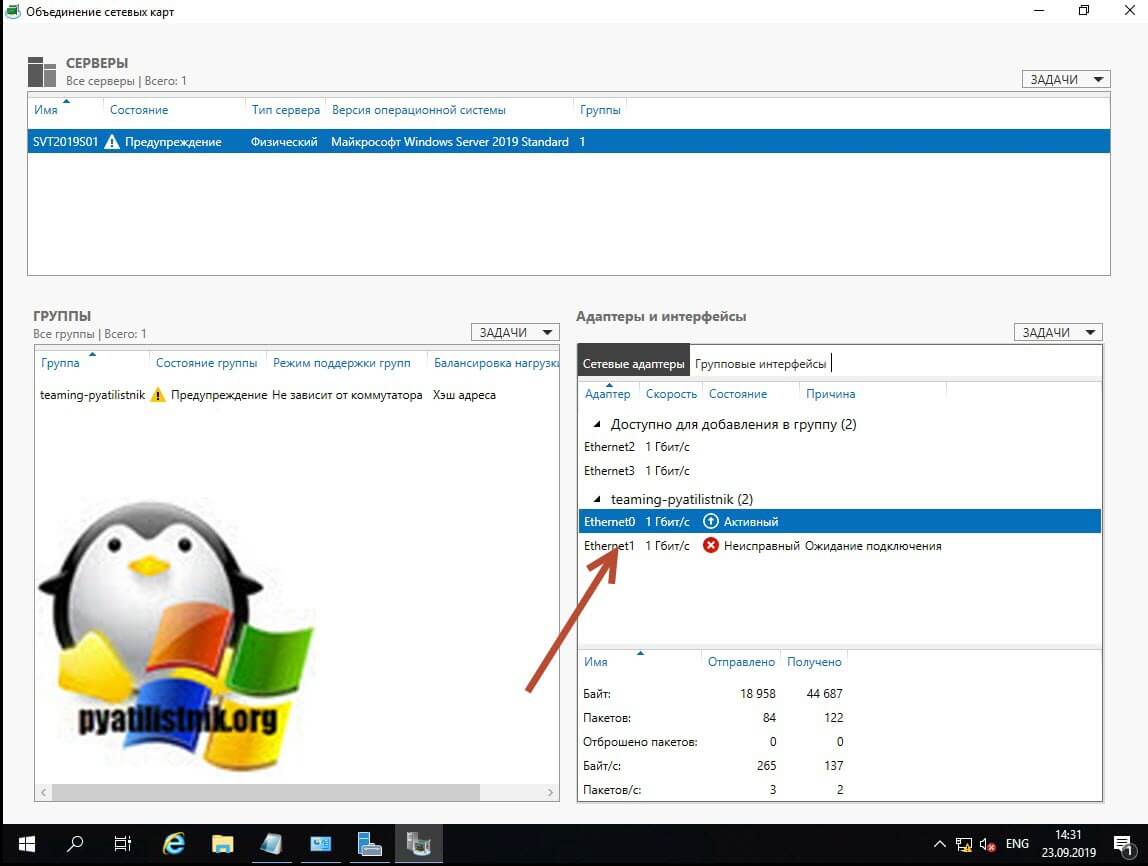

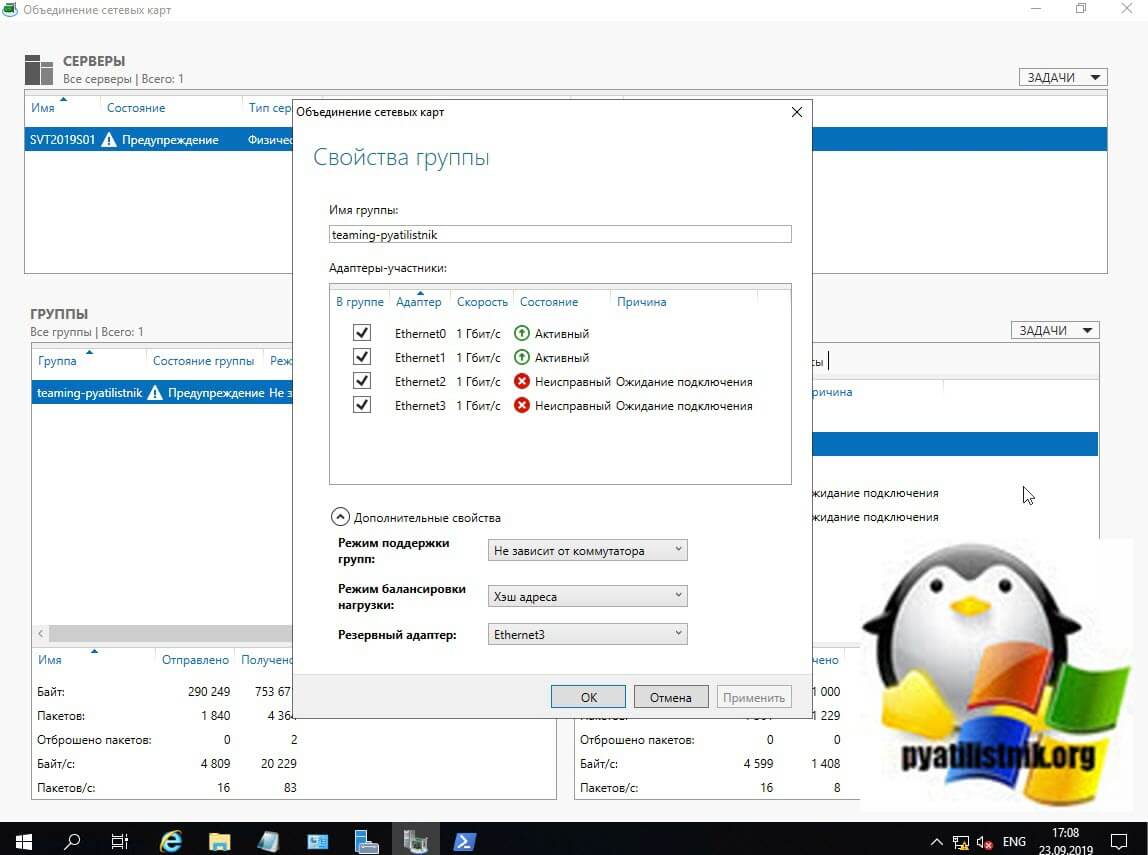

Применяем настройки, в итоге первый сетевой адаптер у вас сразу будет в зеленом, активном состоянии, дополнительный сетевой адаптер, может легко иметь статус «Неисправный, ожидает подключения». Связано это с тем, что идет сборка NIC Teaming, так что можете не беспокоиться.

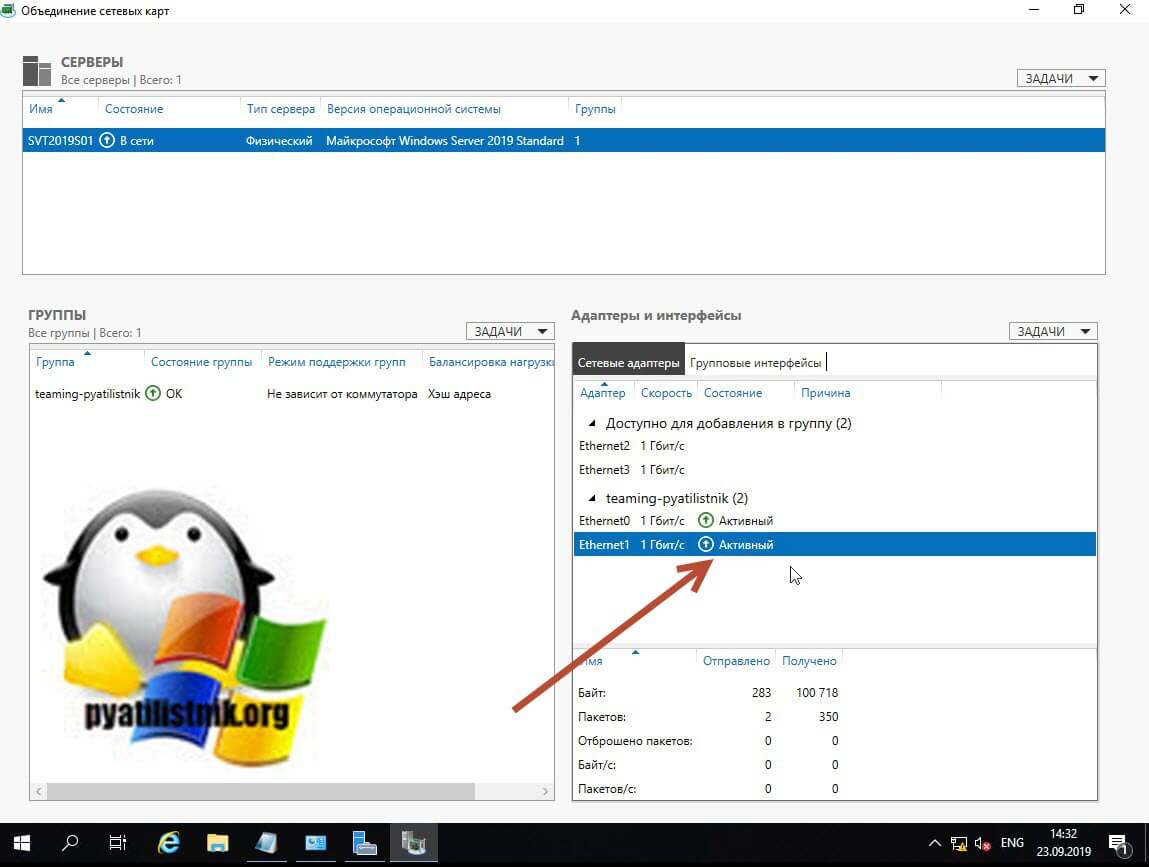

Через пару секунд мы видим, что оба адаптера имеют статус «Активный» и все зелененькое.

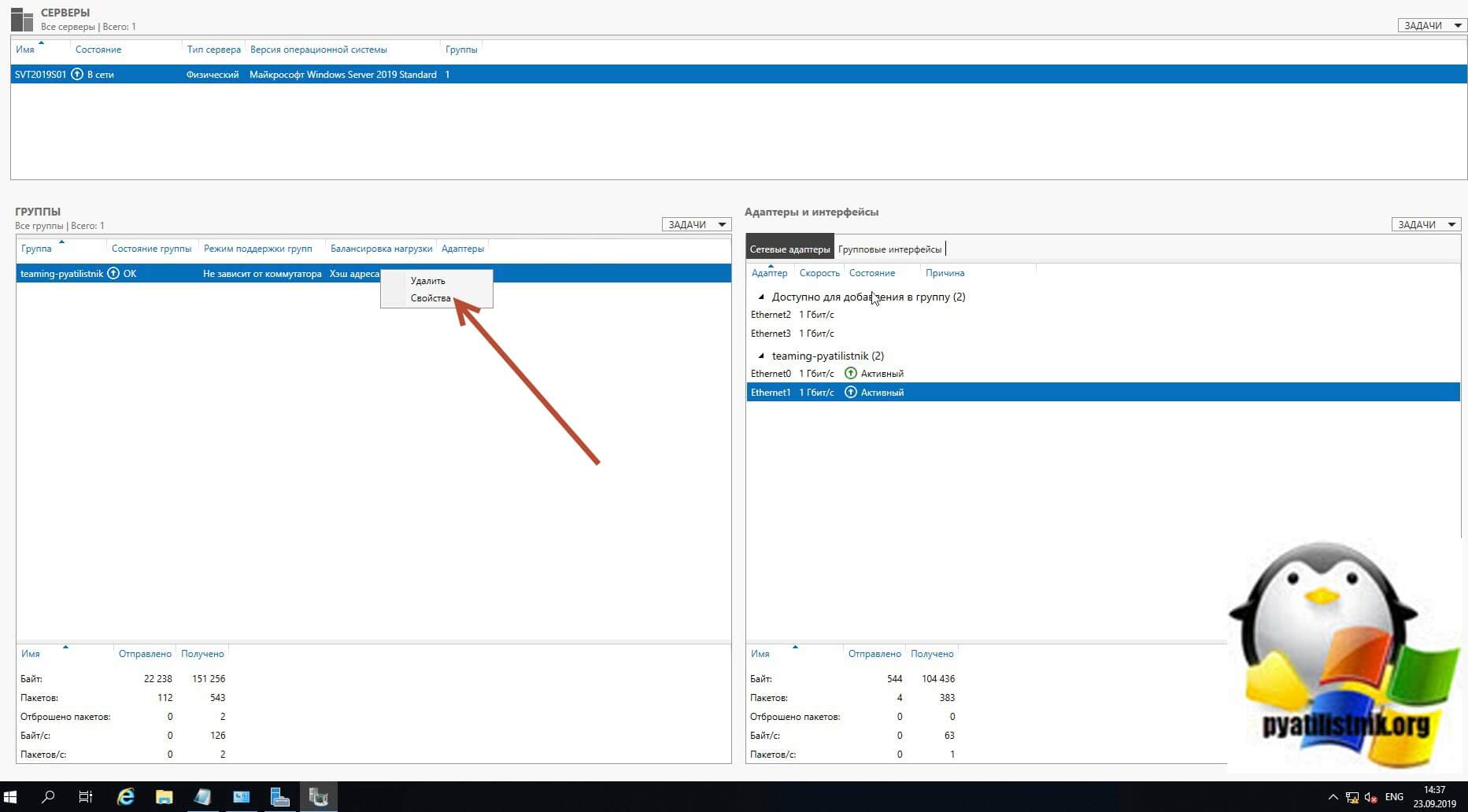

В левой части вы будите видеть вашу группу объединенных сетевых интерфейсов и ее текущие настройки. Если необходимо их поменять, то кликаем по группе правой кнопкой мыши и из контекстного меню выберите пункт «Свойства«.

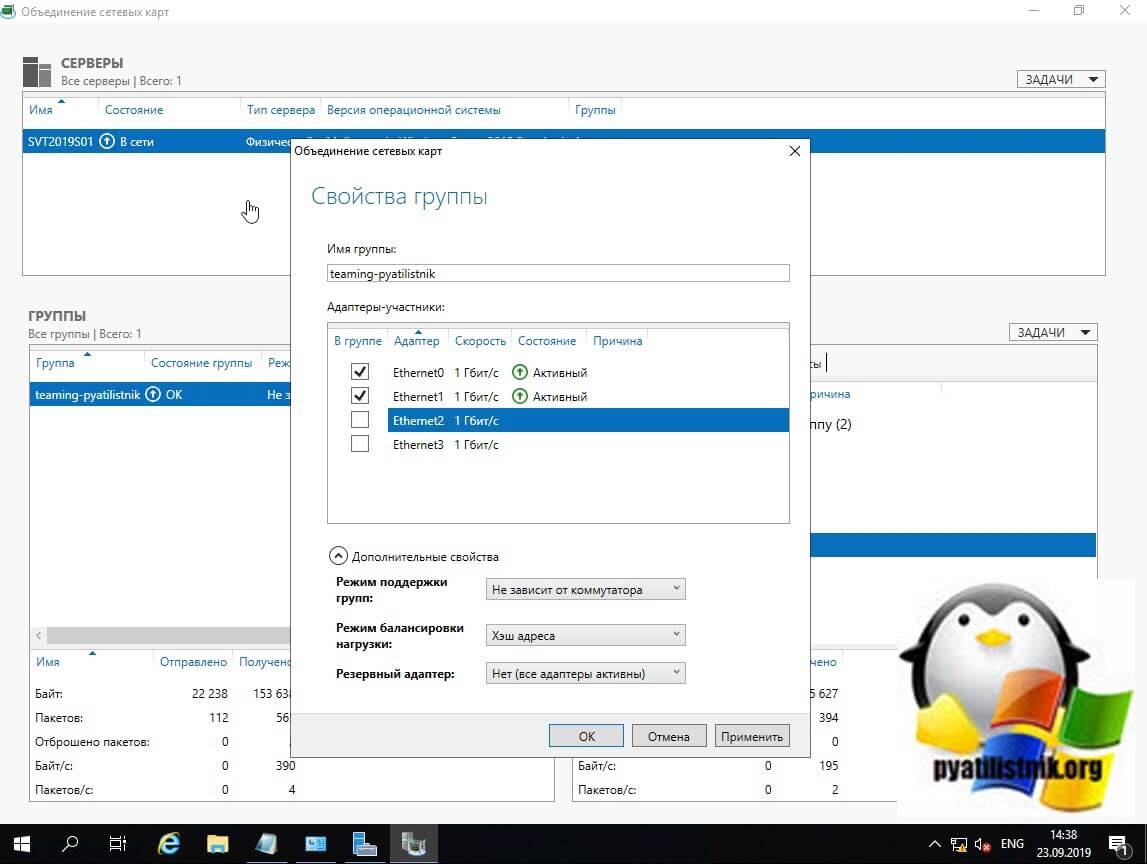

В результате у вас откроется знакомое вам окно со всеми свойствами группы.

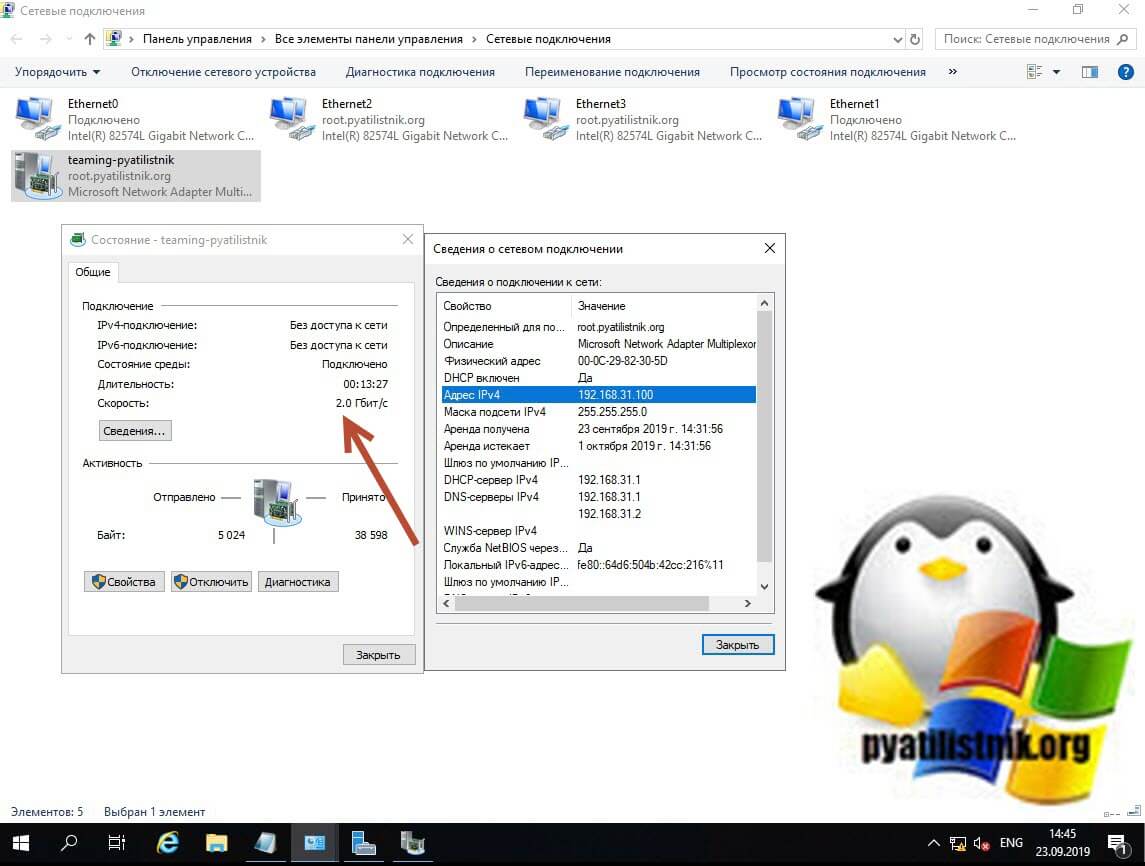

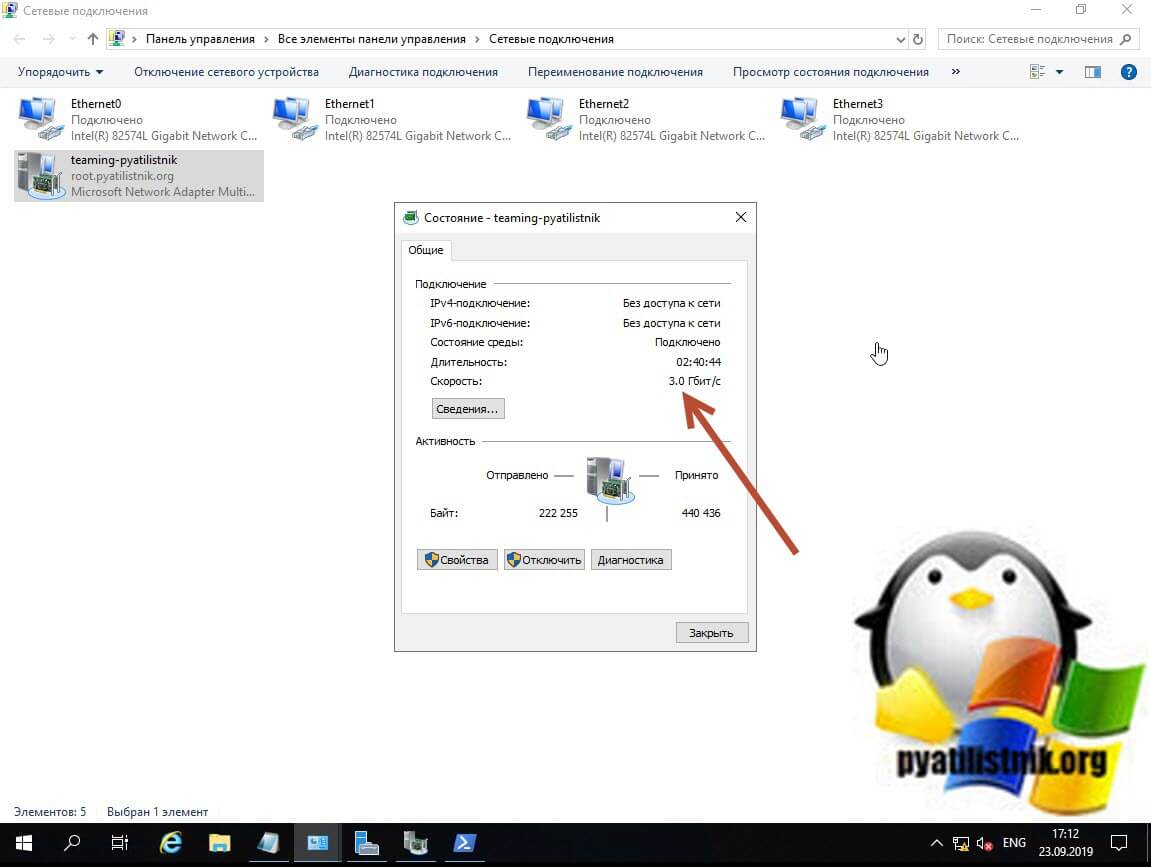

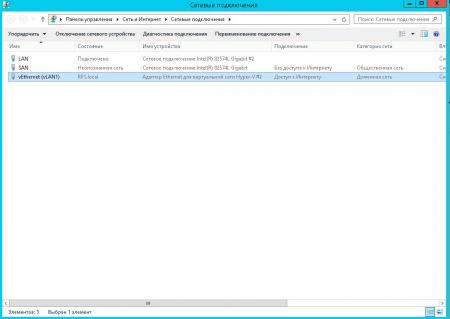

Теперь давайте мы с вами откроем окно «Сетевые подключения», обратите внимание, что у вас появился новый виртуальный адаптер (Microsoft Network Adapter Multiplexor Driver). У него своеобразный значок, отличный от обычных карт, открыв его свойства вы сразу можете увидеть, что его скорость стала 2 Гбит/с, это логично, у нас же произошло сетевое объединение двух адаптеров по 1 Гбит/с. Открыв свойства подключения, я вижу, что получил динамический IP-адрес от моего DHCP сервера, при желании вы можете задать статические настройки.

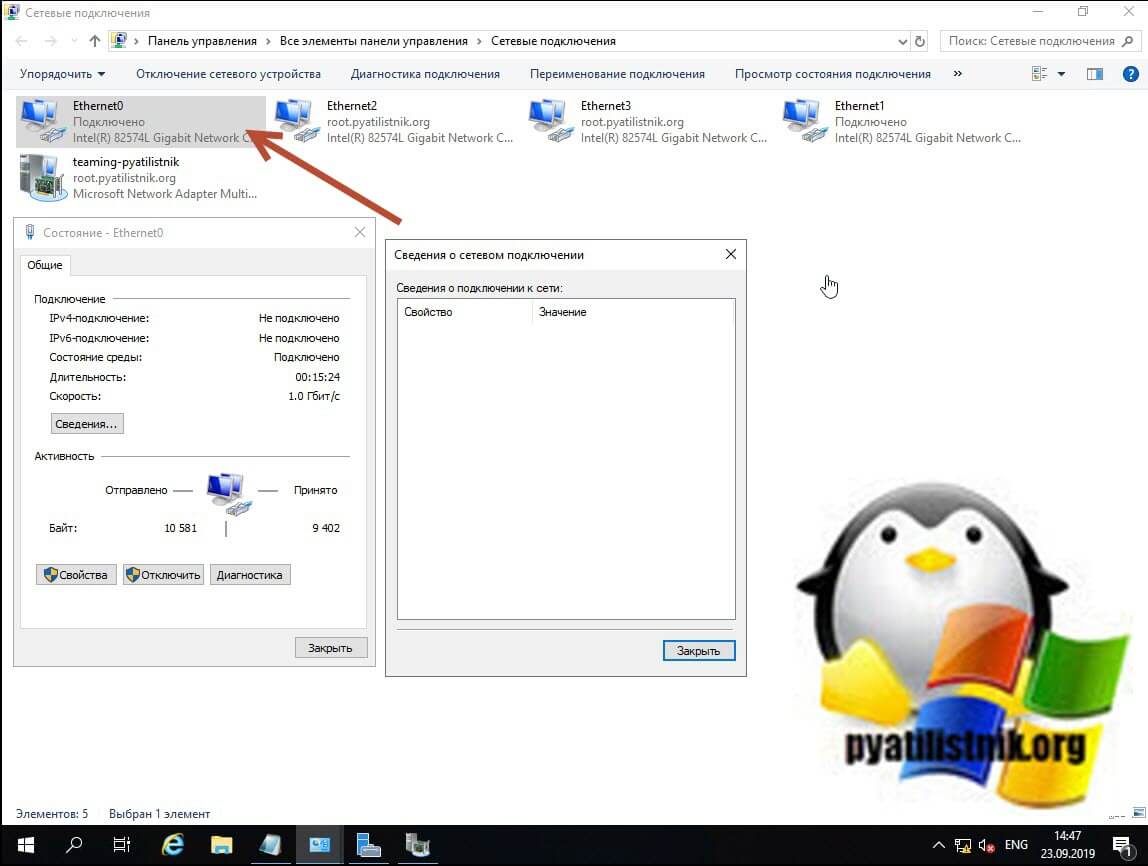

Если вы теперь попытаетесь посмотреть свойства любого из сетевых адаптеров участвующих в тиминге, то у них уже не будет своего IP-адреса, так как он выступает в роли силинка (Это можно сравнить с обычным патч кордом подключенным от коммутатора к серверу)

Убедиться в том, что это силинк можно. так же увидев, что в свойствах адаптера отключены пункты IP версии 4 и 6.

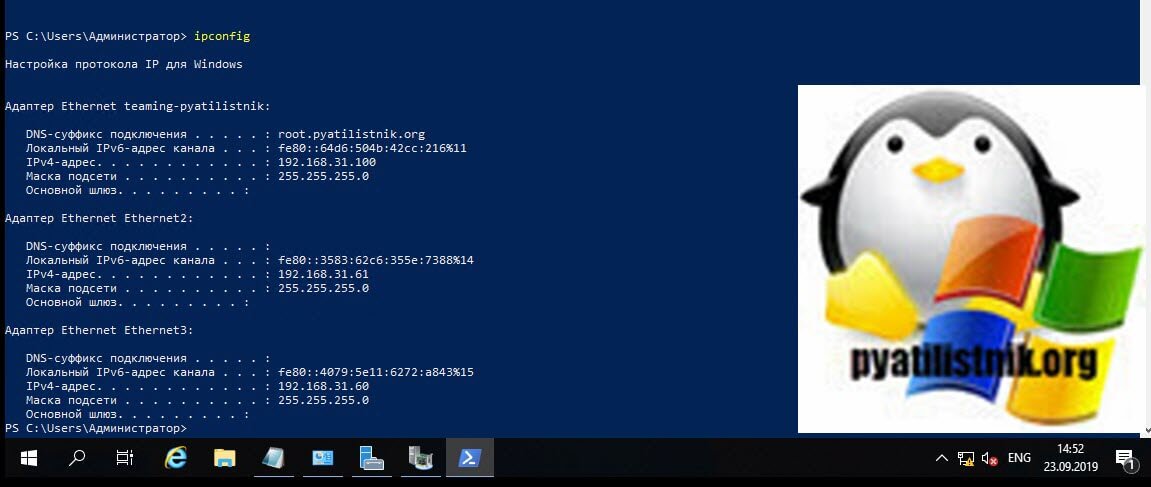

Так же это можно проверить, через команду IPCONFIG, которая выведет три сетевых интерфейса.

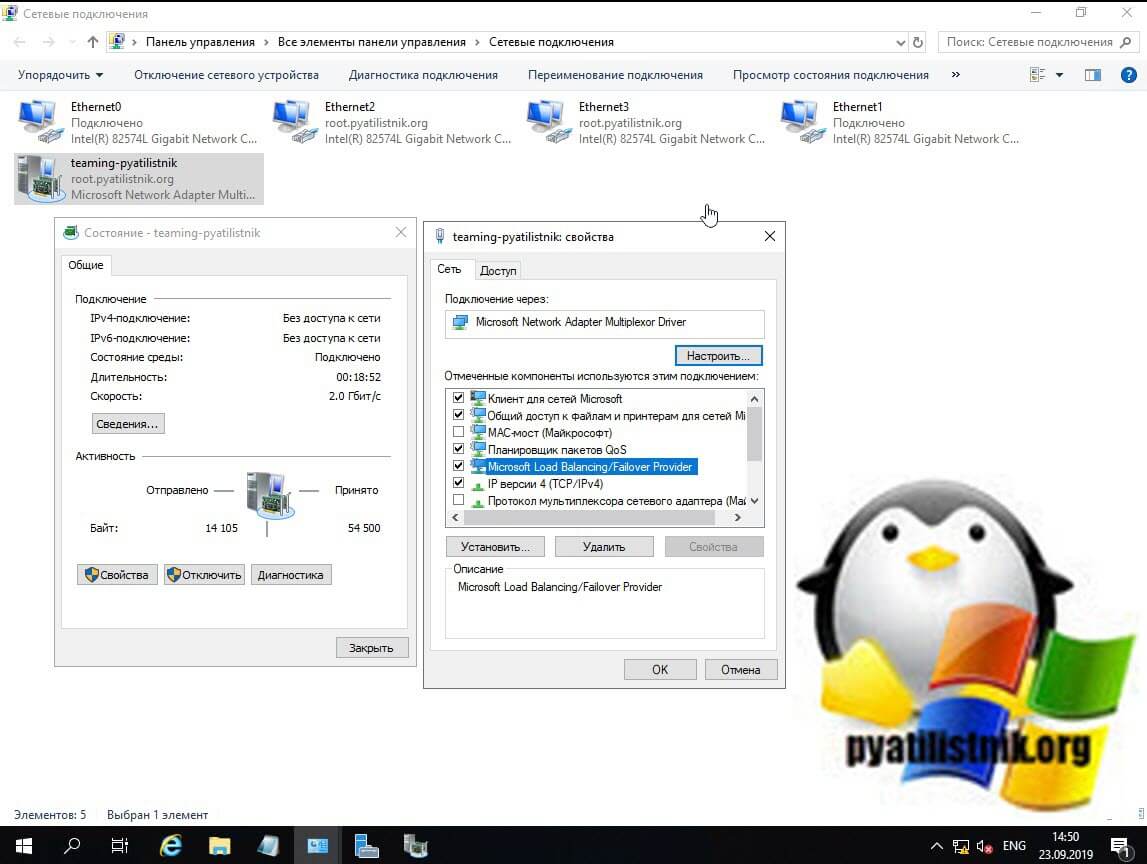

Еще хочу обратить внимание, что на интерфейсе NIC Teaming появился новый драйвер «Microsoft Load Balancing/Failover Provider«, он и участвует в алгоритме балансировки трафика.

Добавление и исключение сетевых адаптеров из NIC Teaming

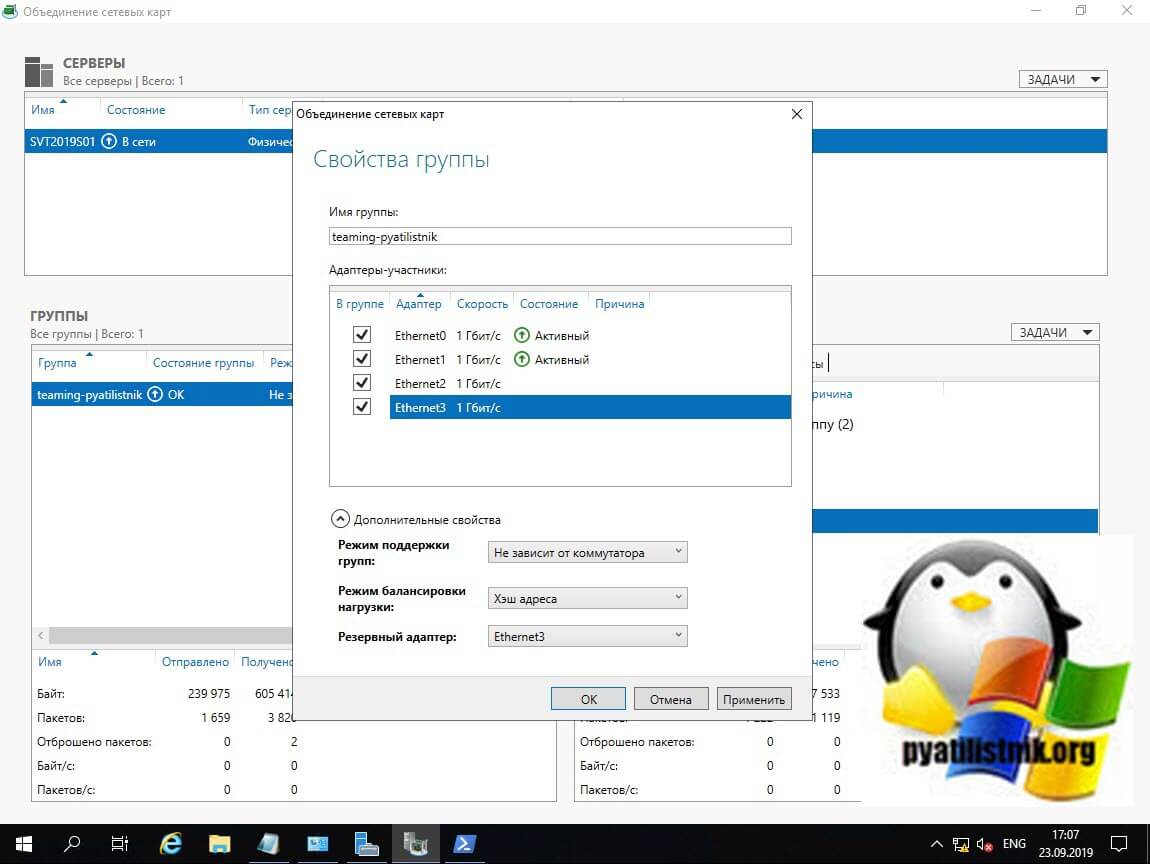

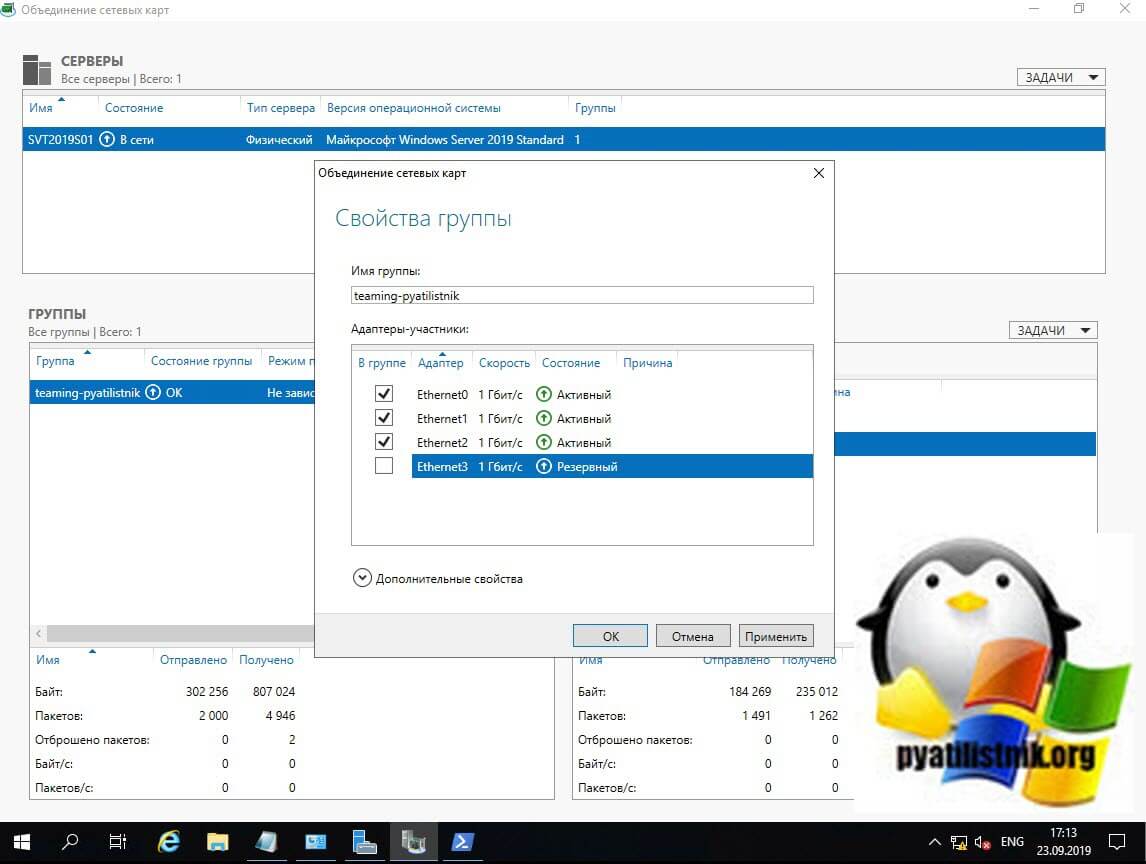

Давайте я в свою группу teaming-pyatilistnik добавлю третий сетевой адаптер. Для этого в диспетчере серверов в свойствах группы поставьте галки на против нужных. Я добавлю сетевые адаптеры «Ethernet2» и «Ethernet3», последний у меня будет, как резервный. Применяем.

Так же ждем настройки.

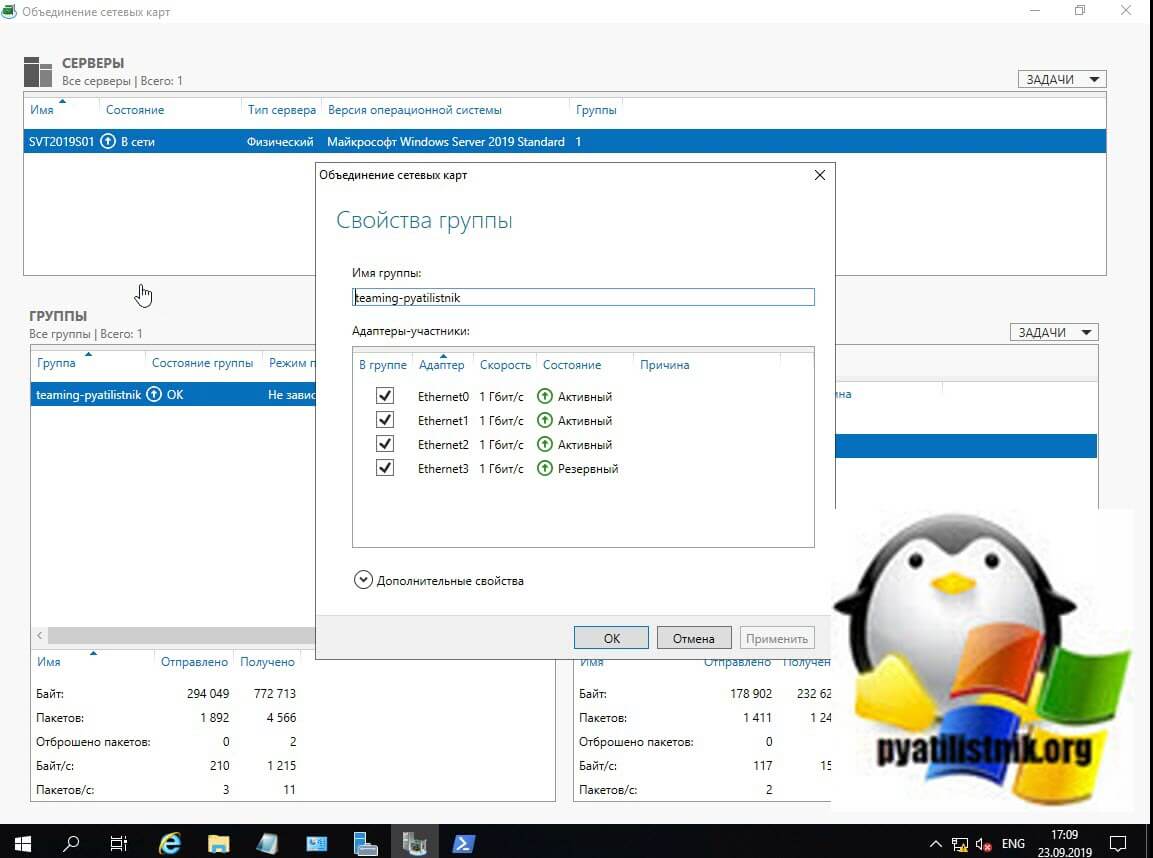

В итоге мы расширили наше объединение сетевых адаптеров, три активных и один резервный.

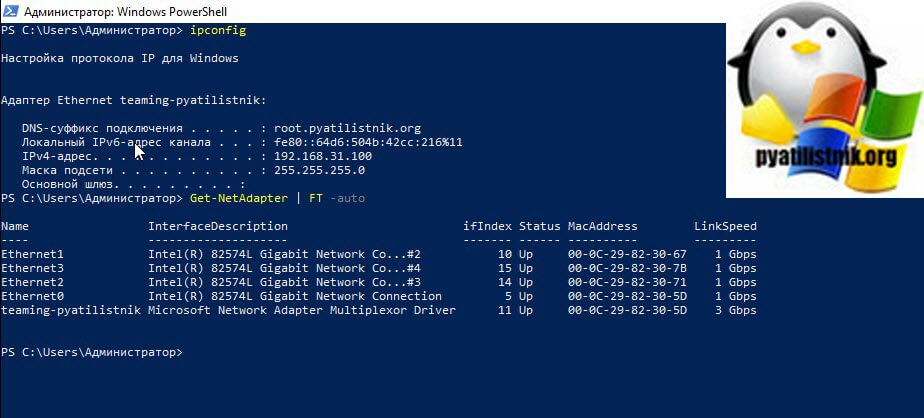

Проверяем утилитой IPCONFIG, видим, что в моей Windows Server 2019 один сетевой интерфейс, но 4-ре физических адаптера. Тиминг готов.

Благодаря этому, я добился пропускной способности в 3 Гбит/с и с одним резервным адаптером.

Для того, чтобы удалить один из сетевых адаптеров из NIC Teaming, в свойствах просто снимаем галку.

Удаление происходит практически моментально.

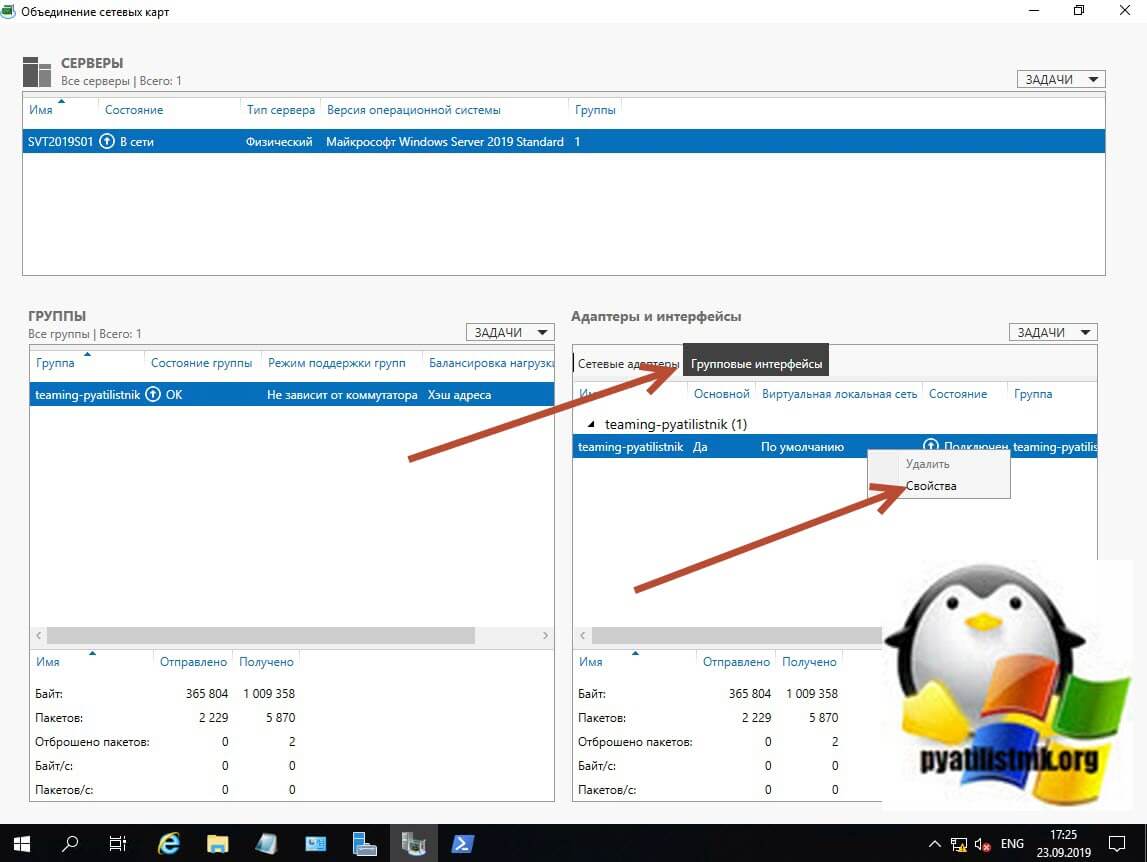

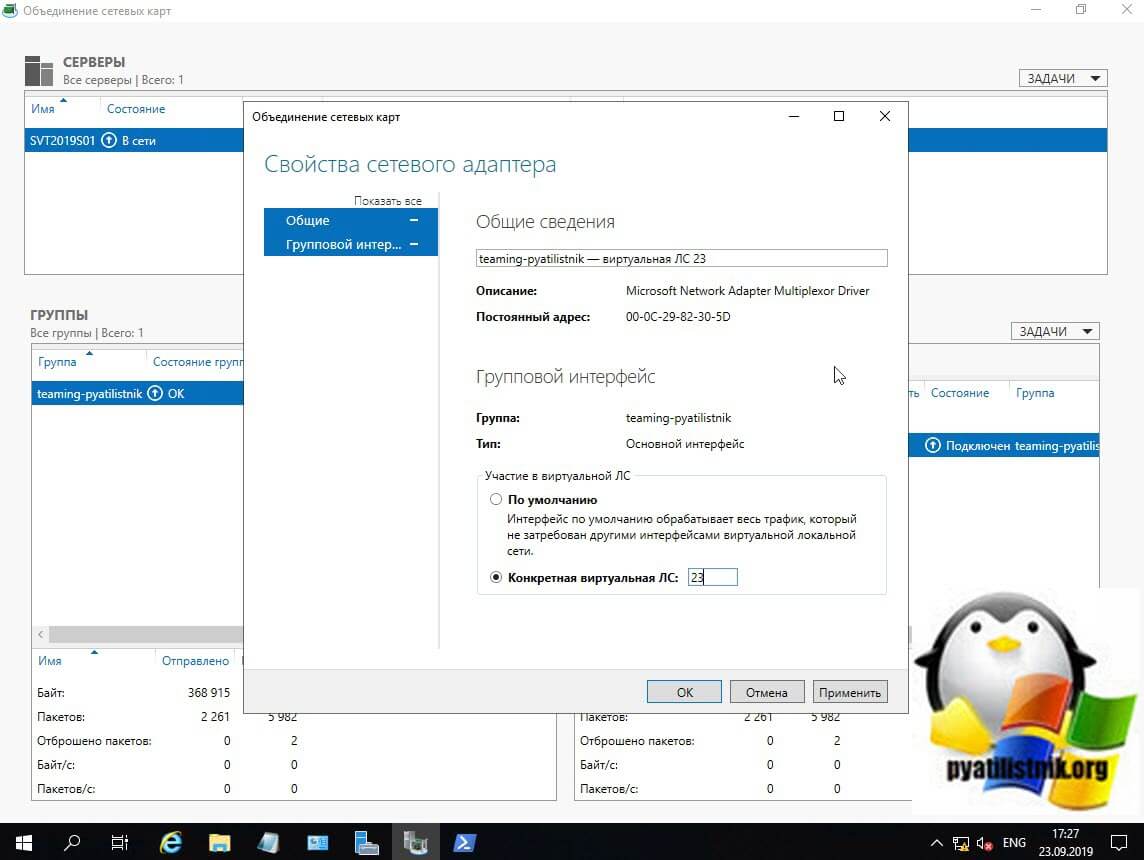

Добавление группового интерфейса в нужный VLAN

Я уверен, что у вас не плоская сеть и вы используете VLAN для разделения трафика. Настроить номер VLAN можно в диспетчере задач, вкладка «Групповые интерфейсы«, вызовите свойства вашей группы сетевых адаптеров.

Ставим галку «Конкретная виртуальная ЛС», где в определенном поле нужно указать номер VLAN, обратите внимание, что данный номер будет дописан в название NIC Teaming.

- Перед включением объединения сетевых карт настройте порты физического коммутатора, подключенные к узлу Teaming, для использования режима магистрали (неизбирательного). Физический коммутатор должен передавать весь трафик на узел для фильтрации без изменения трафика.

- Не настраивайте фильтры VLAN на сетевых адаптерах с помощью параметров дополнительных свойств сетевого адаптера. Разрешите программе объединения сетевых карт или виртуальному коммутатору Hyper-V (при наличии) выполнить фильтрацию виртуальных ЛС.

Если вы планируете использовать VLAN внутри виртуальной машины Hyper-V, то настраивать виртуальную ЛС нужно на виртуальном коммутаторе, а не на группе объединения сетевых карт. Если у вас стоит задача в виртуальной машине использовать несколько виртуальных сетей, то вы каждый порт коммутатора настраиваете на нужный VLAN, никогда не делайте это внутри виртуальной машины. Если же вы используете виртуальные функций SR-IOV (VFs), то обязательно проверьте, что они находятся в одном VLAN, перед тем как их будите объединять.

Создание NIC Teaming через PowerShell

Чтобы создать сетевое объединение интерфейсов через командлеты, вам нужно открыть PowerShell от имени администратора. Первым делом вам нужно посмотреть список физических адаптеров, для этого введите:

Get-NetAdapter | FT -auto

В моем примере их 4-ре. Предположим, что я хочу объединить в NIC Teamin первые два адаптера «Ethernet1» и «Ethernet2».

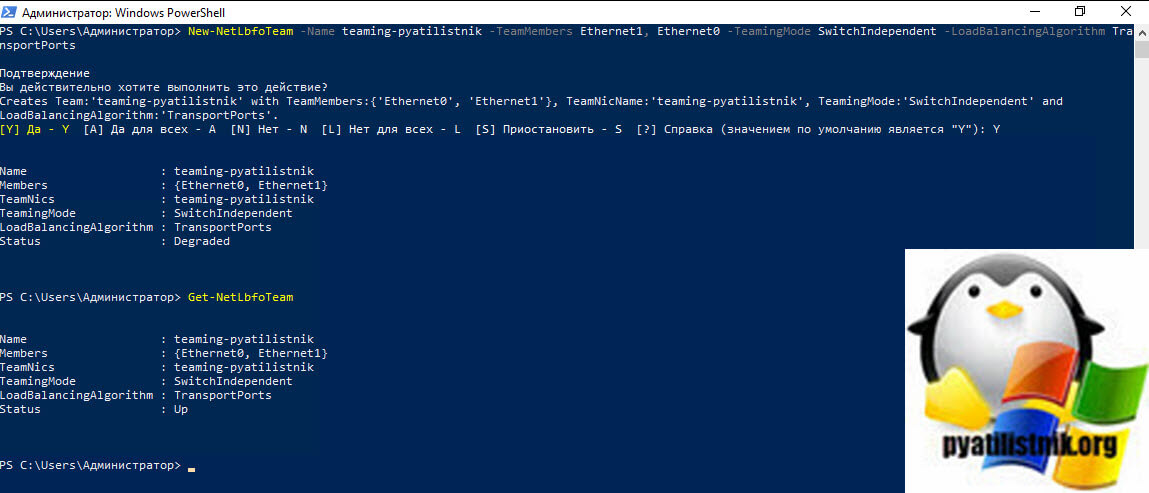

Для создания мы будем использовать командлет New-NetLbfoTeam.

New-NetLbfoTeam -Name teaming-pyatilistnik -TeamMembers Ethernet1, Ethernet0 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm TransportPorts

- -Name -Мы задаем имя нашего объединения сетевых карт

- -TeamMembers — указываем, какие сетевые адаптеры мы будем объединять

- -TeamingMode — режим поддержки групп

- -LoadBalancingAlgorithm — Режим балансировки

Ключи TeamingMode

- LACP (Link Aggregation Control Protocol (LACP, IEEE 802.1ax))

- Static (Статическая поддержка групп (Static Teaming) (IEEE 802.3ad draft v1))

- SwitchIndependent (Не зависит от коммутатора (Switch Independent))

Ключи LoadBalancingAlgorithm

- TransportPorts — это Хэш адреса (Address Hash)

- HyperVPort — это Порт Hyper-V (Hyper-V Port)

- Dynamic — это Динамический (Dynamic)

- IPAddresses — Использует IP-адреса источника и назначения для создания хэша, а затем назначает пакеты, которые имеют совпадающее значение хэша, одному из доступных интерфейсов. При указании этого алгоритма с TeamingMode параметром и значением SwitchIndependent весь входящий трафик поступает на основной интерфейс группы.

- MacAddresses — Использует исходные и целевые MAC-адреса для создания хэша, а затем назначает пакеты, которые имеют совпадающее значение хэша, одному из доступных интерфейсов. При указании этого алгоритма с TeamingMode параметром и значением SwitchIndependent весь входящий трафик поступает на основной интерфейс группы.

Вас спросят, действительно ли вы хотите создать объединенную группу сетевых интерфейсов, говорим «Y». Сразу вы увидите статус «Degraded», через некоторое время уже «Up».

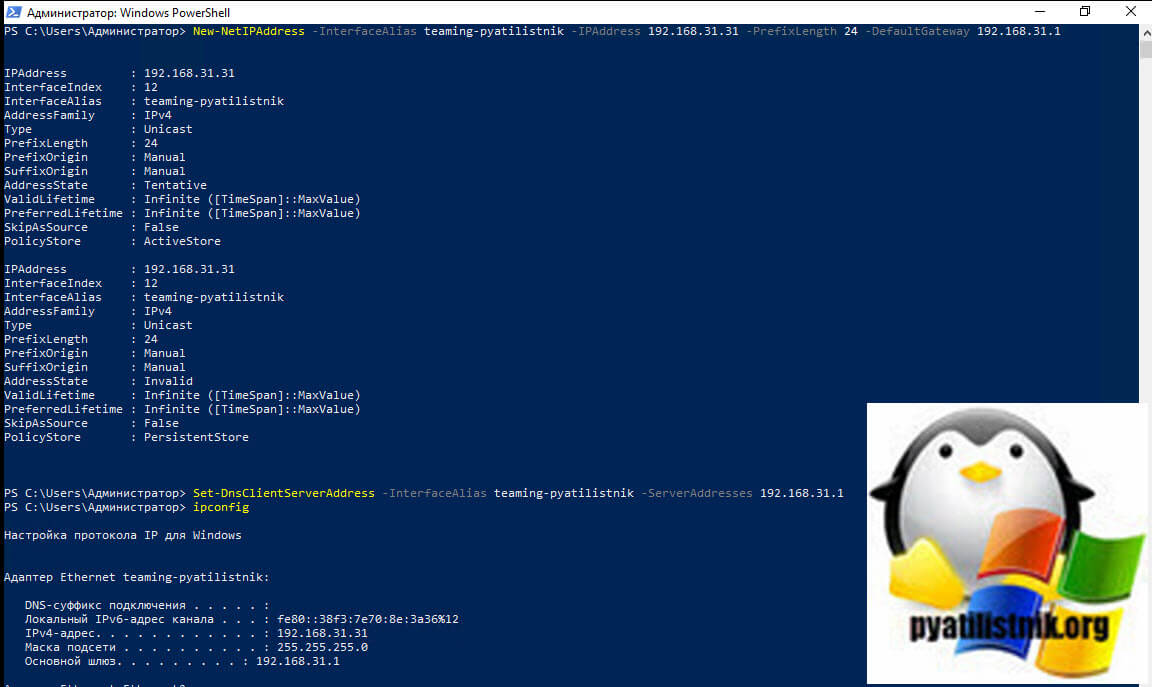

Хочу отметить, что если вы явным образом не задаете статические настройки сетевого адреса, то вы получите его от DHCP, если же стоит задача задать конкретный IP-адрес, то это можно сделать командой

New-NetIPAddress -InterfaceAlias teaming-pyatilistnik -IPAddress 192.168.31.31 -PrefixLength 24 -DefaultGateway 192.168.31.1

Set-DnsClientServerAddress -InterfaceAlias teaming-pyatilistnik -ServerAddresses 192.168.31.1

Дополнительные примеры New-NetLbfoTeam https://docs.microsoft.com/en-us/powershell/module/netlbfo/new-netlbfoteam?view=win10-ps

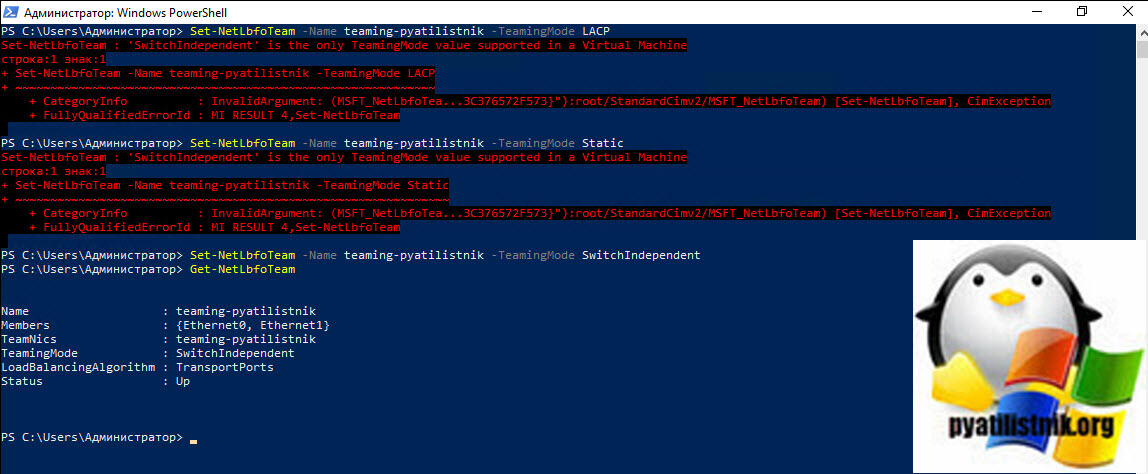

Если нужно изменить поменять настройки вашей тиминговой группы, то для этого есть командлет Set-NetLbfoTeam. Допустим я хочу, чтобы режим поддержки групп был LACP, команда будет выглядеть вот так:

Set-NetLbfoTeam -Name teaming-pyatilistnik -TeamingMode LACP

Хочу отметить, что если вы попытаетесь, как и в моем примере сделать, это на виртуальной машине, то получите ошибку;

Set-NetLbfoTeam : ‘SwitchIndependent’ is the only TeamingMode value supported in a Virtual Machine

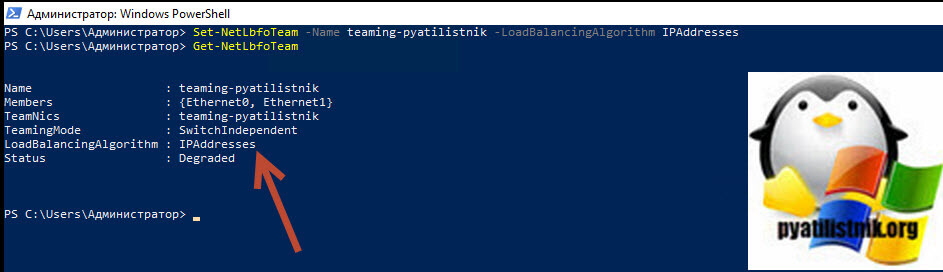

Она вам прямым текстом скажет, что на виртуалках можно использовать только режим SwitchIndependent, на железных серверах все будет работать. Теперь давайте поменяем режим балансировки на IPAddresses, для этого пишем:

Set-NetLbfoTeam -Name teaming-pyatilistnik -LoadBalancingAlgorithm IPAddresses

Дополнительную информацию, о командлете Set-NetLbfoTeam можете посмотреть по ссылке https://docs.microsoft.com/en-us/powershell/module/netlbfo/set-netlbfoteam?view=win10-ps

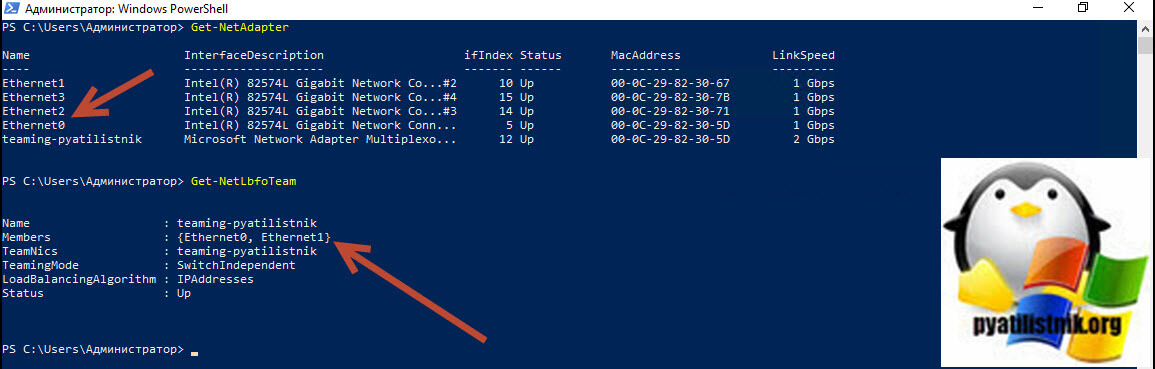

Добавление сетевых адаптеров из NIC Teaming через PowerShell

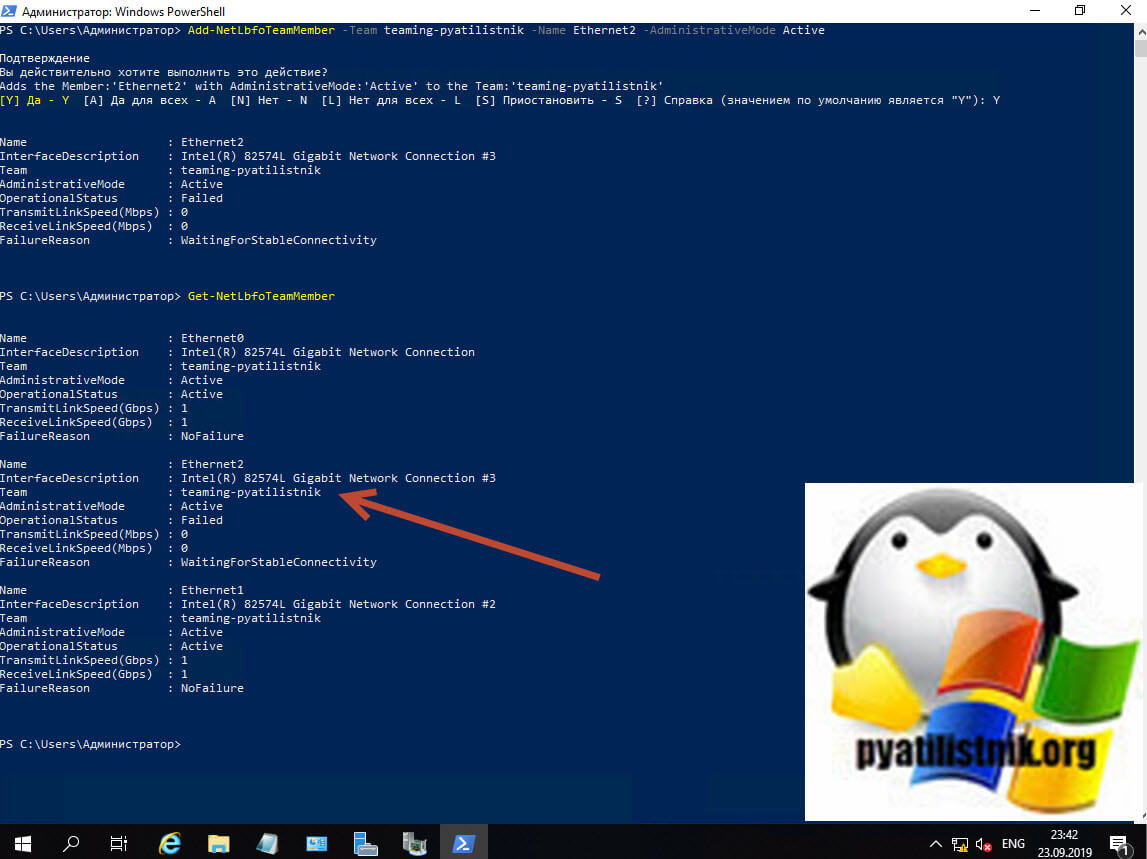

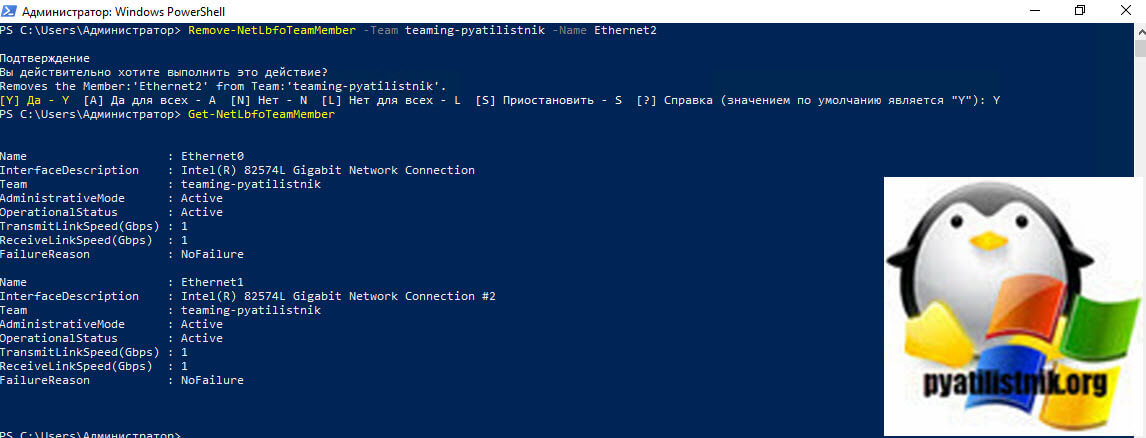

Предположим, что вы решили добавить еще один сетевой адаптер в объединение сетевых интерфейсов, как видим у меня NIC Teaming состоит из адаптеров «Ethernet0» и «Ethernet1», я добавлю «Ethernet2»

Пишем команду:

Add-NetLbfoTeamMember -Team teaming-pyatilistnik -Name Ethernet2 -AdministrativeMode Active (Или Standby)

Удаление сетевых адаптеров из NIC Teaming через PowerShell

Если стоит задачу удалить сетевой адаптер из вашей группы объединенных сетевых интерфейсов, то выполним команду:

Remove-NetLbfoTeamMember -Team teaming-pyatilistnik -Name Ethernet2

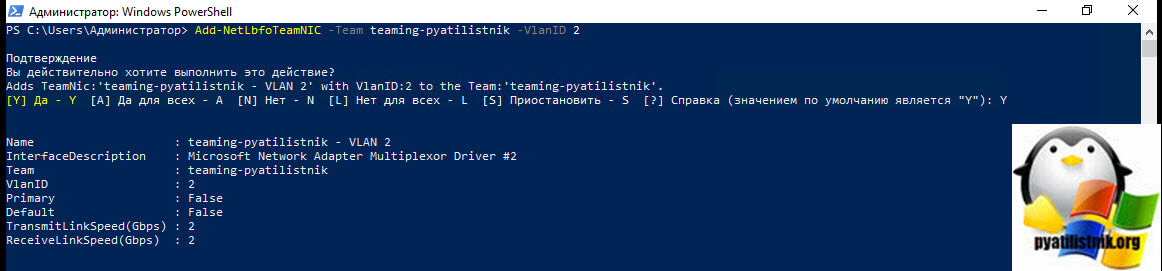

Настройка VLAN на NIC Teaming через PowerShell

Если нужно указать определенную виртуальную сеть (VLAN), то вы можете этого добиться командой:

Add-NetLbfoTeamNIC -Team teaming-pyatilistnik -VlanID 2

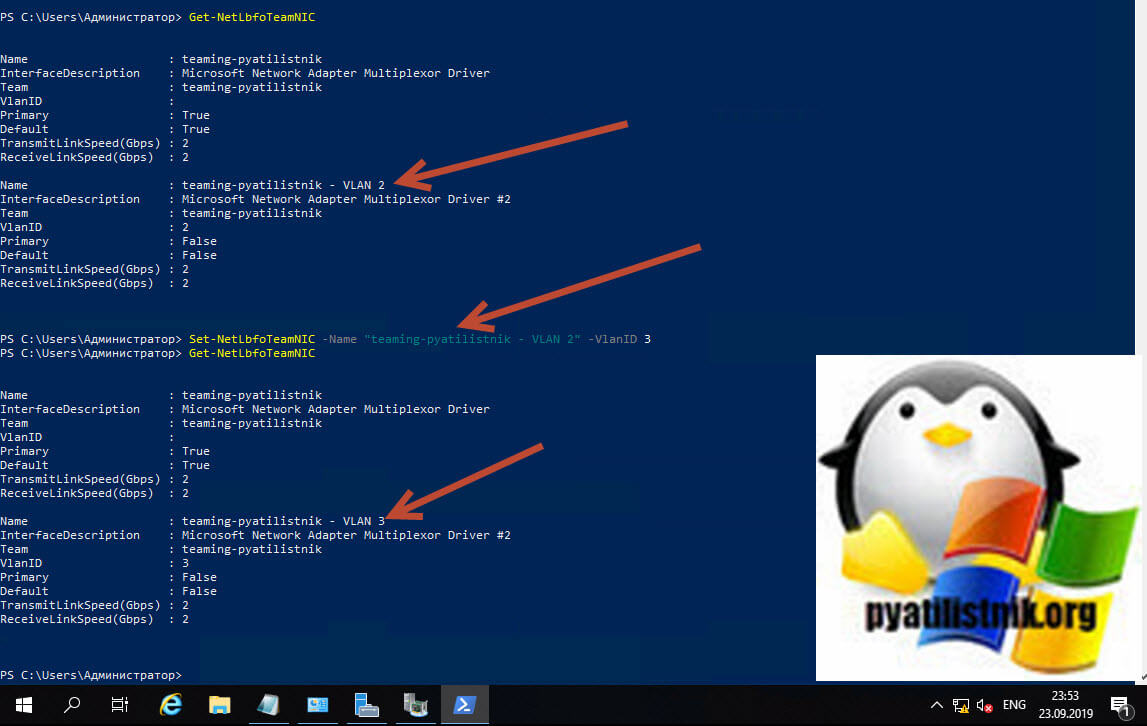

Изменить командой Set-NetLbfoTeamNIC -Name «teaming-pyatilistnik — VLAN 2« -VlanID 3 (Меняем VLAN 2 на 3)

Обратите на имя главного интерфейса в группе «teaming-pyatilistnik — VLAN 2«

Вернуть VLAN по умолчанию, обязательно смотрите «Primary» интерфейс

Set-NetLbfoTeamNic -Name «teaming-pyatilistnik« -Default

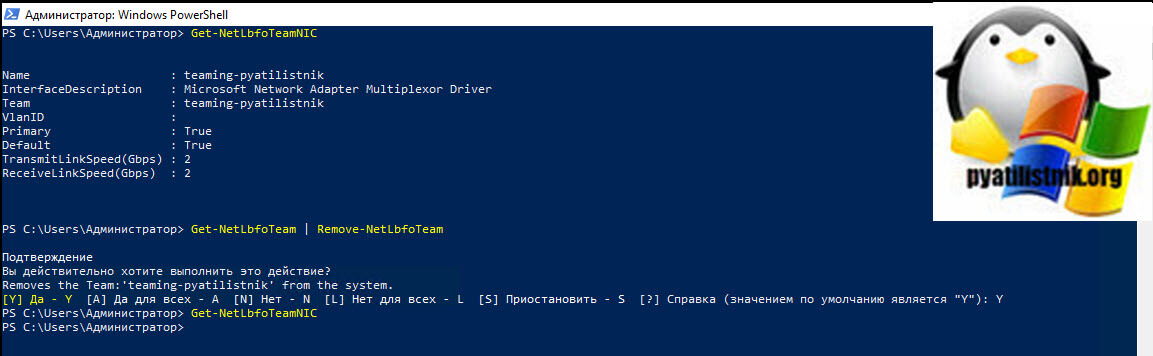

Удаление группы сетевых интерфейсов через PowerShell

Для удаления есть команда:

Remove-NetLbfoTeam -Name teaming-pyatilistnik

Чтобы удалить все тиминги, введите Get-NetLbfoTeam | Remove-NetLbfoTeam

На этом у меня все. Мы разобрали создание, настройку, редактирование, удаление объединения сетевых интерфейсов в операционной системе Windows Server 2019. С вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org.

В данной инструкции мы рассмотрим варианты настройки сетей Hyper-V, расскажем для чего служат каждый тип виртуального коммутатора и базовую настройку каждого из них.

Используются 2 виртуальные машины на ОС Windows Server 2019. Для выполнения действий ниже необходимо иметь процессор с поддержкой аппаратной виртуализации, а также в настройках BIOS/UEFI включить виртуализацию. Также необходимо установить Hyper-V.

Для того, чтобы создать виртуальное сетевое устройство необходимо зайти в Диспетчер Hyper-V → Диспетчер виртуальных коммутаторов. На выбор Hyper-V предлагает 3 типа коммутаторов: внешний, внутренний и частный. Разберемся для чего нужен каждый из них.

Настройка внешней сети

Если вам необходимо, чтобы ваша виртуальная машина была доступна в вашей локальной сети и могла выходить в интернет, то выберите тип внешний.

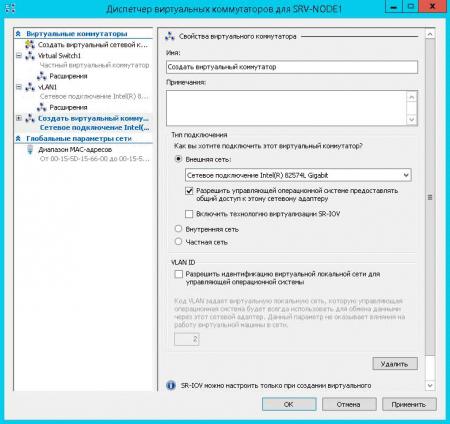

Для этого в диспетчере виртуальных коммутаторов выберете внешний коммутатор, нажмите создать виртуальный коммутатор присвойте ему имя, а затем подключите его к вашей виртуальной машине.

Рисунок 1 — Диспетчер виртуальных коммутаторов

Для этого зайдите в параметры виртуальной машины, выберите слева пункт Установка оборудования, затем в списке справа сетевой адаптер → добавить.

Рисунок 2 — Параметры сетевого адаптера

Далее перейдите в пункт слева сетевой адаптер и в списке виртуальный коммутатор выберете ваш новый виртуальный коммутатор. Теперь он должен появиться внутри ВМ.

Принцип работы с ним практически не отличается от работы с сетевым адаптером на обычном компьютере. В настройках сети вам необходимо будет прописать IP вашего сетевого шлюза (роутера/свича) и назначить IP машины.

Для этого нужно открыть выполнить ввести и открыть ncpa.cpl на виртуальной машине, нажать ПКМ на сетевой адаптер vEthernet (в случае, если на вашей ВМ установлен только один виртуальный сетевой адаптер, то в оснастке он будет единственным), зайти в Свойства → IP версии 4 → Свойства и прописываем IP-адрес, маску подсети и адрес сетевого шлюза.

Далее на ВМ включите сетевое обнаружение. Зайдите в Панель управления → Центр управления сетями и общим доступом → Изменить дополнительные параметры общего доступа и в каждом профиле сети включите сетевое обнаружение.

Рисунок 3 — Настройка общего доступа

Затем попробуйте запустить ping до машины по этому внешнему адресу. Если ВМ пингуется, значит она доступна для других устройств в локальной сети.

Настройка внутренней сети

Если вы хотите настроить доступ с вашей хост-машины и между виртуальными машинами, то выбирайте тип внутренний.

В данном случае сетевой шлюз указывать не нужно; только прописать IP-адрес и маску подсети и включить сетевое обнаружение на ВМ.

Также после того, как вы создали внутренний коммутатор, на хост-машине зайдите в выполнить (Win+R) → введите ncpa.cpl → Enter. Там вы обнаружите Hyper-V Virtual Ethernet Adatpter, зайдите в свойства этого устройства и также пропишите IP-адрес и маску подсети в свойствах IPv4 в свойствах адаптера, чтобы хост-машина смогла взаимодействовать с ВМ по внутренней сети.

Обратите внимание! Для того, чтобы виртуальные машины и хост-машина смогли общаться между собой по внутреннему виртуальному коммутатору, необходимо, чтобы они были в одной подсети.

Например:

Вы назначили ВМ1 IP-адрес 187.255.1.1 и маску подсети 255.255.255.0

Значит, у ВМ2 и хост-машины должен быть IP-адрес в диапазоне 187.255.1.2-254 и такая же маска подсети.

Проверяем работу внутренней сети так же через PING.

Рисунок 4 — Скриншот с хост-машины

Настройка частной сети

Если вам нужна сетевая коммуникация только между ВМ, то выберите частную сеть.

Частная сеть практически ничем не отличается от внутренней; только тем, что хост-машина не может подключаться к виртуальным машинам.

Действия для настройки частной сети идентичны таковым при внутренней, с тем отличием, что виртуальный сетевой адаптер не появится на хост-машине, и вам нужно будет только прописать сетевые конфигурации ВМ в ncpa.cpl.

Что такое Default Switch?

Этот тип виртуального коммутатора создаётся гипервизором автоматически и использует технологию NAT для выхода в интернет.

Подходит только в тех случаях, когда на ВМ вам нужен только выход в интернет.

IP-адрес назначается автоматически и динамически, что значит, что он будет постоянно меняться, а hostname не успевать обновляться, поэтому не подходит для настройки сетевого взаимодействия между виртуальными машинами и устройствами в локальной сети.

Видеоинструкция

В последних нескольких статьях мы говорили о Hyper-V 2019 и рассказывали вам о процедуре установки, начальной настройки и развертывания вашей первой виртуальной машины. Если вы пропустили эти статьи, вы можете проверить их по следующим ссылкам:

Часть 1. Установка Hyper-V 2019 Server Core

Часть 2. Базовый сервер Hyper-V 2019 — начальная настройка

Часть 3. Удаленное управление ядром Hyper-V 2019

Часть 4. Создание первой виртуальной машины в Hyper-V 2019

Часть 5. Экспорт и импорт виртуальной машины в Hyper-V 2019

В этой статье мы расскажем вам, как настроить виртуальные сетевые карты на ваших виртуальных машинах. Прежде всего, мы должны определить, какой тип связи требуется для виртуальных машин. Речь идет о связи между виртуальными машинами, виртуальной машиной и хостом или виртуальной машиной и остальной частью сети? Чтобы это было проще понять, мы создадим сценарий. Представьте, что у нас есть база данных SQL, которая работает на Windows Server 2019, и нам нужно было бы сделать ее доступной и доступной всякий раз, когда клиенты из локальной сети захотят связаться с ней, чтобы написать или прочитать запросы. В этом случае нам нужно создать виртуальную сетевую карту, которая позволит виртуальной машине находиться в той же сети, что и все другие сетевые хосты.

- Откройте диспетчер Hyper-V

- Выберите виртуальную машину. В нашем случае это Windows Server 2019. Нам не нужно выключать виртуальную машину.

- С левой стороны щелкните по Virtual Switch Manager … В разделе Create virtual switch мы можем найти три доступных виртуальных коммутатора, включая Внешний, Внутренний и Частный. Так в чем же разница между ними? Внешний коммутатор обеспечивает связь между виртуальной машиной и остальной частью сети. Это то, что нам нужно настроить в нашем сценарии. Внутренний сетевой коммутатор обеспечивает связь между виртуальной машиной и хостом (сервер Hyper-V 2019). Если вы хотите установить связь только между двумя или более виртуальными машинами, вам необходимо использовать частный виртуальный коммутатор.

- Выберите Внешний виртуальный коммутатор и нажмите «Создать виртуальный коммутатор».

- Введите имя виртуального коммутатора и при необходимости напишите заметки. В нашем случае имя внешнего виртуального коммутатора — LAN, а Note — Связь между виртуальной машиной и остальной частью сети.

- В разделе Внешняя сеть выберите физическую сетевую карту, которую вы хотите связать с виртуальной сетевой картой. В нашем случае мы выберем сетевую карту Intel (R) Wi-Fi 6 AX100 1600 МГц. Обратите внимание, что это сервер для тестирования.

- Нажмите Применить

- В следующем окне в разделе «Ожидающие изменения» может нарушиться подключение к сети, нажмите «ОК», чтобы подтвердить создание внешней карты.

- Подождите, пока изменения не будут применены.

- Подтвердите, нажав ОК

- На следующем шаге нам потребуется назначить ранее созданный внешний сетевой коммутатор виртуальной машине. Щелкните правой кнопкой мыши на виртуальной машине и выберите «Настройки».

- В левой части окна нажмите Сетевой адаптер

- Под виртуальным коммутатором выберите ранее созданную сетевую карту. В нашем случае это ЛВС.

- Нажмите Применить, а затем ОК.

- Поздравляю. Вы успешно создали и назначили виртуальный коммутатор для своей виртуальной машины.

Если вы используете DHCP (протокол динамической конфигурации хоста) в своей сети, он автоматически назначит IP-адрес вашему виртуальному сетевому адаптеру. Если у вас нет DHCP, и вы используете статическую адресацию в сети, пожалуйста, назначьте соответствующий статический IP-адрес, который доступен через ту же сеть, что и другие хосты.

Как бы не ругали пользователи Windows 10 но это самая популярная ОС. Серверные ОС Windows Server также не имеют аналогов. Это что касается относительной простоты настройки и дружелюбности к пользователю. Каждый меня поймет кто хоть когда то пытался соорудить нечто подобное Active Directory на Linux. Это небольшое отступление. Но сегодня я хочу рассказать насколько проста установка и настройка Microsoft Hyper-V Server 2019. Это бесплатный гипервизор от Microsoft.

Я долго сравнивал разные бесплатные гипервизоры (Proxmox, VMWare). Мне хотелось чтобы была возможность управлять сервером через WEB и консоль. Рассматривал Proxmox, но совсем не тривиальная настройка меня остановила.

Про Microsoft Hyper-V Server я знал, но в нем не было WEB интерфейса для управления. Хотя подкупал RDP доступ, Hype-V Manager и возможность использовать Powershell со всем его огромным функционалом.

Буквально на днях узнал о существовании WEB консоли для управления WIndows серверами Windows Admin Center. Этот факт подтолкнул меня к установке бесплатного гипервизора от Microsoft последней версии.

Установка Microsoft Hyper-V Server 2019

Перед началом установки необходимо проверить в BIOS что аппаратная виртуализация включена. У Intel — Intel VT (VT-x и VT-d), AMD — AMD-V. Скачать Hyper-V Server 2019 можно с сайта Microsoft. Обычно я использую английскую версию серверного софта для исключения различных проблем с локализацией.

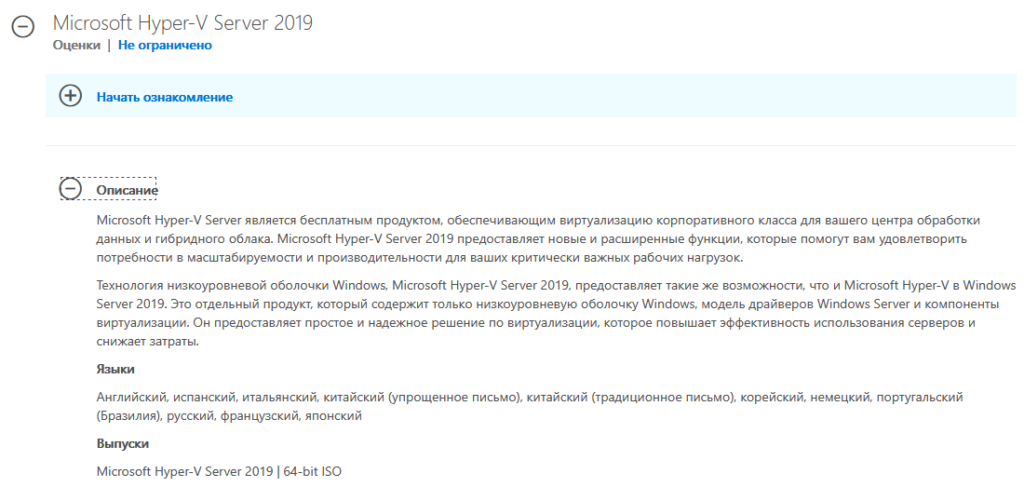

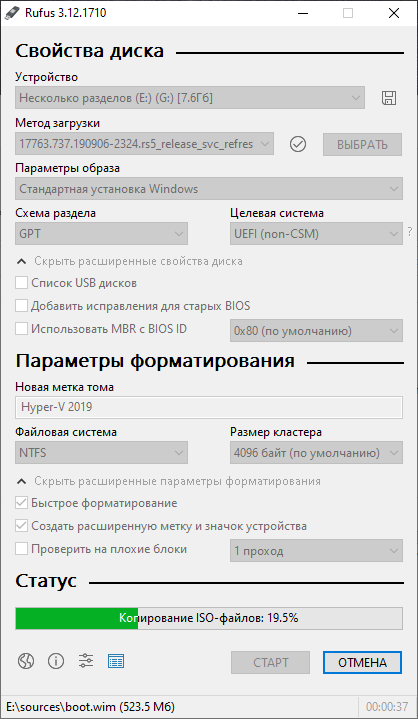

Скачанный ISO файл необходимо записать на USB Flash. Для этих целей я использую Rufus. Используйте накопитель с минимальным объемом не менее 4 Гб.

- Устройство: выбрать ваш Flash накопитель

- Метод загрузки: Диск или ISO нажать кнопку ВЫБРАТЬ и указать ISO образ Hyper-V 2019

- Файловая система: NTFS

Нажать СТАРТ и дождаться окончания записи образа на Flash накопитель.

После окончания записи на флешку можно приступить к установке системы.

Установка системы проста как любой Windows, на этом заострять внимание я не буду.

Настройка Microsoft Hyper-V Server 2019

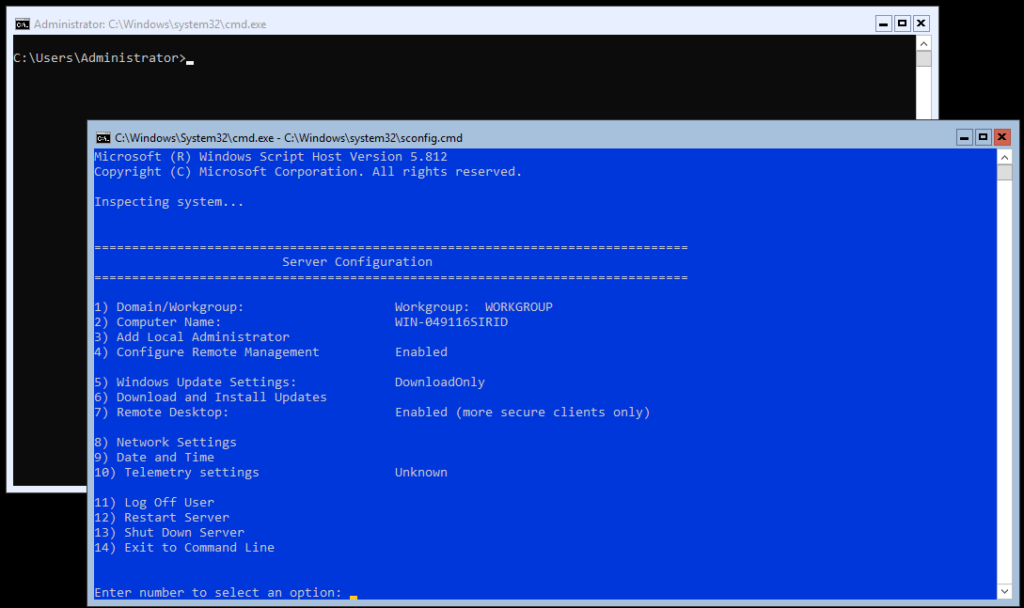

Пройдя авторизацию в Hyper-V Server возникнет окошко Server Configuration с основными настройками сервера. Для использования каждого пункта нажимаем соответствующую цифру и далее Enter.

- Domain/Workgroup — добавить сервер в рабочую группу либо домен. По умолчанию используется рабочая группа WORKGROUP

- Computer Name — имя компьютера. Можно оставить автоматически присвоенное либо изменить на свое.

- Add Local Administrator — добавить локального администратора. Позволяет добавить нескольких локальных администраторов. По умолчанию включен только один администратор с логином Administrator

- Configure Remote Management — настройка разрешений удаленного управления сервером для подключения с помощью Powershell, WEB консоли и т.д.

- Windows Update Settings — установка обновлений Windows. Возможные варианты: Automatic — полностью автоматически, DownloadOnly — только скачать, Manual — ручной режим.

- Download and Install Updates — скачать и установить обновления. Непосредственный запуск установки обновлений.

- Remote Desktop — удаленный доступ к рабочему столу. Необходимо включить для удаленного доступа по RDP. Можно использовать RDP with NLA и RDP any. RDP with NLA для использования на клиентах Windows XP SP3 и выше, более безопасный и быстрый вариант. RDP any для использования на любых клиентах Windows, Linux, Android и т.д.

- Network Settings — доступ к настройкам сетевой карты. Изменить IP, маску, DNS и т.д.

- Date and Time — открывает окошко настройки времени с возможностью изменить сервер синхронизации

- Telemetry settings — сбор сведений телеметрии. Для выбора есть Security, Basic, Enhanced, Full.

- Log Off User — выйти из текущей сессии

- Restart Server — перезагрузить сервер

- Shut Down Server — выключить сервер

- Exit to Command Line — закрыть текущее окно настроек и оставить активным только окно командной строки.

Проведем первоначальные настройки сервера с помощью консоли Server Configuration

Изменим имя компьютера на WHS19. Включим удаленное управление Remote Management и Remote Desktop. Windows Update Settings я оставляю в изначальном состоянии DownloadOnly. Меняю часовой пояс на свой и настройки телеметрии ставлю Secutiry. Сетевые настройки приходят по DHCP (не забываем сделать резервацию) или вручную. После измененных настроек рекомендую перезагрузить сервер.

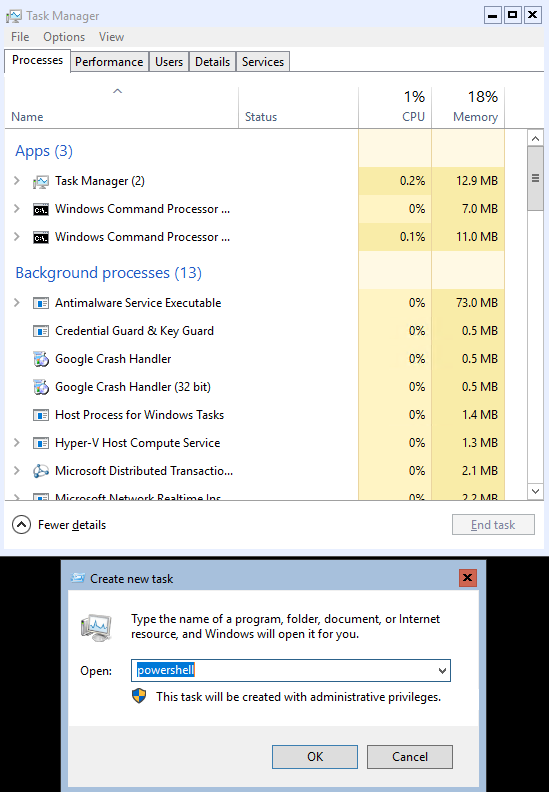

Если по чистой случайности вы закрыли оба окна (консоль cmd и Server Configuration) можно воспользоваться сочетанием клавиш Ctrl+Shift+Esc и вызвать диспетчер задач.

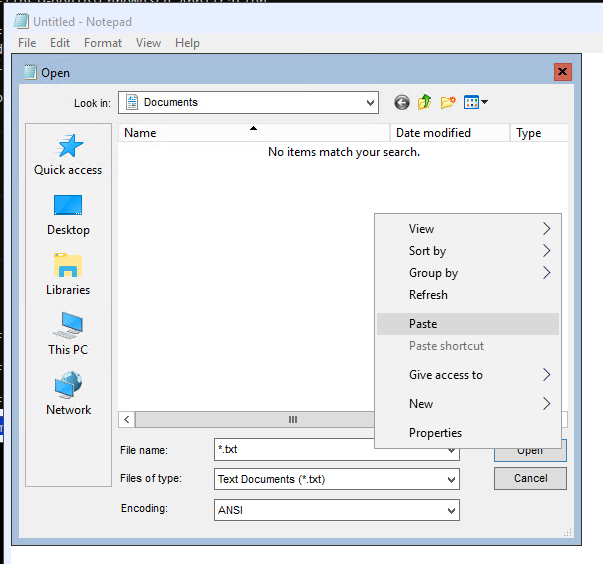

В диспетчере задач меню File — Run new task можно запустить cmd, powershell и любое приложение установленное в системе. Небольшой лайфхак: как быстро скопировать файл со своей машины на сервер Hyper-V Core. Заходим на сервер по RDP, запускаем блокнот. В блокноте нажимает File — Open. На своем компьютере выбираем нужный файл и копируем его в буфер обмена. На сервере в открытом окне блокнота нажимаем правой кнопкой и выбираем вставить. Файл скопируется в текущее место открытое в блокноте.

Настройка дисков

В моём сервере установлено 3 диска. На одном диске установлена система, два других под виртуальные машины и резервные копии. Запустим Powershell из консоли cmd.

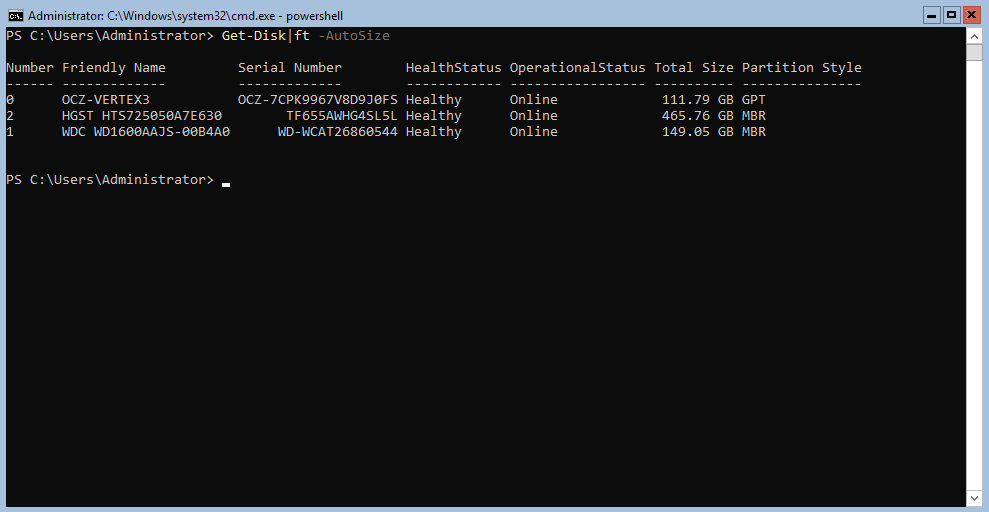

Получим список дисков установленных в сервере

В моем случае система установлена на диск 0 — OCZ-VERTEX3. Диск 1 WDC WD1600AAJS я буду использовать под виртуальные машины. И самый емкий из установленных диск 2 HGST HTS725050A7E630 использую под резервные копии. Подготовим диски.

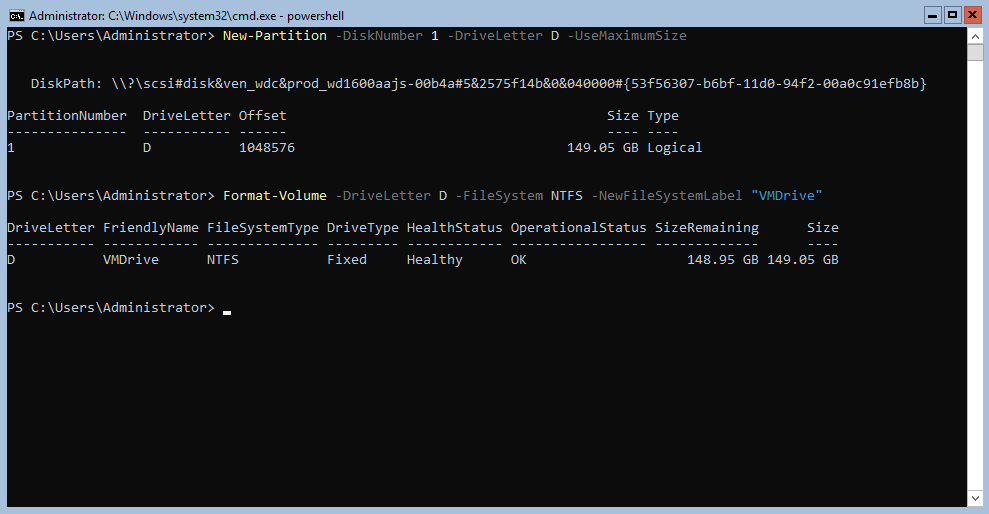

Создадим новый раздел на диске и присвоим ему букву D.

New-Partition -DiskNumber 1 -DriveLetter D –UseMaximumSize

Отформатируем диск под файловую систему NTFS

Format-Volume -DriveLetter D -FileSystem NTFS -NewFileSystemLabel "VMDrive"

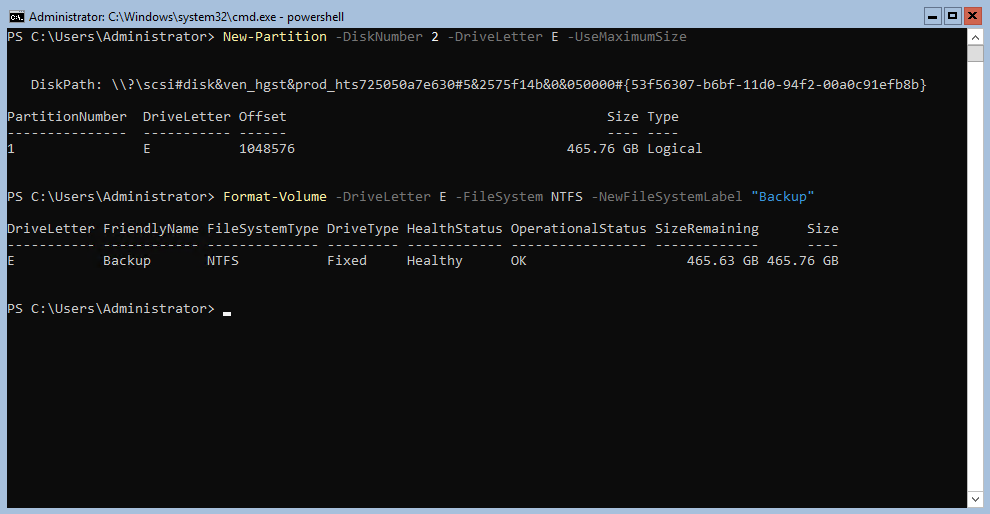

Создаем новый раздел на диске HGST для резервных копий и присвоим диску букву E

New-Partition -DiskNumber 2 -DriveLetter E –UseMaximumSize

Форматируем диск E

Format-Volume -DriveLetter E -FileSystem NTFS -NewFileSystemLabel "Backup"

Место хранения виртуальных машин

По умолчанию система сохраняет новые виртуальные машины на диск C. Изменим путь сохранения на диск D

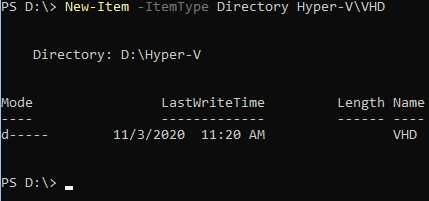

Создаем папку для хранения виртуальных машин и дисков

New-Item -ItemType Directory D:Hyper-VVHD

Укажем системе куда сохранять настройки и диски виртуальных машин

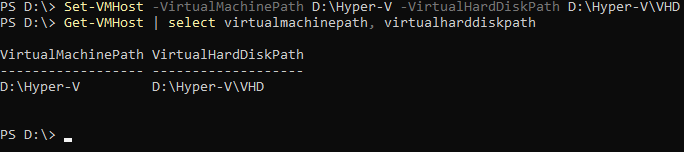

Set-VMHost -VirtualMachinePath D:Hyper-V -VirtualHardDiskPath D:Hyper-VVHD

Проверим что все получилось

Get-VMHost | select virtualmachinepath, virtualharddiskpath

Настройка виртуального коммутатора Hyper-V

Нам необходимо создать виртуальный коммутатор который будет связан с сетевой картой сервера Hyper-V. Он будет получать сетевые адреса также по DHCP как и остальные физические машины в сети.

Проверим поддерживает ли наша сетевая карта технологию SR-IOV (Single Root Input/Output Virtualization). Данная технология виртуализации предоставляет виртуальным машинам прямой доступ к части аппаратных возможностей сетевой карты.

Если данная технология поддерживается, необходимо ее включить командлетом Enable-NetAdapterSriov. После создания виртуального коммутатора включить данную технологию уже не получится.

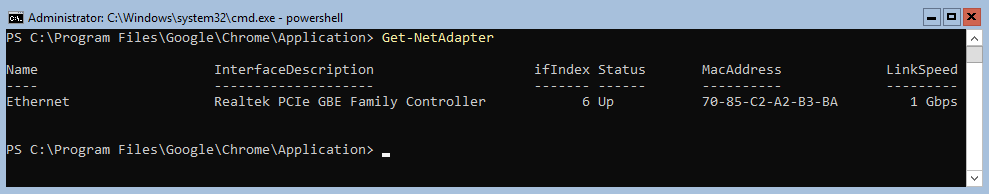

Получим список всех сетевых адаптеров установленных в системе.

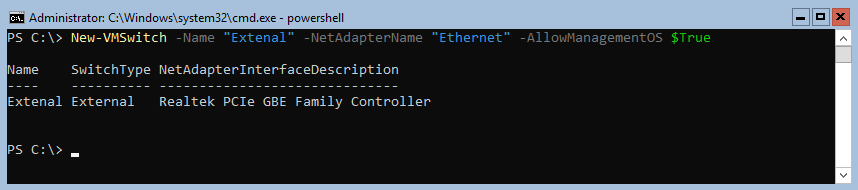

Создадим новый виртуальный коммутатор с именем External. Он будет использоваться как внешний сетевой адаптер получающий адреса по DHCP. При создании включим функцию совместного использования виртуального коммутатора и сетевой карты с виртуальной машиной.

New-VMSwitch -Name "External" -NetAdapterName "Ethernet" -AllowManagementOS $True

Просмотреть детальную информацию по сетевым настройкам можно так

Get-NetIPConfiguration –Detailed

Enhanced Session Mode

Включение функции Enhanced Session Mode позволит подключиться к консоли виртуальной машины используя RDP соединение. С той лишь разницей что подключение будет не к самой виртуальной машине а через средства интеграции гипервизора. Данный метод позволяет подключаться к виртуальной машине даже с отсутствующей сетевой картой. Для себя я вижу удобство именно в подключении к виртуальным машинам с изолированной сетью. Нет необходимости запускать консоль Hyper-V, все можно сделать через RDP.

Основные преимущества Enhanced Session Mode

- можно выбрать произвольное разрешение экрана

- использование локальных принтеров

- перенаправление USB устройств

- подключение дисков

- общий буфера обмена

- работа с аудиоустройствами

- проброс смарт-карт

- поддержка остальных plug-and-play устройств

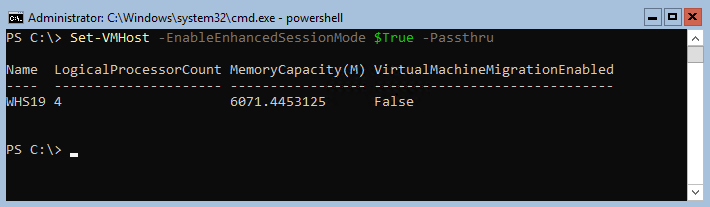

Включим данный режим сразу для всего сервера

Set-VMHost -EnableEnhancedSessionMode $True -Passthru

Удаленное управление Microsoft Hyper-V Server 2019

Удаленное управление Hyper-V сервером доступно многими средствами. Среди них консоль Hyper-V Manager, Powershell, Windows Admin Center, MMC. Для удаленного управления сервером Hyper-V необходимо произвести настройки на сервере и на каждом клиенте с которого будет подключение. Настройку клиента буду проводить на Windows 10 Pro (минимально необходимая версия).

Если сервер используется в сети с доменом, то необходимо добавить запись типа A в DNS сервер (обычно это контроллер домена). В случае рабочей группы просто добавляем имя сервера Hyper-V в файл C:WindowsSystem32driversetchosts. В моем случае запись будет выглядеть так:

Вначале идет IP адрес сервера: 172.16.169.49 далее через пробел имя WHS19. В случае использования файла hosts не забываем добавлять запись на каждой машине используемой для управления сервером.

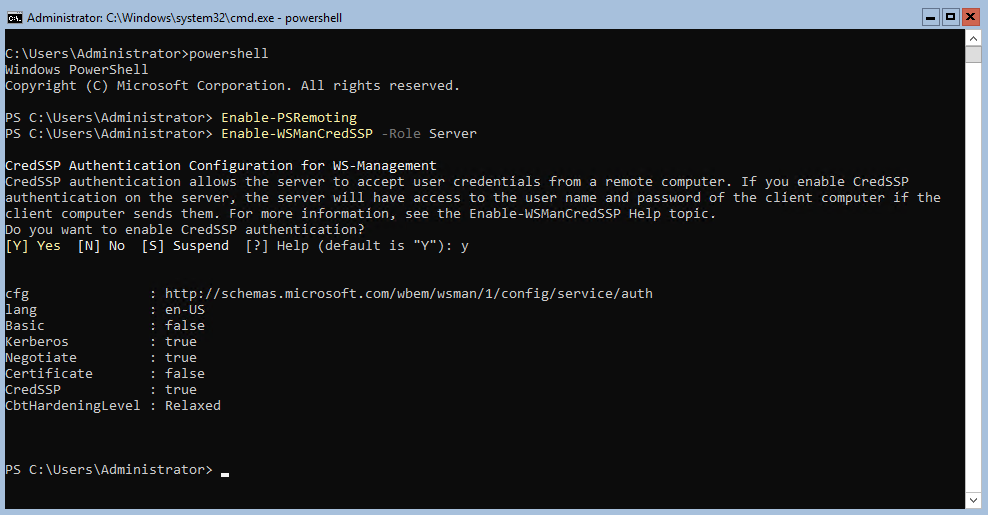

На сервере Hyper-V запустим Powershell и выполним командлет для разрешения удаленного подключения

По умолчанию данный командлет открывает доступ только из доменной и приватной сети. Разрешим доступ также из публичной сети.

Enable-PSRemoting -SkipNetworkProfileCheck -Force

Включаем поддержку проверки подлинности CredSSP на стороне сервера

Enable-WSManCredSSP -Role Server

Проверим что на сервере открыт порт WinRM

Test-NetConnection -ComputerName WHS19 -Port 5985

В выводе командлета поле TcpTestSucceeded должно иметь статус True.

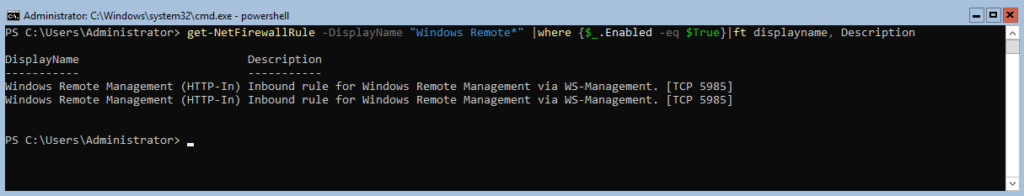

Добавим в межсетевой экран правило разрешающее подключаться с любых IP адресов

Set-NetFirewallRule -Name "WinRM-HTTP-In-TCP-Public" -RemoteAddress Any

Список правил межсетевого экрана касаемо WinRM можно посмотреть с помощью командлета Get-NetFirewallRule

Get-NetFirewallRule -DisplayName "Windows Remote*" |where {$_.Enabled -eq $True}|ft displayname, Description

Добавим еще одно разрешающее правило для доступа с помощью оснасток MMC

Enable-NetFirewallRule -DisplayGroup "Remote Administration"

На данном этапе с настройкой сервера мы закончили переходим к настройке клиента.

Настройка клиента Windows 10

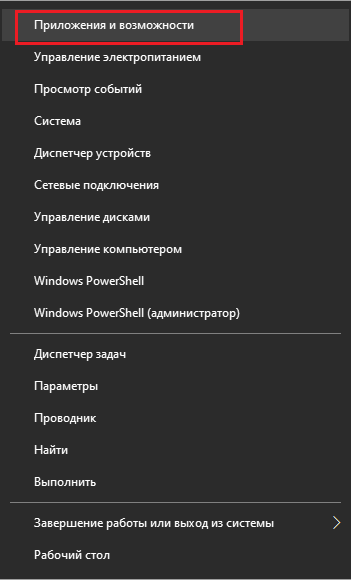

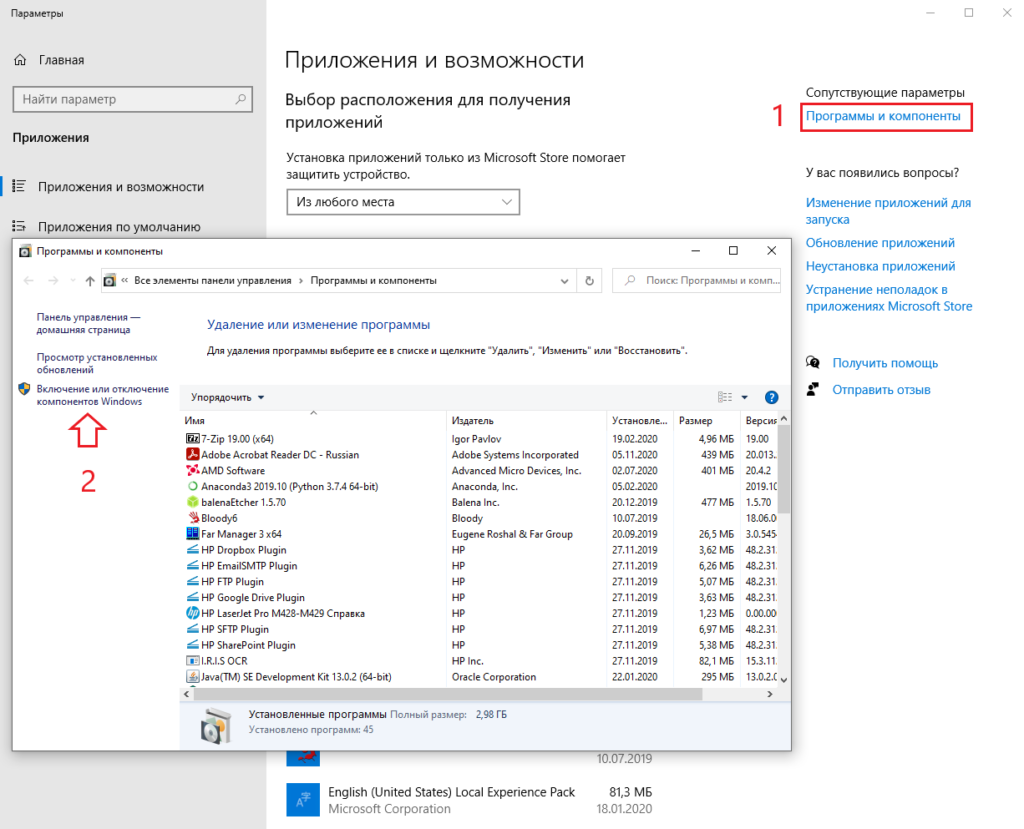

Если вы следовали четко по инструкции то прописали имя компьютера в соответствии с его адресом в файле hosts либо на DNS сервере. Следующим этапом убедимся что на компьютере установлена консоль управления Hyper-V Management. Если её нет, давайте установим.

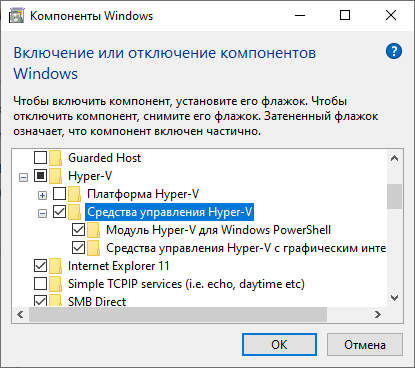

Нажимаем правой кнопкой мыши на Пуск -> Приложения и возможности -> Программы и компоненты -> Включение или отключение компонентов Windows -> Hyper-V -> Средства управления Hyper-V

Далее запускаем Powershell с правами администратора и выполняем все действия по ним.

Включим возможность удаленного подключения

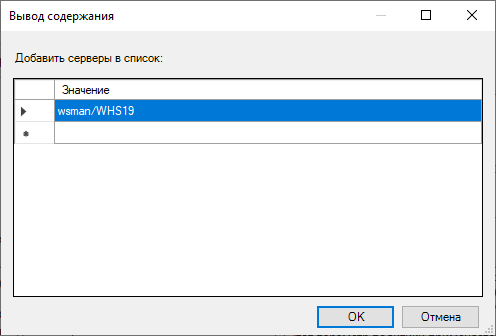

Добавим сервер Hyper-V в доверенные узлы на локальном ПК

Set-Item WSMan:localhostClientTrustedHosts -Value "WHS19"

Проверим что все получилось

Get-Item WSMan:localhostClientTrustedHosts

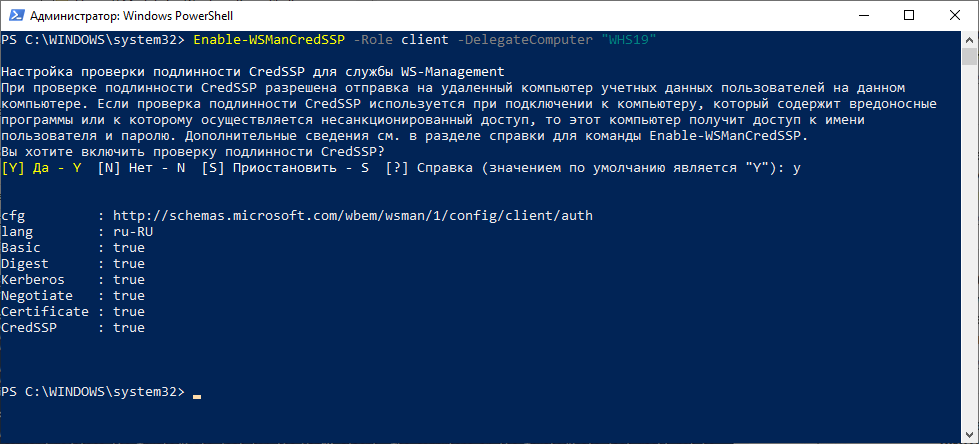

Настройка проверки подлинности CredSSP для службы WS-Management

Enable-WSManCredSSP -Role client -DelegateComputer "WHS19"

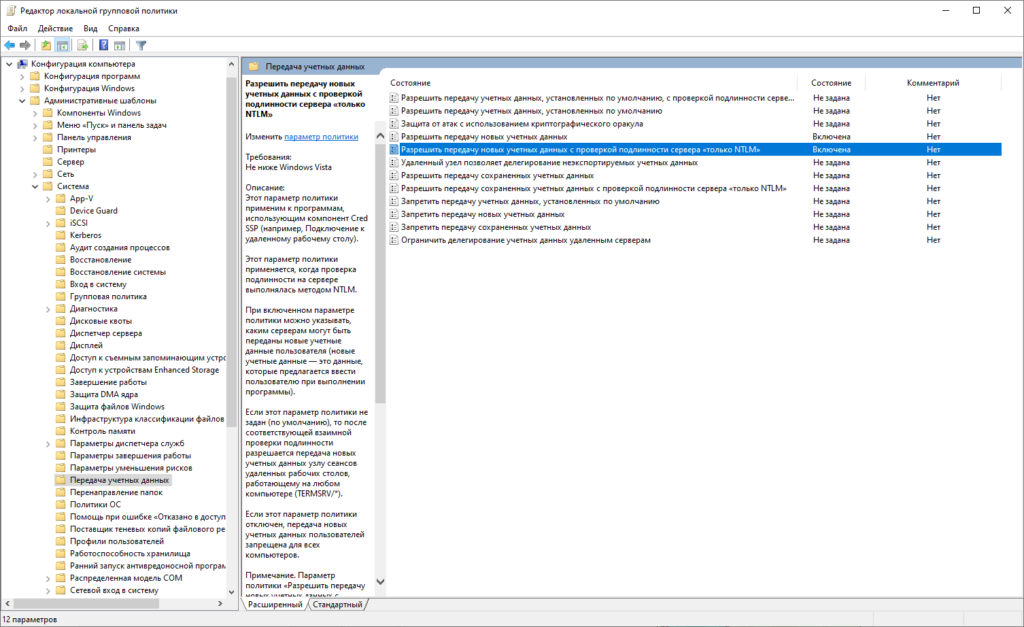

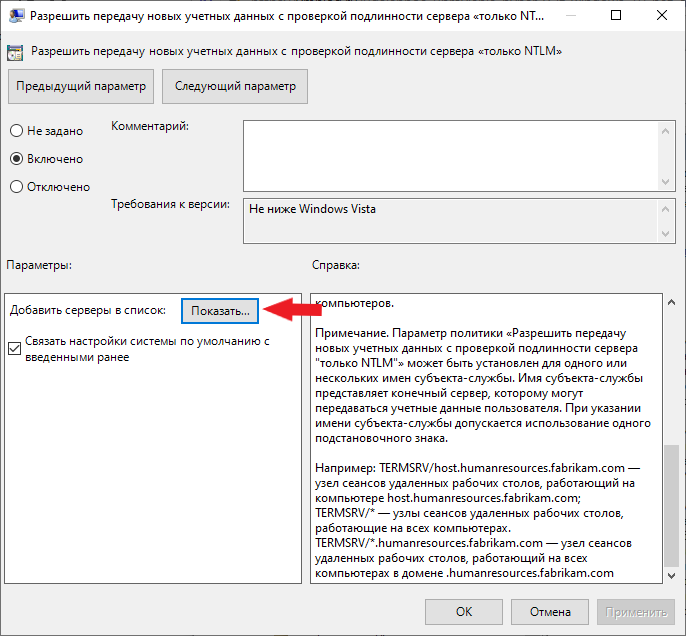

Отредактируем локальную групповую политику. Нажимаем правой кнопкой мыши Пуск -> Выполнить запускаем cmd и далее gpedit. В русской версии: Конфигурация компьютера -> Административные шаблоны -> Система -> Передача данных -> Разрешить передачу новых учетных данных с проверкой подлинности сервера «только NTLM». В английской версии: Computer Configuration -> Administrative Template -> System -> Credentials Delegation -> Allow delegating fresh credentials with NTLM-only server authentication. Включаем данную политику и добавляем сервер Hyper-V в список разрешенных.

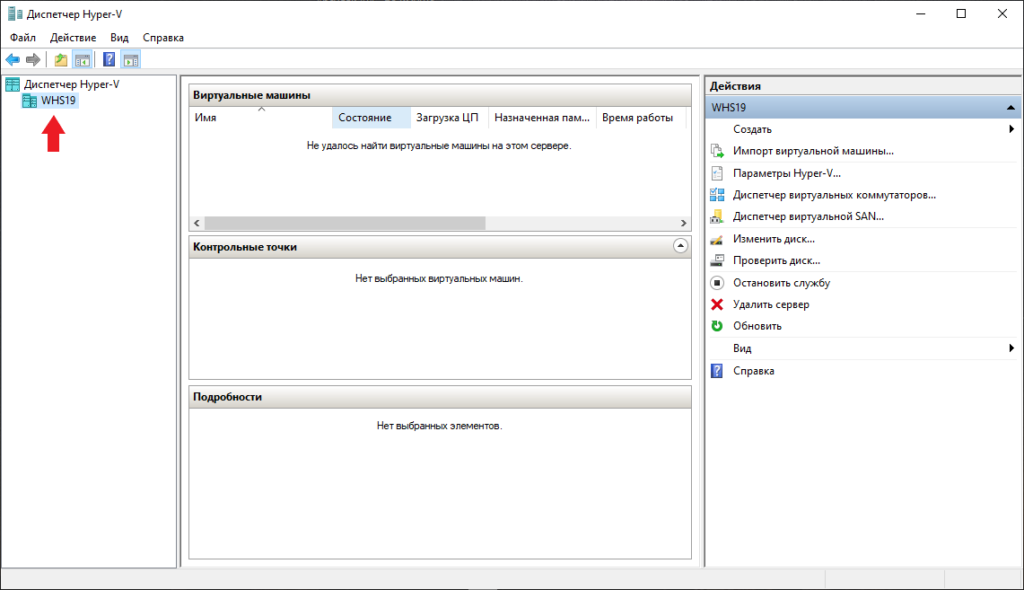

Настройка клиента закончена. Пробуем подключится к серверу используя Hyper-V Manager.

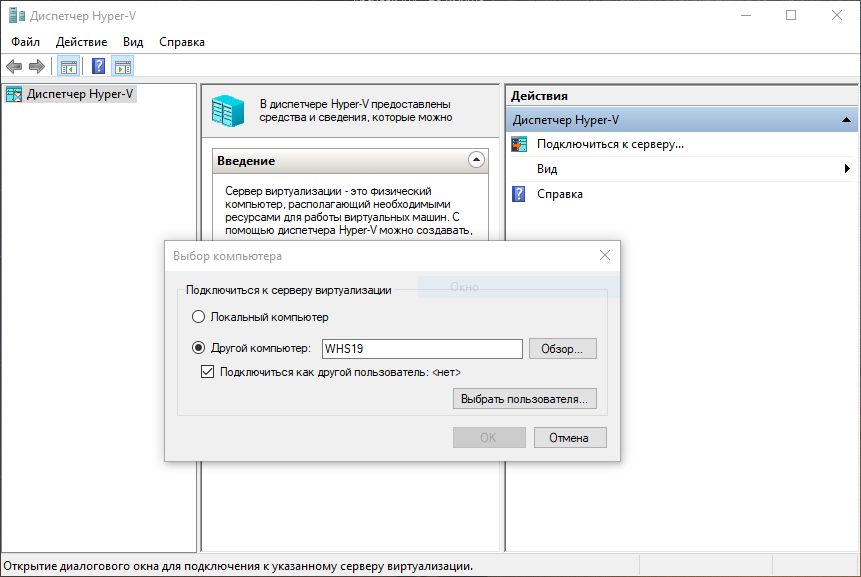

Подключение к серверу с помощью Hyper-v Manager

Запустим Hyper-V Manager (он же Диспетчер Hyper-V). Нажимаем Подключиться к серверу. В открытом окне выбираем поле Другой компьютер пишем имя нашего сервера: WHS19. Ставим галочку Подключиться как другой пользователь.

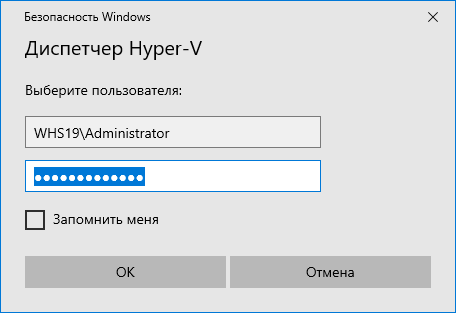

Нажимаем кнопку Выбрать пользователя

Внимательно заполняем логин и пароль для входа на сервер Hyper-V. Обязательно в поле имя пользователя вначале пишем имя компьютера затем имя пользователя. В нашем случае WHS19Administrator. Нажимаем OK. Все готово, теперь можно управлять сервером Hyper-V 2019 из удобной консоли.

Подключение к серверу с помощью Windows Admin Center

Для использования Windows Admin Center необходимо его скачать. Скопируем скачанный файл на сервер Hyper-V. Я скопировал файл WindowsAdminCenter2009.msi по пути C:UsersAdministrator. Переходим в открытую консоль cmd или powershell и запускаем установку.

msiexec /i C:UsersAdministratorWindowsAdminCenter2009.msi /qn /L*v log.txt SME_PORT=9010 SSL_CERTIFICATE_OPTION=generate

Данная команда запустит скрытую установку Windows Admin Center. Журналирование установки идет в файл log.txt, порт для подключения я использую 9010 (можно указать любой свободный). Сертификат создается автоматически. Дожидаемся окончания установки и можем пробовать подключаться.

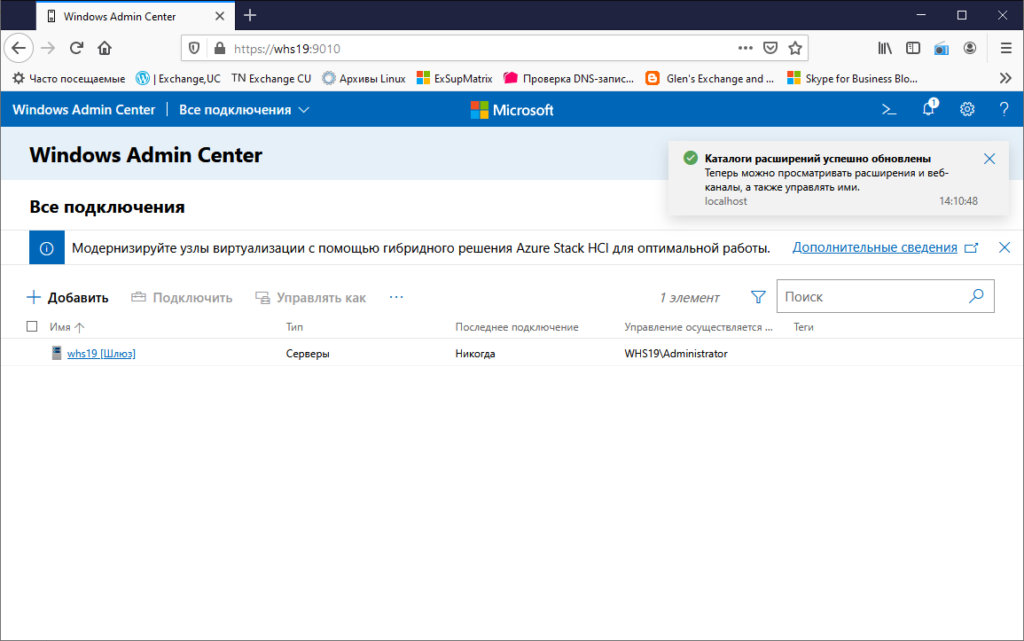

Из любого браузера открываем сайт https://whs19:9010 вводим учетные данные от сервера и попадаем в консоль управления сервером Windows Admin Center.

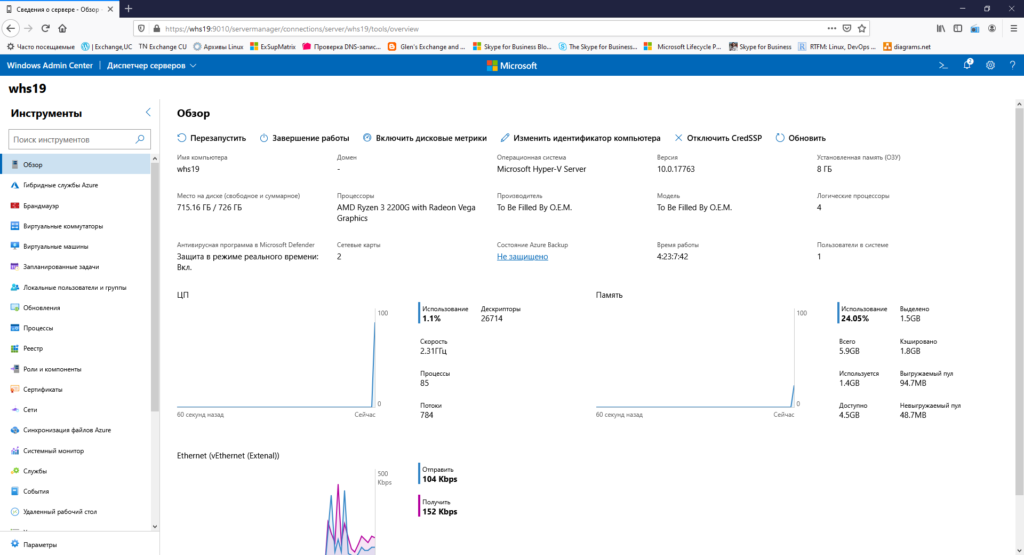

В консоли Windows Admin Center можно следить за загрузкой сервера через удобные графики расположенные на одной странице. Можно быстро выключить, перезагрузить, переименовать сервер. Большой набор функций доступен изначально, также есть воможность расширения за счет дополнительных плагинов.

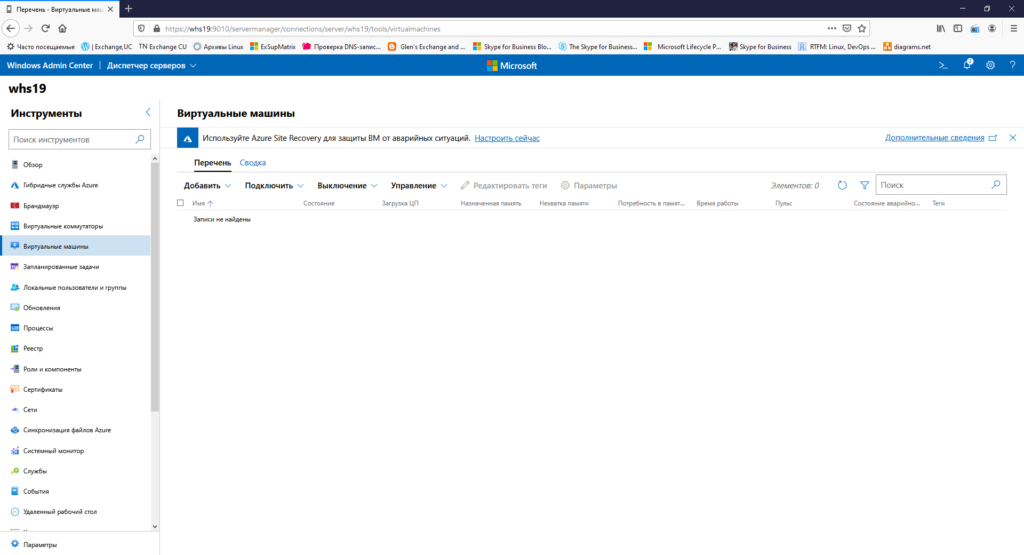

Можно создавать/удалять/управлять виртуальными машинами. Очень удобно прямо из браузера без необходимости запуска других консолей.

Резюмируя хочу сказать что WAC интересный инструмент для быстрой настройки/доступа к серверу. Хотя конечно не без недостатков. Мне лично не нравится то что просмотр логов идет сплошным текстом без выделения по цвету (warning, error и т.д.). В общем смотрите, изучайте, пользуйтесь.

Подключаться к серверу можно и с консоли mmc и с powershell. В общем большой набор инструментов для управления сервером. Установка и настройка Microsoft Hyper-V Server 2019 в целом почти идентична с версией сервера 2016. Можно использовать данную статью как мануал для старой версии.

Хотите отблагодарить автора статьи? Это даст ему дополнительный стимул к написанию новых статей.

На сервере Windows Server 2019 потребовалось запустить виртуальную машину посредством Hyper-V. Установим роль Hyper-V на сервер Windows Server 2019 и создадим какую-нибудь виртуальную машину.

Я буду все действия выполнять на свежем сервере Windows Server 2019 Standard Evaluation. Сервер развёрнут на гипервизоре VMware ESXi. Да-да, я понимаю, что на виртуалке поднимать систему виртуализации не самая здравая идея, но всё это в тестовых целях.

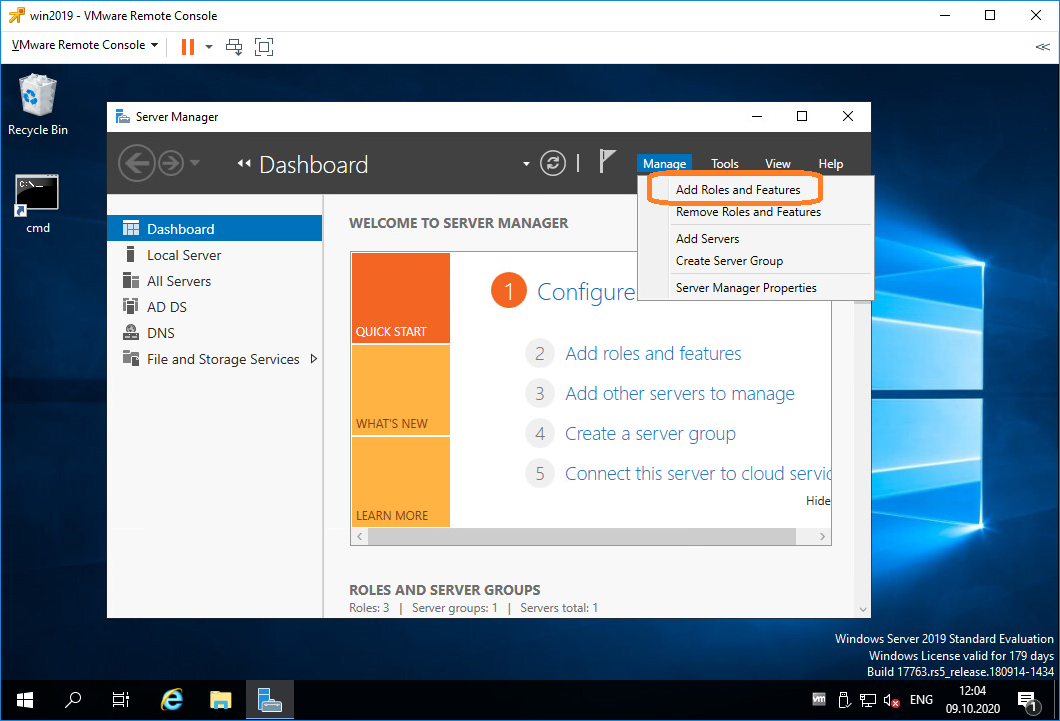

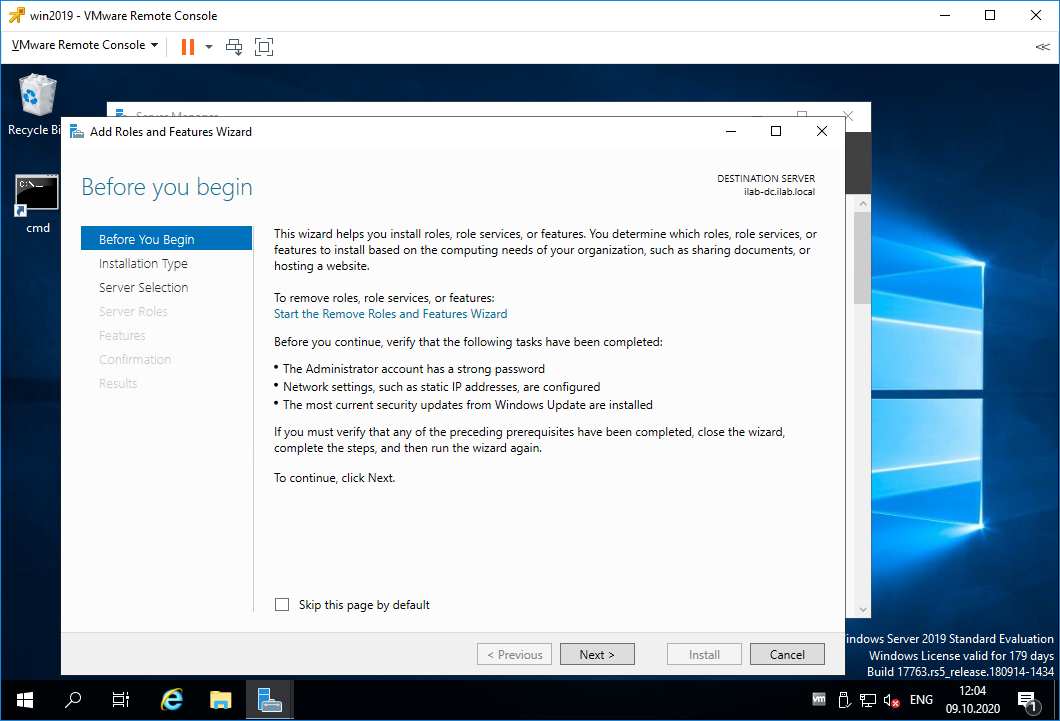

Установка роли Hyper-V на сервере Windows Server 2019

Открываем Server Manager. Manage > Add Roles and Features

Открывается мастер установки ролей. Попадаем в раздел Before You Begin.

Это информационная страница, Next.

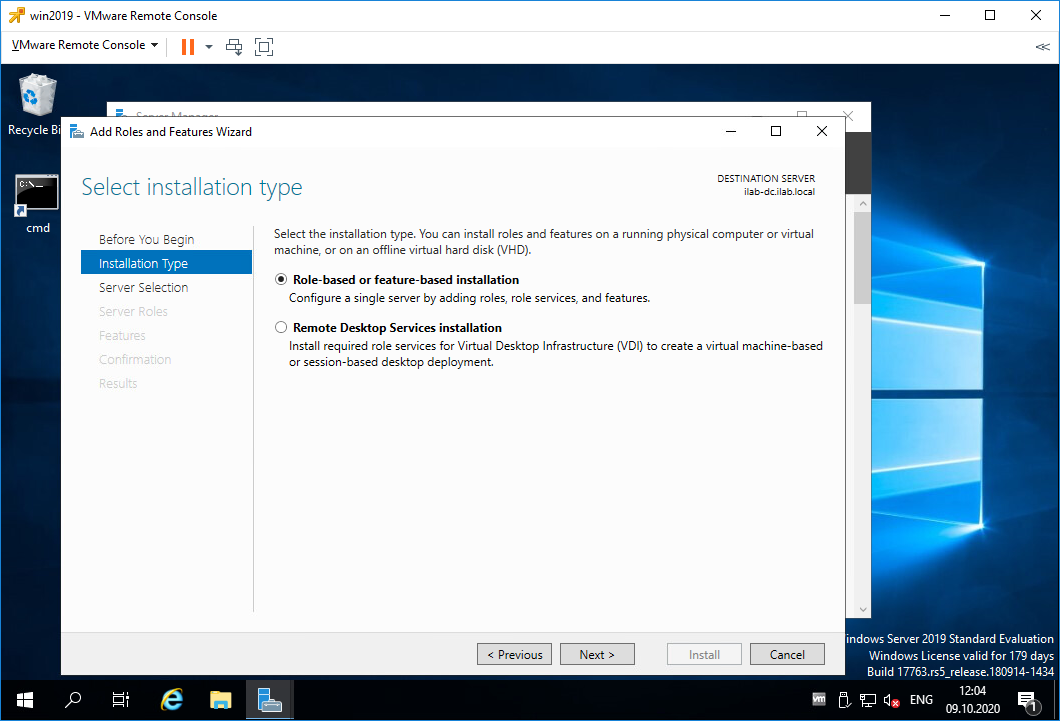

Попадаем в раздел Installation Type. Здесь нужно выбрать тип установку. Выбираем «Role-based or feature-based installation». Next.

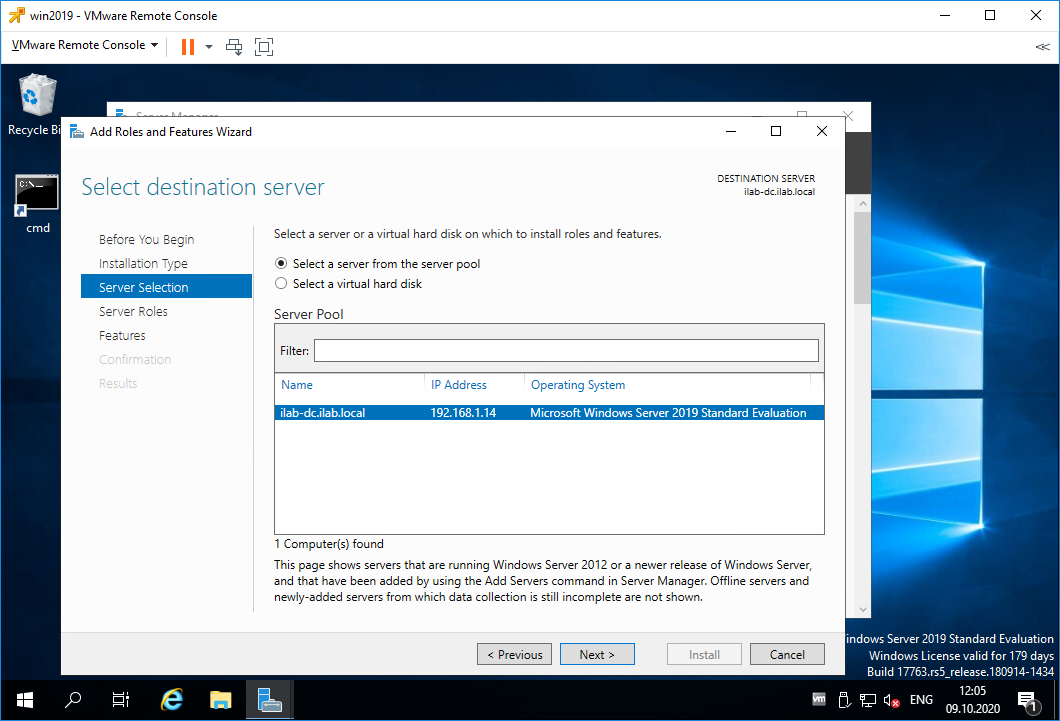

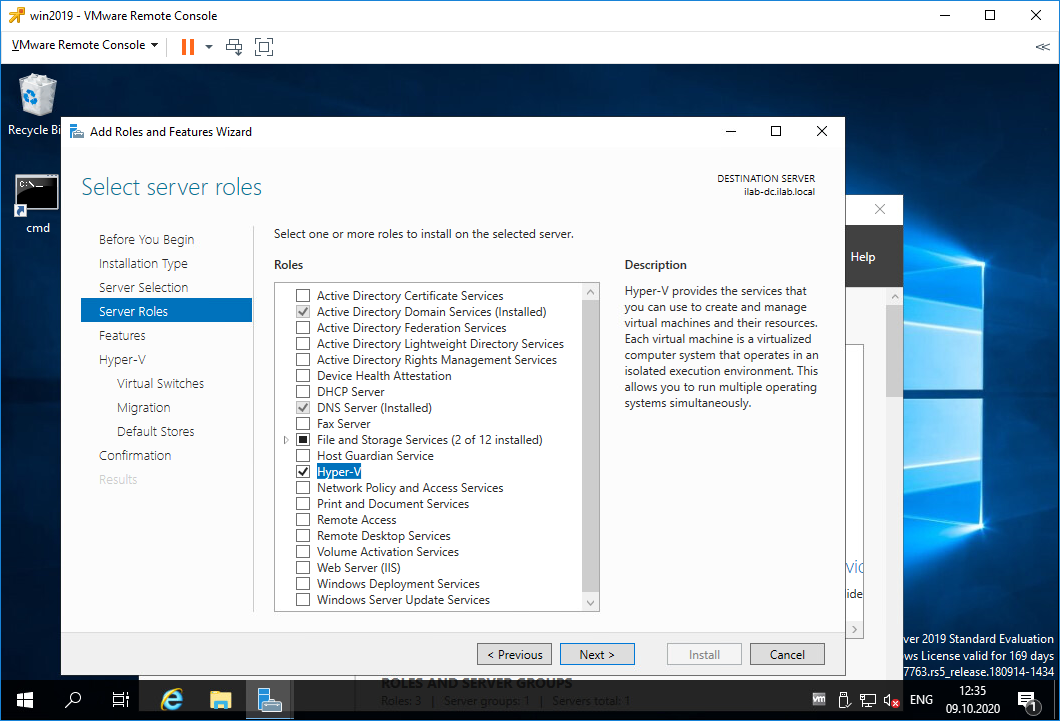

Попадаем в раздел Server Selection. Здесь нужно выбрать сервер, на который будем устанавливать роль. Я выбираю текущий сервер. Next.

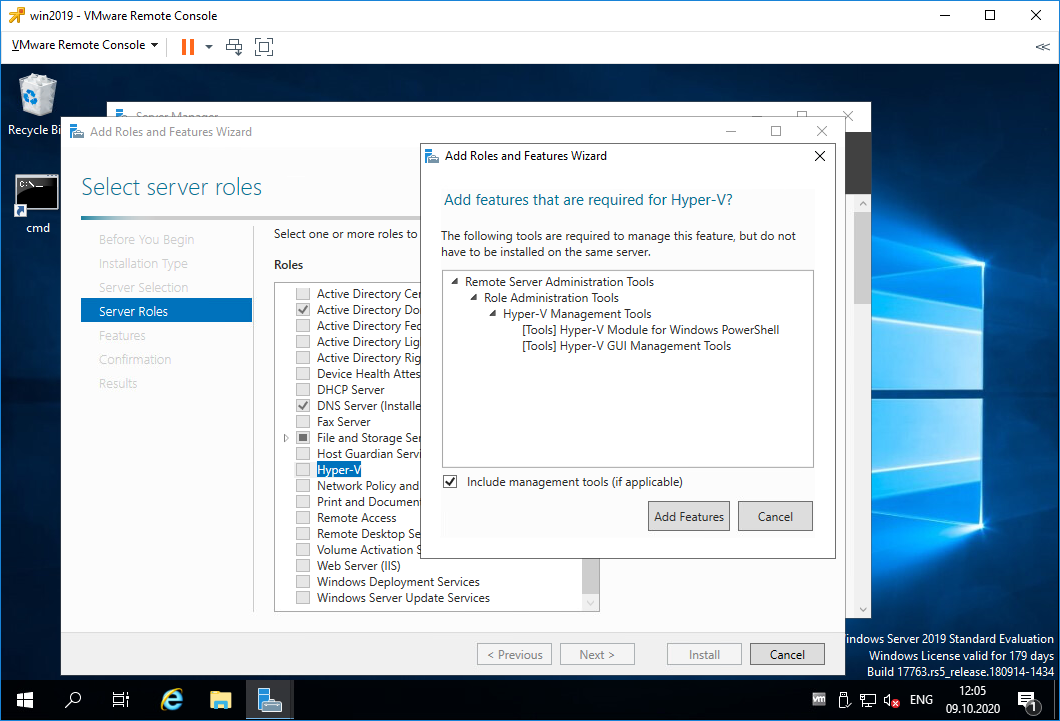

Попадаем в раздел Server Roles. Находим роль Hyper-V, выделяем галкой. Нам предлагают установить фичи, которые необходимы для работы Hyper-V, соглашаемся. Add Features.

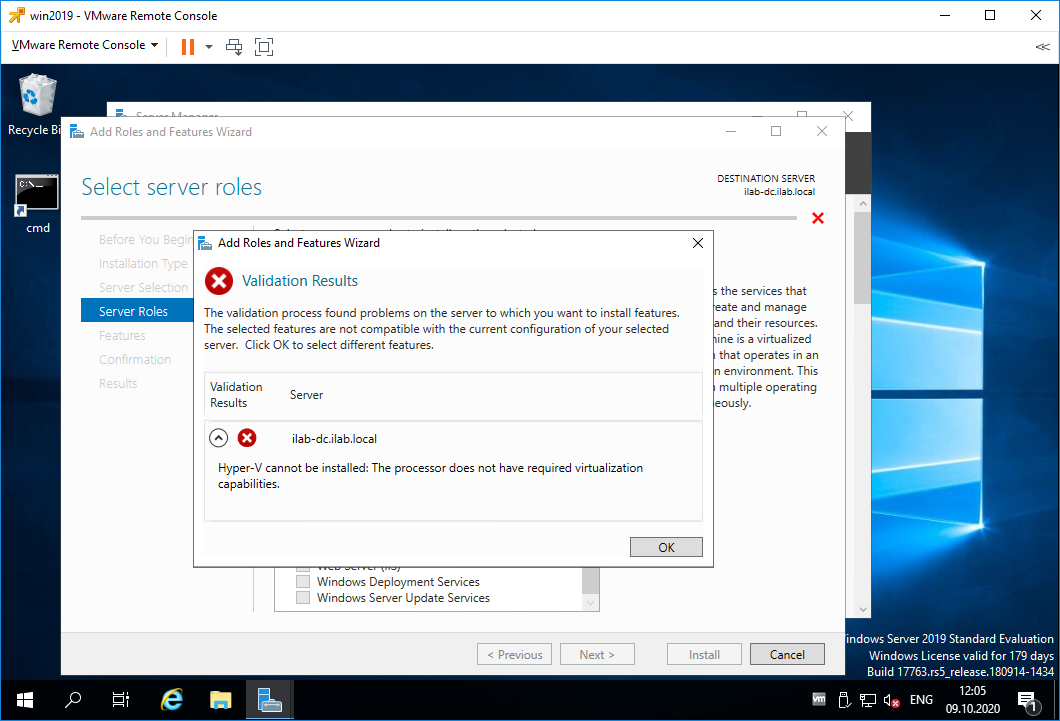

Облом. Я словил ошибку:

Hyper-V cannot be installed: The processor does not have required virtualization.

Для роли Hyper-V требуется процессор, поддерживающий функции виртуализации. Поддержка аппаратной виртуализации может быть отключена в BIOS, в этом случае нужно перезагрузить сервер и в BIOS включить поддержку виртуализации. Это могут быть опции:

- Intel — Intel Virtualization Technology

- AMD — SVM Mode

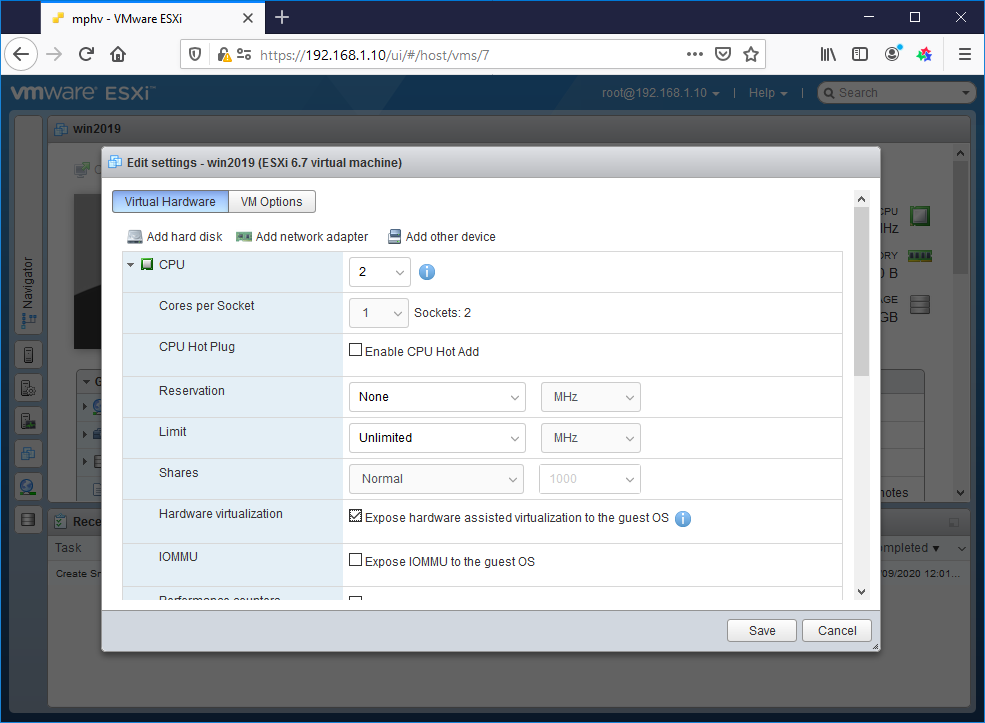

У меня сервер аппаратный на базе VMware, я выключаю его и перехожу к настройкам виртуальной машины.

В настройках CPU включаю галку «Expose hardware assisted virtualization to the guest OS».

Включаю сервер. Снова проходим ту же процедуру. Открываем Server Manager. Manage > Add Roles and Features. Выбираем «Role-based or feature-based installation». Находим роль Hyper-V, выделяем галкой. Нам предлагают установить фичи, которые необходимы для работы Hyper-V, соглашаемся. Add Features.

В этот раз всё проходит успешно. Next.

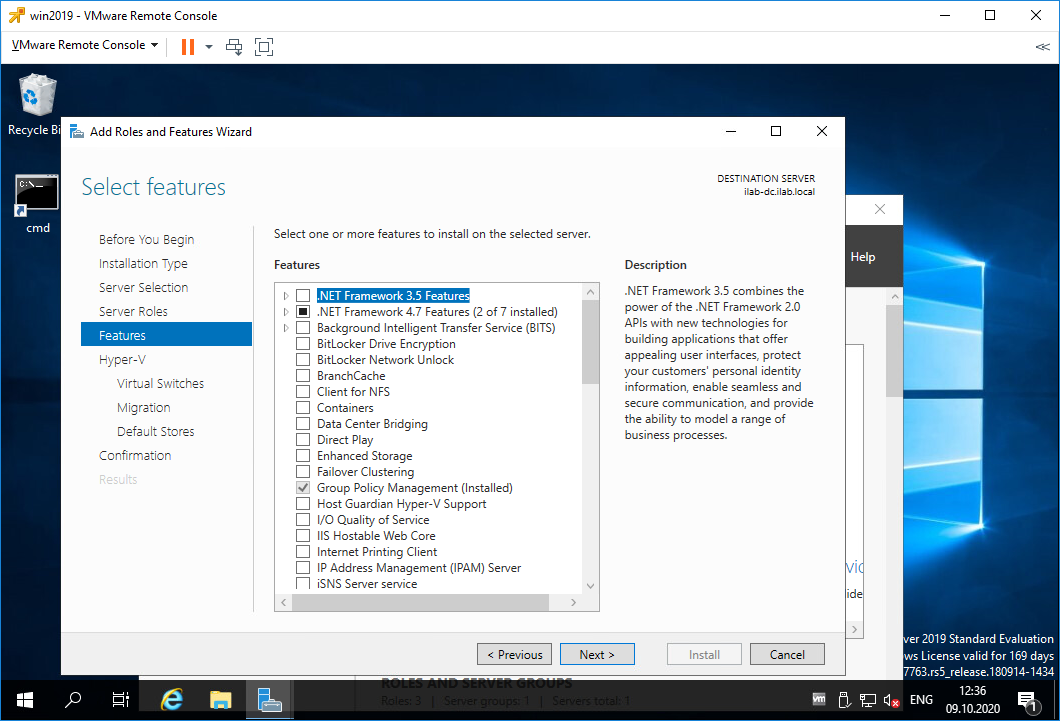

Попадаем в раздел Features, здесь нам ничего не нужно. Next.

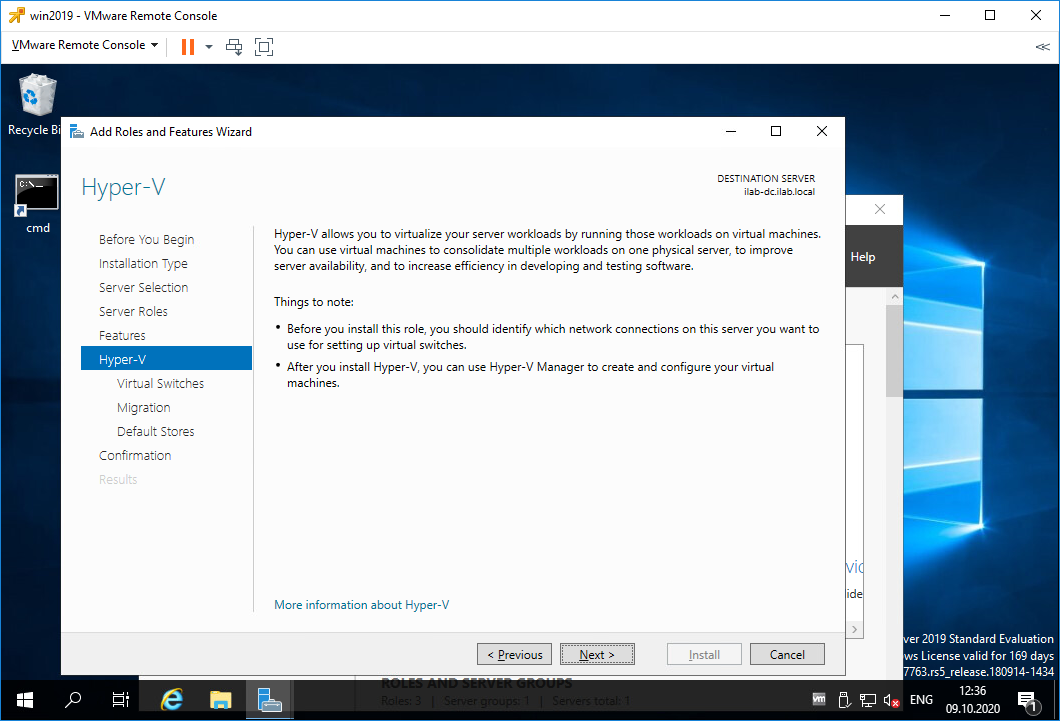

Попадаем в раздел Hyper-V. Здесь рассказывается для чего используется Hyper-V. Кроме того, на этой странице есть важная информация.

- Перед установкой роли Hyper-V следует решить, какую сетевую карту сервера вы будете подключать к виртуальному коммутатору.

- После установки роли Hyper-V для управления виртуальными машинами используйте Hyper-V Manager.

Next.

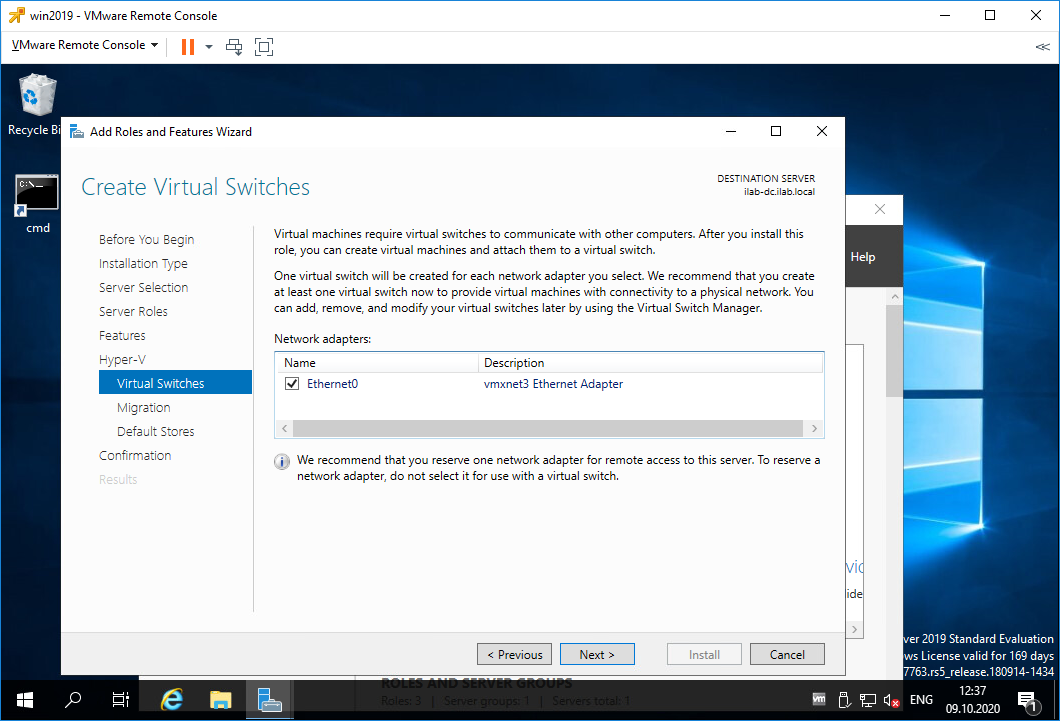

Попадаем в раздел Virtual Switches. Для работы виртуальных машин требуется связать виртуальный коммутатор в сетевой картой сервера, если вы хотите выпустить виртуальный машины в сеть. У меня выбор не очень большой, выделяю единственную сетевую карту. Next.

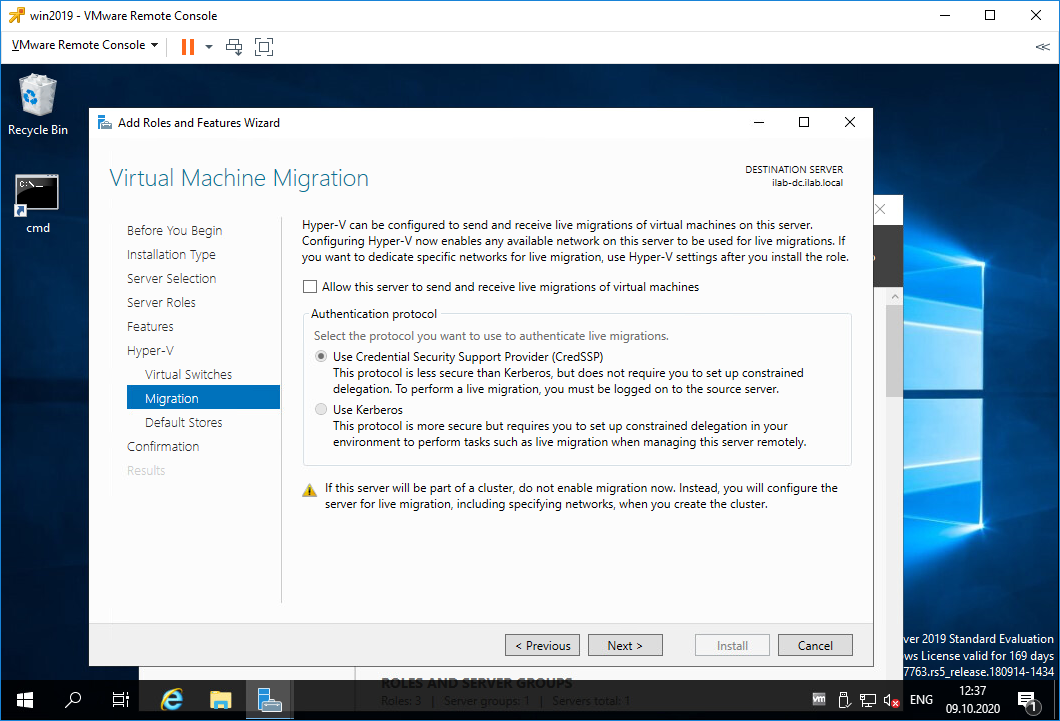

Попадаем в раздел Migration. Здесь настраивается миграция виртуальных машин. У меня будет один сервер с Hyper-V, поэтому никаких миграций не предусмотрено. Next.

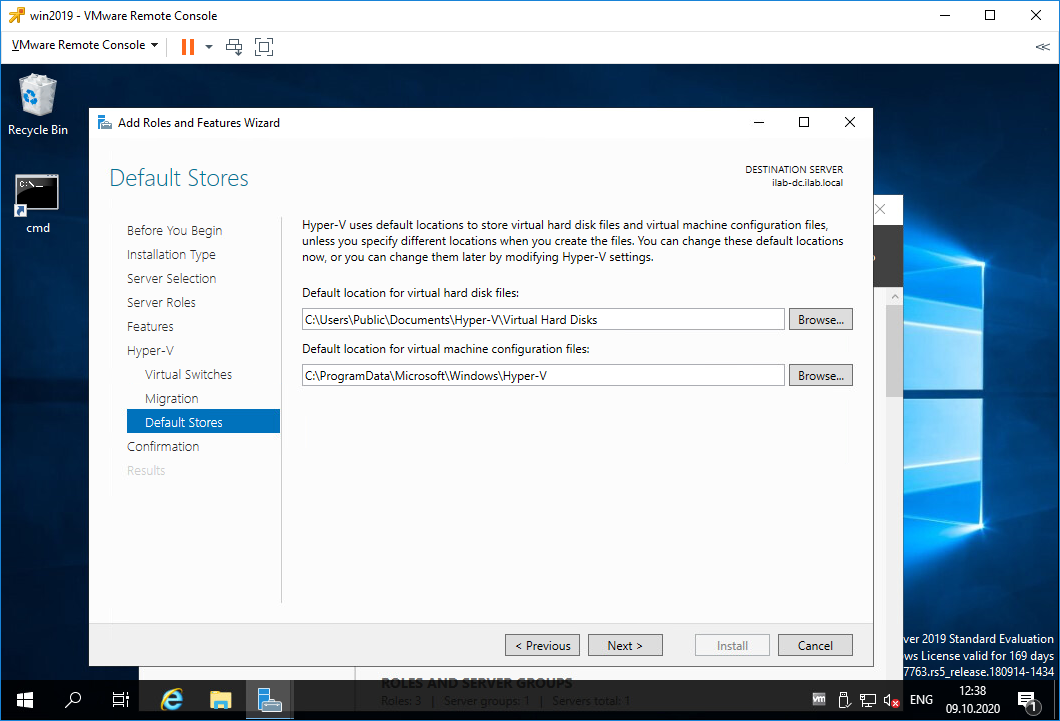

Попадаем в раздел Default Stores. Здесь можно настроить папки по умолчанию для хранения виртуальных дисков и файлов настроек виртуальных машин. Next.

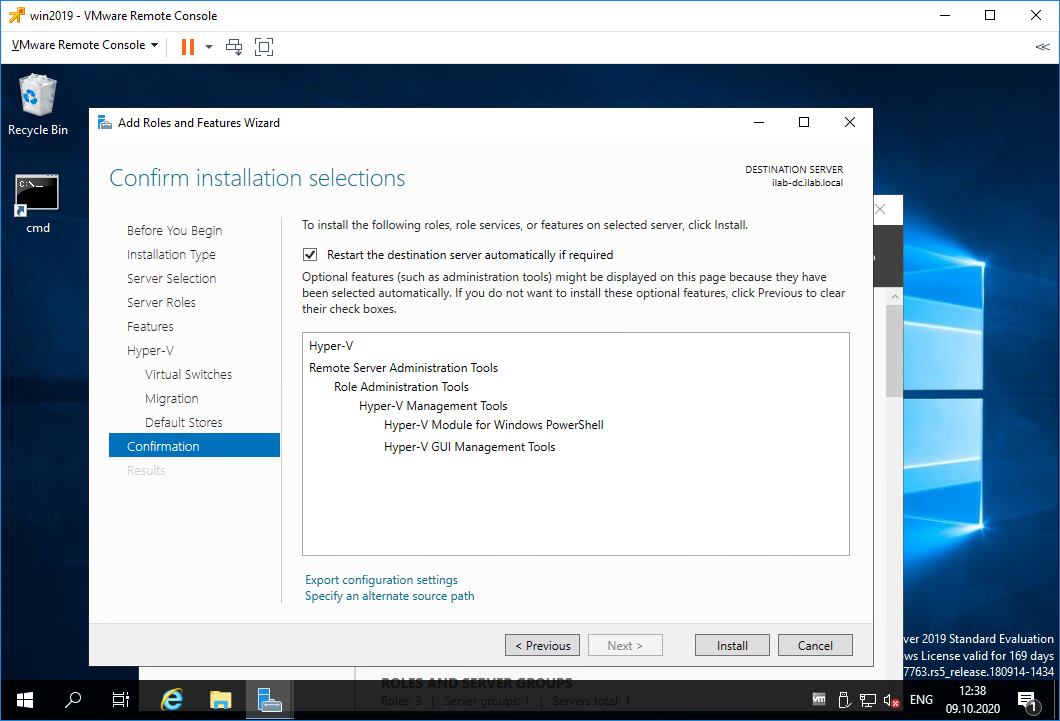

Попадаем в раздел Confirmation. Проверяем что у нас будет установлено. Здесь же ставим галку, чтобы сервер при необходимости перезагрузился. Install.

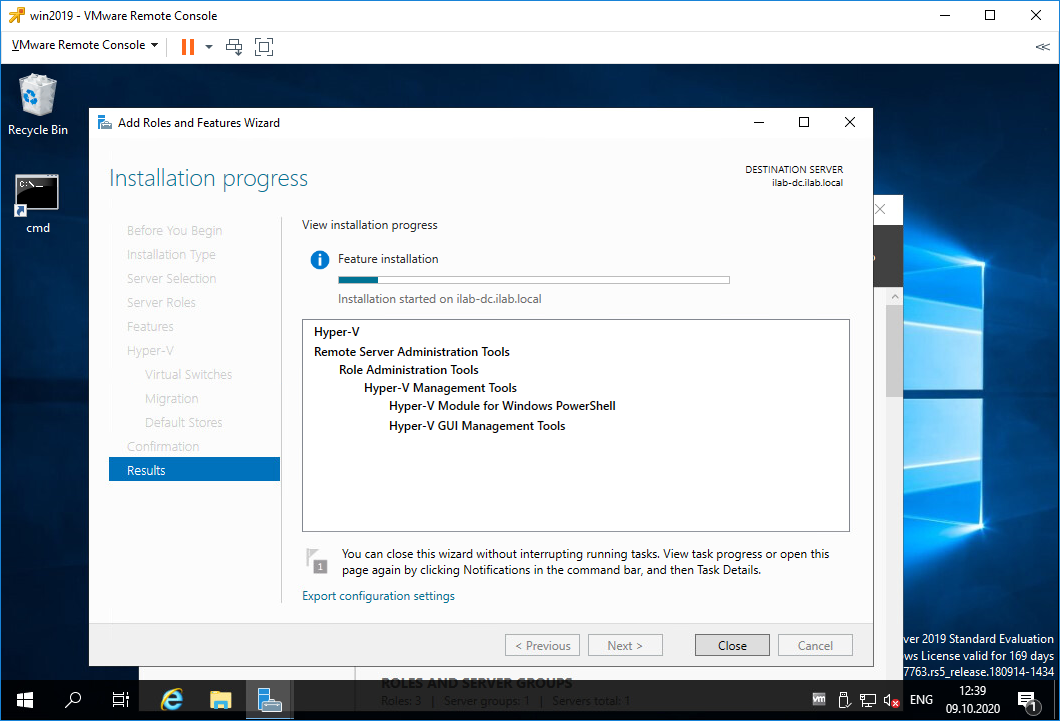

Начинается процесс установки роли Hyper-V.

Сервер перезагружается.

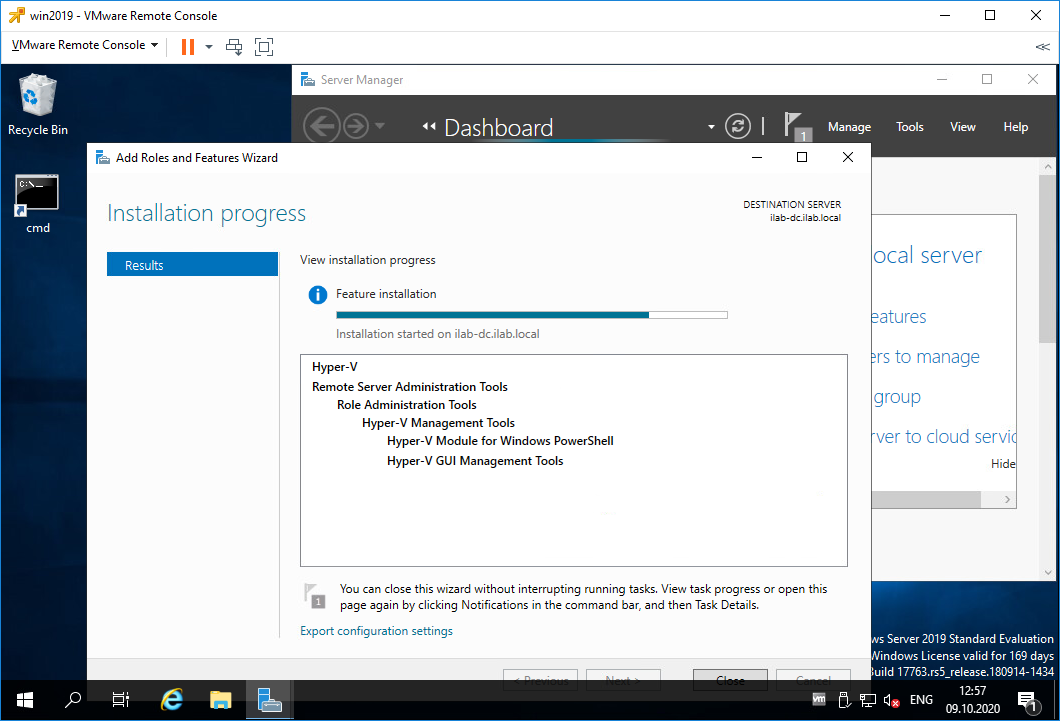

После перезагрузки роль продолжает устанавливаться.

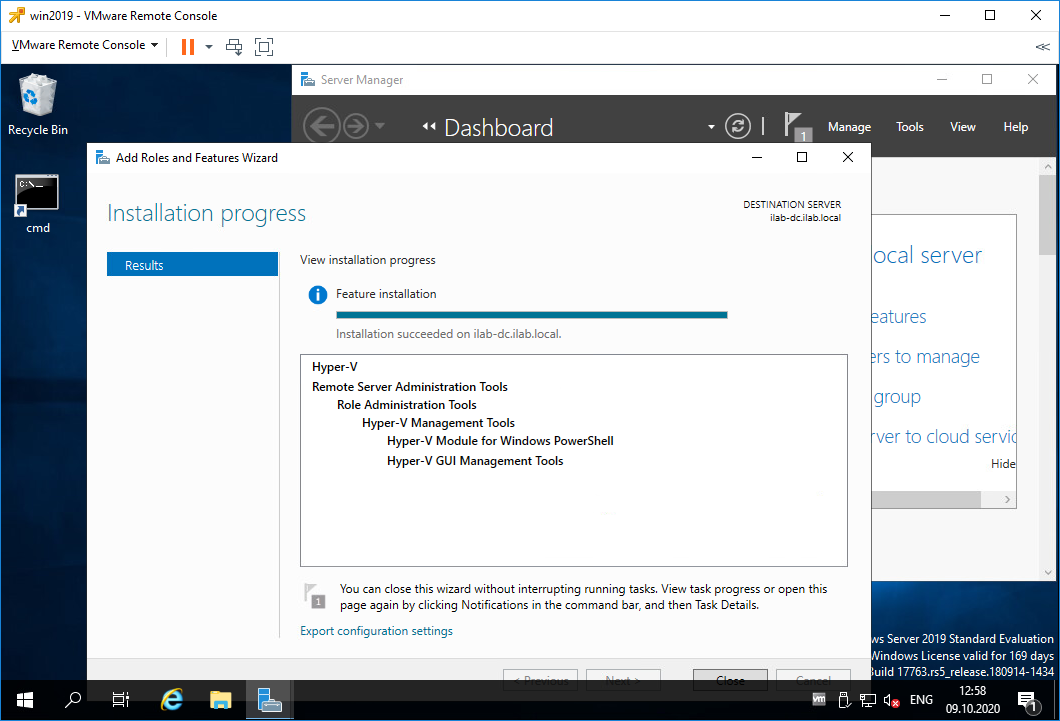

Установка роли Hyper-V успешно завершена. Close.

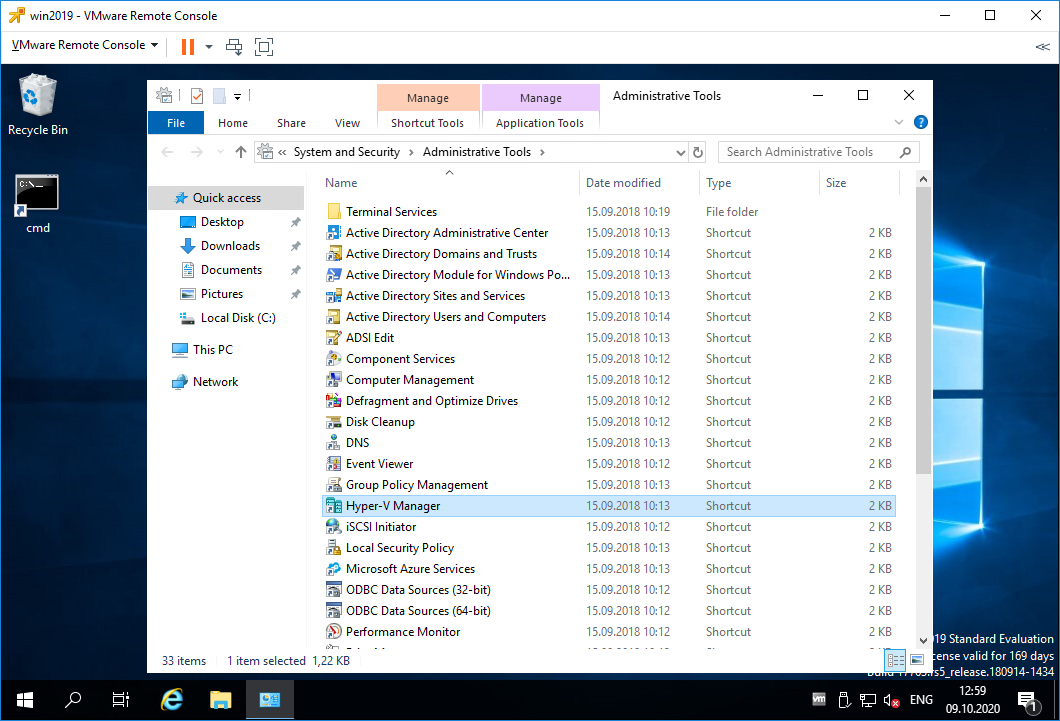

В Administrative Tools появляется Hyper-V Manager.

Настройка виртуального коммутатора Hyper-V

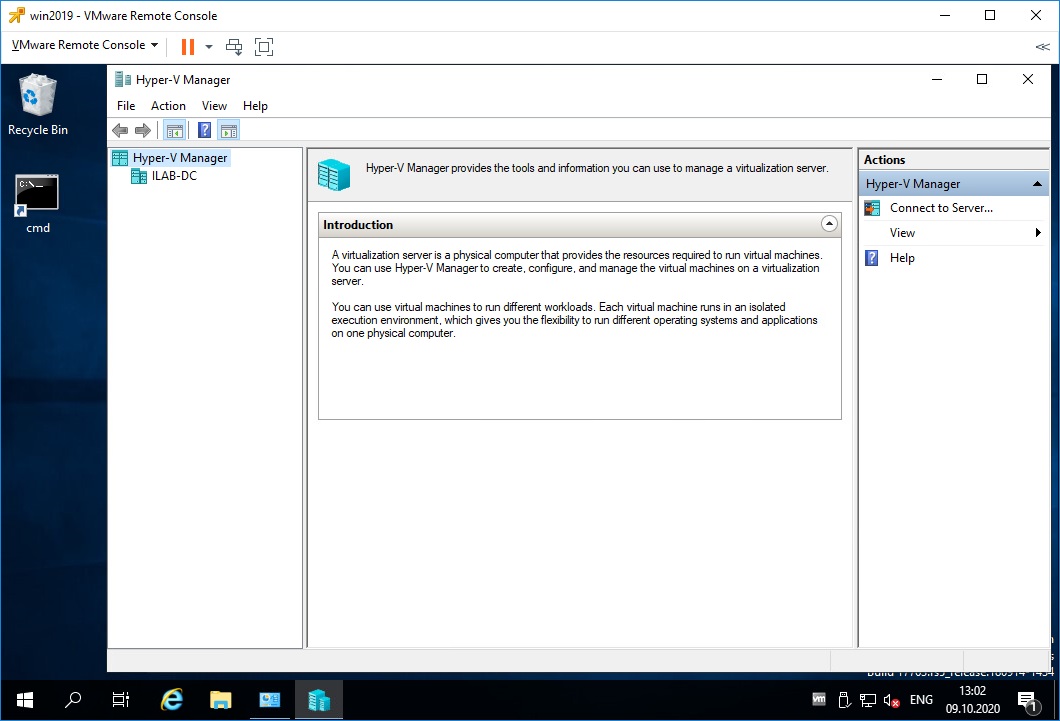

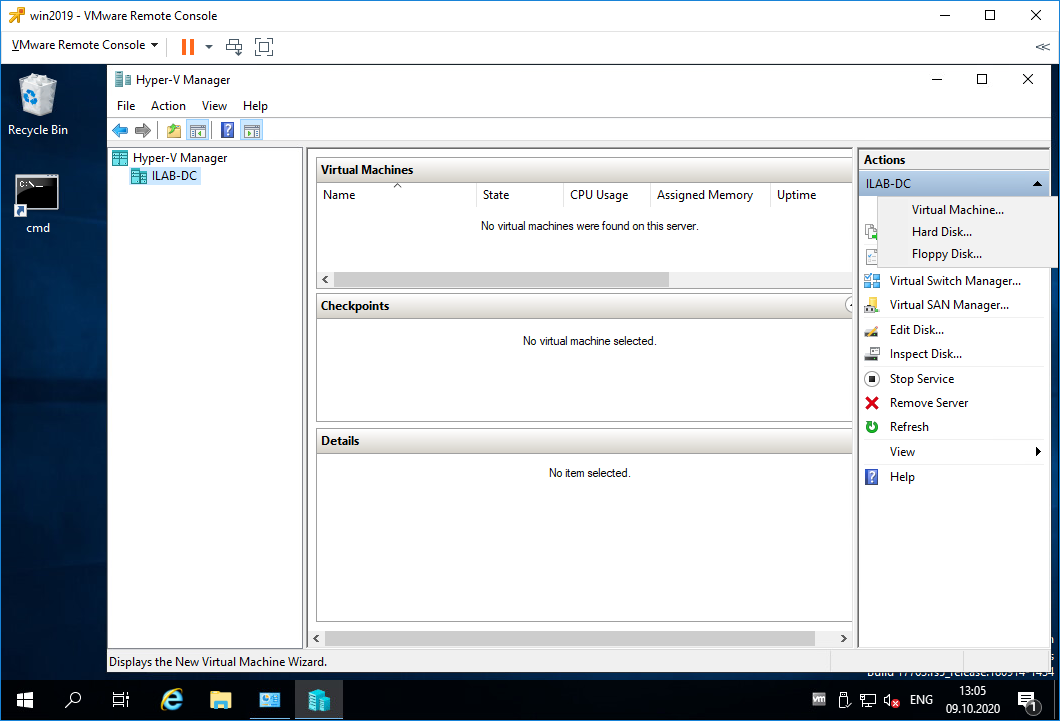

Запускаем Hyper-V Manager.

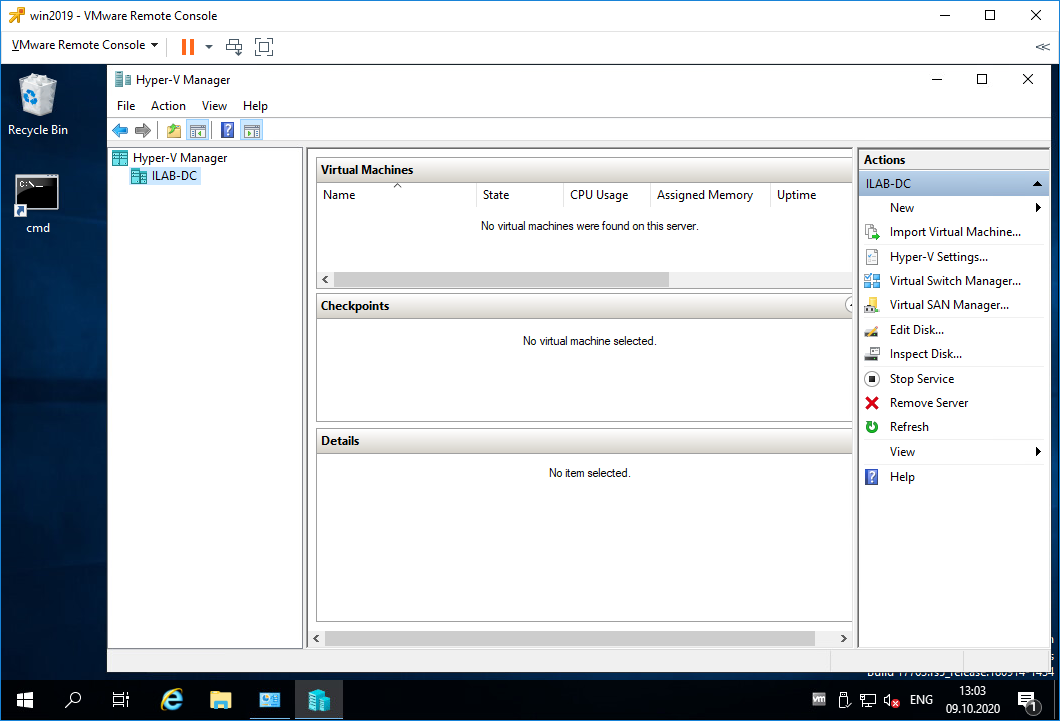

В списках серверов Hyper-V есть текущий сервер ILAB-DC. Нажимаем на него.

Список виртуальных машин пуст. Перед созданием новой виртуалки нужно настроить виртуальный коммутатор. По идее он уже должен быть настроен, т.к. мы при установке роли Hyper-V ставили галку для привязки виртуального коммутатора к физическому сетевому адаптеру. Но проверить не помешает, были случаи, когда виртуальный коммутатор на привязывался к физическому адаптеру. Такое случается, когда роль Hyper-V устанавливается несколько раз. В этом случае зайдите в настройки физического адаптера и снимите галку со всего где есть слово «Hyper-V», после этого физический адаптер можно снова привязать к виртуальному коммутатору из оснастки Hyper-V Manager.

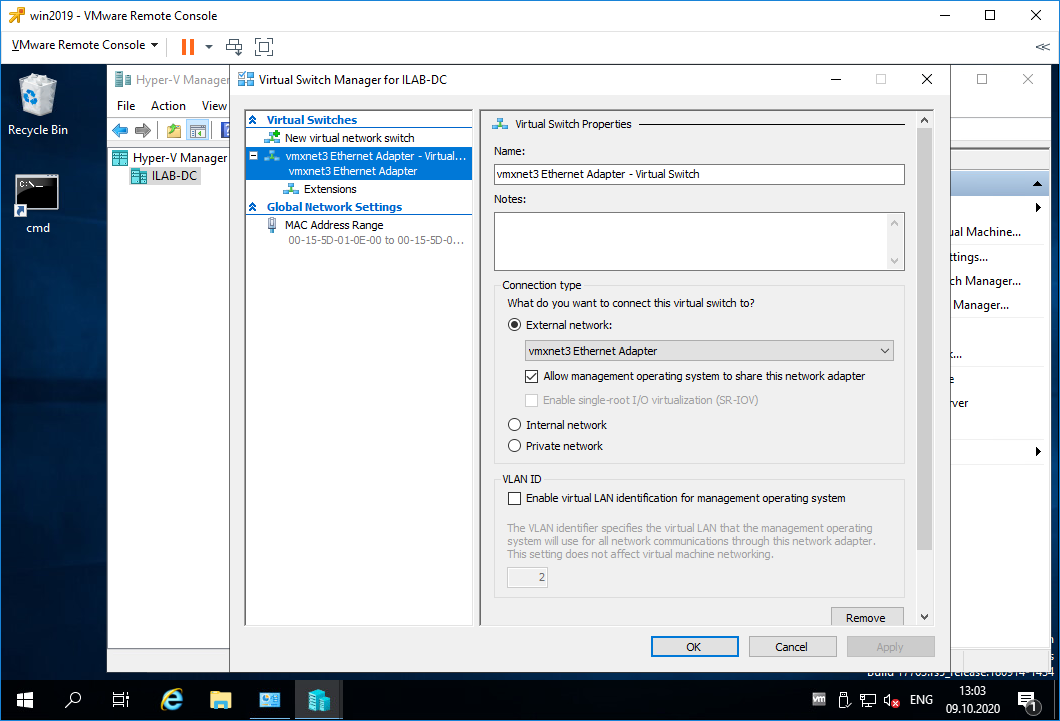

Нажимаем Virtual Switch Manager…

У меня один виртуальный коммутатор «vmxnet3 Ethernet Adapter — Virtual Switch». Виртуальный коммутатор может работать в трёх режимах:

- External network

Предоставляет виртуальным машинам доступ к физической сети для взаимодействия с серверами и клиентами во внешней сети. Позволяет виртуальным машинам на одном сервере Hyper-V взаимодействовать друг с другом.- Allow management operating system to share this network adapter (Разрешить управляющей операционной системе предоставлять общий доступ к этому сетевому адаптеру)

Выберите этот параметр, если вы хотите разрешить узлу Hyper-V совместно использовать виртуальный коммутатор и сетевую карту или группу сетевых адаптеров с виртуальной машиной. Если этот параметр включен, узел может использовать любые параметры, настроенные для виртуального коммутатора, такие как параметры качества обслуживания (QoS), параметры безопасности или другие функции виртуального коммутатора Hyper-V. - Enable single-root I/O virtualization (SR-IOV) (Включить виртуализацию SR-IOV)

Выберите этот параметр, только если вы хотите разрешить трафику виртуальной машины обходить коммутатор виртуальной машины и перейти непосредственно к физическому сетевому адаптеру. Сетевой адаптер должен поддерживать SR-IOV.

- Allow management operating system to share this network adapter (Разрешить управляющей операционной системе предоставлять общий доступ к этому сетевому адаптеру)

- Internal network

Разрешает обмен данными между виртуальными машинами на одном сервере Hyper-V, а также между виртуальными машинами и сервером Hyper-V. - Private network

Разрешает обмен данными только между виртуальными машинами на одном сервере Hyper-V. Частная сеть изолирована от всего внешнего сетевого трафика на сервере Hyper-V. Этот тип сети полезен, если необходимо создать изолированную сетевую среду, например изолированный тестовый домен.

SR-IOV (Single Root Input/Output Virtualization, виртуализация ввода-вывода с единым корнем) — технология виртуализации устройств, позволяющая предоставить виртуальным машинам прямой доступ к части аппаратных возможностей устройства.

При необходимости можно включить поддержку VLAN.

Настраиваю виртуальный коммутатор, вернее, ничего не меняю, меня устраивают текущие настройки. OK.

Создание виртуальной машины в Hyper-V

Пришло время создать первую виртуальную машину. Открываем Hyper-V Manager.

New > Virtual Machine…

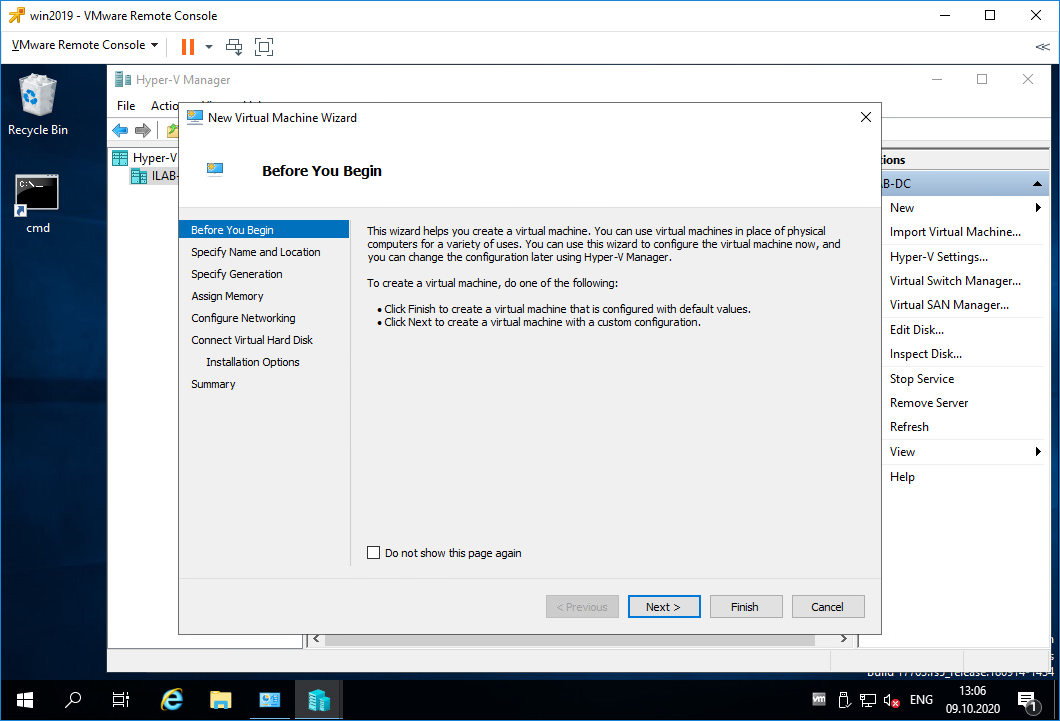

Открывается мастер создания виртуальных машин. Попадаем в раздел Before You Begin. Здесь нет ничего интересного. Next.

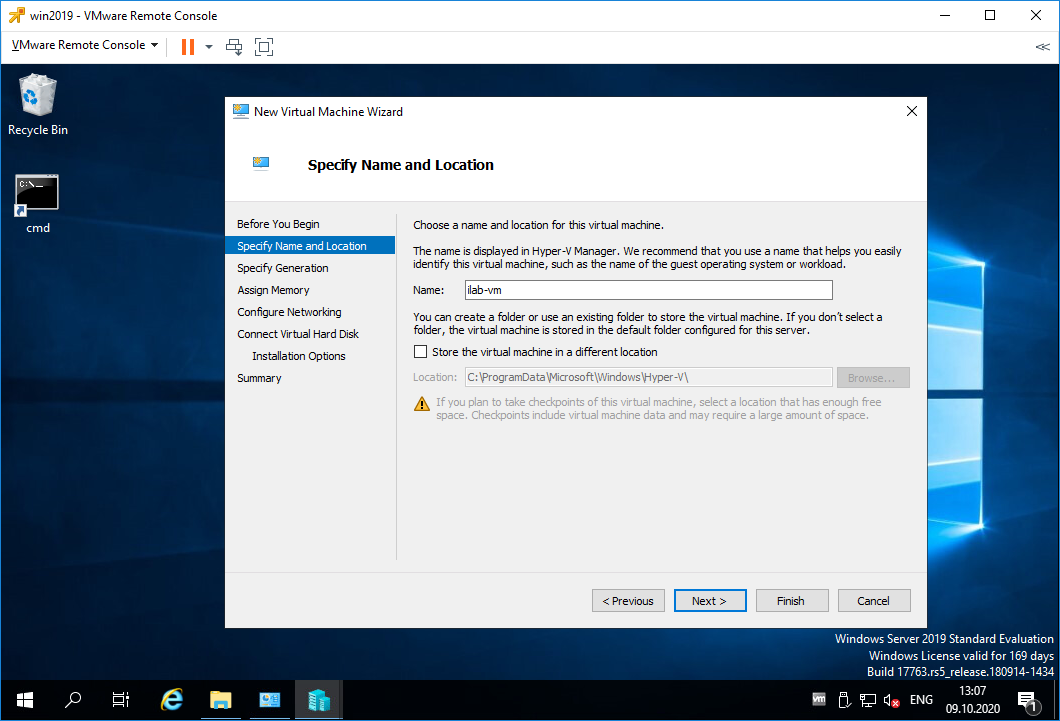

Попадаем в раздел Specify Name and Location. Указываем имя виртуалки. При необходимости можно изменить папку, в которой будут храниться файлы виртуалки. Next.

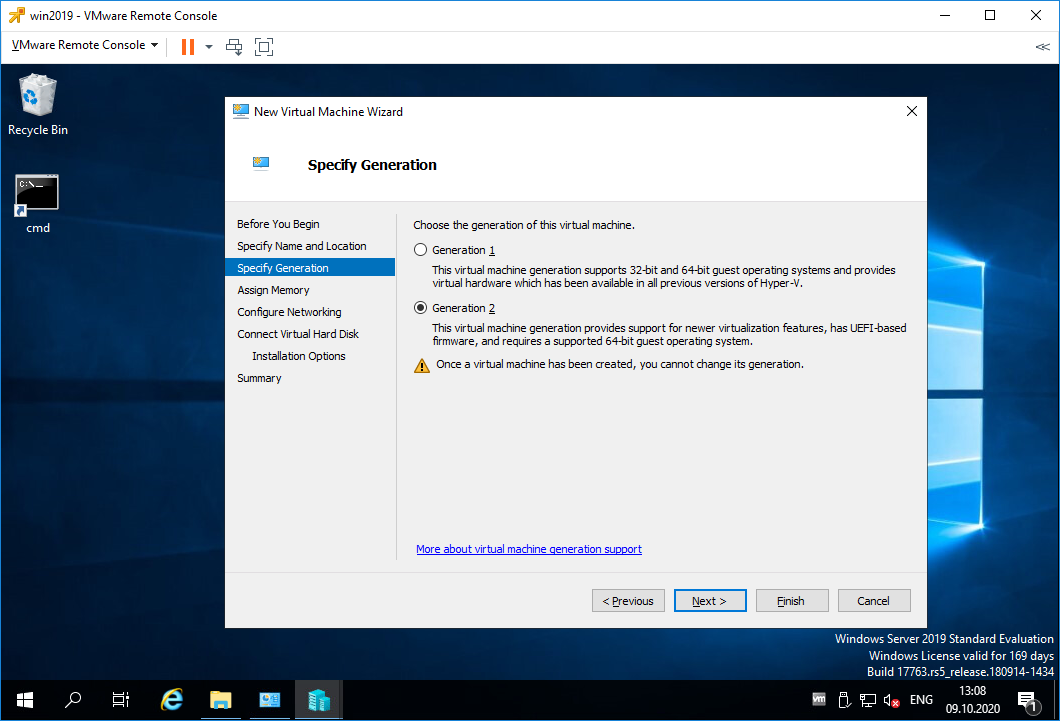

Попадаем в раздел Specify Generation. Выбор поколения зависит от того, какую операционную систему на виртуальной машине вы хотите установить, и метод загрузки, который вы хотите использовать для развертывания виртуальной машины. Виртуальные машины поколения 1 поддерживают большинство гостевых операционных систем. Виртуальные машины поколения 2 поддерживают большинство 64-разрядных версий Windows, Linux и FreeBSD. Рекомендуется выбрать поколение 2 за исключением случаев когда:

- Виртуальный жесткий диск, с которого требуется выполнить загрузку, не совместим с UEFI.

- Поколение 2 не поддерживает операционную систему, которую нужно запустить на виртуальной машине.

- Поколение 2 не поддерживает метод загрузки, который вы хотите использовать.

Next.

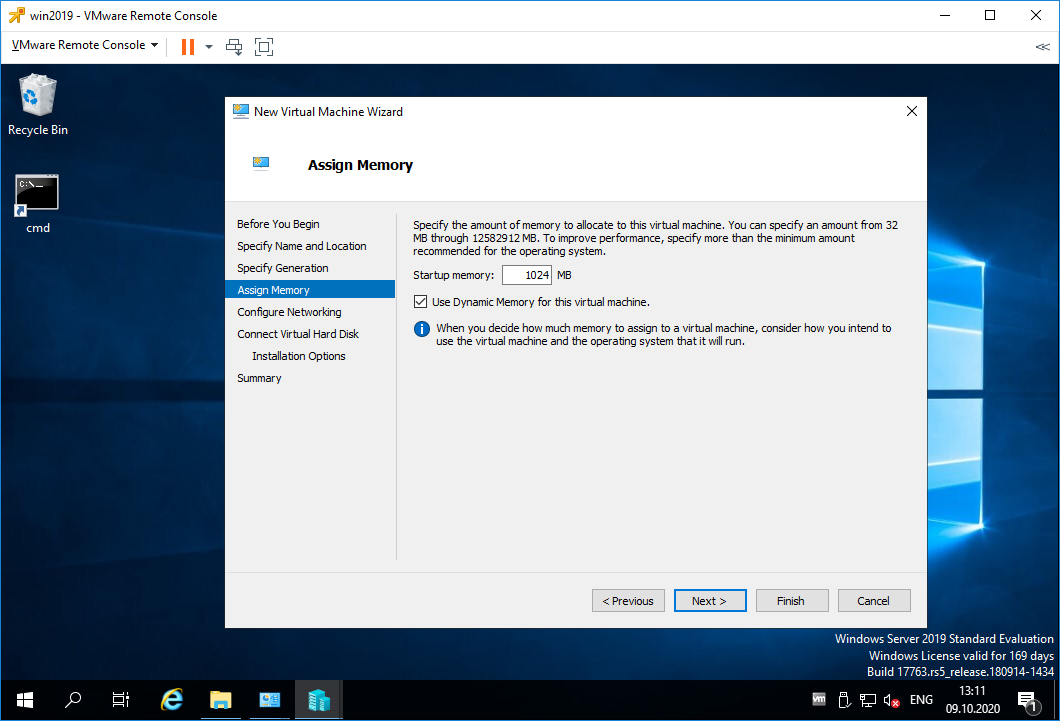

Попадаем в раздел Assign Memory. Выделяем память для виртуалки. Динамическая память забирается у сервера, как ни странно, динамически, т.е. сколько нужно, столько и забирается. Если галку не поставить, то вся выбранная память серверу будет недоступна. Next.

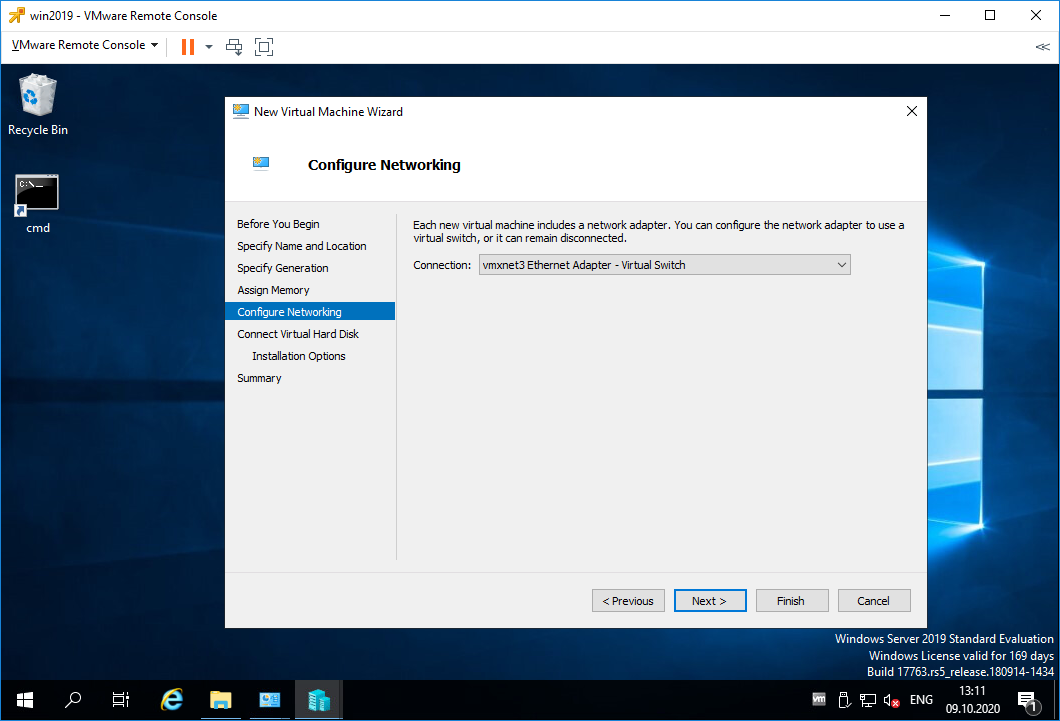

Попадаем в раздел Configure Networking. Выбираем виртуальный коммутатор. У меня он один. Next.

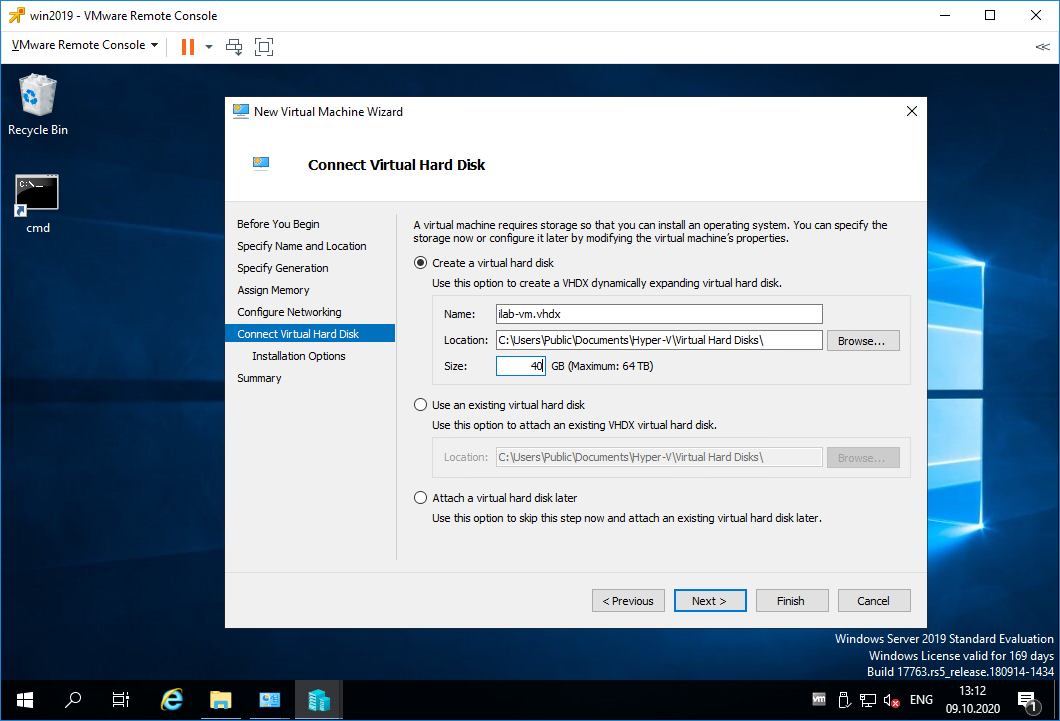

Попадаем в раздел Connect Virtual Hard Disk. Здесь создаём жёсткий диск, можно выбрать папку для его хранения. Можно подключить существующий жёсткий диск. Можно не подключать жёсткий диск. Я создаю новый диск объёмом 40 ГБ. Next.

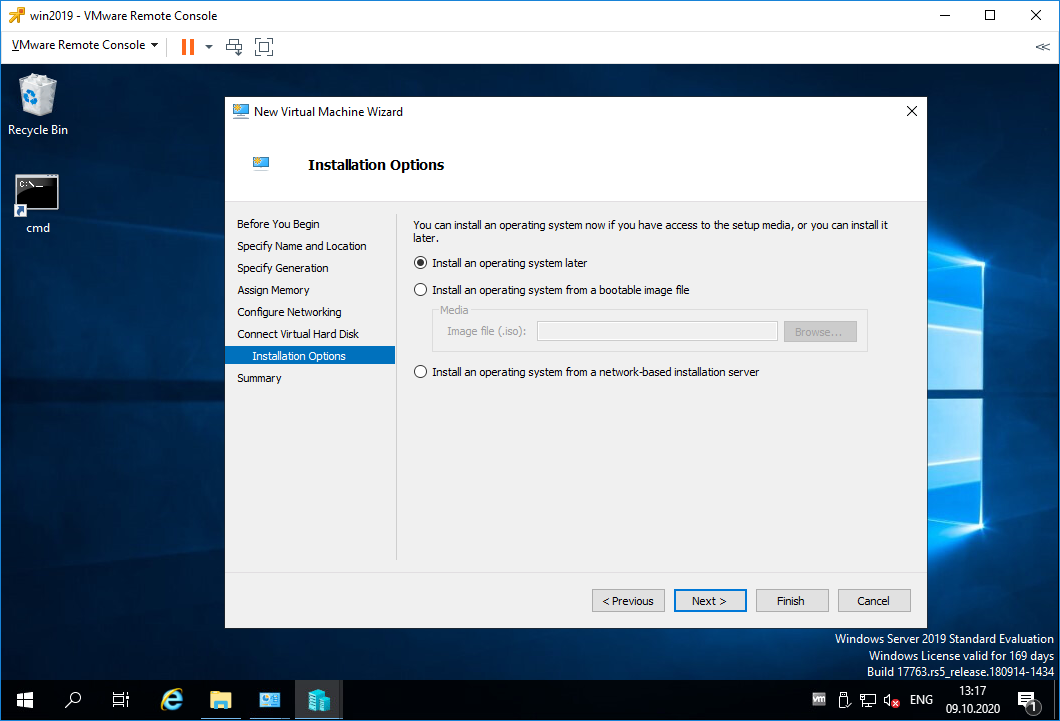

Попадаем в раздел Installation Options. Здесь можно примонтировать образ установочного диска, я сделаю это позже. Next.

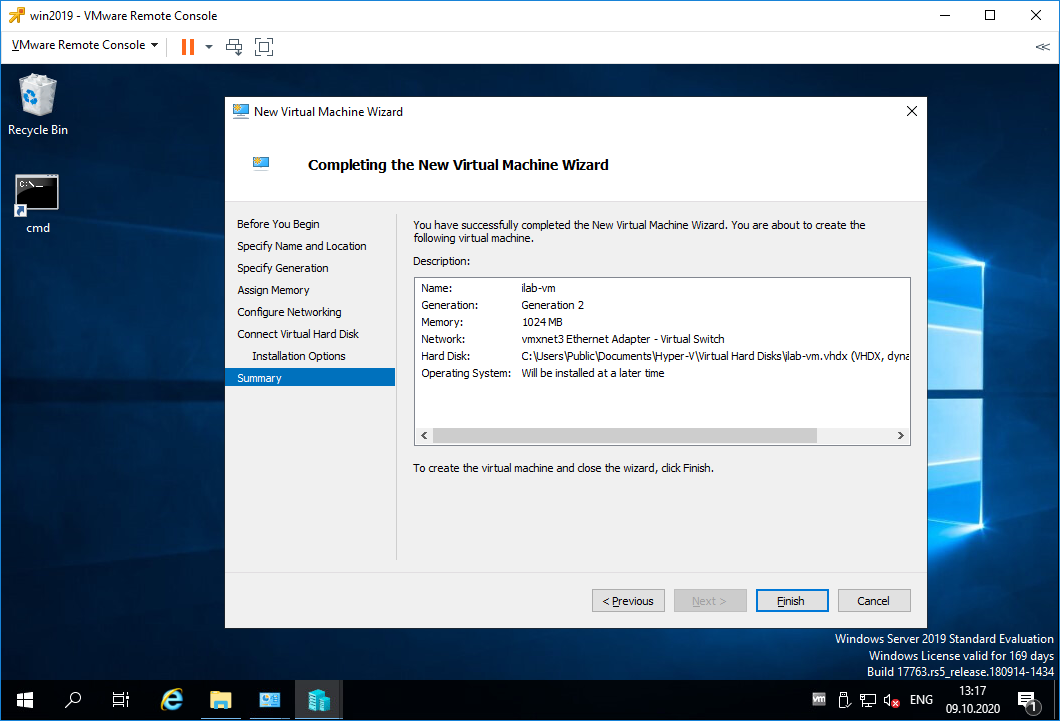

Попадаем в раздел Summary. Проверяем параметры. Finish.

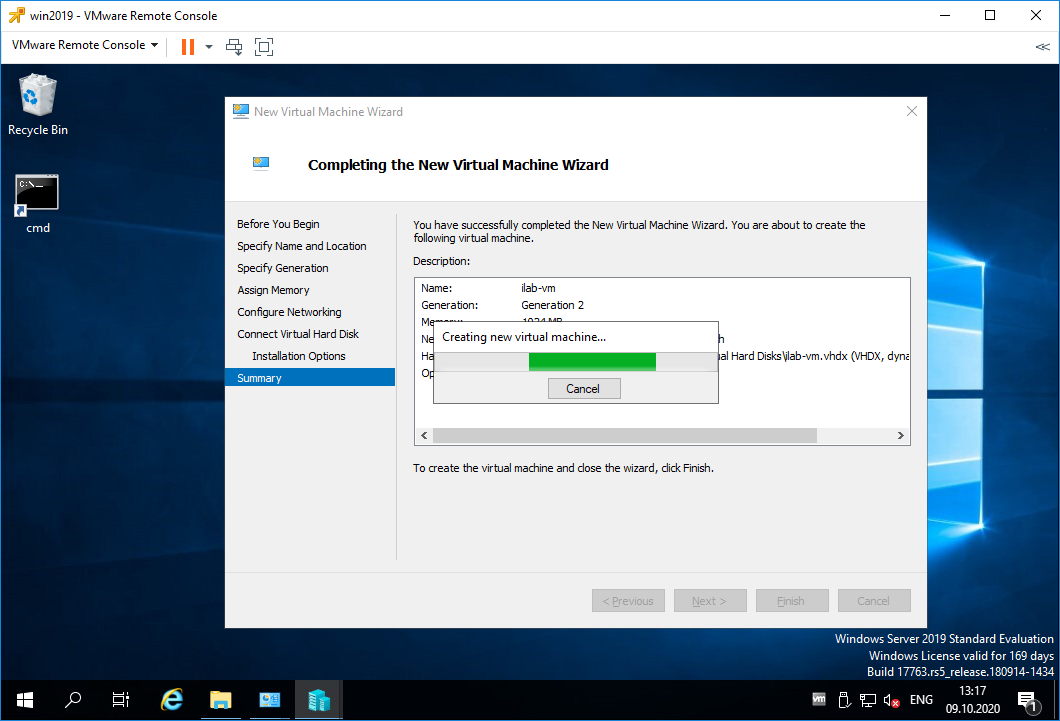

Начинается процесс создания виртуальной машины.

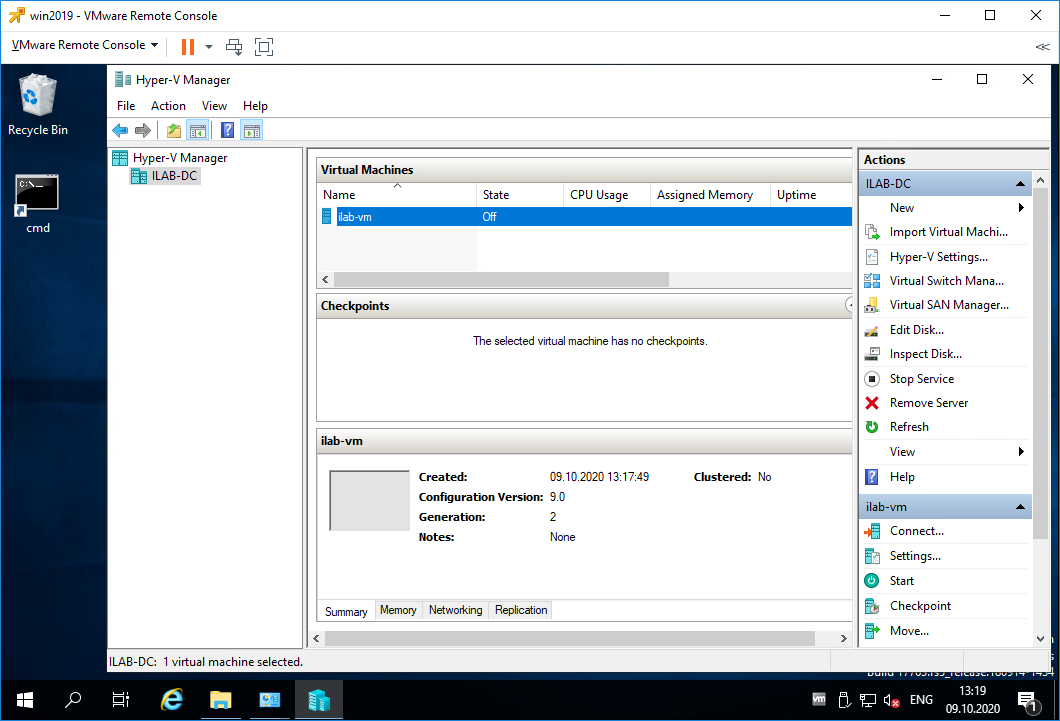

Виртуальная машина создана, она выключена (State = Off).

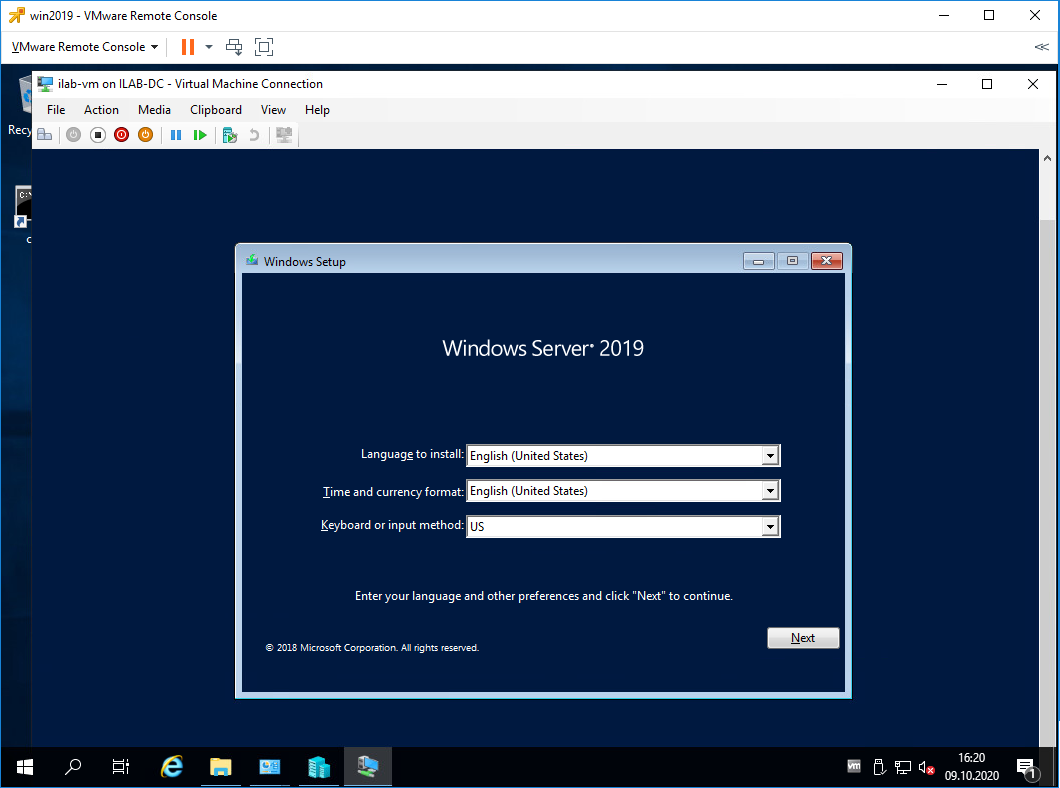

Установка операционной системы на виртуальную машину Hyper-V

Теперь примонтируем ISO образ к виртуальной машине и попробуем начать процесс установки операционной системы.

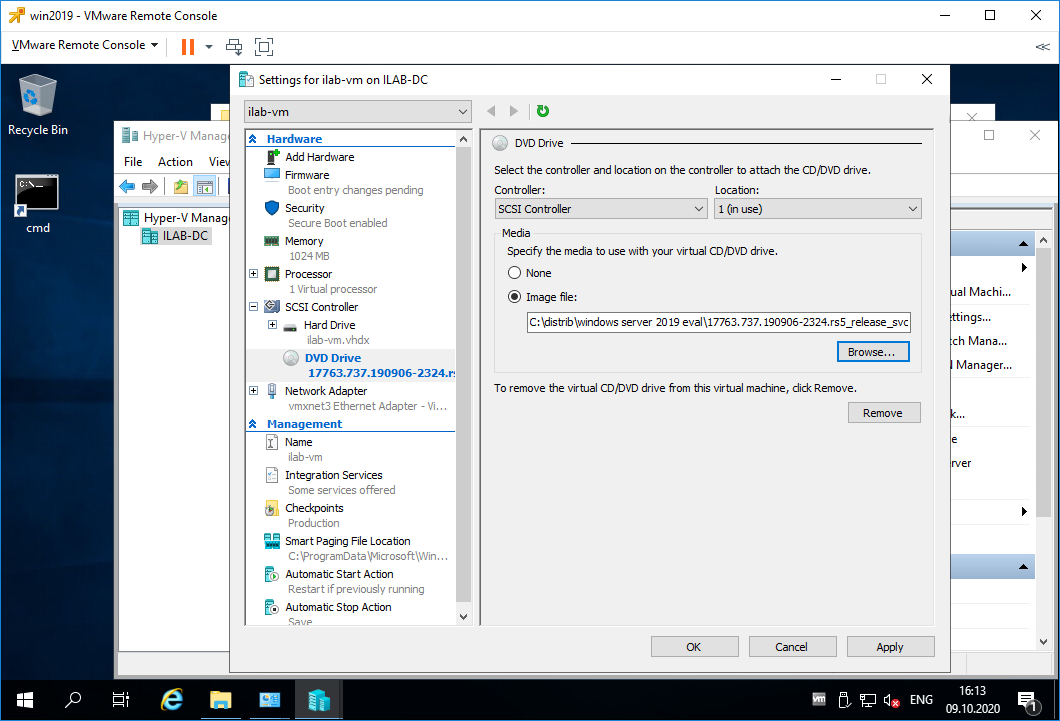

Выделяем виртуалку, нажимаем Settings.

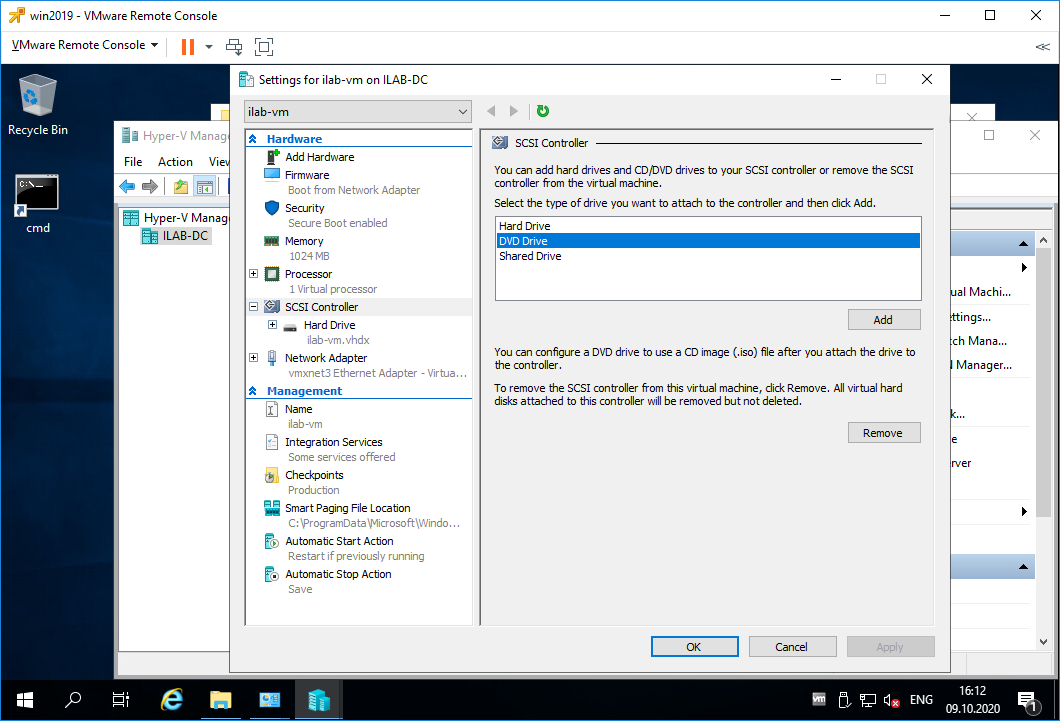

Переходим в раздел SCSI Controller. Видим, что в нём находится только жёсткий диск. Справа выбираем DVD Drive, Add.

У виртуальной машины появляется виртуальный DVD Drive. Выбираем Image file, выбираем ISO образ для установки операционной системы. Apply.

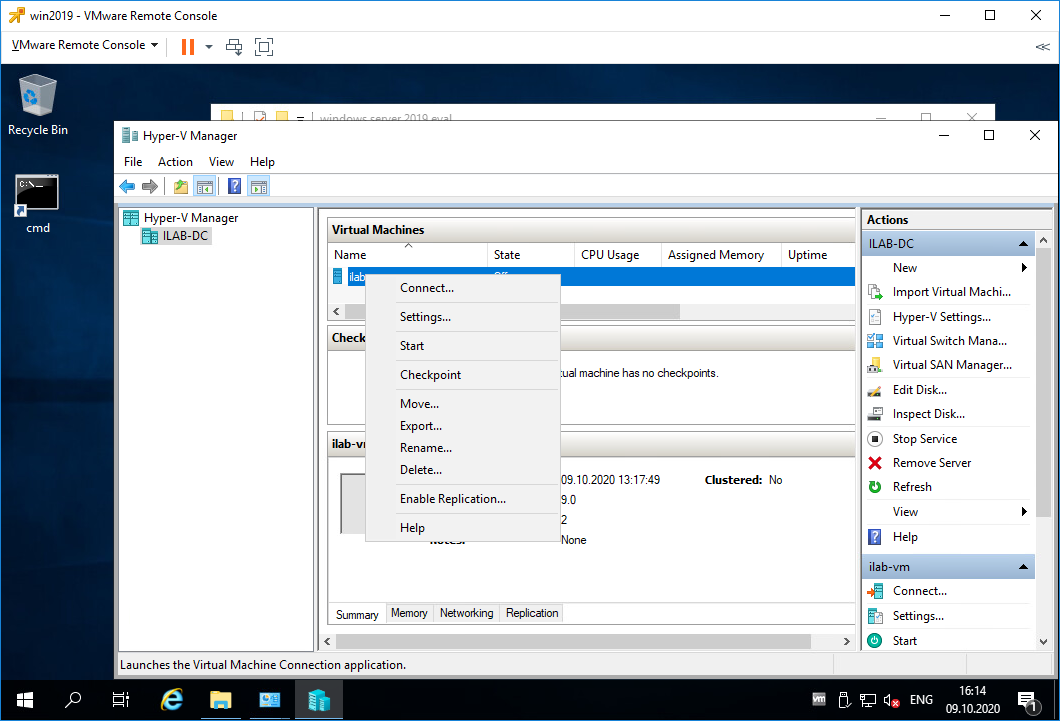

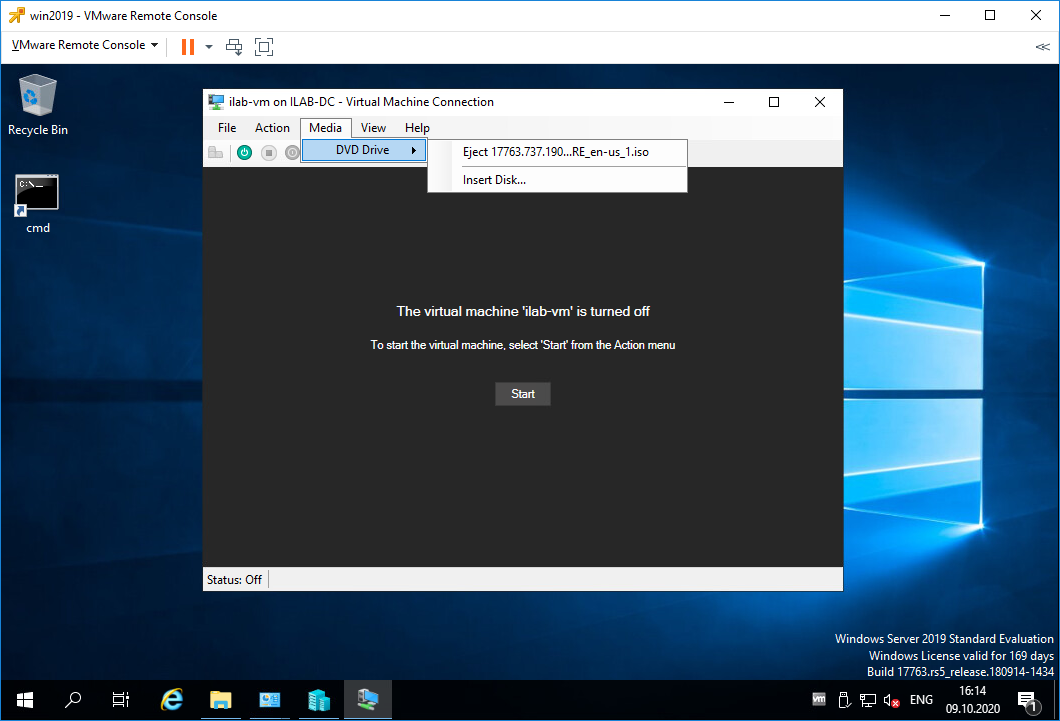

Правой кнопкой на виртуалку, Connect.

Открывается консоль виртуалки. ISO образ можно также вставить/извлечь в меню Mediz > DVD Drive. Включаем виртуалку, Start.

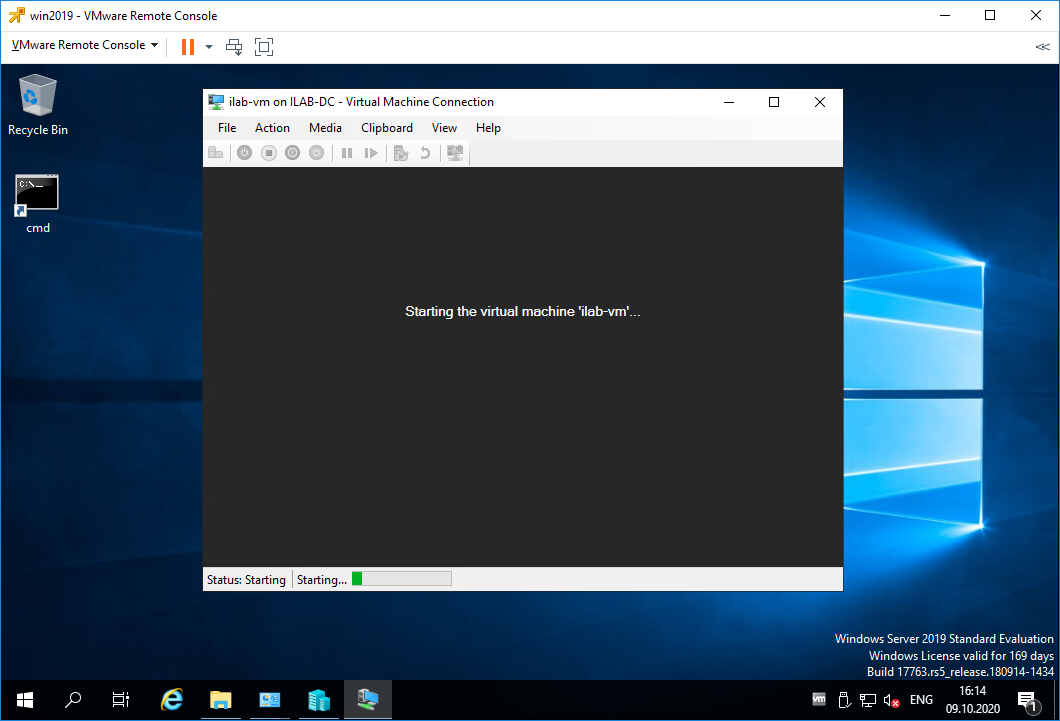

Виртуальная машина включается.

Загружается ISO образ и мы можем установить операционную систему, дальше вы справитесь.

Заключение

Мы с вами на сервере Windows Server 2019 установили роль Hyper-V, настроили виртуальный коммутатор и создали первую виртуальную машину. Подключили виртуальный дисковод и загрузились с установочного ISO образа операционной системы.

Добро пожаловать в волшебный мир виртуализации Hyper-V.

Содержание

- Записки IT специалиста

- Настраиваем сеть в Hyper-V.

- Внешняя сеть

- Внутренняя сеть

- Внутренняя сеть c NAT

- Частная сеть

- Параметры объединения сетевых карт

- Режимы объединения

- Не зависит от коммутатора

- Зависимый от коммутатор

- Режимы балансировки нагрузки

- Хэш адреса

- Порт Hyper-V

- Динамический

- Параметр резервного адаптера

- Свойство основного интерфейса группы

- Объединение сетевых карт windows 2019 hyper v

- Что такое Nic Teaming

- Требования и ограничения к Nic Teaming в Windows Server 2019

- Методы настройки объединения сетевых интерфейсов

- Настройка Nic Teaming в Windows Server 2019

- Использование диспетчера серверов

- Режимы поддержки групп

- Режим балансировки нагрузки

- Добавление и исключение сетевых адаптеров из NIC Teaming

- Добавление группового интерфейса в нужный VLAN

- Создание NIC Teaming через PowerShell

- Ключи TeamingMode

- Ключи LoadBalancingAlgorithm

- Добавление сетевых адаптеров из NIC Teaming через PowerShell

- Удаление сетевых адаптеров из NIC Teaming через PowerShell

- Настройка VLAN на NIC Teaming через PowerShell

- Удаление группы сетевых интерфейсов через PowerShell

- Популярные Похожие записи:

- 4 Responses to Объединение сетевых карт (Nic Teaming) в Windows Server 2019

Записки IT специалиста

Технический блог специалистов ООО»Интерфейс»

Настраиваем сеть в Hyper-V.

С одной стороны, ничего сложного в настройке сетей для виртуальных машин нет, с другой многие начинают путаться во всех этих адаптерах, с трудом понимая, где реальный, где виртуальный, и чем они друг от друга отличаются. Постараемся внести ясность.

За настройку сетей в Hyper-V отвечает Диспетчер виртуальных коммутаторов, если мы откроем его, то увидим следующую картину:

Внешняя сеть

Самый распространенный тип сети, который позволяет виртуальным машинам взаимодействовать с внешними сетями и хостом. При ее создании необходимо выбрать один из физических сетевых адаптеров, через который данная виртуальная сеть будет соединяться с внешними сетями.

В этом нетрудно убедиться, после создания внешней сети на хосте появляется Адаптер Ethernet для виртуальной сети Hyper-V, на который переносятся все настройки с физического адаптера.

Также имеется возможность создания внешних сетей, изолированных от хоста, в этом случае виртуальный сетевой адаптер не создается, а физический интерфейс отключается от хоста, обслуживая только виртуальный коммутатор. Для этого при создании внешней сети необходимо снять галочку Разрешить управляющей операционной системе предоставлять общий доступ к этому сетевому адаптеру.

Внутренняя сеть

Как следует из ее названия, внутренняя сеть предназначена для подключения виртуальных машин и хоста и не предусматривает соединения с внешними сетями. При ее создании также создается виртуальный сетевой адаптер для хоста, который оказывается подключен к виртуальному коммутатору внутренней сети и должен быть сконфигурирован в соответствии с настройками виртуальной сети.

Внутренняя сеть c NAT

Данная возможность появилась начиная с Windows Server 2016, Hyper-V Server 2016 и Windows 10. Подробнее читайте в нашей статье: Настраиваем сеть NAT в Hyper-V

Частная сеть

Частная сеть отличается от внутренней тем, что виртуальный коммутатор может быть подключен только к виртуальным машинам и изолирован от хоста.

Как видим, Hyper-V дает в руки администратора весьма гибкий и мощный инструмент, позволяющий создавать весьма сложные сетевые конфигурации и управлять ими.

Помогла статья? Поддержи автора и новые статьи будут выходить чаще:

Или подпишись на наш Телеграм-канал:

Источник

Параметры объединения сетевых карт

В этом разделе дается обзор свойств группы сетевых адаптеров, таких как объединение и режим балансировки нагрузки. Кроме того, мы предоставляем подробные сведения о параметре адаптера ожидания и свойстве основного интерфейса группы. Если у вас есть по крайней мере два сетевых адаптера в группе сетевых адаптеров, не нужно назначать резервный адаптер для отказоустойчивости.

Режимы объединения

Параметры режима объединения переключаются независимо друг от друга и переключаются. Режим, зависимый от коммутатора, включает статические объединение и протокол управления агрегированием связи (LACP).

Для лучшей производительности группы сетевых адаптеров рекомендуется использовать режим балансировки нагрузки динамического распределения.

Не зависит от коммутатора

В режиме независимого переключения коммутатор или коммутаторы, к которым подключены члены группы сетевых карт, не знают о наличии команды сетевого интерфейса и не определяют, как распределять сетевой трафик между членами группы сетевой карты. вместо этого Группа сетевых адаптеров распределяет входящий сетевой трафик между членами группы сетевой карты.

При использовании независимого режима с динамическим распределением нагрузка на сетевой трафик распределяется на основе хэша адреса TCP-портов, измененного алгоритмом динамической балансировки нагрузки. Алгоритм динамической балансировки нагрузки перераспределяет потоки, чтобы оптимизировать использование пропускной способности членов группы, чтобы отдельные передачи потоков можно было перемещать от одного активного члена группы к другому. В алгоритме учитывается небольшая вероятность того, что распределение трафика может привести к неупорядоченному доставке пакетов, так что для этого нужно свести к минимуму возможность.

Зависимый от коммутатор

При использовании режимов, зависящих от переключения, коммутатор, к которому подключены члены группы сетевых карт, определяет способ распределения входящего сетевого трафика между членами группы сетевой карты. С помощью коммутатора можно определить, как распределять сетевой трафик между членами группы сетевой карты.

Для переключения между зависимыми командами необходимо, чтобы все члены группы были подключены к одному физическому коммутатору или коммутатору с несколькими корпусами, который использует идентификатор коммутатора в нескольких корпусах.

Статическая объединение. Для статического объединения необходимо вручную настроить коммутатор и узел, чтобы определить, какие связи формируют команда. Так как это решение статически настроено, не существует дополнительного протокола, помогающего коммутатору и узлу обнаруживать неправильно подключенные кабели или другие ошибки, которые могут привести к сбою команды. Этот режим обычно поддерживается коммутаторами серверного класса.

Протокол управления агрегированием связи (LACP). В отличие от статических групп, режим объединения LACP динамически определяет связи, подключенные между узлом и коммутатором. Это динамическое подключение позволяет автоматически создавать команды и, теоретически, но редко на практике, расширять и сокращать группу просто путем передачи или получения пакетов LACP из одноранговой сущности. Все коммутаторы Server-Class поддерживают LACP, и для всех требуется, чтобы оператор Network был администратором включил LACP на порте коммутатора. При настройке режима объединения LACP объединение сетевых карт всегда работает в активном режиме LACP с коротким таймером. В настоящее время нет доступных параметров для изменения таймера или изменения режима LACP.

При использовании режима «зависимые» с динамическим распределением нагрузка на сетевой трафик распределяется на основе хэша адреса Транспортпортс, измененного алгоритмом динамической балансировки нагрузки. Алгоритм динамической балансировки нагрузки перераспределяет потоки для оптимизации использования пропускной способности членов команды. Отдельные передачи могут перемещаться от одного активного члена группы к другому как часть динамического распределения. В алгоритме учитывается небольшая вероятность того, что распределение трафика может привести к неупорядоченному доставке пакетов, так что для этого нужно свести к минимуму возможность.

Как и для всех конфигураций, зависящих от коммутатора, параметр определяет способ распределения входящего трафика между членами группы. Ожидается, что этот параметр выполняет разумное задание распределения трафика между членами группы, но полностью зависит от того, как это делает.

Режимы балансировки нагрузки

Параметры режима распределения балансировки нагрузки: хэш адреса, порт Hyper-V и динамический.

Хэш адреса

При использовании хэш-адреса этот режим создает хэш на основе компонентов адреса пакета, который затем назначается одному из доступных адаптеров. Обычно только этот механизм достаточно для создания разумного баланса между доступными адаптерами.

используйте Windows PowerShell, чтобы указать значения для следующих компонентов функции хэширования.

Только исходный и конечный IP-адреса.

Только исходный и конечный MAC-адреса.

Хэш портов TCP создает наиболее детализированное распределение потоков трафика, что приводит к уменьшению количества потоков, которые могут быть независимо перемещены между членами группы сетевой карты. Однако нельзя использовать хэш портов TCP для трафика, не основанного на TCP или UDP, или в том случае, если порты TCP и UDP скрыты из стека, например с трафиком, защищенным с помощью IPsec. В этих случаях хэш автоматически использует хэш IP-адреса или, если трафик не является IP-трафиком, используется хэш MAC-адреса.

Порт Hyper-V

при использовании порта hyper-v Teams сетевых адаптеров, настроенных на узлах Hyper-v, предоставляют независимые от виртуальных машин MAC-адреса. Для разделения сетевого трафика между членами группы сетевой карты можно использовать MAC-адрес виртуальных машин или виртуальную машину, подключенную к коммутатору Hyper/V. вы не можете настроить Teams NIC, созданные в виртуальных машинах с помощью режима балансировки нагрузки портов Hyper-V. Вместо этого используйте режим хэширования адреса.

Так как смежный коммутатор всегда видит конкретный MAC-адрес на одном порту, коммутатор распределяет нагрузку входящего трафика (трафик от коммутатора на узел) по нескольким каналам на основе адреса узла MAC (VM MAC). Это особенно удобно при использовании очередей виртуальных машин (ВМКС), так как очередь может быть размещена на конкретном сетевом адаптере, где ожидается поступление трафика.

Однако если узел содержит только несколько виртуальных машин, этот режим может оказаться недостаточно детализированным, чтобы обеспечить сбалансированное распределение. Этот режим также всегда ограничивает одну виртуальную машину (т. е. трафик с одного порта коммутатора) на пропускную способность, доступную в одном интерфейсе. При объединении сетевых карт в качестве идентификатора используется порт виртуального коммутатора Hyper-V, а не MAC-адрес источника, поскольку в некоторых случаях виртуальная машина может быть настроена с несколькими MAC-адресами на порте коммутатора.

Динамический

Благодаря динамической нагрузке исходящие нагрузки распределяются на основе хэша TCP-портов и адресов IP. Динамический режим также обеспечивает повторную балансировку нагрузки в режиме реального времени, чтобы заданный исходящий поток мог перемещаться между членами группы. Входящие нагрузки, с другой стороны, распределяются так же, как порт Hyper-V. В двух словах, динамический режим использует лучшие аспекты хэш-адреса и порта Hyper-V, а также самый высокий режим балансировки нагрузки.

Исходящие нагрузки в этом режиме динамически сбалансированы в зависимости от концепции фловлетс. Так же, как человеческий голос имеет естественные перерывы в конце слов и предложений, TCP-потоки (коммуникационные TCP-потоки) также естественным образом нарушают работу. Часть TCP-потока между двумя такими разрывами называется фловлет.

Когда алгоритм динамического режима обнаруживает, что фловлет граница была обнаружена, например, когда в потоке TCP произошла недостаточная длина, алгоритм автоматически перераспределяет поток в другой член команды, если это уместно. В некоторых обстоятельствах алгоритм также может периодически перераспределять потоки, которые не содержат фловлетс. По этой причине сходство между потоком TCP и участником команды может измениться в любое время, так как алгоритм динамической балансировки работает для балансировки рабочей нагрузки членов группы.

Независимо от того, настроена ли команда с переключением на независимый или один из режимов переключения, для лучшей производительности рекомендуется использовать динамический режим распределения.

Существует исключение из этого правила, когда группа сетевых адаптеров состоит только из двух членов группы, настраивается в независимом режиме и включает режим «активный/ждущий», при этом одна сетевая карта активна, а другая настроена для резервирования. С этой конфигурацией группы сетевых адаптеров адресное распределение адресов обеспечивает немного более высокую производительность, чем динамическое распространение.

Параметр резервного адаптера

Для параметра «резервный адаптер» задано значение «нет» (все адаптеры активны) или выбор определенного сетевого адаптера в группе сетевых адаптеров, который выступает в качестве резервного адаптера. При настройке сетевой карты в качестве резервного адаптера все остальные невыбранные члены группы активны, и сетевой трафик не отправляется или не обрабатывается адаптером до тех пор, пока не произойдет сбой активного сетевого адаптера. После сбоя активного сетевого адаптера резервный сетевой адаптер станет активным и обработает сетевой трафик. Когда все члены группы восстанавливаются в службу, член Рабочей группы Standby возвращается в состояние Standby.

Если у вас есть команда с двумя СЕТЕВыми адаптерами и вы решили настроить один сетевой адаптер в качестве резервного, будут потеряны преимущества статистической обработки пропускной способности, существующие в двух активных сетевых картах. Для достижения отказоустойчивости не нужно назначать резервный адаптер. отказоустойчивость всегда присутствует при наличии по крайней мере двух сетевых адаптеров в группе сетевых адаптеров.

Свойство основного интерфейса группы

Чтобы открыть диалоговое окно интерфейс основной группы, необходимо щелкнуть ссылку, выделенную на рисунке ниже.

При использовании виртуальных ЛС можно использовать это диалоговое окно, чтобы указать номер виртуальной ЛС.

Независимо от того, используете ли вы виртуальные ЛС, можно указать имя сетевой карты для группы сетевых адаптеров.

Источник

Объединение сетевых карт windows 2019 hyper v

Что такое Nic Teaming

Сейчас когда бизнес уже очень сильно зависит от доступности его сервисов, таких как корпоративная почта, файловый сервер, сайт с веб приложениями и CRM, и многое другое очень сильно встает вопрос по организации отказоустойчивости на разных уровнях. Одним из таких уровней является сетевой. В данной статье нам нужно рассмотреть про организацию отказоустойчивой сети в вашем Windows Server 2019. Сейчас уже себе сложно представить сервер, у которого было бы сетевых интерфейсов меньше двух, чаще всего их четыре и более. Раз они есть, то было бы здорово их объединить и использовать, как одно целое решая тем самым:

Предположим, что у нас вышел из строя один сетевой адаптер, в результате прохождение трафика перестроилось.

Ранее Nic Teaming мог быть реализован только посредством установки специальных драйверов на ваши сетевые карты. Эти драйвера позволяли вам через свойства сетевых адаптеров собирать пулы. Бывало так, что у вас на физическом сервере могли быть сетевые карты разных производителей, и в таком сценарии вы могли иметь проблемы с объединением сетевых карт. Благодаря встроенной возможности Windows Server 2019 эта проблема минимизируется.

Хочу отметить, что данная технология не нова и давно уже реализована и используется на сетевом оборудовании, там она называется LACP, или на системах хранения, например у Synology, там она называется Bonding, в Linux то же Bonding.

Требования и ограничения к Nic Teaming в Windows Server 2019

Как сказано в документации Microsoft драйвер сетевой карты должен иметь цифровую подпись Windows Hardware Qualification and Logo (WHQL). Если WHQL имеется, то вы может объединять адаптеры разных производителей.

Нужно учитывать, что для работы Nic Teaming сетевые карточки должны иметь одинаковую пропускную способность, если вы используете объединение от других производителей, то не используйте их совместно с инструментом Microsoft.

Так же вы не сможете объединить в группу карточки которые работают не по технологии Ethernet, такие как WWAN, Wi-FiInfiniband, сетевые адаптеры отладки ядра (KDNIC). Так же есть ряд технологий, которые не поддерживаются технологией объединения сетевых карт:

Методы настройки объединения сетевых интерфейсов

Существует три метода и два подхода по настройке ваших сетевых карт в общую сетевую группу:

Из инструментов я могу выделить:

Настройка Nic Teaming в Windows Server 2019

Использование диспетчера серверов

Данный метод самый простой и часто используемый, так как подходит большинству системных администраторов, он позволит вам производить настройки тиминга и на серверах Windows Core. Открываем диспетчер серверов, в моем примере на сервере SVT2019S01, у него есть четыре гигабитные сетевые карты intel 82574L. Как видно по умолчанию в Windows Server 2019 объединение сетевых карт отключено, щелкаем по настройке.

В статье по настройке сети в Windows Server 2019 я вам показывал команду PowerShell показывающую вам сетевые настройки:

В результате видно, что мои адаптеры имеют 4 разных Ip-адреса, один статический 192.168.31.3 и три динамических, полученных от DHCP-сервера. Я сделаю пул состоящий из четырех сетевых адаптеров и назначу ему IP-адрес 192.168.31.3.

В результате у вас должно открыться окно «Объединение сетевых карт«, оно будет разбито на три раздела:

Объединение сетевых карт у нас начинается с создания новой группы. В разделе группы, нажмите кнопку «Задачи» и выберите пункт «Создать группу».

Откроется окно создания группы. Тут вам нужно выбрать под себя и свои задачи ряд параметров, а именно:

Нажмите кнопку «Дополнительные свойства«, в ней весь сок. Тут вы сможете настроить:

Режимы поддержки групп

В режиме «Статическая поддержка групп» исходящий трафик при режиме балансировки (Хэш адреса «Address Hash») будет распределяться между всеми активными адаптерами в группе объединенных сетевых карт. Входящий трафик так же будет перенаправлен в соответствии с заданным алгоритмом нагрузки, который задан на коммутаторе.

Режим балансировки нагрузки

При объединении сетевых карт вам не только нужно выбрать режим поддержки, но и еще необходимо задать режим балансировки, коих целых три:

Ниже я расскажу про каждый из них.

Если вы выбираете режим на основе портов, то это равномерное распределение трафика, но если у вас трафик не TCP/UPD, то применяться будет режим IP-адреса, если трафик не IP, то будет хэш на основе MAC-адреса.

Разобравшись с основными понятиями, можно продолжить объединение сетевых карт. В своем примере я для начала объединю в NIC Teaming два сетевых интерфейса «Ethernet0» и «Ethernet1». Дополнительные настройки я выберу:

Применяем настройки, в итоге первый сетевой адаптер у вас сразу будет в зеленом, активном состоянии, дополнительный сетевой адаптер, может легко иметь статус «Неисправный, ожидает подключения». Связано это с тем, что идет сборка NIC Teaming, так что можете не беспокоиться.

Через пару секунд мы видим, что оба адаптера имеют статус «Активный» и все зелененькое.

В левой части вы будите видеть вашу группу объединенных сетевых интерфейсов и ее текущие настройки. Если необходимо их поменять, то кликаем по группе правой кнопкой мыши и из контекстного меню выберите пункт «Свойства«.

В результате у вас откроется знакомое вам окно со всеми свойствами группы.

Теперь давайте мы с вами откроем окно «Сетевые подключения», обратите внимание, что у вас появился новый виртуальный адаптер (Microsoft Network Adapter Multiplexor Driver). У него своеобразный значок, отличный от обычных карт, открыв его свойства вы сразу можете увидеть, что его скорость стала 2 Гбит/с, это логично, у нас же произошло сетевое объединение двух адаптеров по 1 Гбит/с. Открыв свойства подключения, я вижу, что получил динамический IP-адрес от моего DHCP сервера, при желании вы можете задать статические настройки.

Если вы теперь попытаетесь посмотреть свойства любого из сетевых адаптеров участвующих в тиминге, то у них уже не будет своего IP-адреса, так как он выступает в роли силинка (Это можно сравнить с обычным патч кордом подключенным от коммутатора к серверу)

Убедиться в том, что это силинк можно. так же увидев, что в свойствах адаптера отключены пункты IP версии 4 и 6.

Так же это можно проверить, через команду IPCONFIG, которая выведет три сетевых интерфейса.

Еще хочу обратить внимание, что на интерфейсе NIC Teaming появился новый драйвер «Microsoft Load Balancing/Failover Provider«, он и участвует в алгоритме балансировки трафика.

Добавление и исключение сетевых адаптеров из NIC Teaming

Давайте я в свою группу teaming-pyatilistnik добавлю третий сетевой адаптер. Для этого в диспетчере серверов в свойствах группы поставьте галки на против нужных. Я добавлю сетевые адаптеры «Ethernet2» и «Ethernet3», последний у меня будет, как резервный. Применяем.

Так же ждем настройки.

В итоге мы расширили наше объединение сетевых адаптеров, три активных и один резервный.

Проверяем утилитой IPCONFIG, видим, что в моей Windows Server 2019 один сетевой интерфейс, но 4-ре физических адаптера. Тиминг готов.

Благодаря этому, я добился пропускной способности в 3 Гбит/с и с одним резервным адаптером.

Для того, чтобы удалить один из сетевых адаптеров из NIC Teaming, в свойствах просто снимаем галку.

Удаление происходит практически моментально.

Добавление группового интерфейса в нужный VLAN

Я уверен, что у вас не плоская сеть и вы используете VLAN для разделения трафика. Настроить номер VLAN можно в диспетчере задач, вкладка «Групповые интерфейсы«, вызовите свойства вашей группы сетевых адаптеров.

Ставим галку «Конкретная виртуальная ЛС», где в определенном поле нужно указать номер VLAN, обратите внимание, что данный номер будет дописан в название NIC Teaming.

Если вы планируете использовать VLAN внутри виртуальной машины Hyper-V, то настраивать виртуальную ЛС нужно на виртуальном коммутаторе, а не на группе объединения сетевых карт. Если у вас стоит задача в виртуальной машине использовать несколько виртуальных сетей, то вы каждый порт коммутатора настраиваете на нужный VLAN, никогда не делайте это внутри виртуальной машины. Если же вы используете виртуальные функций SR-IOV (VFs), то обязательно проверьте, что они находятся в одном VLAN, перед тем как их будите объединять.

Создание NIC Teaming через PowerShell

Чтобы создать сетевое объединение интерфейсов через командлеты, вам нужно открыть PowerShell от имени администратора. Первым делом вам нужно посмотреть список физических адаптеров, для этого введите:

В моем примере их 4-ре. Предположим, что я хочу объединить в NIC Teamin первые два адаптера «Ethernet1» и «Ethernet2».

Для создания мы будем использовать командлет New-NetLbfoTeam.

Ключи TeamingMode

Ключи LoadBalancingAlgorithm

Вас спросят, действительно ли вы хотите создать объединенную группу сетевых интерфейсов, говорим «Y». Сразу вы увидите статус «Degraded», через некоторое время уже «Up».

Если нужно изменить поменять настройки вашей тиминговой группы, то для этого есть командлет Set-NetLbfoTeam. Допустим я хочу, чтобы режим поддержки групп был LACP, команда будет выглядеть вот так:

Хочу отметить, что если вы попытаетесь, как и в моем примере сделать, это на виртуальной машине, то получите ошибку;

Она вам прямым текстом скажет, что на виртуалках можно использовать только режим SwitchIndependent, на железных серверах все будет работать. Теперь давайте поменяем режим балансировки на IPAddresses, для этого пишем:

Добавление сетевых адаптеров из NIC Teaming через PowerShell

Предположим, что вы решили добавить еще один сетевой адаптер в объединение сетевых интерфейсов, как видим у меня NIC Teaming состоит из адаптеров «Ethernet0» и «Ethernet1», я добавлю «Ethernet2»

Удаление сетевых адаптеров из NIC Teaming через PowerShell

Если стоит задачу удалить сетевой адаптер из вашей группы объединенных сетевых интерфейсов, то выполним команду:

Настройка VLAN на NIC Teaming через PowerShell