В этой небольшой инструкции мы покажем пошагово как создать простой отказоустойчивый кластер Hyper-V Cluster из двух серверов с Windows Server 2016. Такой кластер позволяет без особых проблем организовать отказоустойчивость для виртуальных машин Hyper-V при аппаратных проблемах с одним из серверов.

- Предварительные требования к отказоустойчивому кластеру Hyper-V

- Настройки сети Hyper V

- Установка кластера Hyper-V

- Настройка кластера Hyper-V

Содержание:

Предварительные требования к отказоустойчивому кластеру Hyper-V

- Два сервера с установленной ОС Windows Server 2016 (желательно чтобы количество памяти и CPU на обоих серверах было одинаково)

- Установленная роль Hyper-V с компонентами Failover Cluster и MPIO ( iSCSI по необходимости)

- Как минимум по 2 сетевых карты на каждом сервере (одна сетевая карта будет использоваться для управления и через нее будет идти трафик ВМ, вторая – для взаимодействия хостов между собой – трафик CSV и Heartbeat)

- Общее дисковое хранилище, подключенное к обоим серверам (в этом примере дисковый массив подключается к каждому серверу через 2 порта Fiber Channel, при этом компонент MPIO нужен для того, чтобы каждый сервер видел только одно подключение к диску, а не два)

- Как минимум один диск (LUN) с общего хранилища презентован обоим сервера, инициализирован и отформатирован.

Настройки сети Hyper V

В нашем примере мы настроим следующую IP адресацию для компонентов кластера:

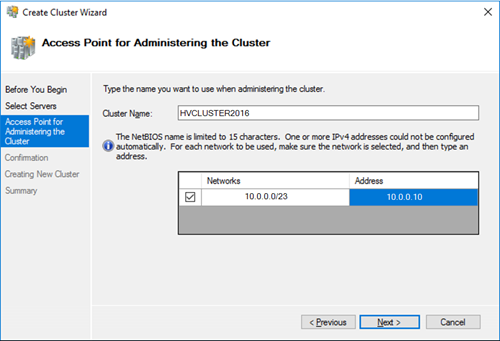

Общее имя кластера: HVCLUSTER2016 (IP адрес 10.0.0.10)

Первый сервер: имя HOST01, с двумя интерфейсами

10.0.0.11 – интерфейс управления, и трафика виртуальных машин

10.0.1.11 – интерфейс для трафика Cluster Shared Volume и Heartbeat

Второй сервер: имя HOST02, с двумя интерфейсами

10.0.0.12 — интерфейс управления, и трафика виртуальных машин

10.0.1.12 – интерфейс для трафика Cluster Shared Volume и Heartbeat

Установка кластера Hyper-V

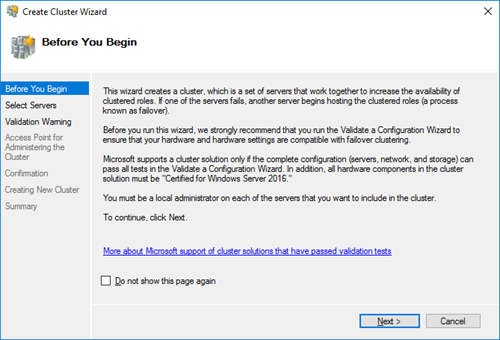

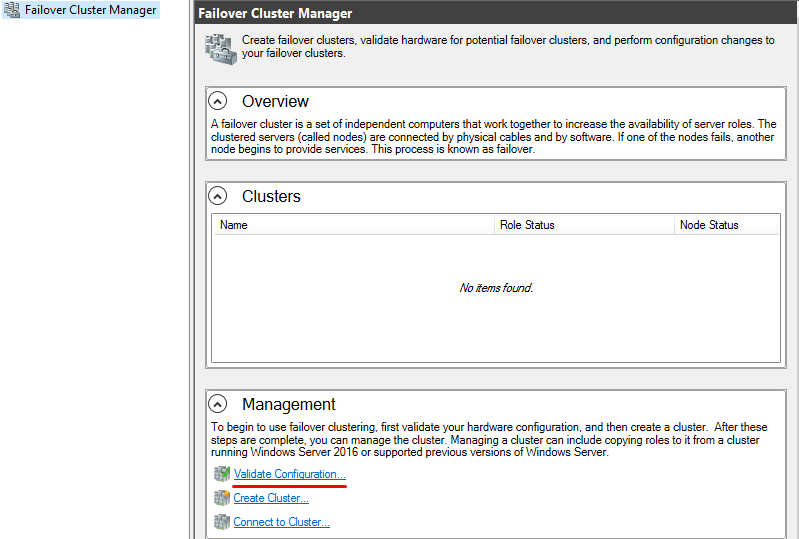

Итак, на любом из серверов запускаем оснастку Failover Cluster Manager и запускаем мастер создания кластера (Create Cluster).

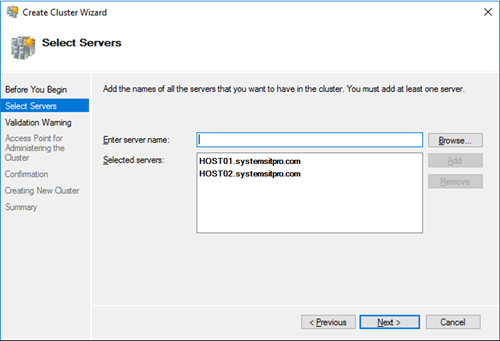

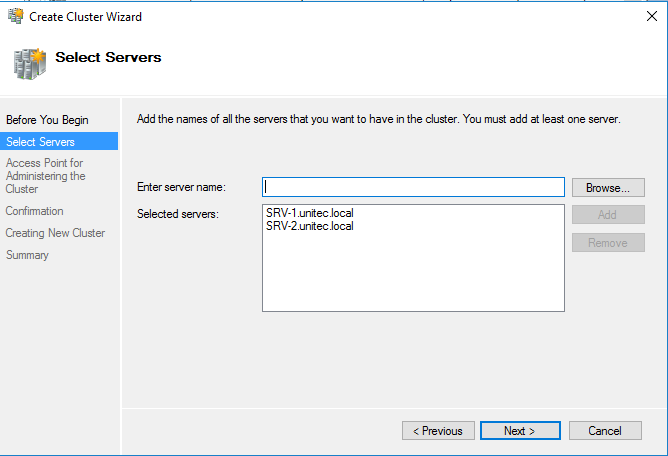

На странице выбора серверов кластера добавляем обе наших ноды.

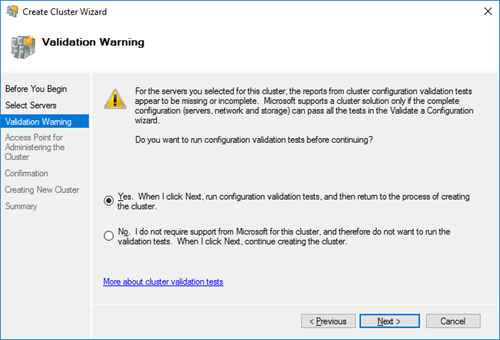

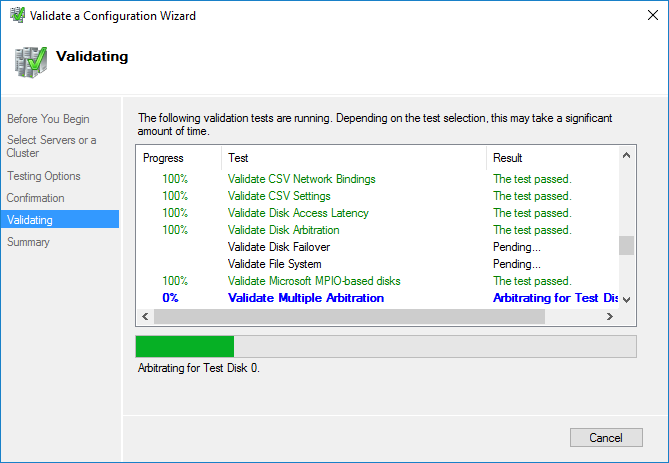

На странице Validation Warning соглашаемся с запуском встроенных тестов валидации кластерной конфигурации.

Выберите, что нужно прогнать все тесты.

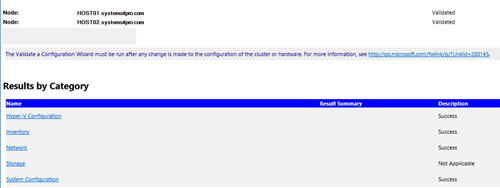

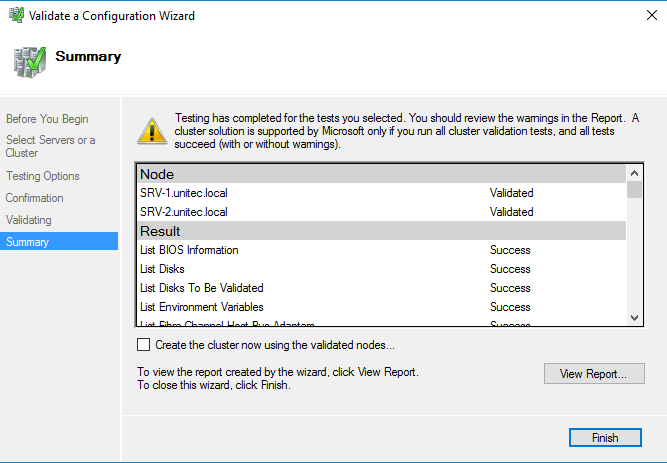

Нужно дождаться окончания валидации. Если будут найдены ошибки – их нужно исправить. После этого нажать на Finish.

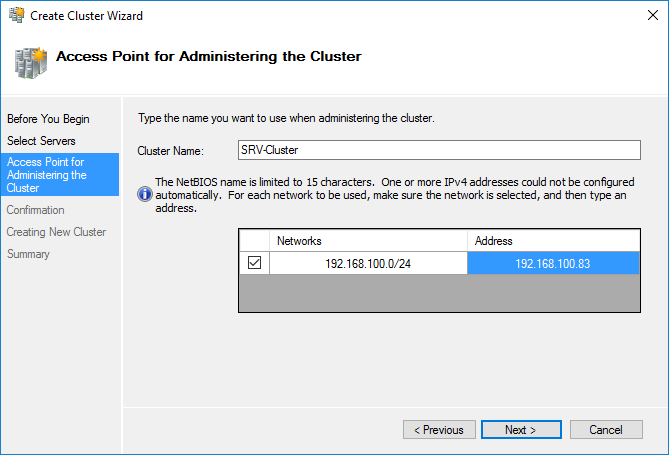

Далее на странице настройки Access Point for Administering the Cluster нужно указать имя кластера и его IP адрес и подсеть.

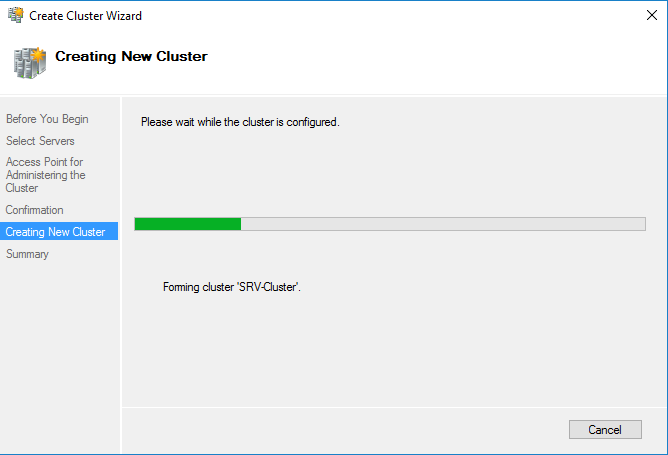

Осталось нажать 2 раза кнопку Next и мастер создаст новый кластер.

Настройка кластера Hyper-V

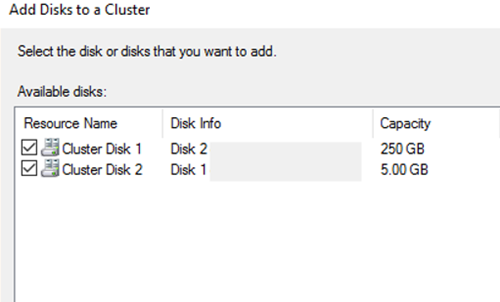

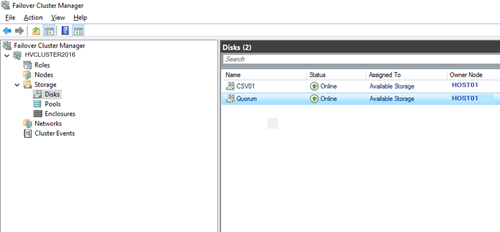

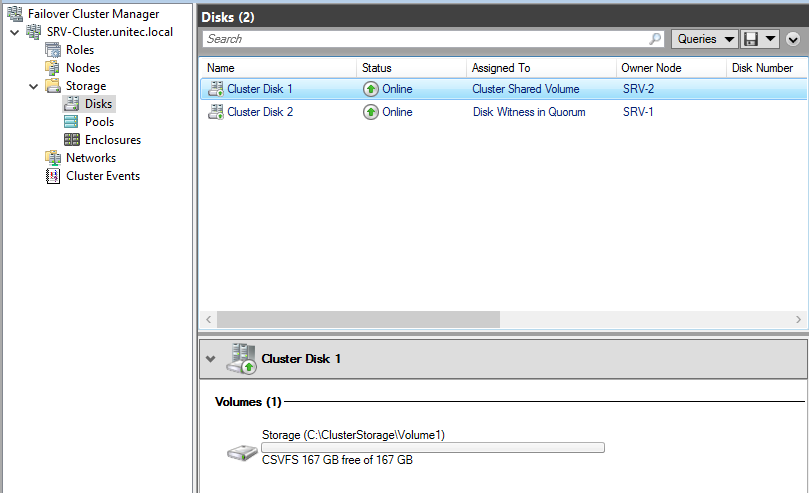

Теперь в кластер нужно добавить диски. Для этого откройте консоль Failover Cluster Management и в разделе Storage -> Disks добавьте общие в кластер общие диски (они должны быть инициализированы и отформатированы)

Задайте содержательные имена дискам. В нашем примере один кластерный диск будет использоваться как том Cluster Shared Volumes (CSV) для хранения файлов ВМ, а второй использоваться для кворума (диск небольшого размера).

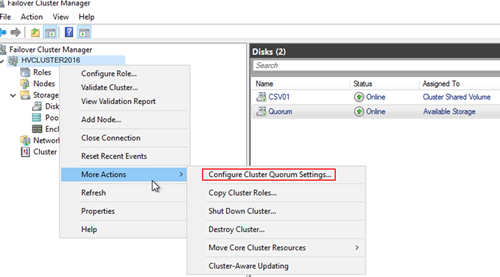

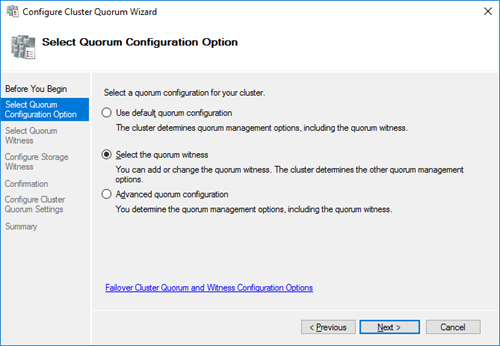

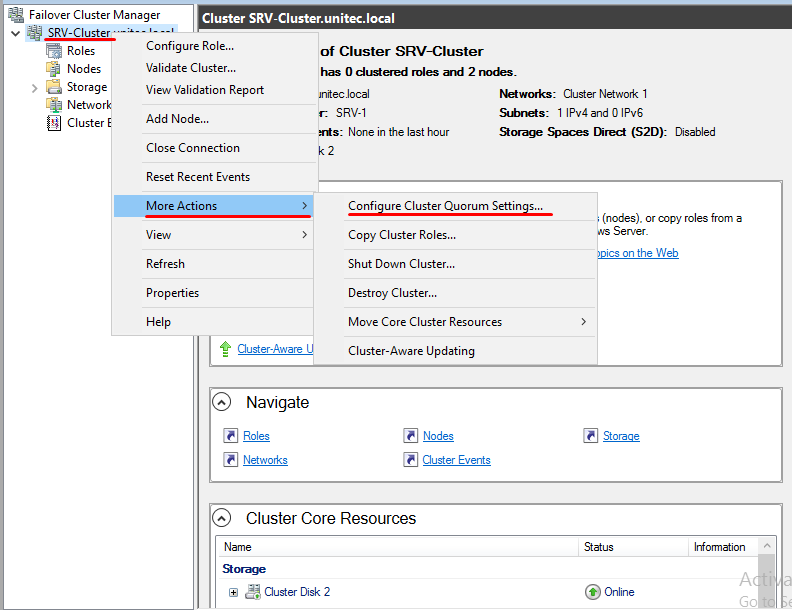

Далее нужно настроить кластерный кворум. Для этого щелкните ПКМ по имени кластера и выберите пункт меню More Actions-> Configure Cluster Quorum Settings.

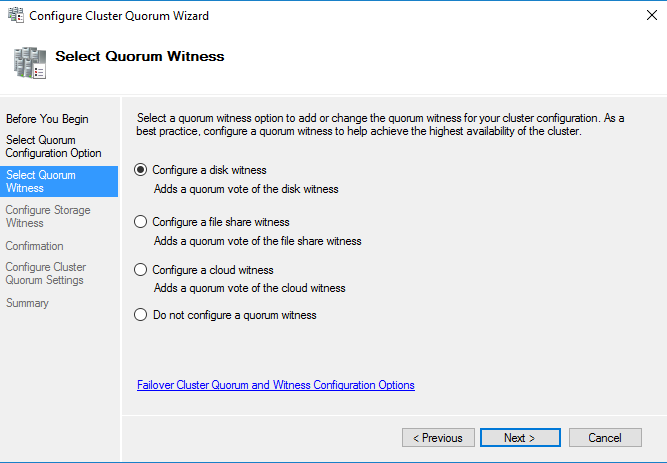

Выберите вариант настройки кворума для кластера Select the quorum witness.

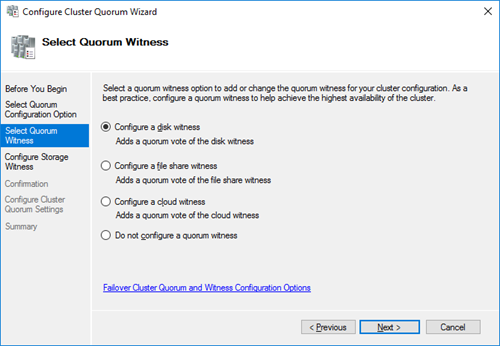

В качестве типа кворума выберите Quorum Witness Select Disk Witness (кворум с использованием диска свидетеля).

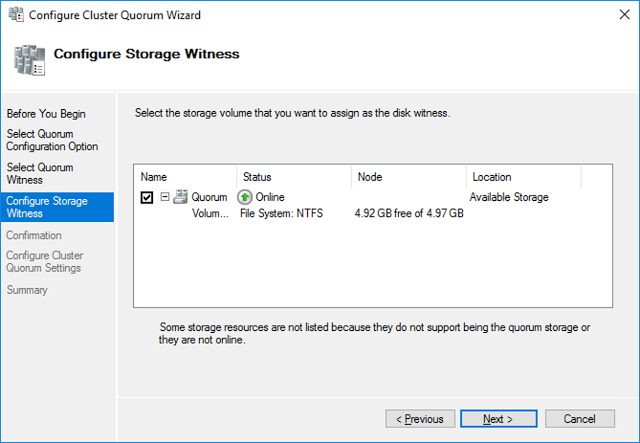

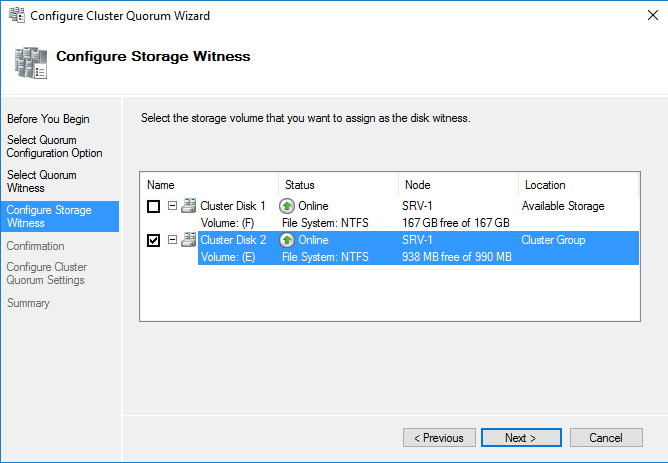

Выберите кластерный диск, который вы хотите использовать в качестве диска-свидетеля.

Теперь в настройках Hyper-V на каждой из нод нужно указать кластерный том CSV в качестве диска по-умолчанию для хранения виртуальных машин.

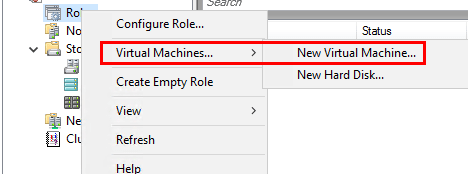

Теперь можно в консоли управления кластером создать новую виртуальную машину: Roles -> Virtual Machines -> New Virtual Machine.

Затем с помощью обычного мастера Hyper-V нужно создать новую виртуальную машину. С помощью Live Migration в дальнейшем можно убедится, что ВМ на легко перемещается между узлами кластера Hyper-V.

В данной статье мы опишем развертывания кластера Hyper-V, на операционной системой ОС Windows 2016.

В примере рассмотрим вариант с двумя серверами, два сервера с ролью Hyper-V и один iSCSI.

Серверам кластера даем имена SRV-1 и SRV-2, хранилищу — iSCSI Storage.

На SRV-1 и SRV-2 устанавливаем роль Hyper-V и Failover Cluster.

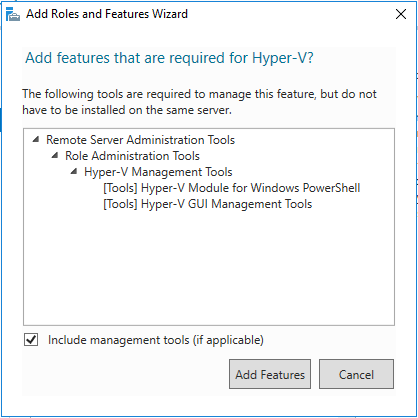

Добавляем роль Hyper-V Добавляем компонент Failover Cluster

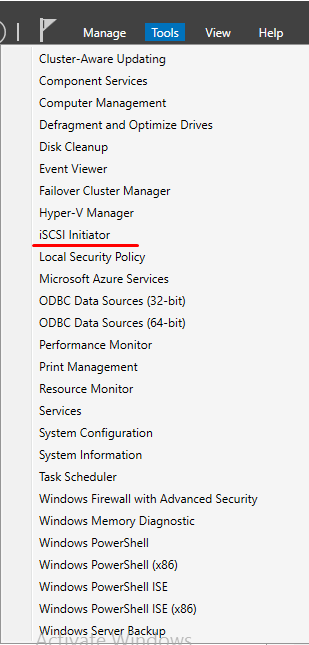

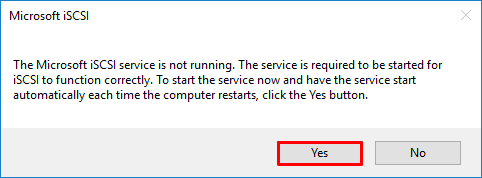

На серверах SRV-1 и SRV-2 запускаем службу iSCSI Initiator.

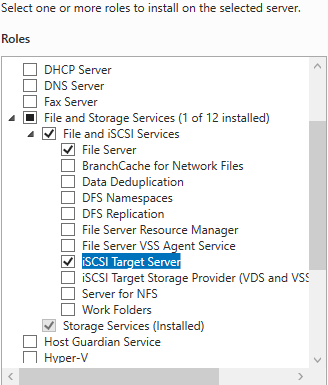

Переходим на сервер iSCSI Storage. Из раздела File and iSCSI Services устанавливаем роль iSCSI Target Server.

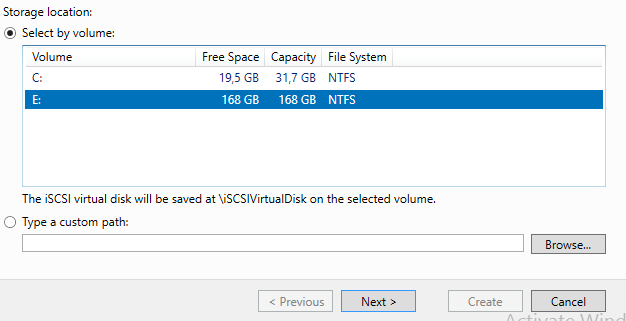

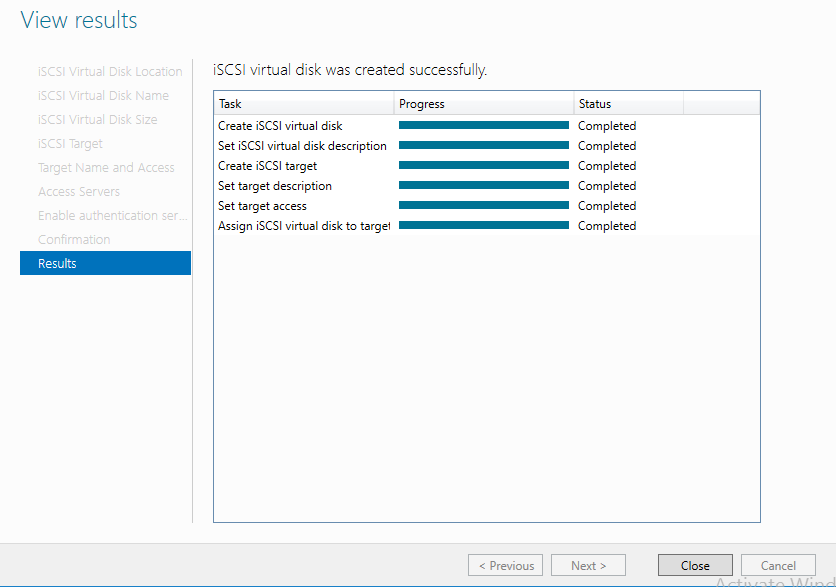

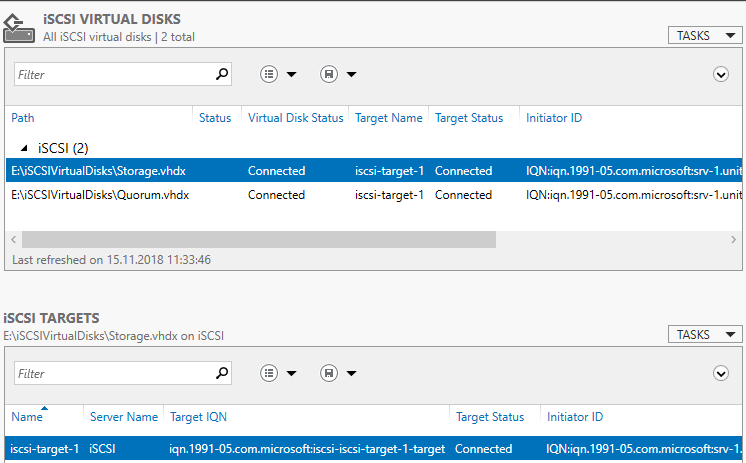

На сервере iSCSI Storage в Server Manager находим iSCSI и создаем 2 виртуальных диска.

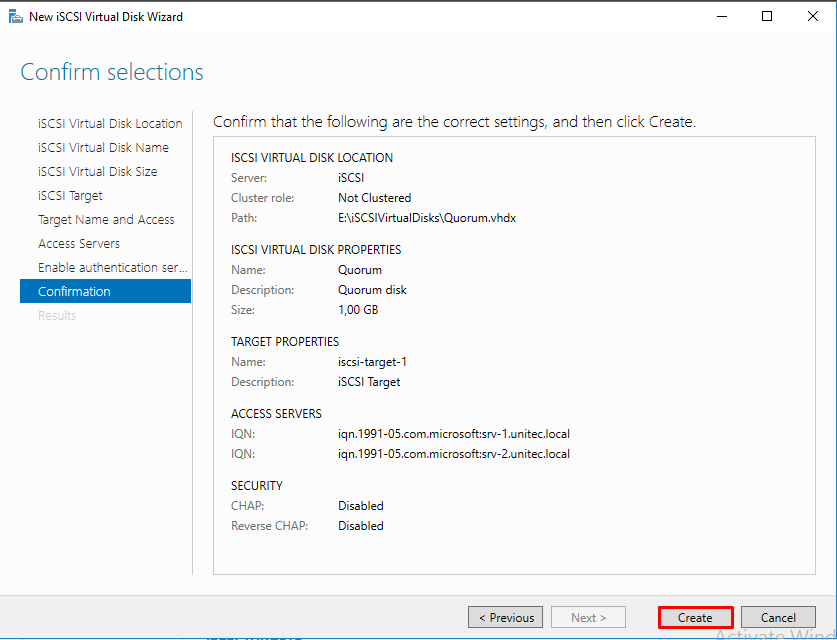

Диск свидетеля кворума и диск для хранения виртуальных машин.

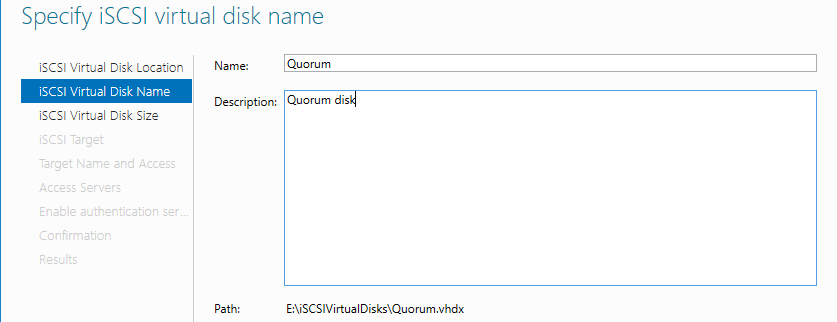

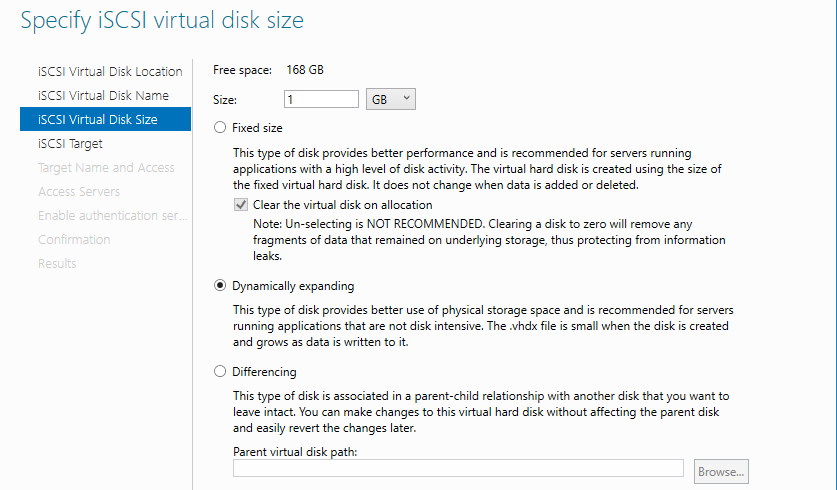

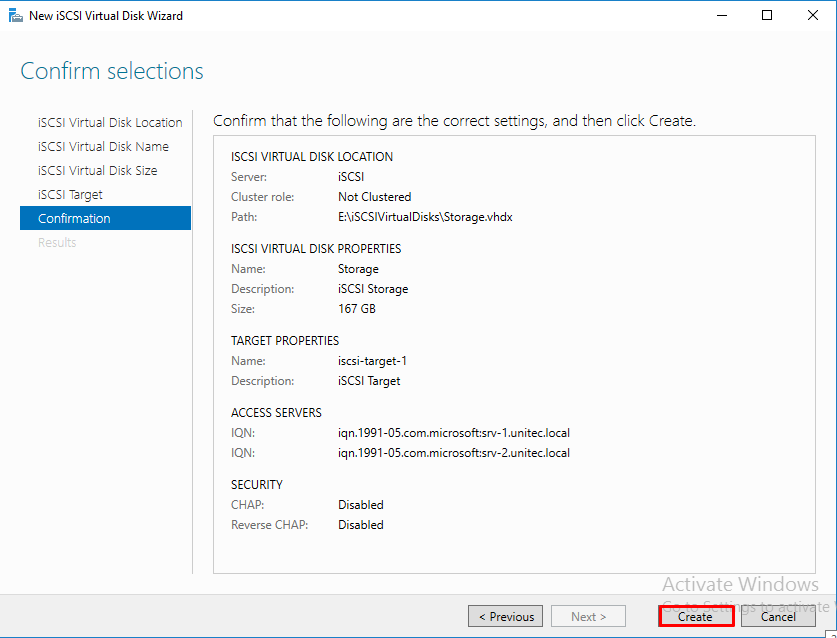

Диск-свидетель — это служебный ресурс кластера, для него достаточно выделить минимальный размер, в нашем случае 1ГБ. Даем ему название Quorum, диску для хранения виртуальных машин даем название — Storage и задаем соответствующий размер.

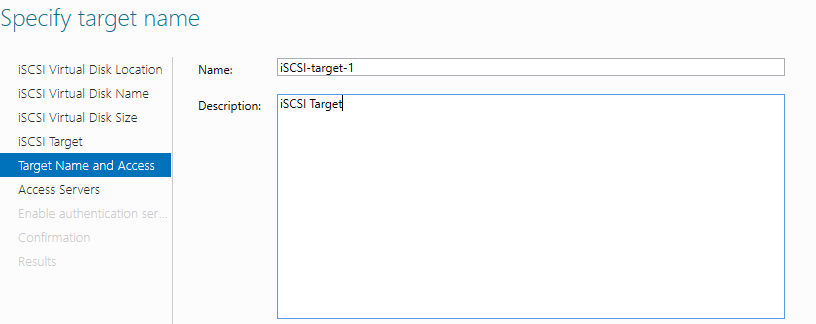

Создаем iSCSI таргет. Задаем имя iSCSI таргета.

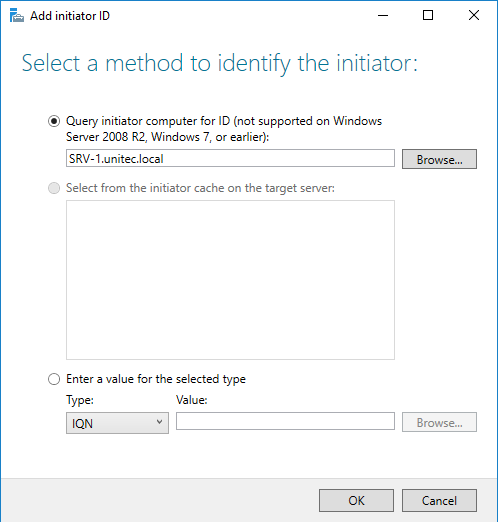

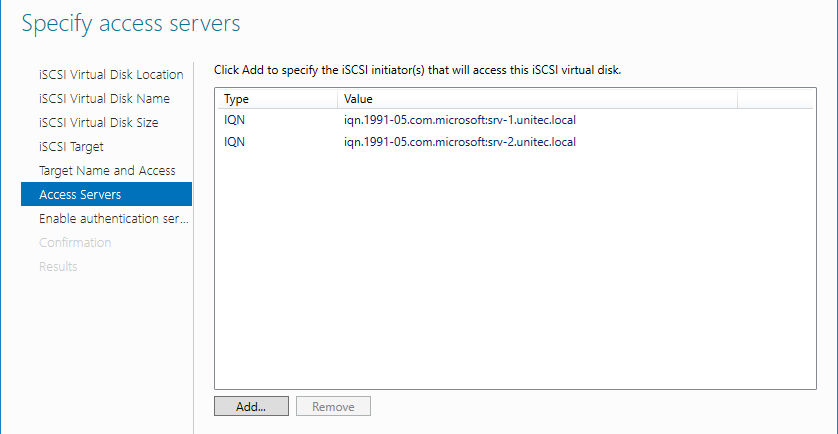

Добавляем сервера, которые могут подключаться к этим дискам (iSCSI инициаторы).

CHAP пропускаем.

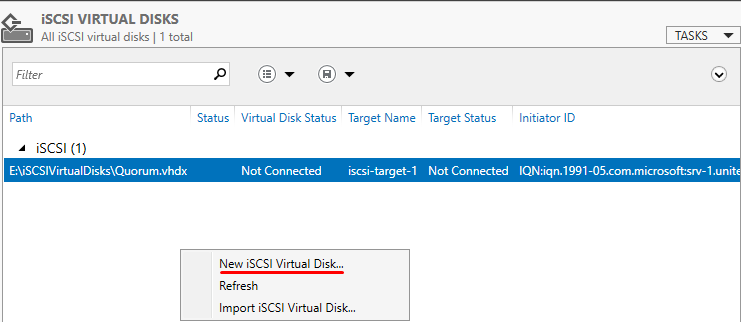

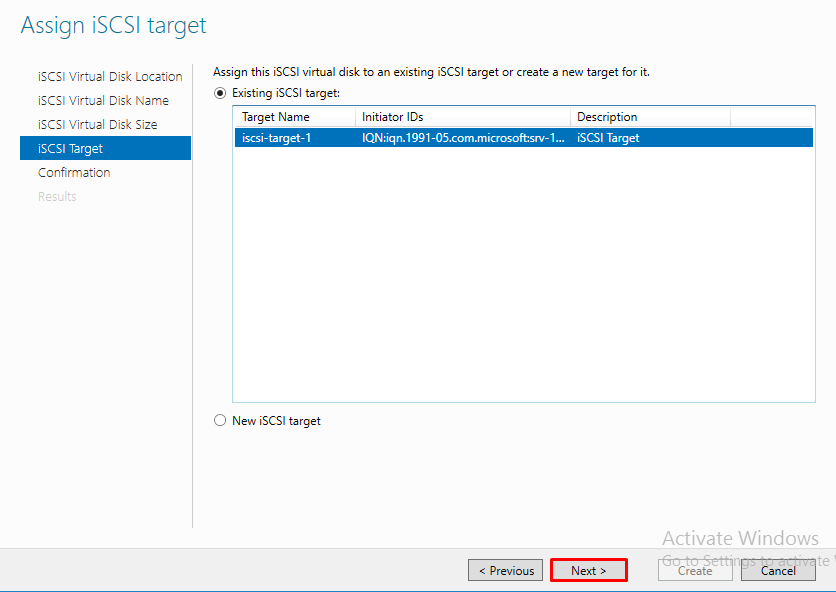

Следующим шагом, создаем второй диск, называем его Storage и подключаем к уже созданному iSCSI таргет.

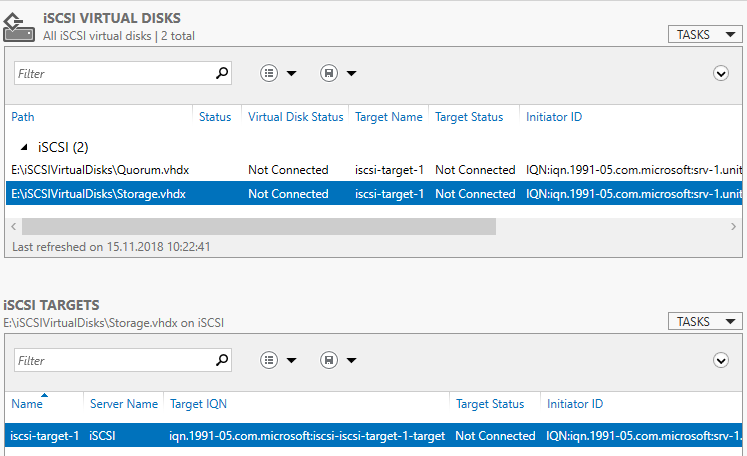

В Server Manager мы видим созданный таргет и инициаторы, но диски пока не подключены.

Возвращаемся на сервера SRV-1 и SRV-2.

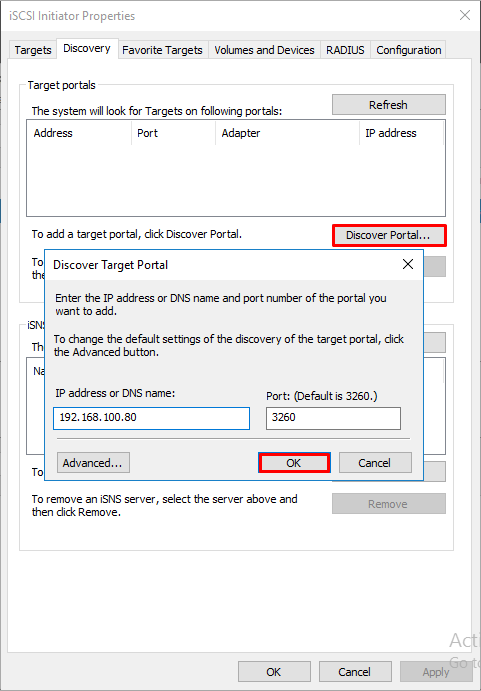

Запускаем оснастку iSCSI Initiator. Добавляем таргет и подключаемся к нему.

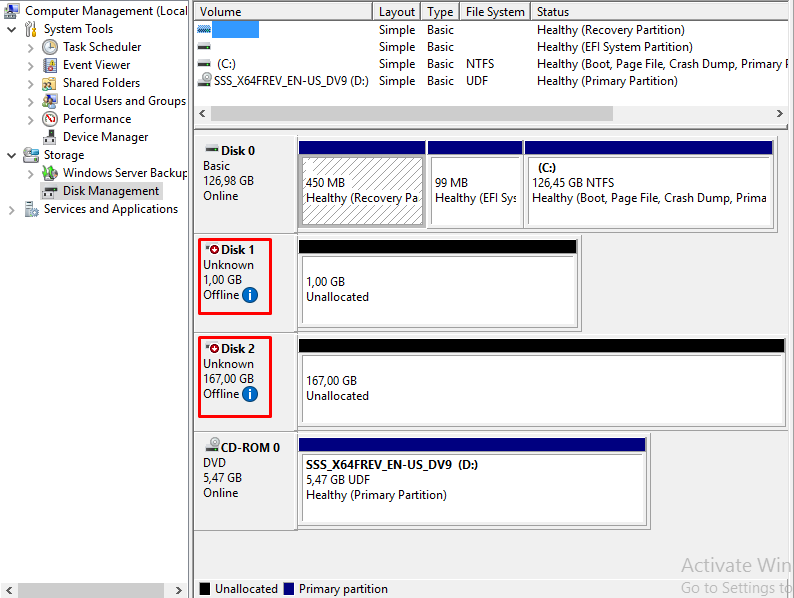

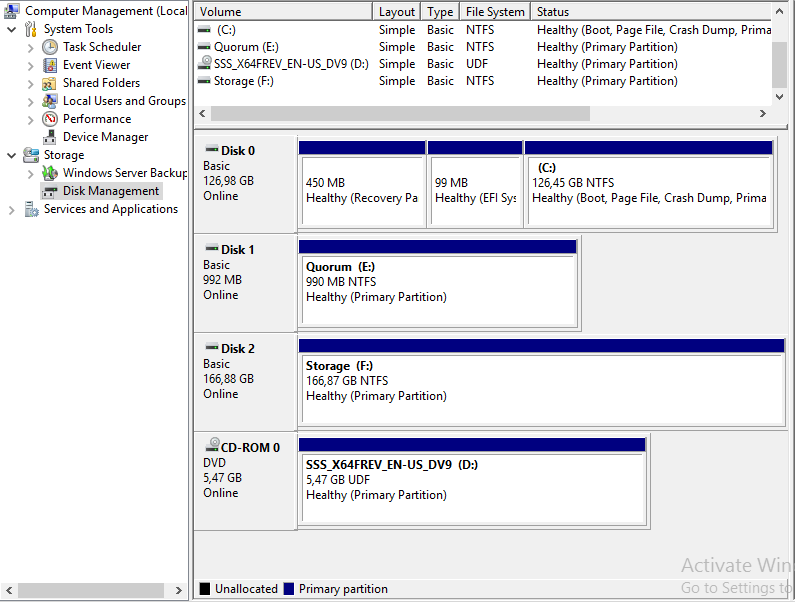

В Disk Management мы видим 2 новых диска. Инициализируем и форматируем новые диски. На втором сервере форматирование не нужно, только инициализация.

Здесь вернемся на сервер iSCSI Storage и убедимся, что все подключено.

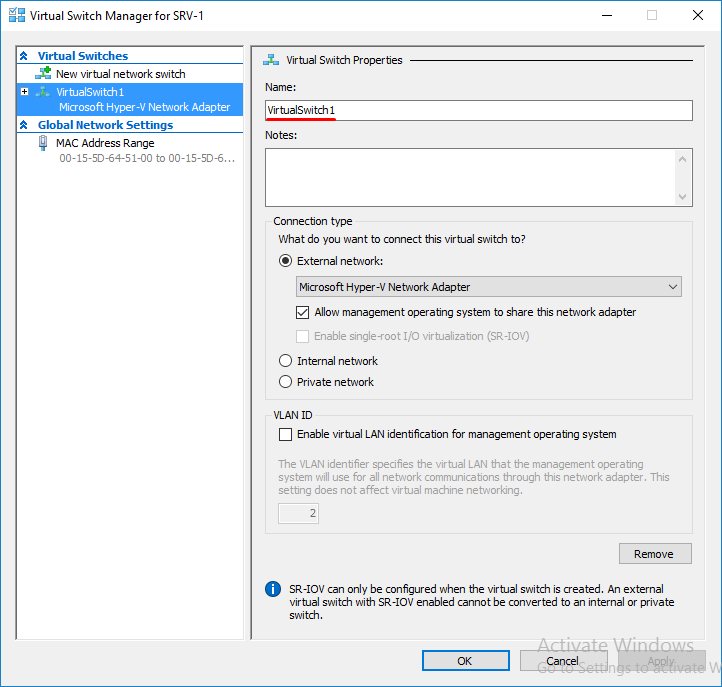

Переходим в диспетчер Hyper-V на серверах SRV-1 и SRV-2 и настраиваем виртуальный коммутатор. Обязательно даем одинаковое название коммутаторам на обоих серверах.

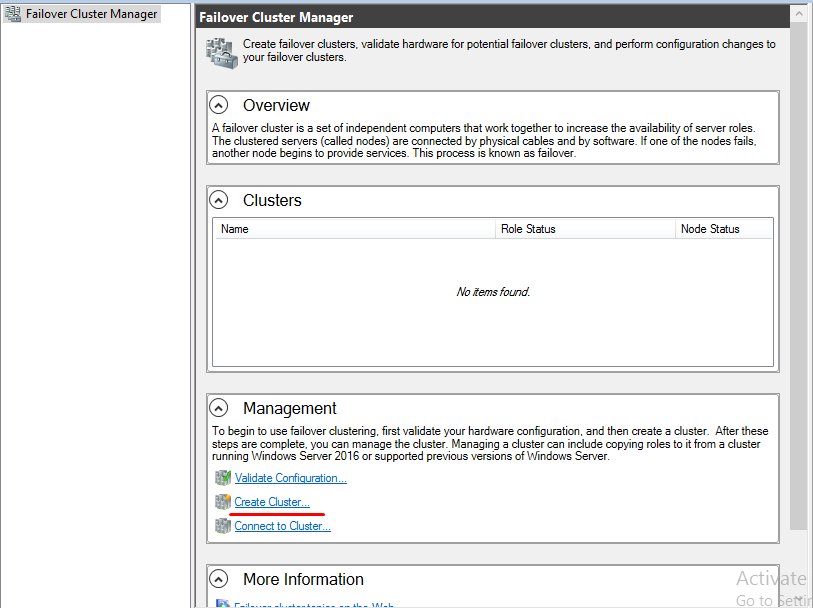

Открываем оснастку Failover Cluster Manager и приступаем к созданию кластера.

Вначале запускаем проверку. Если проверка не выдала ошибок, создаем кластер.

После проверки создаем кластер. При создании кластера для него создается виртуальный объект, которому даем имя и IP-адрес. В AD в том же OU, в котором находятся сервера появится новая машина.

Добавляем диски.

В Failover Cluster Manager переходим в Storage -> Disk -> справа выбираем add Disk и добавляем диски.

Далее указываем Disk Quorum (диск-свидетель)

И добавляем Disk Storage в общие тома кластера.

Для того, чтобы диск мог использоваться сразу несколькими участниками кластера на нем создается CSVFS — реализуемая поверх NTFS кластерная файловая система. Общие хранилища становятся доступны на всех узлах кластера на C:ClusterStorageVolumeN

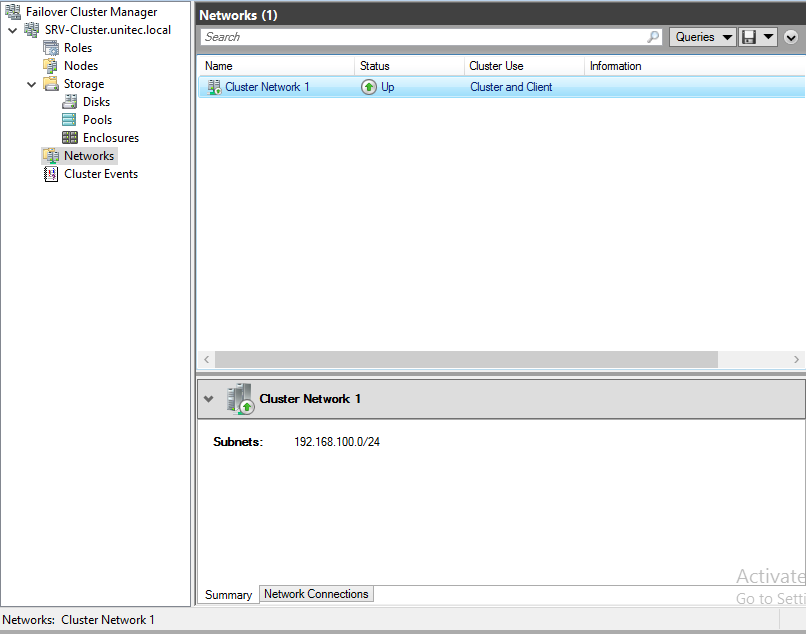

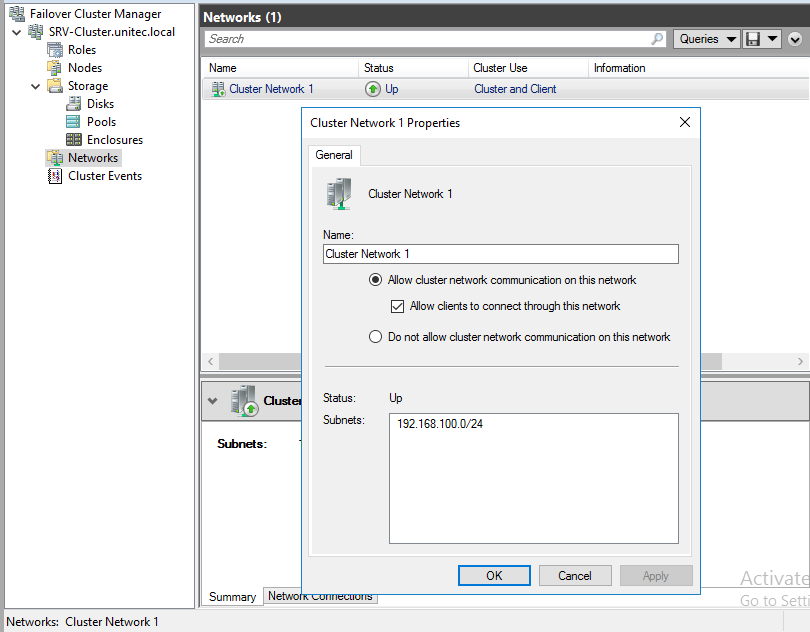

Настраиваем сеть

Перейдем к настройкам сети, для этого перейдем в раздел Networks. Для сети, которая подключена к сети предприятия указываем Разрешить кластеру использовать эту сеть и Разрешить клиентам подключаться через эту сеть. Для сети хранения данных просто оставим Разрешить кластеру использовать эту сеть, таким образом обеспечив необходимую избыточность сетевых соединений.

На этом настройка кластера окончена.

Теперь все виртуальные машины должны создаваться не в диспетчере Hyper-V, а в Failover Cluster Manager. Для создания новой машины заходим в Roles -> Virtual Machines -> New Virtual Machine. Выбираем узел, на котором будет находится машина.

В качестве расположения виртуальной машины обязательно укажите один из общих томов кластера C:ClusterStorageVolumeN.

В параметрах машины Automatic Start Action указываем Automatically Start и задержку старта, что бы избежать перегрузки системы.

В свойствах виртуальной машины (Properties) указываем предпочтительные узлы, в порядке убывания и настраиваем Failover (обработку отказов и восстановление размещения).

На этом настройка виртуальной машины закончена.

Проверяем миграцию виртуальной машины

Move -> Live Migration -> выбираем ноду.

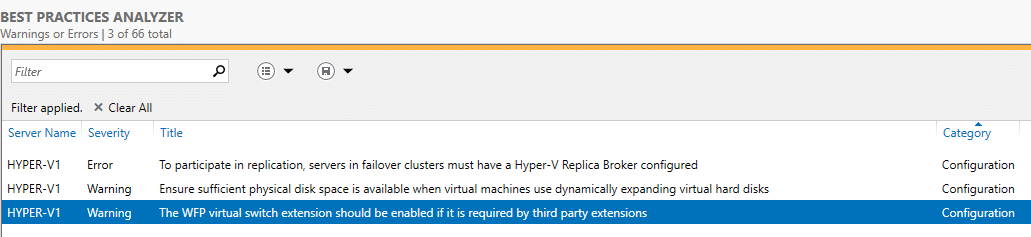

Проанализируем созданный кластер с

BPA (Best Practices Analyzer, Анализатором наилучших решений).

Переходим в Server Manager -> Hyper-V -> справа Tasks -> Start BPA Scan.

Вот что показал мне тест.

По первому пункту — у меня нет необходимости в создании реплики.

По второму пункту — считаю, что машины с динамическими дисками экономят место на диске и состояние диска с виртуальными машинами всегда можно посмотреть и предусмотреть расширение.

По третьему пункту — Расширение виртуального коммутатора WFP должно быть включено, если оно требуется сторонними расширениями.

Еще немного технических видео на канале… Нет, это видео не про Petya – про защиту от Petya смотрите здесь и читайте статьи здесь на блоге, и не про мониторинг производительность дисков (но обещанное продолжение про производительность тоже следует). Подписывайтесь на мой Youtube канал iWalker2000 – для подписки просто кликните сюда

Хотя это видео про развертывание кластера Windows Server 2016 и получилось слегка длинным – но, на мой взгляд – удачным – тут и использование тиминга (NIC Teaming) сетевых интерфейсов для ускорения дисковых операций, и подключение к сетевым дискам iSCSI для общего хранилища кластера, и проблемы с правильным определением кластеров “нужных” сетевых интерфейсов с дальнейшим исправлением, и, конечно же – создание собственно отказоустойчивых ролей в кластере – таких, как высокопроизводительный отказоустойчивый файловый сервер Scale-out File Server и роль виртуальной машины Hyper-V, и вложенная/наследуемая виртуализация (nested virtualization) в Hyper-V, используемая для лабы.

Надеюсь, это видео про основные шаги при развертывании отказоустойчивого кластера Windows Server 2016 Failover Cluster будет полезным для тех, кому “вот прямо срочно” требуется развернуть кластер на Windows Server 2016 и запустить в нем те или иные роли.

СофТы: как развернуть и настроить кластер Windows Server 2016 Failover Clustering, ч.01

Но я пообещал более подробно (кроме собственно, развертывания кластера) раскрыть эту тему – поэтому в следующем “длинном” видео смотрите более подробно про настройки параметров ролей в кластере, а также – о создании гостевого кластера (кластера внутри кластера) для еще более бесперебойной работы и высокой доступности приложений.

И немного о вирусе Petya и украинской “эпидемии”

Продолжение темы про отказоустойчивые кластеры Windows Server 2016 – на этот раз про настройки собственно отказоустойчивости и высокой доступности. А предыдущее видео – про установку и начальную настройку самого кластера Windows Server 2016 Failover Clustering – смотрите тут.

В этом видео про настройку ролей в отказоустойчивом кластере Windows Server 2016 Failover Clustering вы найдете:

-

как работает отказоустойчивость и высокая доступность в кластере Windows для “обычного” приложение – настройка количества сбоев, перезапуск/”переползание” приложения между узлами кластера, остановка приложения.

-

работа приложений, поддерживающих распределенный режим работы и позволяющий им работать на всех (нескольких) узлах кластера одновременно – на примере Scale-Out File Server.

-

Работа отказоустойчивой виртуальной машины Hyper-V в кластере.

-

Настройка параметров восстановления роли кластера в случае сбоя одного из узлов кластера – возврат роли на оригинальны узел после восстановления работоспособности роли, настройка общих приоритетов работы роли и преференций по работе роли на разных узлах кластера Windows Server 2016.

-

Настройка мониторинга отдельного сервиса внутри роли виртуальной машины кластера Hyper-V для мониторинга состояния отдельных процессов ВМ и ее общего здоровья, запущенной в кластере.

-

И, конечно же, демонстрация “падения” одно из узлов кластера Windows Server 2016 и реакция на это событие разных типов ролей – подолжение процесса копирования файлов на Scale-out File Server, старт общей роли на втором узле кластера, и перезапуск виртуальной машины, которая “обрушилась” при падении узла кластера.

Смотрим, учимся, разбираемся и планируем отказоустойчивую работу и высокую доступность необходимых приложений под управлением Windows Server 2016 Failover Clustering.

СофТы: настройка отказоустойчивых ролей в кластере Windows Server 2016 Failover Clustering, ч.02

В продолжение темы про отказоустойчивые кластеры Windows Server 2016 – в следующем видео смотрите про создание гостевого кластера из виртуальных машин Hyper-V внутри основного (физического) кластера Windows Server 2016. Зачем? чтобы гарантировать еще более высокую доступность и надежность приложения, запущенного на виртуальной машине в кластере (которое будет тоже в кластере). Так что улучшается доступность чуть ли не на порядок 😉

Видео об ИТ-карьере – как стать ИТ-специалистом и заработать много денег:

Заключительное видео в серии по теме отказоустойчивого кластера Windows Server 2016 – создание гостевого кластера из виртуальных машин внутри основного кластера – такая себе фукурума 😉

Особенностью данного видео и основным отличием от первого видео – просто развертывания кластера Windows Server 2016 – в том, что гостевой кластер создается не просто так, а в режиме “Active Directory-Detached Cluster” – отключенного от Active Directory кластера Windows.

СофТы: установка гостевого Hyper-V кластера Windows Server 2016 без Active Directory, ч.03

Подробную инструкцию по развертыванию гостевого кластера Windows Server 2016 без Active Directory вы найдете в этом видео, а основные шаги по развертыванию такого отключенного от AD кластера Windows приводятся ниже:

-

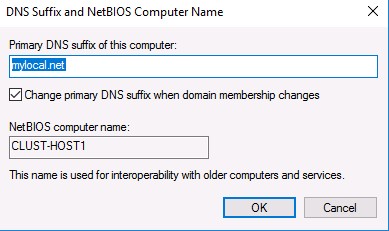

все узлы кластера должны быть зарегистрированы в каком-то из доменов (зон) DNS – для этого необходимо, чтобы DNS сервер поддерживал динамические обновления, суффиксы требуемого домена были прописаны в настройках серверов, а в настройках сетевых интерфейсов – стояли опции обязательной регистрации имени. Или вам потребуется создавать все записи в DNS зоне для узлов кластера, самого кластера и его ролей ручками.

-

настройки firewall должны разрешать обращаться всем узлам друг к другу.

-

на каждом из узлов будущего кластера должна существовать учетная запись-локальный администратор с общими одинаковым именем и паролем. Также, должен быть отключен сетевой фильтеринг в UAC – тот самый ключ в реестре – New-ItemProperty -Path HKLM:SOFTWAREMicrosoftWindowsCurrentVersionPoliciesSystem -Name LocalAccountTokenFilterPolicy -Value 1

ВНИМАНИЕ! Помните, что такой кластер представляет собой потенциальную жертву для атак типа pth/ptt – которые использует тот же Petya и другие вирусы (и просто хакеры). Поэтому смотрите видео про защиту от подобных атак Pass-the-Hash/Pass-the-ticket и, конечно же, читайте статью, посвященную стратегии защиты ИТ-инфраструктуры Defense-in-Depth на примере защиты от Petya.

А поскольку мы развертываем гостевой кластер из виртуальных машин и ему требуется также общие диски для своей работы – смотрите в данном видео сценарии, каким образом вы можете создать и где разместить такие диски в виде специальны общих виртуальных дисков Hyper-V (Shared Disk – VHDX или VHD Set). И, пожалуйста, не монтируйте диски гостевого кластера на те же LUN SAN/iSCSI, которые уже используются “большим” основным кластером – это приведет к катастрофическим последствиям для обеих систем.

Думаю, что все 3 инструкции по кластерам Windows Server 2016 помогут вам освоиться с базовыми аспектами работы с отказоустойчивыми кластерами Windows Server 2016 и их вариациями – гостевым кластером из виртуальных машин Hyper-V и кластером Windows без использования Активного Каталога.

Поэтому данную тему будем пока считать закрытой… Хотя есть масса нюансов в обслуживании повседневном кластеров и, конечно же, есть команды PowerShell, которые позволят намного быстрее и гибче развертывать и управлять кластерами Windows… Но это тема уже другой серии видео про кластеры Windows Server 2016.

А в продолжении технических видео на канале – все та же производительность дисков – измерение скорости работы и ускорение дисковой системы.

Подписывайтесь на мой Youtube канал iWalker2000 – для подписки просто кликните сюда

Немного ссылок на другие материалы для тех, кто хочет стать просто ИТ-специалистом – смотрите первые шаги по созданию тестового рабочего места:

И смотрите другие видео для ИТ-специалистов у меня на канале:

Видео про новые возможности дисков и дисковых массивов:

Также, по просьбам посетителей – меня найти можно (добавляйтесь в друзья и подписчики):

В версиях Windows Server, предшествующих Windows Server 2016, создать отказоустойчивый кластер из нескольких серверов можно было только между серверами одного домена Active Directory. В новой версии теперь можно создавать двух (и более) узловой failover кластер между серверами в разных доменах, и даже между серверами рабочей группы (вообще без домена Active Directory).

Естественно, что на всех узлах кластера нужно устаровить Windows Server 2016. Поддерживаются следующие сценарии кластеризации:

| Служба | Статус | Комментарий |

| SQL server | Поддерживается | Рекомендуется использовать встроенную аутентификацию SQL Server |

| Файловый сервер | Поддерживается, но не рекомендуется | Не поддерживается Kerberos-аутентфикация для SMB |

| Hyper-V | Поддерживается, но не рекомендуется | Не поддерживается режим Live Migration, доступна только Quick migration |

| Message Queuing (MSMQ) | Не поддерживается | MSMQ хранит свои свойства в Active Directory. |

На всех будущих узлах кластера нужно

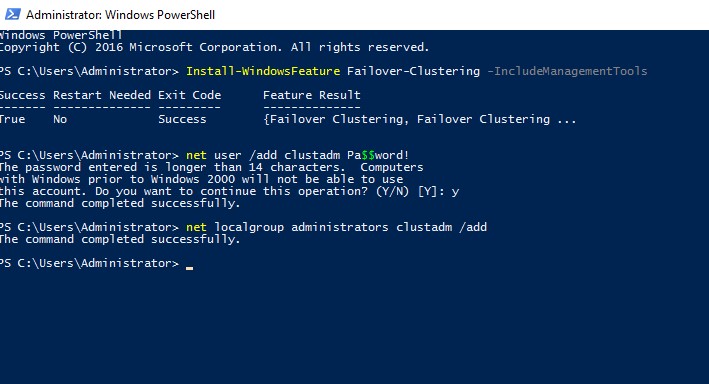

- Установить роль Failover Clustering:

Install-WindowsFeature Failover-Clustering –IncludeManagementTools - На каждой кластерной ноде нужно создать локальную учетную запись с правами администратора (или использовать встроенную учетку администратора) с одинаковыми паролями.

net user /add clustadm Pa$$word!

net localgroup administrators clustadm /add

- При появлении ошибки Requested Registry access is not allowed, необходимо изменить в реестре параметр удаленного UAC — Данный ключ разрешает удаленный доступ к административным шарам.

New-ItemProperty -Path HKLM:SOFTWAREMicrosoftWindowsCurrentVersionPoliciesSystem -Name LocalAccountTokenFilterPolicy -Value 1 - На всех узлах кластера нужно задать одинаковой первичный DNS суффикс (Primary DNS suffix). Это нужно для того, чтобы сервера кластера могли обращаться друг к другу по FQDN именам

- Также нужно снять галку Register DNS connection addresses

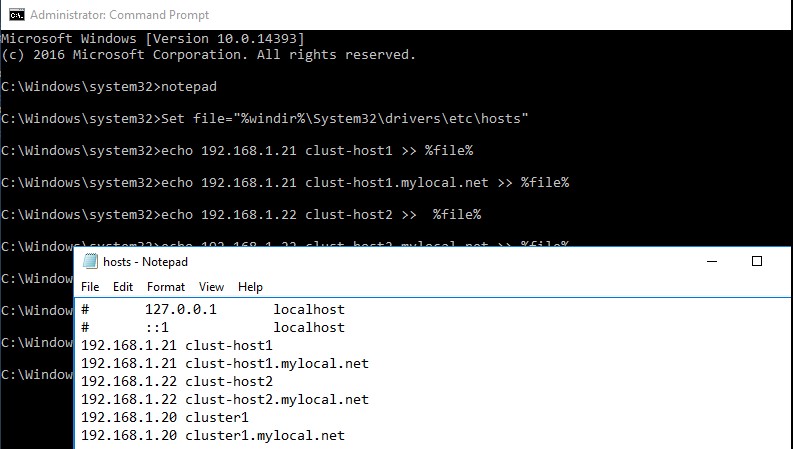

- В файл hosts на всех узлах кластера нужно внести изменения, чтобы сервера могли отрезолвить имена других членов кластера, а также имя кластера (в том числе FQDN имена). Добавить имена в файл c:windowssystem32driversetchosts можно так:

Set file="%windir%System32driversetchosts"

echo 192.168.1.21 clust-host1 >> %file%

echo 192.168.1.21 clust-host1.mylocal.net >> %file%

echo 192.168.1.22 clust-host2 >> %file%

echo 192.168.1.22 clust-host2.mylocal.net >> %file%

echo 192.168.1.20 cluster1 >> %file%

echo 192.168.1.20 cluster1.mylocal.net>> %file%

Для предварительной валидации узлов кластера можно воспользоваться командой:

test-cluster -node "clust-host1.mylocal.net"," clust-host2.mylocal.net"

Для создания кластера через PowerShell, нужно выполнить такую команду:

New-Cluster -Name cluster1 -Node clust-host1.mylocal.net, clust-host2.mylocal.net -AdministrativeAccessPoint DNS -StaticAddress 192.168.1.20

Теперь можно проверить статус кластера и его компонентов командлетами get-cluster и get-clusterresource.

Для подключения (и удаленного управления) кластером через GUI нужно воспользоваться оснасткой Failover Cluster Manager (входит в состав) RSAT для Windows 10.

Теперь с помощью пункта меню Connect to cluster можно подключаться к созданному кластеру. В том случае, если в кластере четное количество серверов, придется настроить ресурс-свидетель. Отметим, что в качестве кворумного свидетеля нельзя использовать сетевую папку SMB. Поддерживается режим Disk Witness — общий диск (с одновременным доступом к нему с обоих узлов), либо Cloud Witness — облачный дисковый ресурс в Azure.

Прочитано:

7 495

Итак, в наличии есть три физических сервера которые должны быть объединены в единый кластер для минимизации простоя сервисов.

Предварительные действия

Шаг №1: На все физические сервера в рамках этой заметке установлена операционная система Windows Server 2016 Standard (RUS) Version 10.0.14393 и все обновления на текущую дату (29.04.2018).

Шаг №2: Операционная система введена в текущий домен (в моем случае это polygon.local)

Шаг №3: Подключаюсь по RDP к первому серверу (srv-noda1) с правами учетной записи (Login: ekzorchik) в ходящей в группу «Администраторы домена» и устанавливаю роль Hyper-V и компонент, через который формируется кластера на Windows системе:

Win + R – control.exe – Администрирование – «Диспетчер серверов» — «Управление» — «Добавить роли и компоненты» и отмечаю галочкой, а на уведомление мастера установки, что к выбранному необходимы дополнительные компоненты соглашаюсь нажатием кнопку «Добавить компоненты»

- Роль: Hyper-V

- Компоненты: Отказоустойчивая кластеризация

- Не забываем выбрать виртуальный коммутатор на каждой ноде, в моем случае у меня Nic Teaming из двух карт, а потому отмечаю галочкой сетевой интерфейс с именем Team1G в роли виртуального коммутатора для Hyper-V.

Этап Hyper-V -> Миграция никак не отмечаю, данные настройки я выполню позже

Указываю размещение виртуальных жестких дисков и конфигураций виртуальной машины на еще одном общем диске, который через хранилище Dell EMC SCv3020 назначен физическим нодам:

На заметку: Важно чтобы общий диск к серверам имел одну и туже логическую букву.

- Расположение по умолчанию для файлов виртуальных жестких дисков: E:disk

- Расположение по умолчанию для файлов конфигурации виртуальной машины: E:conf

На заметку: Но при создании VM нужно указывать путь: C:ClusterStorageVolume1conf, где Volume1 есть LUN логического диска E.

И нажимаю кнопку «Далее», «Установить», галочку об автоматическом перезапуске конечного сервера не ставлю, я считаю, что лучше убедиться, что это действительно нужно, об этом должен сообщить мастер установки устанавливаемого. И вот когда установка завершена я вижу надпись: «Ожидается перезапуск на srv-noda1.polygon.local. Для завершения установки необходимо перезапустить сервер», перезапускаю:

Win + X – Командная строка (Администратор) -> shutdown /r /t 3

Но теперь я знаю, что галочку об автоматическом перезапуске можно ставить и она необходима.

Шаг №4: Проделываю действия Шага №3 и на других серверах которые будут входить в собираемый кластер. Можно либо подключиться к ним по RDP и повторить шаги или же дождаться, когда сервер с именем srv-noda1.polygon.local перезагрузиться и подключиться к нему по RDP и запустить установку роли и компоненты, но уже задействую настройку «Выбор сервера» выбрать сервер, входящий в группу, а у меня это следующая нода.

Для перезапуска/перезагрузки следует воспользоваться созданной группой сервер в которую входит данный сервер:

Win + R – control.exe – Администрирование – «Диспетчер серверов» — перехожу в группу серверов srv-noda и через правый клик мышью по сервер srv-noda2 выбираю меню «Перезапустить сервер» и подтверждаю свое намерение нажатием кнопки «ОК». Пока сервер в перезагрузку проделываю все шаги с третьим сервером.

Шаг №5:

Теперь, когда необходимые роли и компоненты установлены соберем кластер.

Mstsc – srv-noda1.polygon.local – Win + R – control – Администрирование – «Диспетчер отказоустойчивости кластеров» — потом через правый клик мышью по «Диспетчер отказоустойчивости кластеров» выбираю действие «Проверить конфигурацию» на предмет создания кластера.

Выбор серверов или кластера:

- Введите имя: — Обзор – нахожу всех srv-noda[1-3], выделяю их и указываю имя объединяющее их это: srv-cluster, получается следующее:

- Выбранные серверы:

srv-noda1.polygon.local,srv-noda2.polygon.local,srv-noda3.polygon.local

И нажимаю «Далее», оставляю дефолтным выбор мастера «Выполнить все тесты» и нажимаю «Далее», «Далее»

На заметку: к серверам уже должен быть подключен общий диск, который будет кворумным для обмена информацией между нодами кластера

По окончании проверки на создании кластера нужно в обязательном порядке нажать на «Просмотреть отчет…»

На заметку: я отключаю поддержку ipv6 и устанавливаю все обновления на момент написания данной заметки, плюс настройка что уведомлять об обновлениях, а скачивание и установку их я принимаю вручную или же отключаю их:

Управляем обновлениями на Windows Server 2016

Win + X – Командная строка (Администратор)

C:Windowssystem32>sconfig

Введите номер параметра: 5 (Параметры центра обновления Windows)

Выберите режим обновления: указываю M (Ручной)

Введите номер параметра: 15

На заметку: Если на серверах используется Nic Teaming, то интерфейсы на всех серверах должны называться одинаково (Team10G,Team1G)

На заметку: Обязательно следует устранить все проблемы, которые обозначены в отчете при проверке нод из которых вы хотите создать Windows кластер.

После через Мастер «Создать кластер» создаю, отвечая и заполняя настройки мастера:

- Имя кластера: srv-cluster

- Сети: 10.99.99.0/27

- Адрес: указываю свободный IP адрес и подсети, к примеру 10.99.99.99

На заметку: имя кластера не должно быть длиннее 15 символов

И нажимаю «Далее», галочка у «Добавление всех допустимых хранилищ в кластер» должна стоять и нажимаю снова «Далее», «Готово»

Итак, кластер развернут, управление им идет через оснастку «Диспетчер отказоустойчивости кластеров», а именно добавление ролей, управление дисками (а не через «Управление дисками», если перейти в этой оснастке Вас может смутить что диск, который от хранилища не под монтирован, но это нормально, т.к. управление идет через диспетчера кластеров).

Самой важной настройкой обычно ни где не упомянутой остается, что нужно запустить оснастку управления кластером:

Win + R – control.exe – Администрирование – «Диспетчер отказоустойчивости кластеров» — перейти в «Хранилище» — «Диски» и увидеть все диски кластера (либо это LUN, либо это логические тома), выделяю в моем случаем «Диск кластера 2»

| Имя | Состояние | Назначено | Узел владельца |

| Диск кластера 2 | Оперативный | Доступное хранилище | Srv-noda1 |

И через правый клик мышью по нему выбираю «Добавить в общие тома кластера», этой настройкой логический диск размеченного LUN с отформатированной файловой системой NTFS переназначится в том видимый лишь кластеру с файловой системой CSVFS. Когда это проделано то в колонке «Назначено» будет значится уже «Общий том кластера».

Данная настройка предоставляет возможность мигрировать хосты между нодами. Ну как-то так.

Свою задачу по разворачиваю кластера я выполнил и прощаюсь, с уважением автор блога Олло Александр aka ekzorchik.

Начнём с определения, взятого с Microsoft Docs:

Отказоустойчивый кластер — это группа независимых компьютеров, которые работают совместно в целях повышения доступности и масштабируемости кластерных ролей (ранее называемых кластерными приложениями и службами). Кластерные серверы (называемые «узлы») соединены физическими кабелями и программным обеспечением. При сбое на одном из узлов кластера его функции немедленно передаются другим узлам (этот процесс называется отработкой отказа). Кроме того, за кластерными ролями ведется профилактическое наблюдение, чтобы обеспечить их правильную работу. Если они не работают, выполняется перезагрузка или перемещение на другой узел.

Отказоустойчивые кластеры также предоставляют функции общего тома кластера (CSV — Cluster Shared Volume), которые образуют согласованное распределенное пространство имен, используемое кластерными ролями для доступа к общему хранилищу со всех узлов. Благодаря функции отказоустойчивой кластеризации пользователи сталкиваются с минимальным количеством проблем в работе службы.

Простыми словами CSV — это общее дисковое пространство для всех узлов кластера. Используется для хранения файлов ролей кластера (файлы виртуальных машин, сайты IIS, БД SQL, отказоустойчивые сетевые папки и т.д.)

Требования к оборудованию

Оборудование должно быть сертифицированно для работы с той ОС, на основе которой мы строим отказоустойчивый кластер — это рекомендация Microsoft. Несоблюдение данной рекомендации влечёт за собой отказ в технической поддержке.

Серверы: рекомендуется использовать одинаковые серверы в качестве узлов кластера или похожие по составу (процессоры одного семейства, близкое количество оперативной памяти и подобное). Да, есть возможность живой миграции ролей между системами с разными процессорами, но так делать не рекомендуется.

Сетевые адаптеры и подключение: тут рекомендуется избегать точек отказа, т.е. нужно использовать отдельные сети, либо можно подключать узлы кластера к одной сети, построенной на объединённых сетевых интерфейсах (teamed network adapters), «избыточных» коммутаторах и т.д.

При подключении кластера к одной сети такая сеть будет соответствовать требованиям избыточности в мастере проверки конфигурации. Но отчёт мастера будет содержать предупреждение, что в сети не должно быть точек отказа.

Контроллеры или адаптеры для хранилища

Serial Attached SCSI или Fibre Channel: если используется Seral Attached SCSI или Fibre Channel — все элементы системы хранилища на всех узлах кластера должны быть идентичны. Необходимо чтобы ПО Multipath I/O и Device Specific Module (DSM) были одинаковыми на всех узлах. Контроллеры устройств хранения данных, такие как host bus adapter (HBA), драйверы HBA и их прошивки должны быть одинаковыми. При использовании разных HBA необходимо уточнить у производителя хранилища что используются поддерживаемые конфигурации и версии прошивки.

iSCSI: при использовании данной технологии на каждом узле кластера должен быть выделенный контроллер или сетевой адаптер для соединения с дисковым хранилищем. Не рекомендуется смешивать iSCSI и сеть доступа. На всех узлах кластера сетевые адаптеры, используемые для подключения к целевому iSCSI, должны быть идентичны и иметь одинаковую версию прошивки (рекомендация Microsoft). Так же рекомендуется использовать 10GB Ethernet (можно построить и на гигабите, но в этом не много смысла).

Хранилище

Можно использовать сетевое хранилище, совместимое с Windows Server 2016. Так же можно использовать общие сетевые хранилища SMB3.0 в качестве общего хранилища Hyper-V, настроенных в качестве ролей отказоустойчивого кластера.

Часто общее хранилище состоит из нескольких отдельных дисков — LUN’ов (Logical Unit Numbers), сконфигурированных на аппаратном уровне (RAID…)

Для некоторых кластеров один из дисков используется как диск-свидетель (witness disk). На остальных дисках хранятся файлы, необходимые кластерным ролям.

Требования к дискам:

— Чтобы использовать встроенную поддержку дисков, включенную в отказоустойчивый кластер, используйте базовые, а не динамические диски.

— Рекомендуется форматировать разделы в NTFS. При использовании общих томов кластера CSV — разделы должны быть отформатированы в NTFS.

При наличии диска-свидетеля для конфигурации кворума такой диск можно отформатировать в NTFS или ReFS.

— Раздел может быть MBR или GPT.

Диск-свидетель (witness disk) — это диск, на котором хранится копия базы данных конфигурации кластера. Отказоустойчивый кластер использует диск-свидетель только если он настроен как часть кворума кластера.

Требования для Hyper-V

Если кластер будет содержать виртуальные машины Hyper-V, то все узлы кластера должны соответствовать требованиям для установки роли Hyper-V role, которой необходим 64-битный процессор, а так же следующие технологии:

— Аппаратная виртуализация. Процессоры с технологией Intel Virtualization Technology (Intel VT) или AMD Virtualization (AMD-V)

— Должно быть доступно и включено аппаратное предотвращение данных Intel XD bit (execute disable bit) или AMD NX bit (no execute bit).

Подробнее тут.

Использование сетей хранения данных (SAN) с отказоустойчивыми кластерами.

Рекомендуется придерживаться данных рекомендация при развёртывании SAN с кластерами:

— Совместимость хранилища с отказоустойчивой кластеризацией. Необходимо уточнить у производителя что хранилище, включая драйверы, прошивки и т.д. совместимо с кластеризацией в Windows Server 2016.

— Изолированные устройства хранения. По одному кластеру на устройство. Серверы из разных кластеров не должны иметь доступа к одному устройству хранения.

— Использование multipath I/O или объединение сетевых адаптеров (teaming). Отказоустойчивый кластер рекомендуется разворачивать с несколькими хост-адаптерами с использованием «ПО многопутевого ввода-вывода» (multipath I/O), либо объединив несколько сетевых адаптеров (также называется балансировкой нагрузки и отработкой отказа — LBFO). Начиная с Windows Server 2008 многопутевое решение должно быть основано на Microsoft Multi-Path Input-Output (MPIO).

Поставщик оборудования обычно предоставляет для оборудования модуль DSM (MPIO device-specific module, DSM), хотя в состав операционной системы Windows Server входит один или несколько модулей DSM.

Важно: HBA и MPIO крайне чувствительны к своей версионности.

| title | description | ms.topic | ms.assetid | author | ms.author | manager | ms.date |

|---|---|---|---|---|---|---|---|

|

Cluster Operating System Rolling Upgrade |

Learn more about: Cluster operating system rolling upgrade |

how-to |

6e102c1f-df26-4eaa-bc7a-d0d55d3b82d5 |

jasongerend |

jgerend |

lizross |

01/07/2022 |

Cluster operating system rolling upgrade

Applies to: Windows Server 2022, Windows Server 2019, Windows Server 2016

Cluster OS Rolling Upgrade enables an administrator to upgrade the operating system of cluster nodes Hyper-V or Scale-Out File Server workloads without stopping them. Using this feature, the downtime penalties against Service Level Agreements (SLA) can be avoided.

Cluster OS Rolling Upgrade provides the following benefits:

-

Failover clusters running Hyper-V virtual machine and Scale-out File Server (SOFS) workloads can be upgraded from a version of Windows Server, starting with Windows Server 2012 R2, to a newer version of Windows Server. For example you can upgrade Windows Server 2016 (running on all cluster nodes of the cluster) to Windows Server 2019 (running on all nodes in the cluster) without downtime.

-

It doesn’t require any additional hardware. In small clusters, you can add additional cluster nodes temporarily to improve availability of the cluster during the Cluster OS Rolling Upgrade process.

-

The cluster doesn’t need to be stopped or restarted.

-

A new cluster is not required. The existing cluster is upgraded. In addition, existing cluster objects stored in Active Directory are used.

-

The upgrade process is reversible until the final step, when all cluster nodes are running the newer version of Windows Server and the

Update-ClusterFunctionalLevelPowerShell cmdlet is run. -

The cluster can support patching and maintenance operations while running in the mixed-OS mode.

-

It supports automation via PowerShell and WMI.

-

The cluster public property ClusterFunctionalLevel property indicates the state of the cluster on Windows Server 2016 and later cluster nodes. This property can be queried using the PowerShell cmdlet from a cluster node that belongs to a failover cluster:

Get-Cluster | Select ClusterFunctionalLevel

The table below shows the values and each corresponding functional level:

Value Functional level 8 Windows Server 2012 R2 9 Windows Server 2016 10 Windows Server 2019

This guide describes the various stages of the Cluster OS Rolling Upgrade process, installation steps, feature limitations, and frequently asked questions (FAQs), and is applicable to the following Cluster OS Rolling Upgrade scenarios in Windows Server:

- Hyper-V clusters

- Scale-Out File Server clusters

The following scenario is not supported:

- Cluster OS Rolling Upgrade of guest clusters using virtual hard disk (.vhdx file) as shared storage.

Cluster OS Rolling Upgrade is fully supported by System Center Virtual Machine Manager (SCVMM). If you are using SCVMM, see Perform a rolling upgrade of a Hyper-V host cluster to Windows Server 2016 in VMM for guidance on upgrading the clusters and automating the steps that are described in this document.

Requirements

Complete the following requirements before you begin the Cluster OS Rolling Upgrade process:

- Start with a Failover Cluster running Windows Server 2012 R2 or newer. You can upgrade to the next version, for example from Windows Server 2016 to Windows Server 2019.

- Verify that the Hyper-V nodes have CPUs that support Second-Level Addressing Table (SLAT) using one of the following methods;

— Review the Are you SLAT Compatible? WP8 SDK Tip 01 article that describes two methods to check if a CPU supports SLATs

— Download the Coreinfo v3.31 tool to determine if a CPU supports SLAT.

Cluster transition states during Cluster OS Rolling Upgrade

This section describes the various transition states of the Windows Server cluster that is being upgraded to the next version of Windows Server using Cluster OS Rolling Upgrade.

In order to keep the cluster workloads running during the Cluster OS Rolling Upgrade process, moving a cluster workload from a node running an older version of Windows Server to a node running a newer version of Windows Server works by using a compatibility mode. This compatibility mode makes the nodes running the newer version of Windows Server appear as if they are running the the same older version of Windows Server. For example, when upgrading a Windows Server 2016 cluster to Windows Server 2019, Windows Server 2019 nodes operate in a Windows Server 2016 compatibility mode as a temporary measure. A new conceptual cluster mode, called mixed-OS mode, allows nodes of different versions to exist in the same cluster (see Figure 1).

Figure 1: Cluster operating system state transitions

A Windows Server cluster enters mixed-OS mode when a node running a newer version of Windows Server is added to the cluster. The process is fully reversible at this point — newer Windows Server nodes can be removed from the cluster and nodes running the existing version of Windows Server can be added to the cluster in this mode. The process is not reversible once the Update-ClusterFunctionalLevel PowerShell cmdlet is run on the cluster. In order for this cmdlet to succeed, all nodes must be running the newer version of Windows Server, and all nodes must be online.

Transition states of a four-node cluster while performing Rolling OS Upgrade

This section illustrates and describes the four different stages of a cluster with shared storage whose nodes are upgraded from Windows Server 2012 R2 to Windows Server 2016. The process is the same for later versions of Window Server.

«Stage 1» is the initial state — we start with a Windows Server 2012 R2 cluster.

Figure 2: Initial State: Windows Server 2012 R2 Failover Cluster (Stage 1)

In «Stage 2», two nodes have been paused, drained, evicted, reformatted, and installed with Windows Server 2016.

Figure 3: Intermediate State: Mixed-OS mode: Windows Server 2012 R2 and Windows Server 2016 Failover cluster (Stage 2)

At «Stage 3», all of the nodes in the cluster have been upgraded to Windows Server 2016, and the cluster is ready to be upgraded with Update-ClusterFunctionalLevel PowerShell cmdlet.

[!NOTE]

At this stage, the process can be fully reversed, and Windows Server 2012 R2 nodes can be added to this cluster.

Figure 4: Intermediate State: All nodes upgraded to Windows Server 2016, ready for Update-ClusterFunctionalLevel (Stage 3)

After the Update-ClusterFunctionalLevel cmdlet is run, the cluster enters «Stage 4», where new Windows Server 2016 cluster features can be used.

Figure 5: Final State: Windows Server 2016 Failover Cluster (Stage 4)

Cluster OS Rolling Upgrade Process

This section describes the workflow for performing Cluster OS Rolling Upgrade.

Figure 6: Cluster OS Rolling Upgrade Process Workflow

Cluster OS Rolling upgrade includes the steps below for upgrading from Windows Server 2012 R2 to Windows Server 2016, however the process is the same for later versions of Window Server.

-

Prepare the cluster for the operating system upgrade as follows:

-

Cluster OS Rolling Upgrade requires removing one node at a time from the cluster. Check if you have sufficient capacity on the cluster to maintain HA SLAs when one of the cluster nodes is removed from the cluster for an operating system upgrade. In other words, do you require the capability to failover workloads to another node when one node is removed from the cluster during the process of Cluster OS Rolling Upgrade? Does the cluster have the capacity to run the required workloads when one node is removed from the cluster for Cluster OS Rolling Upgrade?

-

For Hyper-V workloads, check that all Windows Server Hyper-V hosts have CPU support for Second-Level Address Table (SLAT). Only SLAT-capable machines can use the Hyper-V role in Windows Server 2016 and newer.

-

Check that any workload backups have completed, and consider backing-up the cluster. Stop backup operations while adding nodes to the cluster.

-

Check that all cluster nodes are online /running/up using the

Get-ClusterNodecmdlet (see Figure 7).

Figure 7: Determining node status using Get-ClusterNode cmdlet -

If you are running Cluster Aware Updates (CAU), verify if CAU is currently running by using the Cluster-Aware Updating UI, or the

Get-CauRuncmdlet (see Figure 8). Stop CAU using theDisable-CauClusterRolecmdlet (see Figure 9) to prevent any nodes from being paused and drained by CAU during the Cluster OS Rolling Upgrade process.

Figure 8: Using theGet-CauRuncmdlet to determine if Cluster Aware Updates is running on the cluster

Figure 9: Disabling the Cluster Aware Updates role using theDisable-CauClusterRolecmdlet

-

-

For each node in the cluster, complete the following:

-

Using Cluster Manager UI, select a node and use the Pause | Drain menu option to drain the node (see Figure 10) or use the

Suspend-ClusterNodecmdlet (see Figure 11).

Figure 10: Draining roles from a node using Failover Cluster Manager

Figure 11: Draining roles from a node using theSuspend-ClusterNodecmdlet -

Using Cluster Manager UI, Evict the paused node from cluster, or use the

Remove-ClusterNodecmdlet.

Figure 12: Remove a node from the cluster usingRemove-ClusterNodecmdlet -

Reformat the system drive and perform a «clean operating system install» of Windows Server 2016 on the node using the Custom: Install Windows only (advanced) installation (See Figure 13) option in setup.exe. Avoid selecting the Upgrade: Install Windows and keep files, settings, and applications option since Cluster OS Rolling Upgrade doesn’t encourage in-place upgrade.

Figure 13: Available installation options for Windows Server 2016 -

Add the node to the appropriate Active Directory domain.

-

Add the appropriate users to the Administrators group.

-

Using the Server Manager UI or Install-WindowsFeature PowerShell cmdlet, install any server roles that you need, such as Hyper-V.

Install-WindowsFeature -Name Hyper-V

-

Using the Server Manager UI or Install-WindowsFeature PowerShell cmdlet, install the Failover Clustering feature.

Install-WindowsFeature -Name Failover-Clustering

-

Install any additional features needed by your cluster workloads.

-

Check network and storage connectivity settings using the Failover Cluster Manager UI.

-

If Windows Firewall is used, check that the Firewall settings are correct for the cluster. For example, Cluster Aware Updating (CAU) enabled clusters may require Firewall configuration.

-

For Hyper-V workloads, use the Hyper-V Manger UI to launch the Virtual Switch Manager dialog (see Figure 14).

Check that the name of the Virtual Switch(s) used are identical for all Hyper-V host nodes in the cluster.

Figure 14: Virtual Switch Manager -

On a Windows Server 2016 node (do not use a Windows Server 2012 R2 node), use the Failover Cluster Manager (see Figure 15) to connect to the cluster.

Figure 15: Adding a node to the cluster using Failover Cluster Manager -

Use either the Failover Cluster Manager UI or the

Add-ClusterNodecmdlet (see Figure 16) to add the node to the cluster.

Figure 16: Adding a node to the cluster usingAdd-ClusterNodecmdlet[!NOTE]

When the first Windows Server 2016 node joins the cluster, the cluster enters «Mixed-OS» mode, and the cluster core resources are moved to the Windows Server 2016 node. A «Mixed-OS» mode cluster is a fully functional cluster where the new nodes run in a compatibility mode with the old nodes. «Mixed-OS» mode is a transitory mode for the cluster. It is not intended to be permanent and customers are expected to update all nodes of their cluster within four weeks. -

After the Windows Server 2016 node is successfully added to the cluster, you can (optionally) move some of the cluster workload to the newly added node in order to rebalance the workload across the cluster as follows:

Figure 17: Moving a cluster workload (cluster VM role) usingMove-ClusterVirtualMachineRolecmdlet-

Use Live Migration from the Failover Cluster Manager for virtual machines or the

Move-ClusterVirtualMachineRolecmdlet (see Figure 17) to perform a live migration of the virtual machines.Move-ClusterVirtualMachineRole -Name VM1 -Node robhind-host3

-

Use Move from the Failover Cluster Manager or the

Move-ClusterGroupcmdlet for other cluster workloads.

-

-

-

When every node has been upgraded to Windows Server 2016 and added back to the cluster, or when any remaining Windows Server 2012 R2 nodes have been evicted, do the following:

[!IMPORTANT]

- After you update the cluster functional level, you cannot go back to Windows Server 2012 R2 functional level and Windows Server 2012 R2 nodes cannot be added to the cluster.

- Until the

Update-ClusterFunctionalLevelcmdlet is run, the process is fully reversible and Windows Server 2012 R2 nodes can be added to this cluster and Windows Server 2016 nodes can be removed. - After the

Update-ClusterFunctionalLevelcmdlet is run, new features will be available.

-

Using the Failover Cluster Manager UI or the

Get-ClusterGroupcmdlet, check that all cluster roles are running on the cluster as expected. In the following example, Available Storage is not being used, instead CSV is used, hence, Available Storage displays an Offline status (see Figure 18).

Figure 18: Verifying that all cluster groups (cluster roles) are running using theGet-ClusterGroupcmdlet -

Check that all cluster nodes are online and running using the

Get-ClusterNodecmdlet. -

Run the

Update-ClusterFunctionalLevelcmdlet — no errors should be returned (see Figure 19).

Figure 19: Updating the functional level of a cluster using PowerShell -

After the

Update-ClusterFunctionalLevelcmdlet is run, new features are available.

-

Resume normal cluster updates and backups:

-

If you were previously running CAU, restart it using the CAU UI or use the

Enable-CauClusterRolecmdlet (see Figure 20).

Figure 20: Enable Cluster Aware Updates role using theEnable-CauClusterRolecmdlet -

Resume backup operations.

-

-

Enable and use the Windows Server 2016 features on Hyper-V Virtual Machines.

-

After the cluster has been upgraded to Windows Server 2016 functional level, many workloads like Hyper-V VMs will have new capabilities. For a list of new Hyper-V capabilities. see Migrate and upgrade virtual machines

-

On each Hyper-V host node in the cluster, use the

Get-VMHostSupportedVersioncmdlet to view the Hyper-V VM configuration versions that are supported by the host.

Figure 21: Viewing the Hyper-V VM configuration versions supported by the host -

On each Hyper-V host node in the cluster, Hyper-V VM configuration versions can be upgraded by scheduling a brief maintenance window with users, backing up, turning off virtual machines, and running the

Update-VMVersioncmdlet (see Figure 22). This will update the virtual machine version, and enable new Hyper-V features, eliminating the need for future Hyper-V Integration Component (IC) updates. This cmdlet can be run from the Hyper-V node that is hosting the VM, or the-ComputerNameparameter can be used to update the VM Version remotely. In this example, here we upgrade the configuration version of VM1 from 5.0 to 7.0 to take advantage of many new Hyper-V features associated with this VM configuration version such as Production Checkpoints (Application Consistent backups), and binary VM configuration file.

Figure 22: Upgrading a VM version using the Update-VMVersion PowerShell cmdlet

-

-

Storage pools can be upgraded using the Update-StoragePool PowerShell cmdlet — this is an online operation.

Although we are targeting Private Cloud scenarios, specifically Hyper-V and Scale-out File Server clusters, which can be upgraded without downtime, the Cluster OS Rolling Upgrade process can be used for any cluster role.

Restrictions / Limitations

- This feature works only for versions of Windows Server starting with Windows Server 2012 R2. This feature cannot upgrade earlier versions of Windows Server such as Windows Server 2008, Windows Server 2008 R2, or Windows Server 2012.

- Each Windows Server 2016 node should be reformatted/new installation only. In-place or upgrade installation types are discouraged.

- A node running the newer version of Windows Server must be used to add the new nodes to the cluster.

- When managing a mixed-OS mode cluster, always perform the management tasks from an up-level node that is running Windows Server 2016. Downlevel Windows Server nodes cannot use UI or management tools against newer versions of Windows Server.

- We encourage customers to move through the cluster upgrade process quickly because some cluster features are not optimized for mixed-OS mode.

- Avoid creating or resizing storage on newer Windows Server nodes while the cluster is running in mixed-OS mode because of possible incompatibilities on failover from a newer Windows Server node to down-level Windows Server nodes.

Frequently asked questions

How long can the failover cluster run in mixed-OS mode?

We encourage customers to complete the upgrade within four weeks. We have successfully upgraded Hyper-V and Scale-out File Server clusters with zero downtime in less than four hours total.

Will you port this feature back to Windows Server 2012, Windows Server 2008 R2, or Windows Server 2008?

We do not have any plans to port this feature back to previous versions. Cluster OS Rolling Upgrade is our vision for upgrading Windows Server clusters.

Do the nodes running the older Windows Server version need to have all the software updates installed before starting the Cluster OS Rolling Upgrade process?

Yes, before starting the Cluster OS Rolling Upgrade process, verify that all cluster nodes are updated with the latest software updates.

Can I run the Update-ClusterFunctionalLevel cmdlet while nodes are Off or Paused?

No. All cluster nodes must be on and in active membership for the Update-ClusterFunctionalLevel cmdlet to work.

Does Cluster OS Rolling Upgrade work for any cluster workload? Does it work for SQL Server?

Yes, Cluster OS Rolling Upgrade works for any cluster workload. However, it is only zero-downtime for Hyper-V and Scale-out File Server clusters. Most other workloads incur some downtime (typically a couple of minutes) when they failover, and failover is required at least once during the Cluster OS Rolling Upgrade process.

Can I automate this process using PowerShell?

Yes, we have designed Cluster OS Rolling Upgrade to be automated using PowerShell.

For a large cluster that has extra failover capacity, can I upgrade multiple nodes simultaneously?

Yes. When one node is removed from the cluster to upgrade the OS, the cluster will have one less node for failover, hence will have a reduced failover capacity. For large clusters with enough workload and failover capacity, multiple nodes can be upgraded simultaneously. You can temporarily add cluster nodes to the cluster to provide improved workload and failover capacity during the Cluster OS Rolling Upgrade process.

What if I discover an issue in my cluster after Update-ClusterFunctionalLevel has been run successfully?

If you have backed-up the cluster database with a System State backup before running Update-ClusterFunctionalLevel, you should be able to perform an Authoritative restore on a node running the previous version of Windows Server and restore the original cluster database and configuration.

Can I use in-place upgrade for each node instead of using clean-OS install by reformatting the system drive?

We do not encourage the use of in-place upgrade of Windows Server, but we are aware that it works in some cases where default drivers are used. Please carefully read all warning messages displayed during in-place upgrade of a cluster node.

If I am using Hyper-V replication for a Hyper-V VM on my Hyper-V cluster, will replication remain intact during and after the Cluster OS Rolling Upgrade process?

Yes, Hyper-V replica remains intact during and after the Cluster OS Rolling Upgrade process.

Can I use System Center Virtual Machine Manager (SCVMM) to automate the Cluster OS Rolling Upgrade process?

Yes, you can automate the Cluster OS Rolling Upgrade process using VMM in System Center.