Windows Storage Server is an exciting development in the storage platform. It can run on nearly any spec’d hardware and allows for simple management of storage appliances across a wide variety of manufacturers. Unlike customized NAS OS from other platforms, you get similar features and functions across an array of manufacturers. It is offered in two flavors, provides simple management, and runs like a champ. Additionally, having familiarity with Windows Server operating systems allows administrators to dive right in.

Windows Storage Server comes in two flavors, WorkGroup and Standard. While they function the same, there are some key differences between the two:

| Role/Feature | Windows Storage Server 2012 R2 Workgroup | Windows Storage Server 2012 R2 Standard |

|---|---|---|

| Active Directory domain controller | No | No |

| Domain join | Yes | Yes |

| Active Directory Lightweight Directory Services (AD LDS) | Yes | Yes |

| Active Directory Certificate Services (AD CS) | No | No |

| Active Directory Federation Services (AD FS) | No | No |

| Active Directory Rights Management Services (AD RMS) | No | No |

| BranchCache™ Peer to Peer | Yes | Yes |

| BranchCache™ Hosted cache | No | Yes |

| Failover clustering | No | Yes |

| Data Deduplication | No | Yes |

| Virtualization (Hyper-V® host or guest support) | No | Yes, 2 VMs |

| Dynamic Host Configuration Protocol (DHCP) | No | Yes |

| DNS | No | Yes |

| Windows Internet Name Service (WINS) | No | Yes |

| Application Server | No | No |

| Network Policy | No | No |

| Desktop Broker | No | No |

| Windows Deployment Server (WDS) | No | No |

| Fax Server | No | No |

| Hardware feature | Windows Storage Server 2012 R2 Workgroup | Windows Storage Server 2012 R2 Standard |

|---|---|---|

| Architecture | x64 | x64 |

| CPU Sockets | 1 | 2 per license |

| Random access memory (RAM) | 32 gigabytes | Unlimited (2 TB on Windows Storage Server 2012 Standard) |

| Disks (number / interfaces / RAID type) | 6/Non-external SAS/Any | Any/Any/Any |

| Concurrent Server Message Block (SMB) connections | 250 | Unlimited |

| Maximum number of users | 50 | Unlimited |

Additionally, licenses can be stacked. If you wanted to create a four socket system and wanted to have four virtual machine licenses you can stack two Standard licenses on the solution.

Key enhancements for Windows Storage Server 2012 R2 over is older brothers (2008/R2 and 2012):

iSCSI Target Server –Improvements to iSCSI Target Server include support for VHDx (VHD 2.0) virtual hard disks for capacities of up to 64 TB. iSCSI Target Server also now supports SMI-S, enabling end-to-end provisioning using System Center Virtual Machine Manager.

SMB – Improvements to the Server Message Block (SMB) protocol include better SMB Direct performance, automatic rebalancing for Cluster Shared Volumes (CSV) on scale-out file servers, shared VHDx files, Hyper-V Live Migration over SMB, SMB bandwidth management, detailed event messages, and more.

Work Folders – a new feature that facilitates the BYOD (bring-your-own-device) scenario by enabling users to access work files from their personal computers and devices. Organizations retain centralized control over their data and can specify device policies such as encryption and lock screen password.

DFS Replication – Enhancements include increases in scalability, the ability to do database cloning and corruption recovery, a Windows PowerShell module, a new WMI provider, faster replication on high bandwidth connections, and recovery tools for conflicts.

Failover Clustering – Enhancements include improvements to virtual machine availability, Cluster Shared Volumes (CSV), dynamic cluster quorums, cluster node health detection, deployment, updating and monitoring.

Hyper-V – Enhancements include shared virtual hard disks, resizing of virtual hard disks while a VM is running, storage quality of service (QoS), improved performance for live migrations, cross-version live migrations, and several more new or improved capabilities.

Storage Spaces – Enhancements include storage tiering, SSD write-back caches for storage spaces, parity storage spaces on failover clusters, dual parity storage spaces, and faster rebuilding of storage spaces after disk failures.

Data Deduplication – Enhancements include support for Cluster Shared Volumes and deduplication of live Virtual Desktop Infrastructure (VDI) VMs that reside on a file server connected via SMB.

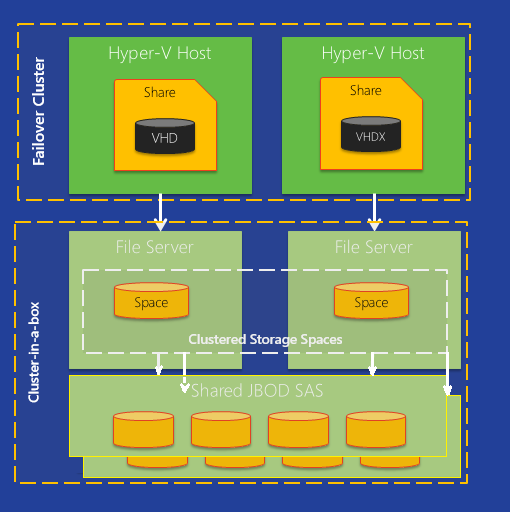

OEM Appliance OOBE (out-of-the-box experience) – Enhancements include added support for four-node cluster deployments and a wizard for creating a domain controller within a Hyper-V VM that can be used to deploy a turnkey cluster-in-a-box.

Storage Management API – Enhancements include an improved Storage Management API enables 10x faster enumerations, added cluster-awareness, and remote management for Storage Spaces new features.

All versions of Windows Storage server can be added to an Active Directory domain, but it cannot function as a domain controller.

Корпорация Microsoft в конце октября выпустила свою новую операционную систему для серверов Windows Server 2012, которая имеет несколько редакций. Системные администраторы могут выбрать те преимущества решения, которые являются для них наиболее значимыми и удовлетворяют их финансовым и функциональным требованиям. Рассмотрим эти редакции Windows Server 2012 подробнее

Николай Печенкин — старший преподаватель учебного центра «Микротест» по направлению Microsoft

.

1. Редакция Windows Server 2012 Standard. Включает в себя все роли и компоненты, доступные для платформы Windows Server 2012, поддерживает до 64 процессорных разъемов, до 4 Тбайт оперативной памяти и предусматривает две лицензии для виртуальных машин.

2. Редакция Windows Server 2012 Datacenter. Включает все роли и компоненты, доступные для платформы Windows Server 2012, поддерживает до 64 процессорных разъемов, до 640 ядер процессоров и до 4 Тбайт оперативной памяти. Предусматривает неограниченное количество лицензий для запуска виртуальных машин на этом же оборудовании.

3. Редакция Windows Server 2012 Foundation. Поставляется только вместе с серверным аппаратным обеспечением, поддерживает 15 пользователей; сервер не может быть включен в домен. Поддерживает один процессор, 32 Гбайт оперативной памяти и только часть служебных ролей сервера.

4. Windows Server 2012 Essentials. Служит в качестве замены редакции Small Business Server в предыдущих версиях. Не может запускать роль Hyper-V, участвовать в формировании отказоустойчивого кластера, устанавливаться в режиме ядра server core или быть сервером служб удаленных рабочих столов remote desktop services. Поддерживает подключение до 25 пользователей и 50 устройств, два процессора и 64 Гбайт оперативной памяти. Сервер с этой редакцией должен быть основным (root) сервером в домене.

5. Microsoft Hyper-V Server 2012. Автономная редакция Hyper-V для виртуальных машин без пользовательского интерфейса. Не требует лицензии для хостовой операционной системы, виртуальные машины при этом лицензируются как обычно. Поддерживает 64 процессорных разъема и 4 Tбайт оперативной памяти. Может подключаться к домену. Не поддерживает другие роли Windows Server 2012.

6. Windows Storage Server 2012 Workgroup. Поставляется только вместе с аппаратным обеспечением. Система хранения начального уровня. Поддерживает до 50 пользователей, один процессор и 32 Гбайт оперативной памяти. Возможно подключение к домену.

7. Windows Storage Server 2012 Standard. Поддерживает 64 процессора, но лицензируется с шагом в два. Поддерживает 4 Tбайт оперативной памяти. Включает две лицензии на виртуальные машины. Предполагает включение в домен. Поддерживает некоторые роли, например DNS и DHCP Server, но не поддерживает: Active Directory Domain Services (AD DS), Active Directory Certificate Services (AD CS) и Active Directory Federation Services (AD FS).

8. Windows MultiPoint Server 2012 Standard. Предусматривает доступ нескольких пользователей к одному хостовому компьютеру напрямую, при этом каждый из них использует свою мышь, клавиатуру и монитор. Поддерживает один процессор, 32 Гбайт оперативной памяти и максимум 12 сессий. Поддерживает некоторые роли, например DNS и DHCP Server roles, но не поддерживает AD DS, AD CS и AD FS. Включение в домен невозможно.

9. Windows MultiPoint Server 2012 Premium. Поддерживает доступ нескольких пользователей к одному хостовому компьютеру напрямую, при этом каждый работает со своей мышью, клавиатурой и монитором. Поддерживает 2 процессора, 4 Тбайт оперативной памяти и максимум 22 сессии. Предполагается использование некоторых ролей, например DNS и DHCP Server; не поддерживаются AD DS, AD CS и AD FS. Допускается подключение к домену.

Требования к аппаратной части Windows Server 2012 зависят от количества ролей и пользователей, подключающихся к серверу. Каждая роль и каждый установленный компонент, в свою очередь, увеличивают общую нагрузку на жесткий диск, процессор, память. При установке Windows Server 2012 в виртуальной среде требования к аппаратной части не меняются, установка возможна на платформу виртуализации Hyper-V, а также на некоторые платформы сторонних разработчиков. Минимальные требования к аппаратному обеспечению представлены в таблице.

При рассмотрении вопроса об обновлении или миграции на Windows Server 2012 следует учитывать особенности, описанные ниже.

Установка через обновление

При установке методом обновления сохраняются файлы, настройки и приложения, установленные на исходном сервере. Вы выполняете обновление в случае, если хотите продолжать использовать то же самое серверное оборудование. Вы можете обновить имеющуюся версию до Windows Server 2012 только с x64 версий Windows Server 2003, Windows Server 2003 R2, Windows Server 2008 и Windows Server 2008 R2.

Установка посредством миграции

Используйте миграцию, когда вы хотите перейти от x86 версии Windows Server 2003, Windows Server 2003 R2 или Windows Server 2008. При миграции можно задействовать компонент Windows Server Migration Tools, входящий в состав Windows Server 2012 для переноса файлов и настроек с компьютеров, работающих под управлением Windows Server 2003, Windows Server 2003 R2, Windows Server 2008, Windows Server 2008 R2.

Кроме представленных выше редакций Windows Server 2012 поддерживает установку в режимеServer Core (минимальный вариант установки Windows Server 2012). При этом работа с сервером осуществляется из командной строки либо с удаленного компьютера, с помощью установленных средств администрирования. Подобный подход имеет ряд преимуществ.

-Поскольку сервер в режиме Server Core имеет меньшее количество компонентов, он требует меньшего количества обновлений, что сокращает время обслуживания сервера системными администраторами.

-Набор функций минимален, требуется меньшее количество оперативной памяти и меньше места на диске.

-Меньшее количество приложений сокращает площадь атаки на сервер.

Возможны два варианта установки Server Core. Первый — стандартный вариант установки. По умолчанию все графические инструменты администрирования находятся в состоянии «Удалены» (Removed). Управление осуществляется локально, только из командной строки, либо путем подключения с удаленной системы с помощью графических средств. Вы можете преобразовать Server Core до полной версии Windows Server 2012 с графическими инструментами администрирования только при наличии всех файлов установки.

Второй вариант — установка в режиме Server Core с инструментами управления. Этот вариант также известен как Server Core-Full Server. Данная редакция работает подобно Windows Server 2012 с графическими инструментами управления. При этом все графические компоненты уже скопированы на диск, но не установлены. Вы можете конвертировать Server Core-Full Server до Windows Server 2012 без дополнительных файлов установки.

Пробежимся по установке

Обычная установка Windows Server 2012 (если вы ее осуществляете без использования файла ответов) включает следующие шаги.

1.Подключение к источнику установки. При этом возможны варианты:

*начать установку с DVD-ROM;

*начать установку с диска USB;

*произвести загрузку по сети (PXE boot), после чего подключиться к серверу WDS и начать установку.

2.На первой странице Windows Setup Wizard необходимо выбрать:

*язык установки;

*формат времени и валюты;

*раскладку и методы ввода.

3.На второй странице мастера Windows Setup Wizard следует выбрать вариант «Установить» (Install now). Также на этой странице вы можете выбрать вариант «Восстановить» (Repair Your Computer). Эту возможность следует выбирать в том случае, если вы не можете загрузить уже установленную версию Windows Server 2012.

4.На странице выбора версии операционной системы указывается версия для установки. По умолчанию задан режим Server Core.

5.На странице лицензионного соглашения необходимо ознакомиться с ним и принять для продолжения установки.

6.На странице выбора типа установки доступны следующие варианты:

*обновление (Upgrade); выбирайте этот вариант, если требуется выполнить обновление до Windows Server 2012 с уже установленной версии Windows Server;

*Custom; выбирайте этот вариант, если нужно выполнить новую установку.

7.На странице выбора места для установки укажите диск, на который необходимо произвести установку. На данном этапе вы можете отформатировать диск, разбить его на разделы, создать диск VHD для установки операционной системы на него. После нажатия кнопки «Далее» начнется процесс копирования файлов, и компьютер будет несколько раз перезагружен. Время установки в первую очередь зависит от аппаратных характеристик компьютера.

8.На странице настроек Settings необходимо ввести пароль для локальной учетной записи администратора, после чего вы сможете выполнить регистрацию в системе для выполнения дополнительных настроек.

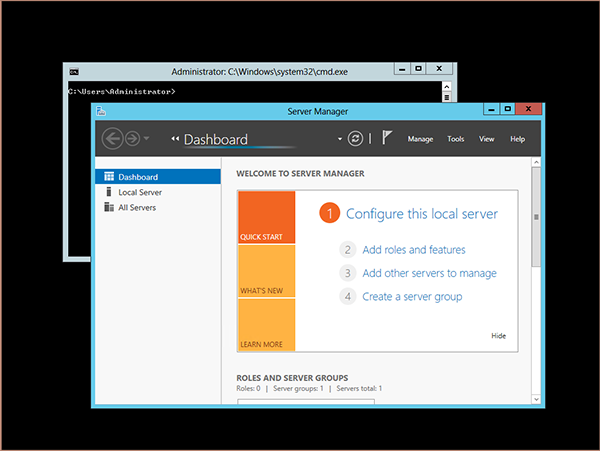

От ядра

Одной из новых функций Windows Server 2012 является возможность перехода от версии Core к полноценной версии с графическим интерфейсом без переустановки всей операционной системы. Для этого потребуется выполнить следующие действия:

-создать папку для монтирования образа. Для этого в командной строке выполним команду mkdir c:mount

-смонтировать образ полной версии Windows Server 2012 — dism.exe /mount-image /ImageFile:d:sourcesinstall.wim /Index:4 /Mountdir:c:mount /readonly

-импортировать графические модули, выполнив следующие команды:

*PowerShell.exe

*Import-Module ServerManagerInstall-WindowsFeature -IncludeAllSubfeature User-Interfaces-Infra -Source:c:mountwindows

и далее выполнить перезагрузку — Shutdown /r /t 5

После проведения этой процедуры вы получите полноценную версию Windows Server 2012 с графическими инструментами управления (см. экран).

|

| Экран. Окно Windows Server 2012 с графическими инструментами управления |

Для обратного преобразования необходимо выполнить следующие команды:

— Powershell.exe;

— Import-Module ServerManager;

— Uninstall-WindowsFeature User-Interfaces-Infra;

— Shutdown /r /t 5.

Содержание

Что нового в хранилище Windows Server 2012 R2?

Многоуровневые пространства хранения

Кеш с обратной записью

Распараллеленное восстановление

Низкоуровневое усовершенствование: встроенная поддержка секторов 4 КБайт

Поддержка UEFI BIOS позволяет работать с дисками GPT

Утилита снкdsк стала более интеллектуальной

Онлайновое самолечение

Онлайновая верификация

Онлайновая идентификация и ведение журналов

Точное и быстрое исправление

Пространства хранения в Wiпdows Server 2012 R2

Повторное использование технологии из облачных служб Microsoft

Предоставление SАN-подобных возможностей посредством инструментов управления Microsoft

Создание пространствах хранения

Создание пула

Ограничения пулов хранения

Просмотр устройств в инструменте Disk Management

Работа с пулом хранения в PowerShell

Выделение пространств а пула под виртуальный диск

Демонстрация настройки многоуровневого хранения с помощью PowerShell

iSCSI в пространствах имен

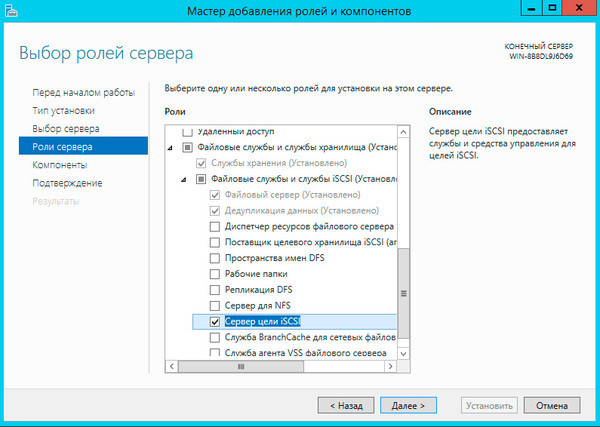

Добавление целевой службы iSCSI

Подключение к виртуальному диску iSCSI со стороны клиента

Общие ресурсы NFS

Где используется общий ресурс NFS

Быстрая настройка общего ресурса NFS

Подключение к общему ресурсу NFS со стороны клиента

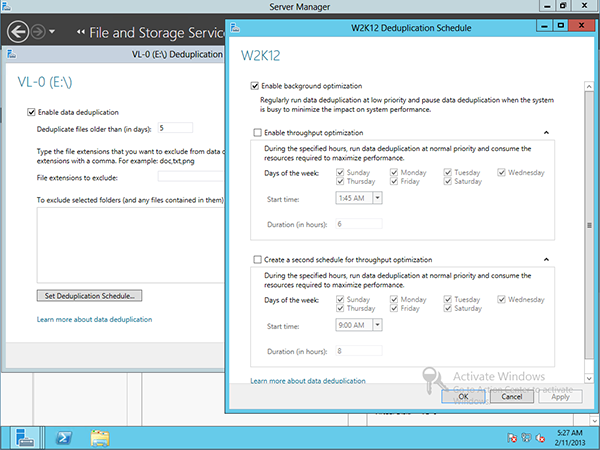

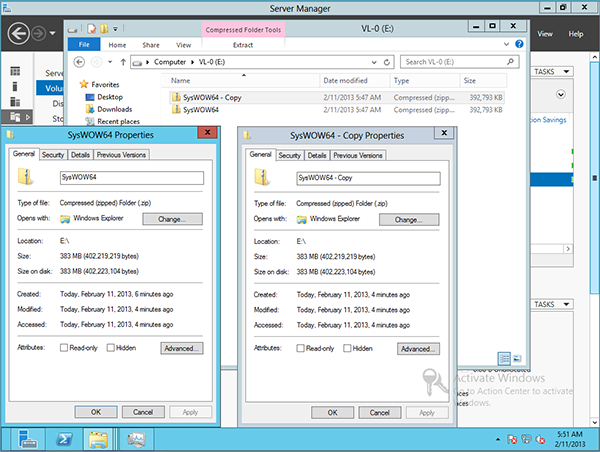

Дедупликация: диск и сеть

Конфигурирование дедупликации данных с помощью диспетчера серверов

Конфигурирование дедупликации данных с помощью PowerShell

Проверка томов на предмет повреждений

Администраторы, которые имели возможность поработать какое-то время с

пространствами хранения (Storage Spaces) в Windows Server 2012, наверняка по

достоинству оценят изменения, внесенные в Windows Server 2012 R2. Но прежде чем приступить к их обсуждению, давайте ознакомимся с краткой сводкой п Storage Spaces, предназначенной для тех, кто не еще не имел дела с этим средством.

Средство Storage Spaces было представлено в Windows Server 2012 как встроенный компонент. Вспомните, что это не RAID, но кое-что новое, что было спроектировано для полноценного корпоративного использования.

Базовая функция Storage Spaces заключается в том, чтобы дать возможность взять просто группу дисков Uust а bunch of disks — JBOD) и сконфигурировать их в пуле. Отсюда вы можете создавать виртуальные диски (действительное пространство хранения) и тома с устойчивостью к отказам разнообразных уровней. Такой тип конфигурации обеспечивает высокую гибкость.

Представьте себе отсутствие обязательства инвестировать в крупную дорогос

тоящую сеть хранения данных (storage area network — SAN) или в специальное

обучение, которое администраторы должны были бы пройти, чтобы конфигури

ровать и обслуживать эту сеть. Основной целью Storage Spaces является предостав

ление рентабельного решения для хранилища с непрерывным доступом к данным.

Пространства хранения и пулы спроектированы с возможностью увеличения по

запросу.

Ниже приведен список лишь некоторых возможностей в Storage Spaces, входя-

щих в состав Windows Server 2012:

• оперативная настройка;

• устойчивость к отказам (зеркальное отображение и контроль по четности);

• интеллектуальное исправление ошибок;

• поддержка множества владельцев;

• интеграция с CSV для возможности обработки масштабированных сценариев.

В этой главе вы изучите следующие темы:

• создание пула хранения на виртуальном диске;

• создание дополнительного хранилища на виртуальном диске;

• применение приемов дедупликации для сокрашения размера файлов.

Что нового в хранилище Windows Server 2012 R2?

Поскольку эта книга посвяшена Windows Server 2012 R2, мы покажем, что нового

пояnилось в хранилище. Разработчики из Microsoft включили в Storage Spaces технологию, которую ранее можно было nстретить только в дорогостоящих массивах хранения. Эта технология подробно рассматривается в последующих разделах.

Многоуровневые пространства хранения

В современном мире хранилищ существует несколько классификаций дисков, в

том числе последовательная расширенная технология подключения (Serial Advance

Technology Attachment — SATA), последовательно присоединенное SСSl-устройство (Serial Attached SCSI — SAS), твердотельный накопитель (Solid State Drive — SSD) и оптоволоконный канал (Fibre Channel). Выбор правильного типа хранилища для работы очень важен. Например, если вам необходим файловый сервер, то SSD не является удачным выбором. Накопители SSD были спроектированы для обеспечения

высокой скорости, но не емкости, и в связи с тем, что файловые серверы обычно нуждаются в емкости, а не скорости, в этом случае намного лучше может подойти диск SATA, который проектировался для большей емкости, нежели скорости.

В Windows Server 201 2 R2 можно иметь максимум два уровня хранения, в сущности, быстрый уровень и медленный уровень. На быстром уровне автоматически используется SSD, а на меменном — SATA. По-настоящему хорошо здесь то, что администратор не должен решать заранее, где размещать данные.

Службы управления

уровнями хранения (Storage Тiers Manageшent Service) автоматически проанализирует данные на дисках в срезах по 1 Мбайт. Она имеет две категории для назначения:

горячие точки (hot spot) и холодные точки (cold spot). Горячие точки — это об.1асти данных, доступ к которым производится часто; здесь выдвигается предположение о том, что поскольку это активные данные, они являются своего рода «горячей темой». Холодные точки представляют собой противоположность: данные, доступ к которым осуществляется нечасто. После анализа горячие точки будут переведены

на уровень SSD, а любые идентифицированные холодные точки будут назначены

уровню SATA.

По умолчанию анализ происходит ежедневно в 1 :00, но вы можете сконфигури

ровать это по своему усмотрению (рис. 1 2. l ). Но если файл нуждается в нахождении на быстром уровне все время, администратор может «закрепить» такой файл на этом уровне.

Рис. 12.1 . Служба Storage Tiers Management в планировщике задач

Кеш с обратной записью

Под кешем с обратной записью понимается способ записи данных на диск.

Данные сначала записываются в кеш, и будут храниться в нем до тех пор, пока их не потребуется перезаписать; в этот момент они сбрасываются на диск и фиксируются. В общем случае запись и хранение данных в кеше обеспечивает лучшую производительность и рассматривается как еще один тип памяти. Если приложение записывает в кеш, оно может быстро-освободить свой обработчик ввода-вывода и возвратиться к выполнению других задач. Определенным рабочим нагрузкам традиционно не нравится кеширование с обратной записью, потому что когда приложение записывает данные, они должны быть записаны на диск во избежание разрушения. Например, Hyper-V требует сквозной записи. Многоуровневое хранилище

может применяться в сочетании с виртуальным диском (в этом случае не с файломVHD/VHDX, имеющим отношение к Hyper-Y и виртуальным машинам, а вирту

альным диском с точки зрения Storage Spaces), чтобы поглощать любые выбросы в операциях записи. Быстрый уровень затем может использоваться для преодоления выброса и разрешения Hyper-V применять кеширование с обратной записью.

Распараллеленное восстановление

В случае отказа диска в традиционном массиве RAID, при наличии горячего ре

зерва (диск, который может немедленно принять работу отказавшего диска в масси

ве RAID), этот горячий резерв вступает в игру и массив RAID начнет воссоздание данных на отказавшем диске. Во время воссоздания влияние на производительность дисковой подсистемы неизбежно, т.к. все данные записываются на единственный диск. Процесс распараллеленного восстановления в Storage Spaces несколько отличается. Если диск отказывает, оставшиеся работоспособные диски, которые имеют подходящую емкость, получают права владения данными, сохраненными на отказавшем диске, и будут обслуживать запросы от пользователей по всем доступнымнакопителям.

Поскольку теперь помощь оказывают все диски, влияние на производительность отсутствует. Процесс восстановления может задействовать горячий резерв или же администратор может заменить отказавший диск новым, который в

фоновом режиме постепенно возвратится в пространство хранения.

низкоуровневое усовершенствование: встроенная поддержка секторов

4 Кбайт

Первоначально жесткие диски использовали формат 512 байтов на сектор, и это

налагало ограничения на размер и производительность хранилища.

Учитывая постоянно растущие потребности в емкости и скорости, назрела необходимость в изменениях, и в течение всего нескольких лет стандартом стали диски с секторами 4 Кбайт.

Тем не менее, программное обеспечение (такое как утилиты файловой системы, операционные системы и механизмы баз данных) не обязательно быстро подхватили это изменение. Большинство производителей устройств поставляли диски с секторами 4 Кбайт, но в целях совместимости эмулировали 512-байтовые секторы.

Очевидно, это сопровождается некоторыми накладными расходами, поскольку сектор 4 Кбайт целиком считывается в память, модифицируется и затем записывается

обратно. Так как происходит определенная степень манипулирования, имеется также мияние на производительность, которое в данном случае вполне приемлемо.

Благодаря встроенной поддержке секторов 4 Кбайт, индустрия хранения данных

больше не эмулирует 5 12-байтовые секторы, а это значит, что влияние на производительность устранено.

В следующем списке перечислены некоторые приложения и сценарии, которые

становятся доступными при поддержке секторов 4 Кбайт:

• возможность установки Windows на диск с секторами 4 Кбайт и загрузки с него

без необходимости в эмуляции (собственный диск 4 Кбайт);

• ноuый файловый формат VHDX;

• полная поддержка Hyper-V;

• резервное копирование Windows;

• полная поддержка со стороны файловой системы New Technology File System

(NTFS);

• полная поддержка со стороны новой файловой системы ReFS (Resilient File

System — отказоустойчивая файловая система);

• полная поддержка со стороны Storage Spaces;

• полная поддержка со стороны средства Windows Defender (Защитник Windows);

• поддержка входящих приложений.

Поддержка UEFI BIOS позволяет работать с дисками GPT

Главные загрузочные записи (masteг boot гecord — MBR) — это спеuиальные об

ласти, расположенные в начале разделенного пространства на диске. Они содержат информацию о внутренней структуре разделов и связанный загрузочный код, который позволяет операционной системе запуститься. Запись MBR хранит свой адрес блока в 32-битном формате. Первоначально диск с 5 12-байтовыми секторами и адресом блока в 32 бита был ограничен объемом 2 Тбайт. Вполне очевидно, что это больше не является приемлемым. Таким образом, индустрия двигается в сторону секторов 4 Кбайт, и теперь диски обладают максимальной емкостью 16 Тбайт. Все выглядит так, как будто мы достигли цели, но с учетом современной инфраструктуры мы можем иметь дело с петабайтами данных, поэтому терабайты вряд ли справятся с этим.

Таблица разделов GUID (GUID Partition ТаЫе — GPT) предоставляет 64-битную

структуру адресаuии. На диске с 512-байтовыми секторами можно иметь 9,4 Збайт

(9 444 732 965 739 290 426 880) данных. В настоящее время GPT поддерживает максимальный размер диска и раздела, равный 8 Збайт.

Если вы приготовились преобразовать свои диски в GРТ, то вы совершенно пра

вы! Но будьте осторожны; не все операционные системы поддерживают загрузку из разделов GPT, используя стандартную систему BIOS. Ознакомьтесь с материалом по следующей ссьтке:

http : / / ru . wi kipedia . org/wiki /Taблицa_paздeлoв_GUID

Унифицированный расширяемый интерфейс прошивки (Unified ExtensiЬle Firmware

lnterface — UEFI) спроектирован как прямая замена унаследованной системы BIOS.

По существу он делает ту же самую работу, но добавляет такую функuиональность, как диагностика и восстановление компьютеров с развернутыми операционными системами. Интерфейс UEFI разработан для поддержки загрузки из разделов GPT, и Windows SeIVer 2012 R2 полностью поддерживает UEFI BIOS.

Утилита снКDsк стала более интеллектуальной

На протяжении многих лет утилита снкоsк была одним из главных инструмен

тов. Она входила в состав многочисленных поколений DOS и Windows, и замеча

тельно видеть этот инструмент модернизированным.

Одной из крупнейших проблем, с которыми сталкивалась утилита снкоsк до ее

модернизации, была ее прямая связь с количеством файлов внутри тома.

Большее число файлов требовало большего времени на ее выполнение. Еще одна причинявшая постоянное беспокойство сложность заключалась в том, что когда снкоsк обнаруживала проблему, она обычно размонтировала том, повторно все сканировала, обнаруживала проблему снова и только затем ее исправляла. Несложно представить, что на крупных томах это занимало длительное время, а при современной культуре постоянной готовности простой попросту неприемлем.

Код инструмента CHKDSK был модернизирован, и модель работоспособности

NTFS также была перепроектирована. Мы обсудим эти модернизации далее, но

они, в сущности, бьuш обусловлены тем, что утилита снкоsк с прежними возмож

ностями больше не была нужна.

онлайновое самолечение

Хотя эта возможность файловой системы NTFS существовала со времен Windows

Vista, количество проблем, которые она способна обнаружить и исправить, зна

чительно увеличилось. В свою очередь, это снизило фактическую потребность в

снкоsк, поскольку большинство проблем удавалось решить с помощью онлайново

го самолечения. Поддерживая самолечение, том не обязан переходить в отключенное состояние.

Онлайновая верификация

В Windows Server 201 2 действительное повреждение можно подтвердить. Иногда

ошибки возникают из-за проблем с памятью, но это не обязательно означает повреждение диска. Теперь, благодаря онлайновой верификации, вы можете акти

визировать проверку. Для выполнения этой проверки драйвер файловой системы

запускает новую службу под названием Spot Yerifieг (Точечный верификатор), как показано на рис. 12.2. Она функционирует в фоновом режиме и не оказывает влияния на производительность системы.

Онлайновая идентификация и ведение журналов

После обнаружения реальной проблемы запускается онлайновое сканирование

файловой системы. Это сканирование рассчитано на выполнение в сочетании с

операционной системой и будет запускаться только во время простоя системы или в период ее низкой загрузки. Найденная проблема фиксируется в журнале для последующего автономного исправления.

точное и быстрое исправление

Поскольку в журнале была зафиксирована информация о местах возникнове

ния проблем, вам не придется заново сканировать всю файловую систему в начале автономного процесса. По существу это означает, что когда вы переведете том в автономный режим для исправления ошибок, такой процесс займет секунды, а не потенциально часы. Быстрое исправление называется Spotfix.

Если вы применяете общие тома кластера (Custer Shared Volume — CSV), никакого простоя не будет, и тома оказываются постоянно готовыми.

Благодаря этим новым усовершенствованиям, исполняющая среда CHKDSK

больше не зависит от количества файлов, а только от числа повреждений данных.

Учитывая возможность исправления настолько многих проблем в онлайновом режиме (при постоянно онлайновом томе CSV), утилита снкоsк становится менее

востребованной. На рис. 12.3 показаны новые опции, которые доступны в снкоsк.

Рис. 12.З. Новые олции CHKDSK

Новыми опциями являются /scan, / forceofflinefix, /perf, /spotfix,

/sdcleanup и /offlinescanandfix. Как видите, они напрямую относятся к опи

санной ранее новой модели работоспособности.

В этот момент мы должны подчеркнуть, что еще одной целью модернизации

снкоsк была необходимость сделать так, чтобы пользователи оставались инфор

мированными о любом повреждении.

Частично причина заключалась в том, чтобы прекратить интенсивные запуски снкоsк для верификации файловой системы со стороны пользователей и администраторов; теперь в этом просто нет нужды.

Система использует центр действий (Action Center), включенный в Windows, чтобы уведомлять пользователя или администратора о разрушении данных в файловойсистеме и рекомендовать какое-то действие. На рис. 12.4 представлены результаты примера онлайнового сканирования.

Пространства хранения в Windows Server 2012 R2

Концепция пространств хранения (Storage Spaces) в Windows Server 201 2 R2 по

существу совпадает с той, которая была воплощена в Windows Server 2012 и обсуждалась в начале этой главы. Исключениями являются упомянутые ранее новые средства, которые сейчас будут рассмотрены более подробно.

повторное использование технологии из облачных служб Microsoft

В Microsoft запускают множество облачных служб. Наверняка вы слышали о

Windows Azure или Office 365. Представьте себе все уроки, которые в Microsoft извлекли во время развертывания, настройки и выполнения ежедневных операций в этих средах.

Также подумайте о том, что если бы Microsoft пришлось приобрести многомиллионные сети хранения, чтобы справиться с постоянно растущей потребностью в наличии хранилища в облачных средах, то насколько они были бы урезанными в контексте облачной среды.

Все накопленные знания разработчики из Microsoft применяют к выпускаемым

новым технологиям, в том числе и к Storage Spaces. Они нуждались в рентабельном способе увеличения хранилища и поддержке основных возможностей, присущих сетям хранения данных, вот почему и появилась технология Storage Spaces. По мере развития облачных служб вы будете наблюдать улучшения в Storage Spaces наподобие тех, что вы видели между выпусками Windows Server 2012 и Windows Server 2012 R2.

Предоставление SАN-подобных возможностей

посредством инструментов управления Microsoft

Одной из по-настоящему интересных особенностей технологий компании

Microsoft является знакомый интерфейс, предлагаемый для управления ее программными продуктами. Обычно доступны два варианта: графический пользовательскийинтерфейс и PowerShell.

Применение графического пользовательского интерфейса

Несмотря на то что консоль управления Microsoft (Microsoft Management

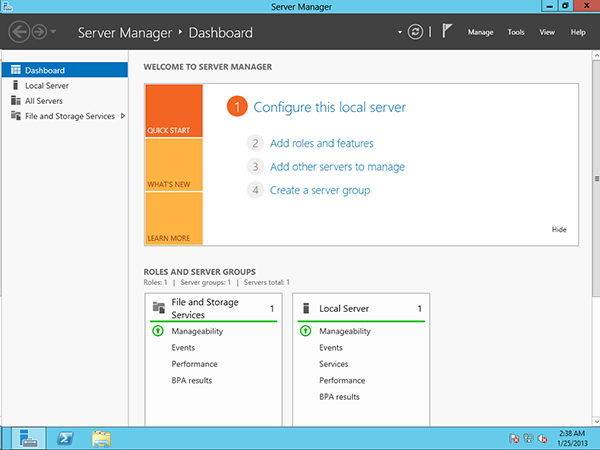

Console — М МС) — традиционная консоль для большинства оснасток управления — по-прежнему существует, большая часть средств внутри Windows Server 2012

R2 управляется через диспетчер серверов (Server Manager), окно которого показано на рис. 1 2.6. Область Storage Pools (Пулы хранения) по умолчанию включена на всех системах и может быть найдена в виде подкомпонента роли

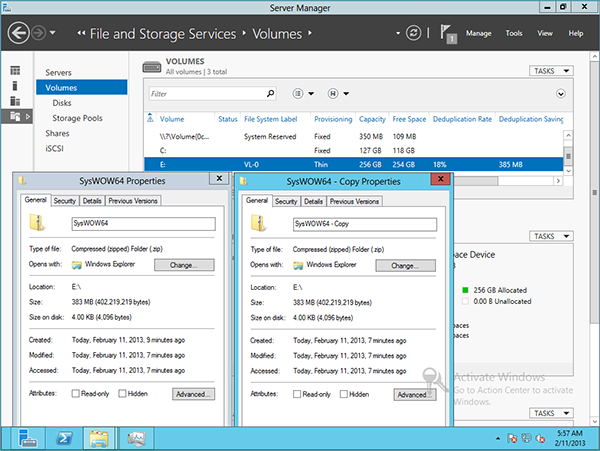

Рис. 12.6. Роль File апd Storage Services в диспетчере серверов

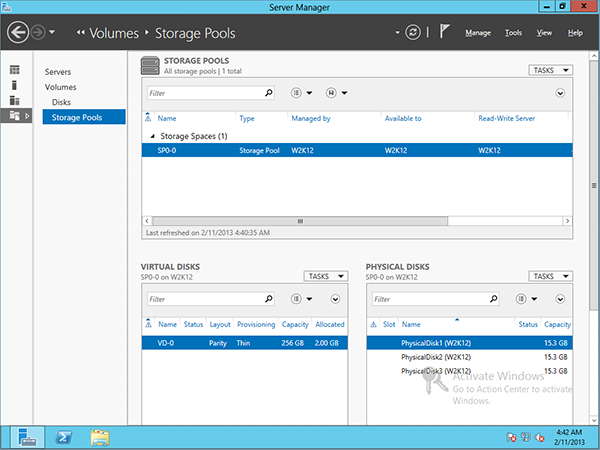

Выбрав элемент меню File апd Storage Services, вы увидите все связанные с ним опции, в том числе и Storage Pools (рис. 12.7). Щелчок на Storage Pools приводит к отображению основной конфигурации (рис. 12.8) .

Рис. 12.В. Конфигурация компонента Storage Pools

Окно с основной конфигурацией делится на три главных области.

• Storage Pools (Пулы хранения). Эта область содержит раздел под названием

Storage Spaces (Пространства хранения), в котором перечислено пространство

Primordial (Первичное). По умолчанию все диски, которые не наз1-1ачены другому пулу, назначаются пулу Primordial. Поработав с пространствами хранения, вы заметите, что пул Primordial перестанет отображаться после того, как все диски окажутся назначенными.

Как видите, пока что другие назначенные или сконфигурированные пулы от

сутствуют. В правом верхнем углу этой области, в раскрывающемся меню Tasks

(Задачи), имеется опция для создания нового пула хранения. Мы этим зай

мемся далее в главе, так что пока не думайте о ней. На пуле Primordia можно

щелкнуть правой кнопкой мыши и просмотреть его свойства.

• Virtual Disks (Виртуальные диски). В области Virtual Disks представлены тома,которые вы будете создавать внутри пула хранения. Вспомните, что это не

файл VHD или VHDX. Внутри пула Primordial создать виртуальный диск не

возможно; сначала должен быть создан пул хранения.

• Physical Disks (Физические диски). Физические диски — это диски, которые

доступны пространствам хранения для назначения пулам хранения. В каждый

момент времени диск может быть назначен только одному пулу.

Если вы щелкнете правой кнопкой мыши на диске в этом списке, то в открывшемся контекстном меню вы получите опцию переключения (включения/выключения) индикатора устройства (переключение индикаторов устройств помогает привыяснении, какие диски работают в массиве физического хранилища); это будет работать, только если используемое хранилище является совместимым сослужбами корпусов SCSI (SCSI Encosure Services — SES). Службы SES также функционируют, когда устройство терпит отказ, и взаимодействуют с компонентом Storage Spaces, чтобы уведомить администратора о том, что произошло.

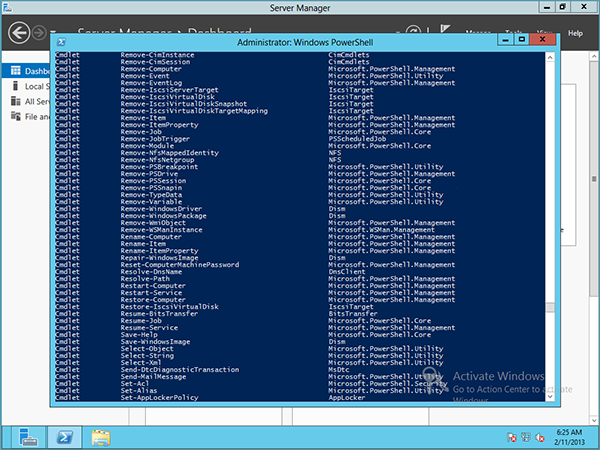

Использование PowerShell

Как уже упоминалось, DЛЯ быстрой настройки Storage Spaces можно применять

команDЛеты PowerShell. Некоторые администраторы при обслуживании серверов

предпочитают работать в среде командной строки. Лично нам нравится смешанный

ПОДХОД.

В Windows Server 201 2 R2 имеется новый модуль PowerShell по имени Storage,

который содержит все команDЛеты PowerShell, необходимые DЛЯ работы с компо

нентом Storage Spaces.

В Wiпdows Server 201 2 и последующих версиях модуль PowerShel автоматичес

ки импортируется, когда вы пытаетесь вызвать команД11ет, который является частью этого модуля. Чтобы просмотреть команД11еты, доступные в модуле Storage, откройте окно PowerShell с повышенными полномочиями и введите get-command

-module Storage. В Windows Server 201 2 R2 доступны 102 команDЛета, правда, не все они относятся к пулу хранения.

К счастью, вы уже знакомы с PowerShel и понимаете его структуру «глагол/су

ществительное». Если вы определяете, какие команDЛеты имеют отношение к тому, что было показано на рис. 1 2.8, это значит, что вы ищете команDЛеты, связанные

с физическими дисками, виртуальными дисками и пулами хранения. Чтобы уп

ростить идентификацию команД11етов DЛЯ каждого аспекта, введите get-command

*StoragePool* l where { $_. modulename -eq «Storage» } и проанализируйте

результат. На рис. 12.9 показан ожидаемый вывод; каждый команDЛет имеет собственный набор опций, которые можно просмотреть с помощью команды get-help имя_ коиандлета .

Рис. 12.9. Командлеты из модуля Storage

Мы не собираемся вдаваться здесь в особые подробности, но продемонстриру

ем вывод из пары команDЛетов. Например, введите get-storagepool и изучите

вывод. Теперь введите get-storagepool 1 fl * и обратите внимание на разницу.

FL — это псевдоним PowerShell DЛЯ Format-List, а опция * определяет, какие

свойства необходимо отобразить, в данном случае — все свойства. Вывод показан на рис. 12.10. Повторите такие же команды DЛЯ команDЛетов get-physicaldisk и

get-virtualdisk и просмотрите их вывод.

Создание пространства хранения

Storages Spaces является исключительно мощным компонентом, и, как упомина

лось ранее, пространства хранения привносят множество преимуществ в организацию. Их также легко конфигурировать. Никакого специализированного обучения DЛЯ этого не требуется.

Рис. 1 2.10. Пример вывода из командлета get-storagepool

На следуюших нескольких страницах мы обсудим процесс создания пространс

тва хранения и покажем, насколько в действительности это легко делается. Общий процесс выглядит следующим образом.

1. Получение свободных физических дисков.

2. Создание пулов хранения.

3. Создание виртуальных дисков.

Мы продемонстрируем создание пула хранения с помощью графического поль

зовательского интерфейса и PowerShell. Однако сначала необходимо кратко представить испытательную среду. Мы имеем одиночный сервер с несколькими физическими дисками, двумя дисками SAS по 100 Гбайт, двумя дисками SAS по 1 50 Гбайт и одним диском SATA объемом 300 Гбайт.

Соэдание пула

При создании пула хранения вы должны решить, какие физические диски назна

чить этому пулу. Важно думать в терминах того, какой пул будет использоваться, и,

с учетом наличия теперь средства многоуровневого хранения, какой тип дисков должен стать частью пула. Чтобы создать пул, выполните перечисленные ниже шаги.

1. Откройте диспетчер серверов и выберите в меню File (Файл) пункт Storage

Services (Службы хранения).

2. Выберите элемент Storage Pools (Пулы хранения).

3. Щелкните правой кнопкой мыши на пуле Primordial и выберите в контекс

тном меню пункт New Storage Pool (Создать пул хранения), как показано на

рис. 12. 1 1 . Откроется мастер создания пула хранения (New Storage Pool Wizard).

Рис. 1 2.1 1 . Создание нового лула хранения 4. Щелкните на кнопке Next (Далее), чтобы пропустить экран приветствия. 655 5. На экране Storage Pool Name (Имя пула хранения), приведенном на рис. 12.12, вы должны назначить пулу хранения имя; в данном случае Test. При желании можно добавить описание. В нижней половине окна вы увидите, что для доступного дискового пула при меняется пул Primordial. Далее потребуется выбрать физические диски в пуле. 6. В этом примере выберите все диски (рис. 12.13). Обратите внимание на возможность выбора дисков АТА и SAS. На рис. 12.14 представлены опции Allocation (Выделение): Automatic (Автоматическое), Hot Spare (Горячая замена) или Manual (Ручное).

Рис. 12.12. Именование пула хранения

Рис. 12.14. Опции выделения дисков

7. В данном примере используется выделение Automatic. Для продолжения

щелкните на кнопке Next.

При выделении дисков вы можете иметь в пуле множество горячих замен, но не

должны смешивать диски, выделяемые вручную и автоматически. Выбор опции

Automatic на этом экране будет автоматически балансировать пул между горячими заменами и полезной емкостью.

Назначив опцию выделения диска, вы не сможете изменить ее с ручного на

автоматическое внутри графического пользовательского интерфейса, но може

те сделать это в PowerShel. На рис. 12. 1 5 показан пример идентификации и

изменения типа выделения диска.

8. Наконец, как и со всеми мастерами, вы получаете шанс пересмотреть выбран

ные опции, прежде чем фиксировать изменение (рис. 12.16). Щелкните на

кнопке Create (Создать), когда будете удовлетворены выбранными вариантами.

Появится экран с индикатором хода работ, на котором после создания пула бу

дет отображено состояние Completed (Завершено), как показано на рис. 12.17.

Поздравляем, вы создали свой первый пул!

Ограничения пулов хранения

Как и со всеми технологиями, пулам хранения присущи некоторые ограничения,

и хотя эта технология является мощной, она, безусловно, не может быть оптимальной абсолютно во всех ситуациях. Имея это в виду, давайте взглянет на ее ограничения.

• Жесткий диск должен иметь объем lO Гбайт или больше.

• В пространстве хранения невозможно развернуть загрузочную систему.

• Любые диски, предназначенные для добавления в пул хранения, не должны

быть разбиты на разделы или сформатированы. Все данные на таких дисках

будут утрачены.

• В случае использования контроля по четности требуются три диска, при двух

стороннем зеркальном отображении — два диска, а при трехстороннем зер

кальном отображении — три и более дисков.

• Все диски в пуле должны иметь одинаковый размер сектора (4 Кбайт/512е или

512). 512е, или 512 Emulatioп (эмуляция 512-байтового сектора), позволяет

производителям выпускать диски с секторами 4 Кбайт и обеспечивать совмес

тимость с программным обеспечением, которое не модернизировано для вос

приятия секторов 4 Кбайт.

• Диски Fibre Channel и iSCSI в пуле хранения не поддерживаются.

+ Все хранилище должно быть совместимо с драйвером storport . sys.

Для проверки этого применяется список совместимости оборудования

Microsoft (Microsoft Hardware Compatibllity List), доступный по следующе

му URL: http : / /www . microsoft . сот/ ru-ru/windows/ compatibil i t у/

compatcenter /home. (Если ваше оборудование находится в этом списке сов

местимости, то оно будет работать с драйвером storport . sys.)

+ Если виртуальный диск должен использоваться в кластере с обходом отказа,

на таком виртуальном диске должна быть развернута файловая система NTFS.

Просмотр устройств в инструменте Disk Management

В сущности, пул хранения представляет собой логический контейнер дпя дисков.

Например, в нашей демонстрационной среде имеется несколько дисков, готовых

для назначения в пул хранения. На экране Disk Management (Управление дисками), показанном на рис. 12. 1 8, можно видеть все перечисленные ранее физические диски до их назначения в пул.

После добавления дисков в пул хранения мы обновляем Disk Managemeпt. Как

видно на рис. 12.19, они перестали отображаться. Диск 1 по-прежнему остался, т.к. он является диском операционной системы, поэтому он должен быть всегда, и вы никогда не будете иметь возможность включить его в пространство хранения. Куда делись диски’? Вспомните, что пул хранения является контейнером. Чтобы снова увидеть тома в Disk Management, понадобится создать nиртуальные диски.

Рис. 1 2. 19. После добавления в пул хранения диски больше не отображаются в Disk Management

Работа с пулом хранения в PowerShell

Ранее мы упоминали, что все задачи, выполняемые в графическом пользователь ском интерфейсе, могут быть сделаны посредством PowerShell. Сейчас мы покажем, как создать пул хранения с применением PowerShell. 1. Сначала необходимо найти доступные диски. Воспользуйтесь командлетом Get-PhysicalDisk для получения списка всех дисков в системе. На рис. 12.20 показан результат для рассматриваемого примера. 2. Взгляните на свойство CanPool. Когда его значение равно True, этот диск мо жет быть помещен в пул хранения. 3. Отфильтруйте физические диски, которые можно помещать в пул, и сохраните результаты в переменной для дальнейшего применения с помощью еле . дующего синтаксиса:

Рис. 12.20. Отображение доступных физических дисков

4. Идентифицируйте подсистему хранения, с которой имеете дело, и снова со

храните результат в переменной, но в этом случае вы заинтересованы только в

свойстве FriendlyName (рис. 12.21).

Используйте приведенный ниже синтаксис для захвата значения свойства

FriendlyName подсистемы хранения:

$storagesystem = (get-storagesubsystem) . friendlyname

Теперь можно создать пул хранения.

Рис. 12.21 . Командлет Get-StorageSubsystem

5. Используйте следующий синтаксис для создания пула:

New-storagepool -friendlyname TestPool -StorageSubSystemFriendlyName

$storagesystem -physicaldisks $drivestopool

Дружественное имя для пула (указываемое в -friendlyname ) может быть лю

бой желаемой строкой. Показанный синтаксис создаст пул по имени TestPool

и добавит в него диски (рис. 12.22).

Рис. 12.22. Вывод в PowerShell при создании нового пула хранения

6. Теперь примените командлет Get-StoragePool для получения более подроб

ной информации о пуле:

Пример вывода можно видеть на рис. 12.23; обратите внимание на объем дета

лей, которые предоставляет PowerShell по сравнению с графическим пользова

тельским интерфейсом.

Выделение пространства пула под виртуальный диск

С самого начала этой главы мы прояснили, что когда ссьшаемся на виртуальный

диск в связи с пространством хранения, то не имеем в виду файл VН ОХ для виртуальной машины. На самом деле, до тех пор, пока вы не поместите виртуальную машину в пространство хранения или не используете ее в качестве целевого хранилища iSCSI, вы нигде не увидите файла VHD.

Рис. 1 2.23. Вывод из командлета Get-StoragePool

Виртуальные диски — это диски, которые выделяются из пула хранения. Ранее

мы созданали пул для физических дисков и показали, что с точки зрения инструмента Disk Management все диски исчезали, поскольку они стали принадлежать пулухранения. Для того чтобы использовать какое-то пространство, содержащееся внутри пула хранения, вы должны создать виртуальный диск. Он не связан напрямую с физическим диском в пуле хранения, но является представителем порции пространства, выделяемого из пула хранения. То, каким образом эта порция обретает существование, зависит опций, которые мы обсудим далее.

Одной из замечательных характеристик виртуализации в целом является возможность максимизации использования оборудования. Например, ранее многие организации имели по одному серверу на роль, что было расточительством, но теперь на одном сервере можно удерживать несколько ролей, которые полностью изолированы друг от друга. Надеемся, что на этом этапе вы уже знакомы с виртуализацией.

Похожая концепция существует в пулах хранения и виртуальных дисках.

Как было указано, пулы хранения — это по существу логические контейнеры для набора физических дисков, которые вы хотите объединить. Виртуальные диски будут представлены серверу для применения в качестве тома. При наличии трех физических дисков по 500 Гбайт, скомбинированных в пул хранения, имеется потенциально 1 ,5 Тбайт пространства (рис. 12.24).

Довольно неплохо. (Мы пока не принимаем во внимание избыточность, т.к. это будет объясняться позже.)

Теперь системный администратор получает запрос от бригады, занимающейся новым приложением, которым Пул хранения

Рис. 12.24. Выделениепула хранения

требуется 2 Тбайт пространства. Тем не менее, когда системный администратор пересматривает прогнозируемый рост, он понимает, что 2 Тбайт не нужны авансом, что хорошо, поскольку в бюджете не предусмотрены расходы на приобретение дополнительных дисков. Знакомая история? Вопрос в том, как разрешить проблему.

Одним из первых выборов, которые вы делаете при создании виртуальных дис

ков, касается типа настройки — фиксированной или тонкой.

• Fixed provisioning (Фиксированная настройка). При фиксированной настрой

ке, если вы запрашиваете 2 Тбайт, то для настройки должно быть доступно

2 Тбайт емкости.

• Thin provisioning (Тонкая настройка). Диски с тонкой настройкой использу

ют только то, что нужно в данный момент. Это замечательно! В предыдущем

примере бригада, занимающаяся приложением, считает, что у них есть запро

шенная емкость 2 Тбайт, но в действительности задействовано только доля от

2 Тбайт (рис. 12.25).

Фиксированная настройка

Е м кость 1 Тбайт

Требуется 1 Тбайт

Используется 1 Тбайт

Тонкая настройка

Е мкость 1 Тбайт

Требуется 1 Тбайт

Используется 200 Гбайт

Рис. 1 2.25. Диски с фиксированной или тонкой настройкой

УПРАВЛЕНИЕ ДИСКАМИ С ТОНКОЙ НАСТРОЙКОЙ

Диски с тонкой настройкой могут приводить к невосполнимому распределению ре

сурсов и должны управляться. Понадобится создать оповещения, чтобы обеспечить

мониторинг свободного пространства, остающегося в пуле и на виртуальном дис

ке. Меньше всего хотелось бы получить перебой в работе из-за перегрузки ресурсов.

При корректном применении диски с тонкой настройкой могут помочь системным

администраторам уменьшить стоимость хранения, но по-прежнему удовлетворять

нуждам потребителей.

Определение компоновки диска

Далее необходимо принять решение относительно компоновки виртуального

диска. Доступны три вида компоновки с разной отказоустойчивостью.

• Simple (Простая). При такой компоновке данные разделяются на полосы по

всем дискам в пуле. Эта компоновка не является отказоустойчивой. В случае

сбоя диска все данные теряются.

ХРАНИЛИЩЕ WINDOWS 2012 R2 663

• Mirror (Зеркальное отображение). Зеркальное отображение данных дублирует их

на разных дисках; это дает максимальную отказоустойчивость, но оказывает

значительное влияние на объем пространства, которое потенциально может ис

пользоваться. Чтобы защититься от одиночного дискового отказа, понадобится

иметь в пуле хранения, по меньшей мере, два физических диска; для обработки

двух дисковых отказов физических дисков должно быть минимум пять.

• Parity (Контроль по четности). Контроль по четности по существу записыва

ет данные в полосы на всех дисках, но также производит запись информации

о четности, что позволяет восстанавливать данные в случае отказа диска. Это

обеспечивает великолепную отказоустойчивость и производительность. Для

обработки одиночного дискового отказа понадобится, по меньшей мере, три

физических диска.

На рис. 12.26 показано визуальное представление различных компоновок, до

ступных для применения. Части, помеченные как «Полоса данных (простая компо

новка)», говорят о том, что данные записываются по всем дискам. В случае частей,

помеченных как «Зеркало», если данные записываются на один диск в 4-дисковом

зеркале, то они будут записываться также и на второй диск. Наконец, в частях, ко

торые помечены как «Контроль данных по четности», данные записываются по

всем дискам и сопровождаются информацией о четности, что позволит проводить

восстановление при отказе.

——- —

Контроль данных по четности

Рис. 1 2.26. Компоновки виртуальных дисков

Создание виртуального диска в графическом пользовательском интерфейсе

Следующий шаг заключается в создании виртуального диска. Все виртуальные

диски проще всего создавать внутри консоли Storage Pools (Пулы хранения) диспет

чера серверов (рис. 12.27).

1 . В области Virtual Disks (Виртуальные диски), находящейся в левой нижней

части окна консоли, выберите в раскрывающемся меню Tasks (Задачи) пункт

New Virtual Disk (Создать виртуальный диск), как показано на рис. 12.28.

2. Щелкните на кнопке Next (Далее) на экране приветствия мастера создания

виртуального диска (New Virtual Disk Wizard).

Как показано на рис. 12.29, вы должны выбрать пул хранения, в котором не

обходимо создать виртуальный диск. В рассматриваемом примере мы собира

емся использовать пул TestPool.

3. Выберите пул хранения и щелкните на кнопке Next.

Виртуальному диску понадобится назначить имя. Можно также ввести описа

ние, для чего предназначен этот виртуальный диск.

4. В данном примере мы назвали диск File _ Vdisk, как показано на рис. 12.30, и

указали в описании, что он применяется для файлового хранилища.

Следующий шаг связан с выбором компоновки хранения (рис. 12.31). Доступ

ны три варианта: Simple (Простая), Mirror (Зеркальное отображение) и Parity

(Контроль по четности).

Рис. 12.30. Ввод имени и описания для виртуального диска

5. Для этого примера выберите Simple и щелкните на кнопке Next.

665

Теперь необходимо выбрать тип настройки. Как показано на рис. 12.32, до

ступны два варианта: Thin (Тонкая) и Fixed (Фиксированная).

6. Для рассматриваемого примера выберите тип настройки Thin, т.к. требуется

максимизировать пространство в пуле хранения.

Сейчас нужно принять решение относительно размера виртуального диска.

Поскольку для него выбрана тонкая настройка, теоретически можно ввести

любое значение.

Рис. 1 2.32. Выбор типа настройки для виртуального диска

7. Пул хранения имеет емкость около 400 Гбайт, поэтому м ы назначим вирту

альному диску 500 Гбайт (рис. 12.33). Для продолжения щелкните на кнопке

Next.

8. Наконец, просмотрите произведенный выбор и подтвердите его, щелкнув на

кнопке Create (Создать).

9. Просмотрите информацию на экране Results (Результаты) и удостоверьтесь,

что все завершено (рис. 12.34). Щелкните на кнопке Close (Закрыть), чтобы

закрыть окно мастера.

Рис. 1 2.33. Установка размера виртуального диска

Рис. 1 2.34. Экран Results мастера после создания нового виртуального диска

Дополнительное УПРАЖНЕНИЕ

Загляняте сейчас в инструмент Disk Management, и вы увидите, что неожиданно появилось!

Создание виртуального диска в PowerShell

Первым делом, давайте воспользуемся PowerShell для просмотра виртуального

диска, который был создан в предыдущем примере с применением графического

пользовательского интерфейса.

На рис. 12.35 демонстрируется применение команмета Get-VirtualDisk мя

измечения всей информации о созданных виртуальных дисках. Как видите, был создан только один виртуальный диск емкостью 500 Гбайт.

Рис. 1 2.35. Вывод из командлета Get-VirtualDisk

Чтобы создать новый виртуальный диск, необходимо воспользоваться команд

летом New-VirtualDisk. Но прежде чем делать это, вы должны узнать дружест

венное имя пула хранения. Помните ли вы команду мя получения дружественного имени пула хранения?

Имея дружественное имя, выполните следующие шаги.

l . С помощью показанного ниже синтаксиса сохраните дружественное имя пула

хранения в переменной:

$sp = (get-storagepool) . friendlynarne

Следующий шаг заключается в создании виртуального диска, но сначала

взгляните на полный синтаксис команды:

New-VirtualDisk -StoragePoolFriendlyNarne $sp [l]

-ResiliencySettingNarne Sirnple -Size 500GB -FriendlyNarne TestVdisk

-ProvisioningType Thin -NurnberofDataCopies 1 -NurnЬerofColumns 2

Как видите, на выбор доступно несколько больше опций. Далее приведены их

краткие описания.

• ResiliencySettingName. Эквивалент опций компоновки хранения Simple,

Mirror, Pari ty.

• NumЬerofDataCopies. Количество копий данных, которые необходимо

хранить; эта опция напрямую связана с ResiliencySettingName. Если вы

выбрали Simple, например, то NumЬerofDatacopies может быть только 1.

В случае выбора Mirror значением NumЬerofDataCopies будет как минимум

2, в зависимости от объема дискового пространства, имеющегося в системе.

• NumЬerofColumns. Прямо связано с количеством дисков, которые вы хо

тите использовать. Пул хранения может иметь сотни дисков, но вам может

требоваться разделение на полосы, зеркальное отображение или приме

нение контроля по четности, скажем, только мя пяти дисков. Эта опция

позволяет сделать выбор. Она также связана с ResiliencySettingName и

NumЬerofDa taCopies.

Значения, установленные дЛЯ NumЬerofDataCopies и NumЬerofColumns, от

носятся к выбранным опциям. Например, если необходимо зеркально отобра

зить данные, мы увеличиваем значение NumЬerofDataCopies, и если требует

ся охватить виртуальным диском несколько физических дисков, то мы увели

чиваем NumЬerofColumns. В этом случае нужна только одна копия данных и

запись данных на два диска.

2. С помощью опции $ sp [ 1] мы выбираем один элемент из всех пулов хранения,

захваченных командой get-storagepool. Например, при наличии пяти пулов

хранения команда get-storagepool возвратит все пять, поэтому $sp [ 1 ] поз

воляет выбрать пул хранения с номером 2 из пяти захваченных. Счетчик начи

нается с О, так что первый пул хранения можно извлечь как $ sp [ О J .

В испытательной среде определено несколько пулов хранения. Если просто

указать $sp, команда сообщит об ошибке, поскольку она попытается вставить

(в этом случае) дружественные имена двух пулов хранения.

На рис. 12.36 демонстрируется пример запуска только что разобранной команды.

Рис. 12.37. Пользовательский интерфейс Storage Spaces с созданным

ранее виртуальным диском

Рис. 12.38. Соэдание нового тома из виртуального диска

Рис. 12.39. Выбор сервера и виртуального диска

4. В этом примере мы оставляем стандартный размер 500 Гбайт с тонкой на

стройкой (рис. 12.40).

Далее, как вы поступили бы с нормальным диском, выберите букву диска или

папку, в которой необходимо смонтировать том.

7. В поле Volume Label (Метка тома) введите Test _ Volume и щелкните на кнопке

Next.

8. Подтвердите выбранные опции и щелкните на кнопке Create (Создать).

9. На экране Results (Результаты), показанном на рис. 12.43, удостоверьтесь в

том, что все задачи имеют состояние Completed (Завершена), и щелкните на

кнопке Close (Закрыть).

1 О. Откройте проводник Windows и обратите внимание на появление нового тома

Рис. 1 2.45, Вывод командлета get-disk

3. Для перевода их в онлайновое состояние вы будете применять командлет

set-disk.

4. Чтобы перевести все диски в онлайновое состояние за один раз, используя

предыдущий синтаксис с фильтрацией отключенных дисков, вывод можно на

править по конвейеру командлету set-disk.

Ниже показан синтаксис, а на рис. 12.46 — результаты выполнения:

Get-disk l where { $ . operationalstatus -eq «Offline» } l set-disk

-isoffline $false

Рис. 12.46. Перевод всех дисков в онлайновое состояние с помощью PowerShell

демонстрация настройки многоуровневого хранения с помощью PowerShell

Мы рассмотрели создание пула хранения, виртуального диска и томов для использования в среде.

В начале главы упоминалось об уровнях хранения. Они могут предоставить огромные преимущества среде, поскольку позволяют разделять хранилище и обеспечивать возврат платежей на основе ресурсов, которые требуются конечным пользователям.

По сути дела, если конечные пользователи требуют высокоскоростного хранилища, вы можете выделить его и выставлять соответствующие счета на оплату;

в противном случае вы можете выделить для обслуживания их потребностей хранилище низкого уровня. Если ваша компания делает возврат платежей, то это пойдет на пользу всем конечным пользователям, т.к. пространства хранения будут автоматически перемещать данные с более частым доступом, на быстрый уровень хранения, а данные, к которым обращаются редко — на медленный уровень хранения.

Поскольку вы уже знакомы с консолью Storage Spaces (Пространства хранения),

вы заметите, что внутри пользовательского интерфейса отсутствует место для конфигурирования пулов хранения. Это средство может быть сконфигурировано только через PowerShell.

Мы уже создали пул хранения по имени TestPool, так что давайте применять

его в качестве дружественного имени.

Как уже говорилось, в Windows Server 2012 R2 можно создавать только два уровня хранения. Система распознает носители двух типов — твердотельный накопитель

(Soid State Drive — SSD) и жесткий диск (Hard Disk Drive — HDD).

Запустив в испытательной среде командлет PowerShell под названием get

physicaldisk, мы получим вывод, показанный на рис. 12.47.

Рис. 1 2.47. Пример вывода командлета get-physicaldisk при создании уровней

хранения

Создание пулов SSD и HDD

Вы видите, что в среде присутствуют устройства SSD и H DD. А теперь мы со

здадим уровни хранения. В рассматриваемом примере мы собираемся создать два

уровня (что также является максимальным поддерживаемым количеством) и затем

создадим виртуальный диск, который будет вьщелен по уровням. Далее мы разобьем диск на разделы и сформатируем.

Ниже показан синтаксис использования командлета New-StorageTier для со

здания пула SSD. Мы должны сохранить его в переменной для дальнейшего применения:

$ssdtier = new-storagetier -StoragePoolFriendlyNarne «TestPool»

-FriendlyNarne SSD_Tier -Mediatype SSD

Для создания уровня Н Н D используется следующий синтаксис:

$hddtier = new-storagetier -StoragePoolFriendlyNarne «TestPool»

-FriendlyNarne HDD_Tier -Mediatype HDD

Далее потребуется добавить виртуальный диск и привязать его к уровням хра

нения. Предугадывая вопрос, можно ли переназначить существующий виртуальный

диск уровню хранения, ответим — нет, нельзя.

Имея это в виду, мы создадим новый виртуальный диск, который будет привязан

к нашим уровням хранения. Вот какой синтаксис применяется:

New-VirtualDisk -StoragePoolFriendlyNarne TestPool -FriendlyNarne

Tiered_VDisk -StorageTiers @ ($ssdtier, $hddtier) -StorageTierSizes

@ (lOGB, SOGB) -ResiliencySettingNarne Sirnple

На рис. 12.48 показан вывод после успешного создания диска.

Рис. 12.48. Вывод после успешного создания диска внутри уровней хранения

Большинство опций должны выглядеть знакомыми по созданию виртуального

диска ранее в главе. Тем не менее, есть две опции, которые связаны с созданием виртуального диска внутри уровня хранения.

• StorageTiers @ ($ssdtier, $hddtier) . Указывает используемые уровни. Это

не хеш-таблица, так что будьте внимательны и не применяйте фигурные скобки.

Мы сохранили уровни в отдельных переменных для простоты ссылки на них.

• StorageTierSizes @ (lOGВ, SOGВ) . Указывает размер каждого уровня и ссы

лается в порядке, установленном в опции -StorageTier. Как вы заметили на

рис. 12.48, общий размер составляет 60 Гбайт, т.е. 10 Гбайт + 50 Гбайт.

Отсюда вам необходимо создать том, как это делалось ранее для хранения дан

ных. Мы покажем быстрый трюк в PowerShell, которым можно воспользоваться

для создания на диске тома 20 Гбайт и его форматирования в единственной строке.

Ниже приведен синтаксис:

Get-VirtualDisk 1 Get-Disk 1 New-Partition -Size 20GB

-AssignDriveLetter 1 Format-Volume -Force -confirm:$false

Вывод команды представлен на рис. 12.49. Теперь вы можете перейти на диск по

его букве и скопировать файл.

Рис. 1 2.49. Соэдание нового раздела и его форматирование в PowerShell

Выделите время на просмотр свойств только что созданного виртуального диска.

На рис. 12.50 обратите внимание, каким образом разделилась емкость из-за того,

что мы разнесли этот виртуальный диск по двум уровням .

Использование кеша с обратной записью

А теперь мы покажем, как использовать одно из последних крупных средств тех

нологии Storage Spaces в Windows Server 2012 R2 — кеша с обратной записью. Как и

с уровнями хранения, ero не получится включить через графический пользователь

ский интерфейс; это должно делаться в PowerShell. Вспомните, кеш с обратной за

писью может поспособствовать в ускорении работы приложений, т.к. запись в кеш

является быстрой и не требует ожидания, пока хранилище зафиксирует запись.

Возьмите команду PowerShell, которая применялась для построения предыдущего

уровня хранения, и модифицируйте имя и опции StorageTierSizes. Затем добавь

те опцию -WriteCacheSize с настройкой размера; в данном случае необходим раз

мер кеша с обратной записью, равный 2 Гбайт:

New-VirtualDisk -StoragePoolFriendlyName TestPooll -FriendlyName

Tiered _ VDisk -StorageTiers @ ($ssdtier, $hddtier) -StorageTierSizes @

(20GB, 70GB) -ResiliencySettingName Simple -WriteCacheSize 2GB

Итак, вы создали виртуальный диск, который будет использовать уровни хране

ния и имеет включенный кеш с обратной записью.

Оптимизация уровней хранения

Последний аспект, который мы обсуждали об уровнях хранения в начале этой

главы, заключается в том, что каЖдую ночь в 1:00 запускается задание, повторно назначающее приоритеты хранилищу и перемещающее данные на быстрый уровень вместо медленного.

В планировщике задач выберите папку Task Scheduler LibraryMicrosoftWindows

Storage Tiers Management (Библиотека планировщика задач Microsoft Windows

Управление уровнями хранения). Планировщик задач отображает задачу под на

званием Storage Tiers Optimization (Оптимизация уровней хранения), показанный на

рис. 12.51. При необходимости вы можете изменить задачу или запустить ее вручную.

Рис. 1 2.51 . Задача Storage Tiers Optimization

iSCSI в пространствах имен

Лространства имен чрезвычайно полезны для обеспечения масштабируемого и

надежного хранилища. Подумайте о сумме, которую компании пришrюсь бы вло

жить для получения уже обрисованных возможностей. Что было бы действительно

полезно сейчас — это объединение всей мощной технологии хранения с iSCSI, что

бы позволить удаленным системам (таким как файловые серверы, почтовые систе

мы, кластеры виртуализации и т.п.) также получить выигрыш от этих средств.

iSCSI требует конфигурирования нескольких элементов, чтобы они предоставля

ли удаленным машинам номера логических устройств (logical unit numЬer — LUN).

Для начала мы объясним несколько элементов, образующих iSCSI с точки зрения

хает-сервера и удаленного сервера, которые необходимо знать, чтобы понять рассматриваемый далее пример.

• Целевой сервер iSCSI. Лозволяет инициаторам iSCSI создавать подключение к

целевой службе, в свою очередь, предстамяющей диск VHD, который распо

ложен на томе uелевоrо сервера. Для операционной системы целевого сервера

это выглядит как файл VНD. Вы можете сконфигурировать контроль доступа,

чтобы соответствующим образом защитить диск.

• Виртуальный диск iSCSI. Виртуальный диск iSCSI в этом случае является дейс

твительным диском VHD, когда просматривается на целевом сервере, но с

точки зрения клиента или инициатора он выглядит как диск, который может

быть переведен в онлайновое или отключенное состояние и имеет созданные

на нем тома.

• Инициатор iSCSI. Инициатор — это клиентское программное обеспечение,

применяемое для подключения к целевому серверу и доступа к каким угодно

виртуальным дискам iSCSI, которые бьши предстамены и к которым автори

зован доступ.

В наши дни эта технология является обычным явлением в большинстве компа

ний, и она позволяет создавать кластеры для бизнес-потребностей всех видов. Ранее нам приходилось использовать сервер Windows с целевым сервером iSCSI для создания кластера Hyper-V, предназначенного для функционирования в производственной сети. В следующем разделе мы разберем пример настройки целевой службы iSCSI, создания виртуального диска и его представления удаленной системе.

добавление целевой службы iSCSI

По умолчанию целевая служба iSCSI не включена. Вы должны добавить ее с по

мощью PowerShell. Синтаксис для добавления компонента Windows под названием

iSCSI Target Seiver выглядит так:

Add-windows feature fS-iSCS ITarget-Server -IncludeManagementTools

После добавления компонента серверу может потребоваться перезагрузка, поэто

му удостоверьтесь в том, что имеете возможность завершить установку.

Компонент iSCSI Target Seiver является частью роли File and Storage Services, а это :значит, что его можно администрировать в консоли диспетчера серверов под улом File and Storage Services, как показано на рис. 12.52.

Рис. 12. 52. Управление целевым сервером iSCSI

Создание виртуального диска iSCSt

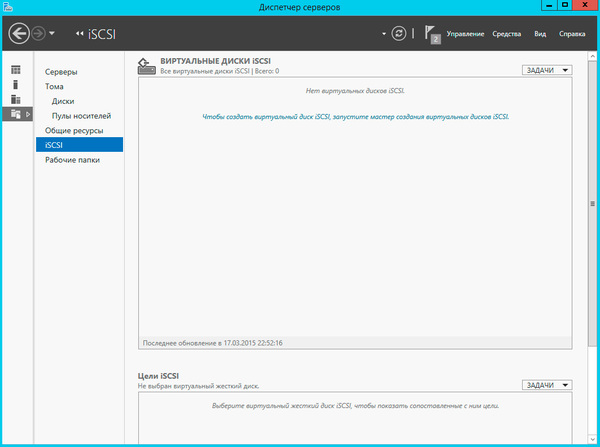

На рис. 1 2.52 видно, что есть две основных области: iSCSI Virtual Disks (Виртуальные диски iSCSI) и iSCSI Targets (Цели iSCSI). Как уже упоминалось, цель будет представлять виртуальные диски iSCSI, которые были созданы. (Не путайте их с виртуальными дисками в пространствах хранения. Они отличаются; виртуальные диски iSCSI на целевом сервере выглядят как файлы VHD.)

Чтобы продемонстрировать это, давайте создадим виртуальный диск iSCSI. В на

шем примере мы будем использовать диск Е, созданный ранее из многоуровневого

пула хранения. Не беспокойтесь, если вы его не настроили; все, что вам необходимо — это диск и папка для сохранения файла YHD, который будет создан.

1 . В центре области iSCSI Virtual Disks (Виртуальные диски iSCSI), показанной

на рис. 12.52, щелкните на ссылке То create an iSCSI virtual disk, start the New

iSCSI Virtual Disk Wizard (Чтобы создать виртуальный диск iSCSI, запустите

мастер создания виртуального диска iSCSI (New iSCSI Yirtual Disk Wizard)).

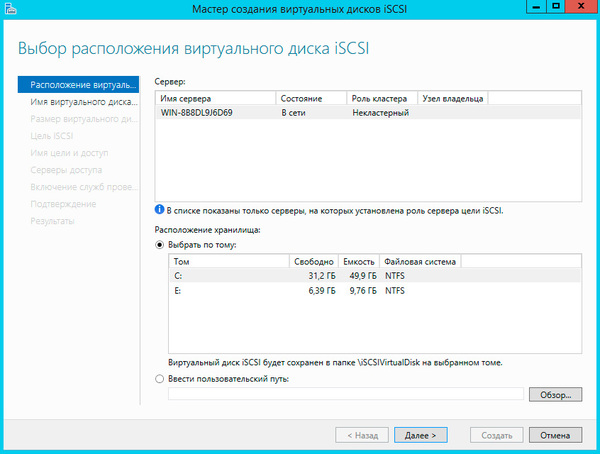

2. Выберите целевой сервер в списке Server (Сервер) и том, где должен хранить

ся виртуальный диск iSCSI. В данном примере диском будет Е : (рис. 12.53).

3. Предоставьте виртуальному диску iSCSI описательное имя; например, если он

предназначен для кластера Hyper-V, введите VМCluster_Vdisk. Обратите вни

мание на путь, отображающийся на экране iSCSI Virtual Disk Name (Имя вир

туального диска iSCSI), который показан на рис. 12.54.

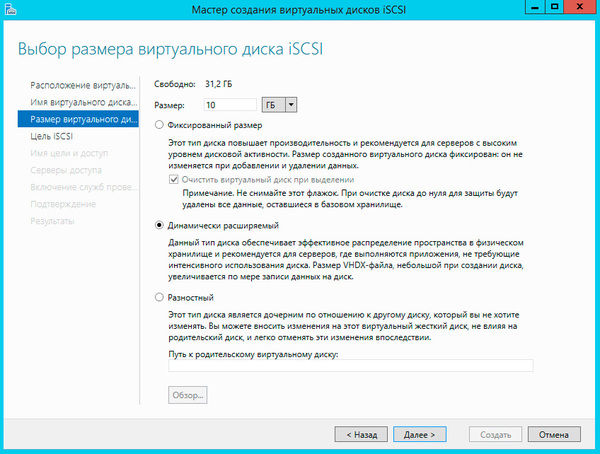

4. Укажите размер виртуального диска; в настоящем примере введите 50 GВ.

Обратите внимание на опции; можно выбрать настройку всего пространства

за один раз (Fixed (Фиксированный)), настройку динамически расширяемого

диска ( Dynamically Expanding (Динамическое расширение)) или применение

разностного диска ( Differencing (Разностный)). Если вы имели дело с Hyper-Y,

то опции должны быть вам хорошо знакомы.

5. В данном случае выберите Dynamically Expanding.

Полезно отметить, что вы должны соблюдать крайнюю осторожность, выбирая между опциями Fixed, Dynamically Expanding и Differencing. Выбор неподходящего типа диска окажет значительное влияние на производительность. В качестве эмпирического правила, если вы не уверены и не знаете тип рабочей нагрузки, который в конечном итоге будет использовать этот диск, выбирайте вариант Fixed.

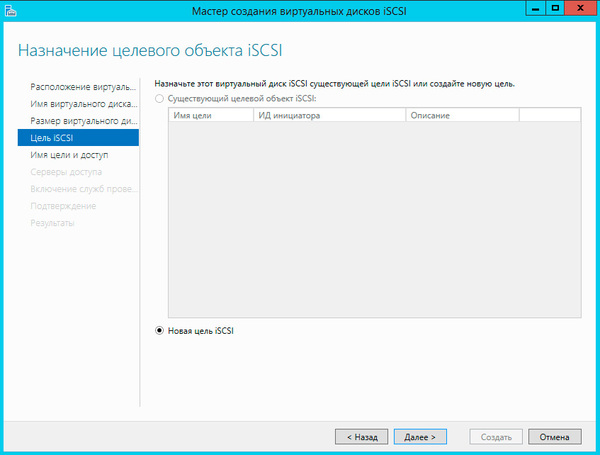

6. Поскольку это новый сервер и пока что целевые серверы iSCSI отсутствуют,

вы должны выбрать переключатель New iSCSI target (Новая цель iSCSI), как

показано на рис. 12.55.

7. Укажите имя для цели iSCSI; в этом примере введите VМCluster_Target

(рис. 12.56). Далее понадобится сконфигурировать доступ к созданному вир

туальному диску iSCSI. Вы можете авторизовать специфичные инициаторы на

основе их имен IQN или DNS, IР-адресов или МАС-адресов.

IQN (iSCSI qualified name — определенное имя iSCSI) является автоматичес

ки сгенерированным именем. В серверах Microsoft оно всегда имеет формат

iqn . 1991-0 6 . com.microsoft :имя_cepвepa.

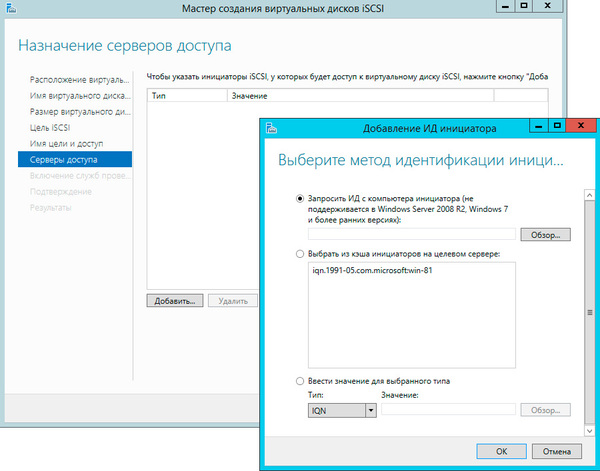

8. На экране Access Servers (Серверы доступа) мастера щелкните на кнопке Add

(Добавить). Откроется диалоговое окно Add initiator ID (Добавление идентифи

катора инициатора), представленное на рис. 12.57.

Если вы знакомы с технологией iSCSI, то заметите новую опцию дЛЯ Win

dows Server 2012 и последующих версий. Когда определенное имя инициато

ра iSCSI не известно, его можно запросить у удаленного сервера. (IQN — это

просто соглашение об именовании дЛЯ iSCSI, которое соответствует форма

ту имени машины; обычно оно следует такому формату: iqn. 1991-05 . сот .

microsoft : serverOl . contoso . com.)

В прошлом при развертывании iSCSI мы отдавали предпочтение именам IQN,

потому что они не меняются, если только не изменяется имя самой машины.

Другие варианты, как было описано ранее, обладают возможностью легкого

изменения в среде, и если вы представляете номера LUN удаленным машина

ми, то не хотите, чтобы это происходило.

9. Как показано на рис. 12.57, выберите переключатель Select from the initiator

cache оп the target server (Выбрать из кеша инициатора на целевом сервере).

Далее можно запросить аутентификацию дЛЯ номера LUN с применением

СНАР (Challenge-Handshake Authentication Protocol (протокол аутентификации

по методу «вызов-приветствие») — это протокол аутентификации мя управле

ния доступом к ресурсам). В рассматриваемом примере мы это проигнорируем.

1О. Наконец, пересмотрите все настройки и щелкните на кнопке Create (Создать)

Хотите создать новый виртуальный диск для iSCSI в PowerShell и представить его цели? Ниже приведены примеры командлетов, которые можно применять.

1 . Создайте виртуальный диск посредством командлета New-iSCSIVirtualDisk.

Вот пример:

New-IscsiVirtualDisk -path e : newdisk.vhdx -SizeBytes 20GB

-Cornputernarne SSOl

2. Добавьте этот виртуальный диск к цели с помощью командлета Add

IscsiVirtualDiskTargetMapping.

Вот пример:

Add-IscsiVirtualDiskTargetMapping -TargetNarne VМcluster-Target

-path e : newdisk. vhdx

Дело сделано!

подключение к виртуальному диску iSCSI со стороны клиента

Вы настроили целевой сервер iSCSI и новый виртуальный диск, но они не ис

пользуются до тех пор, пока клиент не подключится к соответствующему номеру

LUN. Вспомните, что если вы настроили списки доступа, то будете иметь возможность подключения к LUN только из указанной машины.

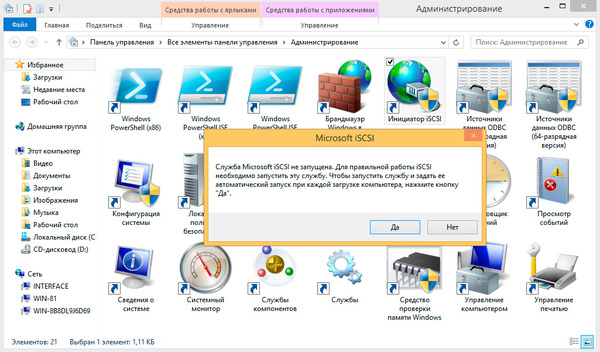

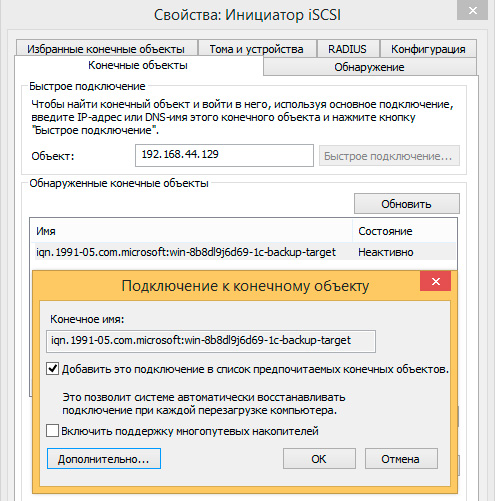

1. Выберите в меню Tools (Сервис) диспетчера серверов пункт iSCSI lnitiator

(Инициатор iSCSI), как показано на рис. 12.58.

Откроется диалоговое окно iSCSI lnitiator Properties (Свойства инициатора iSCSI).

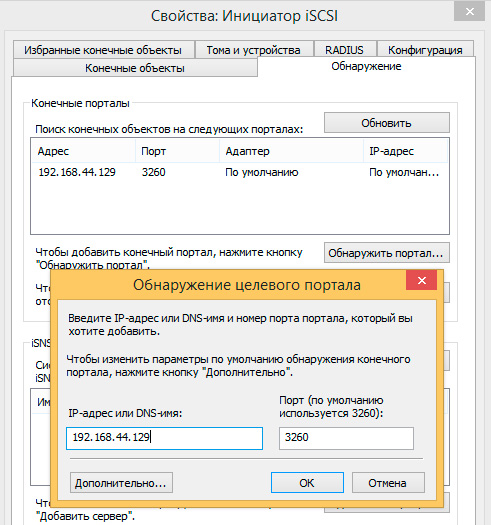

2. Чтобы следовать нашему примеру, введите 192 . 168 . о .1 в поле Target (Цель) и

щелкните на кнопке Quick Connect (Быстро подключиться), как показано на

рис. 12.59.

Откроется диалоговое окно Quick Connect (Быстрое подключение), которое

проверяет, что состоянием является Connected (Подключено). Это гарантирует

видимость номера LUN и корректность настройки правил доступа (рис. 12.60).

Для продолжения щелкните на кнопке Done (Готово).

3. Перейдите на вкладку Volumes and Devices (Тома и устройства) и щелкните на

кнопке Auto Configure (Сконфигурировать автоматически), как показано на

рис. 12.61 . Область Volume List (Список томов) автоматически заполнится томами, которые представляются клиенту.

Рис. 1 2.61 . Вкладка Volumes and Devices

4. Наконец, в окне диспетчера серверов внутри узла Rle and Storage Services (Службы файлов и хранилища) щелкните на папке VolumesqDisks (ТомаqДиски).

На рис. 12.62 видно, что появились два новых диска, для которых в столбце Bus Туре (Тип шины) указано iSCSI. Теперь они готовы к форматированию и созданию стандартных томов.

Общие ресурсы NFS

Сетевая файловая система (Network File System — NFS) позволяет совместно ис

пользовать файлы между сервером Windows и машинами с платформой Unix/Linux

посредством протокола NFS Protocol. В Windows Server 201 2 бы.1и внесены следую

щие усовершенствования.

• Поддержка NFS версии 4.1. Это включает упрошенный доступ через брандма

уэры, протокол RPCSEC_GSS для расширенной безопасности, согласование

безопасности клиентов и серверов, семантика файлов Windows и Unix, улуч

шенная поддержка для кластеризированных файловых серверов и дружествен

ные к WAN составные процедуры.

• Улучшенная производительность. Никакой дополнительной настройки не тре

буется, т.к. за счет применения нового встроенного протокола RPC-XDR вы

должны получить оптимальную производительность в готовом виде.

• Более простое управление.

Задачи управления выполняются с помощью

PowerShell и унифиuированного графического пользовательского интерфейса в

диспетчере серверов. Порт протокола RPC под номером 2049 упрощает конфи

гурирование брандмауэров.

Еще одним усовершенствованием является улучшенное отображение удостоверений, к тому же появился новый поставщик WMlv2.

• Усовершенствования, касающиеся высокой rотовности NFSvЗ. Теперь улучшены

показатели времени обхода отказа с новыми настроенными путями обхода от

казов для каждого физического дискового ресурса. Это ускоряет обход отказа

для клиентов N FS.

Где используется общий ресурс NFS

Файловая система N FS применяется в средах, где существует требование нали

чия общих файловых ресурсов в среде со смесью операционных систем (таких как

Windows и Unix/Linux).

Б.1агодаря усовершенствованиям в Windows Server 2012, вы теперь можете одновременно представлять общий ресурс с помощью NFS и SMB.