Доброго времени суток!

Сегодня хотелось бы немного поговорить о новой фиче в Windows Server 2012 — Storage Spaces или Пространства Данных.

По сути это некоторый механизм виртуализации дисковой подсистемы, который абстрагирует нас от физического уровня дисковой подсистемы. Однако, более интересным вариантом реализации данного механизма являются Кластеризованные Пространства Данных (Clustered Storage Spaces). Давайте более подробно рассмотрим способ настройки данного механизма.

Предварительные Требования

Для начала разберемся с теми необходимыми условиями нашего «дано» для осуществления процесса настройки.

Итак:

1) Для создания Storage Spaces в режиме Failover Cluster необходимо минимум 3 физических диска, объем которых не менее 4 Гб для каждого диска.

2) Все диски внутри Storage Pools должны обязательно быть Serial Attached SCSI (SAS) — независимого от того, будут ли эти диски напрямую подключены к системе, есть ли между ОС и дисками какая-либо прослойка в виде RAID-контроллеров и прочих дисковых подсистем или нет.

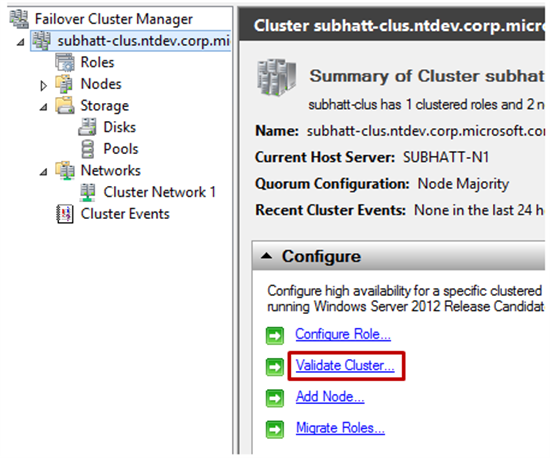

3) Все физические диски, которые будут состоять в кластеризованном пуле должны успешно пройти тест на валидацию в Failover Clustering. Для того чтобы это сделать необходимо открыть Failover Cluster Manager — cluadmin.msc и выбрать опцию Validate Cluster.

4) Кластеризованное пространство данных должно использовать фиксированный тип предоставления ресурсов (речь идет о типе vhd(x)-диска, который используется для Storage Spaces).

5) Поддерживаются простые (simple) и зеркальные (mirror) типы Storage Spaces — тип с контролем честности (parity) не поддерживается.

6) Диски которые используются в отказоустойчивом пуле должны быть выделенными. Это значит что они не могут быть использованы в составе других пулов, только в одном-единственном.

7) Storage spaces которые отформатированы в формате ReFS не могут быть добавлены в общий том кластера (CSV).

Как настроить — пошаговая инструкция

1) Добавьте роль File Services и инструментарий File Services Role Administration Tools на все узлы кластера в Failover Cluster.

2) Откройте консоль управления Failover Cluster Manager (cluadmin.msc).

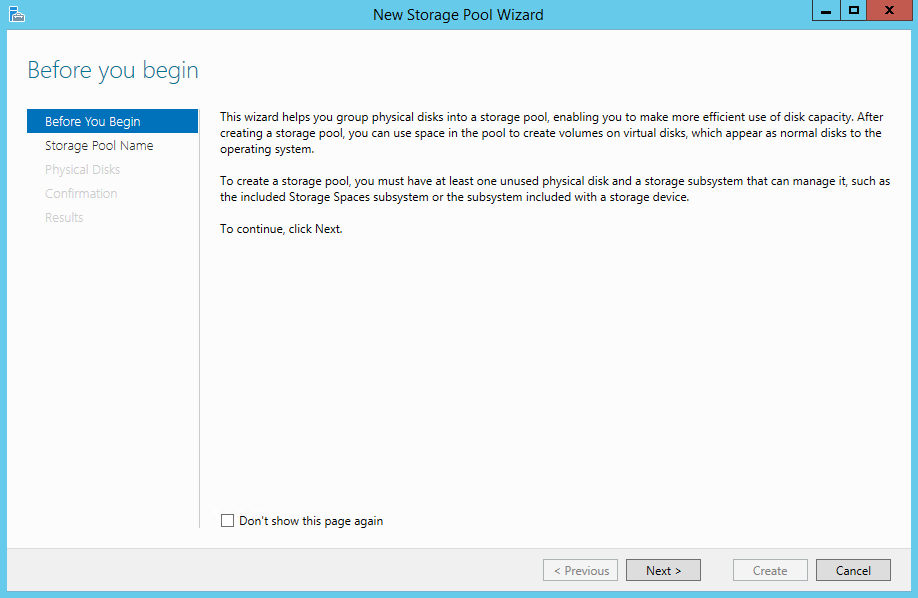

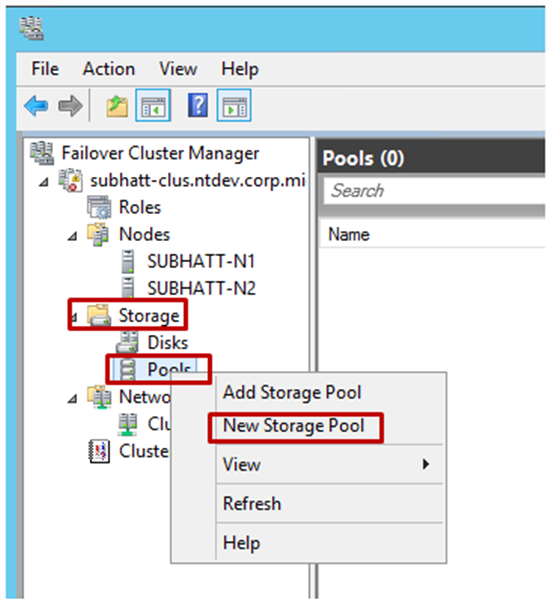

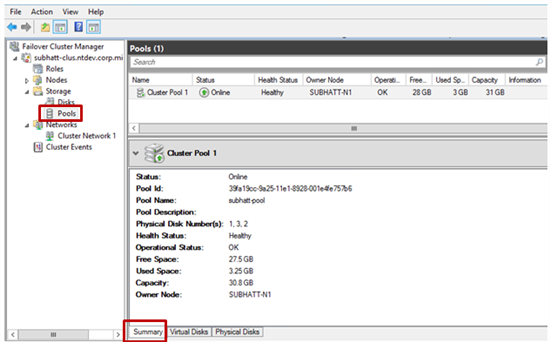

3) В левой части панели раскройте пункт Storage, правый щелчок по Pools и выберите пункт создания нового пула New Storage Pool. Далее вы увидите мастер настройки New Storage Pool Wizard.

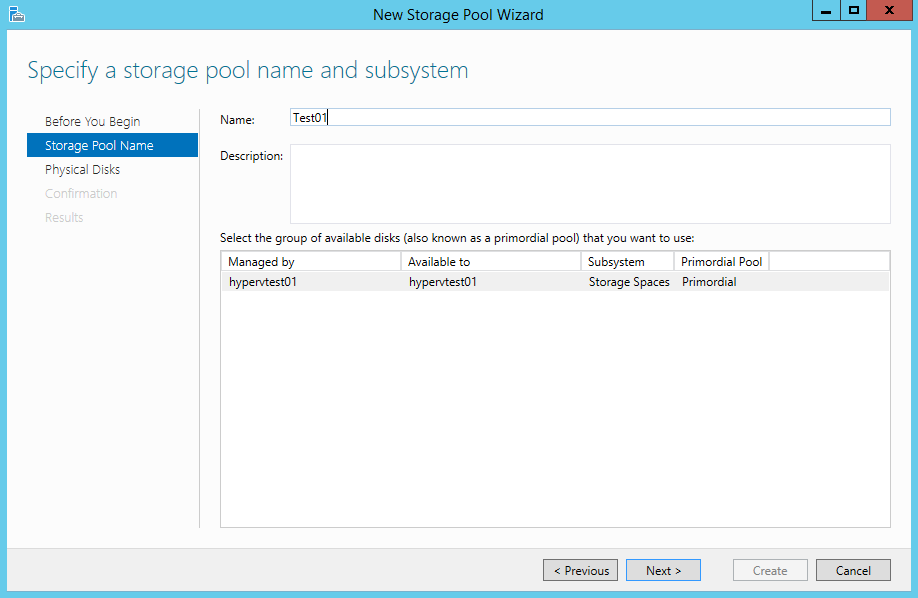

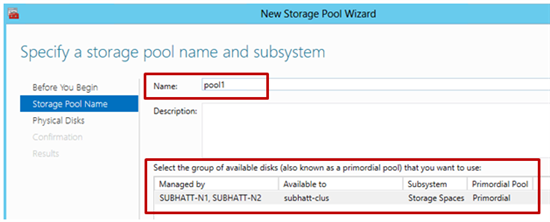

4) Задайте имя для Storage Pool и выберите дисковую подсистему доступную для кластера и нажмите Next.

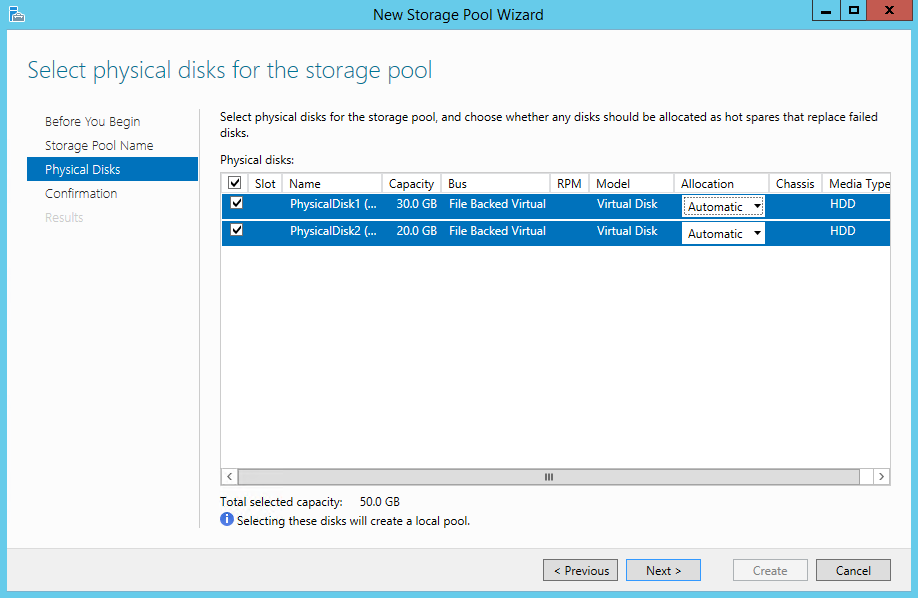

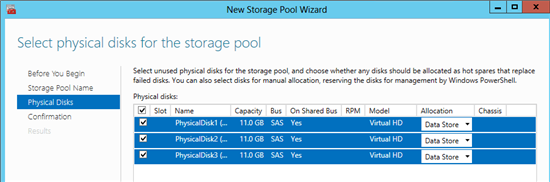

5) Выберите физические диски в разделе Physical Disks для нового пула (помните про требования!!!) и подтвердите создание пула. Пул будет добавлен в кластер переведен в активное состояние (Online).

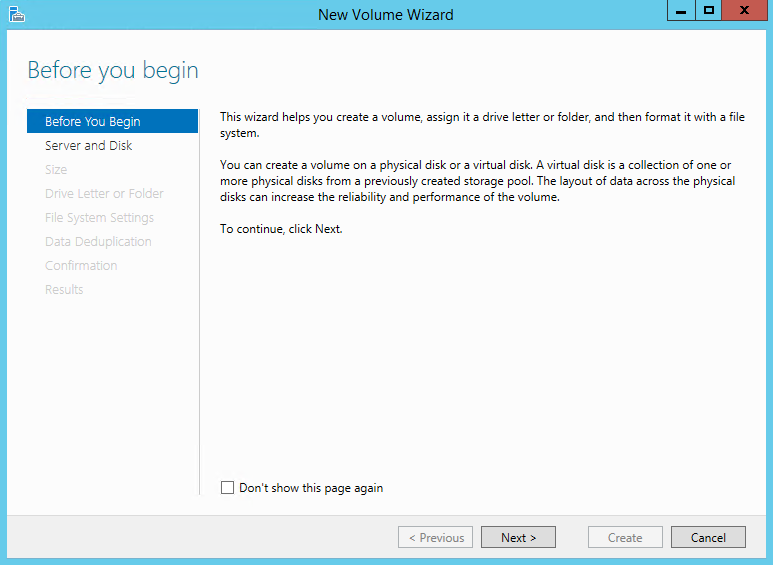

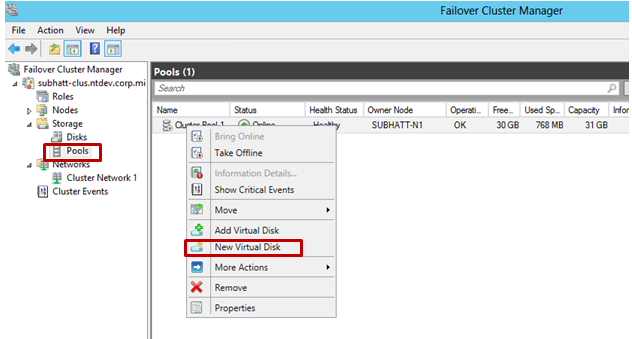

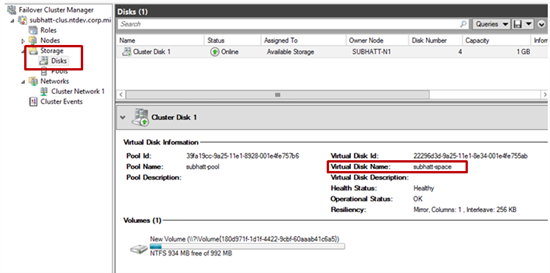

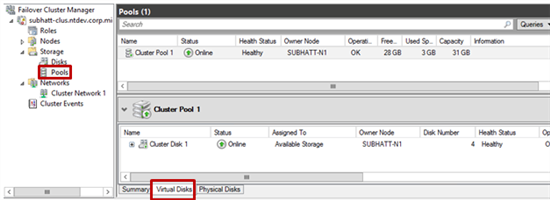

6) Следующий шаг — создание виртуального диска или пространства данных, который будет проассоциирован с нашим пулом. В Failover Cluster Manager выберите интересующий storage pool, который будет обеспечивать виртуальный диск. Правый щелчок и пункт New Virtual Disk — наш выбор!

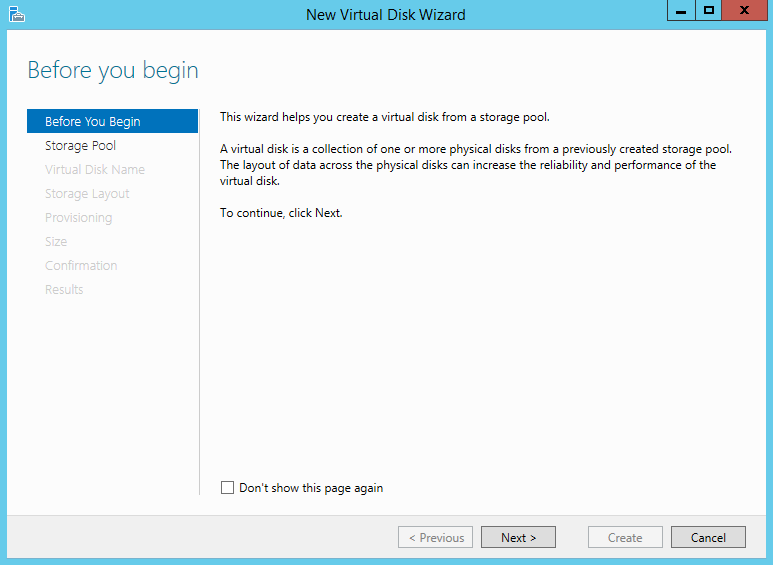

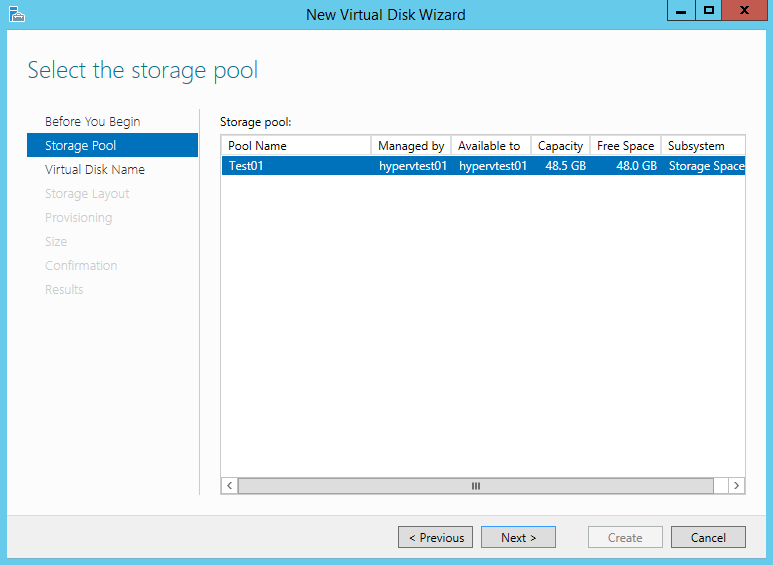

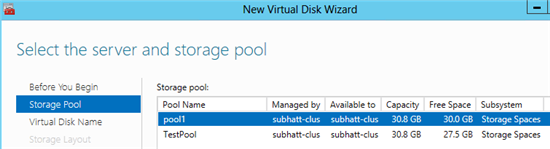

7) Далее будет запущен мастер создания виртуального жесткого диска New Virtual Disk Wizard. Выберите сервер и пул для виртуального диска и нажмите Next. Обратите внимание на то, что в списке серверов будет указан узел, который размещает пул.

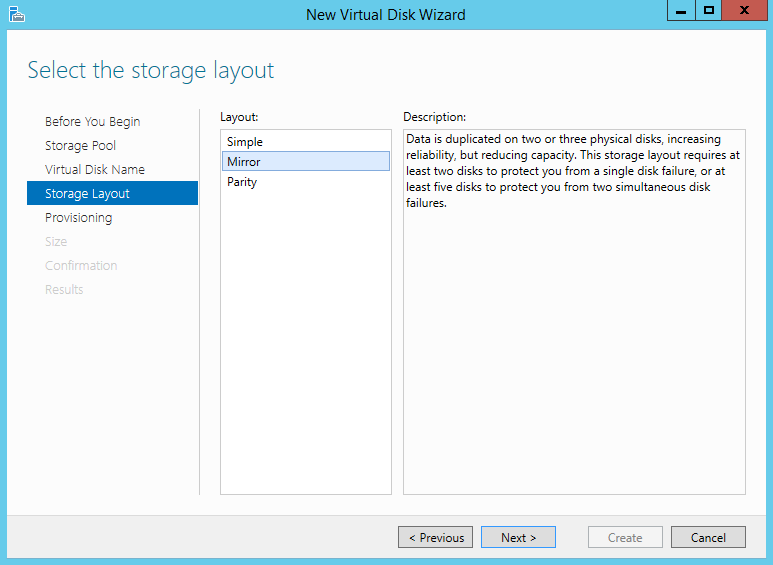

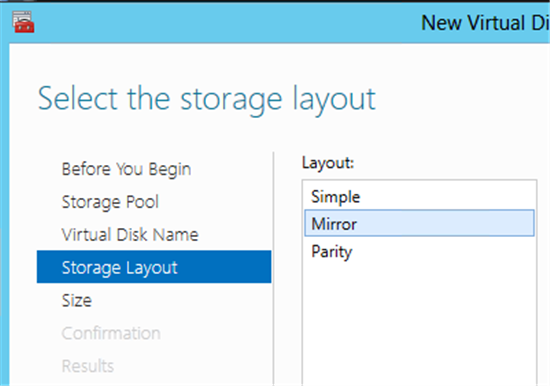

9) Выберите тип дисковый подсистемы — Простой (Simple) или Зеркальный (Mirror). Помним, что вариант Четность (Parity) не поддерживается для кластерной реализации.

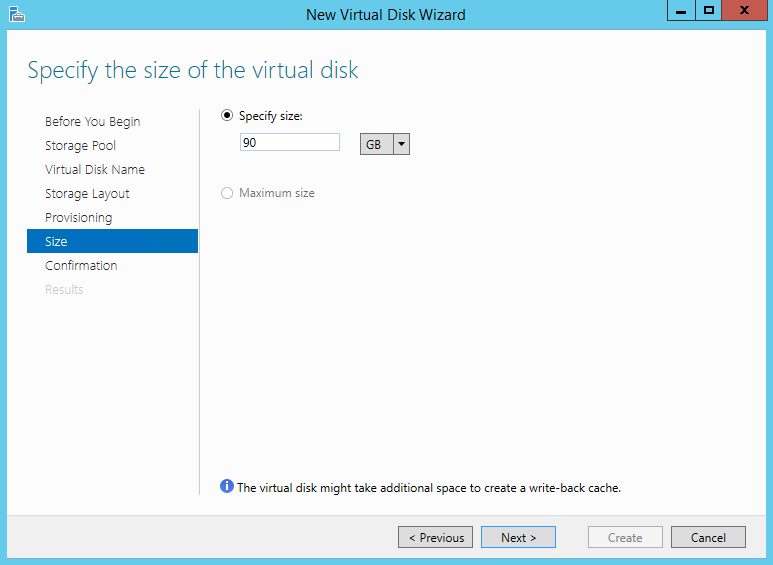

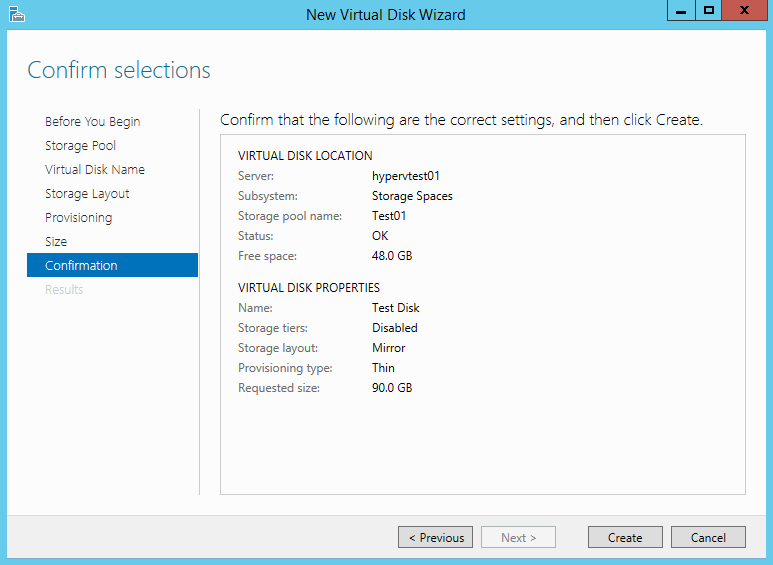

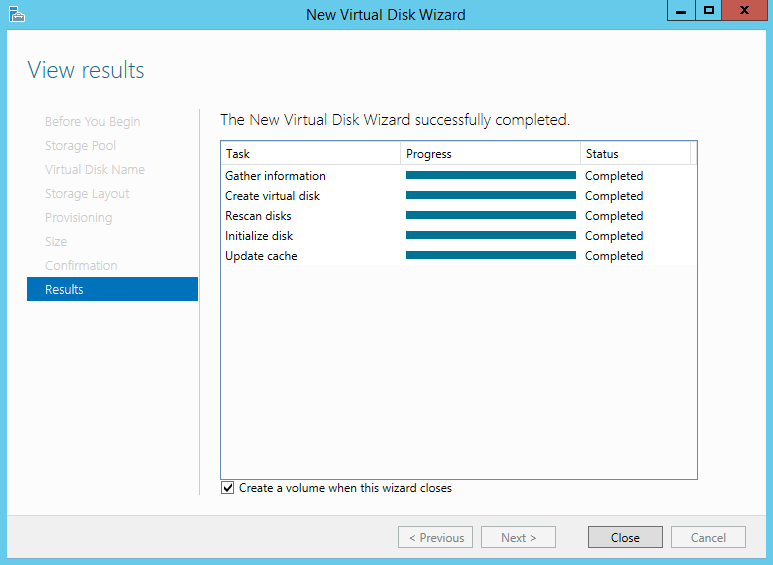

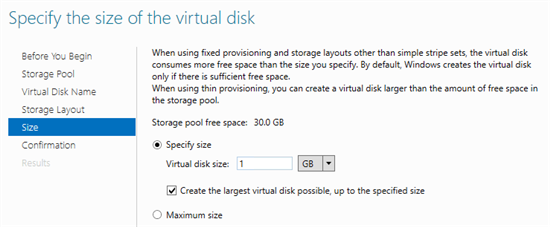

10) Укажите размер виртуального диска и нажмите Next. После подтверждения, диск будет создан. Если вы не сняли галочку с чек-бокса, то далее будет запущен мастер создания тома (New Volume Wizard).

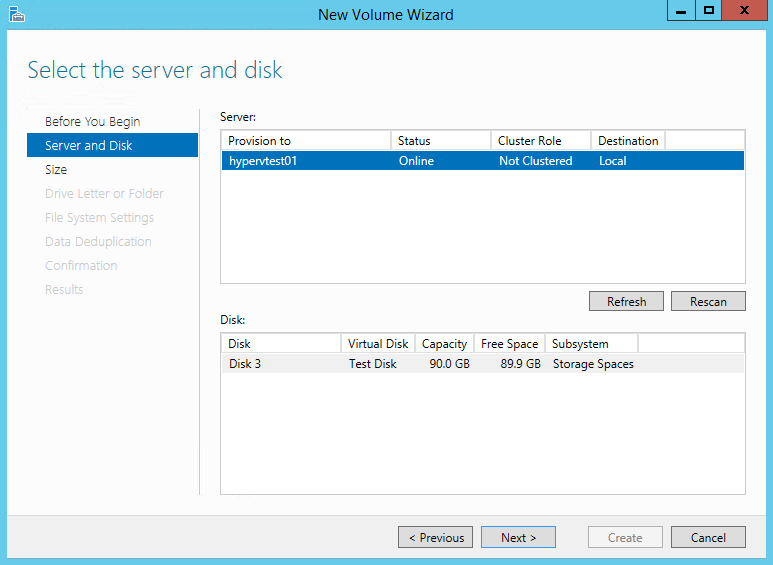

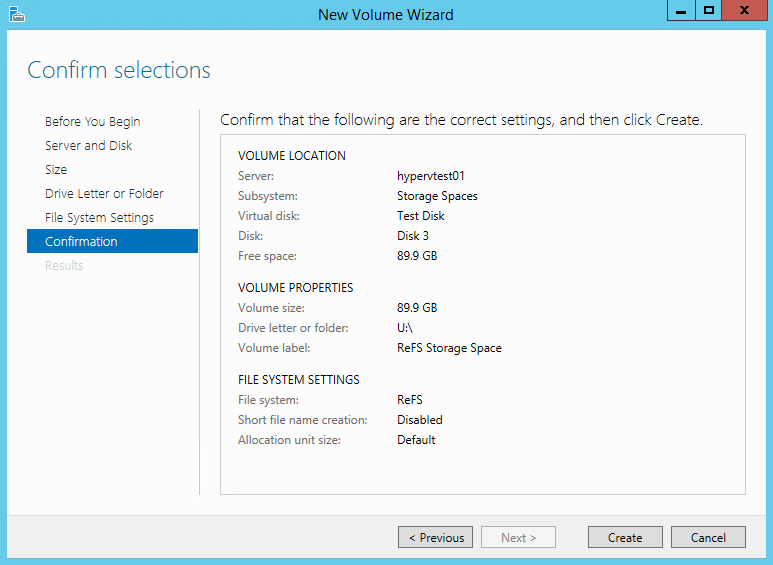

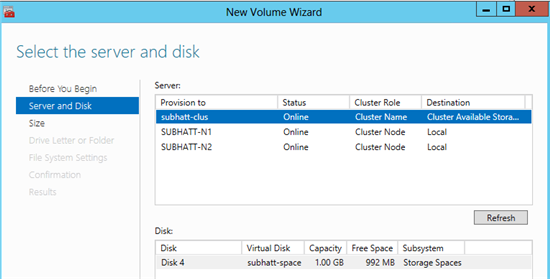

11) Задайте правильную связку «Сервер-Диск» для вашей конфигурации и нажмите Next.

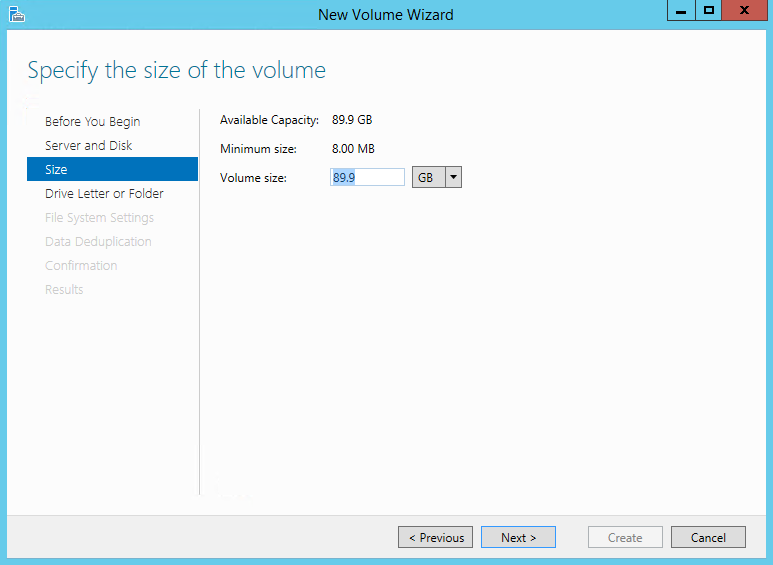

12) Укажите размер тома и нажмите Next.

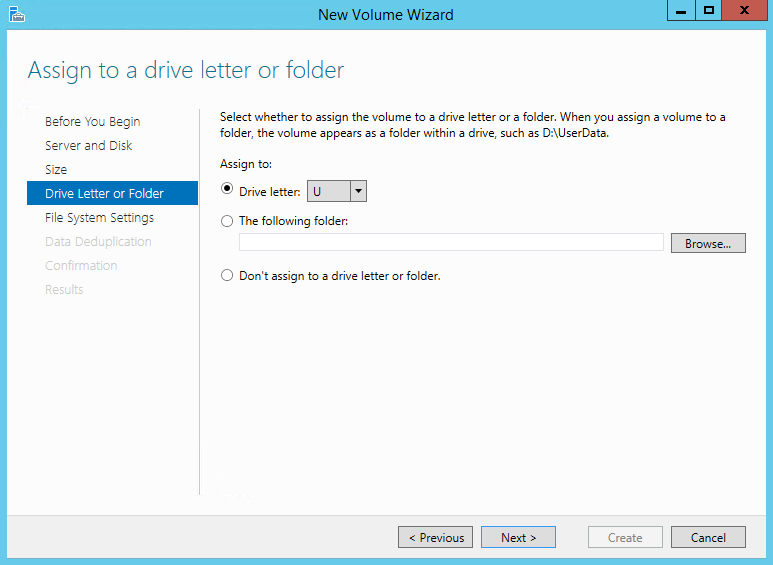

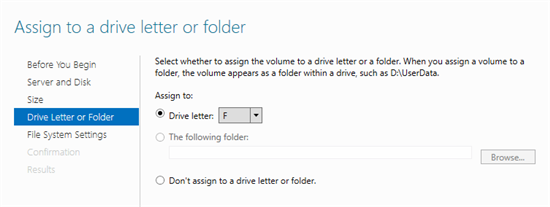

13) Также вы можете назначить букву для нового тома — далее нажмите Next.

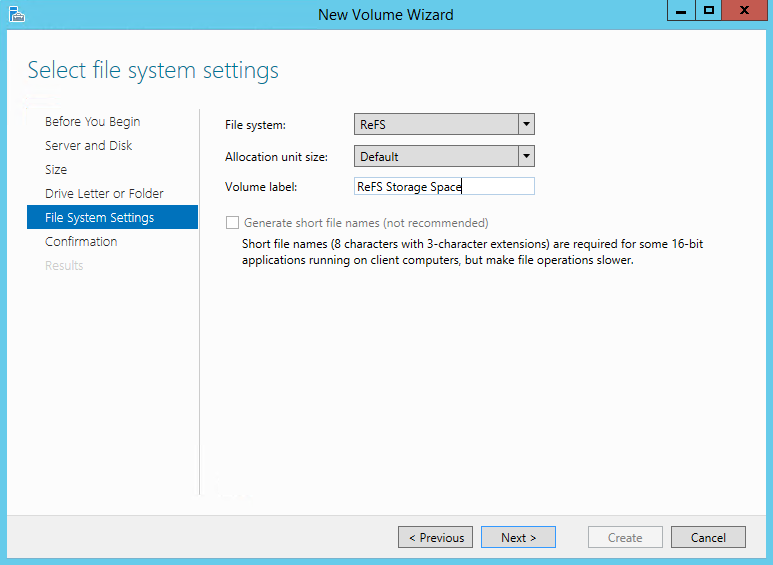

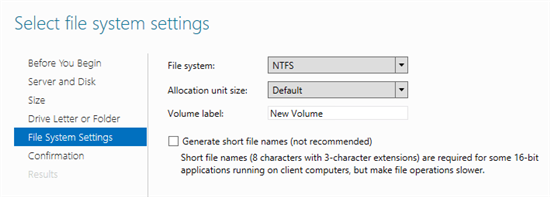

14) Выберите тип файловой системы (мы помним что для нашей задачи подходит только NTFS) и нажмите Next для подтверждения параметров. Новый том будет создан поверх виртуального диска и предоставлен кластеру во владение.

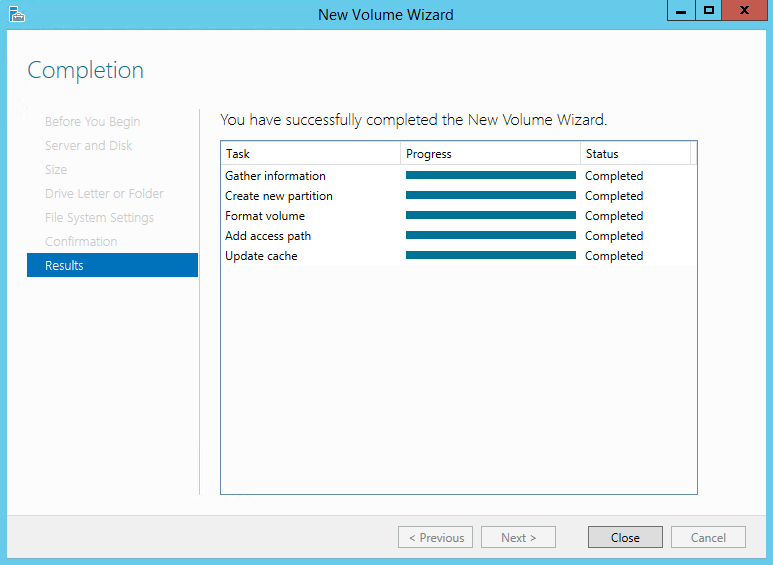

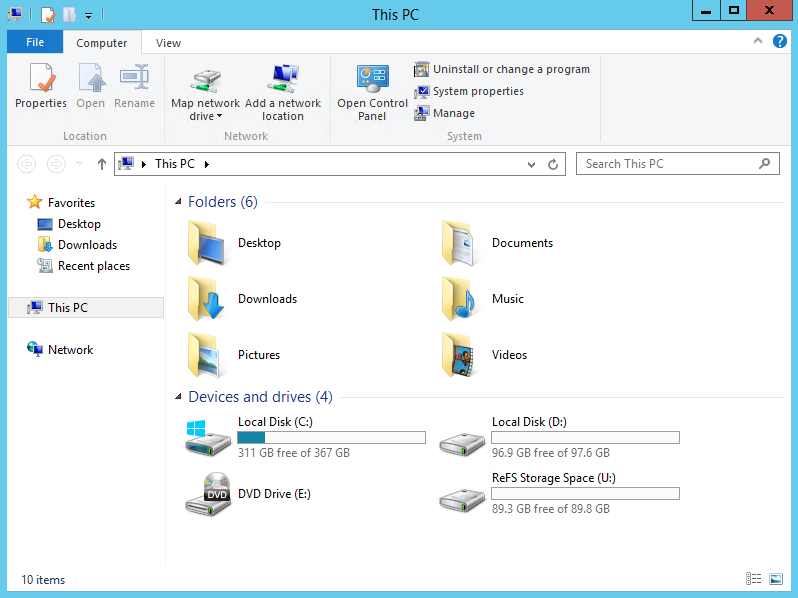

15) Ну что же, наше кластерное пространство успешно создано! Теперь поверх него можно размещать кластеризованные нагрузки. Для того чтобы просмотреть свойства пула зайдите в Failover Cluster Manager.

Любителям PowerShell

Ну и на последок.

Все то же самое, но без GUI)))

1. Создать нового пространства

a. Выбрать физические диски и добавить в пул

$phydisk = Get-PhysicalDisk –CanPool $true | Where BusType -eq «SAS”

b. Получение дисковой подсистемы для пула

$stsubsys = Get-StorageSubsystem

c. Создание нового пула

$pool = New-StoragePool -FriendlyName TestPool -StorageSubsystemFriendlyName $stsubsys.FriendlyName -PhysicalDisks $phydisk -ProvisioningTypeDefault Fixed

d. Добавление диска для горячей замены (Hot Spare)

$hotSpareDisk = Get-PhysicalDisk –CanPool $true |Out-GridView -PassThru

Add-PhysicalDisk -StoragePoolFriendlyName TestPool -PhysicalDisks $hotSpareDisk -Usage HotSpare

2. Создание пространства данных поверх ранее созданного пула

a. $newSpace = New-VirtualDisk –StoragePoolFriendlyName TestPool –FriendlyName space1 -Size (1GB) -ResiliencySettingName Mirror

3. Инициализация, разметка и форматирование ранее созданного пространства данных

a. $spaceDisk = $newSpace | Get-Disk

b. Initialize-Disk -Number $spaceDisk.Number -PartitionStyle GPT

c. $partition = New-Partition -DiskNumber $spaceDisk.Number -DriveLetter $driveletter -size $spaceDisk.LargestFreeExtent

d. Format-Volume -Partition $partition -FileSystem NTFS

4. Добавление пространства данных в кластер

a. $space = Get-VirtualDisk -FriendlyName space1

b. Add-ClusterDisk $space

На этом вроде бы все. Остается добавить, что если вы хотите узнать побольше про новые возможности Windows Server 2012, то мы приглашаем всех на IT Camps, которые будут проходить в Москве. Расписание вы найдетездесь.

И не забывайте про очень полезный ресурс — виртуальную академию Майкрософт

Веселых ИТ-приключений!

С уважением,

Георгий А. Гаджиев

Эксперт по информационной инфраструктуре

Корпорация Майкрософт

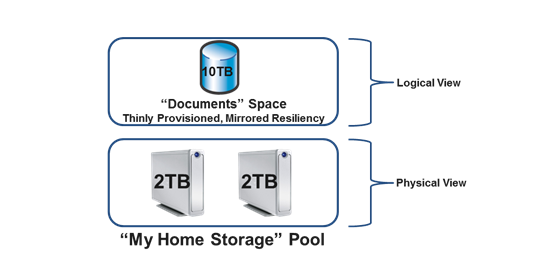

Storage Spaces — новый компонент Server 2012 (и клиента Windows 8), в нем воплощен свежий взгляд разработчиков на хранилище данных и способы его администрирования. Физические диски, обеспечивающие хранение данных, абстрагируются от процесса запроса новых томов, теперь именуемых пространствами (space). Технология Storage Spaces автоматически выполняет все необходимые действия для восстановления избыточности данных в случае отказа диска, при наличии достаточного количества физических дисков

Джон Сэвилл (jsavill@windowsitpro.com) — директор по технической инфраструктуре компании Geniant, имеет сертификаты CISSP, Security and Messaging MCSE для Windows Server 2003 и звание MVP

Базовые возможности файловой системы Windows Server не сильно изменились со времени выпуска первых версий Windows NT. В Windows 2000 появились динамические диски; выше стали надежность и производительность файловой системы NTFS; понемногу изменялись файловые службы, как и протокол Server Message Block (SMB), но революционных переворотов не было. В диспетчере File Server Resource Manager (FSRM) усовершенствованы экранирование, квоты, функции отчетов и классификации, но базовые возможности файловой системы и способы использования файловых служб остались прежними.

Когда речь заходит о файловых службах, я вспоминаю о сервере для хранения документов Microsoft Word и PowerPoint. Если от сервера требуется высокая готовность, его можно ввести в состав кластера, и тогда в каждый момент времени общий файловый ресурс будет предоставлен одним сервером. Отказоустойчивые тома можно создать на динамическом диске с использованием зеркалирования Windows (RAID 1) или чередования с контролем четности (RAID 5). Однако ИТ-администраторам приходится вручную выбирать диски и выполнять любые действия по устранению неполадок. Более того, расширенные функции, такие как гибкая подстройка (thin provisioning — своевременное выделение серверу только необходимого пространства памяти) и удобное добавление памяти к пулу, в котором можно создавать тома, просто невозможны без использования отдельной сети хранения SAN или устройства хранения, подключенного к сети, NAS. Все должно измениться с выходом новой версии Windows Server, Windows Server 2012 (ранее известной под условным названием Windows Server 8).

Использование Storage Spaces

ИТ-администраторы и даже конечные пользователи нередко нуждаются в отказоустойчивом хранилище данных. В других случаях требуется защитить информацию иными способами. Можно открыть оснастку Disk Management консоли управления Microsoft MMC, проверить физические диски, при необходимости преобразовать их в динамические, а затем создать том, соответствующий вашим требованиям. Если том должен увеличиваться, можно предусмотреть возможность его расширения (в зависимости от физических дисков), но нельзя добавлять диски к существующему тому, что позволило бы легко масштабировать хранилище данных. Для малых и средних предприятий и даже крупных компаний с мелкими удаленными филиалами (они обладают всего парой серверов и в них нельзя экономично разместить SAN или NAS) подготовка решения хранения данных для служб — целая проблема. Следующие в списке — опытные пользователи настольных компьютеров, которым тоже трудно организовать данные на внутренних дисках и дисках, подключенных через USB.

.

Первый шаг — создание пула носителей, состоящего из нескольких физических дисков, которые связываются друг с другом и могут быть использованы технологией Storage Spaces. В пулы носителей можно объединять диски, подключенные через интерфейсы USB, Serial ATA (SATA) и Serial Attached SCSI (SAS), в конфигурации Just a Bunch of Disks (JBOD). В отсутствие аппаратной поддержки высокой доступности, например RAID, в технологии Storage Spaces приняты меры для обеспечения отказоустойчивости. Накопители, подключаемые через интерфейс USB, особенно удобны для настольных компьютеров; в серверах применяются накопители SATA и SAS. Кроме того, технология Storage Spaces полностью поддерживает совместное использование SAS. Дисковое устройство можно подключить к нескольким компьютерам в кластере, и пространство Storage Space на совместно используемых накопителях SAS будет доступно всем узлам в кластере и может применяться как часть томов Cluster Shared Volumes (CSV). При использовании внешнего дискового устройства технология Storage Spaces поддерживает протокол SCSI Enclosure Services (SES), предупреждающий об отказах внешних хранилищ данных. Например, можно инициировать уведомление о неисправном диске, если Storage Spaces обнаруживает неполадки на физическом диске.

Вместе со Storage Spaces можно задействовать другие технологии, такие как шифрование Microsoft BitLocker Drive Encryption. Когда создается новый пул носителей, диски, добавляемые в него, исчезают из оснастки Disk Management консоли MMC; эти диски виртуализуются и применяются исключительно функцией Storage Space. О состоянии диска в пуле носителей можно узнать из File and Storage Services в диспетчере Server Manager (на сервере Windows

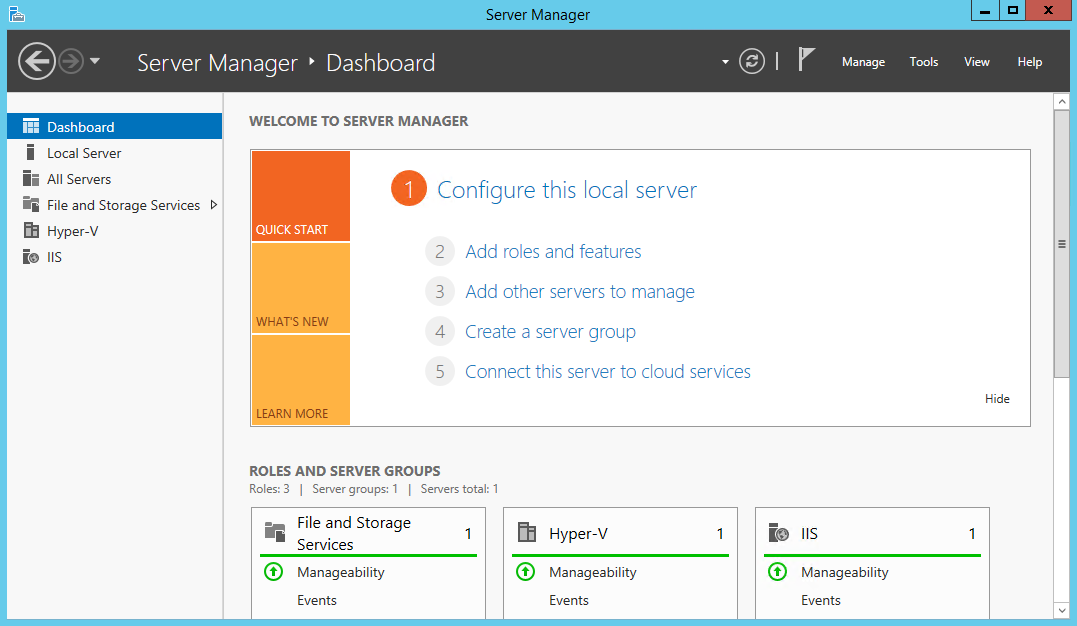

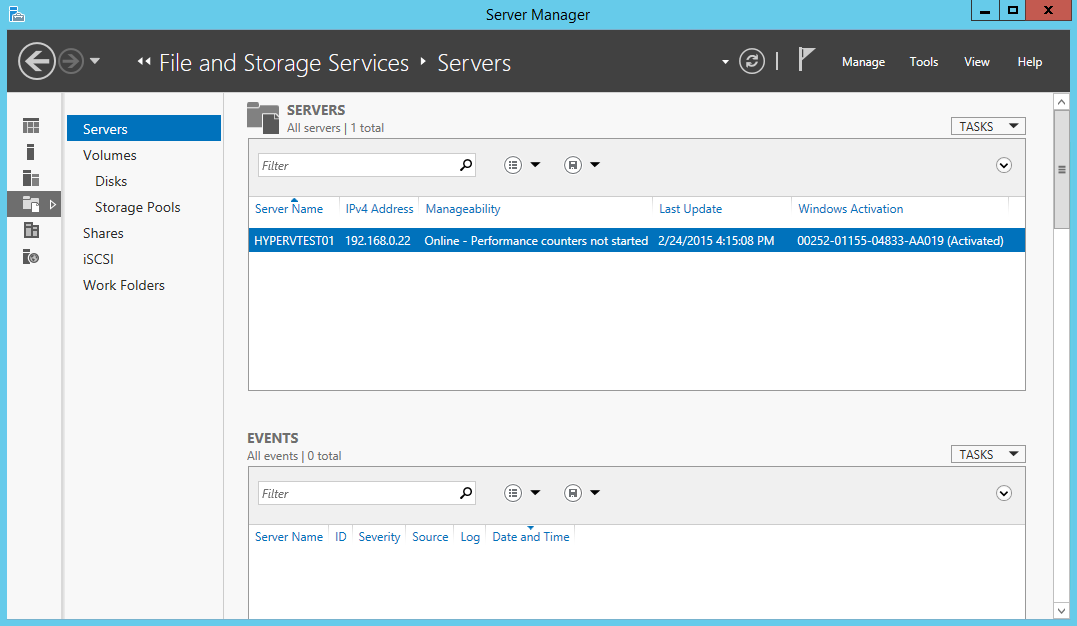

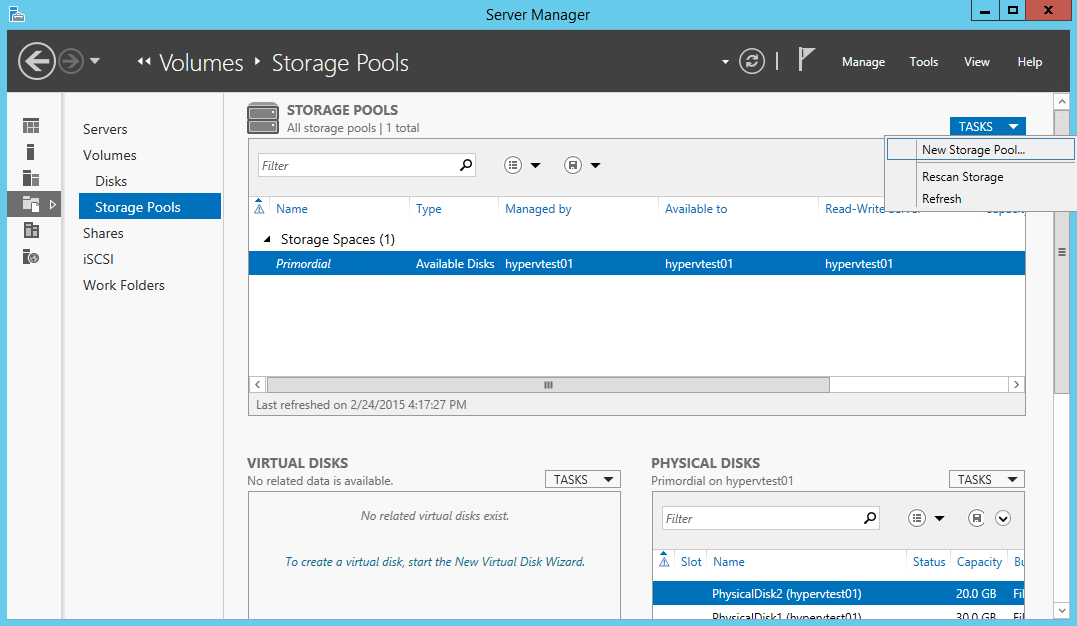

Запустите Server Manager. Убедитесь, что нужный сервер добавлен к списку серверов в экземпляре Server Manager (см. врезку «Управление Windows Server 2012»), затем откройте File and Storage Services. Выберите целевой сервер из вкладки Servers, после чего перейдите на вкладку Storage Pools, на которой показана информация о существующих пулах носителей и дисков, которые могут быть задействованы в пуле носителей. Это диски и системные диски, на которых не содержится никаких томов. Эти неиспользованные диски показаны в пространстве Primordial Storage Space и являются строительными блоками, из которых формируются пулы носителей и Storage Spaces, как показано на экране 1. Для создания пула носителей выполните следующие действия.

1. Из меню Tasks выберите пункт New Storage Pool, чтобы запустить мастер New Storage Pool Wizard.

2. Введите имя и необязательное описание нового пула носителей и нажмите кнопку Next.

3. На следующем экране выберите физические диски, которые будут добавлены в новый пул. Также выберите способ выделения дисков (по умолчанию Data Store). Можно выделять диски как часть виртуальных дисков, которые будут созданы позднее, или оставить в качестве горячего резерва, как показано на экране 2. Нажмите кнопку Next.

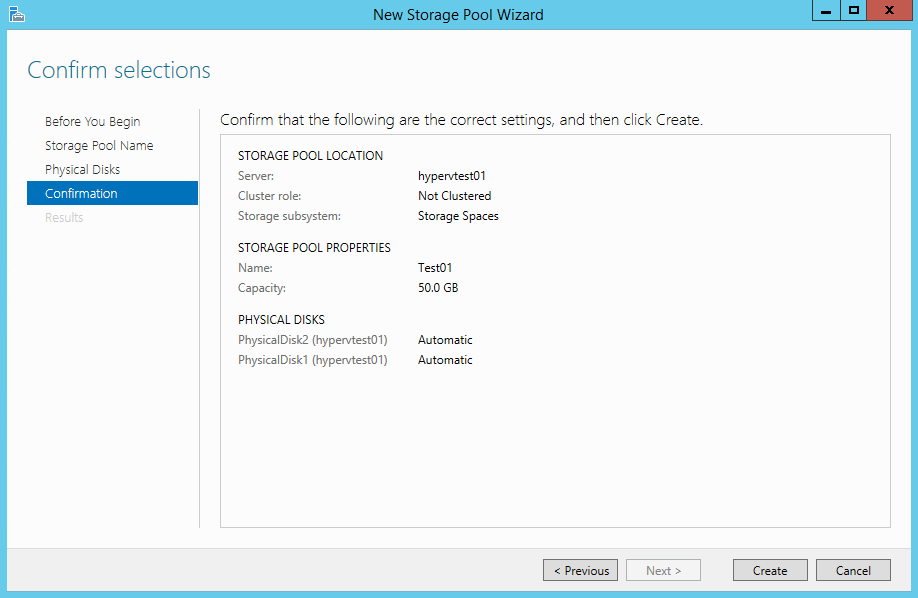

4. На экране появится подтверждение. Нажмите кнопку Create, чтобы завершить создание пула носителей.

|

| Экран 1. Дистанционное управление с помощью Server Manager |

|

| Экран 2. Добавление и выделение дисков новым пулам носителей |

Теперь пул носителей доступен. Следующий шаг — создать виртуальные диски в пуле носителей. Затем можно будет сформировать на этих дисках тома, доступные для использования операционной системой.

В Storage Spaces появилась функция, ранее доступная только при использовании внешних решений хранения данных, таких как сети SAN и устройства NAS: своевременное выделение серверу только необходимого пространства памяти. В процессе создания виртуального диска рассматривается две возможности. Первая — создать диск как фиксированный (выделено все пространство для размера виртуального диска). Вторая — забирать пространство для диска из пула только по мере необходимости. В этом случае можно создать виртуальный диск гораздо большего размера, чем фактически доступное хранилище. Это не означает, что удастся сохранить больше данных, чем вмещает выделенное для пула пространство. Но тома обычно со временем наполняются. Можно создать «тонкий» диск на 10 Тбайт, с которым связан лишь 1 Тбайт физического пространства; когда объем данных увеличится и приблизится к 1 Тбайт, можно физически увеличить пул еще на 1 Тбайт, просто подключив дополнительные диски. Когда объем данных будет приближаться к 2 Тбайт, можно вновь расширить хранилище на 1 Тбайт, добавив диски и т.д. Если добавлять физические диски до заполнения виртуального диска, проблем не возникает. Можно запрограммировать уведомления о достижении предельных значений пула носителей, и у администратора будет время, чтобы добавить нужное пространство.

Создавая виртуальный диск, необходимо лишь знать, в каком пуле носителей разместить диск. Информация о физических дисках не требуется и даже в явном виде недоступна. Цель Storage Spaces — создавать виртуальные диски по мере необходимости. Чтобы создать виртуальный диск, выполните следующие действия.

1. Выберите пул носителей, в котором будет создан новый виртуальный диск. В разделе Virtual Disks укажите задачу New Virtual Disk.

2. Подтвердите правильность выбора сервера и пула носителей на соответствующей странице мастера и нажмите кнопку Next.

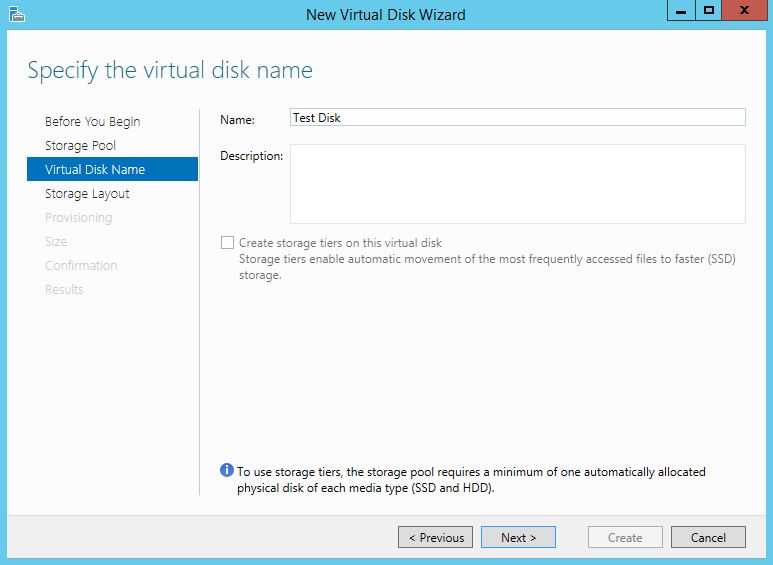

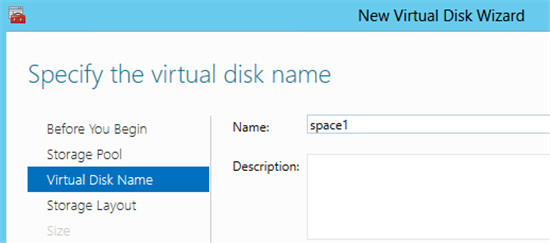

3. Дайте имя и введите необязательное описание нового виртуального диска, а затем нажмите кнопку Next.

4. Выберите структуру хранилища, которая может быть простой (избыточность данных отсутствует и данные разделяются между многими дисками), зеркальной (данные дублируются на дополнительных дисках) или с проверкой четности (данные распределены по нескольким дискам, но благодаря контролю четности защищены в случае отказа диска). До появления Storage Spaces эти конфигурации были известны как RAID 0, RAID 1 и RAID 5. Из-за различий в реализации эти обозначения не употребляются в Storage Spaces. Сделайте выбор и нажмите кнопку Next.

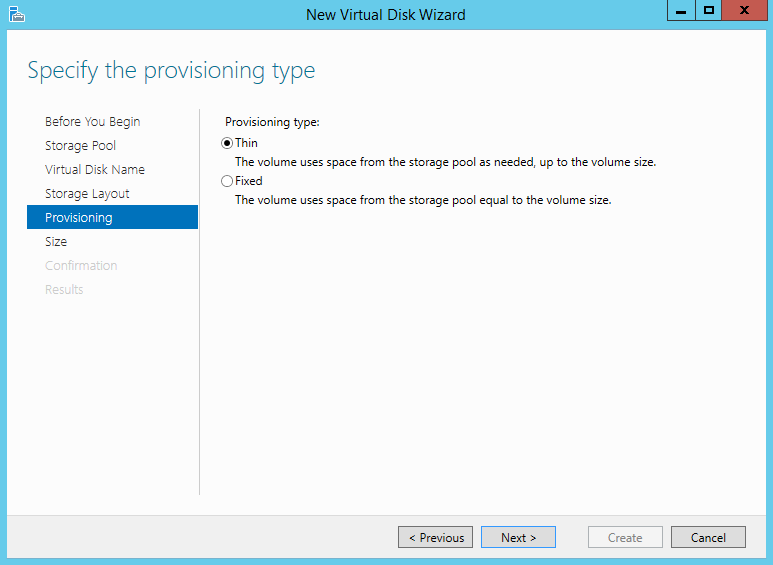

5. Выберите тип подготовки (Thin или Fixed), а затем нажмите кнопку Next.

6. Укажите размер диска. Если выбран тонкий тип, можно указать размер, превосходящий доступное физическое свободное пространство. Нажмите кнопку Next.

7. Отображается подтверждение; нажмите кнопку Create.

Созданный виртуальный диск будет доступен в Server Manager и оснастке Disk Management консоли MMC, где можно создать тома и отформатировать диск для файловой системы. Действительный размер пространства, используемого виртуальным диском в пуле носителей, виден в Server Manager (или в панели управления Storage Spaces на клиенте).

Управлять Storage Spaces можно и с помощью PowerShell. Например, создать новый пул носителей с тремя физическими дисками можно с использованием следующих команд:

$phyDisks = Get-PhysicalDisk $storSub = Get-StorageSubSystem New-StoragePool -FriendlyName «Stuff» -PhysicalDisks $phyDisks[0], - $phyDisks[1], $phyDisks[2] -StorageSubSystemFriendlyName $storSub.FriendlyName Команды для создания виртуальных дисков в пуле: New-VirtualDisk -StoragePoolFriendlyName «Stuff» -ResiliencySettingName Mirror -Size 10TB -Provisioningtype Thin -FriendlyName «Data1» New-VirtualDisk -StoragePoolFriendlyName «Stuff» -ResiliencySettingName Parity -Size 10TB -Provisioningtype Thin -FriendlyName «Data2»

Чтобы получить сведения о виртуальном диске, можно вывести результаты команды Get-VirtualDisk в виде списка. Например, можно задействовать следующую команду, чтобы получить информацию о числе копий данных для зеркала и состоянии операции:

PS C: > Get-VirtualDisk -FriendlyName Data1 | fl

На экране 3 показан небольшой фрагмент результатов.

|

| Экран 3. Результат выполнения команды Get-VirtualDisk |

SMB: лучше чем раньше

В следующей статье я подробнее расскажу о новых протоколах хранения данных в Windows 8. Но чтобы показать огромные преимущества Server 2012 как платформы файловых служб, необходимо коротко рассказать об использовании новых томов, готовых к работе со Storage Spaces.

SMB уже давно используется в Windows в качестве предпочтительного протокола для дистанционного доступа к файлам. В Server 2012 появилась версия SMB 2.2. На первый взгляд, отличия от SMB 2.1 в Server 2008 невелики, но на самом деле как производительность, так и возможности протокола SMB значительно увеличились.

Общая производительность SMB существенно возросла, и доступ к данным через SMB практически равноценен прямому доступу к хранилищу. Такой доступ стал возможным благодаря нескольким изменениям, в том числе протоколу SMB Multi-Channel, обеспечивающему установку нескольких TCP-соединений через несколько сетевых адаптеров в одном сеансе SMB. Благодаря этому изменению становится возможным объединение пропускной способности адаптеров, поскольку удается использовать несколько сетевых адаптеров и процессоров для сетевой обработки, если задействованы функция ReceiveSide Scaling (RSS) и несколько сетевых адаптеров. Этот прием также срабатывает для совместной работы сетевой платы Server 2012 (да, в Server 2012 предусмотрено решение для совместной работы сетевой платы!). Также значительно повысилась доступность общих файловых ресурсов с отказоустойчивой кластеризацией в новом режиме Active-Active, включающем том CSV, доступный всем узлам кластера. Несколько узлов в кластере могут одновременно использовать CSV для важных рабочих нагрузок, таких как виртуальные машины Hyper-V, сохраненных на общем файловом ресурсе, или даже базы данных Microsoft SQL Server. Такое совместное использование файлов в режиме Active-Active исключает простои и потерю дескрипторов в случае переключения ресурсов.

Помимо SMB, Server 2012 располагает iSCSI в качестве ролевой службы, как часть File Services в службах File and Storage Services. После установки этой службы сервер Server 2012 может функционировать как цель iSCSI, обеспечивая доступ к хранилищу как с файлового уровня (с использованием SMB), так и блочного уровня (с использованием iSCSI). Цели iSCSI на сервере обычно представляют собой виртуальные жесткие диски (VHD), и возможна полная конфигурация доступа и служб проверки подлинности.

Проблема Chkdsk

Есть еще одна проблема, связанная с применением файловых служб Windows Server, в частности NTFS, с очень большими томами и множеством файлов. Для устранения некоторых неполадок необходимо воспользоваться утилитой Chkdsk. Chkdsk очень успешно выполняет свои функции, но на это уходит много времени: приходится проверить все содержимое диска, а затем внести исправления, которые (в силу особенностей устройства и быстродействия дисков) могут занять много времени (дни для больших томов со многими файлами). В результате том отключается от сети на время устранения неполадок. Наряду с соображениями по восстановлению данных после аварии, это одна из причин, по которой часто размеры томов NTFS ограничивают: чтобы Chkdsk могла завершить работу за приемлемый период (то есть несколько часов).

Новая файловая система Resilient File System (ReFS), которая начнет более широко использоваться в будущих версиях Windows, должна уменьшить вероятность порчи данных. Собственно NTFS становится более устойчивой, благодаря возможностям самовосстановления, но иногда приходится использовать Chkdsk. В Windows 8 раз и навсегда устранены все препятствия для запуска Chkdsk даже на самых больших томах.

Chkdsk работает медленно. Как уже отмечалось, программа анализирует весь диск и все его содержимое в поисках неисправностей, для чего требуется время. После того, как найдены неисправности (которые затрагивают очень малое число файлов), Chkdsk устраняет их. Операции устранения ошибок занимают очень мало времени (измеряемое секундами). Проблема в том, что Chkdsk переводит том в автономный режим, и его данные становятся недоступными на время проверки и устранения ошибок.

В Server 2012 процесс Chkdsk разделен на две части. В первой выполняется проверка диска и данных, поиск неисправностей. Если ошибка найдена, то она отмечается как требующая исправления. Существенное отличие заключается в том, что во время длительной проверки том остается в сети, так как на данном этапе исправления не вносятся. После завершения проверки, если нужно исправить ошибку, Chkdsk запускается в режиме spotfix, в котором том переводится в автономный режим для устранения неполадок. Том находится в автономном режиме лишь несколько секунд вместо часов или дней. Процесс проверки отделен от процесса исправления ошибок. Для запуска Chkdsk используются две команды. Первая занимает много времени, поскольку выполняет проверку, но не влияет на доступность тома. Вторая команда переводит том в автономный режим или вызывает перезагрузку.

Chkdsk /scan J: Chkdsk /spotfix J:

Можно использовать следующие команды PowerShell:

Repair-Volume -Scan D Repair-Volume -SpotFix D

Если применяется CSV, то простои при операции spotfix исключены. Дело в том, что CSV добавляет еще один промежуточный уровень между диском и способом доступа. Кроме того, CSV может приостановить операции ввода-вывода примерно на 20 секунд. Поэтому когда выполняется действие spotfix, CSV лишь приостанавливает ввода-вывод для тома, пока он переведен в автономный режим и подвергается исправлениям. Таким образом, пользователи тома CSV испытывают лишь легкую задержку доступа; им не приходится работать в автономном режиме или терять дескрипторы файлов.

Мощное решение хранения данных

Функциональность Storage Spaces в сочетании с iSCSI и SMB 2.2 обеспечивает мощное решение хранения данных как для серверов, так и для настольных компьютеров. А если принять во внимание наличие других технологий, таких как новая функция дедупликации данных, то область применения для платформы файловых служб Windows значительно расширяется.

Управление Windows Server 2012

«Возможности многих, простота одного» — таков подход к управлению в следующей версии Windows Server, Windows Server 2012. Даже в условиях виртуализации управление серверами выполняется в основном через подключение к операционной системе для управления удаленным рабочим столом, или поочередным дистанционным подключением к каждому серверу через Server Manager. В Server 2012 все операции управления можно и нужно выполнять дистанционно. После установки инструментария Remote Server Administration Tools for Server 2012 на клиентском компьютере Windows 8 запустите Server Manager и создайте группы серверов, которыми предстоит управлять как единым целым. С помощью представлений панели мониторинга (см. экран A) не составляет труда обнаружить неполадки на любом сервере в группе и одновременно произвести действия над несколькими серверами. Это не означает, что Server Manager нельзя запускать локально на серверах. Но по мере оптимизации процессов управление одиночными серверами становится не самым рациональным подходом. Все чаще вместо полных экземпляров используется Server Core, и приходится управлять дистанционно или задействовать Windows PowerShell для всех операций администрирования.

|

| Экран A. Server Manager |

Назад Главная

Содержание

- 1 Storage Spaces в Windows Server 2012

- 1.1 Характеристики типов обеспечения отказоустойчивости.

- 1.1.1 Простой (Simple)

- 1.1.2 Зеркалирование (Mirror)

- 1.1.3 Контроль четности (Parity)

- 1.2 Настройка Storage Spaces

- 1.1 Характеристики типов обеспечения отказоустойчивости.

Storage Spaces или Пространства Данных — новая функция, которая появилась в Windows Server 2012, представляет собой механизм виртуализации дисковой подсистемы, что в свою очередь обеспечивает высокую доступность и масштабируемость решений хранения данных, как для отдельного сервера, так и кластера северов. Storage Spaces позволяет объединить несколько физических дисков в один логический, упрощая администрирование и обеспечивая защиту от потерь информации.

Схематично процесс создания Storage Spaces можно представить следующим образом:

- Создание одного или нескольких пулов (Pools).

- Создание одного или нескольких виртуальных дисков (Storage Spaces).

- Создание одного или нескольких логических томов.

Из возможностей Storage Spaces можно отметить следующие:

Упорядочивание физических дисков в пулы, которые можно легко расширять. При этом логический размер пула может быть больше чем суммарный объем всех физических дисков благодаря использованию технологии thin provisioning, которая позволяет выделить столько места на виртуальном томе, сколько необходимо, а физические диски добавлять по мере необходимости без каких-либо дополнительных настроек. Причем, типы и размер дисков в одном пуле могут быть разными.

Обеспечения отказоустойчивости за счет использования технологий зеркалирования и хранения информации о четности по аналогии RAID1 и RAID5, а также поддержка горячего резервирования «Hot Spare».

Для организации Storage Spaces необходимо выполнить ряд требований:

- Операционная система Windows Server 2012 или Windows 8.

- Диски SATA или SAS, можно в массиве JBOD. На адаптерах RAID (если используются) все функции RAID должны быть отключены

Некоторые ограничения, с которыми придется столкнуться при настройке Storage Spaces:

- Storage Spaces не могут использоваться для загрузки операционной системы.

- Не поддерживаются iSCSI и Fibre-chanel.

Характеристики типов обеспечения отказоустойчивости.

Простой (Simple)

- Данные чередуются на физических дисках.

- Увеличивается емкость диска и пропускная способность.

- Данный тип не дает отказоустойчивости.

Можно использовать для высоконагруженных систем, где потеря данных не критична или надежность обеспечивается другими методами.

Зеркалирование (Mirror)

- Данные сохраняются на двух или трех физических дисках (для функционирования необходимо минимум два диска для защиты выхода из строя одного из дисков или минимум пять дисков для защиты выхода из строя одновременно двух дисков).

- Надежность повышается, но уменьшается объем диска.

- Скорость передачи данных выше, чем при контроле четности.

Используется технология Dirty Region Tracking (DRT) для отслеживания изменений на дисках в пуле. Когда система возобновляет работу после внеплановой остановки, DRT приводит данные на дисках в соответствие относительно дуг друга.

Контроль четности (Parity)

- Повышение надежности по сравнению с простой (Simple) реализацией.

- Отказоустойчивость повышается благодаря ведению журнала.

- Необходимо минимум три диска для защиты выхода из стоя хотя бы одного диска.

Настройка Storage Spaces

Далее рассмотрим настройку Storage Spaces на примере. В качестве исходных данных, у нас есть сервер с установленной Windows Server 2012 и четыре физических диска. На одном из дисков установлена операционная система. Для обеспечения отказоустойчивости выберем тип зеркалирование на двух дисках, третий диск назначим Hot Spare.

1).В навигационной панели Server Manager выберите File and Storage Services.

2).Далее в панели выберите Storage Pools.

3).В панели STORAGE POOLS выберите TASKS и затем выберите New Storage Pool.

4).В окне Before you begin нажмите Next.

5).В окне Specify a storage pool name and subsystem введите название пула, так же можно добавить описание. Выберите группу доступных физических дисков и нажмите Next.

6).В окне Select physical disks for the storage pool выберете три диска для включения в storage pool, третий диск назначим в качестве Hot Spare.

7).В окне Confirm selections проверьте правильность настроек и нажмете Create.

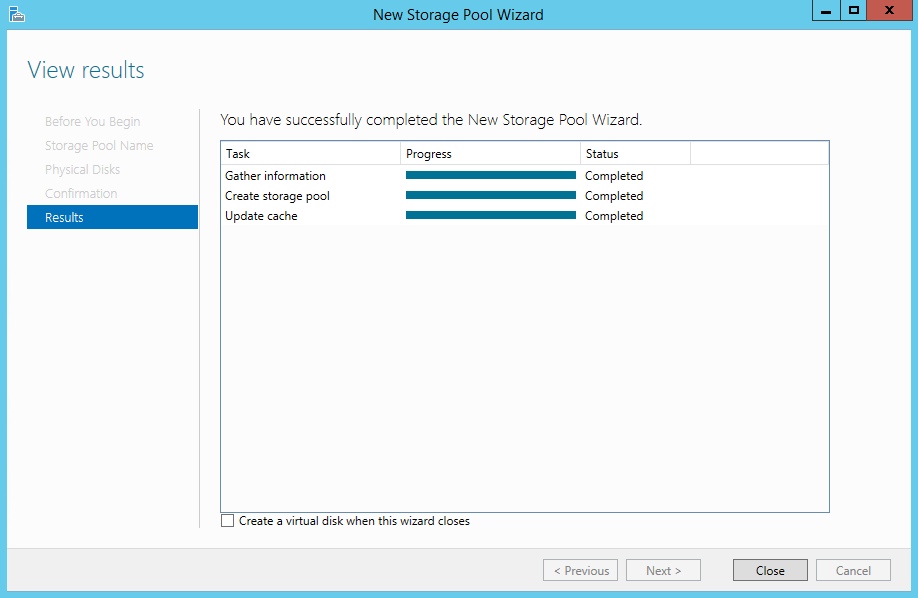

8).По окончании процесса отобразиться окно View results. Нажмите Close.

9).В панели VIRTUAL DISKS выберите TASKS, затем нажмите New Virtual Disk.

10).В окне Before you begin нажмите Next.

11).В окне Select the storage pool выберите нужный storage pool и нажмите Next.

12).В окне Specify the virtual disk name введите название виртуального диска и при желании его описание и нажмите Next.

13).В окне Select the storage layout выберете тип Mirror.

14).Далее предлагается выбрать тип виртуального диска Thin или Fixed. При выборе Thin Provisioning пространство выделяется по мере необходимости, размер диска можно выбрать больше, чем доступно на физических дисках. При выборе Fixed размер виртуального диска остается фиксированным. Выберем тип Fixed.

15).В окне Specify the size of the virtual disk выберете Maximum size.

16).В окне Confirm selections проверьте правильность настроек и нажмете Create.

17).По окончании процесса отобразиться окно View results. Нажмите Close. После создания виртуального диска он будет представлен в диспетчере устройств на равне с обычными дисками.

18).Далее создадим новый том. Для этого в панели VIRTUAL DISKS выберете правой кнопкой нужный виртуальный диск,

далее выберете меню New Volume.

19).В окне Before you begin нажмите Next.

20).В окне Select the server and disk выберете нужный сервер и диск и нажмите Next.

21). В окне Specify the size of the volume выберите размер нового тома и нажмите Next.

22). В окне Assign to a drive letter or folder назначьте букву тома и нажмите Next.

23). В окне Select file system settings оставьте все по умолчанию.

24). В окне Confirm selections проверьте правильность настроек и нажмете Create.

25). По окончании процесса отобразиться окно View results. Нажмите Close.

26). Для того, что бы убедиться, что логический том создан, в Server Manager откройте окно Volumes.

Представим ситуацию, когда один из физических дисков вышел из строя. В окне VIRTUAL DISKS напротив виртуального диска появляется восклицательный знак в желтом треугольнике.

Если в системе присутствует физический диск, отмеченный под горячую замену (Hot Spare), система помечет вышедший из строя диск как Failed и заменяет его на диск Hot Spare. Диск Hot Spare становиться частью виртуального диска, сам виртуальный диск в момент восстановления находится в статусе In Service.

Максим Иванов (mivanov@etegro.com)

This topic discusses common questions about Storage Spaces on Windows Server 2012 R2, Windows Server 2012, Windows 8.1, and Windows 8. For basic info about Storage Spaces, see

Storage Spaces Overview. For design info, see

Software-Defined Storage Design Considerations Guide. For performance information, see

Storage Spaces — Designing for Performance.

Table of Contents

- How can I manage Storage Spaces?

- What are the recommended configuration limits?

- What are the best uses of simple, mirror, and parity spaces?

- What types of drives can I use with Storage Spaces?

- What types of storage arrays can I use with Storage Spaces?

- Enclosure Awareness Support — Tolerating an Entire Enclosure Failing

- What are the resiliency levels provided by Enclosure Awareness?

- What types of storage spaces can I use with a failover cluster?

- What properties can I change after creating a storage space?

- How does Windows let me know of a disk failure?

- How does Storage Spaces respond to errors on physical disks?

- What information will Storage Spaces put in the Event log?

- How do I replace a physical disk?

- What are columns and how does Storage Spaces decide how many to use?

- Example 1: A Two-Column Simple Space

- Example 2: A Three-Column Parity Space

- Example 3: A Two-Column Two-Way Mirror Space

- Controlling the Number of Columns

- Why do I have a low capacity warning even though I still have unused pool capacity?

- A two column, two-way mirror space that uses thin provisioning in a four disk pool

- How do I increase pool capacity?

- What happens to Storage Spaces when moving physical disks between servers?

- How do I check Storage Spaces resiliency health in a failover cluster?

- How do I know repairing a storage space starts and successfully completes?

- What happens if I run out of physical capacity on a thinly provisioned storage space?

- See Also

How can I manage Storage Spaces?

There are three ways to manage Storage Spaces and associated storage pools and drives:

- The Storage Spaces item in Control Panel Available in Windows 10, Windows 8.1 and Windows 8, you can use the Storage Spaces item in Control Panel to easily create and maintain storage spaces and their associated storage

pools. The Storage Spaces item in Control Panel provides simple but powerful control over tasks a user might want to perform. - The File and Storage Services section of Server Manager Available in Windows Server, you can use Server Manager to create and manage storage spaces (also referred to as virtual disks) and their associated storage pools

on the Storage Spaces subsystem as well as on non-Microsoft storage subsystems. Server Manager provides support for performing all of the tasks administrators commonly perform with Storage Spaces. - The Storage module in Windows PowerShell Available in Windows and Windows Server, you can use the cmdlets included in the Storage module to create and manage storage spaces (also referred to as virtual disks) and their

associated storage pools on the Storage Spaces subsystem as well as on non-Microsoft storage subsystems. Windows PowerShell provides comprehensive support for managing Storage Spaces.

What are the recommended configuration limits?

The following are the recommended configuration limits for Storage Spaces:

For clustered storage pools:

- Up to 80 physical disks in a clustered storage pool (to allow time for the pool to fail over to other nodes)

- Up to four storage pools per cluster

For non-clustered storage pools:

- Up to 240 physical disks in a non-clustered Windows Server 2012 R2 storage pool (4 x 60 disk JBOD); you can, however, have multiple pools of 240 disks

- In Windows Server 2012, you can have up to 160 physical disks in a storage pool; you can, however, have multiple pools of 160 disks.

For both clustered and non-clustered pools:

- Up to 480 TB of capacity in a single storage pool

- Up to 64 storage spaces in a single storage pool

- Up to 10 TB per virtual disk when using persistent VSS snapshots and the Volsnap VSS system provider

What are the best uses of simple, mirror, and parity spaces?

Storage Spaces offers simple spaces, mirror spaces, and parity spaces, each with unique characteristics.

- Simple spaces are designed for increased performance when resiliency isn’t very important. They are best suited for temporary data, such as video rendering files, image editor scratch files, and intermediary compiler object files. Simple

spaces require a minimum of one physical disk. - Mirror spaces are designed for increased performance and increased resiliency. Two-way mirror spaces can tolerate one disk failure and three-way mirror spaces can tolerate two disk failures. They are well suited to storing a broad range

of data, from a general-purpose file share to a VHD library. When a mirror space is formatted with the Resilient File System (ReFS), Windows offers automatic data integrity maintenance. This is a layer of resiliency is above and beyond the resiliency achieved

from maintaining multiple data copies to tolerate drive failure.Mirror spaces require at least two disks (per tier if you use storage tiers) to protect you from a single disk failure. To protect

a virtual disk from two simultaneous disk failures, you need at least three disks (per tier), with a minimum of five disks total in the pool to maintain pool metadata.

- Parity spaces are designed for capacity efficiency and increased resiliency. Parity spaces are best suited for archival data and streaming media, such as music and videos. This storage layout requires at least three disks to protect you

from a single disk failure and at least seven disks to protect you from two disk failures.

For details on how to design mirror and parity spaces for maximum reliability and performance, including how to use journal disks to improve parity write performance, see the

Software-Defined Storage Design Considerations Guide.

Note Note

|

|---|

| Storage Spaces cannot be used to directly host the Windows startup disk or page file (though virtual hard disks can be safely stored in a storage space). Storage Spaces is not a disaster recovery or data replication solution, nor is it a substitute for regular backups. |

What types of drives can I use with Storage Spaces?

You can use commodity drives attached via Serial-Attached SCSI (SAS), Serial ATA (SATA), PCI-Express, M.2, U.2, or USB. Storage layers that abstract the physical disks are not compatible with Storage Spaces. This includes VHDs and pass-through disks in a

virtual machine, and storage subsystems that layer a RAID implementation on top of the physical disks. iSCSI and Fibre Channel controllers are not supported by Storage Spaces.

RAID adapters, if used, must be in non-RAID mode with all RAID functionality disabled. Such adapters must not abstract the physical disks, cache data, or obscure any attached devices including enclosure services provided by attached just-a-bunch-of-disks

(JBOD) devices. Storage Spaces is compatible only with RAID adapters that support completely disabling all RAID functionality.

Note Note

|

|---|

| Consumers can use USB drives with Storage Spaces, though USB 2 drives might not offer a high level of performance. A single USB 2 hard drive can saturate the bandwidth available on the shared USB bus, limiting performance when multiple drives are attached to the same USB 2 controller. When using USB 2 drives, plug them directly into different USB controllers on your computer, do not use USB hubs, and add USB 2 drives to a separate storage pool used only for storage spaces that do not require a high level of performance. |

What types of storage arrays can I use with Storage Spaces?

Storage arrays that provide direct connectivity to the physical disks they house and do not layer RAID implementations or abstract the disks in any way are compatible with Storage Spaces. Such arrays are also known as Just a Bunch of Disks (JBOD).

For Storage Spaces to identify disks by slot and leverage the array’s failure and identify/locate lights, the array must support SCSI Enclosure Services (SES) version 3. For a list of compatible arrays, see the

Windows Server Hardware Catalog.

Enclosure Awareness Support — Tolerating an Entire Enclosure Failing

To support deployments that require an added level of fault tolerance, Storage Spaces supports associating each copy of data with a particular JBOD enclosure. This capability is known as enclosure awareness. With enclosure awareness, if one enclosure fails

or goes offline, the data remains available in one or more alternate enclosures.

To use enclosure awareness with Storage Spaces, your environment must meet the following requirements:

- JBOD storage enclosures must support SCSI Enclosure Services (SES).

- Storage spaces must use the mirror resiliency type if you’re using Windows Server 2012:

- To tolerate one failed enclosure with two-way mirrors, you need three compatible storage enclosures.

- To tolerate two failed enclosures with three-way mirrors, you need five compatible storage enclosures.

What are the resiliency levels provided by Enclosure Awareness?

The following table lists the maximum simultaneous fault tolerance of solutions that have enclosure awareness enabled:

| Resiliency type | Three enclosures | Four enclosures |

|

Simple |

Not supported |

Not supported |

|

Two-way Mirror |

1 enclosure; or 1 disk* |

1 enclosure; or 1 disk* |

|

Three-way Mirror |

1 enclosure + 1 disk*; or 2 disks* |

1 enclosure + 1 disk*; or 2 disks* |

|

Single Parity |

Not supported |

Not supported |

|

Dual Parity |

Not supported |

1 enclosure + 1 disk*; or 2 disks* |

* per pool

What types of storage spaces can I use with a failover cluster?

Storage Spaces on Windows Server 2012 R2 supports creating a clustered storage pool when using mirror spaces, parity spaces, and simple spaces. Windows Server 2012 doesn’t support parity spaces on clustered storage pools. To cluster Storage Spaces, your

environment must meet the following requirements:

- All storage spaces in the storage pool must use fixed provisioning.

- Two-way mirror spaces must use three or more physical disks.

- Three-way mirror spaces must use five or more physical disks.

- Parity spaces are supported on Windows Server 2012 R2, but not Windows Server 2012.

- All physical disks in a clustered pool must be connected via SAS.

- All physical disks must support persistent reservations and pass the failover cluster validation tests.

Note: The SAS JBOD must be physically connected to all cluster nodes which will use the storage pool. Direct attached storage that is not connected to all cluster nodes is not usable for clustered pools with Storage Spaces.

What properties can I change after creating a storage space?

Upon creating a storage space, certain fundamental properties are locked in place. These fundamental properties include the provisioning type (thin or fixed), the resiliency type (simple, mirror, or parity), the number of columns the storage space striping

requires, and the striping interleave.

After creating a storage space, you can change properties that do not affect fundamental characteristics, such as the size of the storage space and its name.

How does Windows let me know of a disk failure?

When a disk failure occurs, Windows displays information on the disk failure in the following locations:

- The taskbar

- The Action Center

- The Storage Spaces Item in Control Panel (on Windows 8.1 and Windows

- The Storage Pools section of the File and Storage Services role in Server Manager (on Windows Server)

- The Windows PowerShell cmdlet Get-PhysicalDisk

How does Storage Spaces respond to errors on physical disks?

Physical disks often experience errors of varying severity, from errors that the disk can transparently recover from, without interruption or data loss; to errors that are catastrophic and can cause data loss. For more information, see

How Storage Spaces responds to errors on physical disks.

What information will Storage Spaces put in the Event log?

To help with administration, Storage Spaces will log certain events in the Event log. For more information on the events logged by Storage Spaces, see the following:

- Storage Spaces Event 100

- Storage Spaces

Event 102 - Storage Spaces Event 103

- Storage Spaces Event 104

- Storage Spaces Event 200

- Storage Spaces Event 201

- Storage Spaces Event 202

- Storage Spaces Event 203

- Storage Spaces Event 300

- Storage Spaces Event 301

- Storage Spaces Event 302

- Storage Spaces

Event 303 - Storage Spaces Event 304

- Storage Spaces Event 306

- Storage Spaces

Event 307 - Storage Spaces

Event 308

How do I replace a physical disk?

If you are using the Storage Spaces item in Control Panel, replacing a physical disk is as simple as clicking the command to remove the old disk. After that, you can immediately disconnect the disk. In the background, Storage Spaces leverages resiliency

to reconstruct your data. Disk removal has three prerequisites:

- All storage spaces that depend on the disk are resilient and healthy (removing the disk will not succeed if a simple space depends on the disk). You can discover which storage spaces depend on a physical disk by piping the Get-PhysicalDisk

cmdlet to Get-VirtualDisk. For example:Get-PhysicalDisk -FriendlyName PhysicalDisk1 | Get-VirtualDisk

You can check the resiliency and health of your storage spaces by using the Get-VirtualDisk cmdlet. A storage space is resilient when ResiliencySettingName is either Mirror or Parity and healthy when HealthStatus is Healthy.

- The pool has at least as much unused capacity on other disks as the amount of data the old disk hosts. This ensures that the storage spaces can be reconstructed with a replacement disk. If the usage type of the disk is manual, then the

storage spaces that depend on the disk must have sufficient unused capacity on other disks in their list of disks they can use. In both cases, the unused capacity must be on disks that do not already host an extent of the same stripe as the old disk. This

can be satisfied by first adding the new disk to the pool, and, if applicable, adding it to the storage spaces’ lists of disks that they can use.Tip

You can check for unused capacity on disks the affected storage spaces are not using by subtracting AllocatedSize from Size, as reported by the Get-PhysicalDisk command. - If the pool is clustered, removing the disk would not cause the pool to have fewer than three disks, if the pool does not contain any three-way mirror spaces, or fewer than five disks, if the pool contains a three-way mirror space.

If you are using Windows PowerShell, you must perform following procedure to remove the old disk, assuming that you meet the prerequisites for removing a physical disk.

Removing a physical disk by using Windows PowerShell

-

Open a Windows PowerShell session as an administrator.

-

Type the following command, replacing <diskname> with the friendly name of the disk:

Set-PhysicalDisk -FriendlyName <diskname> -Usage Retired

If the pool is clustered, you will need to run this command on the cluster node which has the cluster resource for the pool online.

-

Type the following command for each storage space that depended on the old disk, replacing <virtualdiskname> with the friendly name of the storage space:

Repair-VirtualDisk -FriendlyName <virtualdiskname>

If the pool is clustered, run this command on the cluster nodes that have the individual storage spaces’ cluster resource online and then run it again on the cluster node that has the pool’s cluster resource online.

-

Prior to performing step 5, you must wait for all active repair jobs to complete. To monitor the status of repair jobs, type the following command:

-

Type the following command:

Remove-PhysicalDisk -FriendlyName <diskname>

The above command did not work in my Windows Server 2012 R2 Essentials.

You have to do this in 2 steps. First give the disk to be removed a name and then remove;

example;

PS C:> $PDToRemove = Get-PhysicalDisk -Friendlyname "PhysicalDisk25"

PS C:> Remove-PhysicalDisk -PhysicalDisks $PDToRemove -StoragePoolFriendlyName "DemoPool"

-

Physically disconnect the old disk.

What are columns and how does Storage Spaces decide how many to use?

Besides offering resiliency to drive failures, Storage Spaces also offers increased performance by striping data across multiple disks. Storage Spaces describes a

stripe via two parameters, NumberOfColumns and

Interleave.

- A stripe represents one pass of data written to a storage space, with data written in multiple stripes (passes).

- Columns correlate to underlying physical disks across which one stripe of data for a storage space is written.

- Interleave represents the amount of data written to a single column per stripe.

The NumberOfColumns and Interleave parameters, which are accessible via Windows PowerShell or WMI, determine the width of the stripe (stripe_width = NumberOfColumns * Interleave). The stripe width determines how much data

and parity (in the case of parity spaces) Storage Spaces writes across multiple disks to increase performance available to apps.

Example 1: A Two-Column Simple Space

A simple example is a two-column simple space, which offers striping with no resiliency.

For the first stripe of data in this example, Storage Spaces writes 256 KB (the default Interleave value) to the first disk (column) in the storage pool, then 256 KB of data to the second disk in the pool. This yields a stripe width of 512 KB (2 columns

* 256 KB interleave).

Example 2: A Three-Column Parity Space

Another example is a three-column parity space (with a 256 KB stripe interleave), the simplest form of a parity space.

For the first stripe of data in this example, Storage Spaces writes 256 KB of data to the first disk (column), 256 KB of data to the second disk, and 256 KB of parity to the third disk. This yields a stripe size of 768 KB (3 columns * 256 KB of interleave).

As more data is written to the parity space, it rotates the column for the parity information among all three disks.

Example 3: A Two-Column Two-Way Mirror Space

Another example is a two-column two-way mirror space. Mirror spaces add a layer of data copies below the stripe, which means that a two-way mirror space duplicates each individual column’s data onto two disks.

For the first stripe of data in this example, Storage Spaces writes 256 KB of data to the first column, which is written in duplicate to the first two disks. For the second column of data, Storage Spaces writes 256 KB of data to the second column, which

is written in duplicate to the next two disks. The column-to-disk correlation of a two-way mirror is 1:2; for a three-way mirror, the correlation is 1:3.

Controlling the Number of Columns

You can control the number of columns and the stripe interleave when creating a new storage space by using the Windows PowerShell cmdlet

New-VirtualDisk with the NumberOfColumns and

Interleave parameters.

Each type of storage space has a minimum number of stripe columns which translates to a minimum number of physical disks, given their column-to-disk correlation (below).

|

Resiliency type |

Minimum number of columns |

Column-to-disk correlation |

Minimum number of disks |

Maximum column count |

|

Simple (no resiliency) |

1 |

1:1 |

1 |

N/A |

|

Two-way mirror |

1 |

1:2 |

2 |

N/A |

|

Three-way mirror |

1 |

1:3 |

5 |

N/A |

|

Single Parity |

3 |

1:1 |

3 |

8 |

| Dual Parity | 7 | 1:1 | 7 | 17 |

Due to striping, a storage space simultaneously allocates capacity from as many disks as its stripe requires. Therefore, when increasing pool capacity, you can usually achieve optimal pool capacity utilization when you add disks in multiples of the number

of disks the storage space needs. For example, adding disks in multiples of four might provide optimal capacity utilization for a pool comprised of two-column, two-way mirror spaces (2 columns + 2 data copies = 4 disks per stripe).

Note Storage Spaces in Windows Server 2012 R2 and earlier by default uses the largest column count possible given the number of disks you have and the resiliency type you select. This is useful for environments with a small number of disks

where you want to maximize performance and don’t have to replace disks very often. However, in environments with a large number of disks, use a column count number one less than the maximum. This allows Storage Spaces to automatically repair virtual disks

following a disk failure or after you retire a disk.

Why do I have a low capacity warning even though I still have unused pool capacity?

Storage Spaces provides advance notification of thinly provisioned storage spaces when the storage pool does not have enough capacity spread among a sufficient number of disks to continue to write new data. The default warning point is 70% capacity utilization.

To learn when Storage Spaces will generate a warning, consider the following example.

A two column, two-way mirror space that uses thin provisioning in a four disk pool

Two of the disks have 1TB capacity and two have 2TB capacity. Because a two column, two-way mirror space needs four disks (number_of_disks = NumberOfColumns * NumberOfDataCopies), it will evenly consume all four disks as it writes new data. When capacity

utilization of the two 1TB disks reaches 70%, Storage Spaces will warn of a low capacity condition. Even though the entire pool has 3.2TB free capacity, the thinly provisioned space will soon not be able to write any more data because the 1TB disks are nearly

fully consumed.

You can easily keep individual storage spaces’ low capacity warning synchronized with each other and with the pool by following the guidance in the next section, “How do I increase pool capacity?” from the moment of creating the pool and through all subsequent

expansions of the pool.

How do I increase pool capacity?

Storage Spaces can usually use the additional capacity from even a single additional drive. However, for optimal capacity utilization, consider the number of columns your storage spaces have and add disks in multiples of that number.

For example, consider a pool which has a four-column simple space, a one-column, two-way mirror space, and an eight-column parity space. The four-column simple space suggests you expand pool capacity in sets of four disks. The one-column, two-way mirror

space suggests you expand pool capacity in sets of two disks (for mirror spaces, you have to multiple the number of columns by the number of copies). The eight-column parity space suggests you expand pool capacity in sets of eight disks. In this example, you

would want to expand pool capacity in sets of eight disks as eight is a common multiple of the number of columns of each of the storage spaces in the pool.

What happens to Storage Spaces when moving physical disks between servers?

Storage Spaces records information about pools and storage spaces on the physical disks that compose the storage pool. Therefore, your pool and storage spaces are preserved when you move an entire storage pool and its physical disks from one computer to

another.

Windows Server 2012 starts storage that could potentially be shared with a cluster in a safe state. For Storage Spaces, that means the first time Windows connects to a storage pool, the pool starts as read-only and the storage spaces will start in a detached

state. To access your data, you must set the storage pool to read-write and then attach the storage spaces.

These steps do not apply to Windows 8 – storage pools start as read-write and storage spaces start as attached.

How do I check Storage Spaces resiliency health in a failover cluster?

The health of each storage space is available only from the cluster node that has the cluster resource for the storage space in the online state. Use Failover Cluster Management to discover which node has the cluster resource for a storage space in the online

state. Then use the Storage Pools section of the File and Storage Services role in Server Manager to view the health of the appropriate storage space.

You can also use the Get-VirtualDisk cmdlet on the node that has the cluster resource online to retrieve the storage space’s properties. The resiliency health of the storage space is noted in the storage space’s properties. To view the health status of a

storage pool, use the Get-StoragePool cmdlet on the cluster node that has the cluster resource for the pool in the online state.

How do I know repairing a storage space starts and successfully completes?

For the repair operation to complete successfully, the pool must have at least as much unused capacity as data to be repaired. If the storage space has a list of disks to use, then the unused capacity must reside on those disks. Unused capacity must reside

on disks which do not already host an extent of the stripe to be repaired. Because repair happens over time, this requirement must be continuously fulfilled for a successful repair completion.

For a quick check on whether repair is successfully progressing, use the Get-VirtualDisk cmdlet to look at the storage space’s

OperationalStatus. While repair is successfully progressing, OperationalStatus will be

In Service. When repair successfully completes, OperationalStatus is

OK. If repair is unable to continue, OperationalStatus returns to

Degraded.

What happens if I run out of physical capacity on a thinly provisioned storage space?

Since the storage space is thinly provisioned, allocation of new capacity occurs as needed. Once capacity is exhausted, there is no room to properly manage files on the storage space and there is a risk of data loss due to file corruption. To protect against

that, Windows takes the storage space offline – removing the storage space from the view of anything that was writing and thereby keeping your files safe. Once the pool has more drives, you can bring the storage space back online and continue running.

When additional drives are not immediately available, you can try to just bring the storage space back online and get to your files until additional drives are available. However, sometimes applications, or the file system itself, may continue writing once

the storage space is online. If that happens, then Windows’ safety measures will again protect your files by taking the storage space offline.

If additional drives are not immediately available and the storage space cannot remain online, then can still get to your files by using PowerShell to temporarily make your storage space read-only.

Get-VirtualDisk –Friendlyname name_of_your_space | Get-Disk | Set-Disk –IsReadOnly $true

Get-VirtualDisk –Friendlyname name_of_your_space | Get-Disk | Set-Disk –IsOffline $false

If you do that, then you will want to switch your storage space back to read-write once your storage pool has additional drives. You can use PowerShell to do that as well.

Get-VirtualDisk –Friendlyname name_of_your_space | Get-Disk | Set-Disk –IsOffline $true

Get-VirtualDisk –Friendlyname name_of_your_space | Get-Disk | Set-Disk –IsReadOnly $false

Get-VirtualDisk –Friendlyname name_of_your_space | Get-Disk | Set-Disk –IsOffline $false

Finally, if you do not add more drives to the storage pool (the control panel will tell you the minimum number of drives to add), then Windows will protect the files which are already on the storage space by taking the storage space offline. Adding new

drives to the storage pool provides the additional capacity the storage space needs. You will be able to bring your storage space back online and continue to copy new files into it.

See Also

- File and Storage Services

- Storage Spaces Overview

- Storage Management Overview

- Modifying a Storage Pool that has a Read-Only Configuration

- Provide cost-effective storage for Hyper-V workloads by using Windows Server (2012 R2)

- Provide cost-effective storage for Hyper-V workloads by using Windows Server: planning and design guide

(2012 R2)

Posted: February 25th, 2015

Storage Spaces is a storage virtualization technology developed by Microsoft and introduced with Windows 8 and Windows Server 2012. It allows to create and manage logical volumes running on a pool – Storage Pool – of physical disks.

We’ve already showed how you can create and manage a Storage Space on Windows 8.1. It’s time to show you how to do the same on Windows Server 2012 / 2012 R2.

You can find the Storage Services control panel opening the Server Manager. Click on File and Storage Services:

Here we are:

Create the Storage Pool

Open the Storage Pools tab, click on the drop-down menu on the upper-right corner and select New Storage Pool:

A configuration Wizard will appear. Go on and specify the name of the Pool:

Select the disks you want to use for your pool:

Confirm and the Pool will be created:

Create the Virtual Disk

We have a Storage Pool but no logical disk that runs on it. Windows Server will launch a new configuration Wizard to create one:

Select the Storage Pool where you want to put your Virtual Disk:

Give it a name:

Choose the Storage Layout. With two disks use Mirror – a sort of virtual RAID 1 – while with more drives we suggest to use the Parity mode. Don’t use the Simple mode because it’s unsafe for your data:

Enabling Thin Provisioning, your Virtual Disk will use only the space effectively occupied by the Virtual Disk:

Specify the size (it can be greater than the underlying Storage Pool):

And even the Virtual Disk is done:

Create the Volume

The last step is to create the Volume. A quite simple step.

Select the Disk:

Choose the volume size:

Select the drive letter:

Select the file system. We suggest ReFS for data storage:

Confirm and the volume will be created:

Finally, you’re ready to use your Storage Pool:

Share:

Tags: Microsoft Windows

Содержание

Что нового в хранилище Windows Server 2012 R2?

Многоуровневые пространства хранения

Кеш с обратной записью

Распараллеленное восстановление

Низкоуровневое усовершенствование: встроенная поддержка секторов 4 КБайт

Поддержка UEFI BIOS позволяет работать с дисками GPT

Утилита снкdsк стала более интеллектуальной

Онлайновое самолечение

Онлайновая верификация

Онлайновая идентификация и ведение журналов

Точное и быстрое исправление

Пространства хранения в Wiпdows Server 2012 R2

Повторное использование технологии из облачных служб Microsoft

Предоставление SАN-подобных возможностей посредством инструментов управления Microsoft

Создание пространствах хранения

Создание пула

Ограничения пулов хранения

Просмотр устройств в инструменте Disk Management

Работа с пулом хранения в PowerShell

Выделение пространств а пула под виртуальный диск

Демонстрация настройки многоуровневого хранения с помощью PowerShell

iSCSI в пространствах имен

Добавление целевой службы iSCSI

Подключение к виртуальному диску iSCSI со стороны клиента

Общие ресурсы NFS

Где используется общий ресурс NFS

Быстрая настройка общего ресурса NFS

Подключение к общему ресурсу NFS со стороны клиента

Дедупликация: диск и сеть

Конфигурирование дедупликации данных с помощью диспетчера серверов

Конфигурирование дедупликации данных с помощью PowerShell

Проверка томов на предмет повреждений

Администраторы, которые имели возможность поработать какое-то время с

пространствами хранения (Storage Spaces) в Windows Server 2012, наверняка по

достоинству оценят изменения, внесенные в Windows Server 2012 R2. Но прежде чем приступить к их обсуждению, давайте ознакомимся с краткой сводкой п Storage Spaces, предназначенной для тех, кто не еще не имел дела с этим средством.

Средство Storage Spaces было представлено в Windows Server 2012 как встроенный компонент. Вспомните, что это не RAID, но кое-что новое, что было спроектировано для полноценного корпоративного использования.

Базовая функция Storage Spaces заключается в том, чтобы дать возможность взять просто группу дисков Uust а bunch of disks — JBOD) и сконфигурировать их в пуле. Отсюда вы можете создавать виртуальные диски (действительное пространство хранения) и тома с устойчивостью к отказам разнообразных уровней. Такой тип конфигурации обеспечивает высокую гибкость.

Представьте себе отсутствие обязательства инвестировать в крупную дорогос

тоящую сеть хранения данных (storage area network — SAN) или в специальное

обучение, которое администраторы должны были бы пройти, чтобы конфигури

ровать и обслуживать эту сеть. Основной целью Storage Spaces является предостав

ление рентабельного решения для хранилища с непрерывным доступом к данным.

Пространства хранения и пулы спроектированы с возможностью увеличения по

запросу.

Ниже приведен список лишь некоторых возможностей в Storage Spaces, входя-

щих в состав Windows Server 2012:

• оперативная настройка;

• устойчивость к отказам (зеркальное отображение и контроль по четности);

• интеллектуальное исправление ошибок;

• поддержка множества владельцев;

• интеграция с CSV для возможности обработки масштабированных сценариев.

В этой главе вы изучите следующие темы:

• создание пула хранения на виртуальном диске;

• создание дополнительного хранилища на виртуальном диске;

• применение приемов дедупликации для сокрашения размера файлов.

Что нового в хранилище Windows Server 2012 R2?

Поскольку эта книга посвяшена Windows Server 2012 R2, мы покажем, что нового

пояnилось в хранилище. Разработчики из Microsoft включили в Storage Spaces технологию, которую ранее можно было nстретить только в дорогостоящих массивах хранения. Эта технология подробно рассматривается в последующих разделах.

Многоуровневые пространства хранения

В современном мире хранилищ существует несколько классификаций дисков, в

том числе последовательная расширенная технология подключения (Serial Advance

Technology Attachment — SATA), последовательно присоединенное SСSl-устройство (Serial Attached SCSI — SAS), твердотельный накопитель (Solid State Drive — SSD) и оптоволоконный канал (Fibre Channel). Выбор правильного типа хранилища для работы очень важен. Например, если вам необходим файловый сервер, то SSD не является удачным выбором. Накопители SSD были спроектированы для обеспечения

высокой скорости, но не емкости, и в связи с тем, что файловые серверы обычно нуждаются в емкости, а не скорости, в этом случае намного лучше может подойти диск SATA, который проектировался для большей емкости, нежели скорости.

В Windows Server 201 2 R2 можно иметь максимум два уровня хранения, в сущности, быстрый уровень и медленный уровень. На быстром уровне автоматически используется SSD, а на меменном — SATA. По-настоящему хорошо здесь то, что администратор не должен решать заранее, где размещать данные.

Службы управления

уровнями хранения (Storage Тiers Manageшent Service) автоматически проанализирует данные на дисках в срезах по 1 Мбайт. Она имеет две категории для назначения:

горячие точки (hot spot) и холодные точки (cold spot). Горячие точки — это об.1асти данных, доступ к которым производится часто; здесь выдвигается предположение о том, что поскольку это активные данные, они являются своего рода «горячей темой». Холодные точки представляют собой противоположность: данные, доступ к которым осуществляется нечасто. После анализа горячие точки будут переведены

на уровень SSD, а любые идентифицированные холодные точки будут назначены

уровню SATA.

По умолчанию анализ происходит ежедневно в 1 :00, но вы можете сконфигури

ровать это по своему усмотрению (рис. 1 2. l ). Но если файл нуждается в нахождении на быстром уровне все время, администратор может «закрепить» такой файл на этом уровне.

Рис. 12.1 . Служба Storage Tiers Management в планировщике задач

Кеш с обратной записью

Под кешем с обратной записью понимается способ записи данных на диск.

Данные сначала записываются в кеш, и будут храниться в нем до тех пор, пока их не потребуется перезаписать; в этот момент они сбрасываются на диск и фиксируются. В общем случае запись и хранение данных в кеше обеспечивает лучшую производительность и рассматривается как еще один тип памяти. Если приложение записывает в кеш, оно может быстро-освободить свой обработчик ввода-вывода и возвратиться к выполнению других задач. Определенным рабочим нагрузкам традиционно не нравится кеширование с обратной записью, потому что когда приложение записывает данные, они должны быть записаны на диск во избежание разрушения. Например, Hyper-V требует сквозной записи. Многоуровневое хранилище

может применяться в сочетании с виртуальным диском (в этом случае не с файломVHD/VHDX, имеющим отношение к Hyper-Y и виртуальным машинам, а вирту

альным диском с точки зрения Storage Spaces), чтобы поглощать любые выбросы в операциях записи. Быстрый уровень затем может использоваться для преодоления выброса и разрешения Hyper-V применять кеширование с обратной записью.

Распараллеленное восстановление

В случае отказа диска в традиционном массиве RAID, при наличии горячего ре

зерва (диск, который может немедленно принять работу отказавшего диска в масси

ве RAID), этот горячий резерв вступает в игру и массив RAID начнет воссоздание данных на отказавшем диске. Во время воссоздания влияние на производительность дисковой подсистемы неизбежно, т.к. все данные записываются на единственный диск. Процесс распараллеленного восстановления в Storage Spaces несколько отличается. Если диск отказывает, оставшиеся работоспособные диски, которые имеют подходящую емкость, получают права владения данными, сохраненными на отказавшем диске, и будут обслуживать запросы от пользователей по всем доступнымнакопителям.

Поскольку теперь помощь оказывают все диски, влияние на производительность отсутствует. Процесс восстановления может задействовать горячий резерв или же администратор может заменить отказавший диск новым, который в

фоновом режиме постепенно возвратится в пространство хранения.

низкоуровневое усовершенствование: встроенная поддержка секторов

4 Кбайт

Первоначально жесткие диски использовали формат 512 байтов на сектор, и это

налагало ограничения на размер и производительность хранилища.

Учитывая постоянно растущие потребности в емкости и скорости, назрела необходимость в изменениях, и в течение всего нескольких лет стандартом стали диски с секторами 4 Кбайт.

Тем не менее, программное обеспечение (такое как утилиты файловой системы, операционные системы и механизмы баз данных) не обязательно быстро подхватили это изменение. Большинство производителей устройств поставляли диски с секторами 4 Кбайт, но в целях совместимости эмулировали 512-байтовые секторы.

Очевидно, это сопровождается некоторыми накладными расходами, поскольку сектор 4 Кбайт целиком считывается в память, модифицируется и затем записывается

обратно. Так как происходит определенная степень манипулирования, имеется также мияние на производительность, которое в данном случае вполне приемлемо.

Благодаря встроенной поддержке секторов 4 Кбайт, индустрия хранения данных

больше не эмулирует 5 12-байтовые секторы, а это значит, что влияние на производительность устранено.

В следующем списке перечислены некоторые приложения и сценарии, которые

становятся доступными при поддержке секторов 4 Кбайт:

• возможность установки Windows на диск с секторами 4 Кбайт и загрузки с него

без необходимости в эмуляции (собственный диск 4 Кбайт);

• ноuый файловый формат VHDX;

• полная поддержка Hyper-V;

• резервное копирование Windows;

• полная поддержка со стороны файловой системы New Technology File System

(NTFS);

• полная поддержка со стороны новой файловой системы ReFS (Resilient File

System — отказоустойчивая файловая система);

• полная поддержка со стороны Storage Spaces;

• полная поддержка со стороны средства Windows Defender (Защитник Windows);

• поддержка входящих приложений.

Поддержка UEFI BIOS позволяет работать с дисками GPT

Главные загрузочные записи (masteг boot гecord — MBR) — это спеuиальные об

ласти, расположенные в начале разделенного пространства на диске. Они содержат информацию о внутренней структуре разделов и связанный загрузочный код, который позволяет операционной системе запуститься. Запись MBR хранит свой адрес блока в 32-битном формате. Первоначально диск с 5 12-байтовыми секторами и адресом блока в 32 бита был ограничен объемом 2 Тбайт. Вполне очевидно, что это больше не является приемлемым. Таким образом, индустрия двигается в сторону секторов 4 Кбайт, и теперь диски обладают максимальной емкостью 16 Тбайт. Все выглядит так, как будто мы достигли цели, но с учетом современной инфраструктуры мы можем иметь дело с петабайтами данных, поэтому терабайты вряд ли справятся с этим.

Таблица разделов GUID (GUID Partition ТаЫе — GPT) предоставляет 64-битную

структуру адресаuии. На диске с 512-байтовыми секторами можно иметь 9,4 Збайт

(9 444 732 965 739 290 426 880) данных. В настоящее время GPT поддерживает максимальный размер диска и раздела, равный 8 Збайт.

Если вы приготовились преобразовать свои диски в GРТ, то вы совершенно пра

вы! Но будьте осторожны; не все операционные системы поддерживают загрузку из разделов GPT, используя стандартную систему BIOS. Ознакомьтесь с материалом по следующей ссьтке:

http : / / ru . wi kipedia . org/wiki /Taблицa_paздeлoв_GUID

Унифицированный расширяемый интерфейс прошивки (Unified ExtensiЬle Firmware

lnterface — UEFI) спроектирован как прямая замена унаследованной системы BIOS.

По существу он делает ту же самую работу, но добавляет такую функuиональность, как диагностика и восстановление компьютеров с развернутыми операционными системами. Интерфейс UEFI разработан для поддержки загрузки из разделов GPT, и Windows SeIVer 2012 R2 полностью поддерживает UEFI BIOS.

Утилита снКDsк стала более интеллектуальной

На протяжении многих лет утилита снкоsк была одним из главных инструмен

тов. Она входила в состав многочисленных поколений DOS и Windows, и замеча

тельно видеть этот инструмент модернизированным.

Одной из крупнейших проблем, с которыми сталкивалась утилита снкоsк до ее

модернизации, была ее прямая связь с количеством файлов внутри тома.

Большее число файлов требовало большего времени на ее выполнение. Еще одна причинявшая постоянное беспокойство сложность заключалась в том, что когда снкоsк обнаруживала проблему, она обычно размонтировала том, повторно все сканировала, обнаруживала проблему снова и только затем ее исправляла. Несложно представить, что на крупных томах это занимало длительное время, а при современной культуре постоянной готовности простой попросту неприемлем.

Код инструмента CHKDSK был модернизирован, и модель работоспособности

NTFS также была перепроектирована. Мы обсудим эти модернизации далее, но

они, в сущности, бьuш обусловлены тем, что утилита снкоsк с прежними возмож

ностями больше не была нужна.

онлайновое самолечение

Хотя эта возможность файловой системы NTFS существовала со времен Windows

Vista, количество проблем, которые она способна обнаружить и исправить, зна

чительно увеличилось. В свою очередь, это снизило фактическую потребность в

снкоsк, поскольку большинство проблем удавалось решить с помощью онлайново

го самолечения. Поддерживая самолечение, том не обязан переходить в отключенное состояние.

Онлайновая верификация

В Windows Server 201 2 действительное повреждение можно подтвердить. Иногда

ошибки возникают из-за проблем с памятью, но это не обязательно означает повреждение диска. Теперь, благодаря онлайновой верификации, вы можете акти

визировать проверку. Для выполнения этой проверки драйвер файловой системы

запускает новую службу под названием Spot Yerifieг (Точечный верификатор), как показано на рис. 12.2. Она функционирует в фоновом режиме и не оказывает влияния на производительность системы.

Онлайновая идентификация и ведение журналов

После обнаружения реальной проблемы запускается онлайновое сканирование

файловой системы. Это сканирование рассчитано на выполнение в сочетании с

операционной системой и будет запускаться только во время простоя системы или в период ее низкой загрузки. Найденная проблема фиксируется в журнале для последующего автономного исправления.

точное и быстрое исправление

Поскольку в журнале была зафиксирована информация о местах возникнове

ния проблем, вам не придется заново сканировать всю файловую систему в начале автономного процесса. По существу это означает, что когда вы переведете том в автономный режим для исправления ошибок, такой процесс займет секунды, а не потенциально часы. Быстрое исправление называется Spotfix.

Если вы применяете общие тома кластера (Custer Shared Volume — CSV), никакого простоя не будет, и тома оказываются постоянно готовыми.

Благодаря этим новым усовершенствованиям, исполняющая среда CHKDSK

больше не зависит от количества файлов, а только от числа повреждений данных.

Учитывая возможность исправления настолько многих проблем в онлайновом режиме (при постоянно онлайновом томе CSV), утилита снкоsк становится менее

востребованной. На рис. 12.3 показаны новые опции, которые доступны в снкоsк.

Рис. 12.З. Новые олции CHKDSK

Новыми опциями являются /scan, / forceofflinefix, /perf, /spotfix,

/sdcleanup и /offlinescanandfix. Как видите, они напрямую относятся к опи

санной ранее новой модели работоспособности.

В этот момент мы должны подчеркнуть, что еще одной целью модернизации

снкоsк была необходимость сделать так, чтобы пользователи оставались инфор

мированными о любом повреждении.

Частично причина заключалась в том, чтобы прекратить интенсивные запуски снкоsк для верификации файловой системы со стороны пользователей и администраторов; теперь в этом просто нет нужды.